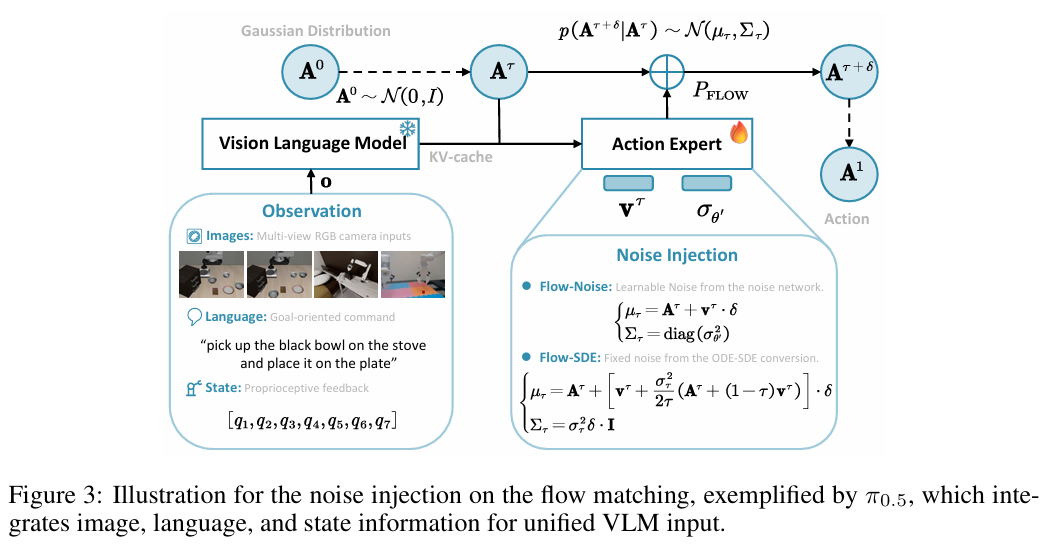

告别预训练:清华大学πRL实现机器人“在实践中进化”的通用解决方案

当前,机器人视觉-语言-动作(VLA)模型的发展正面临一个核心挑战:如何将强化学习(RL)的在线交互优势赋予基于流(Flow-based)的先进模型。现有的训练范式陷入两难:要么依赖大规模、高成本的监督微调(SFT),导致模型在新任务上泛化能力不足;要么受限于流式模型迭代去噪过程中“动作对数似然(log-likelihood)难以计算”的根本性难题,无法应用策略梯度等主流RL算法。

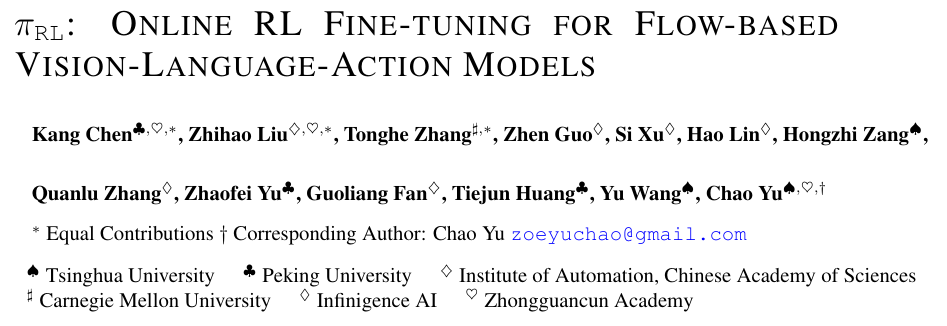

针对此困境,来自清华大学、北京大学、中科院自动化所等机构的研究团队共同提出了 πRL 框架。该框架通过创新的 Flow-Noise 和 Flow-SDE 两种算法,并结合大规模并行仿真训练,成功解决了流式VLA模型的RL适配难题。πRL 不仅保留了流式模型生成高频、灵巧动作的优势,还通过在线环境交互显著提升了其性能与泛化能力,在多个基准测试中实现了从SFT瓶颈到接近满分表现的突破。

论文标题: ONLINE RL FINE-TUNING FOR FLOW-BASED VISION-LANGUAGE-ACTION MODELS

论文链接: https://arxiv.org/pdf/2410.25889v1.pdf

官方代码库: https://github.com/RLinf/RLinf

模型库: https://huggingface.co/RLinf

点击阅读原文,获取论文更多信息

1. 为何需要重新定义流式VLA模型的训练范式?

当前主流VLA模型的训练范式存在根本局限,尤其是对于以 π₀ 和 π₀.₅ 为代表的流式模型,其潜力远未被完全挖掘。

-

监督微调(SFT)的瓶颈:SFT是当前VLA模型训练的基石,但它高度依赖大规模、高质量的专家演示数据。这类数据的采集成本高昂、周期漫长。更重要的是,通过SFT训练出的模型容易对演示轨迹产生过拟合,当面对训练数据中未见过的新任务或长序列任务时,性能会急剧下降,且模型无法通过与环境的动态交互进行自我优化。

-

强化学习(RL)的适配困境:虽然RL能够通过在线交互自主学习和优化策略,但现有VLA+RL的探索主要集中在自回归模型(如OpenVLA)上。这些方法无法直接应用于流式VLA模型,其核心障碍在于:

- 动作对数似然难以计算:流式模型通过一个迭代去噪过程(通常由常微分方程ODE描述)从高斯噪声逐步生成连续的动作块。这个确定性的多步生成过程使其最终动作的对数似然

log π(a|s)难以直接、精确地计算,而这正是主流策略梯度RL算法(如PPO)进行梯度更新所必需的。 - 缺乏探索性:基于确定性ODE的采样过程不含随机性,导致模型无法在环境中进行有效探索,这与RL依赖试错学习的核心机制相悖。

- 动作对数似然难以计算:流式模型通过一个迭代去噪过程(通常由常微分方程ODE描述)从高斯噪声逐步生成连续的动作块。这个确定性的多步生成过程使其最终动作的对数似然

这些局限使得流式 VLA 模型虽然在生成高频、灵巧的连续动作方面具有天然优势,却始终无法充分利用 RL 的在线学习能力。πRL 正是为打破这一僵局而设计,其核心思想是:不再回避流式模型的迭代去噪特性,而是将其精确建模,使其与RL框架兼容。

2. πRL:如何通过“双算法+并行仿真”实现流式VLA的RL优化?

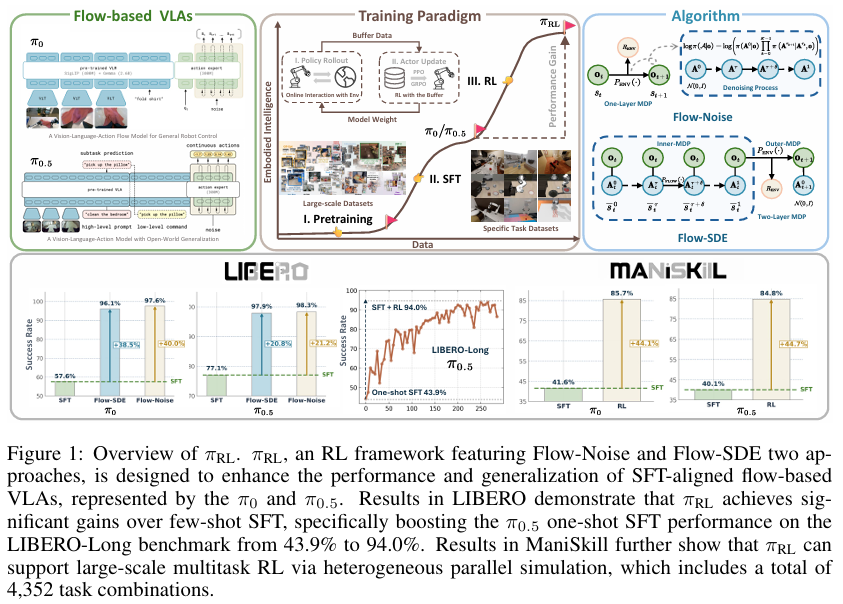

πRL 框架通过 Flow-Noise 与 Flow-SDE 两种互补算法,分别解决了流式VLA模型中“动作对数似然计算”与“探索性不足”两大难题。在此基础上,结合PPO算法进行策略优化,并通过大规模并行仿真环境进行训练。

2.1 核心矛盾破解:两大算法解决RL适配难题

方案一:Flow-Noise——用“可学习噪声网络+单层MDP”计算精确对数似然

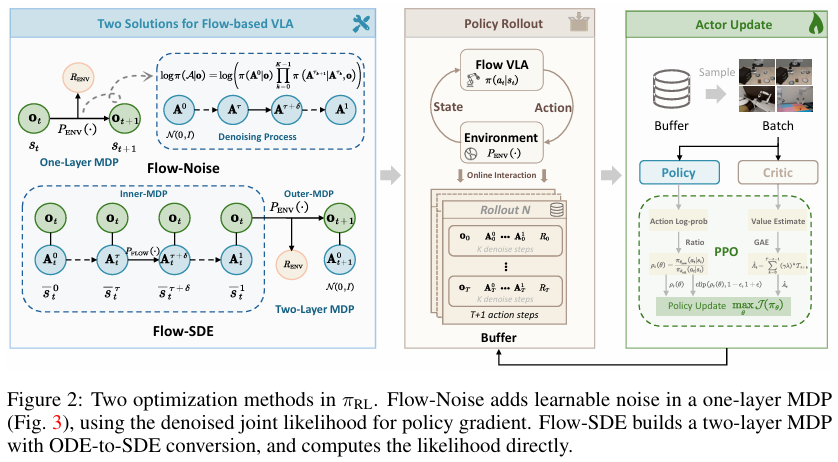

Flow-Noise 的核心思路是将迭代去噪过程建模为一个离散时间的马尔可夫决策过程(MDP),并引入一个可学习的噪声网络来注入探索性,从而实现对数似然的精确计算。

-

随机性注入:在每个去噪步骤中,除了模型预测的更新方向外,还额外注入一个由独立神经网络(噪声网络)学习的噪声。这个噪声的强度可以根据环境反馈动态调整,既保证了探索,又避免了动作失真。去噪过程中的状态转移被建模为一个高斯分布

p(Aτ+δ|Aτ) ~ N(μτ, Στ),其中均值由ODE更新确定,方差则由可学习的噪声网络σ²θ'控制:

{μτ=Aτ+vτ⋅δΣτ=diag(σθ′2)\begin{cases} \mu_{\tau} = A_{\tau} + v_{\tau} \cdot \delta \\ \Sigma_{\tau} = \text{diag}(\sigma^2_{\theta'}) \end{cases} {μτ=Aτ+vτ⋅δΣτ=diag(σθ′2) -

对数似然计算:通过将去噪过程建模为MDP,单个动作的对数似然

log π(a|s)虽然仍不可解,但整个去噪序列(从初始噪声到最终动作)的联合概率log π(A|o)变得可计算。Flow-Noise以此联合概率替代传统RL中的单步动作概率,用于策略梯度计算。其计算公式如下:

logπ(A∣o)=log(π(A0∣o)∏k=0K−1π(Aτk+1∣Aτk,o))\log \pi(A|o) = \log \left( \pi(A_0|o) \prod_{k=0}^{K-1} \pi(A_{\tau_{k+1}}|A_{\tau_k}, o) \right) logπ(A∣o)=log(π(A0∣o)k=0∏K−1π(Aτk+1∣Aτk,o))

其中,A = (A₀, ..., A₁)是完整的去噪序列,K是去噪步数。 -

单层MDP适配:该方案沿用了标准RL的单层MDP框架(状态S → 动作A → 奖励R),仅通过噪声注入和联合概率计算来适配流式模型的特性,无需对现有RL算法(如PPO)的流程进行大幅修改。

点击阅读原文,获取论文更多信息

方案二:Flow-SDE——用“ODE转SDE+双层MDP”平衡探索与效率

Flow-SDE 的核心思路是将确定性的ODE去噪过程转换为等价的随机微分方程(SDE),从而自然地引入探索性,并通过构建双层MDP结构来解耦去噪过程与环境交互,实现计算效率与探索性能的平衡。

-

ODE-to-SDE转换:在保持动作边际分布不变的前提下,论文将流式模型的确定性ODE采样

d**A**τ = vτdτ转换为一个包含漂移项和扩散项的SDE,从而引入随机性。其通用形式为:

dAτ=[vτ+στ22τ(Aτ+(1−τ)vτ)]dτ+στdwτd\mathbf{A}_{\tau} = \left[ v_{\tau} + \frac{\sigma_{\tau}^2}{2\tau}(\mathbf{A}_{\tau} + (1-\tau)v_{\tau}) \right]d\tau + \sigma_{\tau}d\mathbf{w}_{\tau} dAτ=[vτ+2τστ2(Aτ+(1−τ)vτ)]dτ+στdwτ

其中vτ是模型预测的速度场,στ是控制噪声水平的调度函数,dwτ是维纳过程(随机噪声)。 -

双层MDP设计:为了高效处理SDE引入的随机性,Flow-SDE构建了一个双层MDP:

- 内层MDP:处理去噪过程中的状态转移

(ot, Aτt) → (ot, Aτ+δt)。此过程不与环境交互,因此奖励为0。 - 外层MDP:在去噪完成后 (τ=1),将最终生成的动作

A₁t执行到环境中,完成一次机器人与环境的交互(ot, A₁t) → (ot+1, A₀t+1),并获得环境奖励REnv。

这种设计将复杂的去噪过程与环境交互解耦,仅在完成一次完整的动作生成后才计算环境奖励,大幅降低了计算成本。

- 内层MDP:处理去噪过程中的状态转移

-

混合采样加速:为了进一步提升训练效率,Flow-SDE采用了“混合ODE-SDE采样”策略。在一次完整的K步去噪过程中,随机选择一步采用SDE进行随机探索,其余K-1步则采用确定性ODE进行高效计算,从而在探索性与训练效率之间取得了良好平衡。

2.2 策略优化:PPO算法与适配设计

在解决了RL适配难题后,πRL 采用**近端策略优化(PPO)**算法进行策略更新。同时,针对流式VLA模型的特性进行了两处关键适配:

-

动作块级奖励(Chunk-level Reward):流式模型一次生成一个包含

H步连续动作的动作块(Action Chunk)。πRL 将这H步动作在环境中执行后获得的累积奖励Rt = Σ(r_t,j)作为该动作块的单步奖励,从而简化了信用分配问题。 -

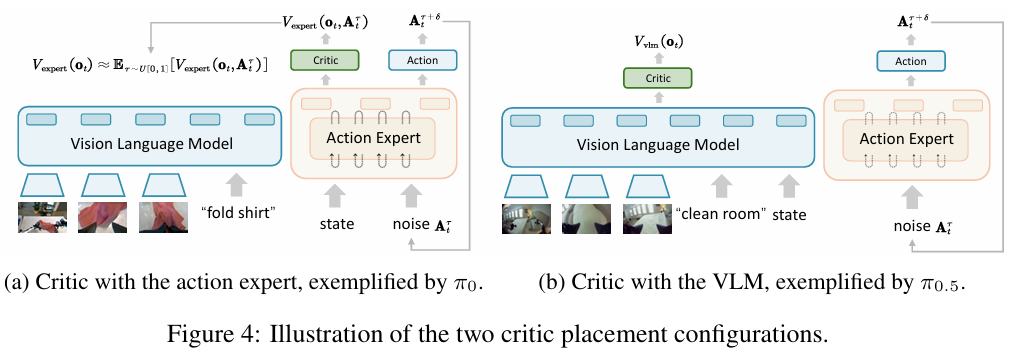

共享演员-评论家(Actor-Critic)架构:为了节省显存,πRL采用共享特征提取器、分离预测头的演员-评论家架构。针对π₀和π₀.₅模型结构上的差异,评论家(Critic)的设计有所不同:

- π₀模型:评论家

V(ot)的估计需要同时输入观测ot和带噪声的动作Aτt,并对整个去噪轨迹的价值进行平均,以提升稳定性。 - π₀.₅模型:评论家

V(ot)直接接入VLM的输出,仅需图像和语言输入,利用了VLM更强的泛化能力来提升价值预测的准确性。

- π₀模型:评论家

2.3 并行仿真训练:支撑大规模多任务优化

为了验证πRL的大规模任务适配能力,团队构建了一个高并行的训练环境:

- 多基准覆盖:涵盖LIBERO(基于CPU,测试多任务知识迁移)和ManiSkill(基于GPU,高保真并行仿真)两大主流基准。其中,ManiSkill任务被扩展到 4,352 种“抓取-放置”任务组合,以测试大规模多任务学习能力。

- 高效并行:在ManiSkill上,采用多达 320 个并行环境同步训练,并结合“环境-模型-采样器同GPU部署”策略,极大降低了数据传输延迟,实现了大规模任务的高效优化。

- 训练策略:SFT阶段仅用少量专家轨迹(如π₀用58条,π₀.₅用40条)初始化模型,RL阶段则冻结VLM参数,仅微调约300M的动作专家模块,在性能与资源消耗之间取得平衡。

3. 实验结果:实现性能与泛化的双重突破

πRL在LIBERO和ManiSkill两大基准上的实验结果,充分证明了其在性能提升、泛化能力和大规模适配上的显著优势。核心结论是:SFT的数据瓶颈被彻底打破,RL在线交互带来了强大的性能和泛化增益。

3.1 LIBERO基准:从“部分成功”到“近满分”的飞跃

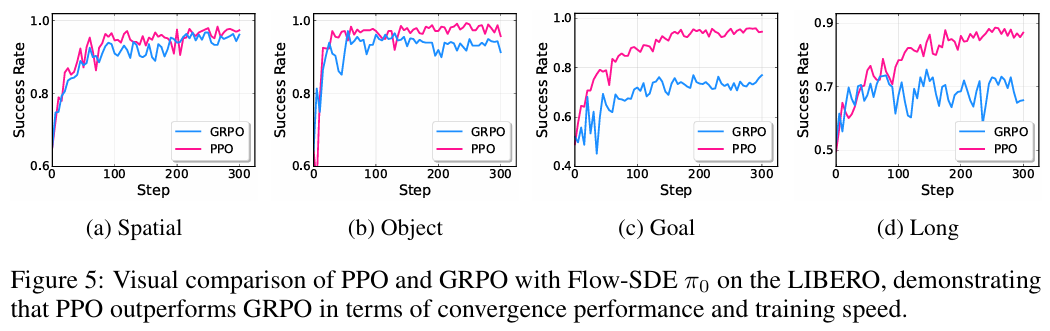

在LIBERO基准(包含Spatial, Object, Goal, Long四大任务集)上,πRL显著弥补了少样本SFT的性能短板。

| 模型 | LIBERO-Spatial | LIBERO-Object | LIBERO-Goal | LIBERO-Long | 平均成功率 |

|---|---|---|---|---|---|

| π₀ (少样本 SFT) | 65.3% | 64.4% | 49.8% | 51.2% | 57.6% |

| π₀ + πRL (Flow-Noise) | 99.0% | 99.2% | 98.2% | 93.8% | 97.6% (+40.0%) |

| π₀.₅ (少样本 SFT) | 84.6% | 95.4% | 84.6% | 43.9% | 77.1% |

| π₀.₅ + πRL (Flow-Noise) | 99.6% | 100% | 99.6% | 94.0% | 98.3% (+21.2%) |

| π₀ (全数据 SFT) | 96.8% | 98.8% | 95.8% | 85.2% | 94.2% |

| π₀.₅ (全数据 SFT) | 98.8% | 98.2% | 98.0% | 92.4% | 96.9% |

关键亮点:

- 长序列任务突破:在最具挑战的LIBERO-Long任务上,πRL将π₀.₅单轨迹SFT模型的成功率从43.9%大幅提升至 94.0%,甚至超过了使用全量数据进行SFT的92.4%。

- 超越全数据SFT:无论是π₀还是π₀.₅,经过RL优化的少样本模型(分别为97.6%和98.3%)均显著超越了使用全量数据SFT的基线模型(分别为94.2%和96.9%),证明了在线环境交互比单纯增加演示数据更有效。

- 算法对比优势:消融实验显示,PPO在所有任务上均优于GRPO(一种无评论家的RL算法),验证了πRL中策略优化设计的有效性。

3.2 ManiSkill基准:4,352种任务的大规模适配验证

在ManiSkill基准上,πRL同样展现了强大的大规模多任务学习能力。

| 模型 (Flow-Noise) | SIMPLER (平均) | MultiTask-IND (4352种) | MultiTask-OOD (平均) |

|---|---|---|---|

| π₀ SFT | 67.2% | 41.6% | 19.5% |

| π₀ + πRL | 86.7% (+19.5%) | 85.7% (+44.1%) | 32.5% (+13.0%) |

| π₀.₅ SFT | 59.2% | 40.1% | 25.9% |

| π₀.₅ + πRL | 79.1% (+19.9%) | 84.8% (+44.7%) | 41.2% (+15.3%) |

关键亮点:

- 大规模任务适配:在包含4,352种任务组合的MultiTask场景下,π₀和π₀.₅的平均成功率分别提升了 44.1% 和 44.7%,证明πRL的并行训练框架能够有效支持大规模、高复杂度的多任务优化。

- 分布外(OOD)泛化提升:尽管OOD场景(如新物体、新指令)仍然充满挑战,但经过RL优化后,π₀在视觉OOD上的性能从43.4%提升至72.9%,π₀.₅在语义OOD上从16.6%提升至25.4%,验证了RL对模型泛化能力的改善。

3.3 消融实验:关键设计的有效性验证

全面的消融实验证实了πRL框架中各项设计的有效性。

- MDP结构:Flow-SDE中采用混合采样的双层MDP结构,相比标准的双层MDP,训练时间减少了50%,同时保持了相近的性能。

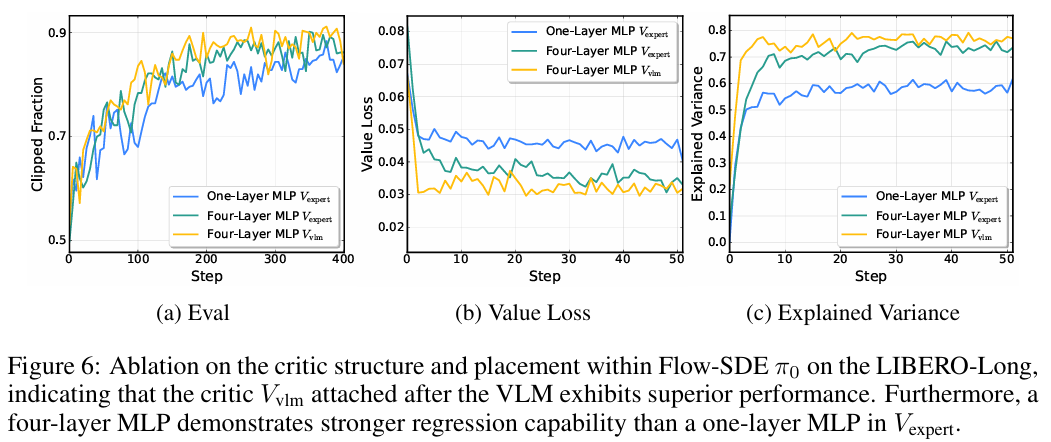

- 评论家设计:对于π₀.₅,将评论家接入VLM(

V_vlm)比接入动作专家(V_expert)的价值损失低30%,解释方差高15%,证明利用VLM的泛化能力有助于更精确的价值预测。 - 超参数影响:实验表明,噪声水平

a=0.5、去噪步数K=4、动作块大小H=5时综合性能最优。过高的噪声或过小的去噪步数会导致动作失真,而过多的去噪步数则会增加不必要的计算成本。

4. 关键结论与未来展望

πRL 的价值在于为“流式VLA模型的RL优化”提供了首个完整且开源的解决方案,其核心启示与未来方向如下:

核心结论

- 流式模型的RL适配关键在于建模去噪过程:Flow-Noise与Flow-SDE两种算法证明,无需改造模型本身,而是通过对迭代去噪过程进行针对性建模(如MDP),即可使其与RL框架兼容。

- “少样本SFT + RL”是性价比最优路径:仅用少量专家数据进行SFT初始化,再通过RL进行在线优化,其性能可以超越全数据SFT,这为降低机器人学习的数据成本提供了有效途径。

- 并行仿真是大规模任务优化的基础:高效的并行训练架构是πRL能够成功处理数千种任务组合的关键,为迈向通用机器人操控奠定了工程基础。

未来方向

- 更优的噪声注入策略:当前的ODE-to-SDE转换仍存在微小的动作分布偏差。未来可以探索更先进的采样方法,进一步降低此偏差。

- 提升分布外(OOD)泛化:当前模型在语义新颖性等OOD场景下的性能提升有限,未来需要探索如何将RL与VLM的预训练知识更深度地融合。

- 真实世界迁移:目前实验均在仿真中完成,未来需验证πRL在真实机器人(如Shadow Hand、Unitree H1等)上的有效性和鲁棒性。

- 多模态融合:结合触觉、力觉等更多模态的观测信息,进一步提升模型在复杂物理交互场景(如抓取柔性或易碎物体)中的表现。

总结

πRL 的出现,成功打破了“流式VLA模型无法用RL优化”的固有认知。它没有选择将流式模型强行改造为自回归模型,而是通过创新的算法设计,让RL适配流式模型与生俱来的特性。对于追求“高灵巧性”和“大规模泛化”的通用机器人应用(如工业装配、家庭服务等)而言,πRL 提供了一条兼顾性能与实用性的清晰路径,有力地推动了“基础模型+强化学习+机器人控制”的跨领域融合,为通用机器人的发展注入了关键动力。

点击阅读原文,获取论文更多信息