【Dify】详细介绍+功能说明

一、介绍

1. Dify是什么?

Dify 是一个开源的大语言模型(LLM)应用开发平台,融合后端即服务(BaaS)与 LLMOps 理念,支持从原型设计到生产部署的全生命周期管理。

它运用智能化流程自动化与数据管理技术,帮助企业优化业务流程、提高工作效率,为多行业场景提供可靠的AI解决方案,助力数字化转型升级。

Dify安装与部署步骤见:https://blog.csdn.net/2401_84926677/article/details/154205900

2. 核心功能

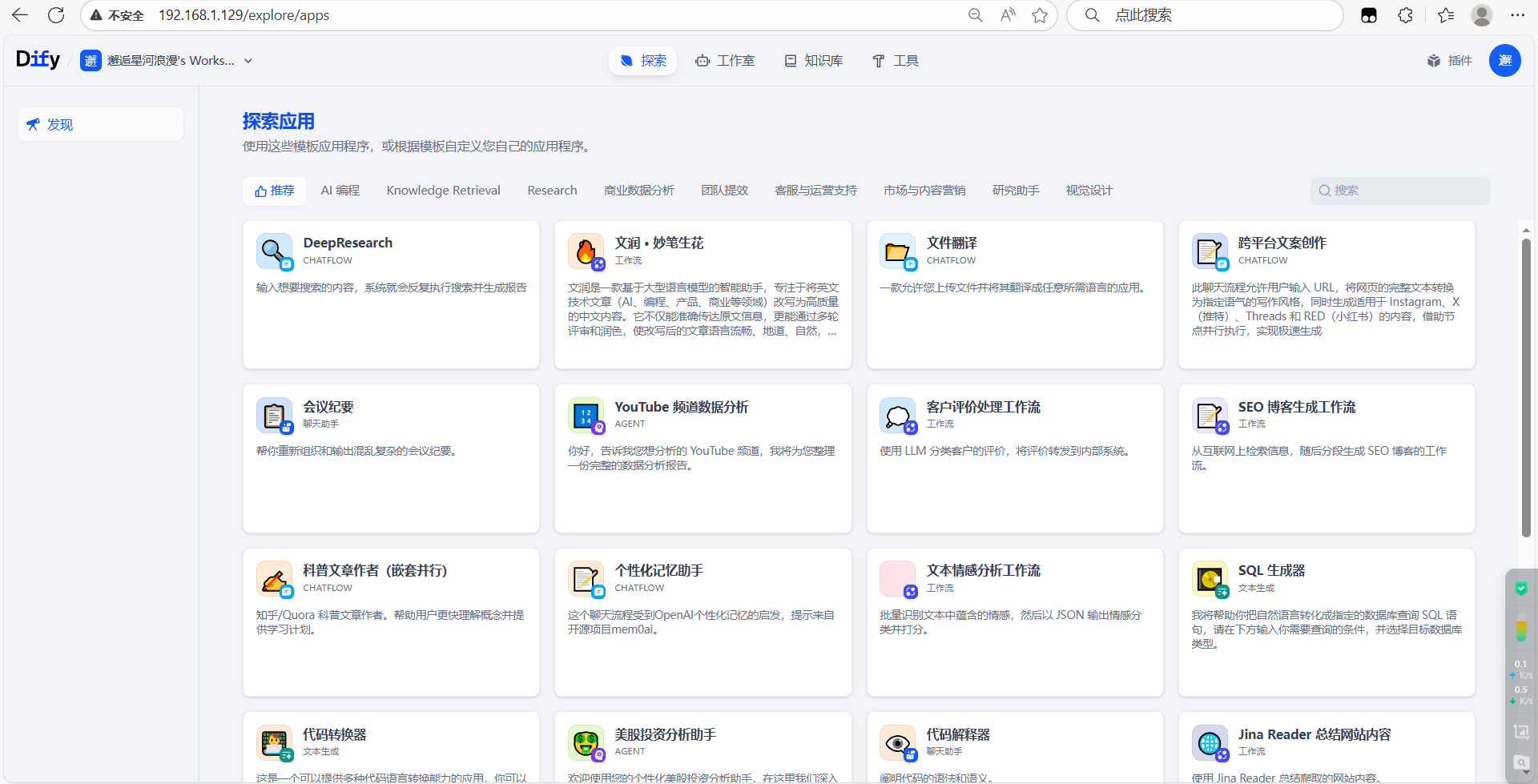

- 低代码/无代码开发:提供可视化的界面,允许用户通过拖拽、配置等方式定义 Prompt、上下文和插件,快速构建 AI 应用。

- 多模型支持:兼容主流大语言模型(LLM),如 DeepSeek、OpenAI、Anthropic、ChatGLM、通义千问等,并支持自定义模型接入。

- RAG(检索增强生成):结合外部知识检索与语言模型生成,提高回答的准确性和丰富度。

- 智能助手(Agent):支持构建具备自主任务规划和执行能力的智能助手,适用于财务分析、报告撰写、旅游规划等场景。

- 知识库管理:支持导入文本、PDF、PPT 等格式的文档,构建私有知识库,提升信息检索效率。

- 插件生态系统:内置丰富的工具和插件,支持自定义开发,扩展 AI 应用的功能。

- 部署灵活:支持云端托管和私有化部署,保障数据安全,适应不同规模和需求的用户。

3. 适用场景

- 企业应用:构建智能客服、知识问答系统、数据分析工具等,提高工作效率。

- 教育培训:辅助教学内容生成、课件制作,以及科研数据分析等。

- 内容创作:生成文章、摘要、代码,或解析长文档进行结构化提取。

- 个人助手:创建个性化的 AI 助手,处理日常任务,如日程安排、信息查询等。

4. 使用方式

- 访问 Dify 主页链接,注册并登录账号。

- 选择所需的模型和服务,配置相关参数。

- 通过可视化界面或 API 接口,开始构建和部署 AI 应用。

5. 为什么选择 Dify?

Dify 提供了一站式的 AI 应用开发解决方案,降低了技术门槛,加快了开发和部署的速度。其开源特性和活跃的社区支持,使其成为开发者和企业用户的理想选择。

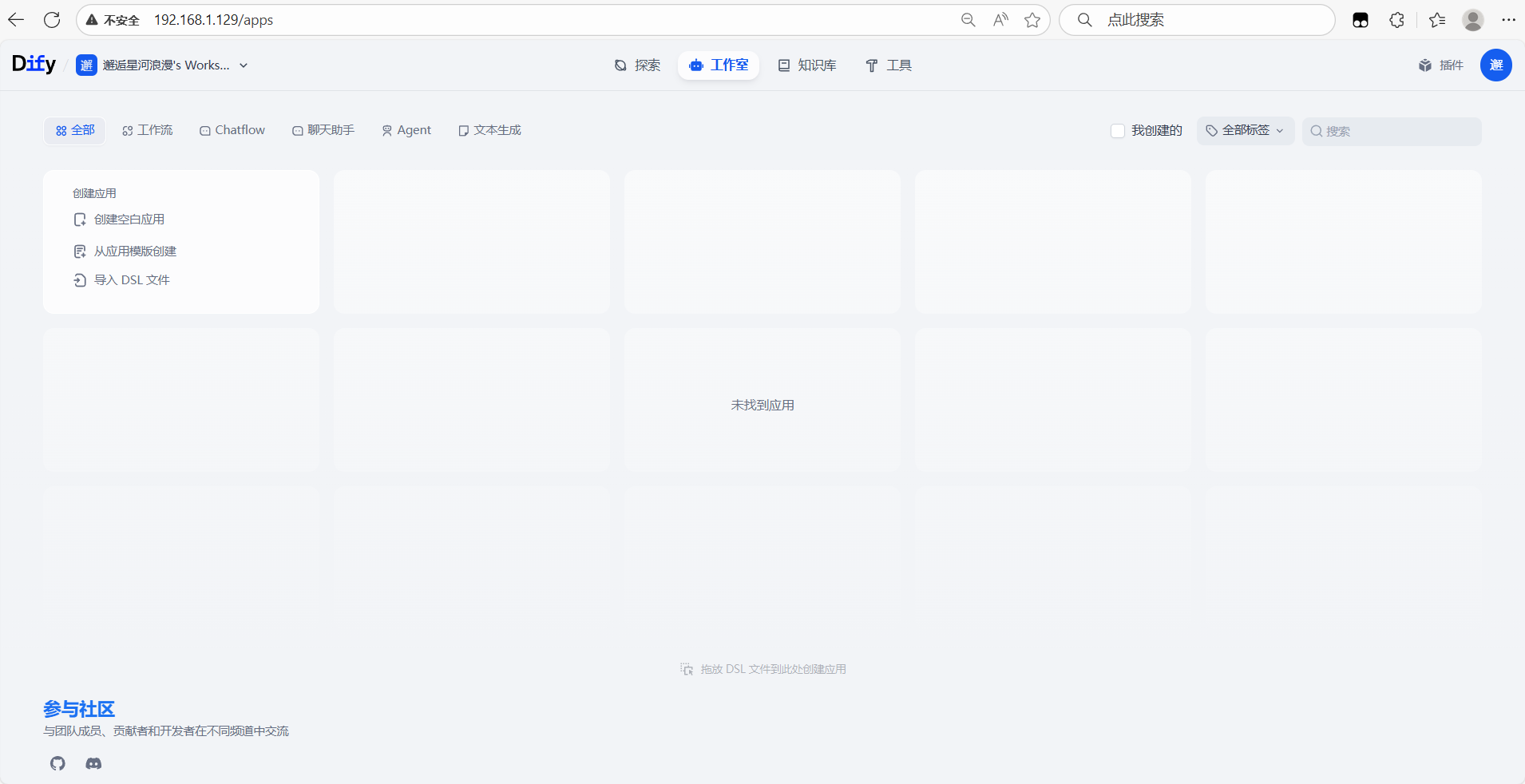

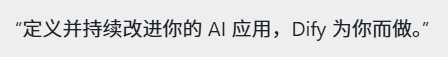

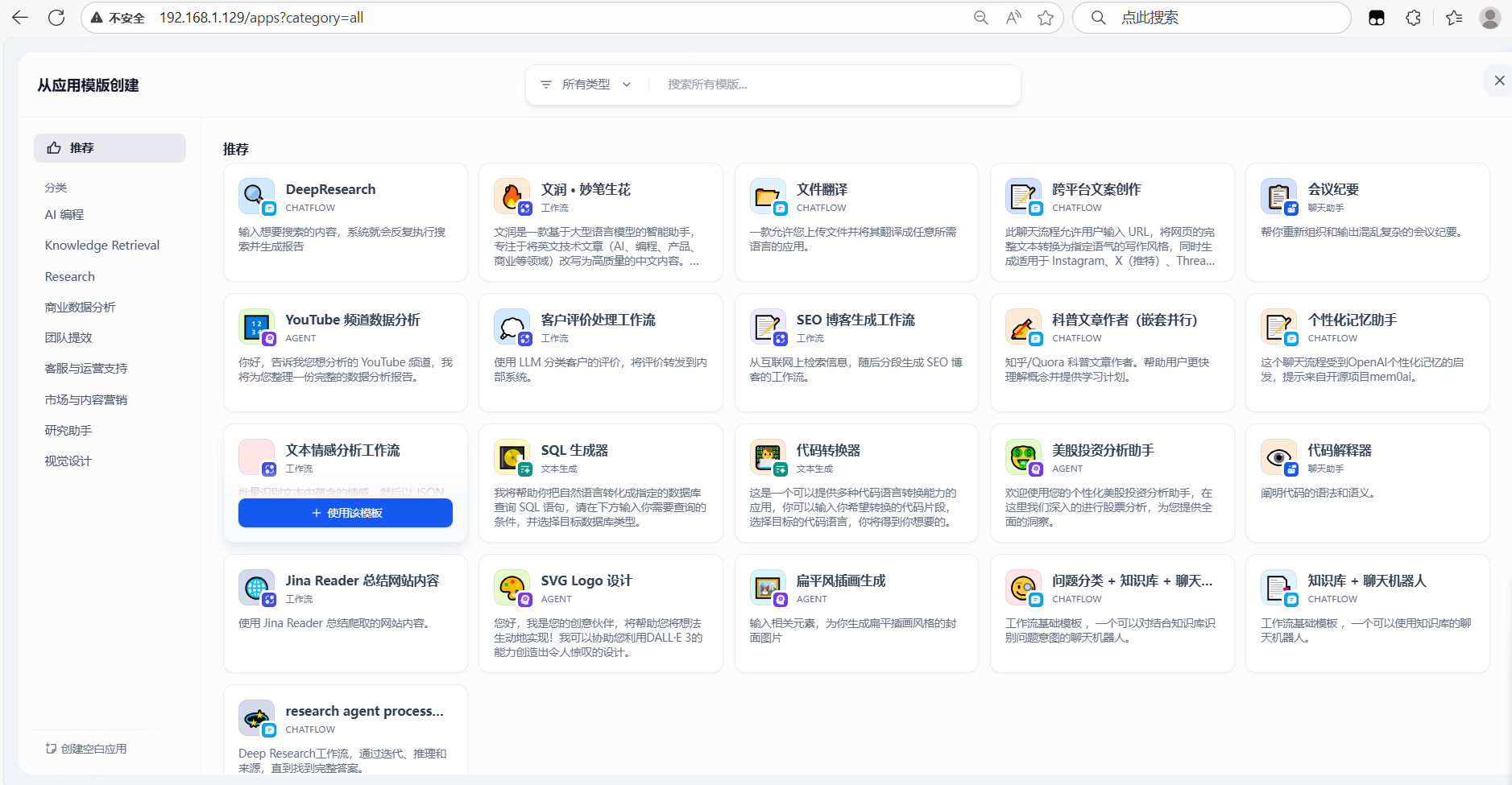

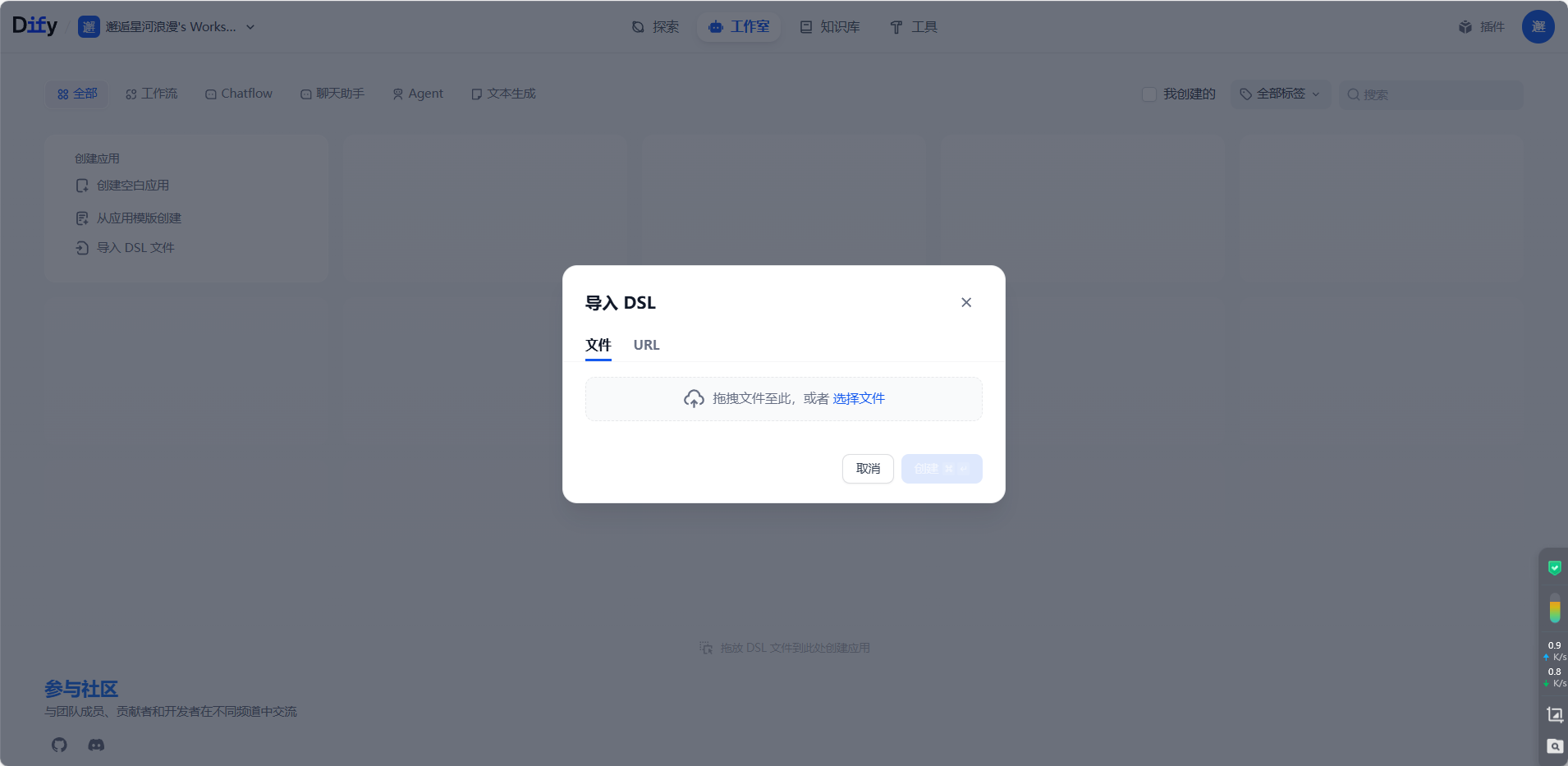

二、界面展示

三、Dify与其他相关技术的区别

| 维度 | Dify | LangChain | OpenAI API/ Claude API |

|---|---|---|---|

| 定位 | 开源 LLM 应用开发平台(全生命周期管理 + 低代码) | LLM 应用开发框架(工具链集成 + 编程式开发) | 纯模型 API(仅提供 LLM 能力) |

| 技术栈 | 前后端一体化(Next.js+Python),支持 Docker 一键部署,内置 LLMOps 监控 | Python 库,依赖开发者手动编写逻辑链 | 纯 API 调用,无开发平台 |

| 核心功能 | 低代码应用编排、可视化工作流、企业级 RAG、多模型管理、生产级监控 | 工具调用、多链管理、记忆机制、代理模式 | 仅提供大模型推理能力 |

| 使用门槛 | 低(可视化界面,支持无代码开发) | 中(需 Python 编程,理解链、代理等概念) | 低(仅需 API 调用,但需自行构建应用) |

| 生产就绪性 | 高(支持私有化部署、RBAC 权限、审计日志、千万级请求) | 中(需自行封装部署,缺乏企业级运维工具) | 中(需自行处理高并发、安全等问题) |

| 典型场景 | 企业智能客服、私有化知识库、多工具协同工作流、AI Agent 产品化 | 科研级复杂 Agent、多工具深度集成应用 | 简单聊天机器人、单轮文本生成 |

| 生态与扩展 | 自有插件市场 + 社区模板,支持对接任意 OpenAI 兼容模型、第三方 API | 生态丰富,支持数百种工具集成(如 SQL、网页爬取) | 仅依赖官方模型,无第三方扩展 |

-

Dify vs LangChain:

- Dify 是 “平台级” 解决方案 ,提供从开发到运维的全流程工具(可视化界面、监控、部署);

- LangChain 是 “框架级” 工具 ,需开发者手动编码实现逻辑,更适合技术团队深度定制。

- 例如:用 Dify 可拖拽搭建 “客服机器人 + 知识库” 应用;用 LangChain 需编写 Python 代码实现工具调用、记忆管理等逻辑。

-

Dify vs 纯大模型 API:

- Dify 是 “应用开发平台”,提供模型管理、工作流、知识库等上层能力;

- 纯 API 仅提供 LLM 推理,需开发者自行构建应用逻辑、前端界面、运维体系。

- 例如:用 Dify 可一键生成带 UI 的客服机器人;用 OpenAI API 需自行开发前端、处理会话管理、部署服务器。