《大模型导论》笔记——模型微调

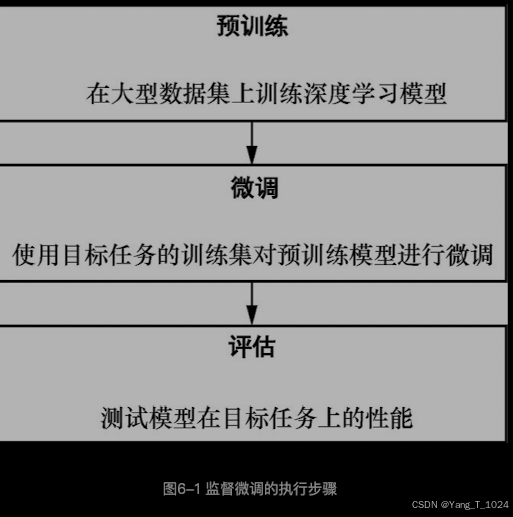

微调(fine-tuning)是一种在预训练语言模型的基础上使用目标任务数据进行训练的模型训练技术。

大模型首先在庞大的语料库进行自监督预训练,构建通用的基础模型。针对特定领域或特定任务,使用少量的额外的语料进行训练,以更好地适应特定领域或特定任务。

模型微调一般出现在大模型开发的后训练阶段。

emmm,拥有本国的大语言模型真的重要哇!~

监督微调的优势 能重复利用预训练模型的参数和结构,以及模型本身具有的相关知识,避免从头训练。

缺点依赖大量的标注数据,如果数据量不足,将导致微调效果大打折扣。

PEFT技术

宗旨是减少微调参数和降低计算复杂度来提升模型在特点任务的性能。lora,qlora等参数高效微调技术被相继提出。(看内容里面说用了矩阵, 再次感觉没有学好高数的匮乏,上学的时候考的分数也还可以,现在又还给老师了,想好好学习一下高数,有一段时间老做噩梦,梦见被老师上课提问高数,emmm,为了我做梦时间的幸福生活,有必要重新好好学一下数学 ~!要不然做梦了也没放过我,emmm)