GRPO相关优化论文

目录

SEED-GRPO: Semantic Entropy Enhanced GRPO for Uncertainty-Aware Policy Optimization

一、核心动机:基础 GRPO 的痛点

二、核心方法:引入 “语义熵” 实现 “不确定性感知的策略更新”

1. 计算 “语义熵”:量化模型对提示的不确定性

2. 基于语义熵调节 “策略更新幅度”

3. 保持 GRPO 核心优势,仅增强 “更新针对性”

基于语义熵的聚类方法

一、聚类的核心目的:给 “不确定性分组”,优化更新效率

二、聚类的具体实现:基于语义熵的 “软聚类” 逻辑

三、聚类的关键价值:连接 “不确定性分组” 与 “高效优化”

语义熵的优势:聚焦 “语义等价”,修正不确定性误判

总结

GFPO- Group Filtered Policy Optimization:

背景:

GFPO的流程可以分解为三个步骤:

GFPO使用的关键度量

实验结论:

TREE SEARCH FOR LLM AGENT REINFORCEMENT LEARNING

SEED-GRPO: Semantic Entropy Enhanced GRPO for Uncertainty-Aware Policy Optimization

SEED-GRPO(Semantic Entropy Enhanced GRPO)是对基础 GRPO 的关键改进,核心是通过引入 “语义熵” 量化模型对输入提示的不确定性,让策略优化更精准地匹配 “模型对任务难度的感知”,解决了基础 GRPO 中 “对所有提示采用相同更新幅度” 的局限性。(相当于在损失函数进行难度加权)

一、核心动机:基础 GRPO 的痛点

基础 GRPO 在策略更新时,会对所有输入提示(prompt)采用 “无差别的更新幅度”,忽略了一个关键问题:模型对不同提示的 “不确定性” 存在差异。

- 例如,面对 “简单数学题”(如 1+1=?),模型不确定性低,已有稳定的正确输出能力;

- 面对 “复杂推理题”(如多步微积分),模型不确定性高,输出波动大,更需要针对性优化。这种 “一刀切” 的更新方式,会导致简单提示的策略过度更新(可能过拟合)、复杂提示的策略更新不足(难以提升),最终影响整体性能。

二、核心方法:引入 “语义熵” 实现 “不确定性感知的策略更新”

SEED-GRPO 的核心创新是将 “语义熵(Semantic Entropy)” 作为 “策略更新幅度的调节因子”,让模型根据自身对提示的不确定性,动态调整更新强度。具体可拆解为 3 个关键步骤:

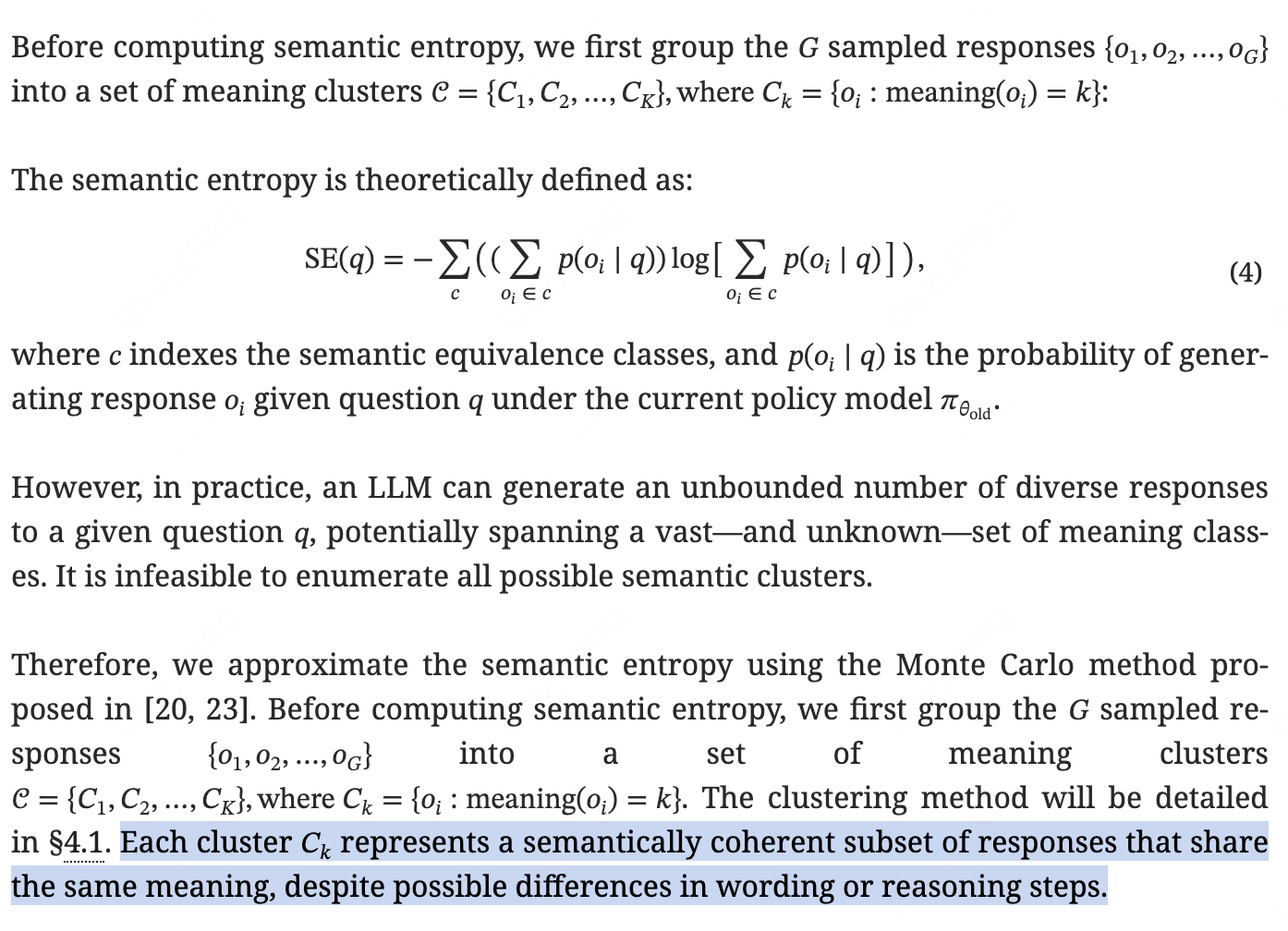

1. 计算 “语义熵”:量化模型对提示的不确定性

“语义熵” 的本质是衡量模型生成结果的 “多样性 / 波动程度”—— 结果越多样(波动大),说明模型对该提示的不确定性越高,语义熵越大;反之则不确定性低,语义熵越小。具体计算方式:

- 让当前策略对某个提示 q 生成一批候选输出(如 10 个结果);

- 计算这批输出的 “分布多样性”(常用方法:通过模型对输出的概率分布计算熵,或通过文本嵌入向量的余弦相似度衡量离散程度);

- 最终得到该提示 q 对应的 “语义熵 H (q)”,H (q) 越大→模型对 q 的不确定性越高。

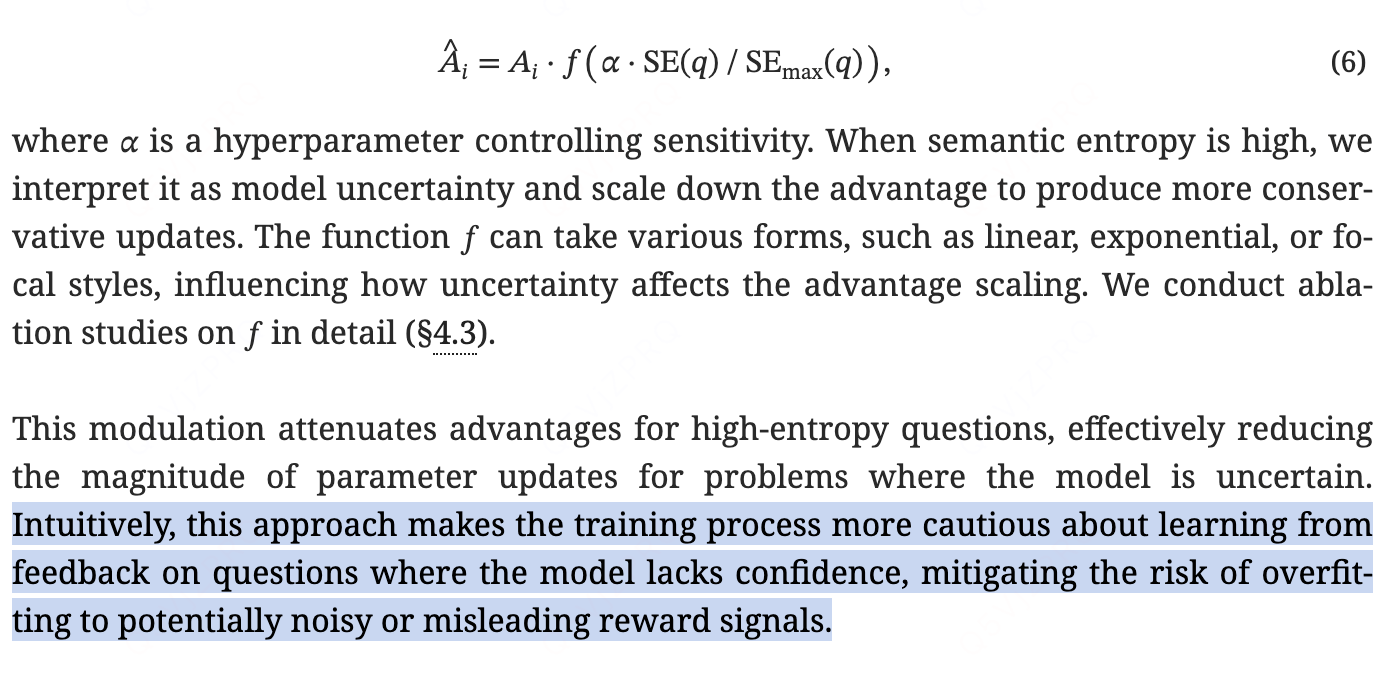

2. 基于语义熵调节 “策略更新幅度”

SEED-GRPO 在基础 GRPO 的损失函数中,加入 “语义熵调节项”,核心逻辑是:

- 高语义熵(H (q) 大)→ 模型对 q 不确定性高→ 增大策略更新幅度:此时模型需要更积极的优化来降低不确定性,提升正确概率;

- 低语义熵(H (q) 小)→ 模型对 q 不确定性低→ 减小策略更新幅度:此时模型已有稳定表现,过度更新易导致过拟合,需 “微调” 而非 “大改”。

具体实现上,通过语义熵 H (q) 动态调整 GRPO 中的 “KL 散度正则化强度 β” 或 “奖励校准权重 Ωε(p)”—— 本质是让更新幅度与模型不确定性 “正相关”,实现 “不确定性 - aware” 的精准优化。

3. 保持 GRPO 核心优势,仅增强 “更新针对性”

SEED-GRPO 并非推翻基础 GRPO,而是在其框架内做 “增量改进”:

- 保留基础 GRPO 的 “奖励校准(均值 - 方差调整)”“不动点迭代”“成功概率放大” 等核心机制;

- 仅通过 “语义熵” 为不同提示分配 “差异化更新资源”,让优化更聚焦于 “真正需要改进的高不确定性提示”,避免资源浪费在低不确定性提示上。

基于语义熵的聚类方法

每个聚类Ck代表语义一致的回答子集,这些回答具有相同的含义,尽管措辞或推理步骤可能存在差异。

此调制减弱了高熵问题的优势,有效地减少了模型不确定的问题参数更新的幅度。 直观地说,这种方法使训练过程在从模型缺乏信心的问题的反馈中学习时更加谨慎,从而减轻了过度拟合潜在噪声或误导性奖励信号的风险。

SEED-GRPO 确实引入了基于语义熵的聚类方法,但它并非传统意义上的 “无监督聚类任务”,而是服务于 “不确定性感知的策略优化”—— 核心是通过聚类将 “语义熵相似的提示(prompt)” 归为一类,让策略能对 “同一不确定性水平的任务” 采用更统一、更精准的更新策略,进一步解决基础 GRPO “单提示单更新” 可能导致的效率低、波动大问题。

一、聚类的核心目的:给 “不确定性分组”,优化更新效率

SEED-GRPO 引入聚类的直接动机是:基础 GRPO 虽能通过语义熵为 “单个提示” 调节更新幅度,但实际任务中存在大量 “语义熵相近、不确定性水平一致” 的提示(比如一批难度相当的初中数学题)。若对这些提示逐一计算语义熵并单独调节,会增加计算成本,且易因单个提示的随机波动(如偶然生成错误结果)导致更新策略不稳定。

因此,聚类的核心作用是 **“批量聚合相似不确定性的提示”**:将语义熵落在同一区间的提示归为一个 “不确定性簇(Uncertainty Cluster)”,对同一簇内的提示采用 “相同的更新幅度调节规则”,既降低计算量,又通过 “批量平均” 减少单提示随机波动的影响。

二、聚类的具体实现:基于语义熵的 “软聚类” 逻辑

SEED-GRPO 的聚类并非严格的 “硬划分”(如 K-Means 的明确类别归属),而是更灵活的 “软聚类”,具体步骤可拆解为:

- 计算所有提示的语义熵:对任务数据集中的所有提示 q,按 SEED-GRPO 的核心方法计算各自的语义熵 H (q)(衡量模型对 q 的不确定性)。

- 确定聚类区间(簇划分依据):根据所有 H (q) 的分布,划分出若干个 “语义熵区间” 作为聚类簇。

- 例如,若 H (q) 的取值范围是 [0, 1],可划分为 3 个簇:低不确定性簇(H∈[0, 0.3])、中不确定性簇(H∈[0.3, 0.7])、高不确定性簇(H∈[0.7, 1]);

- 区间划分通常通过 “统计 H (q) 的分位数” 实现(如 33%、67% 分位数),确保每个簇内的提示数量相对均衡。

- 簇内统一调节更新幅度:对同一簇内的所有提示,采用 “相同的语义熵调节系数” 来调整 GRPO 的策略更新幅度。

- 例如,高不确定性簇(H 大)的调节系数设为 1.2(放大更新幅度,重点优化),低不确定性簇的调节系数设为 0.8(缩小更新幅度,避免过拟合),中不确定性簇设为 1.0(常规更新)。

三、聚类的关键价值:连接 “不确定性分组” 与 “高效优化”

SEED-GRPO 的聚类不是为了 “分类任务”,而是为了让 “不确定性感知的更新策略” 更落地,具体价值体现在两点:

- 降低计算成本:无需对每个提示单独优化调节系数,只需为每个簇计算一套系数,尤其在提示数量庞大的任务中(如百万级文本生成数据),能显著减少计算量。

- 提升更新稳定性:同一簇内的提示语义熵相近,批量调节可 “平滑掉单个提示的随机误差”(如某单个提示因采样随机性导致 H (q) 异常偏高 / 偏低),避免策略为 “异常提示” 做出不合理的更新。

语义熵的优势:聚焦 “语义等价”,修正不确定性误判

语义熵的核心改进是将 “token 序列层面的分布” 升级为 “语义层面的分布”,通过 “先聚类语义、再计算熵” 的逻辑,解决普通信息熵的局限:

- 第一步 “语义聚类”:对模型生成的多个结果,先通过语义相似度(如文本嵌入向量的余弦相似度)将 “含义相同的结果” 归为同一簇(无视表述形式差异);

- 第二步 “计算熵值”:基于 “语义簇的分布” 计算熵 —— 若大部分结果落入同一个语义簇(语义一致),即使 token 序列不同,熵值仍会很低(正确反映 “模型不确定性低”);若结果分散在多个语义簇(语义混乱),则熵值高(正确反映 “模型不确定性高”)。

总结

SEED-GRPO 中的聚类方法是其 “语义熵增强” 逻辑的延伸 —— 本质是通过 “语义熵区间划分” 将提示按不确定性分组,让策略更新从 “单提示精准调节” 升级为 “簇级批量优化”,既保留了 “不确定性感知” 的核心优势,又解决了实际应用中的效率与稳定性问题,是连接理论改进与工程落地的关键设计。

GFPO- Group Filtered Policy Optimization:

背景:

不是越长的response越准确,grpo增加了长response的奖励(某些问题response更长准确率越高,但是整体来看其也可能带来负向收益),导致模型“话痨”。

GFPO的目的就是降低response的长度同时提升准确率,学习到“简洁”偏好具有良好的泛化性,能够迁移到新的领域,避免不必要的冗长。

本质:通过制作和优化目标一致的训练数据来达到目的(提升短且准确的数据量)。

实验做的很充分,在不同问题分类下进行了统计比较。

GFPO的流程可以分解为三个步骤:

- 扩大采样(Sample More): 对于每个问题 q,不再像标准GRPO那样采样 G 个回答,而是采样一个更大的组,例如 G′ 个(G′>G)。这增加了池中出现具有理想特质(如简短且正确)的回答的概率。

- 度量驱动的过滤(Filter): 定义一个或多个我们关心的度量(metric),例如“回答长度”或“词元效率”。根据这些度量,从 G′ 个回答中筛选出最好的 k 个,形成一个保留子集 S。

- 选择性学习(Learn Selectively): 只在这个保留子集 S 内部计算优势和策略梯度。所有被过滤掉的(G′−k 个)回答,它们的优势被强制设为零,不参与模型的参数更新。

这个过程就像一位严格的老师,他让学生们尝试多种解题方法,但只对那些最简洁、最高效的解法进行点评和指导,而对那些冗长拖沓的解法直接忽略。通过这种方式,模型被引导向我们期望的行为方向发展。

这种数据过滤的方法,可以看作是一种隐式的奖励塑造(Implicit Reward Shaping)。我们不需要设计复杂的、包含长度惩罚项的奖励函数,而是通过直接选择“好”的样本,间接地将“简洁性”这个偏好注入到学习过程中。

GFPO使用的关键度量

虽然GFPO框架可以集成任何度量,但本论文主要关注两个旨在减少长度膨胀的度量:

- 响应长度(Response Length): 最直接的度量。在过滤步骤中,直接选择 k 个最短的回答进行学习。这直接鼓励模型生成更简洁的输出。

- 词元效率(Token Efficiency): 定义为 奖励 / 长度(reward / length)。这个度量更加精妙。它不仅奖励简短,更奖励“物有所值”的长度。一个回答可以很长,但只要它能带来相应的高额奖励,它的词元效率就可能很高。反之,一个中等长度但答案错误的回答,其词元效率会非常低。这个度量旨在鼓励模型在简洁和有效之间找到最佳平衡。

实验结论:

- 准确率保持稳定: 使用威尔科克森符号秩检验(Wilcoxon signed-rank test)进行统计分析,结果显示GFPO各个变体与基线GRPO之间的准确率差异在统计上不显著。这意味着GFPO在削减长度的同时,成功地保留了GRPO带来的核心推理能力。在某些情况下,如Omni-MATH,GFPO的准确率甚至略有提升。

- 长度显著缩减: 所有GFPO变体都大幅降低了响应长度。

- 基于长度(Shortest k/G)的GFPO,在G=24,k=4的设置下,对GRPO的超额长度缩减率(ELR)在AIME 25上达到46.1%,在GPQA上达到57.3%,在Omni-MATH上达到71%。

- 基于词元效率(Token Efficiency)的GFPO表现最为出色,在所有任务上都取得了最大的长度缩减。其平均ELR高达79.5%,在AIME 24上甚至达到了84.6%。

- “多看”是“少想”的前提: 作者进行了一项消融实验,只在GRPO的原始采样组(G=8)中进行过滤(例如,Shortest 6/8 GFPO)。结果发现长度缩减效果非常有限。这证实了GFPO的核心假设:必须通过扩大采样(

G↑)来增加候选池的多样性,才能有效地筛选出简洁且优秀的回答。简单的“少学”而不“多看”是行不通的。

https://baijiahao.baidu.com/s?id=1840406163708848590&wfr=spider&for=pc

https://zhuanlan.zhihu.com/p/1939843423994610732

TREE SEARCH FOR LLM AGENT REINFORCEMENT LEARNING

https://arxiv.org/pdf/2509.21240