YOLO-World: Real-Time Open-Vocabulary Object Detection论文阅读

摘要

YOLO系列检测器凭借高效实用的特性已获得广泛应用。然而,其依赖预定义训练对象类别的局限性,制约了其在开放场景中的应用。针对这一缺陷,提出YOLO-World创新方案——通过视觉-语言建模和大规模数据预训练,赋予YOLO开放词汇检测能力。

具体而言,开发了可重参数化视觉语言路径聚合网络(RepVL-PAN)和区域-文本对比损失函数,有效促进视觉与语言信息的交互。该方法在零样本检测场景中展现出卓越性能,能高效识别各类物体。

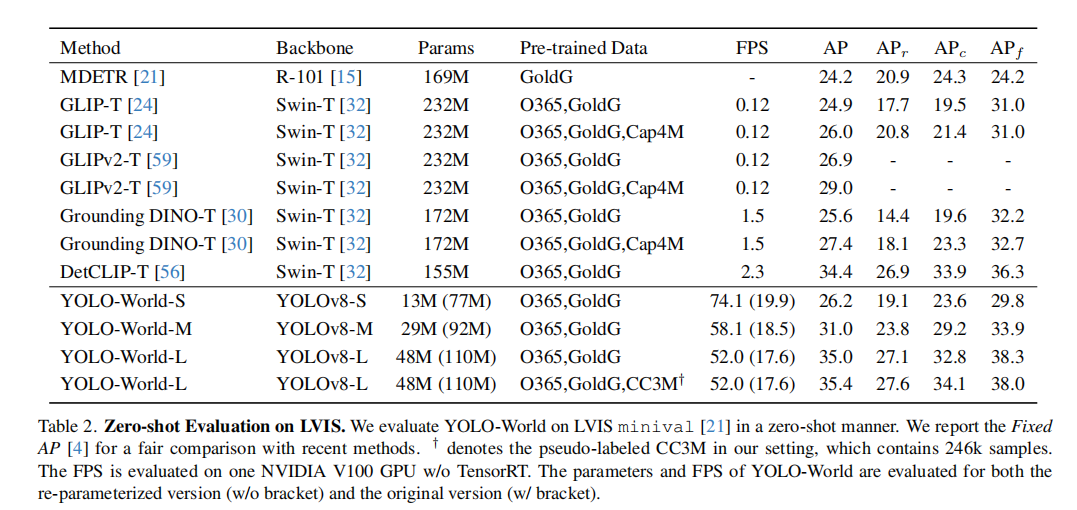

在具有挑战性的LVIS数据集上,YOLO-World在V100架构上实现35.4 AP值和52.0帧率,其精度与速度均超越多项前沿方法。经过微调的YOLO-World在目标检测、开放词汇实例分割等下游任务中也取得了显著成效。

引言

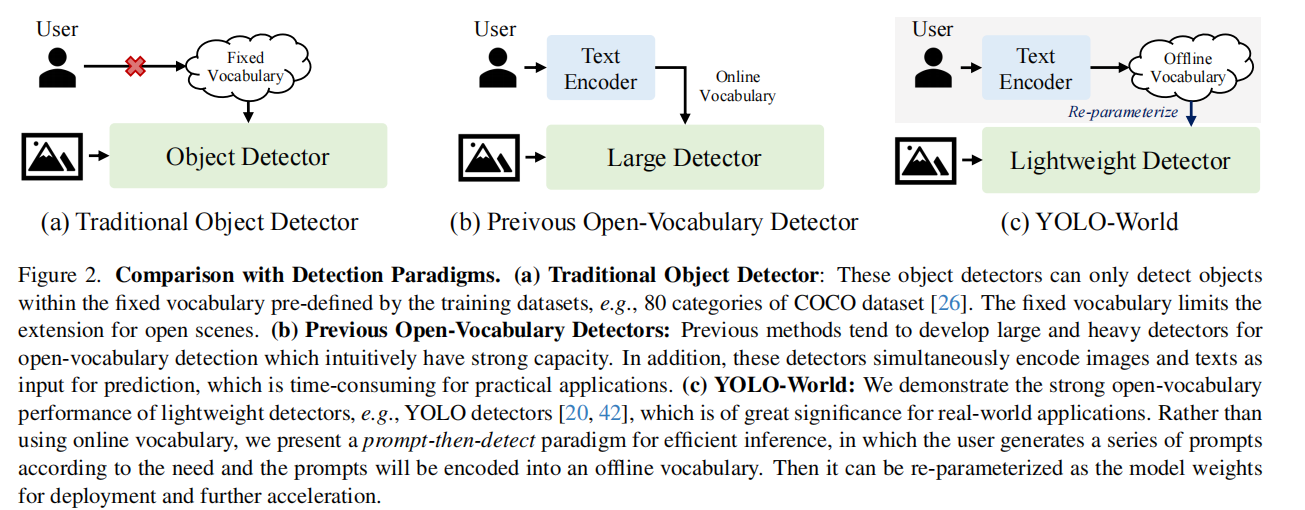

物体检测作为计算机视觉领域长期存在的基础性难题,已在图像理解、机器人技术及自动驾驶汽车等领域得到广泛应用。随着深度神经网络的发展,大量研究[16,27,43,45]在该领域取得重大突破。然而这些方法仍存在局限性,因其仅支持固定词汇量的检测,例如COCO数据集[26]中仅包含80个类别。一旦完成物体类别的定义与标注,训练好的检测器便只能识别这些特定类别,这极大限制了其在开放场景三维应用范围和实际价值。

近期研究[8,13,48,53,58]通过探索主流视觉-语言模型[19,39],尝试从BERT[5]等语言编码器中提炼词汇知识来解决开放词汇检测[58]问题。然而,由于训练数据稀缺且词汇多样性有限(例如仅包含48个基础类别的OV-COCO[58]),这些基于知识蒸馏的方法存在明显局限。部分研究[24,30,56,57,59]将目标检测训练重新定义为区域级视觉-语言预训练,并实现了大规模开放词汇目标检测器的训练。但这些方法在应对现实场景检测时仍面临双重挑战:(1)计算负担过重,(2)边缘设备部署复杂。先前工作预训练大型检测器展现出良好性能,而针对小型检测器进行预训练以赋予其开放识别能力的研究仍属空白。

本文提出YOLO-World框架,致力于实现高效开放词汇量目标检测,并探索大规模预训练方案以推动传统YOLO检测器迈向新开放词汇量时代。相较于现有方法,我们提出的YOLO-World展现出显著优势:推理速度更快、部署更便捷。具体而言,该框架沿用标准YOLO架构[20],并采用预训练CLIP[39]文本编码器进行输入文本编码。我们进一步提出可重参数化视觉-语言路径聚合网络(RepVL-PAN),通过连接文本特征与图像特征实现更优的视觉-语义表征。在推理阶段,可移除文本编码器并将文本嵌入重新参数化为RepVL-PAN权重,实现高效部署。通过大规模数据集上的区域-文本对比学习,我们验证了开放词汇量预训练方案的有效性——该方案将检测数据、定位数据和图像-文本数据统一为区域-文本对。经过大量区域-文本对预训练的YOLO-World展现出强大的大词汇量检测能力,且更多训练数据能显著提升开放词汇量检测性能。

此外,我们探索了提示-检测范式,进一步优化了现实场景中开放词汇量目标检测的效率。如图2所示,传统目标检测器[16,20,23,41-43,52]主要采用固定词汇量(闭集)检测方式,依赖预定义且经过训练的类别。而早期的开放词汇量检测器[24,30,56,59]则通过文本编码器将用户输入的提示转化为在线词汇库进行目标检测。值得注意的是,这类方法往往采用大型检测器搭配复杂骨干网络(如Swin-L[32])来提升开放词汇量处理能力。相比之下,提示-检测范式(图2©)采用“先编码提示构建离线词汇库”的创新思路:首先通过用户输入提示构建可动态调整的离线词汇库,随后高效检测器无需重新编码提示即可实时调用该词汇库。在实际应用中,当检测器完成训练(如YOLO-World)后,我们可预先编码提示或类别构建离线词汇库,并将其无缝集成到检测器中。

贡献及创新内容:

我们推出YOLO-World,这是一款面向现实应用的高效前沿开放式词汇量目标检测器。

我们提出可重构视觉-语言PAN架构,将视觉与语言特征深度融合,并为YOLO-World设计开放式词汇量区域-文本对比预训练方案。

该预训练模型在大规模数据集上展现出卓越的零样本性能,在LVIS数据集上以52.0帧率获得35.4的平均精度。预训练的YOLO-World可轻松适配下游任务,例如开放式词汇量实例分割和指代对象检测。此外,YOLO-World的预训练权重和代码将开源共享,助力更多实际应用落地。

相关文献

传统目标检测

当前主流的物体检测研究聚焦于固定词汇量(闭集)检测,这类方法通过使用预定义类别数据集(如COCO数据集[26]和Objects365数据集[46])训练检测器,使其只能识别预设类别范围内的物体。过去几十年间,传统物体检测方法主要分为三大类:基于区域的方法、基于像素的方法和基于查询的方法。基于区域的方法[11,12,16,27,44](如Faster R-CNN[44])采用两阶段框架,先生成候选区域[44],再进行感兴趣区域分类与回归。基于像素的方法[28,31,42,49,61]多为单阶段检测器,通过预设锚点或像素进行分类与回归。DETR[1]首次尝试使用Transformer[50]进行物体检测,由此催生了大量基于查询的方法[64]。在推理速度方面,Redmon等人提出的YOLOs[40-42]通过简单卷积架构实现实时检测。后续研究[10,23,33,52,55]针对YOLO提出多种改进方案,包括路径聚合网络[29]、跨阶段部分网络[51]和参数重置[6],显著提升了检测速度与精度。与传统YOLO相比,本文提出的YOLOWorld致力于突破固定词汇量限制,通过强大的泛化能力实现更广泛的物体检测。

开放词汇目标检测

开放词汇量目标检测(OVD)[58]已成为现代目标检测领域的新趋势,其核心目标是突破预定义类别的限制,实现对未知类别的检测。早期研究[13]沿用了标准的OVD设置[58],通过在基础类别上训练检测器,并评估其对新类别(未知类别)的识别能力。尽管这种开放词汇量设置能够检验检测器对新对象的识别能力,但由于训练数据集和词汇量有限,该方法在开放场景下的应用仍存在局限性,且难以实现跨领域的泛化能力。

基于视觉-语言预训练方法[19,39]鼓舞,近期研究[8,22,53,62,63]将开放词汇量目标检测转化为图像-文本匹配任务,并通过大规模图像-文本数据来扩展训练词汇量。OWLViT系列模型[35,36]通过检测与定位数据集对基础视觉Transformer[7]进行微调,构建出性能优异的开放词汇量检测器。GLIP[24]提出基于短语定位的开放词汇量检测预训练框架,并在零样本场景下进行评估。Grounding DINO[30]将定位预训练[24]融入检测Transformer[60],实现跨模态融合。多项研究[25,56,57,59]通过区域-文本匹配统一检测数据集与图像-文本数据集,并利用大规模图像-文本对预训练检测器,取得显著性能提升与泛化能力。然而这些方法常采用ATSS[61]或DINO[60]等重型检测器,搭配Swin-L[32]作为骨干网络,导致计算成本高昂且部署困难。与现有方法形成鲜明对比的是,我们提出的YOLO-World框架致力于实现高效开放词汇量目标检测,不仅支持实时推理,还能更便捷地部署下游应用。该框架与ZSD-YOLO[54]存在显著差异——后者虽也通过语言模型对齐技术探索了YOLO的开放词汇量检测[58],但YOLO-World创新性地构建了包含高效预训练策略的YOLO框架,从而显著提升了开放-3视觉-语言PAN词汇量检测的性能和泛化能力。

方法

预训练—区域-文本配对

传统目标检测方法包括yolo系列是基于标注框和标注签开展训练,本文将实例标注重新定义为区域-文本对Ω={Bi,ti}(i=1,…,N),其中ti是对应区域Bi的文本描述。具体而言,ti可包含类别名称、名词短语或物体描述。YOLO-World模型同时接收图像I和文本集合T(由名词构成),并输出预测框{Bˆ_k}及其对应的物体嵌入向量{e_k}(其中e_k∈ℝ^D)。

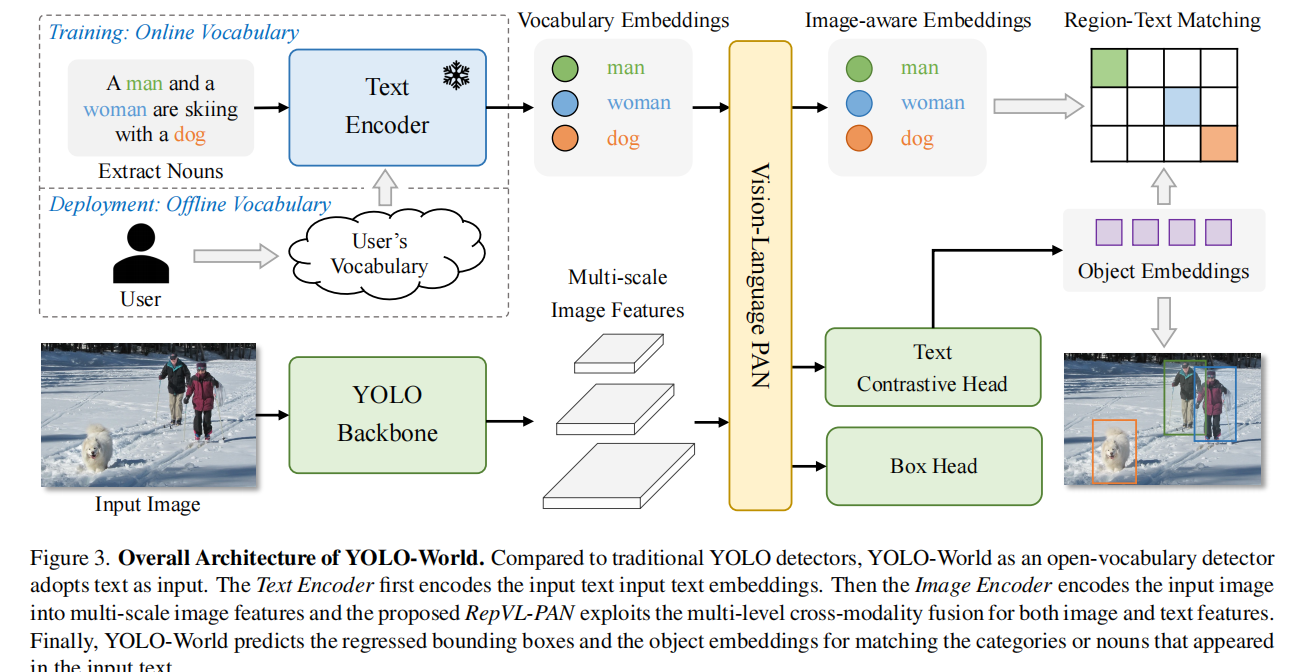

模型架构

图3展示了YOLO-World的整体架构,该架构由YOLO检测器、文本编码器和可重参数化视觉-语言路径聚合网络(RepVL-PAN)组成。当输入文本时,YOLO-World中的文本编码器会将其编码为文本嵌入向量。YOLO检测器中的图像编码器则从输入图像中提取多尺度特征。随后,我们通过RepVL-PAN利用图像特征与文本嵌入之间的跨模态融合,增强文本和图像的表征效果。

YOLO检测器。YOLO-World主要基于YOLOv8[20]开发,该模型包含暗网主干网络[20,43]作为图像编码器、用于多尺度特征金字塔的路径聚合网络(PAN),以及负责边界框回归和物体嵌入的头部。

文本编码器。对于输入文本T,我们采用CLIP[39]预训练的Transformer文本编码器来提取对应的文本嵌入向量W=TextEncoder(T)∈R^C×D,其中C表示名词数量,D为嵌入维度。相较于纯文本语言编码器[5],CLIP文本编码器在连接视觉对象与文本方面具有更强的视觉-语义能力。当输入文本为标题或指代表达时,我们采用简单的n-gram算法提取名词短语,再将其输入文本编码器。

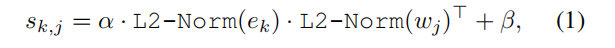

文本对比头。基于先前研究[20],我们采用解耦头架构,通过两个3×3卷积层分别回归边界框{bk}K k=1和对象嵌入向量{ek}K k=1(其中K表示对象数量)。我们提出文本对比头,通过该模块获取对象与文本之间的相似度sk,j。

其中L2-Norm(·)表示L2范数,wj∈W表示第j个文本嵌入向量。此外,我们还引入了包含可学习缩放因子α和偏移因子β的仿射变换。L2范数与仿射变换对稳定区域-文本训练至关重要。

在线词典训练:在训练过程中,我们为每个包含4张图像的马赛克样本构建在线词典T。具体而言,我们会从马赛克图像中采样所有相关阳性名词,并从对应数据集中随机抽取部分阴性名词。每个马赛克样本的词典最多包含M个名词,默认设置为80个。

离线词典推理:在推理阶段,我们采用“提示-检测”策略配合离线词典以提升效率。如图3所示,用户可自定义包含标题或分类等元素的提示序列。随后通过文本编码器对这些提示进行编码,生成离线词典嵌入向量。离线词典不仅避免了对每个输入进行计算,还提供了根据需求调整词典的灵活性。

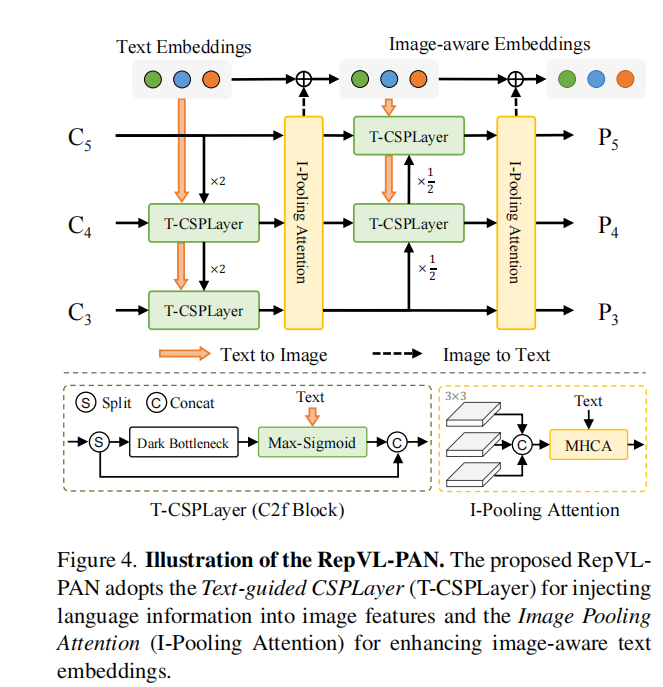

Re-parameterizable Vision-Language PAN

图4展示了我们提出的RepVL-PAN结构,该结构沿袭了文献[20,29]中的自上而下和自下而上路径,通过多尺度图像特征{C3,C4,C5}构建特征金字塔{P3,P4,P5}。此外,我们提出文本引导卷积空间池化层(T-CSPLayer)和图像池化注意力机制(I-Pooling Attention),进一步增强图像特征与文本特征的交互作用,从而提升开放词汇量能力下的视觉-语义表征效果。在推理阶段,离线词汇表嵌入可被重新参数化为卷积层或线性层的权重以供部署。

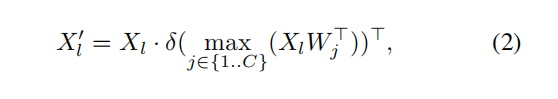

如图4所示,跨阶段部分层(CSPLayer)在自上而下或自下而上融合后被采用。我们通过将文本引导融入多尺度图像特征,扩展了文献[20]中的CSPLayer(亦称C2f),形成文本引导CSPLayer。具体而言,给定文本嵌入W和图像特征Xl∈R^{H×W×D}(l∈{3,4,5}),我们在最后一个暗通道瓶颈块后采用最大值Sigmoid注意力机制,通过以下方式将文本特征聚合到图像特征中:

更新后的Xl′与跨阶段特征拼接后作为输出。δ表示Sigmoid函数。

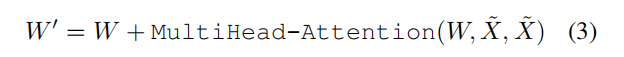

图像池化注意力机制。为增强文本嵌入的图像感知能力,我们提出图像池化注意力机制,通过聚合图像特征来更新文本嵌入。不同于直接对图像特征进行交叉注意力机制,我们采用多尺度特征的最大池化处理,生成3×3区域,最终得到27个补丁标记X˜∈R²⁷×D。随后通过以下方式更新文本嵌入:

预训练策略

基于区域-文本对比损失的学习。给定马赛克样本I和文本T,YOLO-World输出K个物体预测{Bk,sk}(k=1)以及标注Ω={Bi,ti}(i=1)。我们沿用[20]的研究方法,采用任务对齐标签分配[9]将预测结果与真实标注匹配,并为每个正向预测分配文本索引作为分类标签。基于此词汇表,我们通过计算物体-文本(区域-文本)相似度与物体-文本分配之间的交叉熵,构建了区域-文本对比损失Lcon。此外,我们采用交并比损失和分布式焦点损失进行边界框回归,总训练损失定义为:L(I)=Lcon+λI·(Liou+Ldfl),其中λI为权重因子,当输入图像I来自检测或定位数据时设为1,来自图像-文本数据时设为0。考虑到图像-文本数据集存在边界框噪声,我们仅对边界框准确的样本计算回归损失。

基于图像-文本数据的伪标注方法。提出了一种自动标注方案,通过生成区域-文本对替代直接使用图像-文本对进行预训练。该方法包含三个步骤:(1)名词短语提取:首先利用n-gram算法从文本中提取名词短语;(2)伪标注:采用预训练的开放词汇检测器(如GLIP[24])为每张图像的名词短语生成伪框,从而提供粗略的区域-文本对;(3)过滤:运用预训练的CLIP[39]评估图像-文本对及区域-文本对的相关性,过滤低相关性伪标注和图像。我们进一步通过非极大值抑制(NMS)等方法过滤冗余边界框。具体实现细节请参阅附录。通过上述方法,我们从CC3M[47]数据集中采样并标注了24.6万张图像,生成82.1万条伪标注。

实验

预训练

实验设置

实验设置。在预训练阶段,我们采用AdamW优化器[34],初始学习率为0.002,权重衰减系数为0.05。YOLO-World模型在32块NVIDIA V100显卡上进行100个epoch的预训练,总批量大小为512。预训练过程中,我们沿用先前研究[20]的方法,采用颜色增强、随机仿射、随机翻转和四图像拼接等数据增强技术。文本编码器在预训练阶段保持冻结状态。

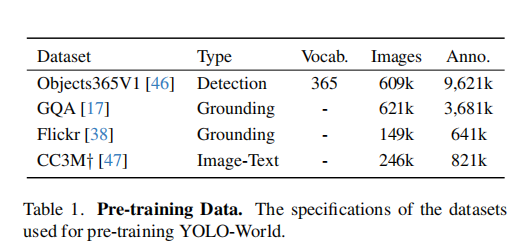

预训练数据。在YOLO-World模型的预训练阶段,我们主要采用检测或定位数据集,包括Objects365(V1)[46]、GQA[17]、Flickr30k[38]等,具体如表1所示。根据文献[24]的建议,我们排除了GoldG[21]数据集中来自COCO数据集的图像(GQA和Flickr30k)。用于预训练的检测数据集标注包含边界框和类别或名词短语。此外,我们还通过伪标注方法(详见第3.4节)对CC3M†[47]数据集进行了扩展,新增了24.6万张图像的图文配对标注。

零样本评估。在完成预训练后,我们直接在LVIS数据集[14]上以零样本方式对提出的YOLO-World模型进行评估。该数据集包含1203个物体类别,远超预训练检测数据集的类别数量,能够有效评估大词汇量检测性能。参照先前研究[21,24,56,57],我们主要在LVIS迷你版[21]上进行评估,并采用固定平均精度[4]作为对比指标。预测的最大数量设置为1000。

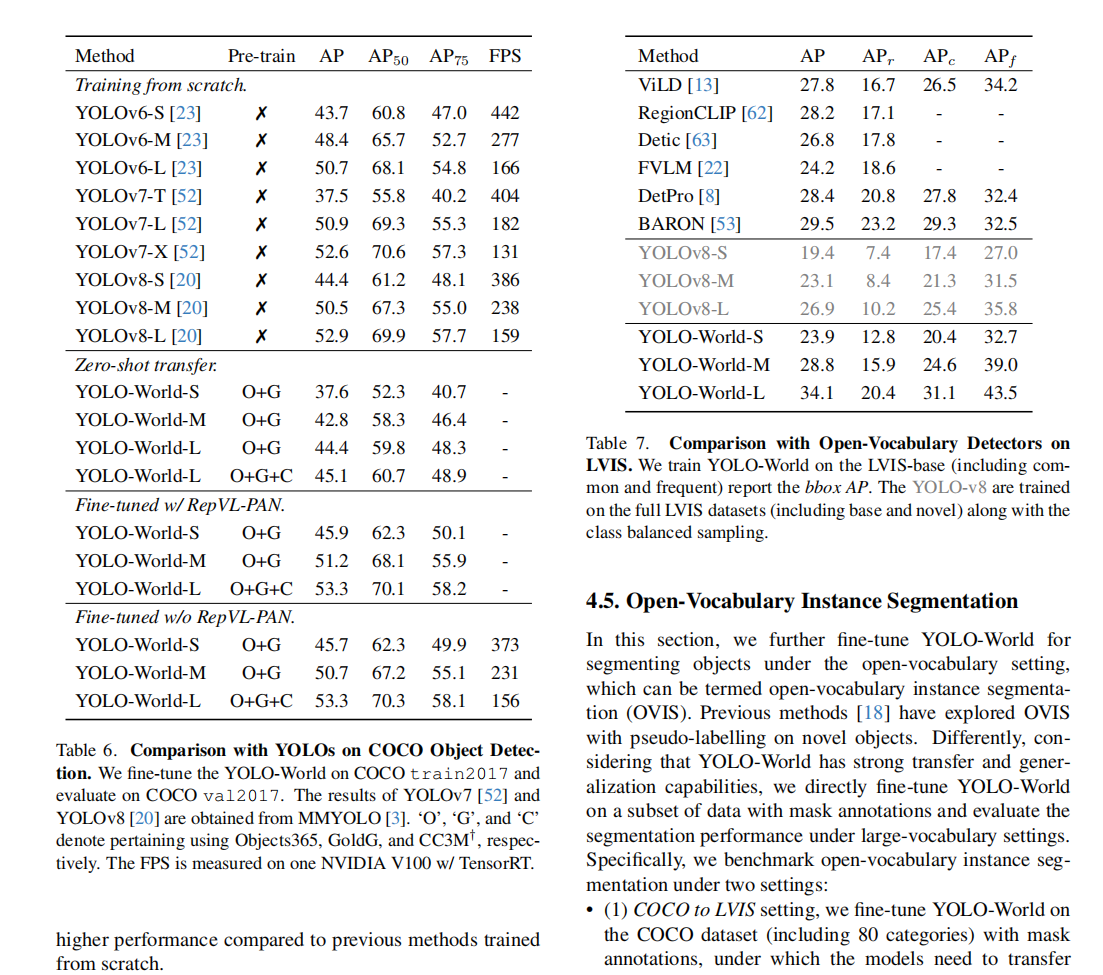

LVIS目标检测主要实验结果。在表2中,我们通过零样本方式将提出的YOLO-World与近期最先进的方法[21,30,56,57,59]在LVIS基准上进行对比。考虑到计算负担和模型参数,我们主要与基于轻量化骨干网络的方法(如Swin-T[32])进行比较。值得注意的是,YOLO-World在零样本性能和推理速度方面均优于先前的最优方法。相较于整合更多数据(如Cap4M(CC3M+SBU[37]))的GLIP、GLIPv2和Grounding DINO,YOLO-World在O365和GolG预训练数据集上即使参数更少仍表现更优。与DetCLIP相比,YOLO-World在性能上具有可比性(35.4对比34.4),同时实现20倍的推理速度提升。实验结果还表明,小型模型(如参数量1300万的YOLO-World-S)可用于视觉-语言预训练,并具备强大的开放词汇能力。

消融实验

我们从预训练和架构两个主要维度对YOLO-World进行分析。除非特别说明,实验均基于YOLO-World-L框架,使用Objects365数据集进行预训练,并在LVIS迷你数据集上进行零样本评估。

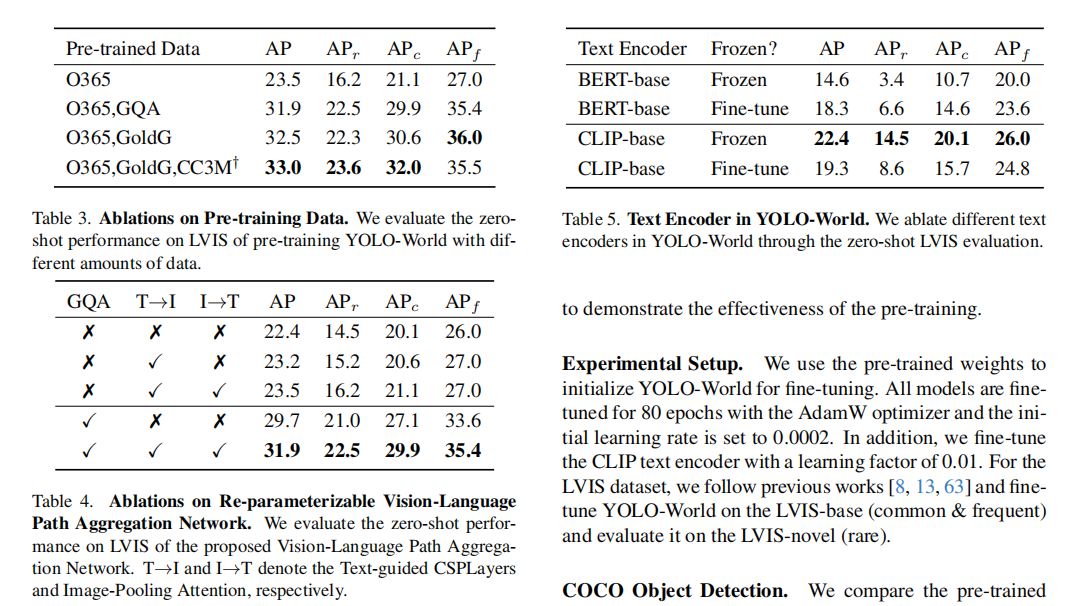

预训练数据方面,表3展示了不同数据集对YOLO-World预训练效果的评估结果。与仅基于Objects365训练的基线模型相比,加入GQA数据集能显著提升性能,在LVIS数据集上实现8.4个百分点的AP值增益。这种提升源于GQA数据集提供的丰富文本信息,有助于增强模型对大词汇量物体的识别能力。当引入CC3M数据集样本(占总数据集的8%)时,稀有物体的AP值还能额外提升0.5个百分点,达到1.3个百分点。表3表明,增加数据量能有效提升大词汇量场景下的检测性能。随着数据量的持续增长,模型性能持续优化,充分证明了使用更大、更多样化数据集进行训练的优势。

关于RepVL-PAN的消融实验,表4展示了YOLO-World提出的RepVL-PAN框架(包含文本引导CSPLayers和图像池化注意力机制)在LVIS零样本检测中的有效性。具体设置包括:(1)仅使用Objects365数据集预训练;(2)同时使用Objects365和GQA数据集预训练。相较于仅含类别标注的Objects365数据集,GQA数据集包含丰富的文本信息,尤其体现在名词短语的标注形式上。如表4所示,提出的RepVL-PAN模型在LVIS数据集上将基线模型YOLOv8-PAN[20]的平均精度提升了1.1个百分点,尤其在LVIS数据集中难以检测和识别的稀有类别(APr)上表现尤为突出。此外,当YOLO-World模型使用GQA数据集进行预训练时,改进效果更加显著,实验表明该模型在获取丰富文本信息时表现更佳。

文本编码器对比。在表5中,我们对比了不同文本编码器的性能表现,包括BERT-base[5]和CLIP-base(ViT-base)[39]。预训练阶段采用两种设置:冻结训练和微调训练,其中微调文本编码器的学习率设定为基础学习率的0.01倍。如表5所示,CLIP文本编码器在LVIS数据集上的表现优于BERT(稀有类别平均精度提升10.1),这得益于其基于图像-文本对的预训练方式,使其在视觉特征嵌入方面更具优势。值得注意的是,虽然在预训练阶段对BERT进行微调能显著提升性能(平均精度提升3.7),但对CLIP进行微调却导致性能大幅下滑。原因在于在O365上进行微调可能会削弱预训练CLIP的泛化能力,因为CLIP仅包含365个类别且缺乏丰富的文本信息。

微调

实验设置。我们使用预训练权重对YOLO-World进行微调,所有模型均采用AdamW优化器进行80轮训练,初始学习率设为0.0002。同时,我们以0.01的学习因子对CLIP文本编码器进行微调。针对LVIS数据集,我们沿用先前研究[8,13,63]的方法,在LVIS-base(常见与高频)数据集上微调YOLO-World,并在LVIS-novel(罕见)数据集上进行评估。

COCO目标检测。我们在表6中将预训练的YOLO-World与先前的YOLO检测器[20,23,52]进行对比。考虑到COCO数据集词汇量较小,为提升训练效率,我们在COCO数据集上微调YOLO-World时移除了提出的RepVL-PAN模块。表6数据显示,我们的方法在COCO数据集上实现了良好的零样本性能,这表明YOLO-World具有强大的泛化能力。此外,经过COCO train2017数据集微调的YOLO-World展现出相较于从零开始训练的先前方法,性能表现更优。

YOLO-World在标准LVIS数据集上的性能调优。首先,与在完整LVIS数据集上训练的基准模型YOLOv8s[20]相比,YOLO-World展现出显著提升,尤其在大型模型上表现突出——例如YOLO-World-L比YOLOv8-L提升了7.2个AP值和10.2个APr值。这些改进充分证明了所提出的预训练策略在大词汇量检测中的有效性。此外,作为高效的单阶段检测器,YOLO-World在整体性能上超越了先前最先进的双阶段方法[8,13,22,53,63],且无需额外设计,例如可学习提示[8]或基于区域的对齐[13]。

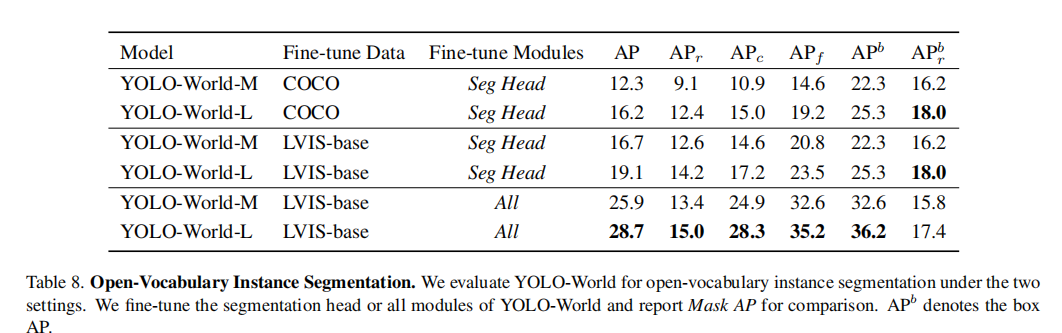

开放词库实例分割

在本节中,我们进一步对YOLO-World进行微调,使其在开放词汇量设置下实现物体分割,即开放词汇量实例分割(OVIS)。先前的研究[18]已探索了在新物体上使用伪标注进行OVIS的方法。不同的是,考虑到YOLO-World具备强大的迁移和泛化能力,我们直接在带有掩码标注的数据子集上对YOLO-World进行微调,并评估其在大词汇量设置下的分割性能。

具体而言,我们在两种设置下对开放词汇量实例分割进行基准测试:•(1)COCO到LVIS设置:我们在包含80个类别的COCO数据集上对YOLO-World进行微调,该数据集带有掩码标注,模型需要从80个类别迁移到1203个类别(80→1203);•(2)LVIS-base到LVIS设置:我们在包含866个类别(常见与高频)的LVIS-base数据集上对YOLO-World进行微调,该数据集带有掩码标注,模型需要从866个类别迁移到1203个类别(866→1203)。我们在包含1203个类别的标准LVIS val2017数据集上评估微调后的模型,其中337个罕见类别未被训练过,可用于衡量开放词汇量性能。

针对开放词汇量实例分割任务,我们对YOLO-World模型进行了两种微调策略:(1)仅微调分割头,(2)微调全部模块。在策略(1)下,微调后的YOLO-World仍保留预训练阶段获得的零样本能力,无需额外微调即可泛化到未见过的类别。策略(2)虽能提升模型在LVIS数据集上的适配性,但可能导致零样本能力下降。表8展示了不同微调设置(COCO或LVIS-base)和策略(仅微调分割头或全模块微调)的对比结果。首先,基于LVIS-base的微调效果优于COCO基线。但AP与APr的比率(APr/AP)基本持平,例如YOLO-World在COCO和LVIS-base上的比率分别为76.5%和74.3%。由于检测器保持冻结状态,我们认为性能差异源于LVIS数据集提供了更精细密集的分割标注,这对分割头的学习更有帮助。当微调全部模块时,YOLO-World在LVIS数据集上取得显著提升,例如YOLO-World-L实现9.6的AP增益。但全模块微调可能削弱开放词汇量性能,导致YOLO-World-L的框APr下降0.6。

可视化

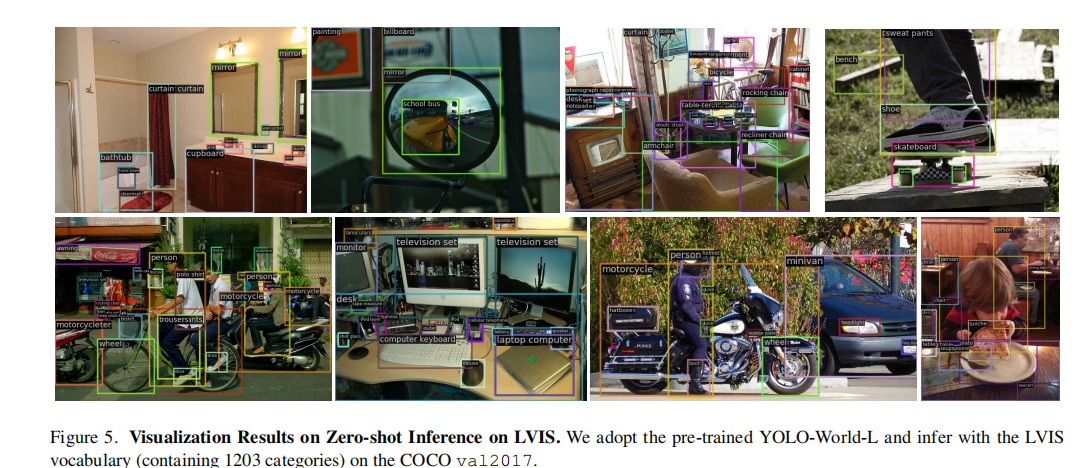

我们展示了预训练YOLO-World-L在三种场景下的可视化效果:(a)LVIS类别零样本推理;(b)带属性细粒度类别的自定义提示输入;©引用检测。可视化结果表明,YOLO-World在开放词汇场景中展现出强大的泛化能力,同时具备引用能力。

零样本推理在LVIS上的表现。图5展示了基于LVIS类别的零样本推理可视化结果,这些结果由预训练的YOLO-World-L生成。预训练的YOLO-World展现出强大的零样本迁移能力,能够尽可能多地检测图像中的物体。

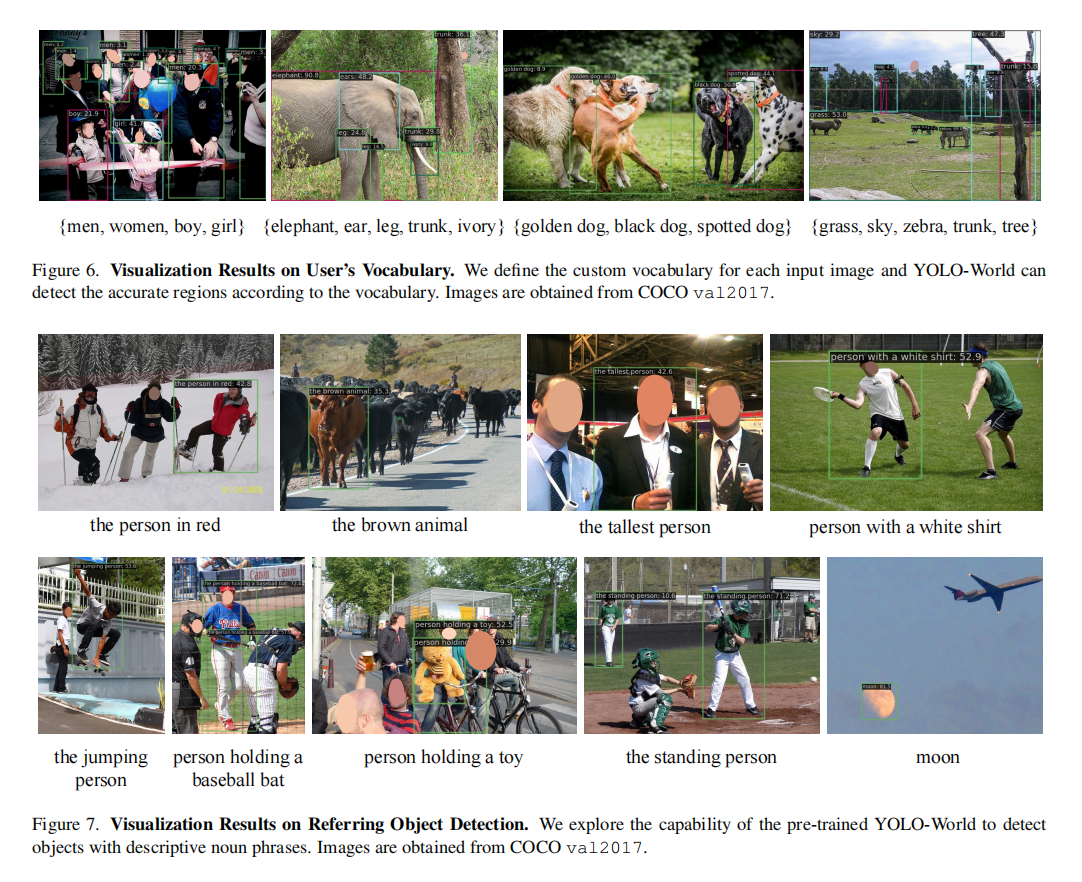

用户词汇检测能力。图6展示了YOLO-World在自定义类别下的检测能力。可视化结果表明,预训练的YOLO-World-L同样具备(1)细粒度检测(即检测单个物体的组成部分)和(2)细粒度分类(即区分物体的不同子类别)的能力。

引用物体检测。图7通过输入描述性名词短语(如“站立的人”)来验证模型能否定位图像中与输入匹配的区域或物体。可视化结果展示了短语及其对应的边界框,证明预训练的YOLO-World具备引用或定位能力。这种能力源于采用大规模训练数据的预训练策略。

总结

我们提出YOLO-World,这是一种前沿的实时开放词汇检测器,旨在提升现实场景应用中的检测效率与开放词汇能力。本文将主流YOLO模型重构为视觉-语言双模态架构,用于开放词汇的预训练与检测,并提出RepVL-PAN框架——该框架通过网络融合视觉与语言信息,支持参数重置以实现高效部署。我们进一步结合检测、定位及图文数据构建有效的预训练方案,使YOLO-World具备强大的开放词汇检测能力。实验结果表明,YOLO-World在速度与开放词汇性能方面均表现优异,同时验证了视觉-语言预训练对小型模型的有效性,为未来研究提供重要启示。我们期待YOLO-World能成为解决现实场景开放词汇检测的新标杆。