手写线程池第2弹:并发与并行深度解析:从CPU原理到高并发系统设计的核心技术

《并发与并行深度解析:从CPU原理到高并发系统设计的核心技术》

引言:一个常见的误解

在技术面试中,我经常向候选人提出这个问题:"请解释并发和并行的区别"。令人惊讶的是,超过70%的开发者无法准确区分这两个概念。更严重的是,这种概念混淆直接导致了在实际项目中的错误设计决策。

让我们从一个真实的案例开始:某电商公司在"双11"大促期间,为了提升系统性能,将原本运行在8核服务器上的服务改为创建1000个线程来处理请求。结果系统性能不升反降,CPU使用率飙升,最终导致服务崩溃。问题的根源就在于:开发者错误地将并发等同于并行,忽视了线程切换的开销。

目录

引言:一个常见的误解

概念本质:并发 vs 并行

并发(Concurrency):逻辑上的同时

并行(Parallelism):物理上的同时

技术原理深度剖析

CPU层面的实现机制

上下文切换:并发的隐藏成本

实际应用场景分析

场景1:IO密集型应用(适合高并发)

场景2:CPU密集型应用(适合真并行)

并发编程的常见陷阱

陷阱1:线程安全问题

陷阱2:死锁(Deadlock)

陷阱3:活锁(Livelock)

陷阱4:资源饥饿

实践指导:如何选择并发/并行模型

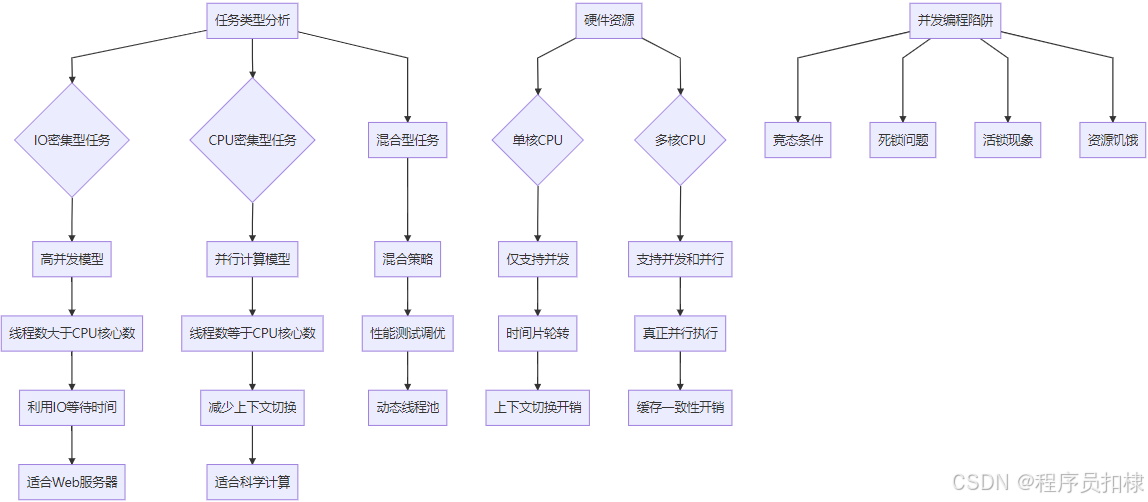

决策流程图

具体配置建议

性能优化策略

减少锁竞争

合理的线程池配置

现代并发编程趋势

异步/等待模式

协程(Coroutine)

响应式编程

总结

🥂(❁´◡`❁)您的点赞👍➕评论📝➕收藏⭐是作者创作的最大动力🤞

💖📕🎉🔥 支持我:点赞👍+收藏⭐️+留言📝欢迎留言讨论

🔥🔥🔥(源码 + 调试运行 + 问题答疑)

🔥🔥🔥 有兴趣可以联系我。文末有免费源码

免费获取源码。

更多内容敬请期待。如有需要可以联系作者免费送

更多源码定制,项目修改,项目二开可以联系作者

点击可以进行搜索(每人免费送一套代码):千套源码目录(点我)2025元旦源码免费送(点我)

我们常常在当下感到时间慢,觉得未来遥远,但一旦回头看,时间已经悄然流逝。对于未来,尽管如此,也应该保持一种从容的态度,相信未来仍有许多可能性等待着我们。

概念本质:并发 vs 并行

并发(Concurrency):逻辑上的同时

并发指的是系统具有处理多个任务的能力,这些任务在逻辑上看起来是同时执行的,但在物理时间上可能是交替进行的。

想象一个优秀的厨师在准备一顿丰盛的大餐:

-

切菜 → 烧水 → 炒菜 → 摆盘

-

他并不是真正的同时做所有事情,而是巧妙地在不同任务间快速切换

-

当水在烧的时候,他去切菜;当菜在炒的时候,他去准备摆盘

在单核CPU时代,这就是并发的工作方式:CPU通过极快的时间片轮转,让多个任务看起来像是在同时执行。

并行(Parallelism):物理上的同时

并行指的是系统真正同时执行多个任务,这需要多核处理器的硬件支持。

现在想象一个专业的厨房团队:

-

厨师A专门切菜

-

厨师B专门炒菜

-

厨师C专门摆盘

-

所有人真正在同时工作

在多核CPU中,每个核心可以独立执行一个线程,实现真正的并行计算。

技术原理深度剖析

CPU层面的实现机制

单核CPU的并发实现:

时间片轮转调度:[线程A: 10ms] → [线程B: 10ms] → [线程C: 10ms] → [线程A: 10ms]...每个线程获得一个时间片(通常10-100ms),当时间片用尽或线程主动让出CPU时,操作系统进行上下文切换。

多核CPU的并行实现:

核心1: [线程A] ──────────────────────>核心2: [线程B] ──────────────────────>核心3: [线程C] ──────────────────────>核心4: [线程D] ──────────────────────>每个核心独立执行线程,真正实现同时运行。

上下文切换:并发的隐藏成本

上下文切换是并发编程中最重要的性能考量因素。当CPU从一个线程切换到另一个线程时,需要:

-

保存当前线程状态

-

寄存器内容

-

程序计数器

-

栈指针

-

-

加载新线程状态

-

恢复寄存器

-

设置程序计数器

-

更新内存管理单元

-

-

缓存失效

-

CPU缓存需要重新预热

-

TLB(转址旁路缓存)需要更新

-

根据测试,一次上下文切换的开销大约在1-10微秒。虽然单次开销很小,但在高并发场景下,频繁的上下文切换会显著降低系统性能。

实际应用场景分析

场景1:IO密集型应用(适合高并发)

Web服务器处理HTTP请求:

请求1:接收数据(等待) → 处理逻辑(计算) → 发送响应(等待)请求2:接收数据(等待) → 处理逻辑(计算) → 发送响应(等待)请求3:接收数据(等待) → 处理逻辑(计算) → 发送响应(等待)在这种场景下,线程大部分时间在等待网络IO,高并发设计可以充分利用CPU资源。当一个线程等待IO时,CPU可以切换到其他线程执行。

场景2:CPU密集型应用(适合真并行)

科学计算或图像处理:

任务1:复杂数学计算(持续占用CPU)任务2:矩阵运算(持续占用CPU) 任务3:数据加密(持续占用CPU)这种任务需要持续占用CPU,应该使用并行计算,线程数最好等于CPU核心数,避免不必要的上下文切换。

并发编程的常见陷阱

陷阱1:线程安全问题

竞态条件(Race Condition):

线程A:读取count=100线程B:读取count=100 线程A:count = 100 + 1 = 101线程B:count = 100 + 1 = 101最终结果:101(期望102)解决方案:使用锁、原子操作或不可变对象。

陷阱2:死锁(Deadlock)

四个必要条件:

-

互斥条件:资源不能被共享

-

占有且等待:线程持有资源并等待其他资源

-

不可抢占:资源只能由持有线程释放

-

循环等待:线程间形成资源等待环

陷阱3:活锁(Livelock)

线程在不断改变状态,但无法继续执行。就像两个人在走廊相遇,都让路却总是挡住对方。

陷阱4:资源饥饿

某些线程永远无法获得所需资源,通常由于优先级设置不当或资源分配算法缺陷。

实践指导:如何选择并发/并行模型

决策流程图

开始↓分析任务类型↓是IO密集型? ──是──> 使用高并发模型(线程数 > CPU核心数)↓ 否 是CPU密集型? ─是──> 使用并行模型(线程数 ≈ CPU核心数)↓ 否混合型任务 ────> 使用混合策略 + 性能测试具体配置建议

IO密集型任务:

-

线程数 = CPU核心数 × (1 + 平均等待时间/平均计算时间)

-

典型场景:Web服务器、数据库查询、文件操作

-

建议:适当增加线程数,充分利用IO等待时间

CPU密集型任务:

-

线程数 = CPU核心数 + 1(预留一个处理其他事务)

-

典型场景:科学计算、视频编码、复杂算法

-

建议:避免过多线程,减少上下文切换

性能优化策略

减少锁竞争

-

锁粒度优化

-

细粒度锁:减少锁的范围

-

读写锁:读多写少的场景

-

-

无锁编程

-

原子操作:CAS(Compare-And-Swap)

-

无锁数据结构:无锁队列、无锁栈

-

-

线程局部存储

-

ThreadLocal变量

-

避免共享数据的竞争

-

合理的线程池配置

根据阿姆达尔定律(Amdahl's Law):

加速比 = 1 / [(1 - P) + P/N]其中P为可并行部分比例,N为处理器数量这个定律告诉我们:系统的加速效果受限于串行部分的比例。即使无限增加处理器,如果存在10%的串行代码,最大加速比也不会超过10倍。

现代并发编程趋势

异步/等待模式

传统的线程池方式:

主线程 → 提交任务 → 线程池执行 → 回调通知现代异步模式:

主线程 → 发起异步调用 → 立即返回 → IO完成时恢复执行这种模式减少了线程阻塞,提高了资源利用率。

协程(Coroutine)

轻量级线程,由用户态调度:

-

创建成本低:通常几KB内存

-

切换开销小:无需内核介入

-

数量可很多:支持数十万协程

响应式编程

基于事件驱动和数据流,提供声明式的并发处理方式。

总结

并发和并行是现代软件开发的基石概念。正确理解它们的区别和适用场景,对于设计高性能、高可用的系统至关重要。

关键要点总结:

-

并发是任务处理的能力,并行是任务执行的方式

-

并发适合IO密集型任务,并行适合CPU密集型任务

-

上下文切换是并发的主要性能开销

-

合理配置线程数比盲目增加线程更重要

-

理解硬件特性是优化并发性能的前提

在实际项目中,我们应该根据具体业务场景、硬件资源和性能要求,灵活选择并发或并行模型,并通过持续的性能测试和调优,找到最适合的解决方案。

🥂(❁´◡`❁)您的点赞👍➕评论📝➕收藏⭐是作者创作的最大动力🤞

💖📕🎉🔥 支持我:点赞👍+收藏⭐️+留言📝欢迎留言讨论

🔥🔥🔥(源码 + 调试运行 + 问题答疑)

🔥🔥🔥 有兴趣可以联系我。文末有免费源码

💖学习知识需费心,

📕整理归纳更费神。

🎉源码免费人人喜,

🔥码农福利等你领!💖常来我家多看看,

📕网址:扣棣编程,

🎉感谢支持常陪伴,

🔥点赞关注别忘记!💖山高路远坑又深,

📕大军纵横任驰奔,

🎉谁敢横刀立马行?

🔥唯有点赞+关注成!

往期文章推荐:

基于Springboot + vue实现的学生宿舍信息管理系统

免费获取宠物商城源码--SpringBoot+Vue宠物商城网站系统

【2025小年源码免费送】