springAI +openAI 接入阿里云百炼大模型-通义千问

我们已经完成

1、本地模型搭建 DeepSeek-R1 本地部署 - 十分钟搞定

2、spring ai 调本地大模型SpringAI + DeepSeek本地大模型应用开发-聊天机器人

我们发现,本地模型受限于本地服务器配置,调用起来响应很慢体验并不好,那么各大厂出了那么多酷炫的大模型我们为啥不用起来呢,lets do it

本文介绍一下spring ai访问阿里百炼大模型,依旧5分钟搞定

1. 申请apiKey

2. 引pom依赖

3. yml模型配置

4. 使用模型工具

1. 申请apiKey

使用人家的模型得有访问凭证,就跟调任何三方开放平台API一样,直接去

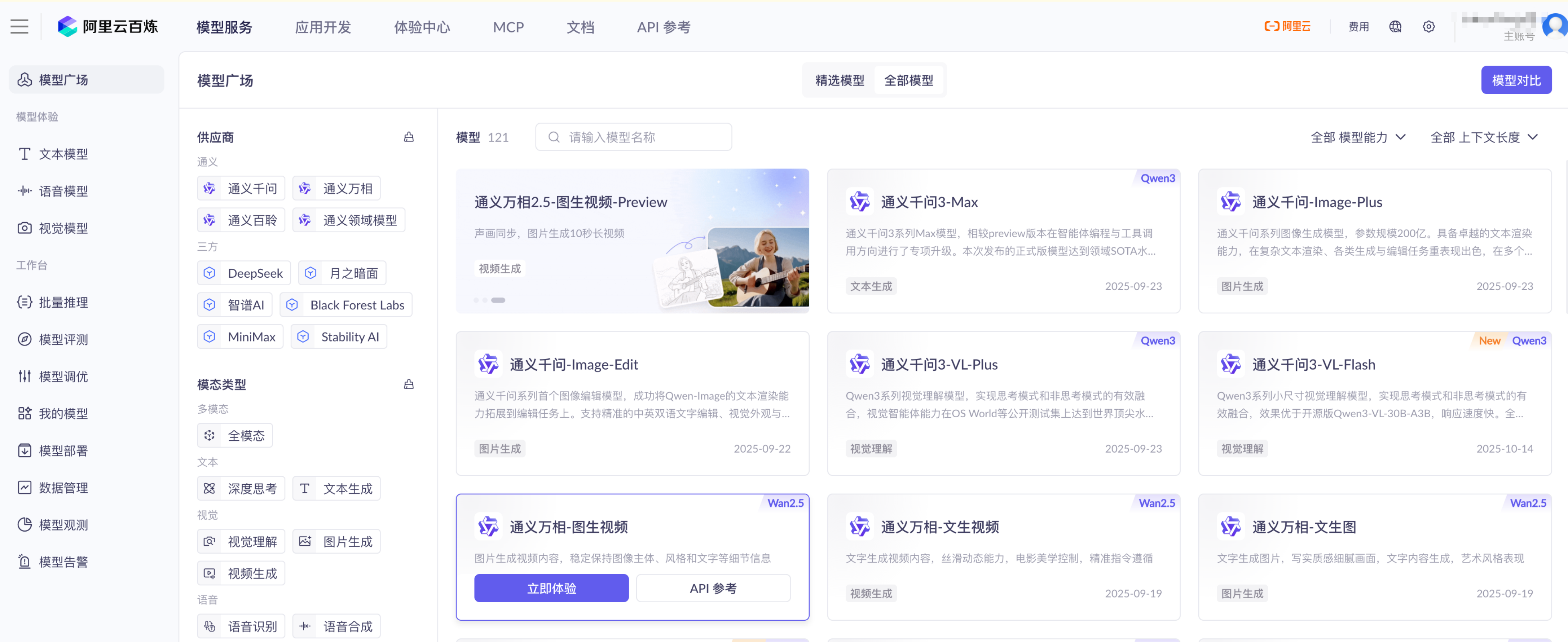

大模型服务平台百炼控制台创建一个就行了

2. 引pom依赖

各大模型默认支持open AI的规范,spring ai 已经帮我们封装好了,引就完事了

<dependency><groupId>org.springframework.ai</groupId><artifactId>spring-ai-openai-spring-boot-starter</artifactId>

</dependency>

3. 配置yml模型地址

跟使用本地ollama一样,我们要配置上模型信息,供spring启动时读取配置文件完成自动装配

- ollama的配置不用管

- 新增openai的配置

- 模型服务地址照抄就行了

- apiKey用你创建的

- 模型我用的通义千问-Max-Latest

spring:ai:ollama:base-url: http://localhost:11434chat:model: deepseek-r1:7bopenai:base-url: https://dashscope.aliyuncs.com/compatible-modeapi-key: 替换成你刚创建的apiKeychat:options:model: qwen-max-latest

模型广场里有好多模型,随便玩就行了,模型名称配对了就行

4. 使用模型工具

上面pom依赖添加完,刷新maven依赖,openai模型相关内容就拉到本地仓库了,开用就完事了,老样子:

- 定义一个聊天客户端bean

- 将openai模型初始化进去

- 指定系统角色,这个随意,不指定就是模型默认系统角色

- chatMemory会话记忆先不用管

@Beanpublic ChatClient openAiClient(OpenAiChatModel model,ChatMemory chatMemory) {return ChatClient.builder(model).defaultSystem("你是一只功夫熊猫,请以功夫熊猫的身份回答问题").defaultAdvisors(new MessageChatMemoryAdvisor(chatMemory)).build();}

controller 不变

@Resourceprivate ChatClient openAiClient;@RequestMapping(value = "/chat",produces = "text/html;charset=utf-8")public Flux<String> chat(String prompt,String chatId) {return openAiClient.prompt().user(prompt).advisors(advisorSpec -> advisorSpec.param(AbstractChatMemoryAdvisor.CHAT_MEMORY_CONVERSATION_ID_KEY,chatId)).stream().content();}

开始对话吧,页面源码在上一篇SpringAI + DeepSeek本地大模型应用开发-聊天机器人,啥也不用动,直接运行

还得是大厂模型啊,丝滑~

接下来我们介绍大模型+传统应用的开发,怎么让大模型调本地项目接口呢。。。