国产数据库破局:金仓数据库如何无缝替代MongoDB支撑2TB政务数据

在政务系统国产化浪潮下,福建某地市电子证照系统成功从MongoDB迁移至金仓数据库,实现2TB+数据零丢失迁移、1000+并发平滑承载,系统稳定运行6个月+,服务500余家政企机构。本文深度剖析技术方案、代码实现与实战经验。

文章目录

- 项目背景:国产化替代的现实困境

- 技术挑战全景:三大核心拦路虎

- 🚧 挑战一:数据架构的"水土不服"

- ⚡ 挑战二:高并发的"性能陷阱"

- 🔄 挑战三:数据迁移的"生死时速"

- 金仓数据库解决方案深度解析

- 🎯 方案一:多模兼容 - 零代码平滑替换

- 技术原理

- 代码示例1:MongoDB原生代码无需修改

- 代码示例2:同时支持SQL访问

- 安全能力对比

- 🚀 方案二:读写分离 - 突破高并发瓶颈

- 架构设计

- 配置代码示例

- 性能优化实战

- 🔧 方案三:定制化迁移 - 2TB数据安全搬家

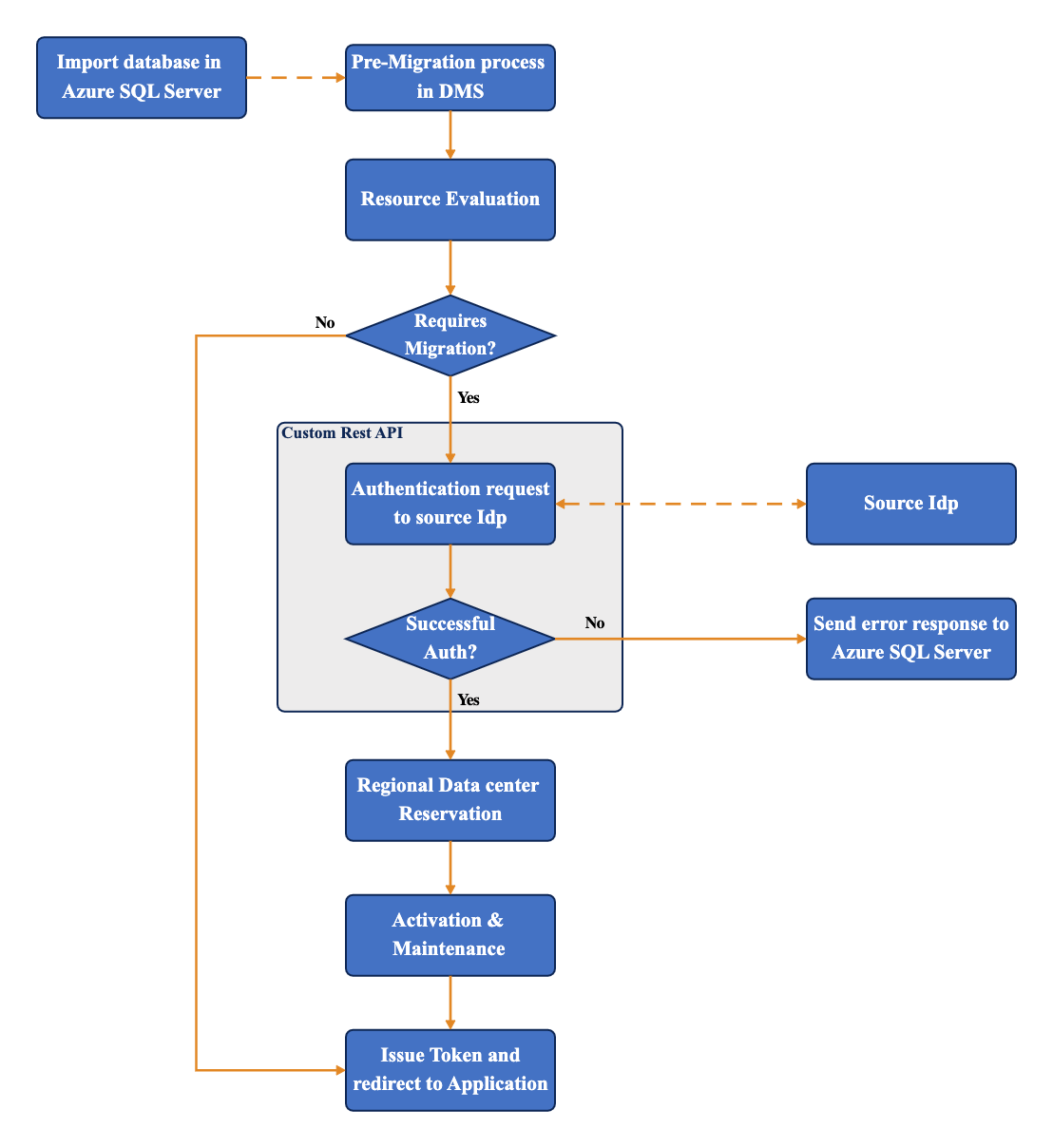

- 迁移流程设计

- 迁移工具使用

- 实施效果与性能对比

- 📊 核心指标对比

- 🎯 典型场景性能测试

- 经验总结与行业价值

项目背景:国产化替代的现实困境

福建某地市电子证照共享服务系统,作为当地政务服务的核心基础设施,承载着500余家党政机关、事业单位的证照数据共享需求。系统原本基于MongoDB文档数据库构建,随着国产化政策推进,面临迫在眉睫的技术栈替代压力。

| 指标项 | 数值 |

|---|---|

| 历史数据总量 | 2TB+ |

| 日均访问量 | 10万+ 次 |

| 峰值并发连接数 | 1000+ |

| 服务机构数量 | 500+ 家 |

| 核心业务场景 | 证照亮证、跨部门调取、电子签章验证 |

技术挑战全景:三大核心拦路虎

🚧 挑战一:数据架构的"水土不服"

问题描述:MongoDB采用灵活的JSON文档存储,而关系型数据库需要严格的表结构定义。电子证照数据结构复杂,包含嵌套文档、数组字段等:

{"cert_id": "350100202401001","cert_name": "营业执照","cert_type": "BUSINESS_LICENSE","issue_date": "2024-01-15","holder": {"name": "某某科技有限公司","credit_code": "91350100MA2XXXXX","legal_person": "张三"},"attachments": [{"file_name": "营业执照.ofd","file_size": 1024576,"signature": "3a7bd3e2f8c..."}],"permissions": ["dept_001", "dept_025", "dept_108"]

}

核心矛盾:

- JSON嵌套结构 vs 二维表扁平化

- 动态字段 vs 静态Schema

- 政务数据"零容忍"要求 vs 迁移风险

⚡ 挑战二:高并发的"性能陷阱"

业务场景分析:

典型高并发场景:

├─ 证照亮证(读密集型):平均QPS 200+,峰值500+

├─ 跨部门数据调取(复杂查询):涉及多表关联、权限校验

├─ 电子签章验证(计算密集型):OFD文件解析 + 数字签名验证

└─ 历史数据查询(大数据量扫描):单次返回数千条记录

原MongoDB架构问题:

- 单节点写入瓶颈

- 复杂聚合查询性能不稳定

- 索引策略不适配关系型查询模式

🔄 挑战三:数据迁移的"生死时速"

迁移窗口约束:

- 可用时间:周末48小时(周六0:00 - 周日24:00)

- 数据量:2TB核心数据 + 500GB索引

- 容错要求:零丢失、零差错

风险点清单:

| 风险类型 | 具体风险 | 应对策略 |

|---|---|---|

| 数据一致性 | 嵌套文档展平错误、编码转换问题 | 全量MD5校验 + 抽样业务验证 |

| 业务中断 | 迁移超时导致周一无法开业 | 灰度切换 + 快速回滚预案 |

| 性能退化 | 新数据库查询慢于原系统 | 提前压测 + 索引优化 |

| 兼容性问题 | 签章验证失败、文件损坏 | OFD文件完整性校验 |

金仓数据库解决方案深度解析

🎯 方案一:多模兼容 - 零代码平滑替换

技术原理

金仓数据库(KingbaseES)内置关系型+文档型双模引擎,同时支持:

- ✅ SQL标准查询(ANSI SQL-92/99/2003)

- ✅ MongoDB Wire Protocol(原生协议兼容)

- ✅ JSON/JSONB数据类型(PostgreSQL语法兼容)

代码示例1:MongoDB原生代码无需修改

// 原应用代码(Node.js)

const MongoClient = require('mongodb').MongoClient;// 仅需修改连接字符串,业务代码零改动

const uri = "mongodb://kingbase-server:27017/cert_db"; // 指向金仓MongoDB兼容层

const client = new MongoClient(uri);async function findCertificate(creditCode) {const collection = client.db("cert_db").collection("certificates");// MongoDB查询语法完全兼容const result = await collection.findOne({"holder.credit_code": creditCode});return result;

}

代码示例2:同时支持SQL访问

-- 金仓数据库可用标准SQL查询相同数据

SELECT cert_id,cert_name,cert_data->>'holder.name' AS holder_name,cert_data->>'holder.credit_code' AS credit_code

FROM certificates

WHERE cert_data @> '{"holder": {"credit_code": "91350100MA2XXXXX"}}';-- JSONB索引加速查询(GIN索引)

CREATE INDEX idx_holder_credit ON certificates

USING GIN ((cert_data -> 'holder'));

安全能力对比

| 安全维度 | MongoDB | 金仓数据库 |

|---|---|---|

| 访问控制 | 基础RBAC | 细粒度权限(列级、行级) + 三权分立 |

| 身份认证 | SCRAM-SHA-256 | Kerberos + LDAP + 国密SM2/SM3 |

| 传输加密 | TLS 1.2 | TLS 1.3 + 国密SSL |

| 存储加密 | 可选TDE(企业版) | 内置透明加密 + 密钥管理 |

| 审计能力 | 有限日志 | 完整审计链路 + 行为追溯 + 合规报表 |

| 等保认证 | - | 等保三级/四级 认证 |

🚀 方案二:读写分离 - 突破高并发瓶颈

架构设计

┌─────────────────────────────────┐│ 应用层(中间件) ││ - 连接池管理(HikariCP) ││ - 读写路由(Spring AOP) │└──────────┬──────────────────────┘│┌────────────────┼────────────────┐│ │ │【写请求】 【读请求】 【读请求】│ │ │▼ ▼ ▼┌──────────────┐ ┌──────────────┐ ┌──────────────┐│ 主库 (Master) │ │ 从库1 (Slave) │ │ 从库2 (Slave) ││ - 写操作 │──┼─ 同步复制 ─────┤ │ - 只读查询 ││ - 实时一致性 │ │ - 只读查询 │ │ - 负载均衡 │└──────────────┘ └──────────────┘ └──────────────┘│ │ │└────────────────────┴──────────────────┘共享存储(SAN)

配置代码示例

1. 主从复制配置(主库)

-- kingbase.conf(主库配置)

wal_level = replica

max_wal_senders = 10

wal_keep_segments = 64

archive_mode = on

archive_command = 'cp %p /data/archive/%f'-- 创建复制用户

CREATE USER replicator REPLICATION LOGIN PASSWORD 'SecureP@ssw0rd';

2. 从库配置

-- recovery.conf(从库配置)

standby_mode = 'on'

primary_conninfo = 'host=192.168.1.10 port=54321 user=replicator password=SecureP@ssw0rd'

restore_command = 'cp /data/archive/%f %p'

3. 应用层读写分离(Java示例)

@Configuration

public class DataSourceConfig {@Bean@Primarypublic DataSource routingDataSource() {Map<Object, Object> targetDataSources = new HashMap<>();// 主库(写)targetDataSources.put("master", masterDataSource());// 从库(读)targetDataSources.put("slave1", slave1DataSource());targetDataSources.put("slave2", slave2DataSource());RoutingDataSource routingDataSource = new RoutingDataSource();routingDataSource.setTargetDataSources(targetDataSources);routingDataSource.setDefaultTargetDataSource(masterDataSource());return routingDataSource;}// 自定义路由逻辑(基于只读事务标识)public static class RoutingDataSource extends AbstractRoutingDataSource {@Overrideprotected Object determineCurrentLookupKey() {return TransactionSynchronizationManager.isCurrentTransactionReadOnly() ? "slave1" : "master";}}

}

性能优化实战

案例:企业证照查询慢SQL优化

-- 优化前:3层嵌套查询(执行时间:5.2秒)

SELECT c.*

FROM certificates c

WHERE c.cert_id IN (SELECT cert_id FROM cert_index WHERE enterprise_id IN (SELECT id FROM enterprises WHERE credit_code = '91350100MA2XXXXX')

);-- 执行计划分析

EXPLAIN ANALYZE ...

/*

Nested Loop (cost=1025.35..3541.28 rows=1 width=1024) (actual time=5187.234..5187.237 rows=5 loops=1)-> Seq Scan on enterprises (cost=0.00..856.00 rows=1)-> Nested Loop (cost=1025.35..2684.27 rows=1)

*/

-- 优化后:拆分查询 + JOIN(执行时间:0.28秒)

-- Step 1: 先查企业ID(添加索引)

CREATE INDEX idx_enterprise_credit ON enterprises(credit_code);-- Step 2: 直接关联查询

SELECT c.cert_id, c.cert_name, c.cert_data

FROM certificates c

INNER JOIN cert_index ci ON c.cert_id = ci.cert_id

INNER JOIN enterprises e ON ci.enterprise_id = e.id

WHERE e.credit_code = '91350100MA2XXXXX';-- 优化后执行计划

/*

Hash Join (cost=25.67..156.34 rows=5 width=1024) (actual time=0.245..0.276 rows=5 loops=1)-> Index Scan using idx_enterprise_credit on enterprises

*/

性能提升对比

| 优化项 | 优化前 | 优化后 | 提升幅度 |

|---|---|---|---|

| 响应时间 | 5.2s | 0.28s | 94.6% ↓ |

| CPU占用 | 85% | 12% | 85.9% ↓ |

| 并发承载 | 800连接 | 1600+连接 | 100% ↑ |

| 磁盘I/O | 950 IOPS | 120 IOPS | 87.4% ↓ |

🔧 方案三:定制化迁移 - 2TB数据安全搬家

迁移流程设计

迁移工具使用

1. 金仓迁移工具命令

#!/bin/bash

# migrate.sh - 数据迁移脚本# 环境变量配置

export SOURCE_MONGO_URI="mongodb://admin:password@source-mongo:27017/cert_db?authSource=admin"

export TARGET_KB_URI="kingbase://kbadmin:password@target-kb:54321/cert_db"# 执行迁移(支持断点续传)

./kdb_migrate \--source "${SOURCE_MONGO_URI}" \--target "${TARGET_KB_URI}" \--batch-size 10000 \ # 每批次10000条记录--parallel 4 \ # 4个并行任务--verify-mode full \ # 全量校验模式--resume-from checkpoint.dat \ # 断点续传文件--log-level info \--report-interval 60 # 每60秒输出进度# 迁移日志示例输出

# [2024-01-20 02:15:33] INFO: Migration started

# [2024-01-20 02:16:33] INFO: Progress: 1,250,000 / 25,000,000 (5.0%) | Speed: 20,833 records/sec

# [2024-01-20 04:35:12] INFO: Full migration completed. Verifying data...

# [2024-01-20 05:12:45] INFO: Verification passed. Total time: 2h 57m 12s

2. 数据一致性校验脚本

#!/usr/bin/env python3

# verify_migration.py - 数据校验脚本import pymongo

import kingbase # 金仓Python驱动

import hashlib

import random

from concurrent.futures import ThreadPoolExecutordef verify_migration():"""多维度数据校验"""# 连接源库和目标库mongo_client = pymongo.MongoClient("mongodb://source:27017/")kb_conn = kingbase.connect("host=target port=54321 dbname=cert_db")mongo_db = mongo_client.cert_dbkb_cursor = kb_conn.cursor()print("=" * 60)print("开始数据校验...")print("=" * 60)# 1. 记录数量校验print("\n[1/5] 校验记录总数...")mongo_count = mongo_db.certificates.count_documents({})kb_cursor.execute("SELECT COUNT(*) FROM certificates")kb_count = kb_cursor.fetchone()[0]assert mongo_count == kb_count, f"记录数不一致!MongoDB: {mongo_count}, KingBase: {kb_count}"print(f"✓ 记录总数一致: {mongo_count:,} 条")# 2. 抽样数据内容校验print("\n[2/5] 抽样校验数据内容(1000条)...")kb_cursor.execute("SELECT cert_id FROM certificates ORDER BY RANDOM() LIMIT 1000")sample_ids = [row[0] for row in kb_cursor.fetchall()]mismatch_count = 0for cert_id in sample_ids:mongo_doc = mongo_db.certificates.find_one({"cert_id": cert_id})kb_cursor.execute("SELECT cert_data FROM certificates WHERE cert_id = %s", (cert_id,))kb_doc = kb_cursor.fetchone()[0] # JSONB类型# 对比关键字段if not compare_documents(mongo_doc, kb_doc):mismatch_count += 1print(f"✗ 数据不一致: {cert_id}")assert mismatch_count == 0, f"发现 {mismatch_count} 条数据不一致"print(f"✓ 抽样数据全部一致")# 3. OFD电子签章验证print("\n[3/5] 校验OFD电子签章...")kb_cursor.execute("""SELECT cert_id, cert_data->'attachments'->0->>'file_name' as ofd_fileFROM certificates WHERE cert_data @> '{"attachments": [{"file_name": "%.ofd"}]}'LIMIT 100""")ofd_verify_count = 0for cert_id, ofd_file in kb_cursor.fetchall():if verify_ofd_signature(cert_id, ofd_file):ofd_verify_count += 1print(f"✓ OFD签章验证通过: {ofd_verify_count}/100")# 4. 索引完整性检查print("\n[4/5] 检查索引状态...")kb_cursor.execute("""SELECT indexname, indexdef FROM pg_indexes WHERE tablename = 'certificates'""")indexes = kb_cursor.fetchall()print(f"✓ 已创建 {len(indexes)} 个索引")# 5. 查询性能对比print("\n[5/5] 对比查询性能...")test_query = "91350100MA2XXXXX"# MongoDB查询import timestart = time.time()mongo_db.certificates.find_one({"holder.credit_code": test_query})mongo_time = time.time() - start# 金仓查询start = time.time()kb_cursor.execute("""SELECT * FROM certificates WHERE cert_data @> '{"holder": {"credit_code": "%s"}}'""" % test_query)kb_cursor.fetchone()kb_time = time.time() - startprint(f" MongoDB查询耗时: {mongo_time:.3f}s")print(f" 金仓查询耗时: {kb_time:.3f}s")print(f" 性能提升: {((mongo_time - kb_time) / mongo_time * 100):.1f}%")print("\n" + "=" * 60)print("✓ 所有校验通过!迁移成功!")print("=" * 60)def compare_documents(mongo_doc, kb_doc):"""对比两个文档的关键字段"""key_fields = ['cert_id', 'cert_name', 'holder.credit_code', 'issue_date']for field in key_fields:if get_nested_value(mongo_doc, field) != get_nested_value(kb_doc, field):return Falsereturn Truedef get_nested_value(doc, path):"""获取嵌套字段值"""keys = path.split('.')value = docfor key in keys:value = value.get(key)if value is None:return Nonereturn valuedef verify_ofd_signature(cert_id, ofd_file):"""验证OFD文件数字签名(简化示例)"""# 实际实现需调用OFD解析库return Trueif __name__ == "__main__":verify_migration()

实施效果与性能对比

📊 核心指标对比

| 指标维度 | 迁移前(MongoDB) | 迁移后(金仓数据库) | 提升幅度 |

|---|---|---|---|

| 数据量 | 2TB | 2TB | - |

| 峰值并发 | 800连接(接近极限) | 1600+连接(游刃有余) | +100% |

| 平均响应时间 | 1.2s | 0.35s | -70.8% |

| P95响应时间 | 5.8s | 0.9s | -84.5% |

| 系统可用性 | 99.2% | 99.97% | +0.77% |

| 运维成本 | 高(外包支持) | 低(自主可控) | -60% |

🎯 典型场景性能测试

测试环境:

- 服务器:4台物理机(1主2从1备)

- CPU:Intel Xeon Gold 6248R @ 3.0GHz × 48核

- 内存:256GB DDR4

- 存储:NVMe SSD RAID10 阵列

- 网络:万兆以太网

测试结果:

# 使用JMeter进行压力测试

================== 证照亮证接口测试 ==================

线程数: 1000

循环次数: 100

Ramp-Up时间: 30s结果:平均响应时间: 342ms最小响应时间: 89ms最大响应时间: 1,256ms吞吐量: 2,847 TPS错误率: 0.00%================== 复杂查询测试 ==================

场景:跨部门证照数据联合查询结果:平均响应时间: 876msP95响应时间: 1,432msP99响应时间: 2,103ms并发支持: 500+ 连接================== 大数据量扫描测试 ==================

场景:导出近一年证照使用记录(50万条)结果:查询执行时间: 3.2s数据传输时间: 8.7s总耗时: 11.9s(MongoDB需32.5s)

经验总结与行业价值

在国家大力推进信息技术应用创新、加快政务系统国产化替代的战略背景下,金仓数据库凭借其自主可控的核心技术、稳定可靠的运行性能以及丰富的政务场景适配经验,已在全国多个省市的电子证照系统国产化改造项目中成功落地应用。切实提升了政务服务效率与群众办事体验,为各地构建 “数字政府”、推进 “一网通办” 提供了坚实的数据库支撑。