自然语言处理实战——基于策略迭代算法的餐厅预订对话系统

目录

一、引言

二、自然语言理解(NLU):recognize_intent函数

三、对话环境建模(MDP):RestaurantBookingEnv类

核心组件:

四、强化学习算法:PolicyIterationAgent类

核心流程:

五、自然语言生成(NLG):action_to_response函数

六、对话模拟:simulate_dialog函数

七、主函数:__main__模块

八、基于策略迭代算法的餐厅预订对话系统的Python代码完整实现

九、程序运行截图展示

十、总结

一、引言

本文实现的项目是一个基于策略迭代算法的餐厅预订对话系统,能够通过自然语言交互完成餐厅预订流程。系统包含自然语言理解、对话环境建模、强化学习决策、自然语言生成和对话模拟等核心模块,各部分协同工作实现智能对话功能。有关策略迭代(动态规划)算法的详细讲解可以参考【强化学习】动态规划算法-CSDN博客。本文将详细介绍该系统的所有功能以及Python代码完整实现。

二、自然语言理解(NLU):recognize_intent函数

功能:识别用户输入的意图,将自然语言转换为系统可理解的结构化意图标签,是对话系统 “听懂” 用户的核心。

实现逻辑:通过关键词匹配识别用户意图,支持以下核心意图:

request_book:用户同意预订(如 “需要”“是的”)或主动请求预订(如 “我要预订”)。inform_date:用户提供预订日期(如 “周六”“10 月 1 日”“明天”),通过日期关键词(星期、日期单位等)匹配。inform_people:用户提供用餐人数(如 “3 人”“5 位”),通过人数关键词(数字、“人”“位” 等)匹配。confirm:用户确认预订信息(如 “确认”)。cancel:用户取消预订(如 “取消”)。unknown:无法识别的意图。

作用:为后续对话状态转移提供依据,确保系统能根据用户意图推进流程。

三、对话环境建模(MDP):RestaurantBookingEnv类

功能:基于马尔可夫决策过程(MDP)定义对话环境,明确对话的状态、系统可执行的动作、状态转移规则和奖励机制,是强化学习的 “场景载体”。

核心组件:

-

状态(states):定义对话所处的阶段,共 7 种状态:

start:初始状态(无任何信息)。wait_book_confirm:等待用户确认是否需要预订。wait_date:等待用户提供预订日期。wait_people:等待用户提供用餐人数。wait_confirm:等待用户确认预订信息。success:预订成功(终止状态)。fail:预订失败(终止状态)。

-

动作(actions):系统可执行的回应动作,共 6 种:

greet:初始问候并询问是否需要预订(如 “您好!请问需要预订餐厅吗?”)。ask_date:询问用户预订日期(如 “请问您需要预订哪一天呢?”)。ask_people:询问用户用餐人数(如 “请问有几位用餐呢?”)。ask_confirm:请求用户确认预订信息(如 “请确认预订信息是否正确哦~”)。confirm_book:确认预订成功(如 “预订成功!期待您的光临~”)。exit:结束对话(如 “对话已结束,如有需要请再次联系我们~”)。

-

状态转移概率(P):定义 “当前状态 + 系统动作” 到 “下一状态” 的转移规则(确定性转移):

- 例如:

start状态执行greet动作后,必然转移到wait_book_confirm状态; - 未定义的(状态 + 动作)组合默认转移到

fail(确保无逻辑漏洞)。

- 例如:

-

奖励函数(R):鼓励完成预订、惩罚中途退出:

- 成功预订(

confirm_book动作)奖励 + 20; - 中途退出(

exit动作)惩罚 - 10; - 正常推进流程的动作(如

ask_date)奖励 0(中性)。

- 成功预订(

-

核心方法

step:根据当前状态、系统动作和用户意图,更新下一状态:- 若用户意图与系统动作的预期匹配(如

ask_date预期inform_date),则按转移规则更新状态; - 若不匹配(如询问日期时用户说 “取消”),则转移到

fail状态(对话失败)。

- 若用户意图与系统动作的预期匹配(如

四、强化学习算法:PolicyIterationAgent类

功能:通过策略迭代算法学习最优对话策略,即 “在每个状态下选择哪个动作能最大化长期奖励”,使系统能自主决策下一步该做什么。

核心流程:

-

策略评估(policy_evaluation):计算当前策略下每个状态的 “状态价值(V)”,即从该状态开始遵循当前策略能获得的累积折扣奖励(考虑未来奖励的现值)。通过迭代更新 V 值,直到收敛(价值变化小于阈值)。

-

策略提升(policy_improvement):基于当前状态价值,更新策略为 “贪婪策略”:对每个状态,选择能最大化即时奖励 + 未来状态价值的动作(即 Q 值最大的动作),确保策略向更优方向改进。

-

训练(train):交替执行 “策略评估” 和 “策略提升”,直到策略稳定(不再变化),此时得到的策略即为最优对话策略(如

start状态最优动作为greet,wait_date状态最优动作为ask_people等)。

五、自然语言生成(NLG):action_to_response函数

功能:将系统的动作(如ask_date)转换为自然语言回应,使系统的输出符合人类对话习惯,是系统 “说人话” 的核心。

实现:通过字典映射动作与预设回应,例如ask_people对应 “请问有几位用餐呢?”,确保回应简洁自然。

六、对话模拟:simulate_dialog函数

功能:模拟用户与系统的完整对话过程,测试最优策略的实际效果。

流程:

- 从初始状态(

start)开始,系统根据最优策略选择动作; - 通过 NLG 将动作转换为自然语言回应并输出;

- 等待用户输入,通过 NLU 识别用户意图;

- 调用环境的

step方法更新状态,判断对话是否终止(成功 / 失败); - 若终止,输出对应结果(如 “预订已完成” 或 “对话出错”)。

七、主函数:__main__模块

功能:串联整个系统的初始化、训练和测试流程。

步骤:

- 创建对话环境(

RestaurantBookingEnv); - 初始化并训练策略迭代智能体(

PolicyIterationAgent),输出收敛迭代次数; - 打印最优策略(每个状态对应的最优动作);

- 启动对话模拟,允许用户与系统交互,验证预订流程。

八、基于策略迭代算法的餐厅预订对话系统的Python代码完整实现

import numpy as np

from collections import defaultdict# ===================== 1. 自然语言理解(NLU):识别用户意图 =====================

def recognize_intent(user_utterance):"""优化意图识别:补充“星期六”“星期日”等关键词"""utterance = user_utterance.lower().strip()# 识别用户同意预订的意图(对应初始问候的回应)if "需要" in utterance or "是的" in utterance or "要" in utterance or "好的" in utterance:return "request_book" # 同意预订# 识别日期意图date_keywords = ["date", "when", "哪天","周一", "周二", "周三", "周四", "周五", "周六", "周日","星期一", "星期二", "星期三", "星期四", "星期五", "星期六", "星期日","今天", "明天", "后天", "号", "月", "日"]if any(keyword in utterance for keyword in date_keywords):return "inform_date" # 提供日期# 识别人数意图people_keywords = ["people", "number", "人数", "个", "人", "位", "1", "2", "3", "4", "5", "6", "7", "8", "9"]if any(keyword in utterance for keyword in people_keywords):return "inform_people" # 提供人数elif "book" in utterance or "reserve" in utterance or "预订" in utterance:return "request_book" # 请求预订elif "confirm" in utterance or "确认" in utterance:return "confirm" # 确认预订elif "cancel" in utterance or "取消" in utterance:return "cancel" # 取消预订else:return "unknown" # 未知意图# ===================== 2. 对话环境建模(MDP) =====================

class RestaurantBookingEnv:"""餐厅预订对话环境,定义MDP的状态、动作、转移概率和奖励"""def __init__(self):# 状态:包含初始确认环节self.states = ["start", # 初始状态"wait_book_confirm", # 等待用户确认是否需要预订"wait_date", # 等待用户提供日期"wait_people", # 等待用户提供人数"wait_confirm", # 等待用户确认预订信息"success", # 预订成功(终止)"fail" # 预订失败(终止)]self.state_index = {s: i for i, s in enumerate(self.states)} # 状态映射为索引self.n_states = len(self.states)# 动作:包含初始问候动作self.actions = ["greet", # 初始问候并询问是否预订"ask_date", # 询问日期"ask_people", # 询问人数"ask_confirm", # 请求确认预订信息"confirm_book", # 确认预订"exit" # 结束对话]self.action_index = {a: i for i, a in enumerate(self.actions)} # 动作映射为索引self.n_actions = len(self.actions)# 状态转移概率矩阵:P[state][action][next_state] = 概率self.P = self._build_transition_matrix()# 奖励函数:R[state][action] = 奖励值self.R = self._build_reward_matrix()def _build_transition_matrix(self):"""构建状态转移矩阵(包含初始确认环节的转移规则)"""P = defaultdict(lambda: defaultdict(lambda: defaultdict(float)))# 1. start状态:初始动作是问候P["start"]["greet"]["wait_book_confirm"] = 1.0 # 问候后进入等待确认是否预订P["start"]["exit"]["fail"] = 1.0 # 直接退出则失败# 2. wait_book_confirm状态:等待用户回应是否需要预订P["wait_book_confirm"]["ask_date"]["wait_date"] = 1.0 # 用户同意,进入询问日期P["wait_book_confirm"]["exit"]["fail"] = 1.0 # 用户拒绝,退出# 3. wait_date状态:等待日期,下一步询问人数P["wait_date"]["ask_people"]["wait_people"] = 1.0P["wait_date"]["exit"]["fail"] = 1.0# 4. wait_people状态:等待人数,下一步请求确认P["wait_people"]["ask_confirm"]["wait_confirm"] = 1.0P["wait_people"]["exit"]["fail"] = 1.0# 5. wait_confirm状态:等待确认,下一步完成预订P["wait_confirm"]["confirm_book"]["success"] = 1.0P["wait_confirm"]["exit"]["fail"] = 1.0# 6. 终止状态:任何动作保持自身for s in ["success", "fail"]:for a in self.actions:P[s][a][s] = 1.0# 7. 定义(状态,动作)组合的默认转移(避免索引错误)for s in self.states:if s in ["success", "fail"]:continuefor a in self.actions:if not P[s][a]: # 若未定义,默认转移到失败P[s][a]["fail"] = 1.0return Pdef _build_reward_matrix(self):"""构建奖励矩阵(鼓励完成预订,惩罚中途退出)"""R = defaultdict(lambda: defaultdict(int))# start状态奖励R["start"]["greet"] = 0 # 问候为中性R["start"]["exit"] = -10 # 提前退出惩罚# wait_book_confirm状态奖励R["wait_book_confirm"]["ask_date"] = 0 # 继续流程为中性R["wait_book_confirm"]["exit"] = -10 # 退出惩罚# wait_date状态奖励R["wait_date"]["ask_people"] = 0 # 继续流程为中性R["wait_date"]["exit"] = -10 # 退出惩罚# wait_people状态奖励R["wait_people"]["ask_confirm"] = 0 # 继续流程为中性R["wait_people"]["exit"] = -10 # 退出惩罚# wait_confirm状态奖励R["wait_confirm"]["confirm_book"] = 20 # 成功预订高奖励R["wait_confirm"]["exit"] = -10 # 退出惩罚# 终止状态无奖励for s in ["success", "fail"]:for a in self.actions:R[s][a] = 0return Rdef step(self, current_state, action, user_intent):"""根据当前状态、动作和用户意图更新状态"""if current_state in ["success", "fail"]:return current_state, self.R[current_state][action], True# 处理wait_book_confirm状态的意图匹配(询问日期时,期待用户提供日期)if current_state == "wait_book_confirm":if action == "ask_date" and user_intent != "inform_date":next_state = "fail" # 用户未提供日期,流程失败else:next_state = list(self.P[current_state][action].keys())[0]else:# 其他状态的意图匹配(日期、人数、确认)expected_intent = {"ask_date": "inform_date","ask_people": "inform_people","ask_confirm": "confirm"}.get(action, None)if expected_intent is not None and user_intent != expected_intent:next_state = "fail" # 意图不匹配,流程失败else:next_state = list(self.P[current_state][action].keys())[0]done = next_state in ["success", "fail"]return next_state, self.R[current_state][action], done# ===================== 3. 强化学习算法:策略迭代 =====================

class PolicyIterationAgent:"""策略迭代算法,求解最优对话策略"""def __init__(self, env, gamma=0.9, theta=1e-6):self.env = envself.gamma = gamma # 折扣因子self.theta = theta # 收敛阈值self.n_states = env.n_statesself.n_actions = env.n_actions# 初始化价值函数和策略self.V = {s: 0.0 for s in env.states} # 状态价值self.pi = {s: {a: 1.0 / self.n_actions for a in env.actions}for s in env.states} # 随机策略def policy_evaluation(self):"""策略评估:计算当前策略下的状态价值"""while True:max_delta = 0.0new_V = {}for s in self.env.states:v = 0.0# 累加所有动作的价值:V(s) = sum(pi(a|s) * [R(s,a) + gamma*V(s')])for a in self.env.actions:if self.pi[s][a] == 0:continuenext_state = list(self.env.P[s][a].keys())[0]prob = self.env.P[s][a][next_state]reward = self.env.R[s][a]v += self.pi[s][a] * prob * (reward + self.gamma * self.V[next_state])new_V[s] = vmax_delta = max(max_delta, abs(new_V[s] - self.V[s]))self.V = new_Vif max_delta < self.theta:breakdef policy_improvement(self):"""策略提升:基于当前价值函数更新为贪婪策略"""policy_stable = Truefor s in self.env.states:old_action_probs = self.pi[s].copy()# 计算每个动作的Q值:Q(s,a) = R(s,a) + gamma*V(s')q_values = {}for a in self.env.actions:next_state = list(self.env.P[s][a].keys())[0]prob = self.env.P[s][a][next_state]reward = self.env.R[s][a]q_values[a] = prob * (reward + self.gamma * self.V[next_state])# 贪婪选择最优动作(均分概率)max_q = max(q_values.values())best_actions = [a for a, q in q_values.items() if q == max_q]for a in self.env.actions:self.pi[s][a] = 1.0 / len(best_actions) if a in best_actions else 0.0# 检查策略是否稳定if self.pi[s] != old_action_probs:policy_stable = Falsereturn policy_stabledef train(self):"""策略迭代主循环:交替评估和提升,直到策略稳定"""iter_cnt = 0while True:self.policy_evaluation()policy_stable = self.policy_improvement()iter_cnt += 1if policy_stable:print(f"策略迭代收敛,迭代次数:{iter_cnt}")break# ===================== 4. 自然语言生成(NLG):动作转回应 =====================

def action_to_response(action):"""将系统动作转换为自然语言回应"""responses = {"greet": "您好!请问需要预订餐厅吗?","ask_date": "请问您需要预订哪一天呢?","ask_people": "请问有几位用餐呢?","ask_confirm": "请确认预订信息是否正确哦~","confirm_book": "预订成功!期待您的光临~","exit": "对话已结束,如有需要请再次联系我们~"}return responses.get(action, "抱歉,我没理解您的意思。")# ===================== 5. 对话模拟:测试系统 =====================

def simulate_dialog(agent, env):"""模拟用户与系统的对话过程(包含初始问候的等待回应)"""current_state = "start"while current_state not in ["success", "fail"]:# 系统选择当前状态的最优动作best_action = max(agent.pi[current_state], key=lambda k: agent.pi[current_state][k])# 生成自然语言回应response = action_to_response(best_action)print(f"系统:{response}")# 等待用户输入并识别意图user_input = input("用户:")user_intent = recognize_intent(user_input)# 更新状态current_state, reward, done = env.step(current_state, best_action, user_intent)if done:if current_state == "success":print("系统:预订已完成,感谢您的使用!")else:print("系统:抱歉,对话过程中出现错误,请重试。")# ===================== 6. 主函数:运行项目 =====================

if __name__ == "__main__":# 1. 创建对话环境env = RestaurantBookingEnv()# 2. 初始化并训练策略迭代智能体agent = PolicyIterationAgent(env, gamma=0.9)agent.train()# 3. 打印最优策略print("\n===== 最优对话策略 =====")for state in env.states:if state in ["success", "fail"]:continuebest_action = max(agent.pi[state], key=lambda k: agent.pi[state][k])print(f"状态「{state}」的最优动作:{best_action}")# 4. 模拟对话print("\n===== 对话模拟开始 =====")simulate_dialog(agent, env)

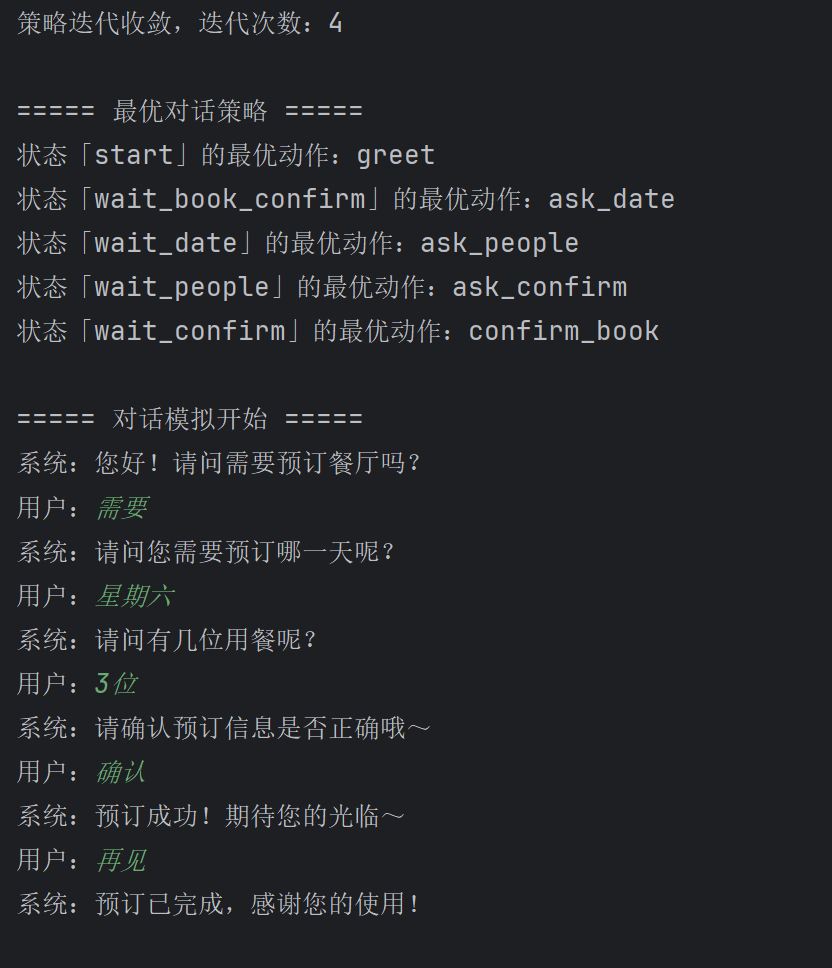

九、程序运行截图展示

十、总结

本文介绍了一个基于策略迭代算法的餐厅预订对话系统,该系统通过自然语言交互完成预订流程。系统包含自然语言理解(NLU)、对话环境建模(MDP)、强化学习决策、自然语言生成(NLG)和对话模拟等核心模块。其中,NLU模块通过关键词匹配识别用户意图;MDP环境定义了7种对话状态和6种系统动作;策略迭代算法通过学习最优对话策略,使系统能自主决策下一步动作;NLG模块将系统动作转换为自然语言回应。最后通过对话模拟验证了系统效果,展示了从初始问候到成功预订的完整流程。该系统实现了智能对话功能的核心技术,为类似任务提供了可扩展的解决方案。