网站可以换域名吗网站设计中常见的错误

转载请注明出处:小锋学长生活大爆炸[xfxuezhagn.cn]

如果本文帮助到了你,欢迎[点赞、收藏、关注]哦~

目录

为什么要用图神经网络?

GIMS 的核心创新

1. 自适应图构建(AGC)

2. GNN + Transformer 的混合匹配器

实验结果:全面碾压现有方法

应用前景

未来展望

总结

- 论文:https://www.sciencedirect.com/science/article/pii/S0893608025009104

- arxiv:https://arxiv.org/abs/2412.18221

- Github:https://github.com/songxf1024/GIMS

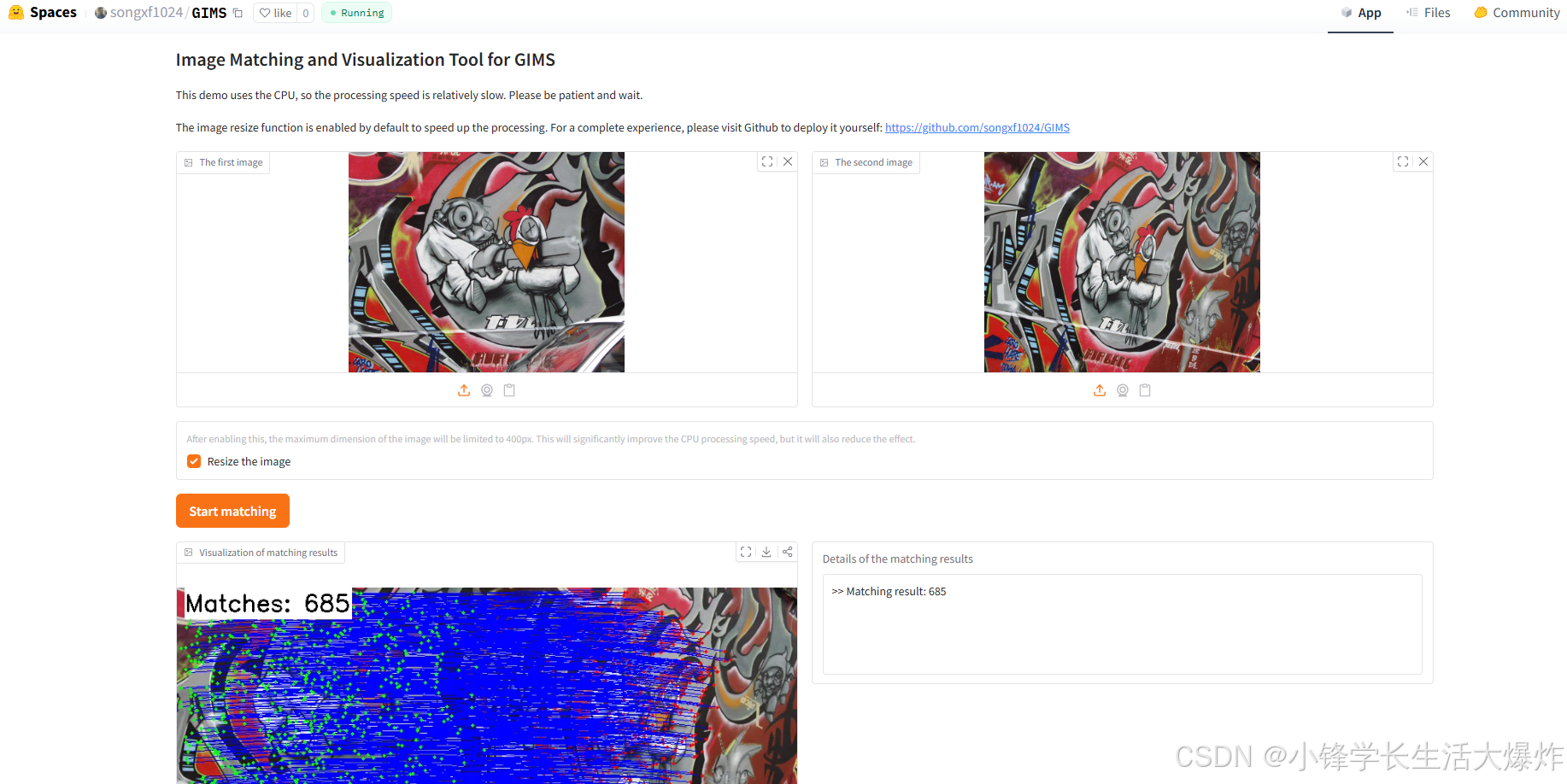

- Huggingface:https://huggingface.co/spaces/songxf1024/GIMS

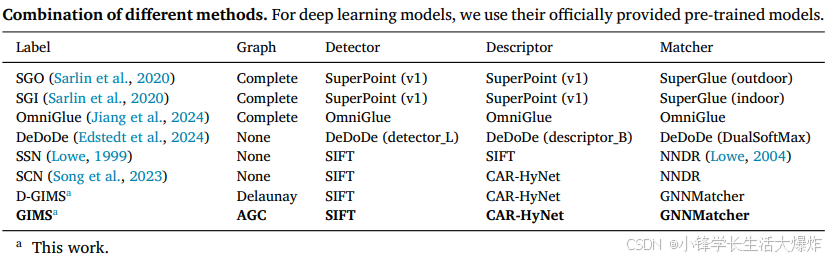

图像匹配一直是计算机视觉领域的核心问题,广泛应用于目标检测、图像拼接、三维重建(SfM)、定位与姿态估计等任务。然而,传统方法和深度学习方法在面对复杂场景时仍存在局限。近期,来自华南理工大学与不列颠哥伦比亚大学的研究团队提出了一种全新的图像匹配系统 GIMS,它通过 自适应图构建(Adaptive Graph Construction, AGC) 与 图神经网络(GNN)+ Transformer 融合,在多个基准数据集上显著超越了现有方法。

为什么要用图神经网络?

传统的 SIFT、SURF 等特征点方法虽然在旋转、尺度不变性上表现优秀,但在光照剧变、视角偏移等复杂条件下往往失效。深度学习方法(如 SuperPoint、SuperGlue)则能学习到更鲁棒的特征,但通常只能捕捉局部或全局信息,很难两者兼顾。

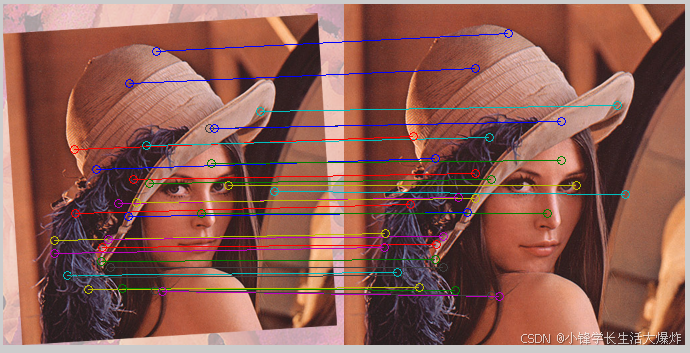

图片里的关键点,不就是“点”吗?点与点之间的关系,可以用“边”来表示。而图结构恰好能自然表达图像中关键点及其空间关系。通过将特征点建模为图的顶点,特征相似性与空间邻近关系作为边,图神经网络能够直接学习点与点之间的依赖关系,为图像匹配提供新的思路。

GIMS 的核心创新

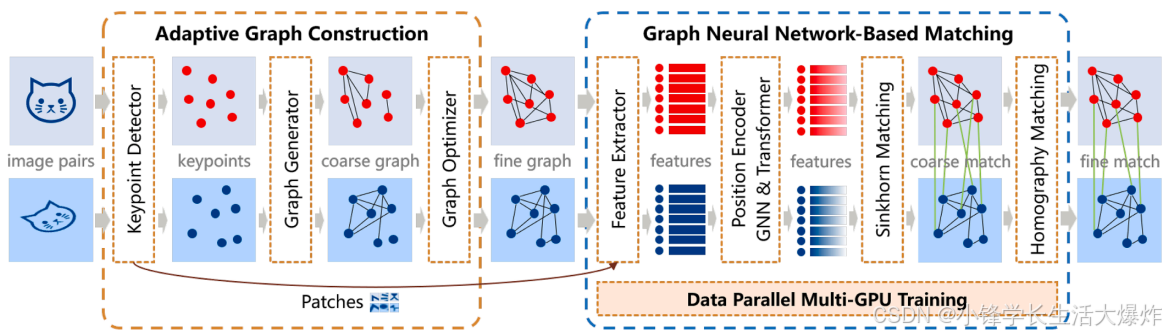

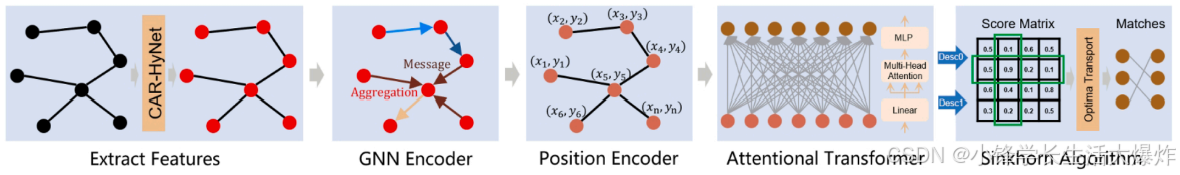

论文提出的 GIMS 系统由两大核心模块组成:

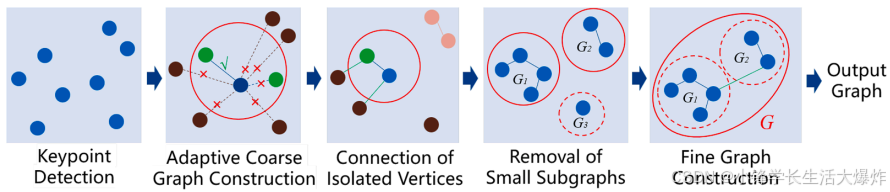

1. 自适应图构建(AGC)

-

不同于传统的固定半径或 k 近邻构图方式,AGC 会根据特征点之间的相似性 动态调整边的生成规则。

-

它通过 距离阈值 β 与 相似性分位数阈值 α 来平衡图的稠密度和鲁棒性,并剔除过小的子图(阈值 θ)。

-

这一方法有效减少了冗余顶点和边,避免了孤立点的丢失问题,从而构建出更紧凑且表达力更强的图结构。

2. GNN + Transformer 的混合匹配器

-

GNN(采用 GraphSAGE)用于聚合局部邻域信息,学习特征点之间的细粒度关系。

-

Transformer 模块则引入全局注意力机制,捕捉远程依赖关系,使得系统能同时兼顾 局部几何约束 和 全局上下文信息。

-

最终,使用 Sinkhorn 算法 在两个图之间进行匹配,得到软分配矩阵,再通过 RANSAC 进一步优化匹配结果。

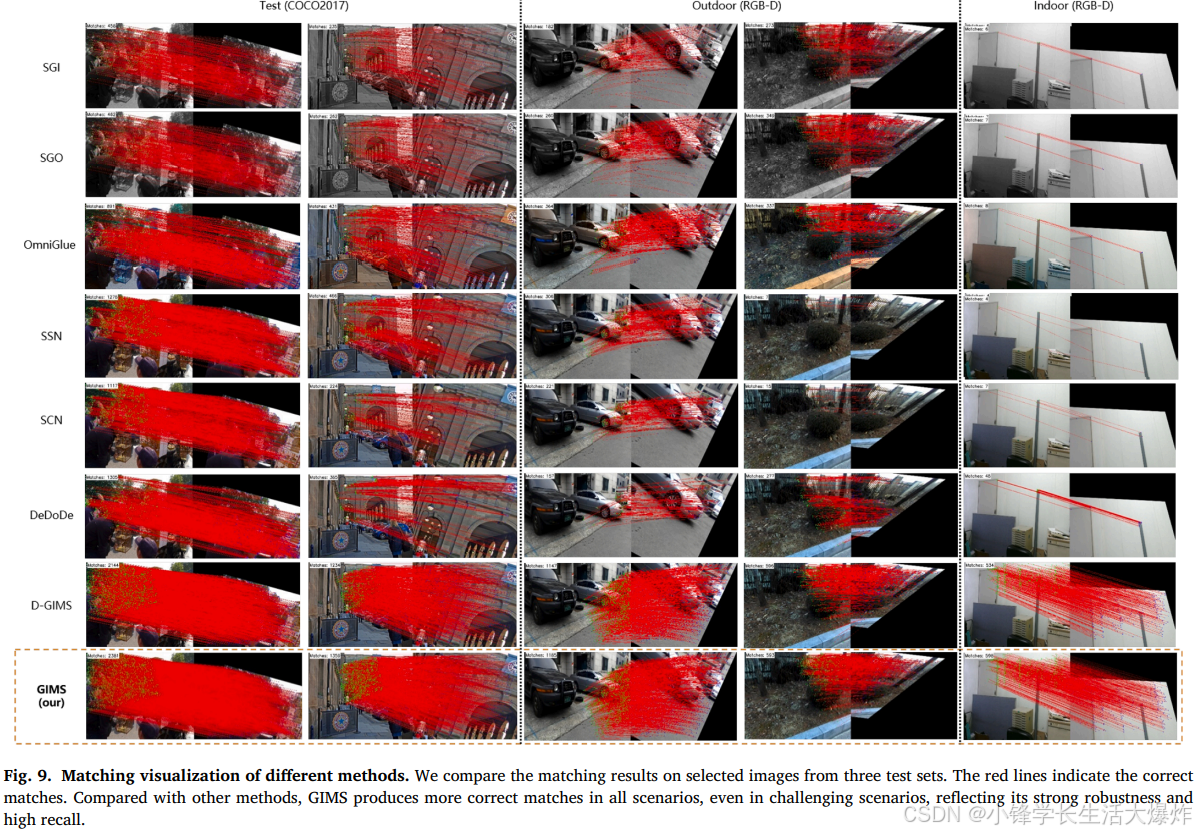

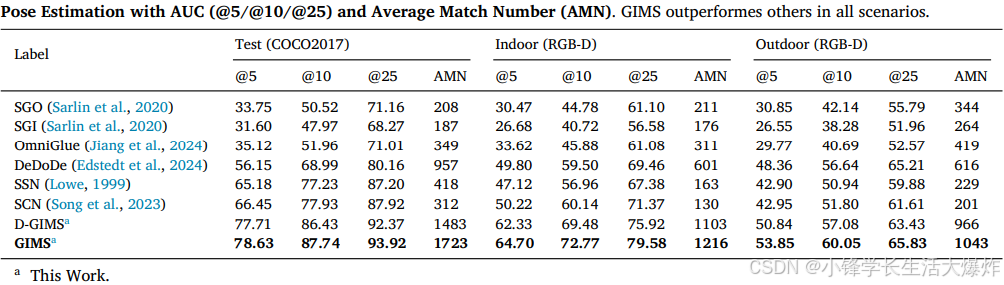

实验结果

研究团队在 COCO2017、RGB-D、Oxford-Affine 等公开数据集,以及真实场景下进行了大量实验。结果表明:

-

匹配数量:相比 SuperGlue、OmniGlue、DeDoDe 等先进方法,GIMS 的平均匹配数量提升了 3.8×–40.3×。

-

姿态估计准确率(AUC):在不同误差阈值下(5/10/25 像素),GIMS 在室内、室外及通用场景均取得了最高的 AUC。

-

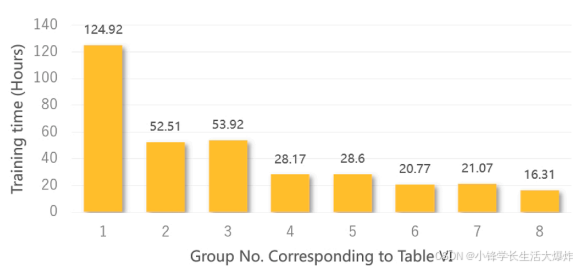

训练效率:通过 多 GPU 数据并行,GIMS 在大规模数据集上能保持可接受的训练时间和内存消耗。

这些结果充分验证了自适应图构建与 GNN-Transformer 融合的有效性与通用性。

应用前景

GIMS 的提出不仅在学术上推动了图像匹配的研究,更在实际应用中具有巨大潜力,例如:

-

无人驾驶与机器人:在动态环境中实现更鲁棒的视觉定位与地图构建。

-

增强现实(AR)与虚拟现实(VR):更精准的特征点匹配带来稳定的场景跟踪。

-

文物修复与医学影像分析:在非刚性变形和噪声干扰下保持可靠匹配。

未来展望

论文也指出了一些挑战和改进方向:

-

如何进一步降低计算开销,使系统在移动端也能实时运行;

-

如何处理超大规模图结构,避免图构建与匹配的性能瓶颈;

-

未来可以探索将 生成模型(如扩散模型) 融入图匹配任务,以进一步提升对复杂场景的适应性。

总结

GIMS 系统为图像匹配提供了一种 兼顾精度与效率的新范式。通过自适应图构建和 GNN-Transformer 的协同作用,它不仅显著提高了匹配准确率和数量,还展现了良好的扩展性。随着代码的开源(GitHub 项目链接),这项工作有望在学术界和工业界得到广泛应用。