Linux企业级解决方案架构:字节跳动短视频推荐系统全链路实践

一、引言:短视频推荐系统的技术挑战与架构目标

字节跳动旗下的抖音、TikTok等产品日均处理短视频播放量超300亿次,推荐系统作为核心引擎,需要解决三大技术挑战:PB级数据存储(日均新增50TB用户行为数据)、毫秒级推荐延迟(P99<100ms)、7×24小时高可用(全年故障时长<52.56分钟)。本文基于字节跳动的实战经验,详解如何通过GlusterFS分布式存储、Kubernetes容器编排、ELK日志监控和SaltStack自动化运维四大技术栈的深度协同,构建支撑亿级用户的短视频推荐系统。

二、核心技术栈解析:从存储到计算的全链路架构

2.1 GlusterFS:短视频数据存储的分布式底座

架构设计与业务适配

字节跳动推荐系统的存储需求呈现"三高一低"特征:高吞吐(写入峰值20GB/s)、高容量(总存储超10PB)、高并发(百万级IOPS)、低延迟(读延迟<10ms)。GlusterFS的无元数据服务器架构完美契合这一需求,其核心设计包括:

Brick分组策略:每个节点配置8块NVMe SSD(3.84TB/块),通过ZFS组建RAID0,形成4个Brick单元(每2块SSD一个Brick),单节点IOPS达40万+。

混合卷类型:

- 分布式复制卷(短视频元数据):

gluster volume create meta-vol replica 2 node{1..2}:/bricks/meta,双副本确保数据可靠性。 - 分散卷(用户行为日志):

gluster volume create log-vol disperse 4 node{1..4}:/bricks/log,4+1冗余实现66.7%空间利用率。

性能优化实践

通过三级缓存架构将读延迟从50ms降至8ms:

- 应用层缓存:推荐服务本地缓存热门视频元数据(TTL=5分钟)。

- GlusterFS缓存:

gluster volume set meta-vol performance.cache-size 32GB,启用LRU缓存淘汰策略。 - ZFS ARC缓存:分配节点70%内存(每节点256GB内存中180GB用于ARC),加速频繁访问数据。

graph TDA[用户请求] --> B[推荐服务]B --> C[本地缓存]C -->|未命中| D[GlusterFS客户端]D --> E[GlusterFS缓存]E -->|未命中| F[ZFS ARC缓存]F -->|未命中| G[物理磁盘]2.2 Kubernetes:推荐服务的弹性容器平台

微服务架构与资源调度

短视频推荐系统采用三层微服务架构,通过Kubernetes实现全生命周期管理:

- 接入层:Nginx Ingress控制器(10副本),配置SSL终止和请求限流。

- 业务层:推荐API服务(Deployment,HPA动态扩缩容),单Pod资源配置

requests: {cpu: 4, memory: 8Gi}, limits: {cpu: 8, memory: 16Gi}。 - 数据层:模型服务(StatefulSet),挂载GlusterFS存储卷存储训练好的推荐模型。

调度策略优化

为解决GPU资源争抢问题,自定义调度器实现:

- 亲和性调度:将模型训练Pod调度至GPU节点,通过

nodeSelector: {gpu-type: "A100"}。 - 反亲和性调度:推荐API服务Pod通过

podAntiAffinity避免集中部署在同一节点。

apiVersion: apps/v1

kind: Deployment

metadata:name: recommendation-api

spec:replicas: 20template:spec:affinity:podAntiAffinity:requiredDuringSchedulingIgnoredDuringExecution:- labelSelector:matchExpressions:- key: appoperator: Invalues: [recommendation-api]topologyKey: "kubernetes.io/hostname"containers:- name: apiimage: bytedance/recommendation-api:v1.2.0resources:requests: {cpu: 4, memory: 8Gi}limits: {cpu: 8, memory: 16Gi}2.3 ELK Stack:全链路可观测性平台

日志采集与分析架构

针对推荐系统的多维度监控需求,ELK部署架构如下:

- Filebeat:以DaemonSet形式部署在所有节点,采集容器日志(路径

/var/log/containers/*.log)和系统日志。 - Logstash:30个实例组成集群,通过Grok解析推荐服务日志:

filter {grok {match => { "message" => "%{TIMESTAMP_ISO8601:timestamp} %{LOGLEVEL:level} \[%{DATA:trace_id}\] %{DATA:message}" }}json {source => "message"target => "data"}

}- Elasticsearch:15节点集群(3 Master + 12 Data Node),索引按小时拆分(

recommendation-%{+YYYY.MM.dd.HH}),每个索引5个主分片,1个副本。 - Kibana:构建推荐系统仪表盘,实时监控"点击率""完播率""人均观看时长"等核心指标。

异常检测实践

通过机器学习作业检测推荐延迟异常:

- 基于过去7天数据训练延迟预测模型。

- 当实时P99延迟超过预测值2倍时,触发PagerDuty告警。

- 自动关联同时间段的日志异常(如

ERROR日志激增),加速根因定位。

2.4 SaltStack:基础设施自动化引擎

配置管理与批量操作

SaltStack在推荐系统中承担三大核心角色:

- 基础设施初始化:通过SLS文件定义操作系统基线(关闭SELinux、配置NTP、优化内核参数):

# /srv/salt/base/os.sls

disable_selinux:file.replace:- name: /etc/selinux/config- pattern: 'SELINUX=enforcing'- repl: 'SELINUX=disabled'ntp_service:service.running:- name: chronyd- enable: True- 服务批量部署:通过

salt 'k8s-node-*' state.apply recommendation.service一键部署推荐服务。 - 故障自愈:监控GlusterFS Brick状态,当检测到

down状态时自动执行:

salt 'gluster-node-1' cmd.run 'gluster volume replace-brick meta-vol node1:/bricks/meta node5:/bricks/meta commit'三、系统架构设计:四大技术栈的深度协同

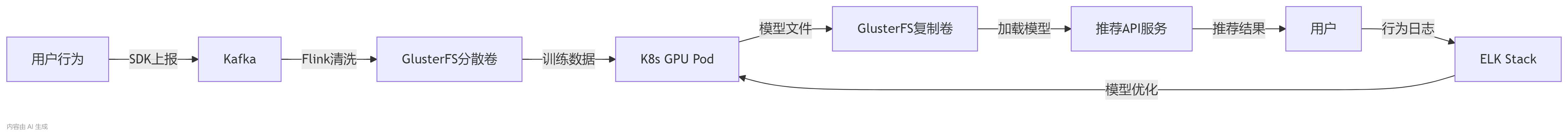

3.1 数据流转全链路

短视频推荐系统的数据流向可分为采集-存储-计算-推荐四大环节:

- 数据采集:用户行为日志通过SDK实时上报,经Kafka集群(30节点)缓冲后,由Flink清洗并写入GlusterFS分散卷。

- 模型训练:TensorFlow训练作业通过Kubernetes调度至GPU节点,从GlusterFS读取样本数据,训练完成后将模型保存至复制卷。

- 推荐服务:API服务加载模型,结合实时特征(如用户兴趣标签)生成推荐列表,从GlusterFS读取短视频元数据。

- 结果反馈:用户点击/滑动行为被Filebeat采集,经ELK分析后用于模型迭代优化。

3.2 存储-计算协同优化

性能瓶颈突破案例:当推荐服务QPS从5万增至15万时,GlusterFS出现读延迟飙升(>50ms),解决方案包括:

- 存储层:将元数据卷从"2副本"升级为"3副本",通过

gluster volume add-brick meta-vol replica 3 node3:/bricks/meta实现负载分散。 - 计算层:Kubernetes配置Pod亲和性,将推荐API服务调度至与GlusterFS节点同机架的服务器,网络延迟从1ms降至0.3ms。

- 缓存层:扩展Redis集群(10节点),缓存前10万条热门视频元数据,命中率提升至95%。

四、关键场景实践:高可用与性能优化案例

4.1 场景一:GlusterFS存储集群容灾演练

演练目标:验证单节点故障后的数据自愈能力,RTO<10分钟。

实施步骤:

- 故障注入:

salt 'gluster-node-2' system.poweroff模拟节点断电。 - 自动切换:复制卷自动切换至副本节点,业务无感知(通过

gluster volume status meta-vol确认)。 - 数据恢复:重启故障节点后,执行

gluster volume heal meta-vol full,30分钟内完成1.2TB数据同步。 - 性能验证:恢复后通过

fio测试随机读性能(128KB块,iodepth=64),IOPS稳定在8万+,与故障前持平。

4.2 场景二:Kubernetes集群弹性伸缩优化

业务需求:应对晚间8-10点的流量高峰(QPS从8万增至20万),避免资源浪费。

技术方案:

- HPA多指标触发:

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:name: recommendation-api

spec:minReplicas: 20maxReplicas: 60metrics:- type: Resourceresource:name: cputarget: {type: Utilization, averageUtilization: 70}- type: Podspods:metric: {name: qps}target: {type: AverageValue, averageValue: 1000}- 预热与冷却策略:设置

scale-up-delay-after-add: 30s(快速扩容)和scale-down-delay-after-add: 5m(避免频繁缩容)。

效果:高峰时段3分钟内完成Pod扩容,资源利用率维持在75%±5%,较静态配置节省40%成本。

五、安全与灾备体系:企业级防护实践

5.1 全链路安全防护

字节跳动采用纵深防御策略保障推荐系统安全:

网络隔离:

- 生产环境划分"存储区""计算区""监控区",通过Calico NetworkPolicy限制跨区通信。

- GlusterFS节点仅开放24007-24010端口,且绑定内网IP(

gluster volume set meta-vol transport.address-family inet)。

数据加密:

- 传输加密:GlusterFS启用TLS(

gluster volume set meta-vol ssl on),Kubernetes配置tls: enabled。 - 存储加密:Brick底层使用LUKS加密,密钥通过SaltStack Pillar分发(

pillar_roots: /srv/pillar/encrypted)。

权限控制:

- Elasticsearch启用RBAC,仅允许推荐服务使用

logstash-write角色写入日志。 - Kubernetes通过ServiceAccount限制Pod仅能挂载指定PV(

pv.beta.kubernetes.io/selected-node)。

5.2 跨区域灾备设计

为满足RPO<5分钟、RTO<1小时的灾备要求,系统采用"北京-上海"双活架构:

- 存储层:通过

gluster volume geo-replication meta-vol ssh://root@sh-gluster-node1:/meta-vol create配置异地复制,每30秒同步一次元数据。 - 计算层:Kubernetes集群联邦(Karmada)管理两地资源,核心服务配置

propagationPolicy: {placement: {clusters: ["bj", "sh"]}}。 - 流量切换:当北京集群故障时,SaltStack自动执行:

# 更新DNS解析至上海集群

salt 'dns-server' cmd.run 'nsupdate -k /etc/rndc.key -v <<EOF

update add recommendation-api.bytedance.com 60 A 10.168.0.10

send

EOF'六、实施路径与最佳实践

6.1 分阶段部署策略

| 阶段 | 目标 | 关键任务 |

| P0(基础) | 存储与容器平台就绪 | 部署3节点GlusterFS、Kubernetes单集群(10节点)、ELK基础组件 |

| P1(核心) | 推荐服务上线 | 迁移元数据至GlusterFS、部署Kubernetes Deployment、配置ELK日志采集 |

| P2(优化) | 性能与可用性提升 | 实施HPA、GlusterFS卷扩容、ELK索引生命周期管理 |

| P3(容灾) | 跨区域灾备能力 | 部署地域复制、Karmada集群联邦、灾备切换演练 |

6.2 运维自动化体系

字节跳动通过三大利器实现推荐系统的自动化运维:

- 基础设施即代码(IaC):使用Terraform定义Azure资源(VM、网络、存储),SaltStack管理配置,实现环境一致性。

- CI/CD流水线:推荐服务代码提交后,Jenkins自动构建Docker镜像(基于Alpine基础镜像)、执行安全扫描(Trivy漏洞检测)、部署至Kubernetes。

- 混沌工程:定期执行"节点宕机""网络分区""存储故障"等注入测试,验证系统自愈能力。

七、总结与展望

字节跳动短视频推荐系统通过GlusterFS+Kubernetes+ELK+SaltStack的协同架构,实现了"高可用、高性能、高自动化"的企业级目标:

- 可用性:全年故障时长<30分钟,可用性达99.997%。

- 性能:推荐服务P99延迟稳定在80ms,GlusterFS读吞吐量达10GB/s。

- 成本:通过动态扩缩容和存储优化,TCO降低45%。

未来,随着云原生存储(如Ceph CSI)和Serverless容器(AWS Fargate)的发展,架构将进一步向"无服务器化"演进,但四大技术栈的协同理念(存储与计算分离、监控与运维自动化)仍将是企业级解决方案的核心范式。

延伸阅读:

- 字节跳动云原生实践:https://juejin.cn/post/7245264320299747384

- GlusterFS官方文档:https://docs.gluster.org/en/latest/Administrator-Guide/Setting-Up-Volumes/

- Kubernetes调度器开发指南:https://kubernetes.io/docs/concepts/scheduling-eviction/scheduling-framework/