论文精读:《Robot Person Following in Uniform Crowd Environment》

文章链接:

[2205.10553] Robot Person Following in Uniform Crowd Environment

摘要

人脸跟踪机器人在安防、养老和社交机器人等领域有广泛应用。然而,当目标人物在统一着装的人群中移动时,该任务尤其具有挑战性。尽管文献中已有大量跟踪器的进展,但当前最先进的跟踪器在此类场景中的人物跟随问题上仍未得到充分解决。

本文致力于提升机器人在人物跟随任务中的感知能力,开发了一种鲁棒且可实时应用的目标跟踪器。我们提出了一种新的机器人人物跟踪系统,配备了新颖的RGB-D跟踪器——基于RGB-D的深度跟踪器(DTRD),能够有效应对统一人群环境下的复杂挑战。

该跟踪器采用了基于变换器(Transformer)的编码器-解码器架构,融合RGB和深度信息,用以区分目标人物与外观相似的干扰物。大量全面的实验结果表明,我们的跟踪器在两个定量评估指标上表现优异,证实其优于其他现有最先进(SOTA)跟踪器。

一、引言

近年来,随着人机协作的发展,移动机器人在工业辅助、医疗护理、监控、养老和环境监测等领域对人物跟随的需求日益增长[1]。传统的机器人跟踪系统多采用激光雷达,获取环境中的距离点云以检测和跟踪目标人物[1]。但激光数据通常存在噪声,且难以实现目标的重识别。

深度学习的兴起推动了视觉跟踪算法的快速发展[2]–[6],使基于视觉的机器人人物跟随成为一种智能且流行的解决方案[7],[8]。该任务的核心挑战在于准确定位目标人物,并及时采取跟随控制动作。其难点主要体现在需要持续识别目标人物,即使在遮挡、尺度变化、旋转等复杂环境下,也要应对因光照变化带来的外观变化。

目前,基于视觉的机器人人物跟随主要依赖鲁棒的视觉目标跟踪器,这些跟踪器集成于机器人中提供感知能力。因此,人物跟随机器人的性能高度依赖于目标跟踪器的鲁棒性和速度。文献中已有多种基于深度学习的目标跟踪器取得了显著进展[9]–[15],其发展得益于多个涵盖旋转、遮挡、低分辨率、小目标等多样现实挑战的广泛基准数据集[16]–[19]。

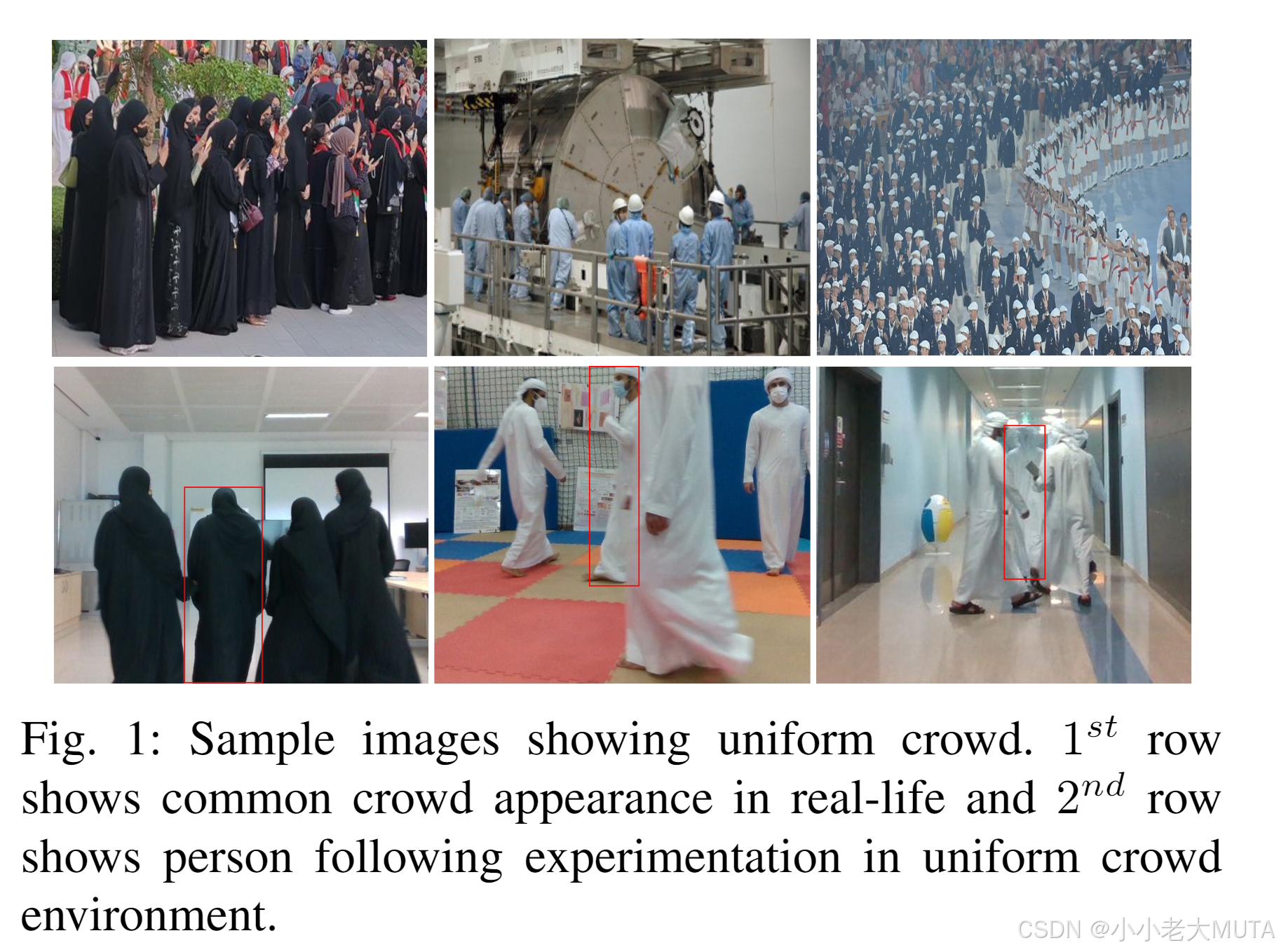

然而,现存基准数据集很少涉及统一人群场景下的人员跟踪,即在目标人物周围的人穿着相似服装的环境中跟踪特定人物。这种情况常见于工业车间、体育馆、学校等场所,如图1所示,也普遍存在于海湾地区及许多亚洲国家中。在此类环境中,仅依赖RGB图像进行人员跟踪对当前最先进的视觉跟踪器而言非常困难,因为它们主要基于外观特征进行感知。当目标与非目标穿着相同服装时,跟踪性能往往会大幅下降。

为解决这一挑战,我们提出了一种新的跟踪系统,利用基于注意力机制的模块,从颜色和深度信息中学习更深层次的表征特征。我们认为,在统一人群的人员跟踪中,仅靠颜色信息不足以区分目标与干扰对象,特别是在目标被外观极其相似的干扰物遮挡时,问题更为复杂。为此,我们将深度信息集成入鲁棒的跟踪架构[14]中。深度信息的加入使得跟踪流程能够更好地区分背景和前景,有效应对高相似度带来的困扰[20]。

总之,本文贡献包括:

• 提出了一套全自主机器人人物跟随系统,配备新颖的RGB-D跟踪器,能够在统一人群和类似外观遮挡等挑战下实现人物跟踪。

• 对多个当前最先进的跟踪器在统一人群环境中的人物跟随性能进行了深入实验评估。

• 引入了一个包含统一人群挑战的新人物跟踪数据集。

二、方法论

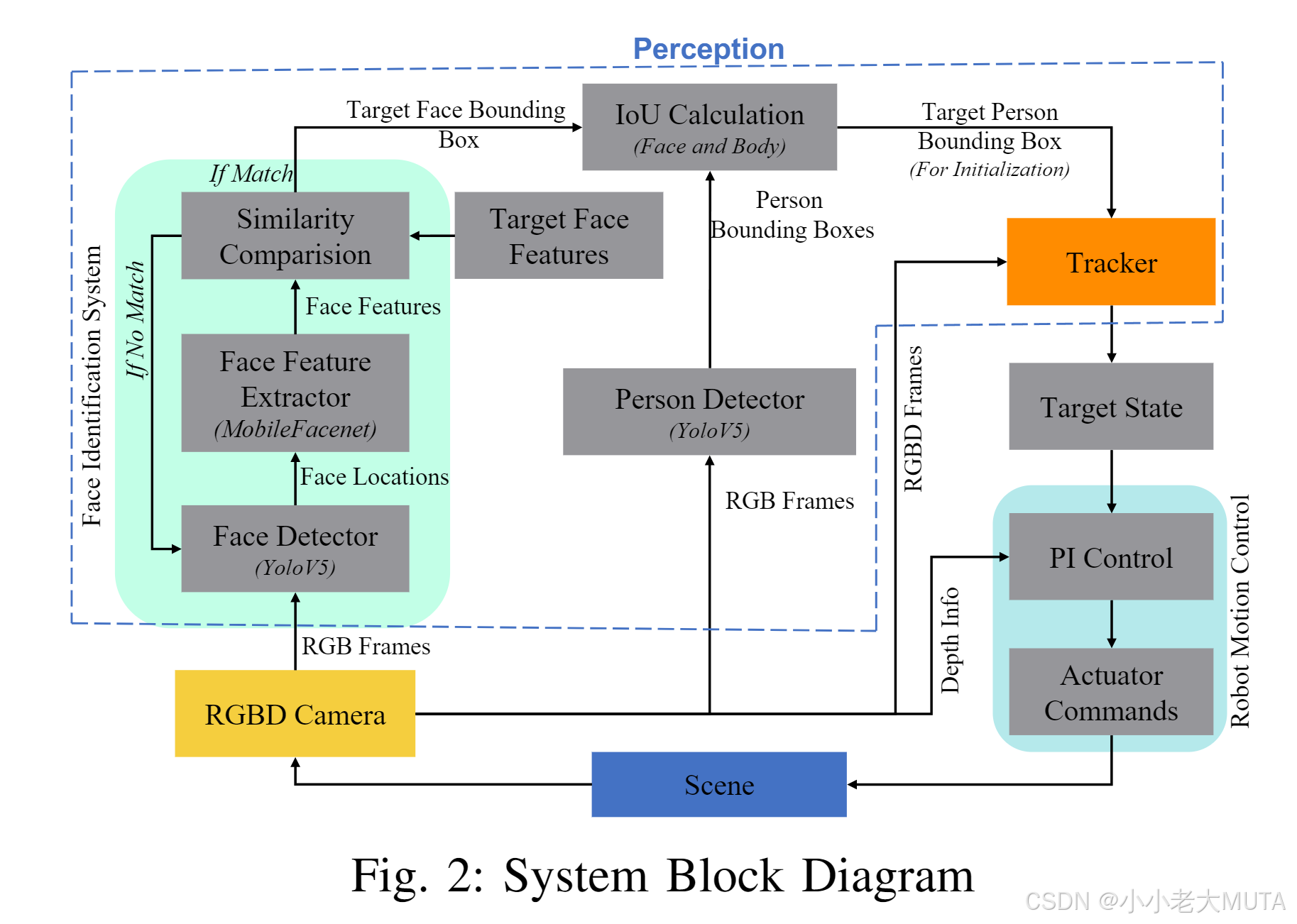

本节介绍我们设计的机器人人物跟随系统的整体流程与组成部分,如图2所示。我们提出的机器人跟随系统是一个完全自主的系统,包含两个主要模块:感知模块(包括人脸识别、人物检测和跟踪)和机器人运动控制。

第II-A节讲解机器人如何持续感知目标人物,第II-B节则阐述机器人的运动控制。

A. 机器人感知

感知模块使机器人能够感知环境并持续识别其目标。该模块的主要目标是实现视觉伺服的自主运行,最大程度减少错误行为。多个子模块协同工作以保证机器人感知的顺畅进行,主要包括:

身份识别模块:基于人脸识别初步确定特定目标人物的身体位置;

跟踪模块:在人群中持续跟踪该目标人物。

(1) 人物识别

由于初始阶段目标人物人脸可见,整体算法包括人脸识别、人物检测和人脸与人物匹配三个部分。为实现快速且鲁棒的人物识别,我们采用了预训练的yoloV5Face[21]进行人脸检测,结合mobile facenet[22]提取特征。mobile facenet将人脸区域嵌入为128维特征向量。通过计算已知目标人脸特征向量与检测到的人脸特征向量之间的欧氏距离,若距离小于0.9阈值即判定为同一人脸,实现人脸验证。

最后,为定位场景中目标人物的全身,我们采用预训练的yoloV5[23]作为人物检测器检测所有人物,计算检测到的人物区域与已识别目标人脸区域的交并比(IoU),IoU最高的对应人物身体即被视为目标人物,用于后续跟踪。

(2)跟踪

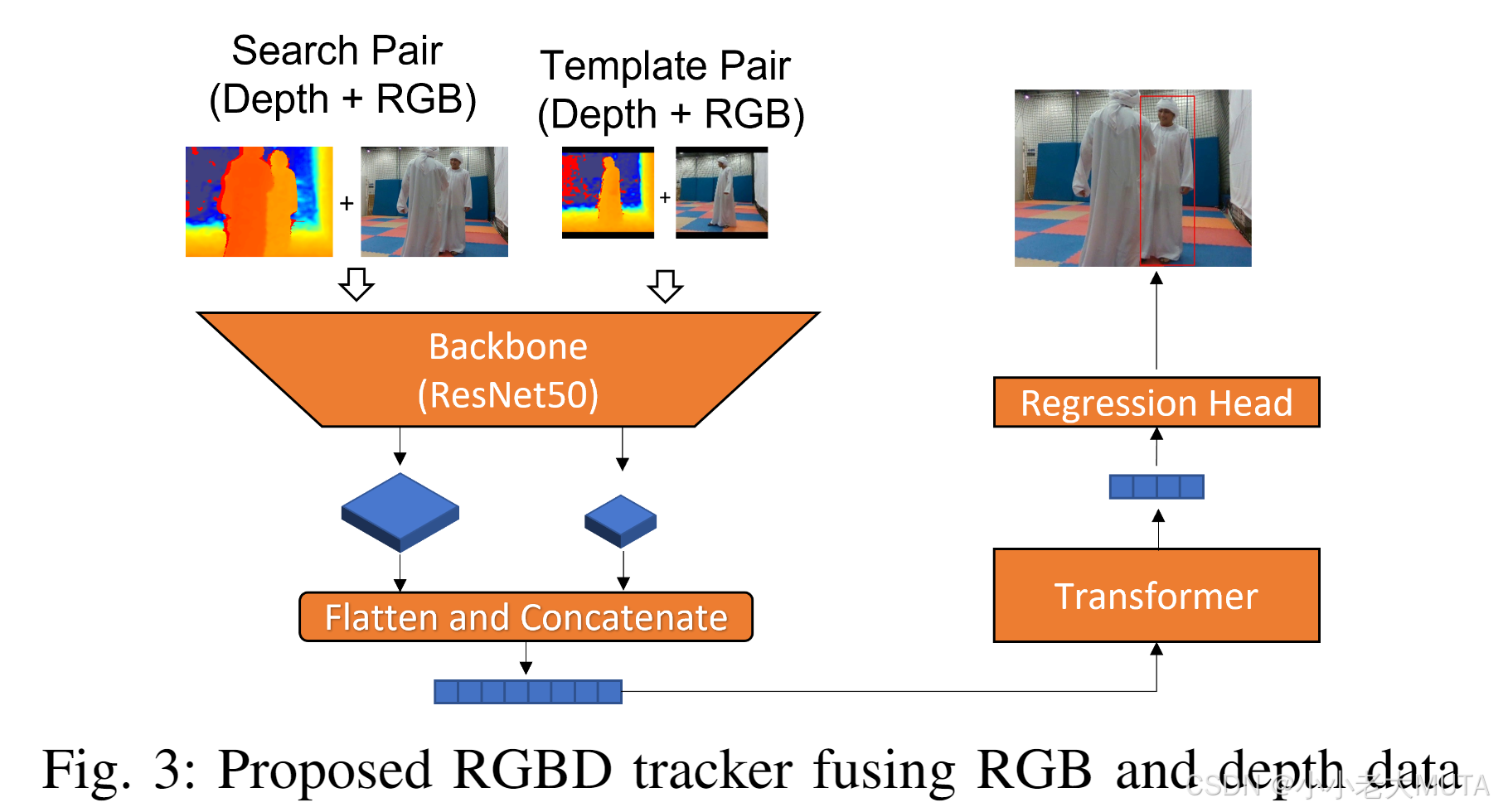

为在统一衣着的人群环境中实现有效跟踪,我们结合RGB和深度信息。仅依靠RGB不足以区分统一人群中视觉特征相似的个体。我们提出了一种新的跟踪模型,称为基于RGB-D的深度跟踪器(DTRD),融合RGB与深度图像,实现更精准的目标区分。该跟踪器能够从RGB和深度图像中提取判别性特征,提升对前景目标与高度相似背景干扰物的区分能力。

此外,跟踪器架构中引入了Transformer模块,以增强特征学习和对特定目标的注意力机制,如图3所示。该模型包含三个主要部分:

Backbone(骨干网络)

采用广泛使用的原始ResNet卷积层[24]进行特征提取,因其表达能力强且通用。输入包含两对图像:模板图像z 和 搜索图像s,每对均包含RGB和深度图。将RGB与深度图合并为4通道图像,,

,然后输入骨干网络。

骨干网络输出两个特征图、

,其中s为步幅,C为特征通道数,H和W分别为高度和宽度。

Transformer模块

包含6个编码器-解码器块和一个位置嵌入层。输入Transformer前,将特征图展平成一维向量,并拼接成长度为、维度为C的特征向量。Transformer将其嵌入到长度为d的一维特征向量中,用于后续处理。

回归头(Regression Head)

由3个全连接层组成,用于预测目标边界框的四个坐标。直接预测目标边界框的左上角和右下角位置。

B. 运动控制

本机器人跟随系统是一个视觉伺服系统,其中目标跟踪器在定位目标中起关键作用。为实现机器人对目标人物的自适应跟随,我们采用了简单的PI控制器作为机器人的运动控制器。同时,我们认为一个良好的目标跟踪器应能补偿控制器的不足,提升机器人跟随性能。

PI控制器定义如下:

其中,,

为控制增益,e(t) 为当前测量值与目标测量值之间的误差,u(t) 为输出速度。

机器人线速度和角速度分别由两个PI控制器控制。

三、实验

本节详细介绍了我们构建的数据集、跟踪器训练过程,以及在统一人群环境下对机器人人物跟随系统进行的实时对比评测实验。

III-A节介绍了数据集的构建及跟踪器训练细节;III-B节说明了实时机器人跟踪的实验设置;III-C和III-D节总结了实验结果并给出了深入观察。

A. 数据集与训练细节

我们提出的跟踪器面临的主要问题是缺乏包含深度信息的统一人群跟踪数据集(即视野中持续出现外观相似的干扰物)。因此,我们收集了45段统一人群视频(平均每段1891帧),同步采集了RGB和深度数据,并使用CVAT工具进行了准确标注(见图1第二排)。该数据集涵盖了多种场景挑战,如遮挡、光照变化、运动模糊等。

我们用70%的数据集对跟踪器进行了训练,初始权重采用了STARK[14]空间模型。为正确嵌入深度信息,骨干网络的第一卷积层被修改为接收四通道输入(RGB加深度),并从头开始训练。训练进行了10个epoch,损失函数包括IoU和L1损失,优化器为ADAMW,学习率为模型部分0.0001,骨干网络部分0.00001。训练完成后,在剩余30%的数据集上评估了跟踪性能。

B. 实时跟踪

为比较系统在目标跟随上的表现,我们选取了5个仅使用彩色图像的当前最先进(SOTA)2D跟踪器(DiMP[25]、ATOM[26]、SiamBAN[11]、STARK[14]、KeepTrack[10])以及我们提出的同时利用彩色和深度图像的3D跟踪器。

1) 实验设置

我们使用pioneer3 AT机器人作为移动平台,搭载位于机器人上方1米处的ZEDm RGB-D相机,控制单元为配备GPU的笔记本电脑。通过OptiTrack系统实时测量机器人和人物的实际位置。

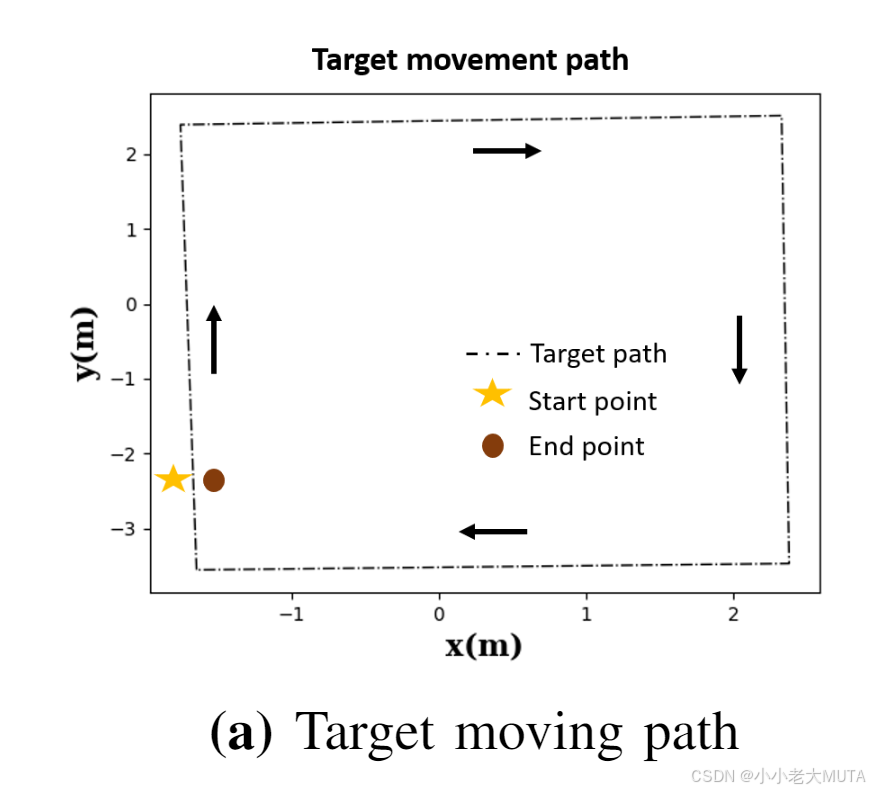

为了进行有效且公平的对比,在图4a所示的预设矩形路径上让目标人物移动,试验在目标人物返回初始位置时结束。机器人和目标人物初始位置固定在图4a左下角,机器人置于角落,目标人物位于其正前方2米处。

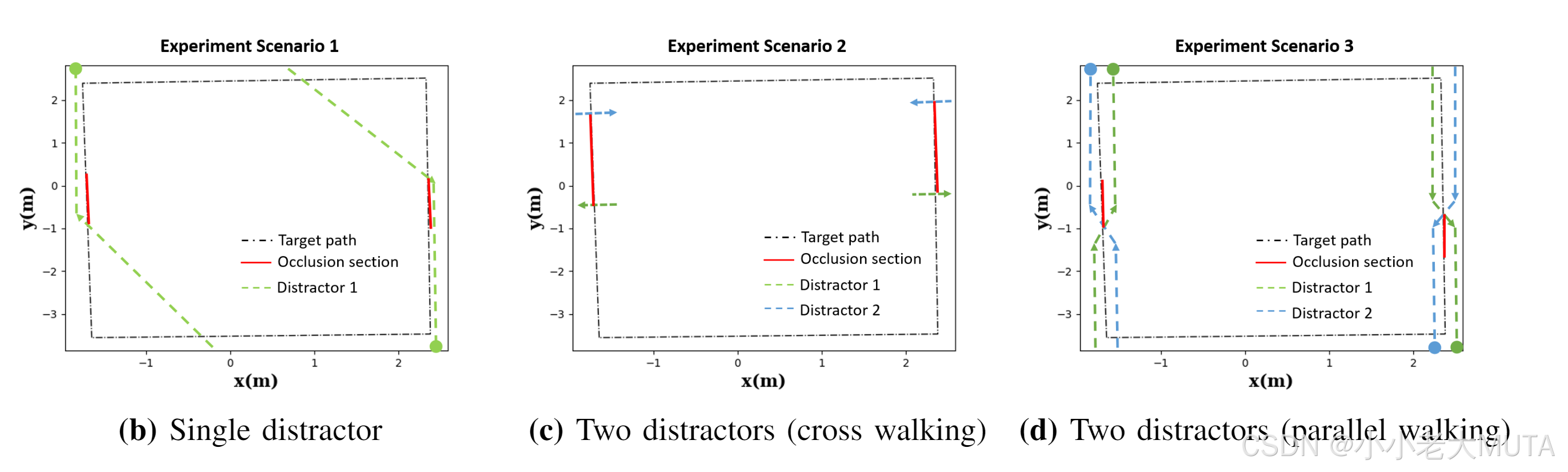

为研究不同干扰物数量对人物跟随系统的影响,实验设置了不同数量的干扰者:

- 无干扰者场景,作为基线评估;

- 单干扰者场景,干扰者横穿路径遮挡目标(图4b);

- 双干扰者场景,干扰者横穿或平行干涉机器人(图4c和4d)。

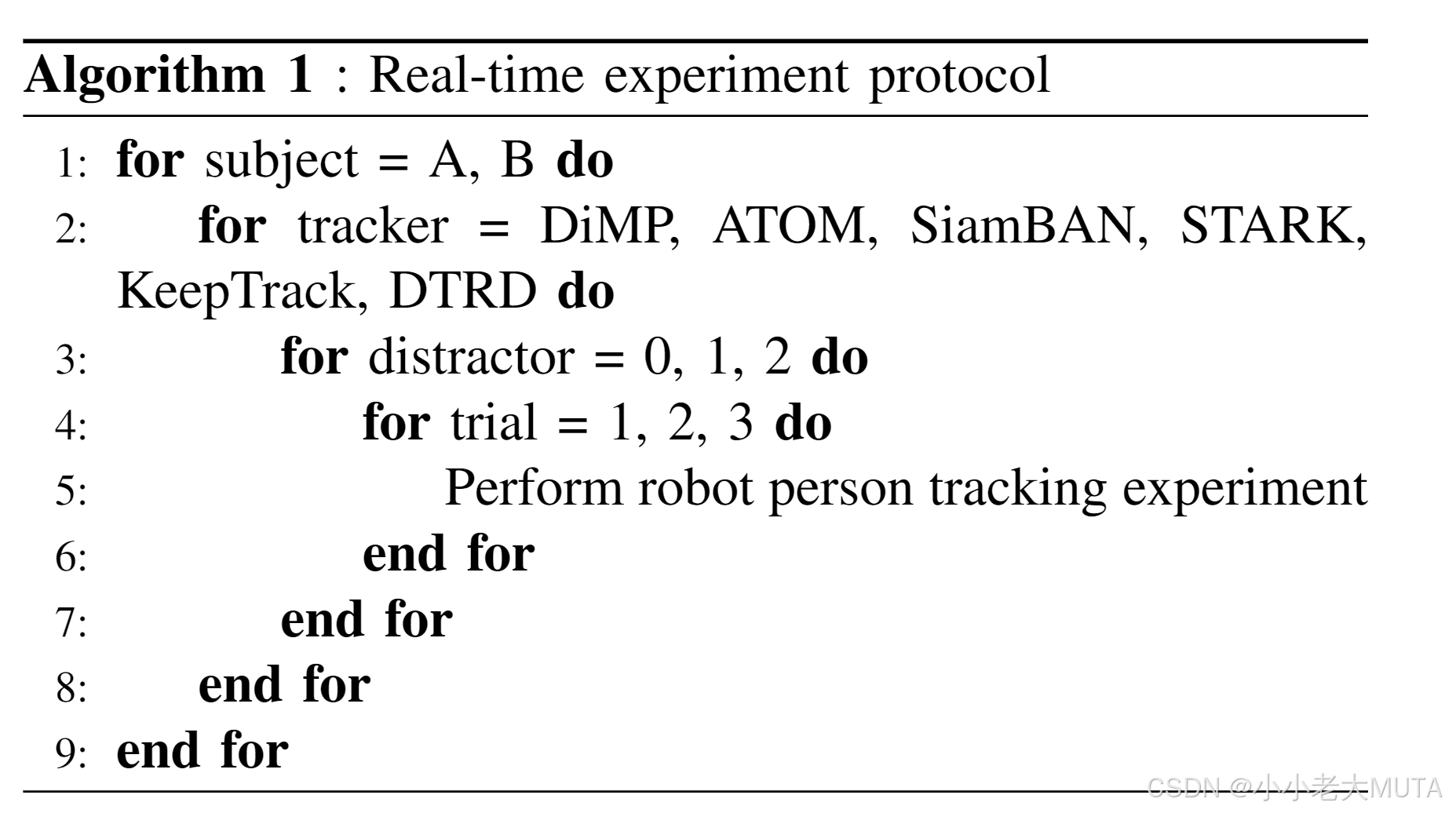

在指标评估过程中,为避免干扰者影响结果,干扰者在机器人开始跟随后停止移动,目标人物继续行进。完整的实验流程如算法1所示,确保系统跟随能力的鲁棒和公平评估。

2) 实验评估指标

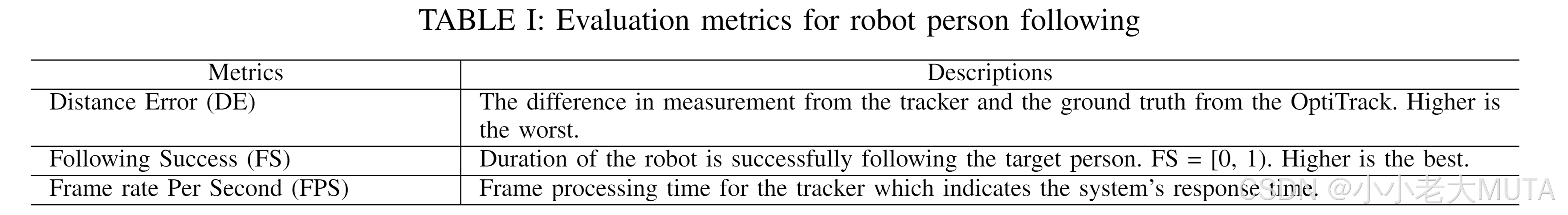

以往研究多采用距离误差和轨迹匹配来定量和定性评估人物跟随,但这些指标在干扰者介入的情况下不足以全面评估系统性能。因此,我们新增了“跟随成功率”(following success)指标,用以更稳健、量化地评估系统表现,详见表I。

C. 结果

基于大量实验,我们报告了四项评估指标的结果。

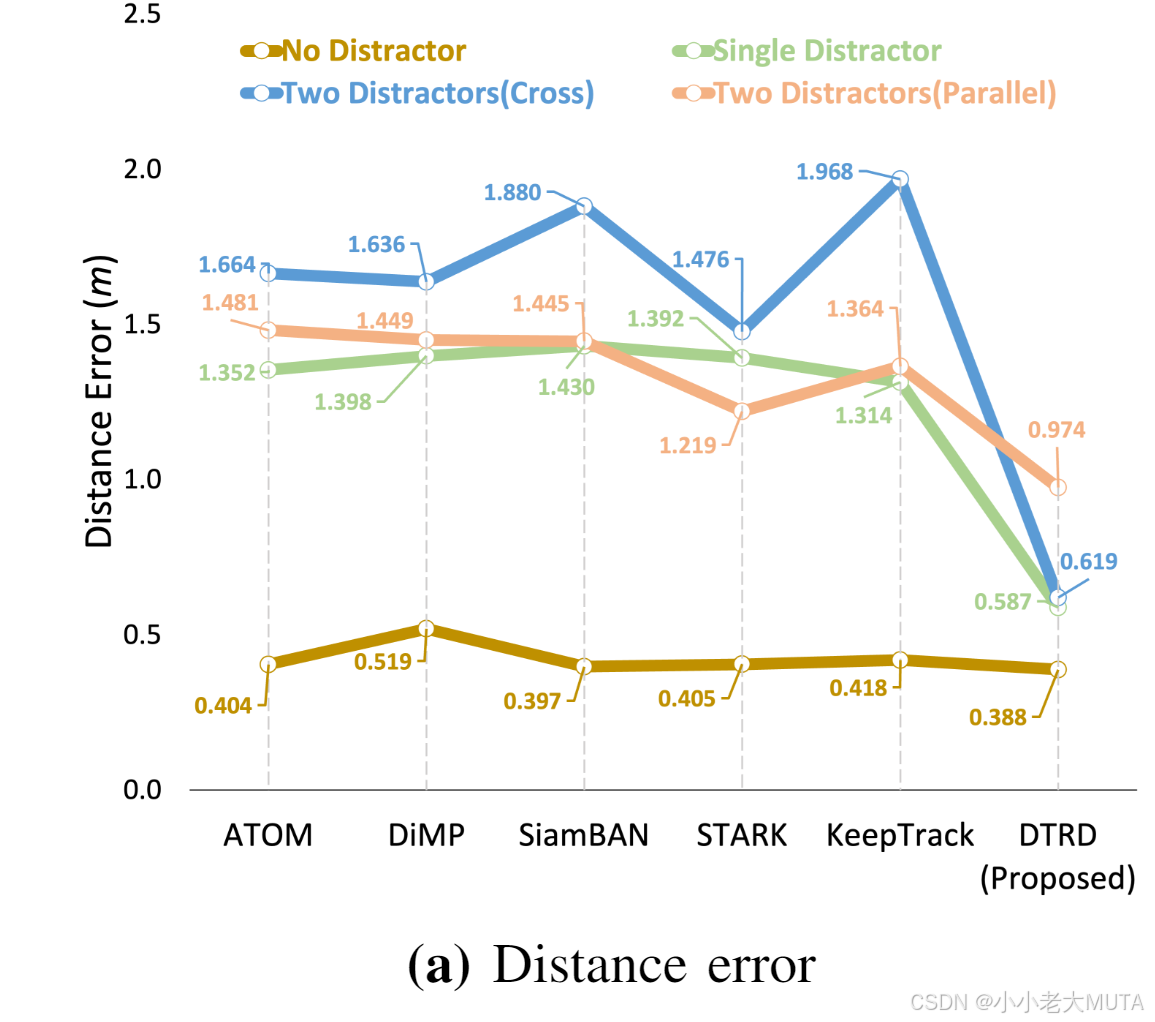

距离误差(DE)结果:DE衡量跟踪器预测的目标状态与OptiTrack真实测量距离间的误差,如图5a所示,无干扰时整体DE约为0.5米。但所有2D SOTA跟踪器在存在干扰者时误差显著增加,平均超过1.2米。相比之下,我们的DTRD跟踪器在两干扰者(横穿)场景误差仅约0.6米,虽两干扰者(平行)场景误差稍高,但仍优于其它跟踪器。

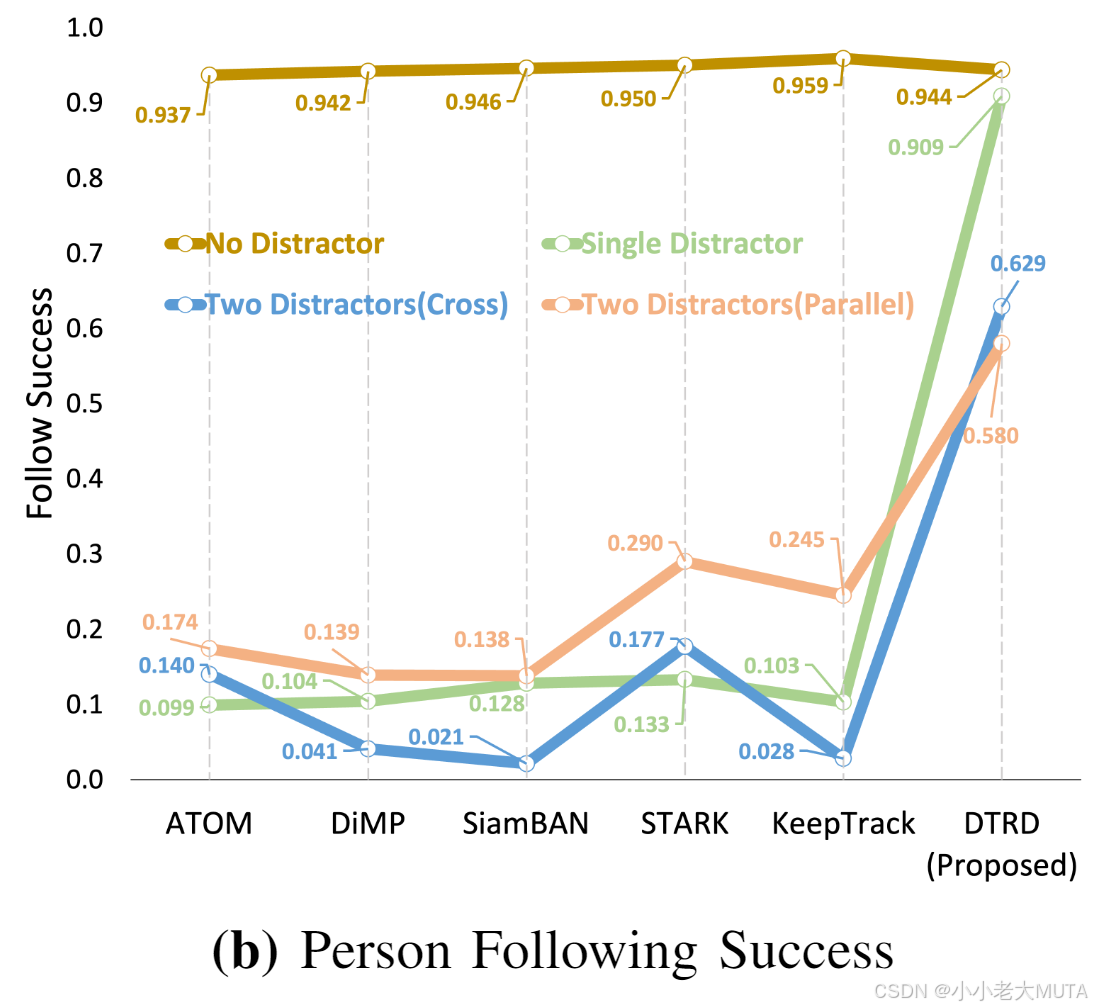

跟随成功率(FS)结果:FS评估跟踪驱动机器人成功跟随目标人物的能力,通过比较机器人与目标人物的行进距离计算。机器人若早早丢失目标,将导致机器人的移动距离短,FS值低;较高的FS值则表明跟踪器即使面对干扰也能保持稳健感知。如图5b,无干扰时所有跟踪器FS值均较高,存在干扰时,所有2D跟踪器FS约为0.2,说明早期丢失目标;而我们提出的跟踪器FS明显较高,表现出良好鲁棒性。

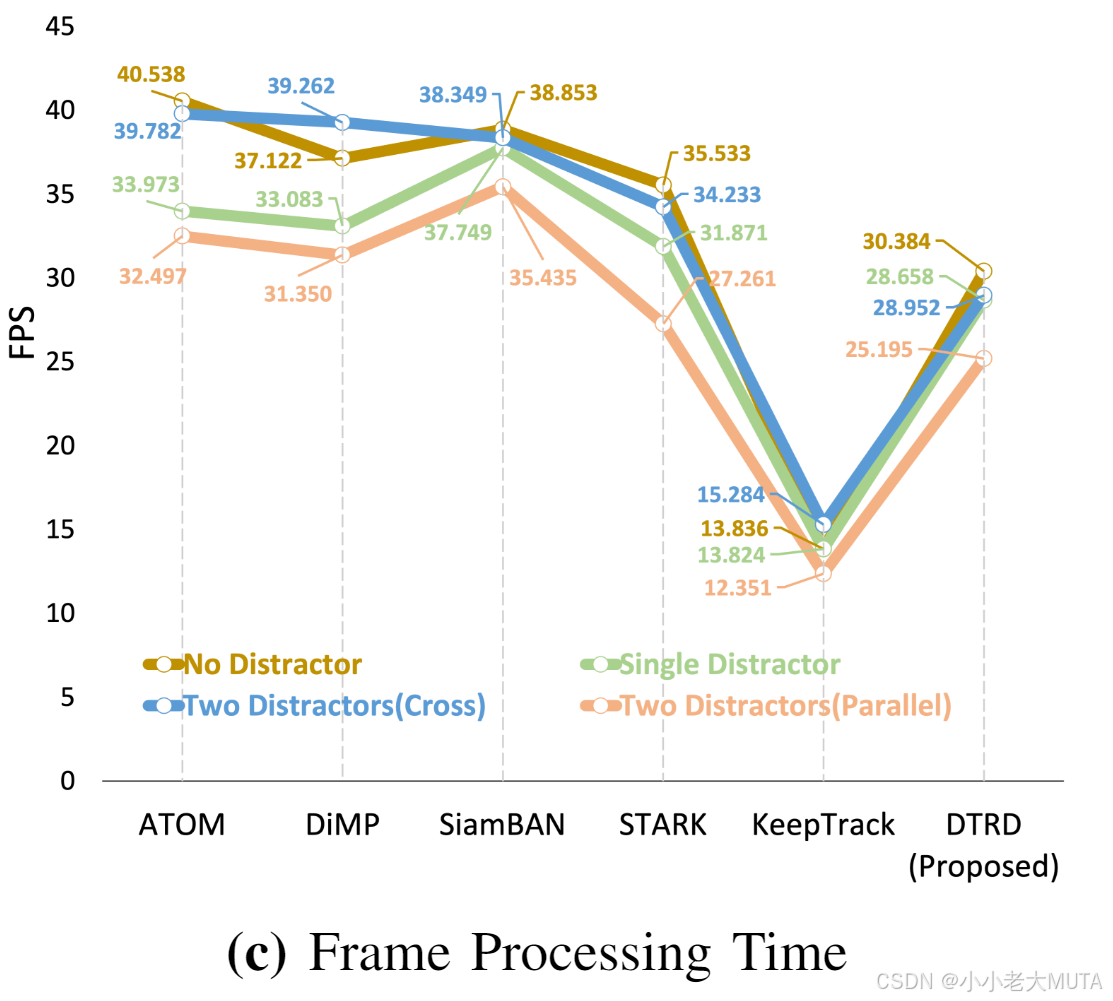

帧率(FPS)结果:该指标反映跟踪器处理帧的速度,直接影响机器人响应速度与稳定性(建议FPS>20)。图5c显示,除KeepTrack(平均FPS约13)外,其余跟踪器均满足该要求。

D. 讨论

实验结果表明,在无干扰者场景中,视觉基础的机器人人物跟随系统能够稳定跟踪目标,多个跟踪器表现均较好。但当干扰者出现时,系统性能明显下降。我们的DTRD跟踪器相较于其他2D跟踪器表现更优,这主要源于两个原因:

首先,所有SOTA 2D跟踪器均仅依赖外观特征,难以应对统一人群环境,而DTRD通过融合深度信息并引入基于注意力的模块,学习更优特征,从而提升区分能力;

其次,我们观察到DTRD在目标与干扰者保持一定距离时表现良好,但当距离过近时仍会受到干扰。两干扰者场景中约0.6的FS值表明DTRD能抵抗首次干扰,但次次干扰时因间距较小而失败。

未来,需要设计更先进的跟踪器以克服统一人群环境下的挑战,同时结合视觉线索的轨迹预测以处理目标暂时视野外情况。值得注意的是,深度信息在解决跟踪难题中潜力巨大。

五、结论

本文提出了一种融合RGB和深度数据的人物跟踪方法,能有效克服外观相似干扰物带来的挑战。该系统对遮挡和统一人群干扰表现出较强鲁棒性,为机器人提供了可靠的感知能力。实验表明,我们的方法在三个稳健的定量评估指标上均优于当前最先进的2D跟踪器。