李飞飞 world labs最新文章 RTFM: A Real-Time Frame Model 翻译及思考

2025年10月16日,李飞飞的world labs团队新发了一篇关于世界模型的文章,我们一起来读一下。

首先是原文链接:https://www.worldlabs.ai/blog/rtfm

在大模型帮助下的翻译内容:

RTFM:实时帧模型(Real-Time Frame Model)

2025 年 10 月 16 日

RTFM A Real-Time Frame Model

今日,我们正式发布 RTFM—— 一款全新的实时生成式世界模型(real-time generative World Model)。RTFM(全称 Real-Time Frame Model,实时帧模型)可在你与之交互的过程中实时生成视频,可用于探索生成的 3D 世界和现实世界场景。目前 RTFM 已作为研究预览版开放。

RTFM 的设计围绕三大核心原则展开:

- 高效性(Efficiency):仅需单块 H100 GPU,RTFM 就能以交互式帧率进行推理。

- 可扩展性(Scalability):RTFM 具备随数据量和计算资源增加而扩展的能力。它无需依赖显式 3D 表示就能对 3D 世界进行建模,并采用通用的端到端架构,从大规模视频数据中学习。

- 持久性(Persistence):你可以与 RTFM 进行不间断交互,其构建的世界永远不会被遗忘。它能建模出一个持久的 3D 世界,即便你转过身去,这个世界也不会消失。

你可点击此处https://rtfm.worldlabs.ai/,在浏览器中体验 RTFM 的演示版本。

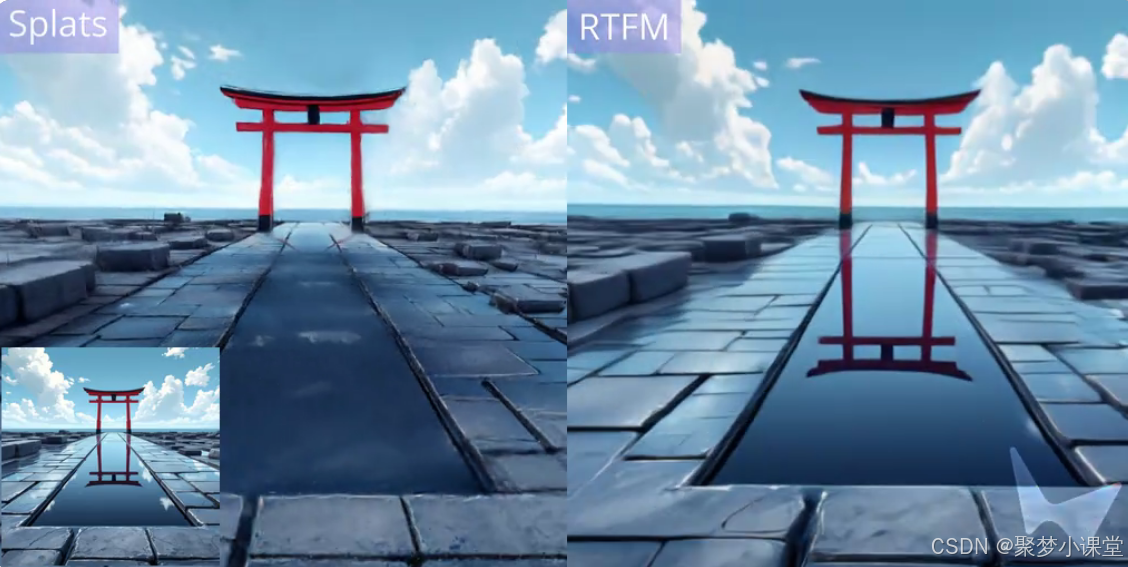

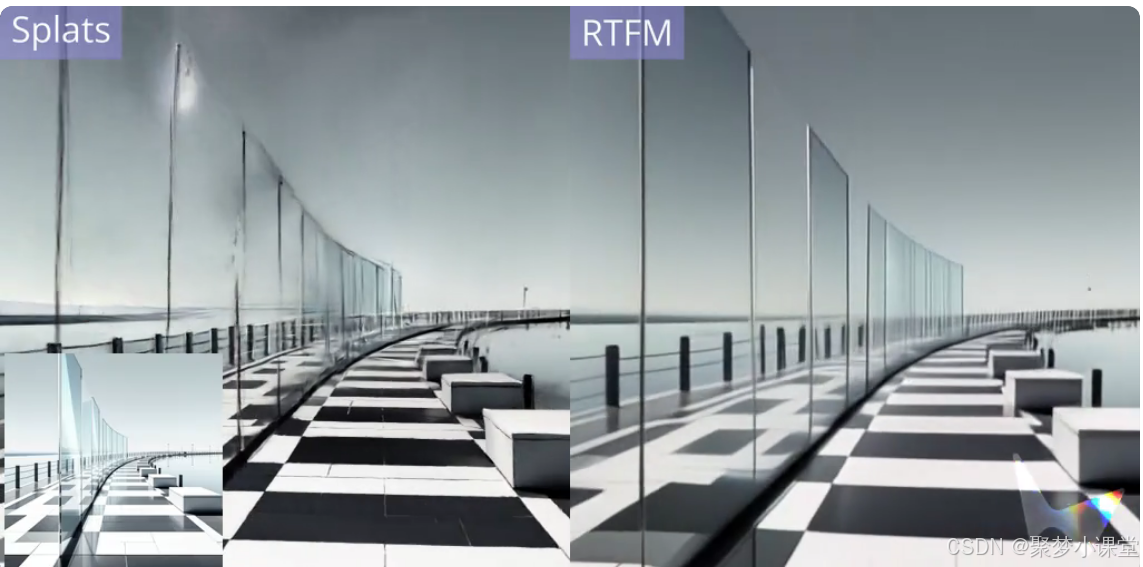

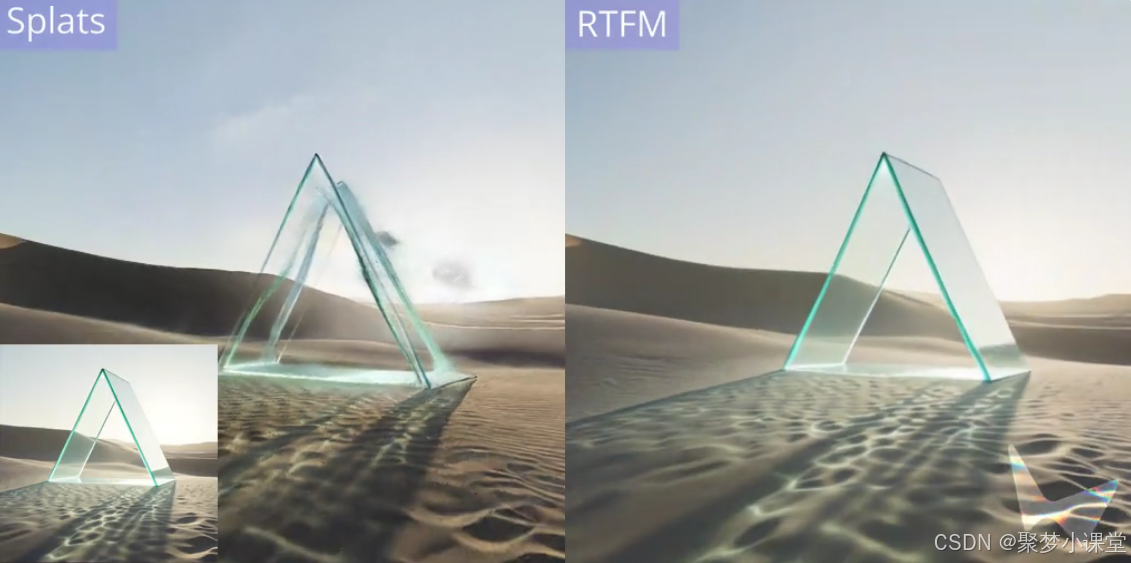

RTFM 能基于单张图像渲染生成 3D 场景。单个模型就能处理多种场景类型、视觉风格及特效,包括反射、光泽表面、阴影和镜头眩光。

【csdn上传视频太麻烦了,所以视频还请移步原文链接,下同】

世界模型对计算资源需求极高

我们对未来充满期待:届时强大的世界模型能够实时重建、生成并模拟出持久、可交互且物理精确的世界。这类模型将改变从媒体到机器人技术等多个行业,其影响还将延伸至更多领域。过去一年,这项新兴技术迎来了蓬勃发展期,生成式视频建模的技术进展已被应用于生成式世界建模领域。

随着该技术的发展,有一点愈发明确:生成式世界模型对计算资源的需求极高,远超如今的大型语言模型(LLMs)。若我们直接将现代视频架构应用于该问题,生成 60 帧 / 秒的交互式 4K 视频流,每秒需生成超过 10 万个 token(约相当于《弗兰肯斯坦》或《哈利・波特》第一部的文本长度);若要在长达一小时甚至更久的交互过程中保持生成内容的持久性,则需要处理超过 1 亿个 token 的上下文。以目前的计算基础设施来看,这既不现实,在经济上也不可行。

我们深信 “惨痛教训”(The Bitter Lesson)的理念:在人工智能领域,那些能随计算资源增加而平稳扩展的简单方法往往会占据主导地位,因为它们能受益于计算成本的指数级下降 —— 而正是这种下降趋势,在数十年间推动了整个科技领域的发展。对于未来计算成本持续下降的趋势,生成式世界模型完全能够从中受益。

这就引出一个很自然的问题:生成式世界模型是否受限于当前的硬件条件?还是说,如今已有办法预览这项技术?

高效性:拉近未来的距离

我们着手设定了一个简单目标:设计一款生成式世界模型,它要足够高效,能在当下部署,同时又能随计算资源的增加而持续扩展。我们的宏伟目标是打造这样一款模型:仅需单块 H100 GPU 即可部署,既能保持交互式帧率,又能确保无论交互多久,所构建的世界都能持久存在。实现这些约束条件,就能让我们 “拉近未来”—— 在当下提供一种体验,让人们得以窥见这类模型未来可能实现的成就。

这一目标影响了我们整个系统的设计,从任务设定到模型架构均涵盖在内。我们对推理栈的各个部分都进行了精心优化,应用了架构设计、模型蒸馏和推理优化领域的最新进展,旨在让运行于当下硬件的模型,能以最高保真度预览未来模型的效果。

可扩展性:作为习得式渲染器的世界模型

传统 3D 图形管线采用显式 3D 表示(如三角形网格、高斯喷溅)对世界进行建模,随后通过渲染生成 2D 图像。它们借助手工设计的数据结构和算法,对 3D 几何结构、材质、光照、阴影、反射等进行建模。数十年来,这些方法一直是计算机图形学领域可靠的主力技术,但它们无法轻松扩展以应对更多数据和计算资源。

RTFM 采用了一种不同的方法。它基于生成式视频建模的最新进展,训练出一个单一神经网络:该网络输入场景的一张或多张 2D 图像,无需构建任何显式的世界 3D 表示,就能从新视角生成该场景的 2D 图像。RTFM 的实现形式是自回归扩散 Transformer(autoregressive diffusion transformer),可对帧序列进行操作;它在大规模视频数据上进行端到端训练,能够以先前帧为条件预测下一帧。

RTFM 可被视为一款习得式渲染器(learned renderer)。它的输入帧会被转换为神经网络激活值(即 KV 缓存,KV cache),这些激活值能隐式表示世界;在生成新帧时,网络会(通过注意力机制)读取这种表示,生成与输入视角一致的世界新视角。将输入视角转换为世界表示,再从这些表示中渲染新帧的机制,均是从数据中通过端到端方式习得,而非手工设计。RTFM 只需在训练过程中观察反射、阴影等复杂特效,就能学会对它们进行建模。

通过将 RTFM 与 Marble 技术相结合,我们可基于单张图像创建 3D 世界。

RTFM 能渲染光照、反射等复杂特效,这些能力均通过数据端到端习得。

在计算机视觉领域,重建(在现有视角间进行插值)与生成(生成输入视角中未呈现的新内容)历来被视为两个独立问题,而 RTFM 模糊了二者之间的界限。当为 RTFM 提供大量输入视角时,由于任务约束性更强,它会倾向于进行重建;当输入视角较少时,它则不得不超出这些视角进行外推。

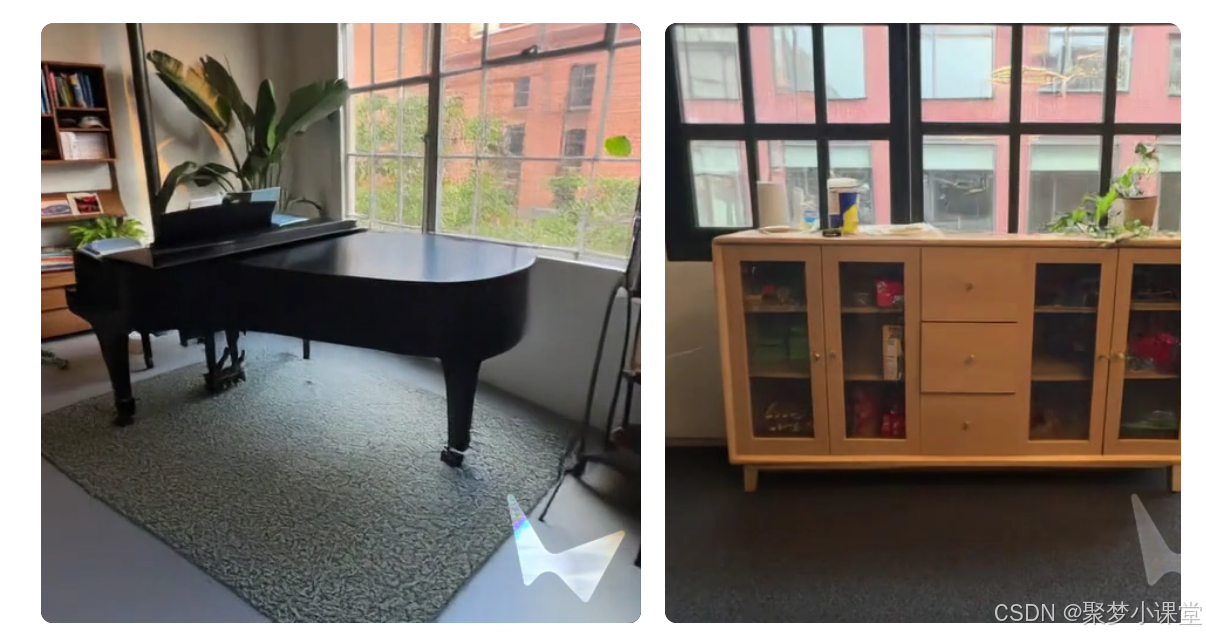

我们可利用 RTFM,基于短视频渲染现实世界场景。

(RTFM 对钢琴的光泽表面进行了建模)

持久性:作为空间记忆的带位姿帧

现实世界的一个关键属性是持久性:当你移开视线时,世界不会消失或发生彻底变化;无论你离开多久,总能回到此前去过的位置。

这对自回归帧模型而言一直是个挑战。这类模型仅通过 2D 图像帧隐式表示世界,因此要实现持久性,就需要模型在用户探索世界的过程中,对不断增加的帧集合进行推理。这意味着生成每一新帧的成本都比前一帧更高,因此模型对世界的记忆实际上受限于其计算预算。

RTFM 通过将每一帧建模为在 3D 空间中具有位姿(位置和朝向,pose)的形式,规避了这一问题。我们通过向模型输入待生成帧的位姿来查询模型,从而生成新帧。因此,模型对世界的记忆(包含在帧中)具有空间结构;它将带有位姿的帧用作空间记忆(spatial memory)。这为模型赋予了一个弱先验假设 —— 即它所建模的世界是三维欧几里得空间 —— 同时又不强制它显式预测该世界中物体的 3D 几何结构。

具备上下文切换(context juggling)功能的 RTFM,能够在大型场景中持久保留几何结构,同时保持高效性。

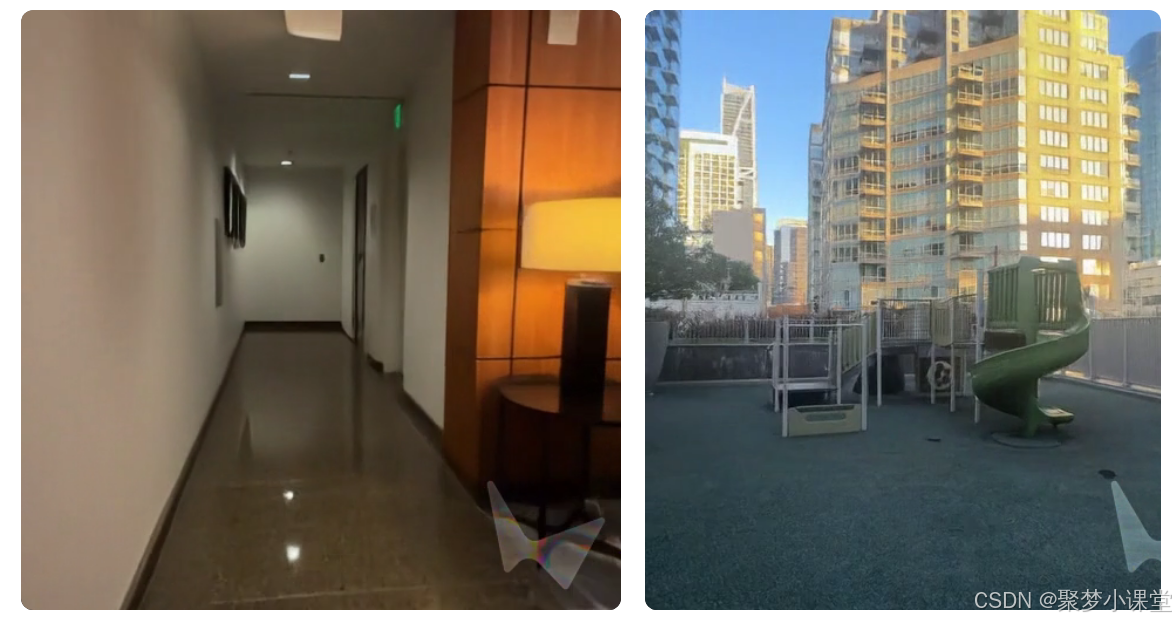

(使用 RTFM 渲染的、带有光泽反射效果的大厅场景)

RTFM 的空间记忆使其具备无界持久性(unbounded persistence)。生成新帧时,我们会从带有位姿的帧的空间记忆中检索附近的帧,为模型形成定制化上下文(custom context)。我们将这种技术称为 “上下文切换”(context juggling):模型在空间的不同区域生成内容时,会使用不同的上下文帧。这使得 RTFM 能够在长时间交互过程中持久保留大型世界,而无需对不断增加的帧集合进行推理。

展望未来

RTFM “拉近了未来”,让人们得以窥见未来世界模型在当下硬件上的部署效果;同时,它还确立了一种技术思路 —— 将世界模型视为通过数据端到端习得的渲染器。

RTFM 的扩展存在许多令人振奋的方向。我们可以增强它,使其能够建模动态世界,并允许用户与生成的世界进行交互。它也非常适合扩展 —— 我们当前的模型以单块 H100 GPU 上的实时推理为目标,但我们预计,针对更大推理预算设计的更大规模模型将持续改进。

如果尚未尝试,不妨现在就体验 RTFM。

以下是体验和思考部分:

以下是基于官网提供的链接,官方固定的几个场景之一,把目标内容移出镜头再移回来之后的场景,可以看到,画面的细节还是有一些变化的,比如说第一组的地板花纹,毛绒地毯的细节,第二组到时保持的还蛮好。

整体有点类似,一个记忆力很强的人可以记住空间里边所有细节,但是特别细节的部分,难免会产生些许的误差,但同时,对于物理环境中金属应该有什么表现,镜子有什么物理特性,透视的原理等有比较好的认知。

(但怎么感觉还是有点类似高斯建模后通过生成模型来还原细节...)

这篇文章核心理念是打破生成式 3D 世界模型的 “高门槛僵局”,让普通人也能在现有硬件上体验 “能持久交互的虚拟世界”,根据目前技术的发展,h100的算力再过三四年普通高端电脑跑的动也是很有机会的。

之前想生成实时 3D 场景,要么得一堆高端 GPU 撑算力,要么交互久了 “世界就消失”,还得手工搭建复杂 3D 模型。而 RTFM 靠三个关键突破解决了这些问题:

一是效率高,单块 H100 GPU 就能让 3D 场景实时跑起来,不用依赖天价算力(虽然h100也挺贵的);

二是能 “记牢” 世界,给每帧标上 3D 位置和方向,就算离开再回来,之前探索的场景也不会丢,不用反复计算所有画面;

三是不用手工做 3D 模型,靠学大量视频就能自己掌握光影、反射这些效果,甚至从单张 2D 图就能生成可探索的 3D 世界,还能灵活补全没见过的视角。

这不仅让 “实时 3D 交互” 离普通人更近,还能给游戏、媒体、机器人导航等行业提供新工具,比如游戏能快速做开放世界,机器人能更好感知 3D 空间,算是把未来的 3D 技术 “拉到了现在能用的水平”。

对了,前一段时间腾讯混元也发了一个“世界模型”,一张图片就可以进去探索,当时我还申请了试用,然后看了下,效果的确还差点意思。

从技术层面上来看,两者至少从理念上差异还挺大。

| 对比维度 | RTFM(李飞飞团队) | 腾讯混元 3D 模型(含 Voyager / 工业级 / 轻量化系列) |

| 技术路径核心 | 隐式 3D 建模:无显式几何结构,基于自回归扩散 Transformer,通过 KV 缓存隐式表征世界 | 显式 + 混合建模:采用 “Transformer+3D CNN” 架构,通过几何 - 纹理解耦生成、深度预测输出 3D 点云 / 网格,支持物理引擎对接 |

| 核心能力侧重 | 1. 单 H100 GPU 实现交互式帧率实时渲染 2. 空间记忆机制(带位姿帧 + 上下文切换)实现无界持久性3. 模糊重建与生成边界 | 1. 工业级高精度建模(Chamfer Distance 提升 30%,三角面片误差<0.01mm) 2. 长距离漫游一致性(支持 800 米 + 无限扩展) 3. 轻量化部署(手机端 8GB 内存可运行) |

| 硬件适配范围 | 聚焦高端单卡:仅支持单块 H100 GPU(交互级帧率需求) | 全场景覆盖: - 工业级:A100/H100 集群(48GB + 显存) - 消费级:RTX 3060/4080(8GB + 显存) - 移动端:骁龙 8 Gen3/M1 Pro(6GB + 内存) |

| 输入输出形态 | 输入:单张 2D 图 / 短视频 输出:实时交互视频流(无固定 3D 文件,随视角动态生成) | 输入:文 / 图 / 草图 / 多视图 输出:可编辑 3D 资产(GLB/OBJ/USDZ)、3D 点云、物理仿真文件,兼容 Unity/Blender |

| 核心定位与目标 | 前沿技术验证:以 “当前硬件预览未来世界模型” 为目标,探索 AI 对 3D 空间的持久感知能力 | 产业落地工具:降低 3D 生产门槛,覆盖工业建模(《流浪地球 3》道具)、游戏资产(《王者荣耀》角色)、AR 教育等场景,将建模周期从 5-10 天压缩至分钟级 |

| 关键技术创新点 | 上下文切换(context juggling):通过空间邻近帧检索优化计算,平衡持久性与效率 | 1. 原生 3D 重建闭环(视频直接导出点云,无需后处理) 2. 动态 FP8 量化(显存占用降低 35%) 3. 物理引擎集成(支持布料 / 流体仿真) |

如果文章介绍的视频录屏确实如此实现,那么 RTFM 对‘世界模型’的探索更显纯粹 —— 无需显式定义‘物体对象’,却能通过帧序列的空间关联,间接呈现世界中物体的坐标关系,还能复现水的反射折射等物理规律的视觉表现(虽暂未看到对动态物体的建模),基本可视为世界模型的雏形。只是当前对 H100 算力的依赖、场景精度的保真度,仍有较大提升空间。

这一思路甚至能启发 3D 游戏引擎的 AI 变革:未来或许会出现‘AI 生成可探索世界’的新游戏生态,改变内容生产形态。当然,这一切的前提是,RTFM 的技术路径被验证可靠,能吸引更多人才参与探索,推动技术落地与优化。