语义三角论对AI自然语言处理中深层语义分析的影响与启示

摘要

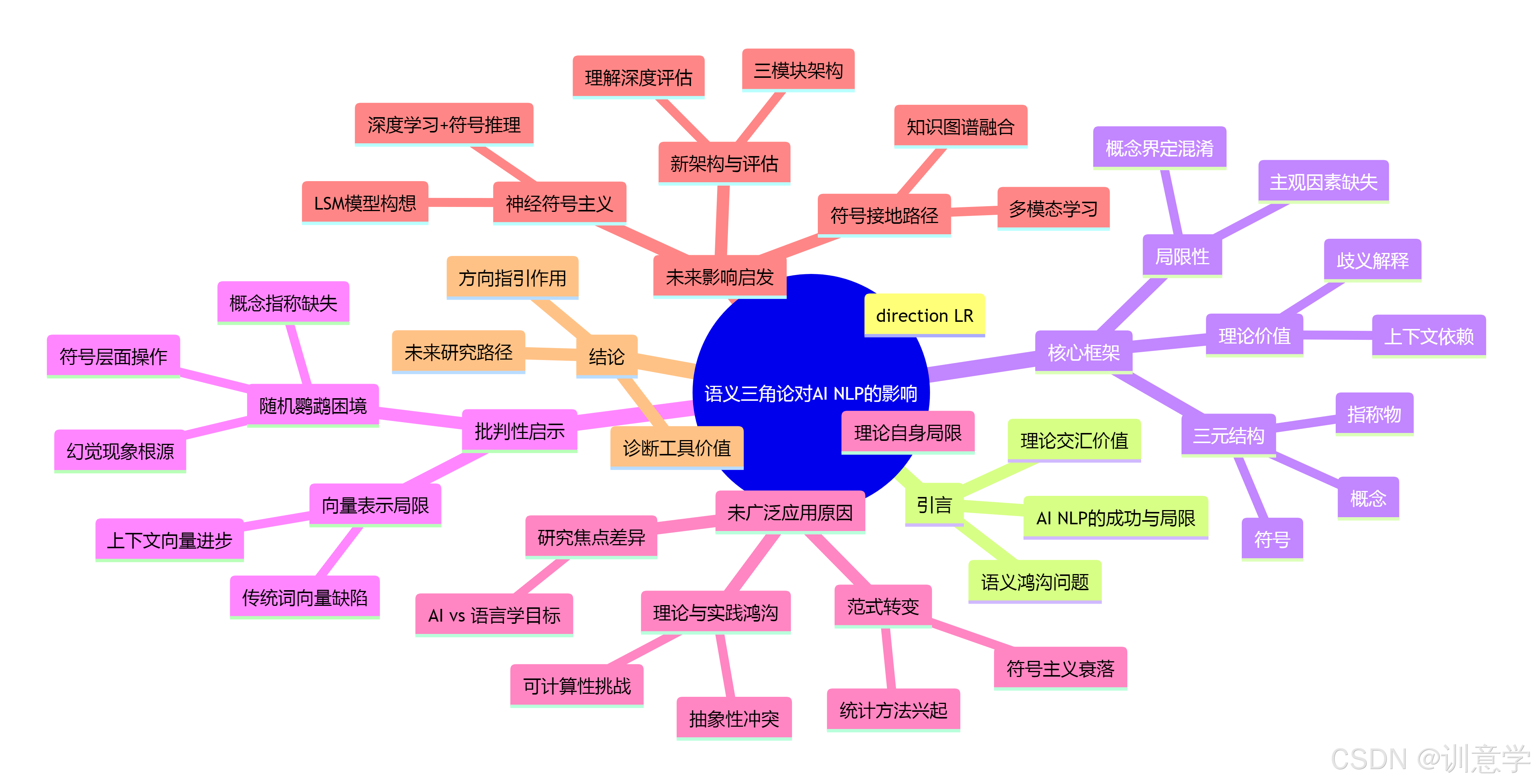

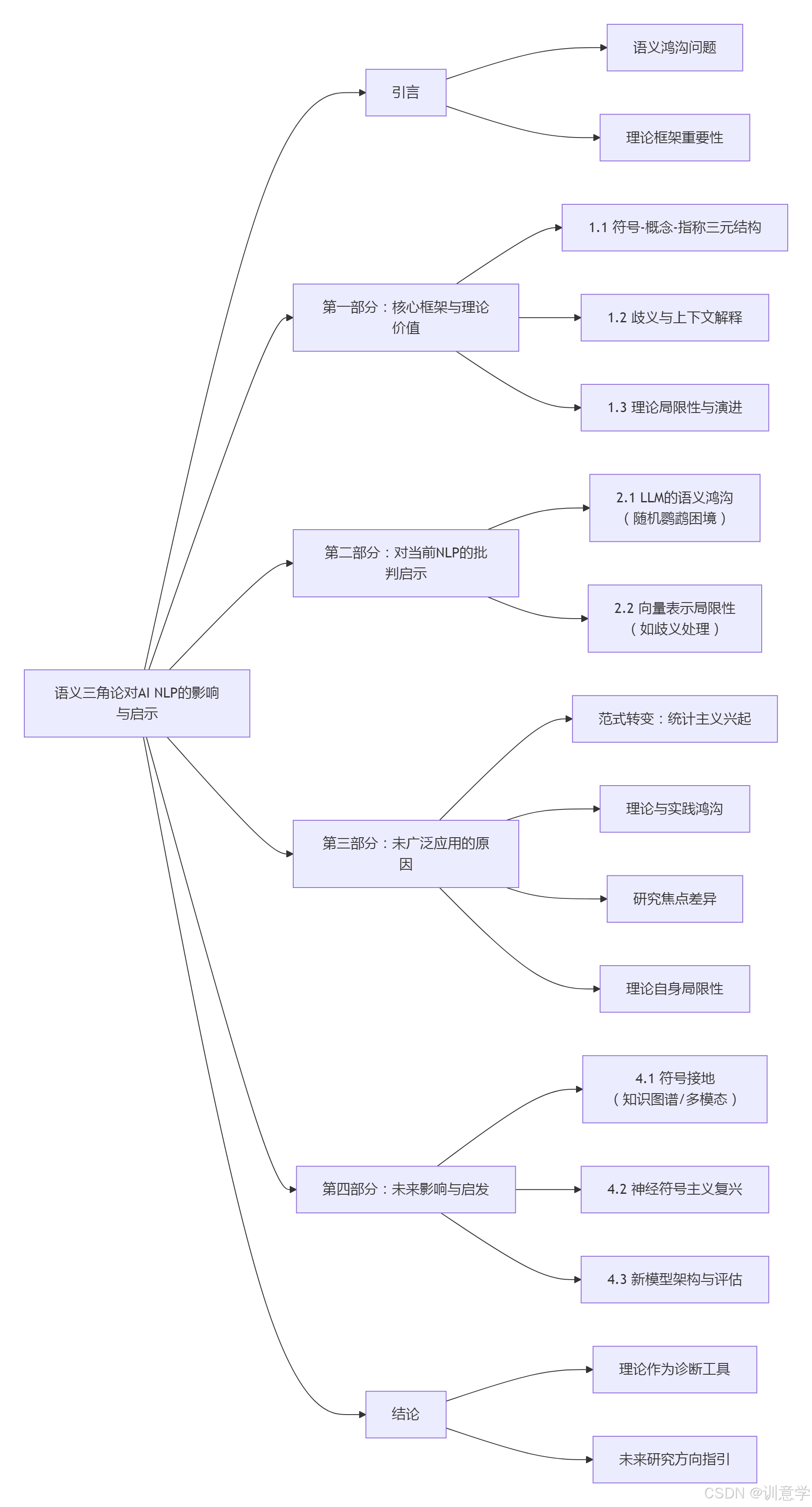

本报告旨在深入探讨语言哲学中的经典理论——语义三角论(Semantic Triangle Theory),对于人工智能(AI)领域中自然语言处理(NLP)的深层语义分析所带来的影响与启示。研究发现,尽管语义三角论并未作为一种具体的算法或模型被当前主流的NLP系统(如基于Transformer的大语言模型)直接实现,但其核心思想为我们理解和批判当前AI技术在语义理解方面的根本性局限提供了深刻的理论框架。该理论通过揭示符号、概念与现实世界指称物之间的复杂关系,精准地指出了当前模型(常被批评为“随机鹦鹉”)存在的“语义鸿沟”或“符号接地问题”。报告分析了该理论未能被广泛应用的技术与历史原因,并进一步指出,语义三角论的核心洞见正启发着AI研究的前沿方向,尤其是在推动知识图谱融合、多模态学习以及神经符号主义等旨在实现更深层次意义理解的领域。因此,语义三角论的价值更多体现在其作为一种诊断工具和哲学指南,为下一代人工智能的语义研究指明了方向。

引言:语义三角论与AI语义研究的交汇点

随着人工智能技术的飞速发展,自然语言处理(NLP)在文本生成、机器翻译和问答系统等领域取得了巨大成功 。然而,尽管以大语言模型(LLM)为代表的技术展现出惊人的语言能力,学术界和工业界也日益认识到其在“真正理解”语言意义方面的深层局限 。这些模型在处理复杂推理、消解歧义和联系现实世界时常常会失败,暴露出所谓的“语义鸿沟”(semantic gap)。

在这一背景下,重温经典的语言哲学理论显得尤为重要。由奥格登(Ogden)和理查兹(Richards)提出的语义三角论,为我们提供了一个分析意义构成基本要素的强大框架 。该理论主张,意义的产生涉及三个要素:符号(Symbol,即语言形式,如词语)、概念(Concept/Thought,即人脑中的思想或意义)和指称物(Referent,即符号在现实世界中指向的对象)。其核心哲学基础在于,符号与指称物之间没有直接、必然的联系;它们的连接必须通过人类头脑中的“概念”作为中介 。这一观点,继承并发展了索绪尔关于符号任意性的思想 恰好点明了当前AI语义研究所面临的核心挑战:如何让机器不仅仅是处理符号,而是能够建立符号、概念与现实世界之间的有效联系。

第一部分:语义三角论的核心框架及其对语义分析的理论价值

1.1 符号、概念与指称:意义的三元结构

语义三角论的核心是一个三角形模型,其三个顶点分别代表:

- 符号(Symbol/Expression) :语言的物理形式,例如口头说出的声音或书面写下的文字 。

- 概念(Meaning/Thought) :当人们使用或听到一个符号时,在脑海中形成的抽象思想或意义 。这是意义的主观部分。

- 指称(Reference/Referent) :符号在外部世界中所指向的实际物体、事件或实体 。

该模型的关键洞见在于,符号与指称物之间的连线是虚线,表示它们之间不存在直接的因果或必然关系 。例如,“树”这个词本身与现实世界中的任何一棵具体的树都没有物理上的相似性。只有通过人类大脑中对“树”的普遍概念(有树干、树枝、树叶的植物),这个词才能与现实中的树木联系起来。这个框架强调了意义理解过程的间接性和认知中介性。

1.2 对歧义与上下文的理论解释

语义三角论为理解自然语言中普遍存在的歧义性(ambiguity)和上下文依赖性提供了清晰的理论解释。

- 歧义性:当一个“符号”可以对应多个不同的“概念”时,歧义就产生了 。例如,“bank”这个符号可以指向“银行”这个金融机构的概念,也可以指向“河岸”这个地理概念。AI模型在处理歧义时遇到的困难,从该理论视角看,是模型无法根据情境有效选择正确的“概念”路径 。

- 上下文:上下文的作用在于帮助听者或读者锁定唯一的、正确的“概念”。例如,在句子“I need to deposit money at the bank”中,“deposit money”这个上下文信息帮助我们将“bank”这个符号与“金融机构”的概念联系起来,而不是“河岸”。当前AI模型,尤其是早期的非上下文模型,正是在利用上下文信息选择正确意义路径方面存在不足 。

1.3 理论的局限性与演进

尽管语义三角论是理解意义的基础模型,但它也存在一些局限性。批评者指出,该模型未能充分考虑使用者个人的主观情感、文化背景等个性化因素对意义构建的影响 。此外,有学者认为其对“概念”和“意义”的界定存在混淆,并提出了如“语义梯形”或“语义四边形”等更复杂的模型来试图弥补其缺陷 。一些研究者还提出了“语义三棱”(Semantic Tetrahedron)等变体,试图扩展其解释力 。尽管存在这些批评和发展,语义三角论作为理解符号关系的基础模型,在21世纪的语言学和翻译研究中仍被用作基准 。

第二部分:语义三角论对当前NLP深度语义分析的批判性启示

语义三角论虽然不是一个计算模型,但它作为一个“诊断工具”,深刻地揭示了当前NLP技术,特别是大语言模型(LLMs)在深层语义理解上的根本缺陷。

2.1 “随机鹦鹉”的困境:揭示LLM的语义鸿沟

许多研究者将LLMs描述为“随机鹦鹉”(stochastic parrots),认为它们本质上是复杂的模式匹配器,擅长模仿人类语言的形式,但并不真正理解其意义 。语义三角论为这一批判提供了理论支撑:

- 聚焦于“符号”层面:当前的LLMs,通过在海量文本数据上进行训练,极其擅长学习“符号”之间的统计关系 。它们能预测哪个词最有可能出现在另一个词之后,从而生成流畅、语法正确的句子。这对应于语义三角中“符号”层面的操作。

- 缺失“概念”与“指称”的连接:然而,这些模型内部缺乏一个明确的、与外部世界相连的“概念”层和“指称”层 。模型生成的“知识”并非源于对世界事实的理解,而是文本数据中共现模式的反映。这就是“符号接地问题”(symbol grounding problem),即模型的符号(词元)没有牢固地“锚定”在真实世界的意义上 。

- “幻觉”现象的根源:当模型缺乏对指称物的真实世界知识时,它就无法验证其生成内容的真实性,从而容易产生“幻觉”(hallucination)——即编造看似合理但完全错误的信息 。从语义三角的角度看,这是因为模型在“符号”和“概念”之间建立了虚假的联系,而没有通往“指称物”的核验路径。

2.2 向量表示的局限性:以歧义处理为例

在NLP中,词向量(word embeddings)是语义表示的核心技术之一。语义三角论同样能揭示其在处理歧喁义时的内在局限。

- 传统词向量的缺陷:像Word2Vec或GloVe这样的静态词向量模型,为每个词(符号)生成一个固定的向量表示 。这意味着无论“bank”在何种上下文出现,它都对应同一个向量。这种“一词一向量”的模式无法捕捉多义性,因为它将与一个符号相关联的多个“概念”混淆在了一个单一的数学表示中 。

- 上下文词向量的进步与局限:像BERT这样的上下文词向量模型通过考虑上下文来为同一个词生成不同的向量,这是巨大的进步 。然而,这种方法仍然主要在“符号”层面操作,通过符号的邻近关系来调整表示,而不是通过一个明确的、结构化的“概念”系统来消歧。它解决了部分问题,但没有从根本上建立起符号到世界的映射。

第三部分:为何语义三角论未在NLP中被广泛直接应用?

尽管语义三角论具有深刻的理论洞察力,但在实际的NLP工程实践中,我们很少看到它的直接应用。其原因主要有以下几点:

-

1. 范式转变:统计方法的兴起与符号主义的衰落

自20世纪90年代以来,NLP领域经历了一场“统计学革命”。基于大规模数据和机器学习的方法在性能上远超了基于规则和复杂语义理论的早期符号主义系统 。实用主义和性能导向使得开发人员更倾向于能够处理大规模数据且效果可量化的统计模型,而像语义三角这样抽象的理论则被暂时搁置。 -

2. 理论与实践的鸿沟:抽象性与可计算性的冲突

语义三角论是一个高度抽象的描述性模型,而非一个可直接执行的计算模型。其核心的“概念/思想”顶点,本质上是人类认知中的一个黑箱。如何将这个模糊、主观的“概念”转化为计算机可以操作和推理的离散、结构化数据,本身就是人工智能的核心难题之一。这使得直接“实现”该理论变得极为困难。 -

3. 研究焦点的差异:AI研究者与语言学家的不同需求

AI研究者和语言学家的目标不尽相同。AI研究者通常更关注于在特定任务(如情感分析、信息抽取)上实现高精度,而对模型是否在哲学意义上“真正理解”语言的关注度较低 。只要模型在特定应用中表现良好,其内部机制的语言学或哲学完备性就不是首要考虑。 -

4. 理论自身的局限性

如前所述,该理论因其未能充分解释意义的主观性和动态性而受到批评 。对于旨在模拟或辅助复杂人类交互的AI系统而言,这种忽略个体差异的理论模型可能不足以指导构建足够精细和个性化的应用。

第四部分:语义三角论对未来AI语义分析的潜在影响与启发

尽管面临上述挑战,语义三角论的核心思想并未过时。相反,它正以一种新的方式,启发着AI语义研究的前沿探索,为解决当前技术的瓶颈提供了路线图。

4.1 迈向符号接地:知识图谱与多模态学习的融合

为了弥合符号与指称物之间的鸿沟,一个关键方向是“符号接地”。语义三角论清晰地指出了这条路径的重要性。

- 知识图谱(Knowledge Graphs)作为“概念”层:知识图谱以结构化的三元组(主语、谓语、宾语)形式存储关于世界实体的知识,可以被视为语义三角中“概念”层的一种可计算的代理 。通过将语言模型与知识图谱相结合,可以让模型在生成文本时查询和利用这些结构化的事实知识,从而减少“幻觉”,提高回答的准确性,实现语言符号与世界知识的“接地”。

- 多模态学习作为“指称”的代理:多模态学习将文本(符号)与图像、声音等其他模态的数据相关联。例如,当模型同时学习“猫”这个词和大量猫的图片时,它就在符号和感官世界(指称物的代理)之间建立了更直接的联系。这为模型提供了一种非语言的方式来“理解”世界。

4.2 神经符号主义的复兴:结合符号推理与深度学习

语义三角论的三元结构天然地契合了神经符号主义(Neuro-Symbolic AI)的思想。这一研究方向旨在结合深度学习的模式识别能力和符号AI的逻辑推理能力。

- 分工与协作:深度学习模型(神经网络)非常适合处理“符号”层面的模糊、连续数据(如文本和图像),而符号系统(如逻辑规则、本体论)则擅长处理“概念”层面的离散、结构化知识和推理。

- 大型符号学模型(LSMs)的构想:受此启发,有研究者提出了构建“大型符号学模型”(Large Semiosis Models, LSMs)的构想 。这种模型旨在通过明确地建模符号、意义及其与世界的联系来解决LLMs的语义鸿沟问题,这正是对语义三角思想的现代诠释和工程化尝试。

4.3 启发新的模型架构与评估标准

语义三角论还启发我们重新思考AI模型的架构和评估方式。

- 模型架构:未来的AI模型或许应该包含三个独立的但相互作用的模块,分别负责:1) 符号处理(如当前的Transformer架构);2) 概念表示与推理(如知识图谱或逻辑引擎);3) 世界交互与感知(如多模态接口)。

- 评估标准:当前的NLP评估大多基于特定任务的性能指标(如准确率、BLEU分数)。语义三角论提醒我们,需要开发新的评估基准,专门用于测试模型的“理解”深度,例如检验其常识推理能力、事实一致性、对指称物属性的理解以及在虚拟环境中执行指令的能力(一种符号接地的终极测试) 。

结论

综上所述,语义三角论对人工智能中自然语言处理的深层语义分析的影响,并非体现在作为一种被直接采纳的算法,而是体现在其作为一种强大而持久的概念框架和批判性工具。它精确地诊断了当前以大语言模型为代表的AI技术的核心软肋——即在符号处理上的巨大成功与在真实意义理解上的深刻失败之间的“语义鸿沟”。

虽然由于历史范式转变、理论与实践的差距等原因,该理论未被广泛集成到主流NLP系统中,但其对意义构成的深刻洞察力,正指引着AI研究的未来。它激励着研究者们超越单纯的统计模式匹配,通过融合知识图谱、发展多模态学习和探索神经符号主义等路径,努力为AI建立起从符号到概念、再到现实世界的桥梁。最终,语义三角论就如同一座灯塔,虽不直接参与航行,却为探索人工智能“意义海洋”的深处,提供了至关重要的方向指引。