Linux内核架构浅谈43-Linux slab分配器:小内存块分配与内核对象缓存机制

在Linux内核的内存管理体系中,伙伴系统(Buddy System)负责处理大内存块(以页为单位)的分配与回收,但对于内核频繁使用的小内存块(如task_struct、inode等对象),伙伴系统的效率会显著下降——不仅会产生大量内存碎片,还会因频繁的页分配操作增加开销。为解决这一问题,Linux内核引入了slab分配器,它基于“对象复用”思想,为小内存块分配提供高效支持,同时实现内核对象的缓存管理。

一、slab分配器的核心定位:填补伙伴系统的短板

要理解slab分配器的价值,首先需要明确它与伙伴系统的分工差异。伙伴系统以“页”(通常4KB)为最小分配单位,适合分配连续的大内存块(如进程地址空间、内核栈),但无法直接处理1KB、256B等更小粒度的内存需求。而内核在运行过程中,大量操作依赖小内存块——例如创建进程时需要分配task_struct结构体(约1.5KB)、打开文件时需要分配inode结构体(约512B),这些场景若直接使用伙伴系统,会导致:

- 内存碎片严重:分配1KB内存时,伙伴系统需分配1页(4KB),剩余3KB空间若无法被复用,会成为内部碎片;

- 分配效率低下:每次小内存分配都触发伙伴系统的页分配流程,涉及复杂的链表操作和内存块合并逻辑;

- 对象初始化开销:内核对象(如inode)的创建需要频繁初始化成员变量,重复创建/销毁会浪费CPU资源。

slab分配器的出现正是为了弥补这些短板。它基于伙伴系统提供的页帧,将其拆分为更小的“slab块”,并为频繁使用的内核对象建立专用缓存,实现“分配-复用-回收”的高效循环。

特性 伙伴系统(Buddy System) slab分配器 最小分配单位 1页(通常4KB) 自定义小内存块(如64B、128B、256B) 适用场景 大内存块分配(如进程虚拟地址空间、内核栈) 小内存块分配(如内核对象、临时数据缓存) 核心优势 避免外部碎片,高效管理连续页帧 避免内部碎片,复用对象减少初始化开销 依赖关系 直接管理物理内存页帧 基于伙伴系统分配的页帧,拆分小内存块

二、slab分配器的核心原理:三层结构与对象缓存

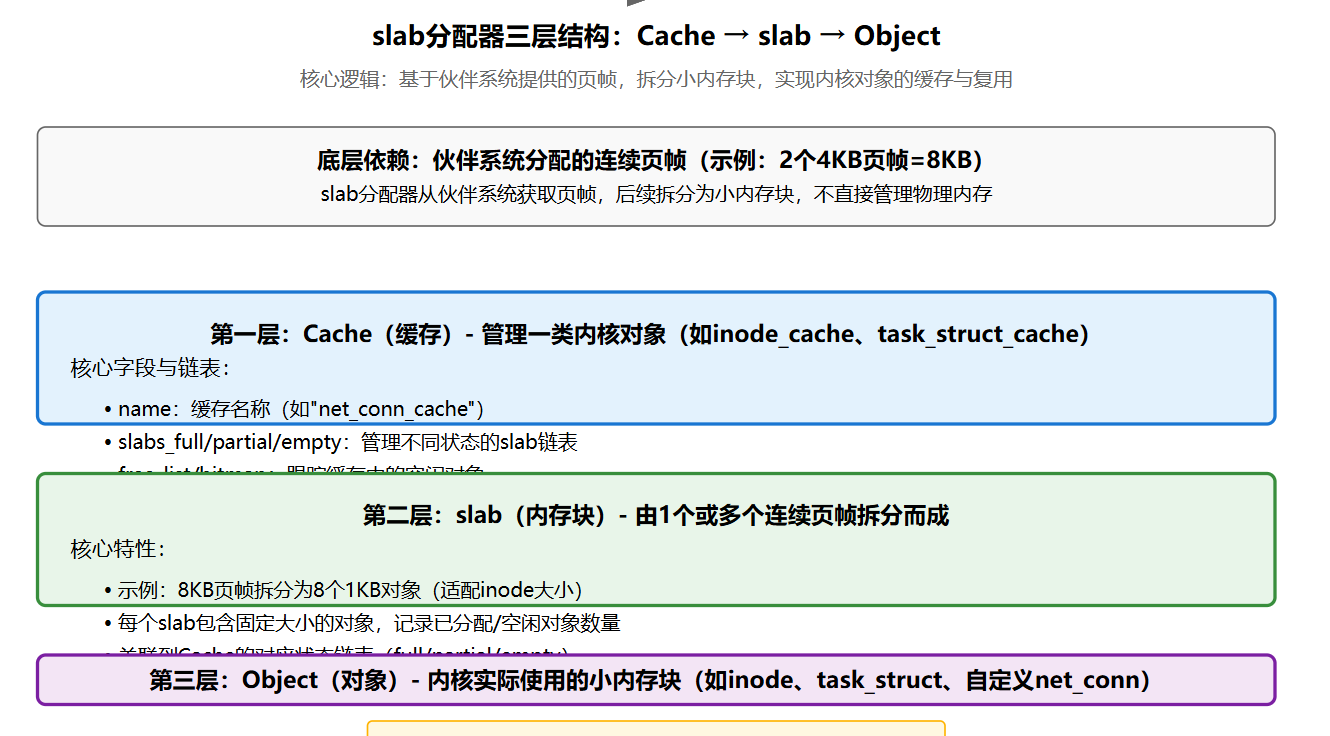

slab分配器通过“缓存(Cache)- slab - 对象(Object)”三层结构实现小内存块管理,同时引入“冷热页”机制优化CPU缓存命中率。

1. 三层结构设计

slab分配器的核心是“缓存”概念,每个缓存对应一类内核对象(如inode、task_struct)或通用小内存块。每个缓存由多个slab组成,每个slab则由一个或多个连续页帧拆分而成,最终每个slab包含多个大小相同的“对象”(即实际分配给内核的小内存块)。

- 缓存(Cache):最高层结构,代表一类对象的管理单元。例如,“inode_cache”专门管理inode对象,“task_struct_cache”管理task_struct对象。每个缓存维护三个链表:

slabs_full:所有对象已分配的slab链表;slabs_partial:部分对象已分配的slab链表;slabs_empty:所有对象未分配的slab链表。

- slab:中间层结构,由1个或多个连续页帧组成(如2个页帧组成8KB的slab)。slab内部将页帧拆分为固定大小的对象,例如将4KB页帧拆分为16个256B的对象。每个slab记录已分配/空闲对象的数量和位置。

- 对象(Object):最底层结构,即内核实际使用的小内存块。对象分为“空闲”和“已分配”两种状态,空闲对象通过链表或位图管理,分配时直接从空闲链表中取出,回收时放回链表(无需重复初始化)。

struct kmem_cache {const char *name; // 缓存名称(如"inode_cache")size_t object_size; // 单个对象大小size_t align; // 对象对齐要求unsigned int flags; // 缓存标志(如SLAB_HWCACHE_ALIGN)// slab链表:full/partial/emptystruct list_head slabs_full;struct list_head slabs_partial;struct list_head slabs_empty;// 空闲对象管理(不同实现方式)union {struct list_head free_list; // 空闲对象链表struct { // 位图管理(适用于小对象)unsigned long *bitmap;unsigned int bitmap_size;};};// 统计信息unsigned int num_objects; // 每个slab包含的对象数unsigned int objects_per_slab; // 同num_objectssize_t slab_size; // 每个slab的大小(页帧总数×页大小)

};

2. 对象缓存与复用机制

slab分配器的核心优化之一是“对象复用”。对于频繁创建/销毁的内核对象(如inode、dentry),slab会为其建立专用缓存,对象回收时不释放内存,而是标记为“空闲”并保留在缓存中,下次分配时直接复用,避免重复初始化。

示例:inode对象的缓存流程

- 缓存初始化:内核启动时,通过

kmem_cache_create("inode_cache", sizeof(struct inode), 0, SLAB_HWCACHE_ALIGN, NULL)创建inode专用缓存,指定对象大小为sizeof(struct inode),并按CPU缓存行对齐(优化访问速度); - slab分配:当首次分配inode时,缓存发现

slabs_empty和slabs_partial为空,调用伙伴系统分配2个连续页帧(8KB),拆分为8个1KB的inode对象(假设inode大小为1KB),构建新slab并加入slabs_partial链表; - 对象分配:从

slabs_partial的slab中取出一个空闲inode对象,调用初始化函数(如inode_init_always)初始化关键成员,返回给内核使用; - 对象回收:当inode不再使用时,内核调用

kmem_cache_free(inode_cache, inode),将inode对象标记为空闲并放回slab的空闲链表,slab仍保留在缓存中; - 缓存收缩:当系统内存紧张时,内核会扫描

slabs_empty链表,将空闲slab的页帧归还给伙伴系统,释放物理内存。

注意:对象复用并非“零成本”——回收的对象可能残留旧数据,因此内核必须在分配时重新初始化关键成员(如inode的i_mode、i_size等)。但相比重新分配内存并初始化所有成员,复用仍能显著减少开销。

3. 冷热页机制:优化CPU缓存命中率

slab分配器还引入“冷热页”机制,利用CPU缓存的局部性原理提升访问速度。其核心思想是:

- 热页(Hot Page):包含最近被访问过的对象的slab页帧,这些页帧大概率仍在CPU缓存中,分配时优先使用热页中的对象,减少CPU缓存失效;

- 冷页(Cold Page):包含长期未被访问的对象的slab页帧,这些页帧可能已被换出CPU缓存,仅在热页无空闲对象时使用。

例如,当分配一个task_struct对象时,slab分配器首先检查“热页”链表中的slab,若有空闲对象则直接分配;若热页无空闲,则从“冷页”链表中取对象,并将对应的页帧加载到CPU缓存。这种机制能有效减少CPU缓存 miss,提升内核运行效率。

三、slab分配器的关键接口与技术示例

Linux内核提供了一组标准接口,用于创建缓存、分配/回收对象,以及销毁缓存。以下是核心接口的使用示例,基于Linux 2.6.24内核版本(文档中指定的核心版本)。

1. 核心接口定义

代码示例

// 1. 创建slab缓存

struct kmem_cache *kmem_cache_create(const char *name, // 缓存名称size_t size, // 对象大小size_t align, // 对齐要求(0表示默认对齐)unsigned long flags, // 缓存标志void (*ctor)(void *) // 对象构造函数(初始化)

);// 2. 从缓存分配对象

void *kmem_cache_alloc(struct kmem_cache *cache, // 目标缓存gfp_t gfp_flags // 内存分配标志(如GFP_KERNEL)

);// 3. 回收对象到缓存

void kmem_cache_free(struct kmem_cache *cache, // 目标缓存void *obj // 待回收的对象

);// 4. 销毁slab缓存

void kmem_cache_destroy(struct kmem_cache *cache);// 5. 通用小内存块分配(基于默认缓存)

void *kmalloc(size_t size, gfp_t gfp_flags);// 6. 通用小内存块回收

void kfree(const void *obj);

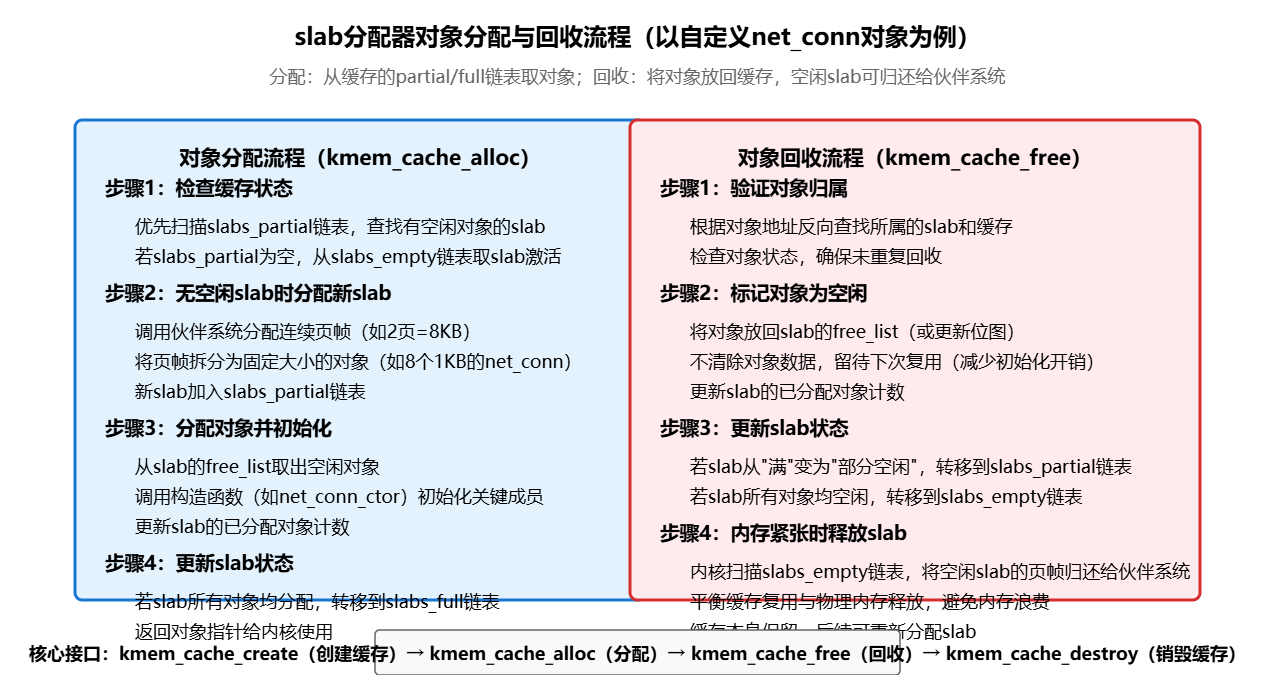

2. 技术示例:自定义内核对象的slab缓存

假设内核需要频繁创建“网络连接信息”对象(struct net_conn),我们可以为其创建专用slab缓存,优化分配效率。

#include <linux/module.h>

#include <linux/slab.h>

#include <linux/list.h>// 定义自定义内核对象:网络连接信息

struct net_conn {unsigned int conn_id; // 连接IDunsigned char ip[16]; // 目标IP地址(IPv6)unsigned short port; // 目标端口struct list_head list; // 链表节点(用于连接管理)

};// 全局slab缓存指针

static struct kmem_cache *net_conn_cache;// 对象构造函数:初始化net_conn成员

static void net_conn_ctor(void *obj) {struct net_conn *conn = (struct net_conn *)obj;conn->conn_id = 0;memset(conn->ip, 0, sizeof(conn->ip));conn->port = 0;INIT_LIST_HEAD(&conn->list); // 初始化链表节点

}// 模块初始化:创建slab缓存

static int __init net_conn_cache_init(void) {// 创建缓存:对象大小=sizeof(struct net_conn),按64字节对齐,启用构造函数net_conn_cache = kmem_cache_create("net_conn_cache", // 缓存名称sizeof(struct net_conn), // 对象大小64, // 对齐要求(64字节,适配CPU缓存行)SLAB_HWCACHE_ALIGN | SLAB_CONSISTENCY_CHECKS, // 标志:缓存行对齐+一致性检查net_conn_ctor // 构造函数);if (!net_conn_cache) {printk(KERN_ERR "Failed to create net_conn slab cache\n");return -ENOMEM;}printk(KERN_INFO "net_conn slab cache created successfully\n");return 0;

}// 测试:分配/回收net_conn对象

static void test_net_conn_alloc(void) {struct net_conn *conn1, *conn2;// 从缓存分配对象(GFP_KERNEL:可睡眠等待内存)conn1 = kmem_cache_alloc(net_conn_cache, GFP_KERNEL);if (!conn1) {printk(KERN_ERR "Failed to allocate net_conn object\n");return;}conn2 = kmem_cache_alloc(net_conn_cache, GFP_KERNEL);if (!conn2) {printk(KERN_ERR "Failed to allocate net_conn object\n");kmem_cache_free(net_conn_cache, conn1); // 回收已分配的conn1return;}// 使用对象(模拟设置连接信息)conn1->conn_id = 1001;strncpy(conn1->ip, "2001:db8::1", sizeof(conn1->ip)-1);conn1->port = 8080;conn2->conn_id = 1002;strncpy(conn2->ip, "2001:db8::2", sizeof(conn2->ip)-1);conn2->port = 8081;printk(KERN_INFO "Allocated net_conn: conn_id=%u, ip=%s, port=%u\n",conn1->conn_id, conn1->ip, conn1->port);printk(KERN_INFO "Allocated net_conn: conn_id=%u, ip=%s, port=%u\n",conn2->conn_id, conn2->ip, conn2->port);// 回收对象(放回slab缓存,不释放内存)kmem_cache_free(net_conn_cache, conn1);kmem_cache_free(net_conn_cache, conn2);printk(KERN_INFO "net_conn objects freed to slab cache\n");

}// 模块退出:销毁slab缓存

static void __exit net_conn_cache_exit(void) {if (net_conn_cache) {kmem_cache_destroy(net_conn_cache);printk(KERN_INFO "net_conn slab cache destroyed\n");}

}module_init(net_conn_cache_init);

module_exit(net_conn_cache_exit);

MODULE_LICENSE("GPL");

MODULE_DESCRIPTION("Slab Allocator Test for Custom Kernel Object");

3. 通用小内存分配:kmalloc与kfree

对于无需专用缓存的临时小内存块,内核提供kmalloc和kfree接口,它们基于slab分配器的“通用缓存”(如大小为64B、128B、256B的默认缓存)实现,无需手动创建缓存。

// 分配128字节的临时内存块(用于存储网络数据包头部)

void *pkg_header = kmalloc(128, GFP_KERNEL);

if (!pkg_header) {printk(KERN_ERR "kmalloc failed for package header\n");return -ENOMEM;

}// 使用内存块(模拟填充数据包头部)

memset(pkg_header, 0, 128);

((unsigned short *)pkg_header)[0] = 0x0800; // IPv4协议类型// 回收内存块(放回通用slab缓存)

kfree(pkg_header);

kmalloc会根据请求的内存大小,自动选择最匹配的通用缓存(如请求128B时,选择128B的通用缓存),避免内存浪费。而kfree会根据对象地址反向查找所属的slab缓存,将对象标记为空闲。

四、slab分配器的衍生版本:slub与slob

随着Linux内核的发展,slab分配器出现了两个衍生版本——slub和slob,分别针对不同场景优化:

1. slub分配器:简化设计与SMP优化

slub分配器是Linux 2.6.22版本后引入的默认分配器,它简化了slab的三层结构,去除了“缓存”层的部分冗余链表,直接通过“slab”和“对象”两层管理内存。其核心优化包括:

- 简化数据结构:每个slab直接关联到对应的对象类型,无需维护full/partial/empty三个全局链表,减少锁竞争;

- SMP友好:使用per-CPU缓存(CPU本地slab),减少多CPU间的锁竞争,提升并行分配效率;

- 动态调整slab大小:根据系统负载自动调整slab的页帧数量,避免内存浪费;

- 更好的调试支持:提供

/sys/kernel/slab/接口,可实时查看缓存使用情况(如对象数量、空闲率)。

2. slob分配器:嵌入式系统的轻量级选择

slob分配器(Simple List Of Blocks)是为嵌入式系统设计的轻量级分配器,适用于内存资源有限(如几十MB)的场景。它的核心特点是:

- 代码极简:仅几百行代码,内存开销极小,适合嵌入式内核;

- 基于链表管理:使用单链表管理空闲内存块,分配时采用“首次适配”算法,实现简单;

- 无对象缓存:不支持专用缓存和对象复用,仅提供基础的小内存块分配功能;

- 适用于低负载场景:由于未优化碎片和CPU缓存,仅适合内存需求低、分配频率低的嵌入式任务。

选型建议:对于大多数服务器和桌面系统,默认的slub分配器是最佳选择;对于嵌入式系统(如路由器、物联网设备),可选择slob分配器以减少内存开销;传统的slab分配器已逐渐被slub取代,仅在需要兼容旧内核模块时使用。

五、slab分配器的性能调优与监控

为确保slab分配器高效运行,内核提供了多种调优手段和监控接口,帮助开发者定位内存泄漏、碎片等问题。

1. 关键调优参数

/proc/sys/vm/slab_min_order:每个slab的最小页帧数量(以2的幂次表示),默认值为0(1页)。若对象较大(如4KB),可将其设置为1(2页),减少slab拆分次数;/proc/sys/vm/slab_max_order:每个slab的最大页帧数量,默认值为3(8页),防止单个slab占用过多内存;SLAB_HWCACHE_ALIGN:创建缓存时的标志,强制对象按CPU缓存行对齐(如64B),减少缓存 miss;SLAB_CONSISTENCY_CHECKS:调试标志,启用对象一致性检查(如越界访问检测),适合开发阶段使用。

2. 监控接口:/sys/kernel/slab/

slub分配器提供/sys/kernel/slab/虚拟文件系统,可实时查看每个缓存的详细信息。例如,查看inode_cache的使用情况:

查看inode_cache的基本信息

// 查看inode_cache的基本信息

$ cat /sys/kernel/slab/inode_cache/size # 单个对象大小(字节)

1024$ cat /sys/kernel/slab/inode_cache/objects # 已分配对象数量

128$ cat /sys/kernel/slab/inode_cache/free_objects # 空闲对象数量

32$ cat /sys/kernel/slab/inode_cache/slab_size # 每个slab的大小(字节)

8192 # 2个页帧(2×4096)

通过这些接口,可快速定位“缓存膨胀”(如free_objects持续为0,可能存在内存泄漏)、“对象大小不匹配”(如size远大于实际需求,导致内部碎片)等问题。

六、总结:slab分配器在Linux内核中的价值

slab分配器作为Linux内核内存管理的“中间层”,填补了伙伴系统在小内存块分配上的短板,其核心价值体现在:

- 效率提升:通过小内存块拆分和对象复用,减少内存碎片和CPU开销,使内核能高效处理频繁的小内存分配需求;

- 通用性与灵活性:支持专用缓存和通用缓存,适配不同内核对象的分配场景,同时提供slub、slob等衍生版本,满足不同系统需求;

- 可观测性:通过sysfs接口提供详细的缓存监控信息,便于问题定位和性能调优;

- 稳定性保障:减少内存泄漏和碎片风险,为内核长期稳定运行提供支撑(如服务器连续运行数月不重启)。

对于Linux内核开发者而言,理解slab分配器的原理和接口,不仅能写出更高效的内核代码(如合理使用kmem_cache减少对象初始化开销),还能快速定位内存相关的性能问题,是深入内核开发的必备知识。