【论文精读】ThermoStereoRT:全天候实时热成像立体匹配的创新方案

标题:ThermoStereoRT: Thermal Stereo Matching in Real Time via Knowledge Distillation and Attention-based Refinement

作者:Anning Hu, Ang Li, Xirui Jin, Danping Zou(上海交通大学导航与位置服务重点实验室)

论文链接:https://arxiv.org/pdf/2504.07418

代码地址:https://github.com/SJTU-ViSYS-team/ThermoStereoRT

在计算机视觉领域,立体匹配技术是实现深度感知的核心手段,广泛应用于机器人导航、自动驾驶、3D 重建等场景。然而,传统基于 RGB 图像的立体匹配方法在低光照、烟雾、雾天等恶劣环境下性能严重下降,难以满足全天候作业需求。热成像相机不受环境光照影响,能在极端条件下稳定工作,但热成像图像存在纹理缺失、噪声高、分辨率低等问题,且标注数据稀疏,给立体匹配带来巨大挑战。

上海交通大学邹丹平教授课题组提出的ThermoStereoRT方法,创新性地结合轻量级网络架构、注意力机制与知识蒸馏技术,实现了热成像立体匹配的实时性与高精度平衡。本文将从研究背景、方法设计、实验验证、核心创新与应用前景五个维度,对该论文进行全面精读,深入解析其技术细节与突破点。

一、研究背景与挑战

1.1 立体匹配技术的现状与局限

立体匹配的核心目标是从两台校正相机拍摄的图像对中计算视差图,进而反推深度信息。目前主流方法主要基于 RGB 图像,可分为两类:

- 传统学习型方法:如 PSMNet、AANet 等,通过 3D 卷积正则化代价体提升精度,但计算复杂度极高,难以在嵌入式设备上实时运行;

- 迭代优化方法:如 RAFT-Stereo、CRE-Stereo 等,通过循环更新视差估计改善性能,但低分辨率热成像图像会导致其收敛困难,精度骤降。

RGB 相机的本质缺陷在于依赖环境光照,在夜间、雾天、浓烟等场景下会因图像信息丢失而失效,而热成像相机通过探测物体热辐射成像,完全不受光照影响,成为全天候场景的理想选择。

1.2 热成像立体匹配的核心挑战

尽管热成像技术具备环境鲁棒性,但将其应用于立体匹配时面临三大关键问题:

- 图像质量差:热成像图像分辨率低(通常为 256×640 或 480×640)、纹理稀疏、噪声高,导致特征匹配歧义性大;

- 标注数据稀缺:现有热成像立体数据集(如 MS2、CATS)规模小且地面真值(GT)稀疏(多由 LiDAR 采集,存在大量空白区域),难以支撑深度模型训练;

- 实时性需求:实际应用(如无人机夜间监控、床底清洁机器人)对推理速度要求高,传统复杂模型无法满足嵌入式设备部署需求。

为解决上述挑战,ThermoStereoRT 从网络轻量化、特征增强、数据增强三个维度提出创新方案,实现了 “高精度 + 实时性” 的双重突破。

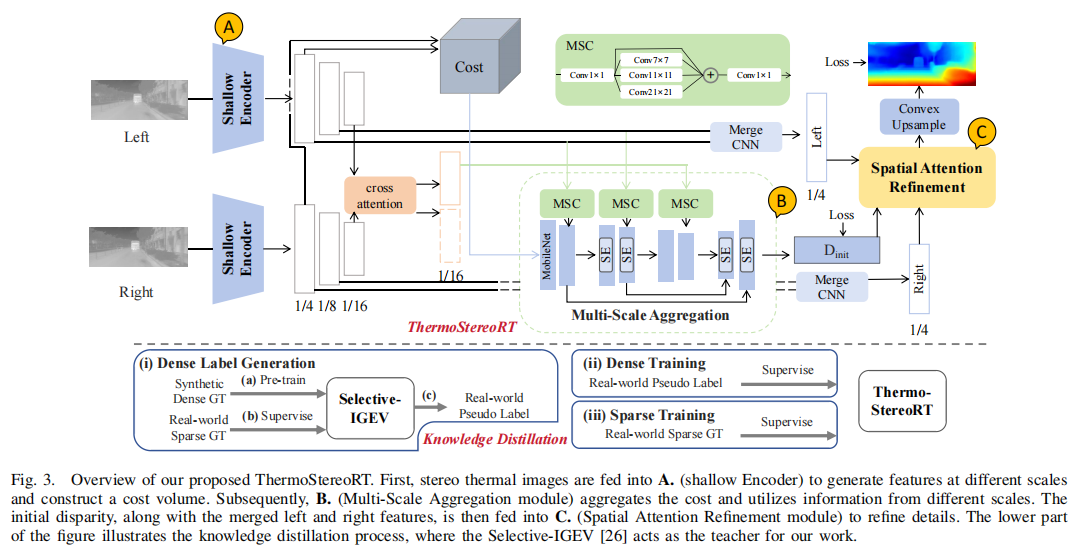

二、方法设计:ThermoStereoRT 的完整架构

ThermoStereoRT 的核心框架分为四大部分:轻量级编码器(Shallow Encoder)、多尺度聚合模块(Multi-Scale Aggregation)、空间注意力细化模块(Spatial Attention Refinement),以及知识蒸馏模块(Knowledge Distillation)。整体流程如下,输入为一对校正后的热成像图像,输出为最终视差图。

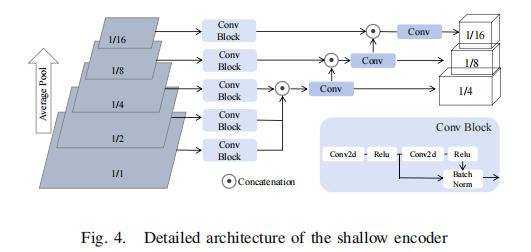

2.1 浅层编码器:高效特征提取

传统立体匹配模型(如 PSMNet)采用深层 CNN 提取特征,导致计算量过大。ThermoStereoRT 受 NeuFlow 启发,设计了浅层 CNN 编码器,在保证特征表达能力的同时大幅降低计算成本。

核心设计细节

- 图像金字塔构建:对输入热成像图像

(M∈{Left,Right})通过平均池化生成 5 个尺度的金字塔

(s=1,2,4,8,16),对应分辨率为原图的 1/1~1/16;

- 多尺度特征融合:为保留高分辨率细节,使用

、

、

通过 “双卷积块” 提取 1/4 分辨率特征

(通道数

);再将高分辨率特征下采样后与低分辨率特征拼接,得到 1/8、1/16 分辨率特征

、

,结构如图 4 所示;

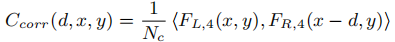

- 3D 相关性代价体构建:基于 1/4 分辨率的左右特征

与

,通过内积计算每个视差级别的相关性代价,公式如下:

其中

其中为视差值,

,

为最大视差。该设计避免了深层网络的冗余计算,同时通过多尺度特征覆盖细结构与大视差场景。

2.2 多尺度聚合模块:代价体优化

代价体的质量直接决定视差估计精度。ThermoStereoRT 基于 MobileNetV3 残差块构建聚合网络,通过多尺度卷积(MSC) 与注意力机制增强代价体的判别性。

核心设计细节

- 残差连接与 SE 模块:在 1/4、1/8 分辨率处引入残差连接,缓解梯度消失问题;嵌入 Squeeze-and-Excitation(SE)模块,动态调整通道权重,突出有效特征;

- 跨注意力特征增强:以左图 1/16 特征

为查询(Query),右图 1/16 特征

为键(Key)和值(Value),通过全局跨注意力生成

,增强特征区分度;

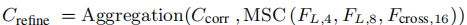

- 多尺度卷积(MSC):对

、

、

应用 1×1、7×7、11×11、21×21 四种卷积核,捕捉局部与全局信息,生成注意力权重并与聚合网络中间输出相乘,得到优化后的代价体

,公式如下:

- 连续视差回归:通过软 argmin 函数从

中计算初始视差图

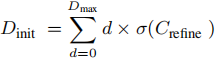

,避免离散视差的量化误差:

,其中σ(⋅)为 softmax 函数,用于计算每个视差值的概率。

,其中σ(⋅)为 softmax 函数,用于计算每个视差值的概率。

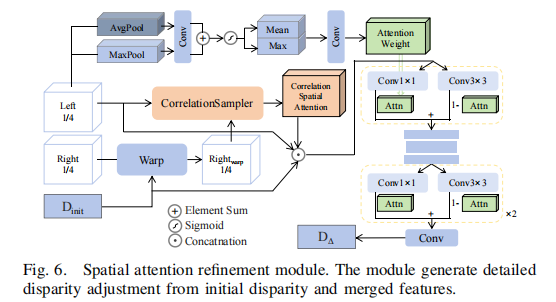

2.3 空间注意力细化模块:视差精度提升

初始视差图Dinit可能存在边缘模糊、小目标丢失等问题。ThermoStereoRT 设计了轻量级空间注意力细化模块,通过单步操作(而非迭代)实现视差调整,兼顾精度与速度,结构如图 6 所示。

核心设计细节

- 特征融合:将左图 1/4 与 1/8 分辨率特征通过 MergeCNN 融合,得到

;根据

将右图融合特征

扭曲(Warp)到左图视角;

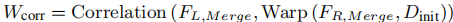

- 相关性注意力计算:计算扭曲后的右图特征与左图特征的相关性,生成

,反映特征错位程度,用于指导视差调整:

- 多感受野解码:将

、

、

拼接为

,使用 1×1(捕捉局部细节)与 3×3(捕捉全局结构)卷积核解码视差调整量

;引入注意力权重

(基于全局信息与通道注意力训练),自适应融合两种卷积输出,避免直接拼接的信息冗余;

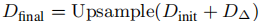

- 最终视差生成:将

与

相加,通过 RAFT 的凸上采样(Convex Upsample)恢复到原图分辨率,得到

:

。

。

2.4 知识蒸馏:解决数据稀疏问题

热成像数据集的稀疏 GT 无法充分训练模型,ThermoStereoRT 引入三阶段知识蒸馏,利用教师模型生成密集伪标签,提升学生模型(ThermoStereoRT)的泛化能力,且不增加推理时计算量。

蒸馏流程(如图 3 下部所示)

- 密集标签生成(Dense Label Generation):

- 预训练一个计算密集型教师模型(Selective-IGEV,在相同实验设置下 EPE 最低),先使用合成数据(如 SceneFlow,转换为灰度图模拟热成像)训练,再用稀疏 GT 微调;

- 利用微调后的教师模型对热成像图像生成高质量密集伪标签。

- 密集训练(Dense Training):以密集伪标签为监督,训练学生模型(ThermoStereoRT),学习细粒度视差信息。

- 稀疏训练(Sparse Training):用原始稀疏 GT 对学生模型进行微调,避免伪标签引入的误差,优化最终性能。

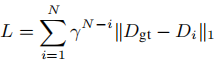

损失函数设计

采用序列 L1 损失,对不同阶段的视差预测(、

)赋予指数递增权重,强调最终预测的准确性:

其中γ=0.9(权重衰减系数),N=2(预测阶段数),

其中γ=0.9(权重衰减系数),N=2(预测阶段数),为地面真值。

三、实验验证:全面评估性能

为验证 ThermoStereoRT 的有效性,团队在两个主流热成像立体数据集(MS2、CATS)上进行了基准测试、消融实验与实时性评估,对比了 10 余种主流方法(如 PSMNet、RAFT-Stereo、LightStereo)。

3.1 实验设置

数据集详情

| 数据集 | 场景覆盖 | 图像数量(热成像) | 分辨率 | 测试场景 |

|---|---|---|---|---|

| MS2 | 驾驶场景 | 训练 76,544 / 验证 400 / 测试 71,253 | 256×640 | 白天 / 夜间 / 雨天 |

| CATS | 室内 + 室外 | 训练 134 / 验证 34 | 480×640 | 杂乱环境 |

| SceneFlow (合成) | 虚拟场景 | 训练 34,801 | 540×960 | 模拟热成像 (灰度值 0-40) |

硬件与训练参数

- 训练环境:单张 NVIDIA A6000 GPU,PyTorch 框架;

- 批量大小:4(保持原始分辨率训练);

- 优化器:AdamW,学习率调度:One-Cycle(最大学习率 0.001);

- 训练步数:MS2 数据集 200k 步,CATS 数据集 30k 步;蒸馏阶段:教师模型 100k(合成)+150k(MS2),学生模型 100k(伪标签)+150k(MS2)。

3.2 基准测试结果

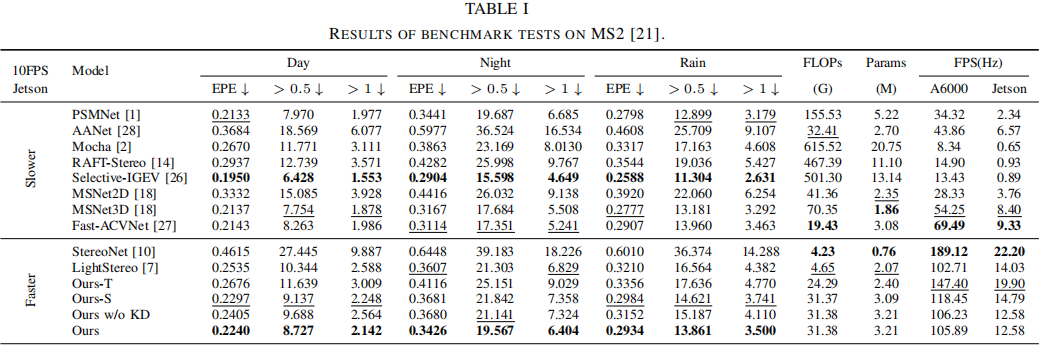

1. MS2 数据集性能

MS2 数据集是目前最大的热成像立体数据集,覆盖白天、夜间、雨天三种复杂场景,评估指标包括端点误差(EPE,越低越好) 和异常值比例(误差 > 0.5/1 像素,越低越好),以及计算量(FLOPs)、参数量(Params)、帧率(FPS)。

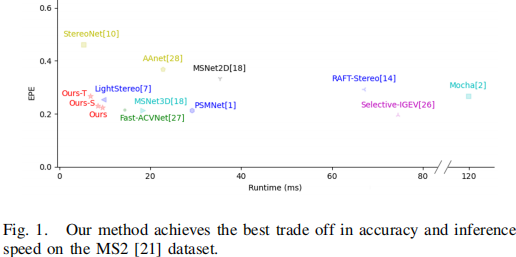

核心结论:

- 精度领先:ThermoStereoRT(Ours)在所有场景下 EPE 均低于实时方法(如 LightStereo、StereoNet),白天 EPE 0.2240,夜间 0.3426,雨天 0.2934,比 LightStereo 提升 11.6%,比 StereoNet 提升 51.5%;

- 实时性优秀:在 NVIDIA Jetson Xavier NX(嵌入式设备)上帧率达 12.58 FPS,Ours-S(移除 SE 模块)达 14.79 FPS,满足实时需求;而高精度非实时方法(如 Selective-IGEV)帧率仅 0.89 FPS,无法部署;

- 轻量化:参数量 3.21 M,FLOPs 31.38 G,远低于 PSMNet(5.22 M/155.53 G)、RAFT-Stereo(11.10 M/467.39 G)。

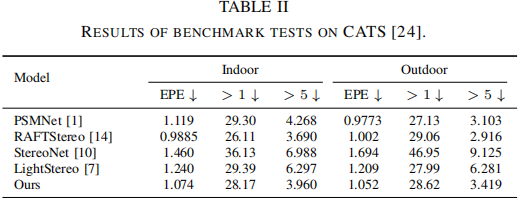

2. CATS 数据集性能

CATS 数据集场景更杂乱,测试室内外视差估计能力。结果显示:

- ThermoStereoRT 在室内场景 EPE 1.074,室外 1.052,是实时方法中最低;

- 异常值比例(>5 像素)室内 3.960%、室外 3.419%,优于 RAFT-Stereo(室内 3.690%/ 室外 2.916%,但 RAFT-Stereo 非实时)。

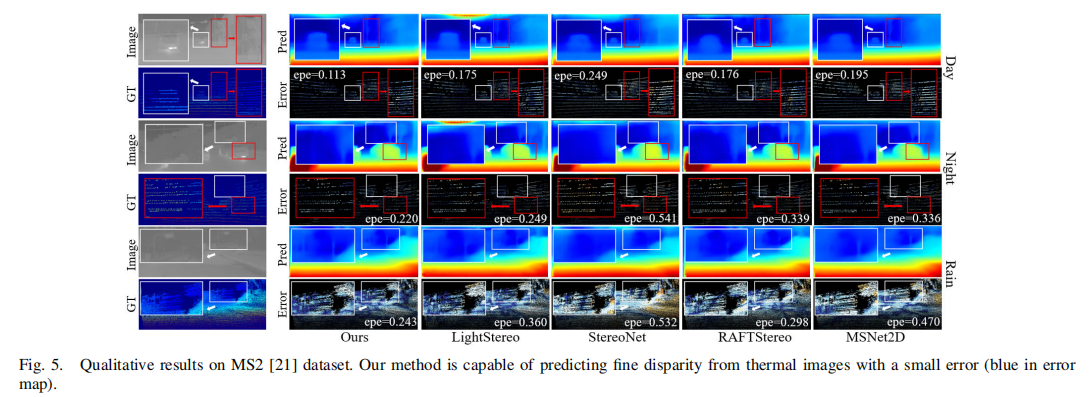

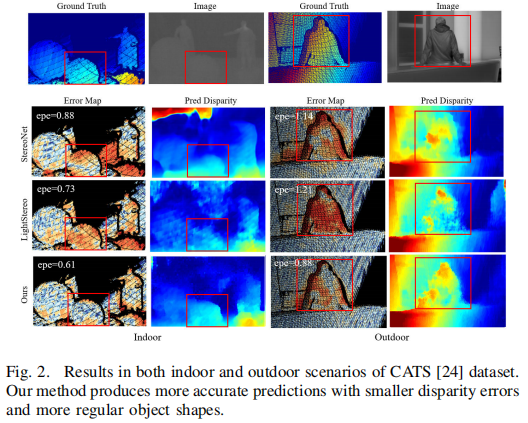

3. 定性结果可视化分析

- 图 5(MS2 数据集):ThermoStereoRT 预测的视差图误差(蓝色区域)更小,能清晰恢复远处车辆、树木、电线杆的细节,而 RAFT-Stereo、MSNet2D 存在明显误匹配;

- 图 2(CATS 数据集):室内场景中,ThermoStereoRT 能从模糊热成像图像中恢复球体轮廓;室外场景中,准确还原人体形状,而其他方法出现轮廓断裂或错位。

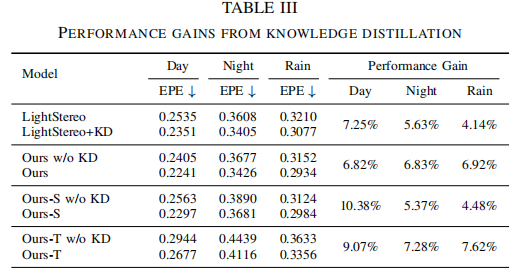

3.3 知识蒸馏效果

为验证蒸馏的有效性,对比了模型在 “有无蒸馏” 下的性能提升:

- ThermoStereoRT(Ours)在蒸馏后,白天 EPE 降低 6.82%,夜间降低 6.83%,雨天降低 6.92%;

- 其他方法(如 LightStereo)蒸馏后也有性能提升,但 ThermoStereoRT 提升更显著,证明蒸馏能有效利用密集伪标签弥补稀疏 GT 的不足。

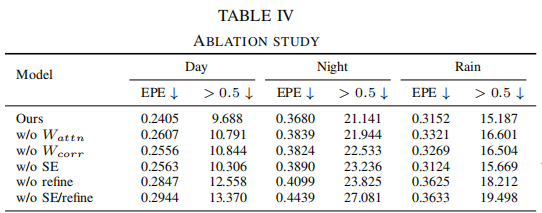

3.4 消融实验

消融实验针对 ThermoStereoRT 的核心模块(注意力权重Wattn、相关性注意力Wcorr、SE 模块、细化模块)进行逐一移除,验证各模块的必要性:

- 移除细化模块(w/o refine):EPE 上升最显著(白天从 0.2405→0.2847),证明空间注意力细化对细节恢复至关重要;

- 移除Wattn或Wcorr:EPE 均上升(如 w/o Wattn白天 EPE→0.2607),说明多感受野融合与左右特征相关性对精度的贡献;

- 移除 SE 模块(w/o SE):夜间 EPE 从 0.3680→0.3890,证明通道注意力能增强特征判别性。

3.5 实时性评估

在嵌入式设备(NVIDIA Jetson Xavier NX,21 TOPS)上的帧率测试显示:

- ThermoStereoRT(Ours)帧率 12.58 FPS,Ours-S 达 14.79 FPS,Ours-T(移除 SE + 细化)达 19.90 FPS,均满足实时需求;

- 传统高精度方法(如 PSMNet、Selective-IGEV)帧率低于 3 FPS,无法在嵌入式设备上运行。

四、核心创新与局限性

4.1 三大核心创新

- 轻量级架构设计:通过浅层编码器、MobileNetV3 残差块、单步细化模块,在保证精度的同时将参数量控制在 3.21 M,FLOPs 31.38 G,实现嵌入式设备部署;

- 注意力机制融合:多尺度卷积注意力(MSC)增强代价体、空间注意力细化(Wattn、Wcorr)提升视差细节、SE 模块优化通道权重,全方位解决热成像图像纹理缺失问题;

- 知识蒸馏方案:三阶段蒸馏(密集标签生成→密集训练→稀疏微调)有效利用合成数据与伪标签,突破热成像数据集稀疏 GT 的限制,且不增加推理成本。

4.2 局限性与未来方向

- 视差范围限制:当前方法基于固定最大视差Dmax,对超远距离场景(如无人机高空监控)的大视差估计可能存在误差;

- 动态场景适配:未针对动态目标(如快速移动的行人、车辆)进行优化,运动模糊可能导致视差估计偏差;

- 多模态融合潜力:未结合 RGB 图像(若光照条件允许)进一步提升精度,未来可探索热成像 - RGB 跨模态立体匹配。

五、应用前景与总结

5.1 典型应用场景

ThermoStereoRT 的 “全天候 + 实时性 + 轻量化” 特性使其在多个领域具备落地潜力:

- 夜间无人机监控:不受光线影响,实时生成深度图,辅助目标检测与跟踪;

- 室内服务机器人:如床底清洁机器人,通过热成像感知障碍物深度,避免碰撞;

- 自动驾驶:雾天、雨天等恶劣天气下,补充 RGB 相机的深度感知能力,提升行驶安全;

- 安防巡检:黑暗环境中对人员、设备的深度定位,支持智能预警。

5.2 总结

ThermoStereoRT 针对热成像立体匹配的三大核心挑战(图像质量差、数据稀疏、实时性需求)提出了系统性解决方案:通过轻量级架构实现高效推理,通过多注意力机制增强特征表达,通过知识蒸馏突破数据限制。实验证明,该方法在 MS2、CATS 数据集上均实现 “精度领先 + 实时性优秀”,为全天候立体匹配提供了新的技术范式,也为热成像视觉的工业化应用奠定了基础。

论文代码已开源(https://github.com/SJTU-ViSYS-team/ThermoStereoRT),感兴趣的读者可进一步探索其实现细节与扩展应用。