高德西交语义与空间解耦具身导航!JanusVLN:基于双隐式记忆的视觉语言导航框架

- 作者:Shuang Zeng1,2^{1,2}1,2, Dekang Qi1^{1}1, Xinyuan Chang1^{1}1, Feng Xiong1^{1}1, Shichao Xie1^{1}1, Xiaolong Wu1^{1}1, Shiyi Liang1,2^{1,2}1,2, Mu Xu1^{1}1, Xing Wei2^{2}2

- 单位:1^{1}1阿里巴巴高德地图,2^{2}2西安交通大学

- 论文标题:JanusVLN: Decoupling Semantics and Spatiality with Dual Implicit Memory for Vision-Language Navigation

- 论文链接:https://arxiv.org/pdf/2509.22548

- 项目主页:https://miv-xjtu.github.io/JanusVLN.github.io/

- 代码链接:https://github.com/MIV-XJTU/JanusVLN

主要贡献

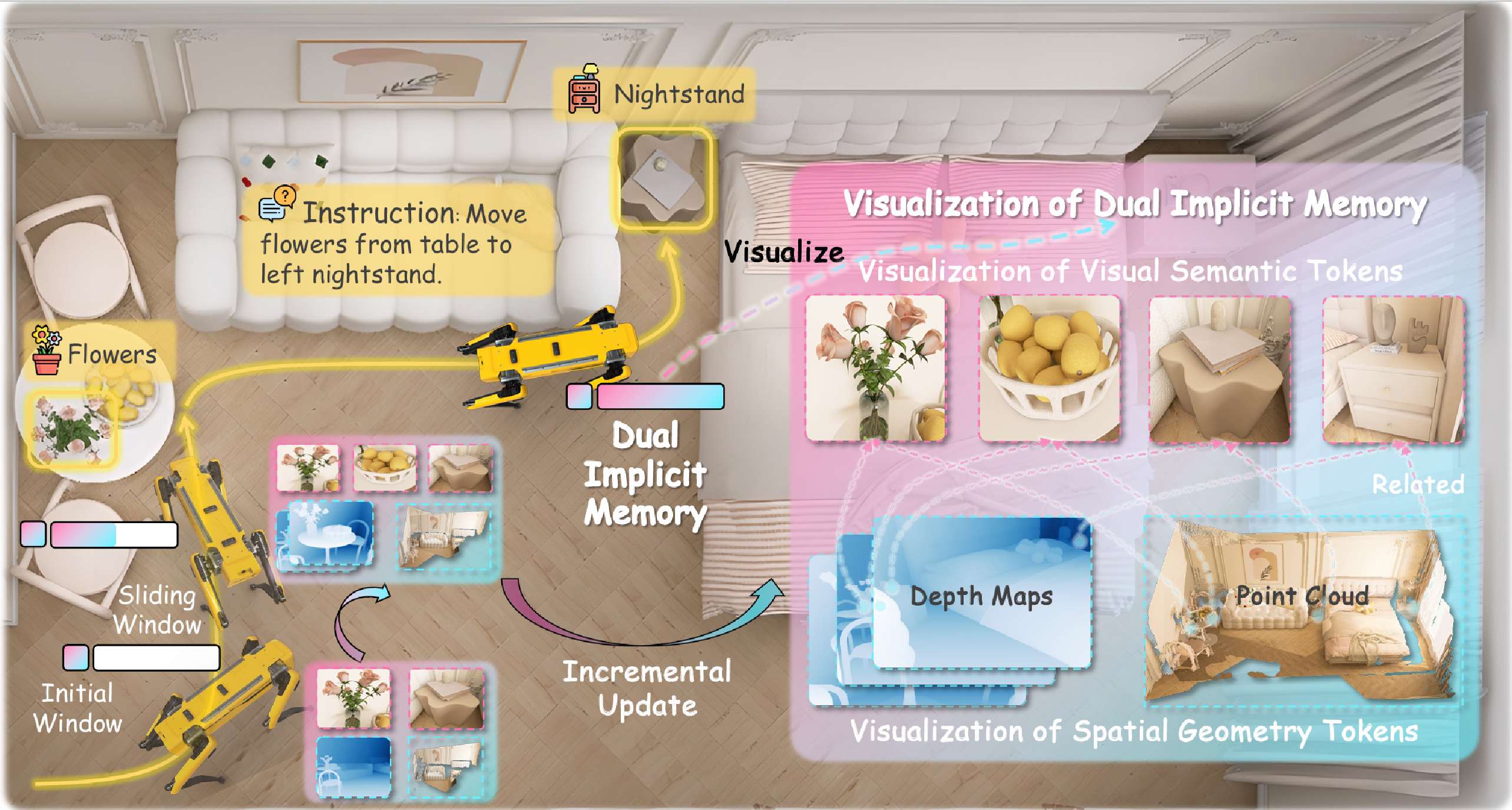

- 提出了双隐式记忆范式,受人类认知科学的启发,该范式同时捕捉视觉语义和空间几何信息,克服了现有导航LLM的固有局限性。

- 设计了JanusVLN框架,通过增量更新初始和滑动窗口的缓存键值对(KV),避免了对每个新帧重新计算历史帧,显著降低了计算和推理开销。

- 在VLN-CE基准测试中取得了SOTA结果,无需辅助3D数据,验证了JanusVLN的有效性,并为该领域建立了一个新的记忆范式。

研究背景

- 视觉语言导航(VLN)任务:要求智能体在未见过的环境中,根据自然语言指令和连续的视频流进行导航。最近的研究利用多模态大语言模型(MLLM)的强大语义理解能力推动了VLN的发展。

- 现有方法的局限性:这些方法通常依赖于显式语义记忆,如构建文本认知地图或存储历史视觉帧,存在空间信息丢失、计算冗余和记忆膨胀等问题,阻碍了高效导航。此外,现有的视觉编码器几乎都继承了基于2D图像文本对预训练的CLIP范式,缺乏对3D几何结构和空间信息的理解,限制了其在复杂导航中的空间推理能力。

方法

基础介绍

导航任务定义

- 在连续环境中的VLN任务定义为:在时间步长ttt时,具身智能体根据自然语言指令III和以自身为中心的RGB视频流OT={x0,…,xt}\mathcal{O}_{T}=\{x_{0},\ldots,x_{t}\}OT={x0,…,xt}来预测下一步的低级动作at+1a_{t+1}at+1。

- 动作空间包括“向前移动”“向左转”“向右转”和“停止”,每个动作对应细微的物理变化,允许在连续空间中灵活操作。执行动作后,智能体获得新的观测xt+1x_{t+1}xt+1,直到在目标位置执行“停止”动作。

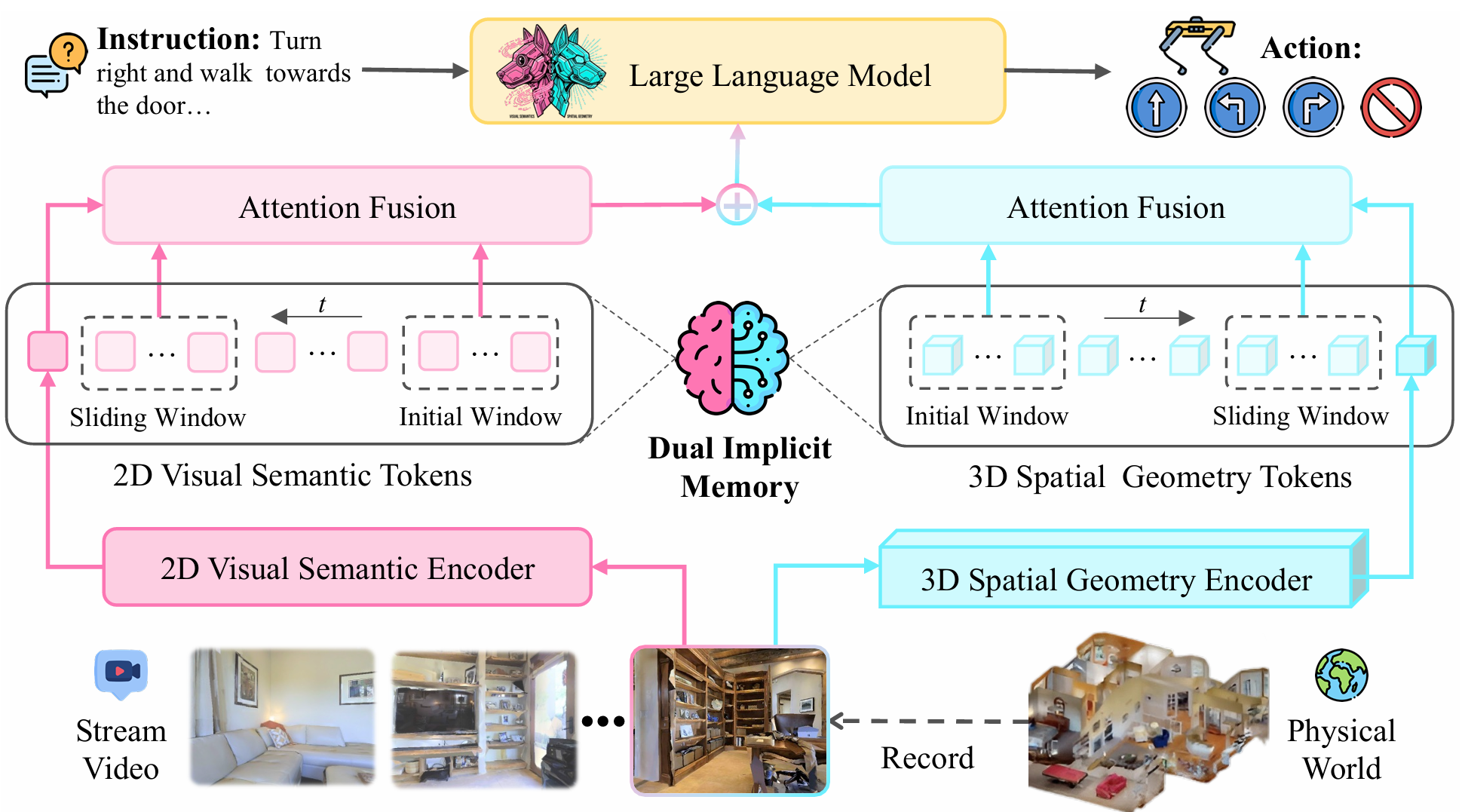

VGGT

- VGGT(Visual Geometry Grounded Transformer)是基于Transformer前馈架构的模型,包含三个关键部分:用于提取单图像特征的编码器、用于跨帧交互生成几何tokenGtG_{t}Gt的融合解码器以及用于3D属性的任务特定预测头。

- 其重建流程为先通过编码器和解码器得到几何token序列,再通过MLP预测点图和像素置信度图。该研究关注特征提取,利用编码器和融合解码器作为3D视觉几何编码器,以嵌入3D几何先验信息。

双隐式记忆

隐式神经表示

- 与以往存储高维、未经处理的显式历史帧的方法不同,该研究创新性地缓存经过神经网络深度处理的历史KV对。

- 这些KV对是从Transformer等注意力模块的输出中得到的,构成了过去环境的高级语义抽象和结构化表示。

- 这种隐式记忆不仅是一种紧凑、高效的存储实体,而且是一种经过神经网络提炼的浓缩知识表示,能够以最小的计算成本检索和推理信息。

混合增量更新

- 采用混合缓存更新策略来避免因扩展导航序列而产生的显著内存开销和性能下降。

- 该策略将记忆分为两部分:

- 一是滑动窗口队列MslidingM_{sliding}Msliding,容量为nnn,以先进先出的方式存储最近nnn帧的KV缓存,使模型关注即时相关上下文信息,对实时决策至关重要;

- 二是永久保留初始几帧的KV缓存MinitialM_{initial}Minitial,模型对这些初始帧表现出持续的高注意力权重,它们作为“注意力汇”,为整个导航提供关键的全局锚点,有效恢复性能。

- 通过整合这两种机制,构建了一个动态更新的固定大小的隐式记忆,既能敏锐感知最近环境,又能保持长期记忆信息。对于每个新输入帧,计算其图像token与隐式记忆之间的交叉注意力,直接检索历史信息,从而避免了对过去帧进行冗余的特征提取。

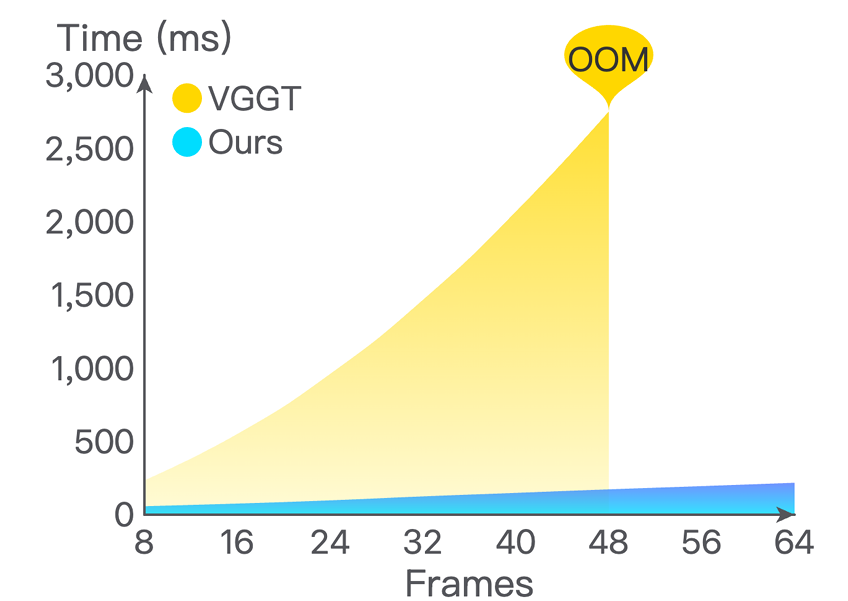

推理时间对比

- VGGT的推理时间会随着新帧的增加呈指数增长,因为其需要重新处理整个序列,导致在48G GPU上仅处理48帧时就会出现内存不足错误。

- 而该研究的方法通过避免重新处理历史帧,使其推理时间仅略有增加,展现出极高的效率。

JanusVLN架构

解耦视觉感知:语义和空间性

- 为了使具身智能体具备语义理解(“它是什么”)和空间感知(“它在哪里以及它与周围环境的关系”)的双重能力,提出了JanusVLN双编码器架构,将语义和空间信息从视觉输入中分离。

- 对于2D语义编码器,采用Qwen2.5-VL的原始视觉编码器,将输入帧xtx_{t}xt与语义记忆交互编码为语义tokenStS_{t}St。此外,Qwen2.5-VL将空间相邻的2×22\times22×2块合并为一个图像token,以降低计算成本。

- 对于3D空间几何编码器,使用VGGT模型的预训练编码器和融合解码器,将输入帧与空间记忆交互编码为空间几何tokenGtG_{t}Gt。

空间感知特征融合

- 在获得语义特征StS_{t}St和空间几何特征GtG_{t}Gt后,首先采用Qwen2.5-VL中的空间合并策略,将GtG_{t}Gt中空间相邻的2×22\times22×2特征块连接起来,形成与StS_{t}St形状对齐的Gt′G_{t}^{'}Gt′。

- 然后,利用轻量级两层MLP投影层融合语义和空间几何信息,得到最终的空间几何增强视觉特征FtF_{t}Ft,并将其与指令III的文本嵌入一起输入到MLLM的主干中,以生成下一步动作。

实验

实验设置

仿真环境与评估指标

- 数据集:在VLN-CE(Vision-Language Navigation Continuous Environments)的两个基准数据集R2R-CE和RxR-CE上进行实验。这些数据集包含从Matterport3D场景中使用Habitat模拟器收集的轨迹。

- 评估指标:使用标准的VLN指标进行评估,包括导航误差(NE)、Oracle成功率(OS)、成功率(SR)、成功加权路径长度(SPL)和归一化动态时间规整(nDTW)。其中,SR和SPL是主要指标,分别反映任务完成情况和路径效率。

现实世界评估设置

- 机器人平台:使用Unitree Go2机器人平台,配备Insta360 X5相机捕获前方RGB图像。

- 运行方式:JanusVLN在远程服务器上运行,服务器配备A10 GPU,用于连续处理RGB图像和指令,并将推理结果返回给机器人以执行动作。

- 任务类型:重点关注需要空间理解的导航任务。

实现细节

- 模型构建:基于Qwen2.5-VL 7B和VGGT构建JanusVLN。

- 训练过程:训练一个周期,仅微调LLM和投影层,学习率分别为2e-5和1e-5,同时保持语义和空间编码器冻结。

- 窗口大小:初始窗口大小设为8帧,滑动窗口大小设为48帧。

- 权重设置:空间几何特征的权重λ设为0.2。

- 额外数据:遵循StreamVLN,额外加入155K轨迹(约9207K图像-动作对)来自ScaleVLN的一个子集,并使用DAgger算法从标准R2R-CE和RxR-CE数据集中收集14K轨迹(约1485K图像-动作对)。

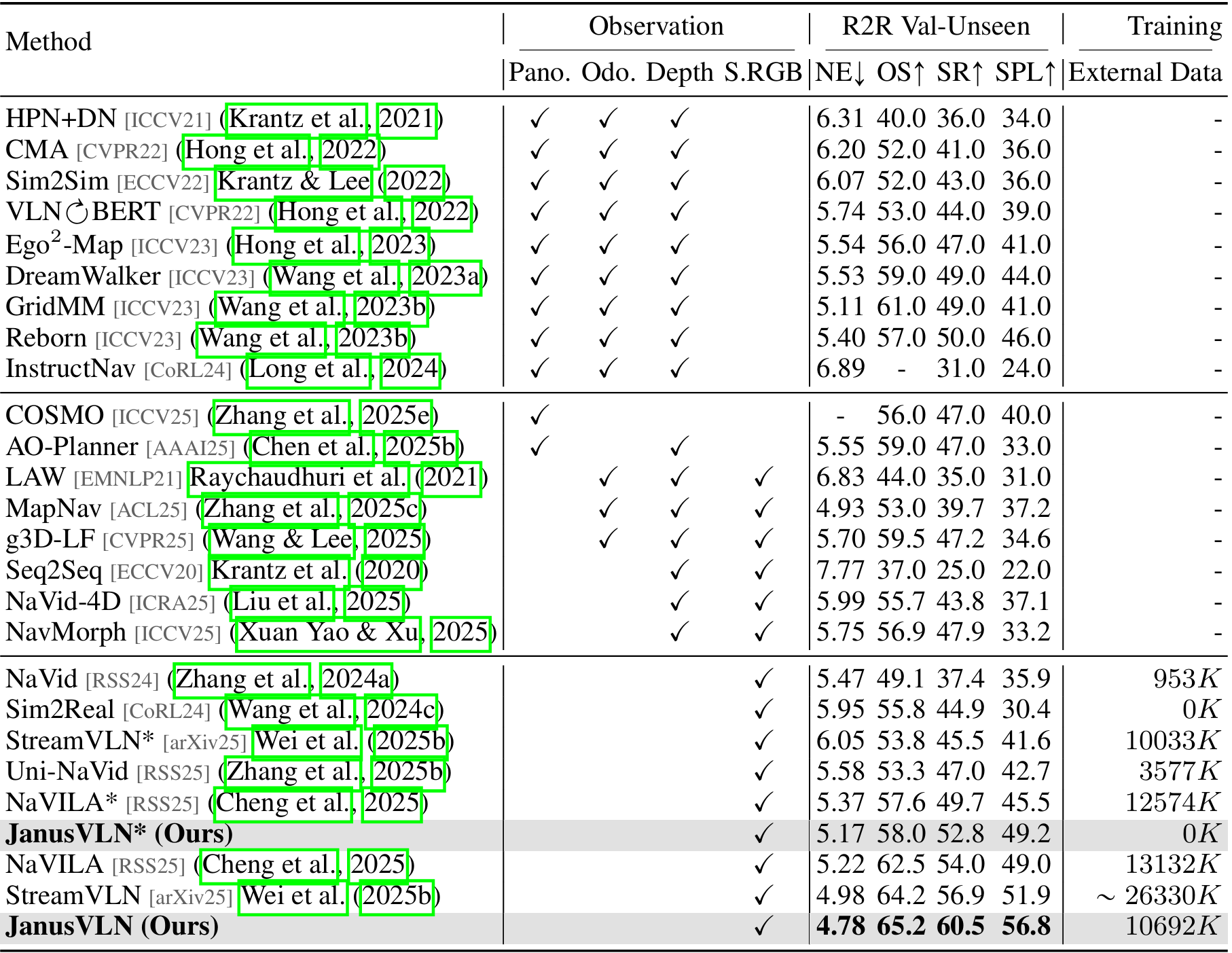

主要结果

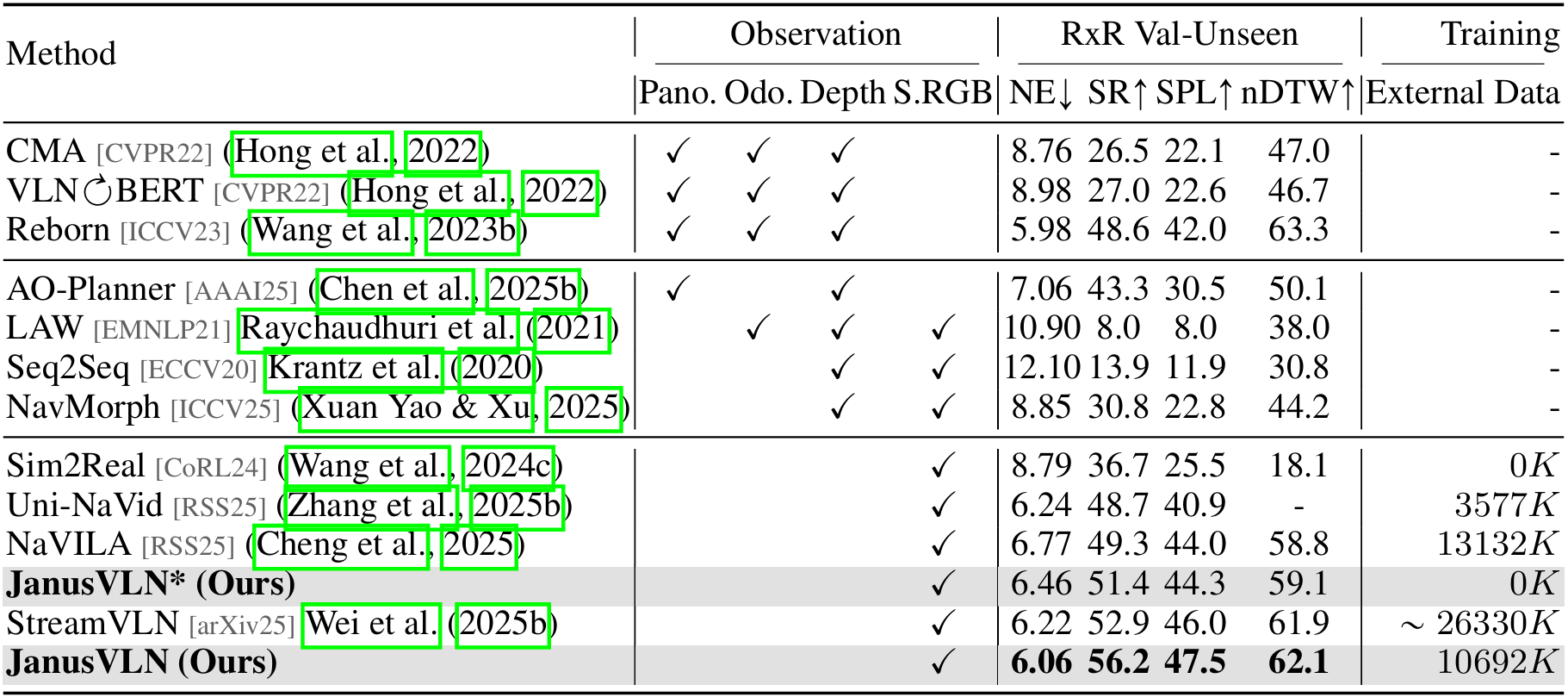

VLN-CE基准测试结果

- 性能对比:JanusVLN在R2R-CE和RxR-CE数据集上均取得了优异的性能。与使用多种输入类型(如全景图、里程计和深度图)的方法相比,仅使用单RGB输入的JanusVLN在成功率(SR)上实现了10.5-35.5的提升;与使用额外3D深度数据的方法相比,也取得了12.6-16.7的性能提升。此外,JanusVLN还优于使用显式文本认知地图或历史帧的方法,且使用的辅助数据更少。

- 具体数据:例如,在R2R-CE数据集上,JanusVLN的导航误差(NE)为5.17,Oracle成功率(OS)为58.0%,成功率(SR)为52.8%,成功加权路径长度(SPL)为49.2%。在RxR-CE数据集上,JanusVLN的SR为56.2%,SPL为47.5%,nDTW为62.1%。

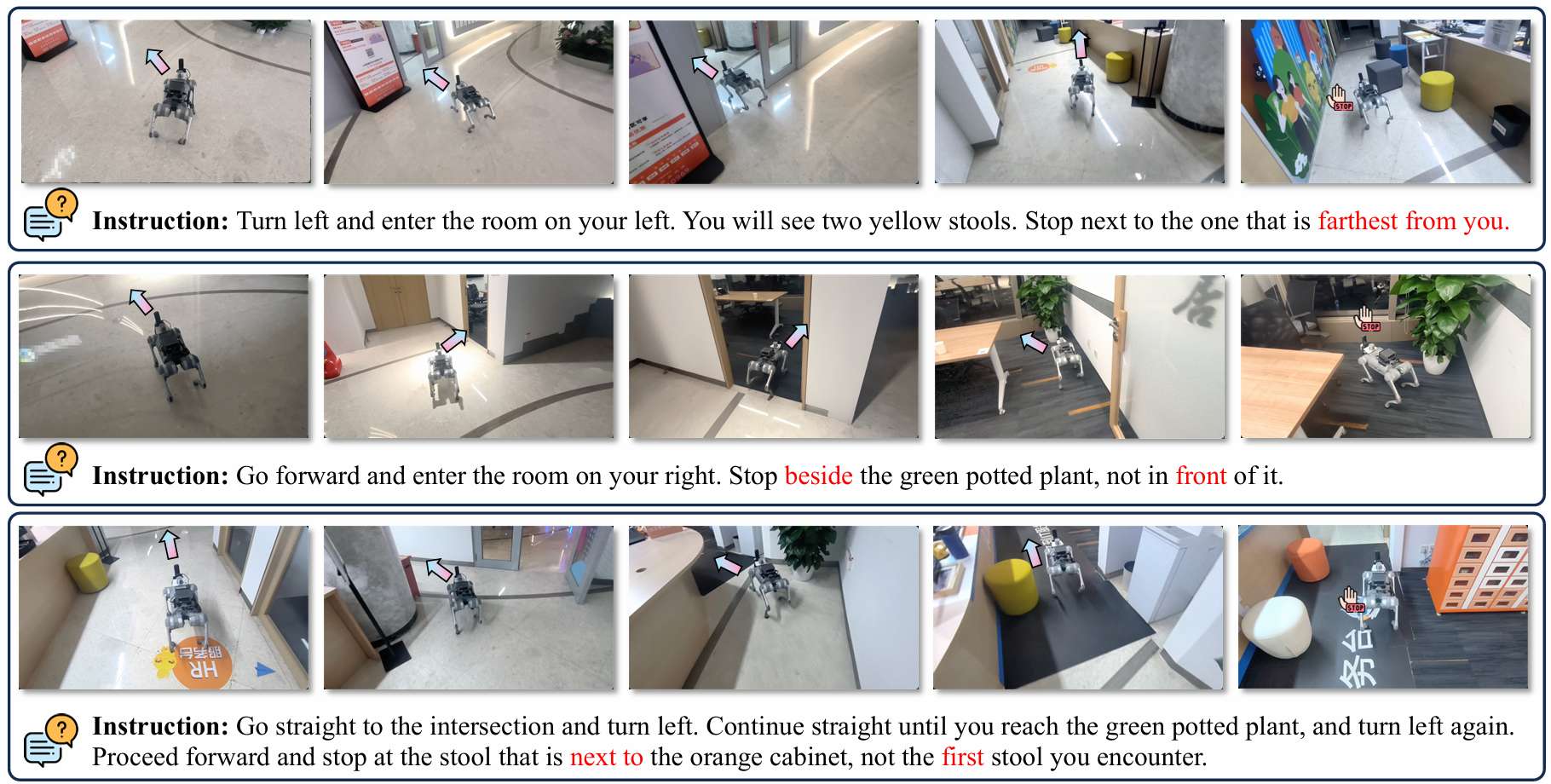

现实世界定性结果

- 任务选择:选择了一些需要空间理解的导航任务,包括深度感知(最远的黄色凳子)、3D方向和相对定位(在绿色盆栽旁边而不是前面)、空间关联(橙色柜子旁边的凳子)。

- 性能表现:通过利用双隐式记忆中的空间几何记忆,JanusVLN有效地增强了空间推理能力,成功完成了这些具有挑战性的任务。

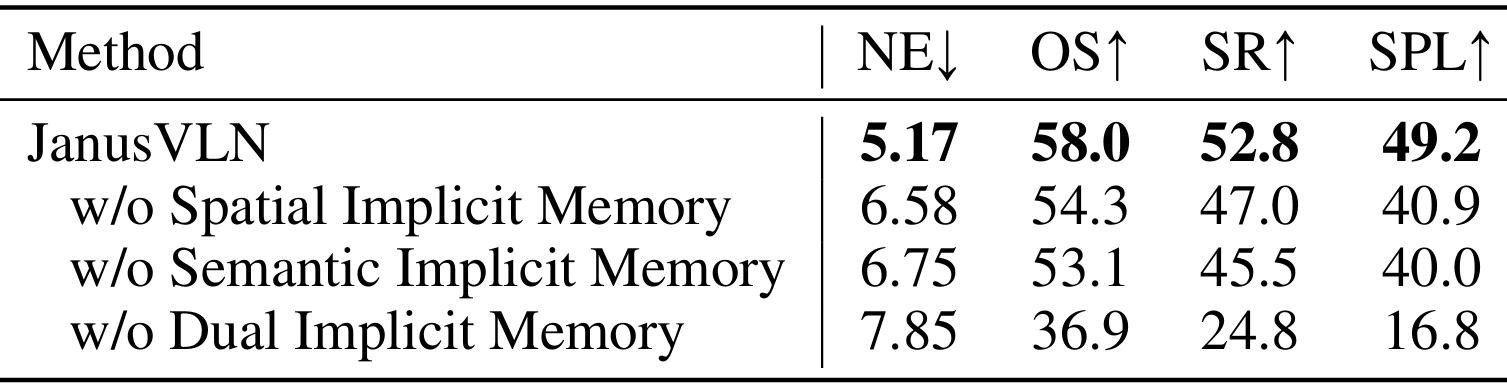

消融研究

双隐式记忆的消融

- 移除空间记忆:移除空间记忆后,SPL分数从49.2大幅下降至40.9,表明空间几何记忆有效增强了智能体的空间理解能力。

- 移除语义记忆:移除语义记忆后,SR降低了13.8%,强调了语义记忆的必要性。

- 同时移除两者:同时移除空间和语义记忆后,模型性能近乎崩溃,进一步证明了双隐式记忆的互补性和不可或缺性。

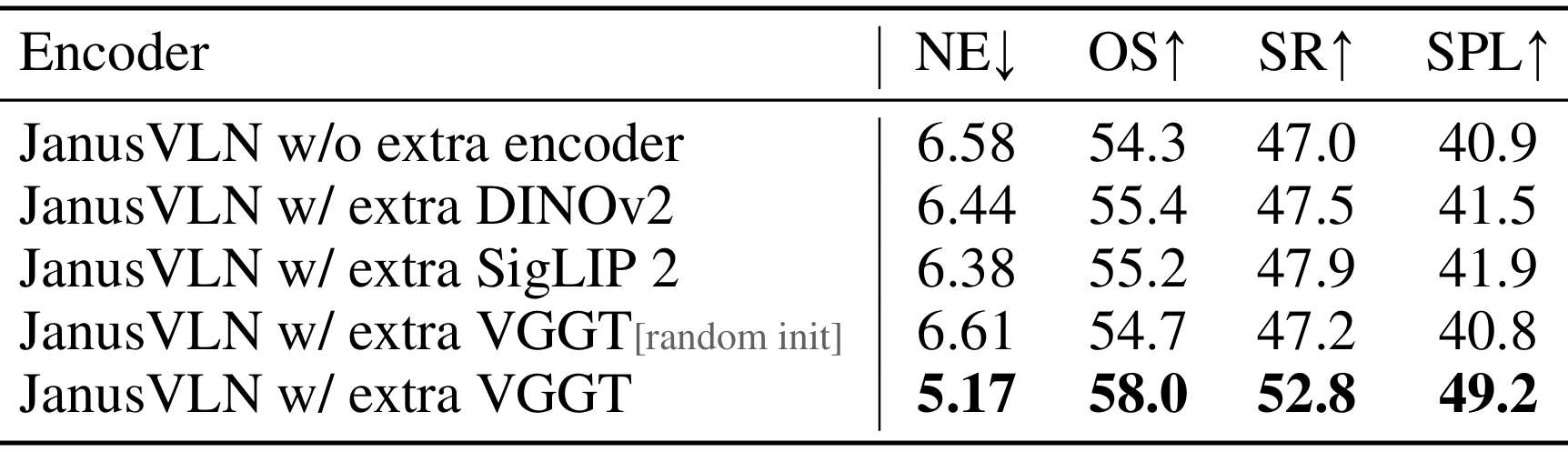

3D几何先验的消融

- 替换空间几何编码器:将VGGT替换为其他视觉编码器(如DINOv2和SigLIP 2)时,性能没有显著提升。这些编码器主要基于2D图像文本对预训练,与Qwen2.5-VL的原始视觉编码器提供的信息冗余,因此无法带来显著改进。

- 随机初始化VGGT:随机初始化的VGGT没有显著增益,说明JanusVLN的优势在于其增强的空间理解能力,而非仅仅增加模型容量。

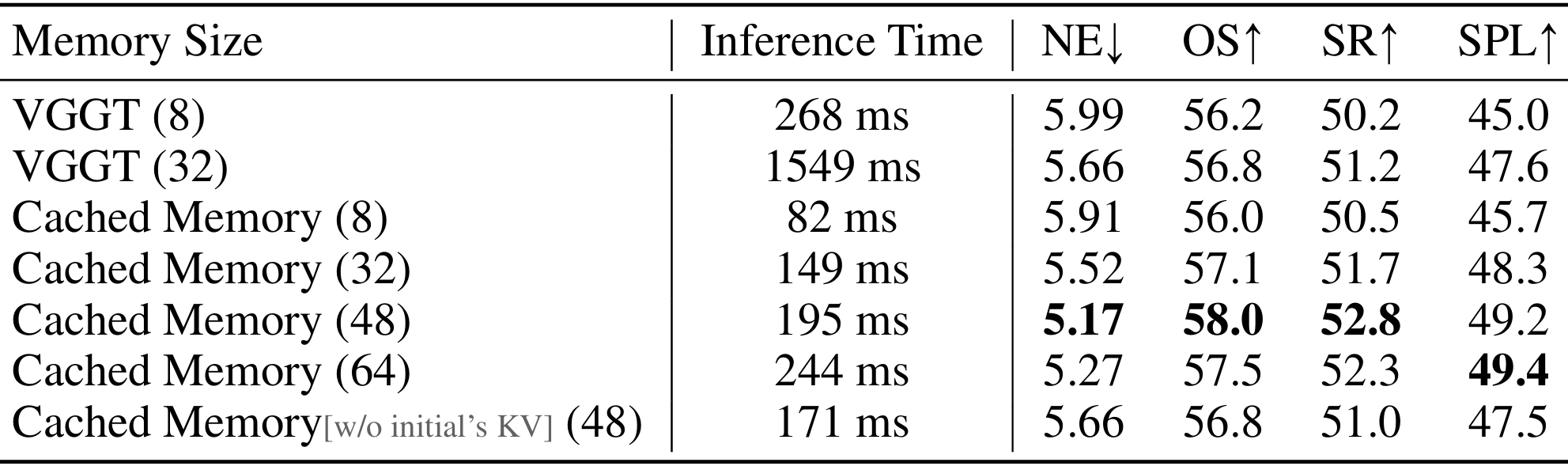

记忆大小的消融

- VGGT模型:VGGT模型需要重新计算整个序列以提取每个新帧的特征,导致推理开销随记忆大小增加呈指数增长。例如,当记忆大小为8时,推理时间为268ms;当记忆大小为32时,推理时间增长至1549ms。

- JanusVLN模型:通过动态缓存历史KV对,JanusVLN避免了重新计算,显著降低了推理开销。例如,当记忆大小为8时,推理时间为82ms;当记忆大小为48时,推理时间为195ms。同时,随着记忆大小的增加,JanusVLN的性能逐渐提高,在48帧时达到饱和。

- 移除初始窗口的KV缓存:移除初始窗口的KV缓存会导致轻微的性能下降,表明初始几帧的内存确实捕获了重要的模型信息。

结论与未来工作

- 结论:

- JanusVLN作为一种新型的VLN框架,通过构建双隐式神经记忆,克服了传统方法在记忆膨胀、计算冗余和空间感知缺失方面的瓶颈。

- 它将MLLM与3D视觉几何基础模型相结合,仅从RGB视频中感知空间几何结构,无需辅助3D数据。

- 实验结果证明了JanusVLN的优越性,推动了VLN研究从2D语义主导转向3D空间-语义协同,为开发下一代空间感知型具身智能体指明了方向。

- 未来工作:

- 可以进一步探索更复杂的融合策略,以更有效地结合空间几何特征和视觉语义特征。此外,还可以尝试整合更大规模的外部数据集,以构建更强大的导航模型。