全参数与PEFT深度剖析

🍋🍋大数据学习🍋🍋

🔥系列专栏: 👑哲学语录: 用力所能及,改变世界。

💖如果觉得博主的文章还不错的话,请点赞👍+收藏⭐️+留言📝支持一下博主哦🤞

一、引言

在大模型蓬勃发展的当下,微调技术成为了连接通用模型与特定任务、领域的关键纽带。大模型虽在预训练阶段吸收了海量知识,具备强大的通用能力,但面对千差万别的实际应用场景,如医疗领域的疾病诊断辅助、金融行业的风险评估、法律事务中的合同审查等,仍需进一步优化才能精准发力。

微调,简言之,就是在预训练好的大模型基础上,利用特定任务或领域的数据集进行二次训练,使模型能更好地适应具体需求 。其中,全参数微调与高效微调 PEFT(Parameter - Efficient Fine - Tuning)是两种重要的微调策略,它们在原理、操作方式和应用效果上各有千秋,共同构成了丰富的微调技术体系。接下来,让我们深入剖析这两种微调方式,探寻它们在大模型优化之路上的独特魅力与价值。

二、全参数微调

2.1 基本原理

全参数微调,简单直白来讲,就是在预训练模型的基础上,允许模型中的每一个参数都参与到后续的训练过程中 。在深度学习模型里,参数通常指的是神经网络中各层的权重(weights)和偏置(biases)。以常见的 Transformer 架构为例,就包含了多头注意力机制中的权重矩阵,如\(W_q\)、\(W_k\)、\(W_v\) ,以及前馈神经网络中的权重和偏置 。当进行全参数微调时,这些参数都会在反向传播过程中,依据特定任务数据集上计算得到的梯度来更新。

从数学原理上看,假设模型的参数集合为\(\theta\),损失函数为\(L(\theta; x, y)\),其中\(x\)是输入数据,\(y\)是对应的标签。在全参数微调中,通过梯度下降法来更新参数:\(\theta_{t+1} = \theta_t - \alpha \nabla_{\theta} L(\theta_t; x, y)\),这里的\(\alpha\)是学习率,\(\nabla_{\theta} L(\theta_t; x, y)\) 是损失函数关于参数\(\theta\)在当前时刻\(t\)的梯度 。这个过程不断迭代,使得模型在特定任务上的损失逐渐降低,从而让模型的输出更接近真实标签,实现对特定任务的适配。

2.2 具体方法

2.2.1 标准全参数微调

标准全参数微调是最为直接、基础的微调方式,在这种方法下,模型的所有可训练参数都会被更新,整个过程没有任何冻结层,也不存在对网络层施加的约束条件 。比如在使用预训练的 BERT 模型进行文本分类任务时,BERT 模型内部从输入层、隐藏层到输出层的所有参数,都会在反向传播过程中根据当前文本分类任务的损失函数计算梯度,并依据梯度进行更新。

这种方法的优势很明显,它能充分发挥整个模型的潜力。由于所有参数都参与训练,模型可以对任务数据进行全面、深入的学习,从而在特定任务上获得较高的精度 。在图像识别领域,如果使用预训练的 ResNet 模型对特定种类的植物图像进行分类,标准全参数微调能让模型充分捕捉植物图像中的细微特征差异,实现高精度的分类。

然而,它的缺点也不容忽视。计算资源需求高就是一个突出问题,因为要更新所有参数,在训练过程中就需要存储大量的参数以及它们对应的梯度信息 。当模型规模较大时,像 GPT-3 这样拥有数百亿参数的模型,这一需求会对硬件设备提出非常高的要求,不仅需要高性能的 GPU,还可能需要多卡并行计算,成本高昂。并且,当数据集规模相对较小而模型容量较大时,过拟合风险会显著增加。模型可能会过度学习训练数据中的细节和噪声,导致在新数据上的泛化能力变差 。比如在医疗影像诊断中,如果训练数据有限,采用标准全参数微调一个大型的医学影像分析模型,模型可能会记住训练集中影像的一些特殊特征,但这些特征并非疾病的本质特征,从而在面对新的患者影像时,出现误诊的情况。

2.2.2 基于重参数化的全参数微调

基于重参数化的全参数微调,旨在通过引入特定的结构,在保持原有模型架构不变的前提下,实现更高效的参数利用 。低秩分解就是一种典型的重参数化方法。以 Transformer 模型中的线性层为例,假设原始的权重矩阵为\(W \in \mathbb{R}^{d \times k}\),其中\(d\)是输入维度,\(k\)是输出维度。在低秩分解中,将\(W\)分解为两个低秩矩阵\(A \in \mathbb{R}^{d \times r}\)和\(B \in \mathbb{R}^{r \times k}\)的乘积,即\(W = A \cdot B\),这里的\(r\)是远小于\(d\)和\(k\)的秩值 。在训练过程中,不再直接更新\(W\),而是更新\(A\)和\(B\)。

这种方法有诸多优势,从内存占用角度来看,由于只需要存储低秩矩阵\(A\)和\(B\),相比于存储原始的高维权重矩阵\(W\),内存占用大幅降低。在控制泛化能力方面,低秩分解相当于对模型施加了一种隐式的正则化。因为低秩假设限制了模型的表达能力,使得模型不能过度拟合训练数据,从而在一定程度上提高了模型的泛化性能 。并且,通过调整秩\(r\)的值,可以灵活地探索不同配置组合之间的权衡关系,以满足多样性的应用场景需求。如果在处理简单的文本情感分类任务时,可以设置较小的\(r\)值,既能满足任务需求,又能降低计算成本;而在处理复杂的机器翻译任务时,适当增大\(r\)值,以提升模型的表达能力。

2.3 适用场景与案例分析

全参数微调适用于对精度要求极为严苛,同时又拥有充足计算资源和大规模高质量数据集的场景 。在医疗诊断辅助领域,像华南理工大学研发的扁鹊大模型,其核心基于 ChatGLM-6B 架构,通过对千万级中文健康对话数据进行全参数微调,实现了精准的慢性病管理和健康咨询服务。在处理复杂的医学诊断推理任务时,全参数微调能让模型充分学习大量的医学知识和病例信息,精准捕捉病历中的细微症状关联,为医生提供准确的诊断参考,帮助患者获得更有效的治疗方案。

在金融风险评估领域,市场环境复杂多变,数据维度高且关系复杂。全参数微调可以使模型综合考虑各种经济指标、市场趋势和历史数据,更敏锐地识别数据中的风险信号,为金融机构提供更精准的风险评估结果,辅助其做出合理的投资决策和风险管理策略 。例如,利用全参数微调训练一个金融风险评估模型,它可以对宏观经济数据、行业数据、企业财务数据等进行全面分析,预测投资项目的风险概率,为投资者规避潜在风险。

三、高效微调 PEFT(轻量化微调)

3.1 PEFT 的核心思想

高效微调 PEFT,作为一种新兴且极具潜力的微调策略,其核心思想在于巧妙地冻结预训练模型的大部分参数,仅针对少量新增或修改的参数进行训练 。在传统的全参数微调中,模型所有参数都参与训练,这就好比对一座已经建好的大厦进行全面翻修,不仅耗费巨大的人力、物力(对应计算资源),而且在某些情况下还可能破坏大厦原本稳定的结构(导致过拟合等问题)。而 PEFT 则像是对大厦的关键区域进行针对性改造,既保留了大厦整体的稳定性(预训练模型的泛化能力),又能高效地满足新的功能需求(适配特定任务)。

从资源消耗角度来看,这种方式极大地降低了计算成本和存储成本 。因为只需存储和更新少量参数,在训练过程中,计算梯度和更新参数的操作也主要集中在这些少量参数上,大大减轻了硬件设备的负担。以一个拥有数十亿参数的大型语言模型为例,采用 PEFT 进行微调时,需要训练的参数可能仅占原模型参数的千分之一甚至更少,这使得在普通的消费级 GPU 设备上也能进行高效的模型微调,极大地拓宽了模型应用的范围。

3.2 主要方法详解

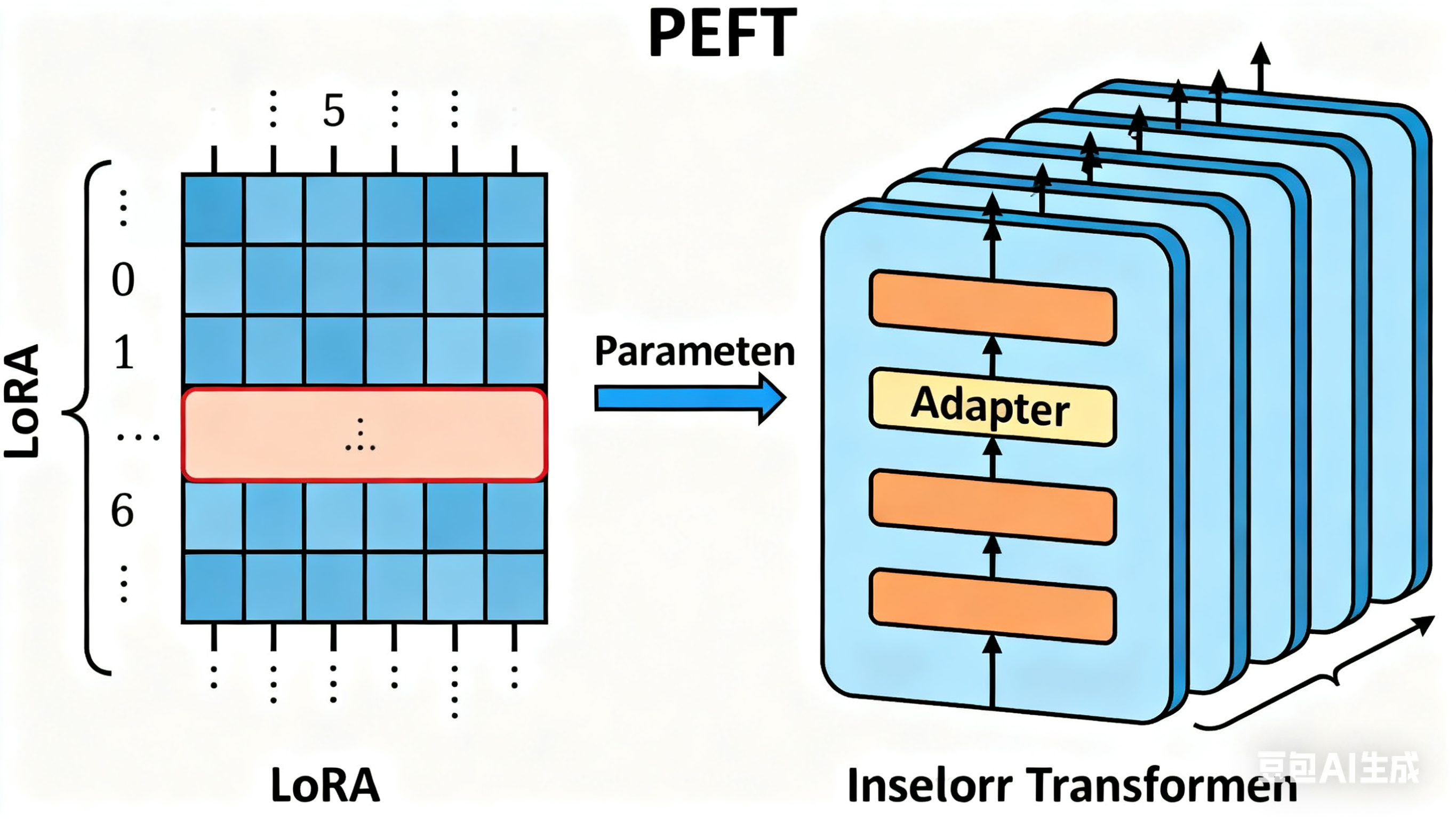

3.2.1 LoRA(Low - Rank Adaptation)

LoRA 即低秩自适应,是一种在深度学习领域广泛应用的高效微调技术,其核心原理基于低秩矩阵分解。在 Transformer 架构中,当对模型进行微调时,假设原始的权重矩阵为\(W\) ,维度通常较高,如\(d_{in} \times d_{out}\) 。LoRA 引入了两个低秩矩阵\(A\)和\(B\) ,其中\(A\)的维度为\(d_{in} \times r\) ,\(B\)的维度为\(r \times d_{out}\) ,这里的\(r\)是远小于\(d_{in}\)和\(d_{out}\)的秩值 。通过这种方式,将权重的更新\(\Delta W\)表示为\(A\)和\(B\)的乘积,即\(\Delta W = A \cdot B\) 。在训练过程中,只需要更新低秩矩阵\(A\)和\(B\)的参数,而原始模型的权重\(W\)保持不变 。

这种方法带来了诸多显著优势。在减少训练参数方面,与全参数微调相比,LoRA 大大降低了需要训练的参数量。例如在 GPT-3 模型中,全参数微调涉及的可训练参数数以百亿计,而采用 LoRA 微调时,可训练参数数量能减少至原来的千分之一甚至更少 ,这使得训练效率大幅提升,训练时间显著缩短。并且,由于不需要更新原始模型的所有参数,在推理阶段,LoRA 不会增加额外的计算量,也就不会引入推理延迟,保证了模型在实际应用中的实时性 。

在实际应用场景中,企业内部的知识库问答系统定制就常采用 LoRA 技术 。企业通常拥有大量的业务文档、技术资料等,希望通过微调预训练语言模型,使其能够准确回答员工关于这些内部知识的问题。利用 LoRA,企业可以在不耗费大量计算资源的前提下,快速对模型进行定制化训练,让模型精准理解企业内部特定的术语、业务流程等知识,提升问答系统的准确性和效率 。

3.2.2 QLoRA

QLoRA,即量化低秩自适应,是在 LoRA 基础上进一步发展而来的创新技术,主要聚焦于解决大模型内存占用过高的问题 。它的核心原理是在 LoRA 引入低秩矩阵分解减少参数量的基础上,创新性地引入了 4 - bit 量化技术和双重量化技术 。

4 - bit 量化技术将模型参数的数据类型从常规的 16 - bit 或 32 - bit 降低到 4 - bit ,这意味着每个参数占用的内存空间大幅减少。以一个包含 100 亿参数的模型为例,若采用 16 - bit 存储,大约需要 160GB 的内存空间来存储参数;而采用 4 - bit 量化后,内存占用可降低至 40GB 左右 。并且,QLoRA 还引入了 4 - bit NormalFloat (NF4) 这种针对正态分布权重设计的数据类型,相较于传统的 4 - bit 整数和浮点数,NF4 在实际应用中展现出更优异的性能 。

双重量化技术则是对初次量化后的常量进行二次量化,进一步压缩存储 空间。通过这种方式,平均每个参数可以节省约 0.37 位的存储空间 ,对于大型模型而言,这能节省相当可观的内存。QLoRA 还利用 NVIDIA 统一内存特性,引入分页优化器。在 GPU 内存不足时,分页优化器可以自动将优化器状态卸载到 CPU 内存,确保在处理长序列长度的小批量数据时,GPU 不会因为内存峰值而出现错误,实现无错误的 GPU 处理 。

QLoRA 的出现,使得在资源有限的情况下微调超大型模型成为可能。在单张 48GB GPU 上即可微调 65B 参数的超大模型 ,这在之前是难以想象的。例如,在一些科研机构或小型企业中,可能无法配备大规模的 GPU 集群,但又有对大型语言模型进行微调的需求,QLoRA 技术就为他们提供了可行的解决方案,推动了大模型技术在更广泛场景中的应用 。

3.2.3 适配器(Adapters)

适配器是一种在 Transformer 层后插入小型全连接网络模块的高效微调方式 。这些适配器模块通常由两个全连接层组成,中间带有一个非线性激活函数,如 ReLU 。在微调过程中,仅训练这些适配器模块,而预训练模型的其他参数保持冻结状态 。当输入数据经过 Transformer 层处理后,会接着进入适配器模块。适配器模块通过调整自身的参数,对 Transformer 层输出的特征进行进一步变换和调整,使其更适应特定的任务需求 。

适配器的模块化设计使其具有很强的多任务适配能力 。例如,在一个多语言翻译系统中,针对不同语言对的翻译任务,可以为每个任务单独训练一个适配器模块 。当需要进行英语到中文的翻译时,加载对应的适配器模块,模型就能利用这个适配器对英语输入进行处理,生成符合中文表达习惯的翻译结果;而在进行英语到法语的翻译时,切换到法语翻译对应的适配器模块即可 。这种方式不仅提高了模型在不同任务上的适应性,还能有效避免不同任务之间的干扰,因为每个适配器模块只针对特定任务进行训练,相互独立 。

在跨领域客服系统中,适配器也发挥着重要作用 。客服系统需要处理来自不同领域的客户咨询,如电子产品售后、金融产品咨询、生活服务投诉等 。通过为每个领域训练一个适配器,当接收到客户咨询时,系统可以根据咨询内容所属领域,快速加载相应的适配器,让模型准确理解客户问题,并提供专业、准确的回答,提升客户满意度 。

3.2.4 Prefix Tuning

Prefix Tuning 主要聚焦于自然语言生成任务,其核心原理是通过在 Transformer 模型的每一层输入前添加可训练的 “前缀向量” 来引导模型的输出 。这些前缀向量就像是给模型的 “任务提示”,模型在生成文本时,会根据这些前缀向量所携带的信息,结合输入文本,生成更符合任务需求的内容 。

以文本摘要任务为例,在训练阶段,为模型的每一层输入添加特定的前缀向量 。这些前缀向量经过训练,能够让模型学习到文本摘要任务的关键特征和模式 。当模型处理一篇新闻报道时,前缀向量会引导模型关注报道中的关键信息,如事件主体、发生时间、主要影响等 ,从而生成简洁、准确的摘要内容 。在文本生成任务中,Prefix Tuning 可以帮助模型更好地控制生成文本的风格、主题等 。如果希望生成一篇正式的商务邮件回复,通过训练特定的前缀向量,模型就能生成语言规范、格式恰当的邮件内容 。

3.2.5 Prompt Tuning

Prompt Tuning 是一种相对轻量级的微调方法,其原理是仅对输入提示嵌入向量进行训练 。在预训练模型中,输入文本通常会先被转换为词嵌入向量,而 Prompt Tuning 在这个过程中,添加了可训练的提示嵌入向量 。这些提示嵌入向量会与词嵌入向量拼接在一起,作为模型后续处理的输入 。通过训练这些提示嵌入向量,可以引导模型朝着特定的任务方向进行输出 。

这种方法特别适用于对模型输出风格进行快速调整的轻量级任务 。在社交媒体内容生成场景中,不同的平台和用户可能有不同的语言风格偏好 。有的用户喜欢幽默风趣的表达方式,有的则倾向于简洁明了的语言 。通过 Prompt Tuning,可以训练不同风格的提示嵌入向量 。当为喜欢幽默风格的用户生成内容时,加载幽默风格的提示嵌入向量,模型就能生成充满趣味和梗的社交媒体文案;而当为追求简洁的用户服务时,切换到简洁风格的提示嵌入向量,模型即可生成简洁直接的内容 。

四、全参数微调与 PEFT 的对比分析

4.1 资源消耗对比

在计算资源方面,全参数微调由于需要更新模型的每一个参数,在反向传播过程中,要计算所有参数的梯度,这无疑需要强大的计算能力支持。以 GPT-3 模型为例,其拥有 1750 亿个参数 ,进行全参数微调时,即便是使用多块高性能 GPU 并行计算,训练时间也可能长达数周,消耗大量的计算资源和时间成本 。而 PEFT 方法,如 LoRA,只需要更新引入的低秩矩阵参数,可训练参数数量相较于全参数微调大幅减少,通常仅为原模型参数的千分之一甚至更少 。这使得在普通的消费级 GPU 上也能高效完成训练,计算资源需求大幅降低,训练时间也能缩短至几小时到数天不等 。

从存储资源角度来看,全参数微调需要存储整个模型的所有参数,以及在训练过程中产生的梯度信息 。对于大型模型,这将占据巨大的存储空间。在医疗影像分析中使用的大型卷积神经网络模型,全参数微调时存储模型参数和相关信息可能需要几十 GB 甚至上百 GB 的存储空间 。而 PEFT 方法,像适配器方法,仅需存储适配器模块的参数,这些参数数量极少,大大降低了存储需求 。QLoRA 通过 4 - bit 量化技术和双重量化技术,进一步压缩模型参数的存储大小,使得存储资源消耗得到更显著的控制 。

4.2 性能表现对比

通过大量的实验数据和实际案例可以发现,全参数微调在数据量充足、任务复杂且对精度要求极高的情况下,往往能展现出出色的性能 。在一些复杂的科学研究任务中,如蛋白质结构预测,全参数微调可以让模型充分学习大量的实验数据和专业知识,捕捉到数据中的细微模式和关系,从而实现高精度的预测 。

然而,在很多实际应用场景中,PEFT 方法也能取得与全参数微调相当甚至更优的性能 。在自然语言处理的文本分类任务中,使用 LoRA 进行微调的模型,在准确率和召回率等指标上,与全参数微调的模型相差无几 。在某些情况下,由于 PEFT 方法能够有效避免过拟合问题,其在泛化性能上甚至优于全参数微调 。在处理社交媒体短文本情感分类任务时,数据量相对较小且噪声较多,采用 PEFT 微调的模型能够更好地适应这种数据特点,在测试集上表现出更高的准确率 。

4.3 适用场景总结

基于上述对比分析,全参数微调更适合于拥有充足计算资源和大规模高质量数据集,且对模型精度有极致要求的场景 。在科研领域,如对宇宙天体数据的分析、药物研发中的分子结构分析等,需要模型能够精准捕捉数据中的复杂特征和规律,全参数微调可以充分发挥其优势 。在工业生产中的质量检测环节,如果需要对产品进行高精度的缺陷检测,全参数微调也能通过对大量样本的学习,实现精准的判断 。

而 PEFT 则在资源受限的环境中表现出色,适用于数据量相对较小、计算资源有限但又需要快速实现模型定制化的场景 。在边缘设备上进行图像识别应用开发时,由于设备的计算能力和存储容量有限,采用 PEFT 方法可以在不占用过多资源的前提下,对模型进行微调,使其适应特定的识别任务 。在企业内部的一些轻量级应用,如简单的文档分类、员工日常问题的智能答疑等,PEFT 也能快速完成模型的适配,满足业务需求 。

五、如何选择与应用

5.1 根据自身资源与需求选择方法

如果拥有充足的计算资源,如配备多块高性能 GPU 的计算集群,并且数据集规模较大,涵盖了丰富的样本和多样性的特征,同时对模型在特定任务上的精度要求极高,那么全参数微调是一个不错的选择 。在生物制药领域的蛋白质结构预测任务中,由于蛋白质结构的复杂性和多样性,需要模型能够学习到极其细微的特征和规律。此时,全参数微调可以让模型充分利用大规模的蛋白质序列和结构数据,通过更新所有参数,捕捉数据中的复杂模式,从而实现高精度的蛋白质结构预测,为药物研发提供关键的支持 。

相反,如果计算资源有限,比如只有单块普通的 GPU,或者数据集规模较小,难以支撑全参数微调的需求,同时对模型的实时性要求较高,那么 PEFT 方法更为合适 。在智能家居设备的语音助手开发中,设备的计算能力和存储容量有限,无法进行大规模的全参数微调。而采用 LoRA 等 PEFT 方法,可以在少量的用户语音数据上对预训练模型进行快速微调,使语音助手能够准确理解用户的指令,实现设备的控制和信息查询等功能 。

5.2 微调过程中的注意事项

在微调过程中,过拟合是一个常见且棘手的问题 。当模型在训练数据上表现出色,但在测试数据或新数据上表现不佳时,就可能出现了过拟合 。为了应对这一问题,可以采取多种策略。增加训练数据量是一种直接有效的方法,更多的数据可以让模型学习到更广泛的特征和模式,减少对训练数据中噪声和细节的过度学习 。在图像分类任务中,如果训练数据仅包含有限的图像样本,模型可能会记住这些样本的特殊特征,而无法泛化到新的图像。通过收集更多不同角度、光照条件、背景环境下的图像数据,可以增强模型的泛化能力 。采用数据增强技术,对于图像数据,可以进行旋转、缩放、裁剪、添加噪声等操作,生成更多的训练样本,丰富数据的多样性 。

正则化技术也是防止过拟合的重要手段,L1 和 L2 正则化通过在损失函数中添加正则化项,对模型参数进行约束,防止参数过大,从而降低模型的复杂度,减少过拟合的风险 。Dropout 技术在训练过程中随机丢弃部分神经元,使得模型不能过度依赖某些特定的神经元连接,增强了模型的鲁棒性和泛化能力 。还可以使用早停法,在训练过程中,监控验证集上的性能指标,如准确率、损失值等。当验证集上的性能不再提升,甚至开始下降时,及时停止训练,避免模型在训练集上过拟合 。

梯度消失或梯度爆炸也是微调过程中可能遇到的问题,尤其是在深层神经网络中 。梯度消失指的是在反向传播过程中,梯度逐渐减小,导致靠近输入层的参数更新缓慢或几乎不更新,使得模型难以学习到有效的特征 。梯度爆炸则相反,梯度在反向传播中不断增大,导致参数更新过大,模型无法收敛 。为了解决这些问题,可以选择合适的激活函数,如 ReLU 函数,其在正数部分的导数恒为 1,能够有效避免梯度消失问题;改进权重初始化方法,如 Xavier 初始化和 He 初始化,能够使权重在正向和反向传播中保持合适的方差,确保梯度有效传递 ;采用批量归一化(Batch Normalization)技术,对每一层的输入进行归一化处理,使数据分布稳定,减少内部协变量偏移,从而让梯度在传播时更稳定,不易消失或爆炸 。