【ComfyUI】Flux 扩展原始图像边界

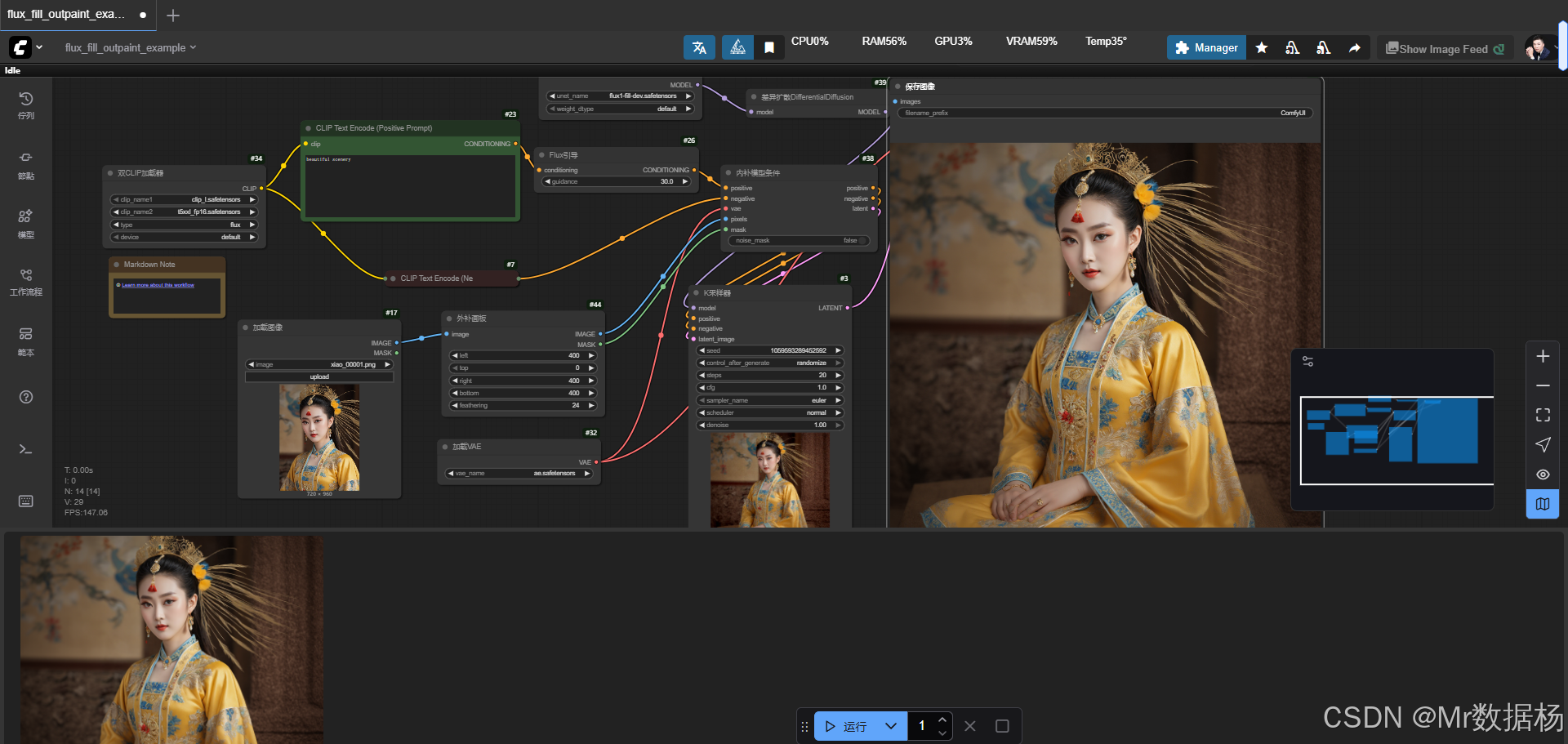

今天展示的案例是一个基于 Flux 扩图 的 ComfyUI 工作流,它能够将原始图像进行外扩生成更大尺寸的画面。该流程利用了扩散模型与条件编码的结合方式,通过对加载图像的边缘填充与掩码重建,生成符合上下文语义的扩展内容。

在效果演示中,原图会自然地向四周延伸,保持风格与内容的统一,从而实现类似壁画、场景拼接或大幅插画的效果。

文章目录

- 工作流介绍

- 核心模型

- Node 节点

- 工作流程

- 应用场景

- 开发与应用

工作流介绍

该工作流主要围绕 Flux 填充模型 进行构建,结合 CLIP 文本编码器与 T5 语义编码,能够对输入的正向提示与负向提示进行解析,再通过采样器与解码器生成符合目标的扩展图像。整体流程从加载图片开始,经过外扩填充、掩码生成、条件编码和扩散推理,最终得到完整的大尺寸画面。这一过程不仅适合艺术创作中的背景延展,也能用于海报设计、漫画拼接和影视分镜扩展等场景。

核心模型

在工作流中,核心模型包括文本编码器、扩散模型和 VAE 解码器。文本编码部分由 CLIP 与 T5 双编码器完成,对提示词进行语义理解和潜在空间条件生成;扩散部分采用 Flux.1 Fill Dev 模型,专门针对 inpainting 与图像外扩任务进行优化;最后由 VAE 模型负责潜在向量到图像的还原,保证生成画面的清晰度与一致性。通过三者的协作,能够实现从文本到图像的精准引导与外扩生成。

| 模型名称 | 说明 |

|---|---|

| clip_l.safetensors | CLIP 文本编码模型,用于解析提示词并生成语义向量 |

| t5xxl_fp16.safetensors | T5 大规模语言模型编码器,补充更细腻的语义信息 |

| flux1-fill-dev.safetensors | Flux 填充扩散模型,专注图像外扩与修补生成 |

| ae.safetensors | VAE 解码模型,将潜在空间数据转换为最终图像 |

Node 节点

该工作流由多个节点协同运行,完成从图像输入到结果保存的全过程。输入部分通过 LoadImage 节点加载原始图像,ImagePadForOutpaint 节点负责对图像进行四周填充并生成掩码区域;文本条件由 CLIP Text Encode(正向与负向提示)节点完成,再交由 FluxGuidance 节点进行条件优化;在模型推理阶段,UNETLoader 与 DifferentialDiffusion 节点构成主干扩散网络,结合 InpaintModelConditioning 节点处理带掩码的潜在向量;KSampler 节点则执行采样生成,VAEDecode 负责解码还原,最终由 SaveImage 节点输出生成结果。

| 节点名称 | 说明 |

|---|---|

| LoadImage | 加载原始输入图像 |

| ImagePadForOutpaint | 对输入图像进行外扩填充并生成掩码 |

| CLIP Text Encode (Positive/Negative Prompt) | 解析提示词,生成正负向条件编码 |

| FluxGuidance | 对条件编码进行引导调整,强化语义控制 |

| UNETLoader | 加载 Flux 扩散模型,作为主干网络 |

| DifferentialDiffusion | 对扩散模型进行差分增强,提高生成稳定性 |

| InpaintModelConditioning | 将掩码区域与条件输入结合,生成潜在向量 |

| KSampler | 执行扩散采样过程,生成潜在图像结果 |

| VAELoader / VAEDecode | 加载 VAE 并将潜在向量解码为最终图像 |

| SaveImage | 保存生成的扩展图像结果 |

工作流程

整个工作流程围绕“加载图像—生成掩码—条件编码—扩散采样—解码输出”的主线展开。输入的原始图片通过加载节点进入流程,首先经过外扩填充以获得新的画布区域和对应的掩码;随后提示词经由双重文本编码器解析为潜在空间中的正负条件信息,并通过引导节点进一步强化语义控制;在扩散模型部分,UNet 网络与差分扩散机制协同作用,将带有掩码和条件输入的潜在表示转化为可生成的图像潜 latent;最后经过采样与 VAE 解码,得到扩展后的完整图像并保存。整个过程保持了原始画面的连贯性,同时在外扩区域引入合理的细节与内容。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 图像输入 | 读取原始图像并准备扩展处理 | LoadImage |

| 2 | 画布扩展 | 对输入图像进行外扩并生成掩码区域 | ImagePadForOutpaint |

| 3 | 文本条件 | 编码正向与负向提示词,生成语义条件 | CLIP Text Encode (Positive/Negative) |

| 4 | 条件引导 | 对生成的语义条件进行优化调整 | FluxGuidance |

| 5 | 模型加载 | 调用 Flux 填充模型与差分扩散组件 | UNETLoader + DifferentialDiffusion |

| 6 | 潜在条件 | 结合掩码区域与条件输入形成潜在向量 | InpaintModelConditioning |

| 7 | 扩散采样 | 运行采样过程生成扩展潜在图像 | KSampler |

| 8 | 图像解码 | 使用 VAE 解码潜在表示为最终图像 | VAELoader + VAEDecode |

| 9 | 结果保存 | 输出并保存扩展后的图像结果 | SaveImage |

应用场景

这一工作流适合在多个实际场景中应用。对于设计师而言,它能够在制作宣传海报、插画或游戏原画时轻松实现画面扩展,避免因分辨率限制带来的素材不足。对于漫画和影视分镜的创作者,该流程能将局部画面外扩成更完整的场景,保证连贯性并节省人工绘制成本。在日常使用中,也能将摄影作品延展成大尺寸的展示图,用于展览或装饰。其应用价值不仅体现在艺术创作的效率提升,还在于对图像生成技术的灵活运用,为跨领域创意提供更多可能性。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 海报与插画设计 | 扩展画布,增强构图 | 平面设计师 | 宣传画、艺术插图 | 获取高分辨率大幅作品 |

| 漫画与影视分镜 | 补充场景画面,保持连续性 | 漫画作者、影视创作者 | 连贯的场景镜头 | 快速生成完整画面 |

| 摄影扩展 | 将照片扩展为大尺寸输出 | 摄影师、展览布展人员 | 摄影作品 | 满足展览与装饰需求 |

| 游戏与虚拟场景 | 制作完整背景与环境 | 游戏原画师 | 游戏场景素材 | 提升沉浸感与画面表现力 |

| 创意实验 | 探索 AI 外扩图像的艺术效果 | 艺术爱好者、研究人员 | 实验性艺术作品 | 生成独特的创意画面 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

ComfyUI使用教程、开发指导、资源下载

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用