本地部署 DeepSeek 私有助手:从零到上线的完整方案

添加图片注释,不超过 140 字(可选)

引言

人工智能(AI)正在迅速发展,借助 DeepSeek 等强大的开源模型,您可以在本地运行尖端的大型语言模型(LLM)。

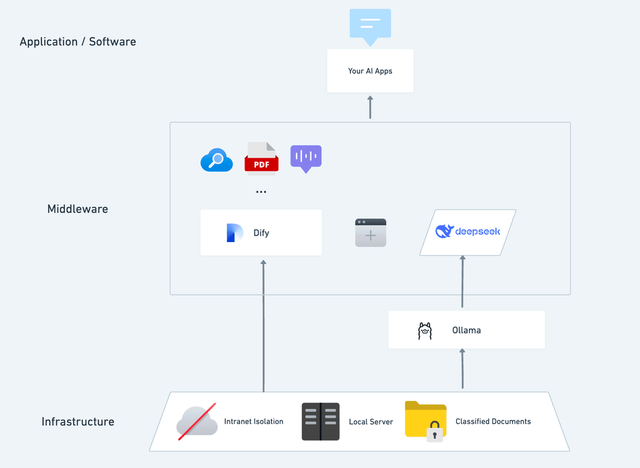

本指南将引导您使用轻量级推理框架 Ollama 部署 DeepSeek,并结合 Dify 平台构建可视化 AI 助手。

完成部署后,您将能够通过 Python API 调用模型,快速开展人工智能驱动的实验,并实现完全私有化的数据处理。

第一部分:为什么选择 DeepSeek?

快速高效 — 针对本地推理优化,轻量且响应迅速。

开源 — 无限制访问,无厂商锁定。

Python API 集成 — 方便在 Python 应用中调用。

可定制 — 支持根据业务需求进行微调与修改。

第二部分:Ollama 本地部署 DeepSeek

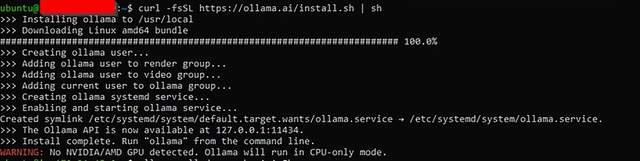

步骤 1:安装 Ollama

Ollama 是一个轻量级运行时,可简化本地 LLM 部署。安装命令:

curl -fsSL https://ollama.ai/install.sh | sh

按 Enter 键或单击以查看大图

添加图片注释,不超过 140 字(可选)

安装后,验证它是否正常工作:

ollama --version

步骤 2:下载 DeepSeek 模型

建议先下载 15 亿参数的小型模型,节省系统资源:

ollama pull deepseek-r1:1.5b

添加图片注释,不超过 140 字(可选)

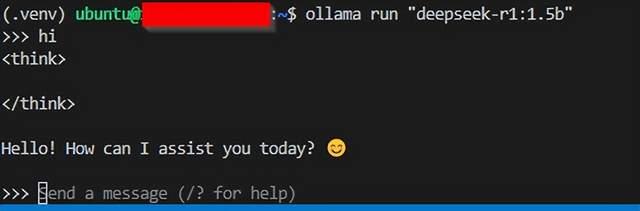

步骤 3:运行 DeepSeek

此命令初始化 DeepSeek 模型,并使其准备好处理自然语言查询:

ollama run deepseek-r1:1.5b

添加图片注释,不超过 140 字(可选)

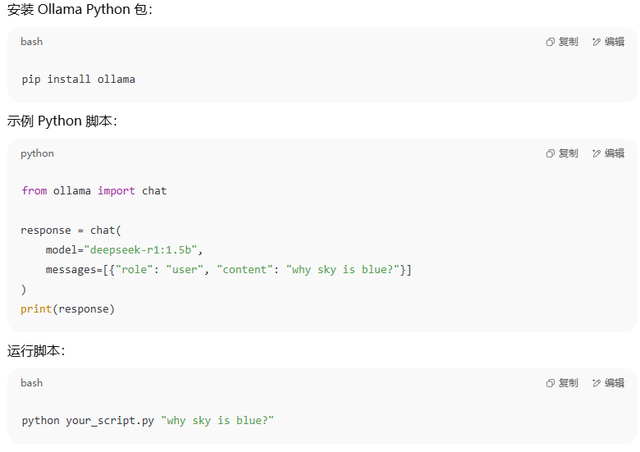

步骤 4:安装 Python 包并调用 API

添加图片注释,不超过 140 字(可选)

第三部分:Dify 集成与可视化 AI 助手

添加图片注释,不超过 140 字(可选)

1. 为什么结合 Dify?

访问 1000+ AI 模型(平台无关,兼容多模型推理)。

提供 Web UI、知识库、RAG、工作流等工具。

支持完全离线运行,确保数据安全。

2. 部署前准备

硬件要求

CPU:≥ 2 核

GPU/RAM:≥ 16 GiB(推荐)

软件要求

Docker

Docker Compose

Ollama

Dify 社区版

3. 安装 Dify 社区版

bash

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -d

安装完成后,访问:

http://your_server_ip

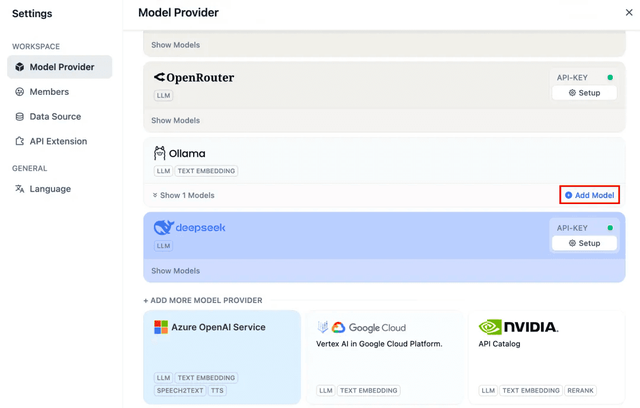

4. 在 Dify 中接入 DeepSeek

打开 Profile → Settings → Model Provider。

选择 Ollama 并点击“添加模型”。

模型名称:deepseek-r1:7b(根据实际部署填写)。

基本 URL:http://your_server_ip:11434。

添加图片注释,不超过 140 字(可选)

5. 构建 AI 应用

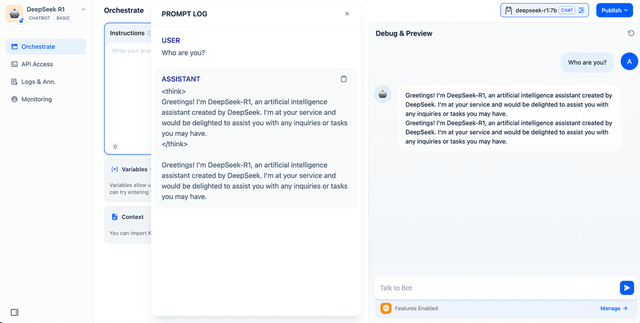

(1) 聊天机器人

创建空白应用 → 选择“聊天机器人”类型 → 指定 DeepSeek 模型 → 测试交互。

添加图片注释,不超过 140 字(可选)

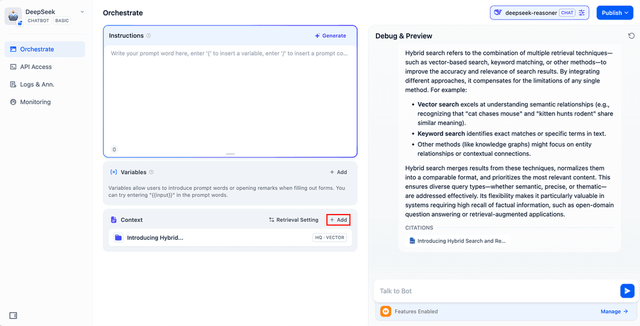

(2) 知识库增强(RAG)

上传内部文档 → 启用父子分块保留结构 → 将知识库接入 AI 应用上下文 → 提升回答准确性。

添加图片注释,不超过 140 字(可选)

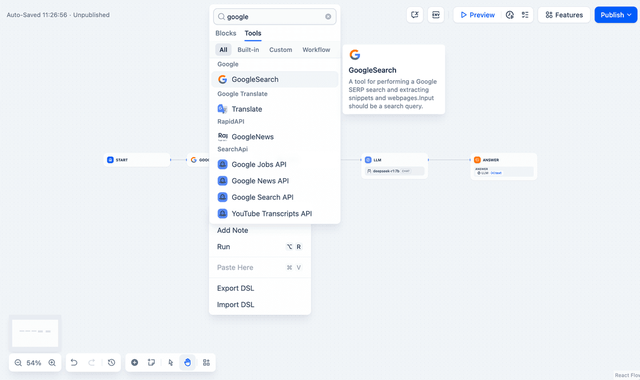

(3) 工作流集成

可加入 Web 搜索节点、代码执行节点、负载均衡和错误处理节点,实现更复杂的自动化逻辑。

添加图片注释,不超过 140 字(可选)

第四部分:常见问题(FAQ)

Q1:Docker 中 Ollama 无法访问?

修改 Ollama 环境变量:Mac:launchctl setenv OLLAMA_HOST "0.0.0.0"Linux:编辑 ollama.service 并添加 Environment="OLLAMA_HOST=0.0.0.0"Windows:在系统环境变量中设置 OLLAMA_HOST 并重启 Ollama。

Q2:如何修改 Ollama 地址和端口?

使用环境变量 OLLAMA_HOST 绑定新地址和端口。

总结

结合 Ollama 与 Dify,您可以在本地快速部署 DeepSeek 模型,实现完全私有化、安全可控、可定制的 AI 助手。 此方案兼顾了部署简单性与功能扩展性,适用于个人开发者与企业落地应用,并可在未来结合量化模型与推理加速进一步提升性能。

结论:方案特色与价值

本方案将 Ollama 的轻量化本地推理能力与 Dify 的可视化应用构建平台深度结合,实现了从模型部署到业务落地的全链条私有化 AI 解决方案。其核心特色包括:

完全私有化与数据安全

全程离线运行,数据不出本地网络,满足企业级合规与隐私保护需求。

快速落地与低门槛

从安装到可用只需约 1 小时,部署流程简单,无需深厚 AI 开发经验。

高度灵活的模型与功能扩展

兼容多种模型版本(1.5B ~ 70B),可根据硬件能力自由选择,并支持知识库增强(RAG)、Web 搜索、工作流编排等功能。

低成本与高性能并存

一次部署,持续使用,无需支付云端调用费用;结合本地 GPU 可显著降低推理延迟。

全场景适配

适用于个人研发实验、企业客服与质检、知识管理、内部培训等多种场景,具备很强的可扩展性。

总结来看,这套 Ollama + Dify + DeepSeek 组合,不仅为个人和企业提供了安全可控、快速可用、可持续演进的 AI 能力,还为未来的多模态、加速推理和定制化应用奠定了坚实基础。