深度相机初探:立体视觉(Stereo Vision)、结构光(Structured Light)、TOF(Time of Flight,飞行时间)

文章目录

- 深度相机

- 一、立体视觉(Stereo Vision):模仿人眼的 “被动式” 深度感知

- 1. 核心原理

- 2. 关键组件

- 3. 优缺点

- 4. 典型应用

- 二、结构光(Structured Light):主动投射 “图案” 的 “高精度” 深度感知

- 1. 核心原理

- 2. 关键组件

- 3. 优缺点

- 4. 典型应用

- 三、TOF(Time of Flight):直接 “测时间” 的 “长量程” 深度感知

- 1. 核心原理

- 2. 关键组件

- 3. 优缺点

- 4. 典型应用

- 四、三种技术核心差异总结

- 五、选择逻辑

深度相机

深度相机的核心功能是获取场景中物体的三维深度信息(即 “距离”),其技术方案主要分为三类:立体视觉(Stereo Vision)、结构光(Structured Light)、TOF(Time of Flight,飞行时间)。三者的本质区别在于 “如何计算深度”—— 前两者基于 “三角测量原理”,TOF 基于 “光的飞行时间”,具体原理、特点及应用可通过以下维度简析:

一、立体视觉(Stereo Vision):模仿人眼的 “被动式” 深度感知

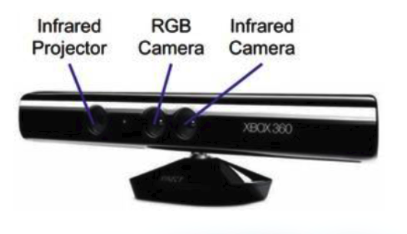

立体视觉是最接近人眼视觉原理的技术,属于 “被动式”(不主动发射光信号,依赖环境光),核心靠 “双相机视差” 算深度。

![![[Pasted image 20251010175139.png]]](https://i-blog.csdnimg.cn/direct/370bbcaa087a4c08aa8b52e20f9f71c7.png)

1. 核心原理

模仿人眼 “左右眼看到同一物体的位置差异”(即 “视差”),通过三角几何关系反推深度:

- 步骤 1:双相机校准。深度相机内置两个平行且参数一致的 RGB 相机(类似人眼间距,称为 “基线”),先通过算法校准两相机的位置偏差,确保拍摄的图像在同一坐标系下。

- 步骤 2:拍摄与匹配。两相机同时拍摄同一目标场景,得到两张 “略有偏移” 的图像(左图、右图)。

- 步骤 3:计算视差与深度。通过 “特征匹配算法”(如 SIFT、SURF)找到两张图像中 “同一物体点” 的像素位置差异(即 “视差”);再结合两相机的固定间距(基线)、焦距等参数,用三角公式计算该点到相机的深度(视差越小,深度越远)。

2. 关键组件

- 双 RGB 相机(核心,需严格校准);

- 图像处理器(用于特征匹配与深度计算)。

3. 优缺点

- 优点:

- 被动式,无主动光发射,不会因强光(如阳光)导致自身信号被淹没;

- 成本较低(仅需双相机,无特殊光发射器);

- 适合户外自然光照场景。

- 缺点:

- 依赖环境光,弱光 / 无光环境(如黑夜、暗室)完全失效;

- 特征匹配难度高:若场景中物体纹理少(如白墙、纯色桌面),易出现 “匹配失败”,导致深度图缺失;

- 精度受 “基线” 影响:基线越短(如手机尺寸限制),远距离精度越差;基线越长,近距离易 “盲区”。

4. 典型应用

- 低成本室内机器人(如扫地机器人避障);

- 户外监控(辅助识别物体距离);

- 早期 VR/AR 设备(如 Oculus Rift 初代)。

二、结构光(Structured Light):主动投射 “图案” 的 “高精度” 深度感知

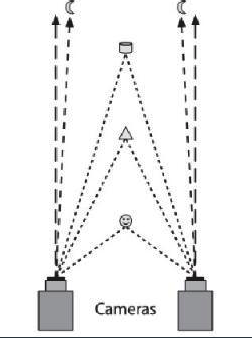

结构光是主动式技术(主动发射已知图案的光信号),核心靠 “图案形变” 反推深度,属于 “主动三角测量” 的延伸。

1. 核心原理

通过投射 “预先设计的光图案” 到目标,利用图案的形变计算深度:

-

步骤 1:发射编码光。由红外发射器(如 VCSEL 垂直腔面激光器)向目标投射 “已知结构的光图案”,常见类型:

- 散斑结构光(如苹果 Face ID):投射随机分布的 “微米级散斑”(类似无数小光斑);

- 条纹结构光:投射连续的条纹 / 网格图案(如工业检测设备)。

![![[Pasted image 20251010175346.png]]](https://i-blog.csdnimg.cn/direct/864182c8fa3d469198ad8fd68c69eac2.png)

-

步骤 2:接收形变图案。由专用红外传感器(避免环境光干扰)接收目标反射的光图案 —— 由于目标各点距离不同,图案会产生 “拉伸、偏移、扭曲” 等形变(距离越近,形变越明显)。

-

步骤 3:计算深度。通过算法对比 “原始图案” 与 “形变图案” 的差异,结合发射器与传感器的固定位置(三角关系),反推目标各点的三维坐标。

![![[Pasted image 20251010175324.png]]](https://i-blog.csdnimg.cn/direct/84ecf51e904644cf8450a8fe6329c0b4.png)

2. 关键组件

- 红外发射器(投射编码图案);

- 红外传感器(接收反射图案);

- 处理器(图案对比与深度计算)。

3. 优缺点

- 优点:

- 主动光信号,不依赖环境光,弱光环境仍有效;

- 近距离精度极高(通常 ±1% 以内,1 米距离误差<1cm);

- 帧率高(30~60fps,可实时输出深度图)。

- 缺点:

- 量程短(通常 0.1~10 米),远距离图案形变不明显,精度骤降;

- 抗强光能力弱:户外阳光会淹没红外图案,导致深度计算失效;

- 易受高反射 / 低反射物体影响(如镜子会反射图案,黑布会吸收光,均导致形变无法识别)。

4. 典型应用

- 消费电子:手机人脸识别(苹果 Face ID、安卓厂商 3D 人脸识别)、手机 AR 测量(部分方案);

- 工业领域:零件尺寸检测、精密装配定位;

- 室内机器人:近距离物体抓取(如服务机器人)。

三、TOF(Time of Flight):直接 “测时间” 的 “长量程” 深度感知

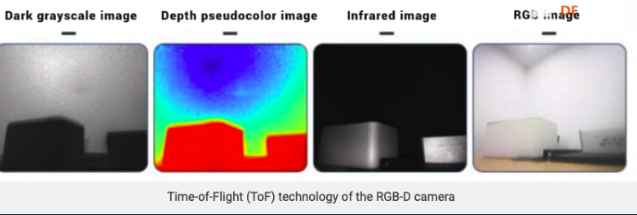

TOF 是主动式技术(主动发射光信号),核心靠 “光的飞行时间” 直接计算距离,无需依赖图案或视差,属于 “直接测距”。

1. 核心原理

利用 “光从发射到反射回传感器的时间差”,结合光速计算深度(距离 = 光速 × 时间差 / 2,除以 2 是因为光需往返)。根据测量方式,分为两类:

- dTOF(直接飞行时间):发射 “短脉冲激光”,直接测量单个脉冲从发射到接收的时间差(如 iPhone 12 及以后的 LiDAR 模块);

- iTOF(间接飞行时间):发射 “调制光”(如周期性的红外光),测量发射光与反射光的 “相位差”,通过相位差反推时间差(更常见于消费级深度相机)。

![![[Pasted image 20251010175429.png]]](https://i-blog.csdnimg.cn/direct/6059d5bc959b4fe69637bbd8388c8e1f.png)

2. 关键组件

- 光发射器(dTOF 用脉冲激光器,iTOF 用调制红外 LED/VCSEL);

- 光电传感器(如 SPAD 单光子雪崩二极管,高精度接收光信号);

- 计时器 / 相位检测器(测量时间差或相位差)。

3. 优缺点

- 优点:

- 量程长(通常 1~50 米,部分工业级可达 100 米以上);

- 抗干扰能力强:光信号波长特定(多为 905nm),不易受阳光、环境光影响,户外性能优于结构光;

- 对物体纹理无依赖:即使是白墙、纯色物体,也能稳定测距(无匹配失败问题)。

- 缺点:

- 精度略低于结构光(通常 ±2%~5%,10 米距离误差约 20~50cm);

- 成本高于立体视觉和结构光(需高精度计时器与传感器);

- 易受 “多路径干扰”(如光经多个物体反射后回到传感器,导致时间差计算偏差)。

4. 典型应用

- 消费电子:手机 AR 导航(如 iPhone LiDAR)、平板 / 笔记本手势控制;

- 户外机器人:无人配送车、巡检机器人避障;

- 安防监控:远距离人体检测与距离判断;

- 工业测绘:中短距离场景三维建模。

四、三种技术核心差异总结

| 技术类型 | 工作方式 | 核心原理 | 精度(近距离) | 量程 | 环境适应性 | 成本 | 典型应用 |

|---|---|---|---|---|---|---|---|

| 立体视觉 | 被动式(无发光) | 双相机视差 + 三角测量 | 中(±3%~5%) | 中短 | 依赖环境光,弱光失效 | 低 | 扫地机器人、户外监控 |

| 结构光 | 主动式(投图案) | 图案形变 + 三角测量 | 高(±1% 以内) | 短(0.1~10m) | 弱光有效,强光失效 | 中 | 人脸识别、工业质检 |

| TOF | 主动式(发光信号) | 飞行时间 / 相位差→距离 | 中(±2%~5%) | 长(1~50m+) | 弱光 / 户外有效 | 高 | 手机 AR、户外机器人 |

五、选择逻辑

- 若需低成本、被动式、户外自然光场景(如扫地机器人),选立体视觉;

- 若需室内高精度、弱光场景(如人脸识别、工业检测),选结构光;

- 若需户外长量程、抗干扰场景(如 AR 导航、户外机器人),选TOF。