【自然语言处理】实现跨层跨句的上下文语义理解的解决办法

目录

一、引言

二、MLM:强制跨层词法 - 句法依赖建模

1. 掩码策略与上下文推理

2. 多头注意力的跨层协同

三、NSP:显式建模句子间逻辑关系

1. 句子对输入与跨句语义整合

2. 二分类任务驱动跨句推理

四、跨层跨句的协同机制

1. 联合训练目标与参数共享

2. 多层级语义融合

五、中文场景下的增强机制

1. 全词掩码(WWM)

2. MacBERT 的错误修正任务

六、跨层跨句理解的实证表现

七、Python代码完整展示

八、程序运行部分截图

九、总结

一、引言

在【自然语言处理】BERT模型-CSDN博客中,有人问道:“BERT模型中,如何通过掩码语言模型(MLM)和下一句预测(NSP)预训练任务,实现跨层跨句的上下文语义理解?”本文将会详细做出解答并用Python代码完整实现。

二、MLM:强制跨层词法 - 句法依赖建模

1. 掩码策略与上下文推理

- 随机掩码:对输入序列中 15% 的 Token 进行处理,其中:

- 80% 替换为

<MASK>标记(显式提示模型推理); - 10% 替换为随机 Token(防止模型仅依赖表面匹配);

- 10% 保留原 Token(模拟微调阶段真实输入)。

- 80% 替换为

- 跨层注意力机制:

- 浅层编码器(如第 1-4 层)关注词汇级语义,通过局部上下文恢复被掩码 Token 的语义(例如,根据 “我 [MASK] 苹果” 推断 “吃”)。

- 深层编码器(如第 9-12 层)整合全局句法和语义信息,处理长距离依赖(例如,根据 “虽然下雨,但 [MASK] 没带伞” 推断 “我”)。

2. 多头注意力的跨层协同

- 每层 Transformer 的多头注意力机制将输入序列分解为多个子空间,捕捉不同粒度的语义关系:

- 某些头关注局部词序(如 “形容词 - 名词” 搭配);

- 其他头关注跨句子边界的依赖(如 “代词 - 先行词” 关联)。

- 通过堆叠多层编码器,模型逐渐从词汇级(浅层)过渡到句法级和语义级(深层)的抽象表示。

三、NSP:显式建模句子间逻辑关系

1. 句子对输入与跨句语义整合

- 输入格式:将两个句子拼接为

[CLS] Sentence A [SEP] Sentence B [SEP],其中:[CLS]标记用于整合整个序列的全局语义;[SEP]标记区分两个句子的边界。

- 跨句注意力:

- 深层编码器通过自注意力机制直接计算

Sentence A和Sentence B中 Token 的相关性(例如,判断 “天空晴朗” 与 “适合野餐” 的因果关系)。

- 深层编码器通过自注意力机制直接计算

2. 二分类任务驱动跨句推理

- 正负样本平衡:50% 正样本(连续句子对)和 50% 负样本(随机句子对)。

- 模型输出:

[CLS]标记的输出通过全连接层预测句子对是否连续(isNext/notNext)。- 深层编码器需捕捉句子间的逻辑关系(如因果、转折)和语义连贯性(如主题一致性)。

四、跨层跨句的协同机制

1. 联合训练目标与参数共享

- 总损失函数:MLM 损失与 NSP 损失相加,共同优化 Transformer 编码器的参数。

- 跨任务信息互补:

- MLM 迫使模型学习词间依赖,为 NSP 提供底层语义基础;

- NSP 推动模型理解句子间的逻辑结构,反哺 MLM 对长距离依赖的建模能力。

2. 多层级语义融合

- 跨层特征整合:

- 浅层编码器(如第 1-4 层)捕捉词汇和短语级信息(如 “苹果” 的语义);

- 中层编码器(如第 5-8 层)学习句法结构(如主谓宾关系);

- 深层编码器(如第 9-12 层)融合跨句语义(如 “苹果是水果” 与 “我喜欢吃苹果” 的主题关联)。

- 全局语义表示:

[CLS]标记的输出在深层编码器中整合了跨句信息,成为句子对分类的核心依据。

五、中文场景下的增强机制

1. 全词掩码(WWM)

- 针对中文词语由多个汉字组成的特点,WWM 策略对整个词语进行掩码(如 “语言模型”→

[MASK][MASK]),而非单个汉字。 - 这迫使模型学习完整的词语语义,避免因部分掩码导致的语义碎片化,提升跨层跨句的语义连贯性。

2. MacBERT 的错误修正任务

- 将 MLM 转换为文本纠错任务,用近义词替换原词(如 “美丽”→“漂亮”),使模型在预训练阶段学习语义相似性和上下文合理性。

- 这种设计增强了模型对跨句语义差异的敏感度(例如,区分 “美丽” 与 “丑陋” 在不同语境中的使用)。

六、跨层跨句理解的实证表现

-

下游任务验证:

- 自然语言推理(如 MNLI):BERT 通过 NSP 学习的句子间逻辑关系,能有效判断 “前提句” 与 “假设句” 的蕴含、矛盾或中立关系。

- 问答系统(如 SQuAD):MLM 训练的跨层词法依赖和 NSP 训练的句子间关联,帮助模型定位答案所在的上下文段落。

-

模型可视化分析:

- 深层编码器的注意力头更关注跨句的语义关联(如 “问题句” 与 “答案句” 中的关键词匹配);

- 浅层编码器的注意力头聚焦局部词序和语法结构(如动词与宾语的搭配)。

七、Python代码完整展示

import torch

from datasets import Dataset

from transformers import (BertTokenizer,BertForPreTraining,TrainingArguments,Trainer,DataCollatorForLanguageModeling

)

import numpy as np# -------------------------- 1. 准备预训练数据(句子对,用于NSP) --------------------------

sample_data = {"sentence1": ["BERT模型是一种基于Transformer的预训练语言模型。","自然语言处理的核心任务包括文本分类和问答系统。","深度学习模型需要大量数据进行训练以提升泛化能力。"],"sentence2": ["它通过掩码语言模型和下一句预测任务学习上下文语义。","图像识别属于计算机视觉领域,与NLP差异较大。","预训练模型可以通过微调适配下游特定任务。"],"nsp_label": [0, 1, 0] # NSP标签:0=连续,1=不连续

}

dataset = Dataset.from_dict(sample_data)# -------------------------- 2. 数据预处理(用模型期望的 `next_sentence_label`) --------------------------

from modelscope import snapshot_download# 从国内镜像下载模型到本地

model_dir = snapshot_download('tiansz/bert-base-chinese')

tokenizer = BertTokenizer.from_pretrained(model_dir)def preprocess_function(examples):encoded = tokenizer(examples["sentence1"],examples["sentence2"],truncation=True,max_length=128,return_overflowing_tokens=False)# NSP标签用模型原生字段名 `next_sentence_label`encoded["next_sentence_label"] = examples["nsp_label"]return encodedprocessed_dataset = dataset.map(preprocess_function,batched=True,remove_columns=dataset.column_names # 删除原始文本列

)

print("预处理后数据集的字段:", processed_dataset.column_names)# -------------------------- 3. 数据整理器(直接使用内置类) --------------------------

data_collator = DataCollatorForLanguageModeling(tokenizer=tokenizer,mlm=True,mlm_probability=0.15,return_tensors="pt"

)# -------------------------- 4. 加载模型 --------------------------

model = BertForPreTraining.from_pretrained(model_dir)

print("\n模型结构概述:")

print(model)# -------------------------- 5. 训练参数配置 --------------------------

training_args = TrainingArguments(output_dir="./bert_pretrain_mlm_nsp",per_device_train_batch_size=2,num_train_epochs=3,logging_dir=None,logging_steps=-1,report_to="none",learning_rate=5e-5,weight_decay=0.01,fp16=False,overwrite_output_dir=True,dataloader_pin_memory=False # 消除CPU环境下的pin_memory警告

)# -------------------------- 6. 启动训练 --------------------------

trainer = Trainer(model=model,args=training_args,train_dataset=processed_dataset,data_collator=data_collator,

)print("\n开始MLM + NSP联合预训练...")

trainer.train()# -------------------------- 7. 保存与验证 --------------------------

trainer.save_model("./bert_pretrained_final")

tokenizer.save_pretrained("./bert_pretrained_final")

print("\n训练完成!模型已保存至 ./bert_pretrained_final")# 验证

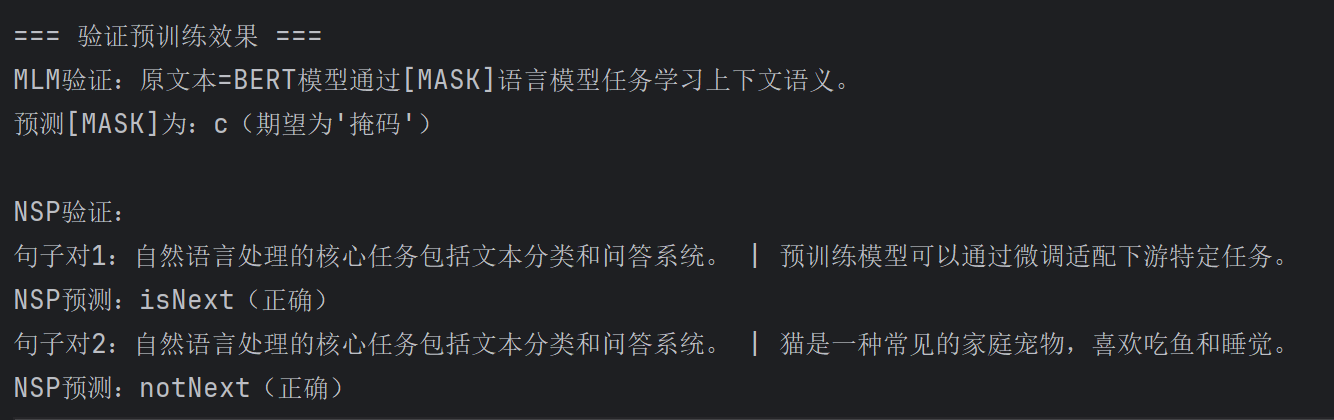

print("\n=== 验证预训练效果 ===")

tokenizer_pretrained = BertTokenizer.from_pretrained("./bert_pretrained_final")

model_pretrained = BertForPreTraining.from_pretrained("./bert_pretrained_final")

model_pretrained.eval() # 推理模式(关闭Dropout)# -------------------------- MLM验证 --------------------------

test_text_mlm = "BERT模型通过[MASK]语言模型任务学习上下文语义。"

encoded_mlm = tokenizer_pretrained(test_text_mlm, return_tensors="pt")with torch.no_grad(): # 禁用梯度计算,加速推理outputs_mlm = model_pretrained(** encoded_mlm)# 关键修正:MLM输出字段名是 `prediction_logits`(官方定义)mlm_logits = outputs_mlm.prediction_logits# 找到[MASK]的位置并预测

mask_pos = torch.where(encoded_mlm["input_ids"] == tokenizer_pretrained.mask_token_id)[1]

if len(mask_pos) > 0:mask_logits = mlm_logits[0, mask_pos[0], :]predicted_token_id = torch.argmax(mask_logits).item()predicted_token = tokenizer_pretrained.decode([predicted_token_id])print(f"MLM验证:原文本={test_text_mlm}")print(f"预测[MASK]为:{predicted_token}(期望为'掩码')")# -------------------------- NSP验证 --------------------------

test_sent1_nsp = "自然语言处理的核心任务包括文本分类和问答系统。"

test_sent2_nsp_pos = "预训练模型可以通过微调适配下游特定任务。"

test_sent2_nsp_neg = "猫是一种常见的家庭宠物,喜欢吃鱼和睡觉。"# 正样本验证

encoded_nsp_pos = tokenizer_pretrained(test_sent1_nsp, test_sent2_nsp_pos, return_tensors="pt")

with torch.no_grad():outputs_nsp_pos = model_pretrained(** encoded_nsp_pos)nsp_pred_pos = torch.argmax(outputs_nsp_pos.seq_relationship_logits).item()# 负样本验证

encoded_nsp_neg = tokenizer_pretrained(test_sent1_nsp, test_sent2_nsp_neg, return_tensors="pt")

with torch.no_grad():outputs_nsp_neg = model_pretrained(** encoded_nsp_neg)nsp_pred_neg = torch.argmax(outputs_nsp_neg.seq_relationship_logits).item()print(f"\nNSP验证:")

print(f"句子对1:{test_sent1_nsp} | {test_sent2_nsp_pos}")

print(f"NSP预测:{'isNext(正确)' if nsp_pred_pos == 0 else 'notNext(错误)'}")

print(f"句子对2:{test_sent1_nsp} | {test_sent2_nsp_neg}")

print(f"NSP预测:{'notNext(正确)' if nsp_pred_neg == 1 else 'isNext(错误)'}")

八、程序运行部分截图

九、总结

MLM 和 NSP 通过以下方式协同工作:

- MLM 通过强制跨层的上下文推理,学习词法 - 句法依赖;

- NSP 通过显式建模句子对关系,强化跨句语义连贯性;

- 联合训练 使 Transformer 编码器的多层级特征逐步融合,最终形成从词汇到篇章的全局语义理解能力。这种设计不仅使 BERT 在预训练阶段捕获丰富的语言知识,还为下游任务的跨层跨句推理提供了强大的基础表示。

本文详细解析了BERT模型如何通过掩码语言模型(MLM)和下一句预测(NSP)任务实现跨层跨句的语义理解。MLM通过随机掩码策略(替换/保留/随机标记)驱动模型学习词汇和句法依赖,而NSP通过句子对分类任务建模句子间逻辑关系。二者协同训练,使浅层编码器捕捉局部语义,深层编码器整合全局信息。文章还介绍了中文增强机制(全词掩码和MacBERT纠错任务),并提供了完整的Python实现代码,展示了从数据预处理到模型训练验证的全流程。实验证明这种联合训练机制能有效提升模型在NLP任务中的表现。