大模型训练微调和推理阶段的显存对比分析

随着AI的普及,大家在使用大模型过程中经常提及7b,32b,甚至671b等等,究竟是什么意思呢,其实这个“b”就是 billion(十亿) 的缩写,一般是指AI大模型的 参数(Parameters) 数量,而且只有上千万参数量才可能称作为大模型,比如deepseek-r1:7b就是一个参数量为70亿的大模型,Qwen3-72b表示一个参数量为720亿的大模型。我们只要搞懂了这些参数,以后再也不怕被那些技术名词唬住了。大模型的生命周期主要包含训练(Training)、微调(Fine-tuning)和推理(Inference)三个阶段**,不同阶段的显存需求是完全不同的,一般三者的显存对比分析如下。

一、训练

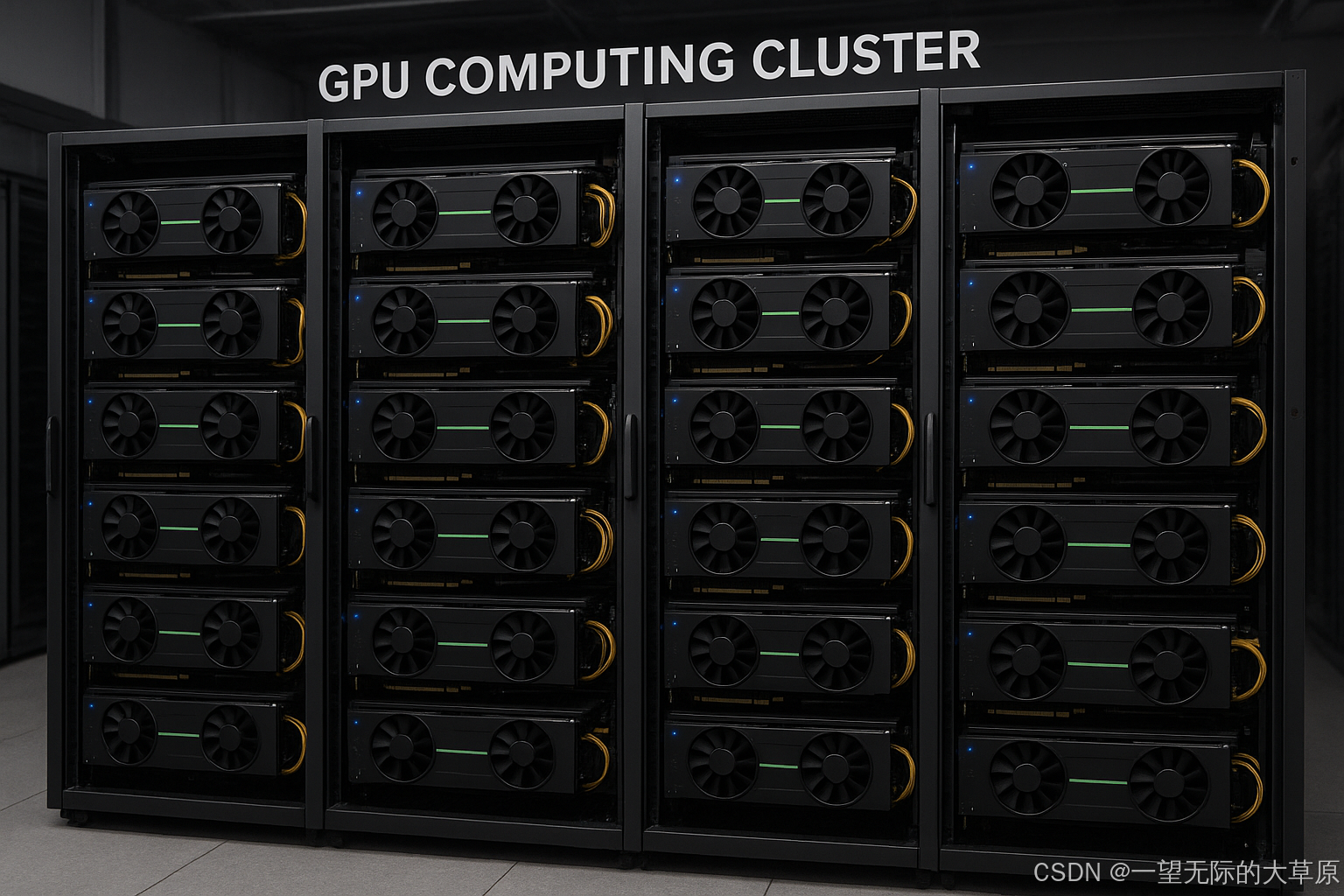

训练阶段的算力要求是三个阶段最高的,主要关注运算性能 (TFLOPS)、GPU 数量、高速互联(如NVLink、Infiniband)保障数据传输效率。训练算力需求一般随模型参数量和数据集规模呈指数级增长,常见的公式是所需总算力(FLOPs)=6×P×D,这里的P是模型参数量,D是用于训练的数据量(即词源Tokens)。因此,总算力取决于参数量和数据量,参数量其实也取决于数据量,只有用于训练的数据量达到一定规模才能构建出可用的模型。

训练阶段的显存要求是三个阶段最高的,主要关注模型参数 (P) 、 梯度 、优化器状态和激活值等,同时需要存储用于优化计算的多个数据副本。比如deepseek-r1:7b,在训练过程中,用于存储模型状态 (参数+梯度+优化器)的显存为12X7B=84GB,用于存储激活值的显存为80GB,再加上多个数据的副本约40GB,合计200GB,相当于三张80G的A100。

一、微调

微调分为全量微调和高效微调

全量微调:显存要求一般是模型参数大小的16-20倍,比如deepseek-r1:7b,需要显存16X7=120GB以上,相当于两张80G的A100。

高效微调(LoRA):显存一般是模型参数大小的3-5倍,比如deepseek-r1:7b,需要显存3X7=20GB以上,相当于1张40G的A100。有时候也会用到量化微调(即Q-LoRA),相当于比LoRA所需的算力还低。

二、推理

推理阶段仅涉及模型的前向传播,主要来自模型参数和 KV Cache,显存需求远低于微调。推理更关注延迟和并发能力,可通过量化、缓存、并行等方式优化。

单条推理:显存一般是模型参数大小的1-3倍,比如deepseek-r1:7b,需要显存1X7=7GB以上,相当于单卡RTX 3090/4090,8G显存或24G显存,DeepSeek-R1:72b,需要显存1X72=72GB以上,相当于两张40G的A100。