论文解读:GRAPHEVAL: A LIGHTWEIGHT GRAPH-BASED LLM FRAMEWORK FOR IDEA EVALUATION

1. 一段话总结

为解决现有基于 LLM 的观点评估方法(如 prompt-based 方法、微调轻量模型)存在的不稳定性、难以理解复杂语义信息及易忽略事实错误等问题,研究者提出GraphEval—— 一种轻量级基于图的 LLM 观点评估框架,其核心是将复杂观点拆解为可理解的 “观点节点”,通过 LLM 关系提取或 BERT 相似度构建 “观点图”;框架包含两种方法:Graprcher Dataset 两个数据集上验证,GraphEval 的F1 分数至少提升 14%,且计算与 API 成hEval-LP(无训练标签传播算法,将已知节点质量标签传播到未知节点)和GraphEval-GNN(低计算资源的 GNN 模型,新增新颖性检测以识别抄袭观点);实验在 ICLR Papers 和 AI Resea本低,还能有效检测抄袭观点,代码已开源(https://github.com/ulab-uiuc/GraphEval)。

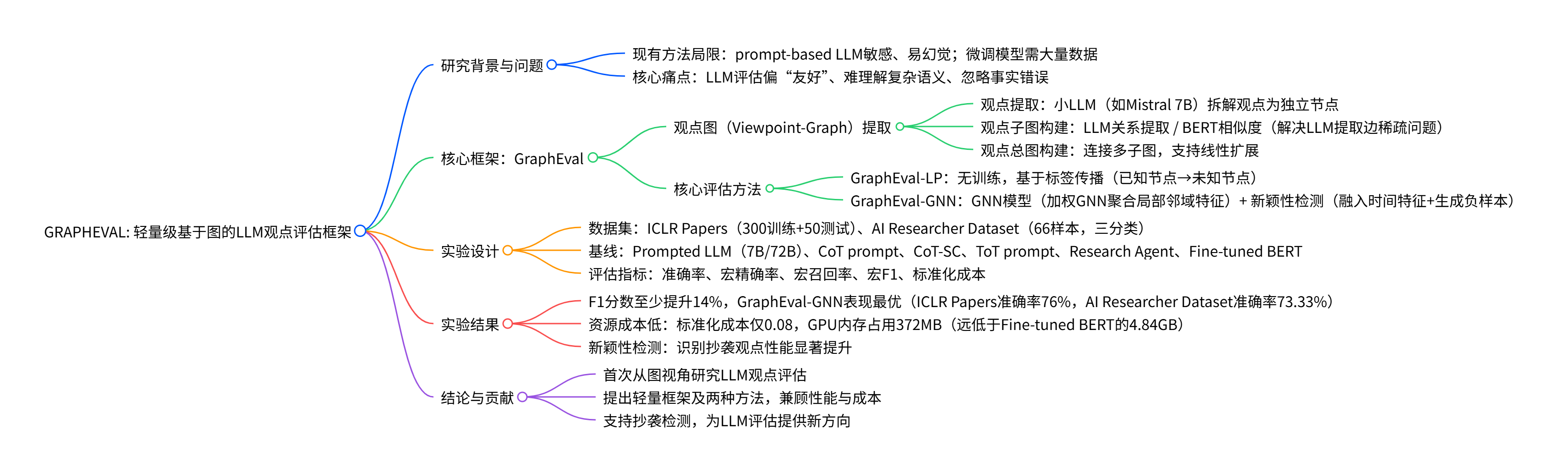

2. 思维导图(mindmap)

3. 详细总结

1. 研究背景与核心问题

现有基于 LLM 的观点评估(如学术研究观点评估)存在三大核心问题:

- 不稳定性:prompt-based 方法对提示词高度敏感(如图 1 中同一观点在不同 prompt 下分数差异达 10 分,均倾向 “Accept”),且易产生幻觉;

- 语义理解难:复杂观点包含多概念、多逻辑关系,LLM 需博士级理解能力才能准确判断,现有方法易忽略穿插的事实错误(如图 2 中 LLM 仅关注全局信息,漏检红色标注的事实错误);

- 泛化性与成本问题:微调轻量模型(如 BERT)需大量训练数据,泛化性差;大模型(如 72B)评估性能未提升反而下降,且 API 成本高。

2. GraphEval 框架设计

GraphEval 的核心是 “将复杂观点结构化”,通过 “观点图” 实现全局与局部信息融合评估,整体流程分为 “观点图提取” 和 “两种核心评估方法” 两部分。

2.1 观点图(Viewpoint-Graph)提取

| 提取步骤 | 具体操作 | 关键细节 |

|---|---|---|

| 观点提取(Viewpoint Extraction) | 用小 LLM(如 Mistral 7B)将观点拆解为独立 “观点节点” | 观点节点为语义独立、可评估的最小单元(如事实、论点),避免代词歧义 |

| 观点子图构建(Viewpoint-subgraph) | 两种方式:1. LLM 关系提取:LLM 识别观点对逻辑关系(支持 / 反对)2. BERT 相似度:BERT 编码观点得嵌入,计算余弦相似度,连接 Top-k 节点 | LLM 提取存在边稀疏问题(300 个观点平均边数 3.71,密度 10.73%),BERT 方式可调节 k 控制边密度 |

| 观点总图构建(Viewpoint-Graph) | 连接训练集与测试集的所有观点子图,每个节点连接其他子图中 Top-m 相似节点 | 支持线性扩展,新观点子图可快速融入 |

2.2 两种核心评估方法

-

GraphEval-LP(无训练标签传播)

- 初始化:训练集观点节点向量对应标签设为 1(其他为 0),测试集节点初始为 0 向量;正则化边权重(节点所有邻边权重和为 1);

- 标签传播:迭代更新节点向量(节点向量 = 自身向量 + 邻接节点加权向量,归一化),直至标签稳定;

- 标签预测:对某观点的所有节点向量求和,取最大值对应标签为预测结果。

-

GraphEval-GNN(GNN + 新颖性检测)

- 特征初始化:节点特征用 BERT 编码,边特征用相似度 / 关系属性;

- 加权 GNN 计算:通过 L 层 GraphConv 聚合邻域特征(公式 3:\(h_{v}^{(l)}=U^{(l)}ConCAT\left(Mean\left(\{ReLU(w_{v}W^{(l)}h_{q}^{(l-1)}),q\in N(v)\right\}),h_{v}^{(l-1)}\right)\));

- 子图预测:用Mean Pooling(全局信息)和Max Pooling(局部信息)聚合节点嵌入,经 MLP 和 Softmax 输出观点标签;

- 新颖性检测:融入时间特征(捕捉观点时序),生成抄袭观点作为负样本(如复制高评分观点、替换部分节点),提升抄袭识别能力。

3. 实验设置

3.1 任务与数据集

任务:以学术论文摘要为观点载体,预测评审结果(4 分类:Reject、Accept (Poster)、Accept (Oral)、Accept (Spotlight);AI Researcher Dataset 合并为 3 分类)。

| 数据集 | 数据规模 | 标签分布(Reject/Poster/Oral/Spotlight) | 用途 |

|---|---|---|---|

| ICLR Papers | 训练 300 + 测试 50 | 训练:55%/25%/10%/10%;测试:64%/24%/8%/4% | 主数据集 |

| AI Researcher Dataset | 66 样本 | 53.03%/27.27%/19.70%/0%(Oral 与 Spotlight 合并) | 额外测试集 |

3.2 基线与评估指标

- 基线方法:Prompted LLM(7B/72B)、CoT prompt、CoT-SC(5 次采样集成)、ToT prompt(5 分支迭代)、Research Agent、Fine-tuned BERT;

- 评估指标:准确率(Accuracy)、宏精确率(Macro Precision)、宏召回率(Macro Recall)、宏 F1(核心指标)、标准化成本(Normed Cost,最高成本设为 1)。

3.3 实现细节

- 模型配置:GNN 为 2 层加权 GNN(隐藏维度 64),Adam 优化器(学习率 1e-3→0),最大 epoch 1000;

- 资源消耗:GraphEval-GNN 平均 GPU 内存 372MB(Fine-tuned BERT 为 4.84GB),Mistral 7B API 成本 $0.20/1M tokens。

4. 实验结果

4.1 与基线对比(核心结果)

| 数据集 | 最优模型 | 准确率提升(vs 最优基线) | F1 提升(vs 最优基线) | 标准化成本 |

|---|---|---|---|---|

| ICLR Papers | GraphEval-GNN | 76%(vs Fine-tuned BERT 66%,+10%) | 43.59%(vs Fine-tuned BERT 26.01%,+17.58%) | 0.08 |

| AI Researcher Dataset | GraphEval-GNN | 73.33%(vs Fine-tuned BERT 60%,+13.33%) | 67.13%(vs Fine-tuned BERT 53.33%,+13.8%) | 0.08 |

关键结论:

- GraphEval-GNN 显著优于所有基线,包括大模型(如 72B Prompted LLM 准确率仅 4%-6%);

- GraphEval-LP 表现次之(ICLR Papers 准确率 70%),且无需训练,适合低资源场景;

- 复杂 prompt 方法(如 ToT、Research Agent)未优于简单 prompt,证明 prompt 优化对复杂语义评估作用有限。

4.2 新颖性评估效果

人工构建 80 个抄袭观点(3 种方式:直接复制、替换部分节点、相似节点替换),对比 “有无新颖性检测” 的 GraphEval-GNN 性能,结果显示加入新颖性检测后,准确率、精确率、召回率、F1 均显著提升,验证其有效识别抄袭观点的能力。

5. 研究贡献与结论

- 理论贡献:首次从图视角研究 LLM 观点评估,为图增强 LLM 研究提供新方向;

- 方法贡献:提出轻量级 GraphEval 框架,包含无训练的 GraphEval-LP 和带新颖性检测的 GraphEval-GNN;

- 实践贡献:实验验证框架F1 至少提升 14%,低计算 / API 成本,支持抄袭检测,代码开源可复用。

4. 关键问题

问题 1:GraphEval 通过哪些设计解决了现有 LLM 观点评估的 “不稳定性” 和 “复杂语义理解难” 两大核心问题?

答案:针对 “不稳定性”,GraphEval 通过 “观点图” 结构规避 LLM 对 prompt 的敏感性 —— 将复杂观点拆解为独立 “观点节点”,评估基于节点间的关联(标签传播 / GNN 聚合),而非依赖 LLM 对整体观点的主观判断,减少 prompt 波动影响;针对 “复杂语义理解难”,GraphEval 采用两层设计:1. 观点拆解:用小 LLM 将复杂观点拆分为语义独立的节点,降低理解难度;2. 全局 + 局部信息融合:观点图捕捉节点间关联(全局),GraphEval-GNN 的 Mean Pooling(全局信息)和 Max Pooling(局部信息,如单个事实错误节点)结合,避免现有 LLM 仅关注全局而忽略局部事实错误的问题。

问题 2:GraphEval 的 “观点子图构建” 包含 LLM 关系提取和 BERT 相似度两种方式,二者的差异及最终选择依据是什么?

答案:二者差异及选择依据如下:

- 边密度与信息完整性:LLM 关系提取方式的边稀疏(300 个观点平均边数 3.71,密度 10.73%),大量节点孤立,丢失关系信息;BERT 相似度方式可通过调节 Top-k 控制边密度,确保节点间关联充分;

- 资源成本:LLM 关系提取需额外调用 LLM API,增加 token 成本;BERT 相似度基于预训练模型编码,成本更低;

- 稳定性:LLM 关系提取易受 prompt 影响产生幻觉,BERT 相似度基于语义嵌入计算,结果更稳定;最终 GraphEval 在子图构建中优先采用BERT 相似度方式,解决 LLM 提取的边稀疏和高成本问题,确保观点子图的有效性。

问题 3:GraphEval 的 “新颖性检测” 模块具体如何设计,实验中如何验证其有效性?

答案:1. 模块设计:包含两部分 ——① 特征层面:在观点节点特征中融入时间信息,让模型捕捉观点的时序先后;② 数据层面:人工生成 “抄袭观点” 作为负样本(3 种方式:直接复制高评分观点、随机替换高评分观点的部分节点、用观点图中相似节点替换高评分观点节点),并标注低评估标签,加入 GNN 训练;2. 有效性验证:在 ICLR Papers 数据集上构建 80 个抄袭观点测试集,对比 “有无新颖性检测” 的 GraphEval-GNN 性能,结果显示加入新颖性检测后,模型在准确率、精确率、召回率、F1 分数上均显著提升,证明其能有效识别抄袭或衍生观点,避免 LLM 因未考虑新颖性而给抄袭观点高分的问题。