文档解析Logics-Parsing

1. 摘要(Abstract)

近年来,大型视觉语言模型(LVLM)的快速发展极大推动了文档解析任务的进步。与传统的基于流水线的方法相比,端到端范式凭借集成光学字符识别(OCR)、表格识别、数学公式识别等技术,在将 PDF 图像转换为结构化输出方面展现出显著优势。然而,由于缺乏针对文档布局和阅读顺序的明确分析阶段,LVLM 在处理多栏报纸、海报等复杂类型文档时能力受限。为解决这一局限,本报告提出 Logics-Parsing 模型:一种基于端到端 LVLM 并融合强化学习的模型。该模型设计了精细的奖励机制,用于优化复杂布局分析与阅读顺序推断。此外,通过在有监督微调中融入化学公式、手写汉字等多样数据类型,扩展了模型的通用性。最后,为对该方法进行严格评估,我们构建了 LogicsParsingBench 基准数据集,包含 1078 张页面级 PDF 图像,涵盖 9 个主要类别及 20 多个子类别,后续将公开发布。在 LogicsParsingBench 上开展的全面实验表明,所提模型在各类文档分析场景中均具备有效性,达到了当前最优(SOTA)性能。

# 论文

https://arxiv.org/pdf/2509.19760

# 代码

https://github.com/alibaba/Logics-Parsing

https://www.modelscope.cn/models/Alibaba-DT/Logics-Parsing/files

# 项目

https://logics.alibaba-inc.com/parsing/

# 演示

https://www.modelscope.cn/studios/Alibaba-DT/Logics-Parsing/summary

2. 引言(Introduction)

从 PDF 文档图像中自动解析结构化内容,一直是文档人工智能(Document AI)领域的核心挑战。提取出的纯文本、表格、公式等元素,是先进的基于 AI 的文档分析、检索增强生成(RAG)乃至通用人工智能(AGI)的基础组件。传统 OCR 系统 [7,20] 通常采用基于流水线的架构,依次部署专业模型处理元素检测、区域裁剪、元素识别等子任务。但这种模块化方法存在三个关键局限:首先,每个专业模型仅优化自身局部目标,无法保证整个文档解析任务达到全局最优;其次,训练和部署多个模型的计算开销极大;最后,对文档中多个子组件的独立处理,会破坏元素间的信息交互,影响整体上下文建模。为缓解这些缺陷,端到端 OCR - 2.0 模型 [24,25] 应运而生,旨在降低维护成本,并实现对各类子任务的全局优化。

近年来,大型视觉语言模型(LVLM)[2,3,12,15] 的迅猛发展,大幅提升了模型处理多模态数据的能力。尽管 LVLM 具有较强的泛化能力,但大多数模型主要针对推理任务训练,在视觉 - 文本感知场景中存在局限。此外,LLaVAR [27]、mPLUG - DocOwl [26]、olmOCR [17] 等主流 LVLM 的视觉编码器所采用的 CLIP 目标函数 [18],主要关注粗粒度的视觉 - 文本语义对齐,忽略了图像中包含的细粒度文本信息。同时,预训练的 CLIP 视觉模型通常仅支持固定输入分辨率(如 224×224 或 336×336 像素),难以满足包含密集、小尺寸文本元素的文档解析需求。为解决这些问题,Vary [24] 并行训练了一个高分辨率视觉编码器,专门用于文档级 OCR 任务;Qwen2 - VL 系列 [3,22] 引入原生动态分辨率机制,打破了空间限制。尽管取得了这些改进,端到端文档解析范式仍面临关键挑战:当前 LVLM 广泛采用的下一个 token 预测目标,仅简单优化输入文本图像与输出文本之间的 token 级对齐,却忽视了复杂布局对阅读顺序推断的干扰。为解决这一问题,Infinity - Parser [21] 将强化学习引入文档解析任务,并设计了三种布局感知奖励机制。但尽管奖励机制经过专门设计,其段落计数目标仅统计段落数量,未考虑对应元素块的明确位置与分隔;且在 Qwen - 2.5 - VL - 7B [3] 基础模型上直接执行 GRPO [19],并未确保该基础模型适用于文档解析任务,可能误导 GRPO 的优化方向。近期研究 [4] 强调了大型模型后训练的关键原则:有监督微调(SFT)负责记忆,强化学习(RL)负责泛化,这表明在通过强化学习实现泛化之前,需先通过有监督微调稳定模型输出格式。

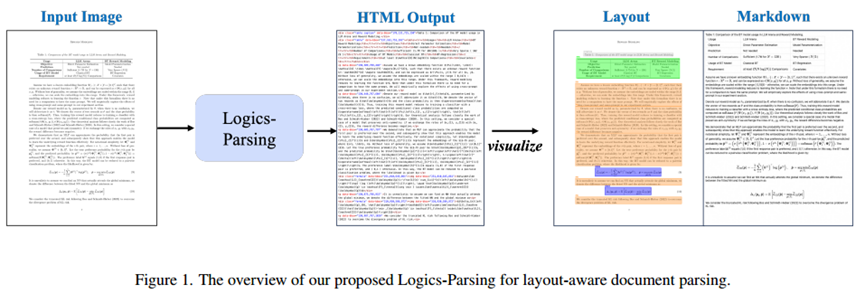

为解决上述局限,本报告提出 Logics - Parsing 模型 —— 一种基于端到端 LVLM 并融合强化学习的框架,旨在构建稳健且具备布局感知能力的文档解析模型(如图 1 所示)。该模型采用 “先 SFT 后 RL” 的两阶段训练策略,以确保有效性。首先,通过在训练中融入纯文本、数学公式、表格、化学公式、手写汉字等多样数据类型,使用 30 多万张高质量页面级文档图像对 Qwen2.5 - VL - 7B [3] 进行微调,为文档解析奠定坚实基础。其次,借助布局感知的多组件奖励机制以及新颖的难样本挖掘策略,增强模型正确识别页面布局结构的能力,并确保模型在识别出的布局下遵循自然阅读顺序。该阶段显著提升了模型在多栏报纸、海报等复杂布局文档上的性能。此外,为严格评估所提 Logics - Parsing 模型,我们构建了一个全面的基准数据集 LogicsParsingBench,包含 1078 张页面级 PDF 图像,涵盖 9 个主要类别(如学术论文、技术报告)及 20 多个子类别。与涵盖多种文档类型且标注信息丰富的顶级基准数据集 OminiDocBench [16] 相比,LogicsParsingBench 更注重评估模型处理复杂布局和解析科学内容的能力,并引入了多项增强的评估协议。

图 1 Logics - Parsing 布局感知文档解析整体框架

综上,本研究的贡献如下:

- 提出 Logics - Parsing 模型:一种基于端到端大型视觉语言模型(LVLM)并融合强化学习的框架。通过明确建模文档布局,支持文本、数学公式、表格等异构内容类型的多模态识别,该框架能够构建在复杂真实文档解析场景中性能强劲且适用范围广的模型。

- 为使 Logics - Parsing 具备对各类内容的稳健识别能力,我们收集了 30 多万张高质量页面级文档图像,通过自动化流水线标注结合人工循环验证的方式完成标注。单页中同时包含纯文本、数学公式、表格等元素,为复杂真实文档分析提供了全面的训练数据。

- 在包含 9 个类别、1078 张页面级 PDF 图像的综合基准数据集 LogicsDocBench 上进行了大量评估,结果有效验证了所提方法在复杂布局中显著提升了结构理解与内容排序能力,在实际文档解析任务中表现更优。

3. 方法(Methodology)

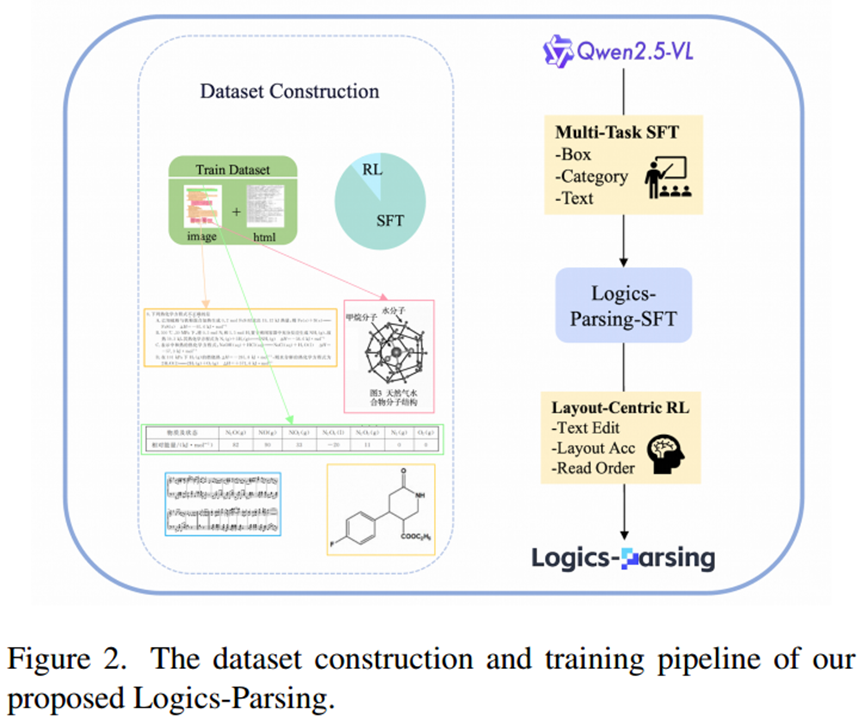

本节将详细介绍 Logics - Parsing 模型的方法,该模型采用两阶段训练范式,旨在同时提升文档解析能力与细粒度结构对齐能力。首先概述 “先 SFT 后 RL” 框架,然后介绍高质量训练数据集的构建过程,最后详细阐述每个训练阶段。

3.1 概述(Overview)

如图 2 所示,整个训练过程始于有监督微调(SFT)阶段。在该阶段,模型在大规模、多样化的文档数据集上,以标准的下一个 token 预测为目标进行训练,从而具备文本识别、文本块与空间坐标关联等基本能力。

图 2 Logics - Parsing 数据集构建与训练流程

然而,我们认为有监督微调中逐 token 的自回归监督,为页面结构学习提供的信号既间接又不充分。例如,token 级交叉熵损失不会对错误的段落级阅读顺序进行明确惩罚,也无法区分边界框坐标中小误差与大误差的差异。

为解决这些局限,我们引入了布局中心强化学习(LC - RL)阶段。该阶段利用规模较小但精心挑选的高难度高质量样本,直接优化结构分析能力。通过采用多组件奖励函数,明确评估文本准确性、布局精度与逻辑阅读顺序,引导模型生成不仅文本准确,而且结构连贯、逻辑顺序合理的输出。

3.2 数据集(Dataset)

为实现有效的模型训练,我们构建了一个大规模、多样化、高质量的数据集,其核心特征之一是采用 HTML 标注格式。众所周知,HTML 天然能够编码文档的层级结构(如嵌套表格、列表),且便于可视化渲染。该综合数据集的构建与 “先 SFT 后 RL” 的两阶段训练策略相契合,分为 SFT 子集与 RL 子集。这种双子集设计确保了数据准备与相应模型优化阶段的一致性。

3.2.1 SFT 数据集(SFT Dataset)

为丰富训练多样性并构建性能强劲的文档解析基础模型,我们从两个互补来源收集数据。

一方面,我们系统地整合多个成熟的公开数据集,并将其标准化为统一的 HTML 标注格式。具体而言,在页面级解析方面,我们从 olmOCRmix - 0225 [17] 中筛选样本子集,将其原始标注转换为标准化的 HTML 格式;在表格识别这一关键子任务中,我们从 FinTabNet [28]、TNCR [1]、PubTabNet [29] 等顶级基准数据集中收集数据,使模型能够接触到各类表格结构;在化学结构识别方面,我们直接采用分子 OCR 基准数据集 ChEBI - 20 - MM [13],为模型理解化学图表的特定语法与布局规则提供针对性训练。

另一方面,我们构建了一个大规模内部数据集,通过 “自动化提取 + 专业模型优化” 的两阶段标注流水线完成标注。首先,利用 Mathpix 1 对大量公开文档进行预标注,提取内容、边界框与语义类型;随后,针对 Mathpix 难以解析的复杂布局,使用 Gemini 2.5 Pro [5] 进行验证与修正,重点修正嵌套公式、多层表格等复杂场景下的错误,确保标注的高精度与高可靠性。

然而,仍有大量高度复杂的文档与边缘案例无法通过上述自动化标注流水线处理。对于这些样本,我们引入人工干预:约 10000 张页面样本由专业人工标注员进行严格审核与修正。此外,我们还对这些样本的文档阅读顺序进行人工标注 —— 这是自动化工具难以实现的。这种人工循环标注方式,不仅严格保证了标注准确性,还扩大了标注覆盖范围,形成了一个黄金标准子集,显著增强了模型对真实场景中文档内容与结构组织的理解能力。

3.2.2 RL 数据集(RL Dataset)

强化学习通常受益于规模小但质量高的数据集。为此,我们提出一种新颖的难样本挖掘策略,从上述 SFT 数据集中筛选出一个针对性子集。

首先,从上述人工循环标注子集中手动挑选约 4000 张页面样本。这些样本特意选择布局复杂且具有挑战性的案例,此类案例已被证明对标准自回归模型构成巨大挑战。

其次,为收集对 RL 阶段学习既具有难度又具备信息量的样本,我们采用推理引导的难样本挖掘策略:将 SFT 模型在整个训练集上进行推理,选择预测结果与真实标签之间的标准化编辑距离处于 [0.5, 0.8] 区间的样本。该区间能够有效捕捉 SFT 模型虽能部分理解但无法完美解析的案例,为后续基于 RL 的优化形成理想的 “学习区域”。通过这种方式,又收集了约 4000 张额外样本。

综上,上述数据挖掘策略共为 LC - RL 阶段获取了约 8000 张高质量、高难度的训练样本。LC - RL 的有效性在很大程度上依赖于这种专门针对 SFT 模型弱点的训练集。

3.3 有监督微调(Supervised Fine-Tuning)

训练范式的第一阶段聚焦于有监督微调(SFT),旨在使模型具备基础的文档理解能力,并使模型输出与目标结构化 HTML 格式对齐。

我们并未从零开始训练大型视觉语言模型(VLM),而是策略性地选择在强大的预训练基础模型之上构建自己的模型 —— 选用 Qwen2.5 - VL - 7B - Instruct [3]。该选择基于其在开源 VLM 中的当前最优性能:不仅为各类视觉 - 语言任务奠定了稳健基线,还能高效适配下游特定领域任务。具体而言,在 2.2 节所述的综合数据集上,以标准的下一个 token 预测为目标,对模型进行一个 epoch 的微调,使模型能够根据输入文档图像生成目标 HTML 序列。

该过程得到的基线模型称为 Logics - Parsing - SFT。完成此阶段后,该模型已在核心文档分析任务中展现出卓越性能:不仅能实现精准的文本识别与空间定位,还具备高度的指令遵循能力,能够持续生成符合提示要求的结构化 HTML 输出。尽管 Logics - Parsing - SFT 已构建了坚实的基础模型,但 token 级监督的固有局限,促使我们开展后续以布局为中心的强化学习阶段。

3.4 布局中心强化学习(Layout-centric Reinforcement Learning)

如前所述,SFT 阶段采用的下一个 token 预测目标,在复杂布局与阅读顺序学习方面存在固有局限,尤其在处理报纸、杂志、多栏报告等布局高度复杂的文档时表现明显。对于这类样本,即使人类要解析出正确的阅读顺序也非易事。为克服这一挑战,我们提出第二训练阶段 —— 基于布局中心强化学习(LC - RL),采用组相对策略优化(GRPO)算法(我们发现该算法非常适合此类问题)。通过综合的多组件奖励函数(直接评估输出答案质量)与精心挖掘的 “高难度且含信息量” 数据集,引导模型生成更符合人类阅读习惯的结果。

具体而言,在每次训练迭代中,我们对模型预测结果与真实标签进行解析,提取其中的组成元素:文本内容(包括文本、公式等)及其对应的边界框坐标,然后计算三个不同的奖励组件。第一个奖励通过负标准化莱文斯坦距离(Levenshtein distance)[9],衡量预测文本序列与真实文本序列之间的字符级相似度;第二个奖励用于评估预测边界框与目标边界框的定位准确性,引导模型将每个内容元素定位到页面的正确位置;第三个奖励主要关注优化解析内容的逻辑阅读流程,通过计算参考段落与预测段落之间的成对倒置次数来衡量。该奖励直接惩罚顺序混乱的内容,对于学习复杂的非线性阅读路径至关重要。最后,对每个样本,将这三个组件以线性组合的方式构成最终奖励。

4. 实验(Experiments)

4.1 LogicsParsingBench:复杂文档解析基准数据集(LogicsParsingBench: A Benchmark for Complex Document Parsing)

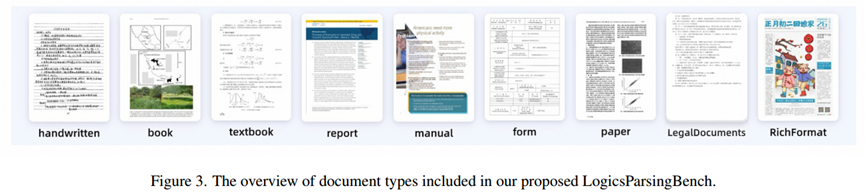

为解决现有评估基准数据集的局限(尤其是对复杂逻辑结构文档与专业科学内容文档覆盖不足的问题),我们引入 LogicsParsingBench 基准数据集。该数据集经过精心筛选,具有挑战性,旨在严格评估现代文档解析模型的能力。LogicsParsingBench 包含 1078 张高质量页面,能够反映真实场景的复杂性,推动文档智能领域的发展。

该基准数据集具有三个核心特征:首先,LogicsParsingBench 中的样本涵盖 9 个主要类别(如图 3 所示)和 20 多个子类别,包含中英文两种语言,确保了覆盖的多样性与全面性。我们的基准数据集特别强调学术与科学文档类别,这些文档来源于数学、物理、化学等多个 STEM(科学、技术、工程、数学)领域,其特点是包含大量复杂嵌套的数学公式与精密的化学结构。此外,数据集中还纳入了乐谱、中文古籍等稀有且具有挑战性的文档类型,进一步丰富了测试样本的多样性。

图 3 LogicsParsingBench 包含的文档类型概述

其次,LogicsParsingBench 中包含大量具有多栏布局与文图混合内容的复杂页面,这不仅对模型提出了更高要求,也为评估模型的布局分析能力与泛化能力提供了更严格的标准。

最后,更复杂的基准数据集自然需要更精细的评估协议。基于 OminiDocBench [16] 的顶级开源评估代码,LogicsParsingBench 的评估协议进行了两项关键改进:

- 全局文本评估(Global Text Evaluation):我们认为常用的逐块文本匹配评估,会对段落分割粒度的微小差异施加过度惩罚。为缓解这一问题,我们采用全局文本评估策略:将单页中所有文本内容(排除页眉页脚)拼接成一个字符串,再计算莱文斯坦距离。这种方式为核心文本识别能力提供了更全面、更稳健的衡量标准,且不受块分割粒度的影响。

- 更严格的内容标准化(Stricter Content Normalization):为确保不同模型输出之间的公平比较,我们实施了更严格的标准化协议,尤其针对表格数据。通过去除冗余空格、简化特定 LaTeX 格式标签,使评估更关注语义准确性,而非表面格式差异。

4.2 实现细节(Implementation Details)

在实验中,Logics - Parsing 模型基于 Qwen2.5 - VL - 7b - Instruct [3] 构建,该模型是处理各类多模态任务的强大基础模型。借助 Qwen 中提出的原生动态分辨率机制,我们在保持输入图像原始宽高比的同时,仅将总像素数限制在 1024×1024 以内,输出 token 长度限制在 8192 以内。这种设计在满足任务对高分辨率输入需求的同时,平衡了计算开销。

模型采用两阶段训练方式:在第一阶段(SFT 阶段),仅优化 Logics - Parsing 模型的 LLM(大型语言模型)组件,以构建文档解析的基础能力,而视觉编码器与视觉 - 语言投影器的参数保持冻结。训练批次大小设为 256,训练 1 个 epoch,学习率设为 2e - 5;在第二阶段(LC - RL 阶段),采用基于 ROLL [23] 实现的强化学习框架,通过 GRPO 算法进行策略优化。为实现细粒度对齐,该阶段的超参数设置更为保守:批次大小降至 32,学习率调低至 1e - 6,在精心筛选的 RL 数据集上固定训练 250 步。

为对所提方法进行严格评估,我们在 LogicsParsingBench 基准数据集上,将 Logics - Parsing 与当前最优(SFT)方法进行对比。为保持一致性,大多数评估指标与 OminiDocBench 保持一致。具体而言,我们计算所有文本组件(包括纯文本、表格数据的 HTML 序列、数学公式的 LaTeX 表达式、化学分子的简化分子输入行输入系统(SMILES)字符串)的预测输出与真实参考之间的标准化编辑距离(NED)[10]。在阅读顺序评估中,同样计算纯文本内容的 NED,且在最终阅读顺序计算中排除表格、图像及忽略组件。

4.3 主要结果(Main Results)

4.3.1 与当前最优方法的对比(Comparison with State-of-the-Art Methods)

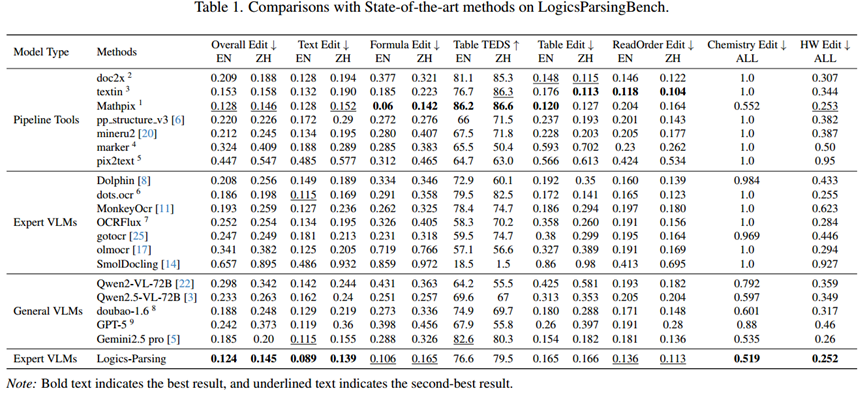

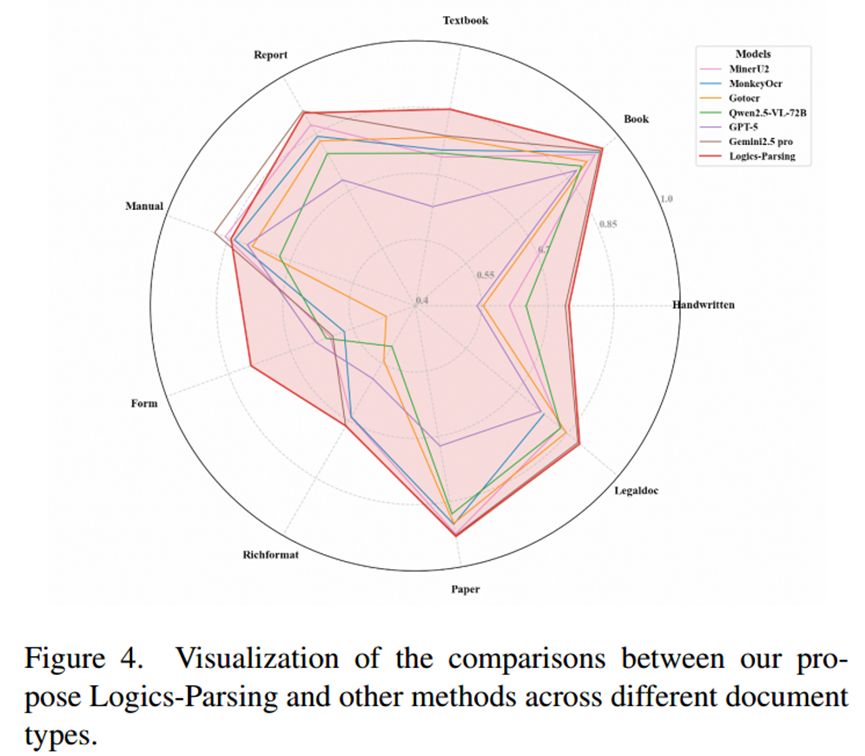

本节报告了在表 1 中,所提 Logics - Parsing 模型与各类现有文档解析模型的实验对比结果,包括当前最优的开源模型 [3,6,8,25] 以及 doc2x 2、TextIn 3 等领先商业工具。图 4 还可视化展示了不同文档类型下各方法的性能对比,更直观、全面地体现了 Logics - Parsing 模型相对于其他当前最优方法的优越性与性能平衡性。

表 1 LogicsParsingBench 上与当前最优方法的对比

图 4 Logics - Parsing 与其他方法在不同文档类型上的对比可视化

具体而言,如表 1 所示,我们将现有方法分为三类:流水线工具、专业 VLMs(视觉语言模型)和通用 VLMs,这些类别共同代表了文档解析领域的主流技术范式。我们的 Logics - Parsing 模型属于专业 VLMs 类别,旨在构建专门用于文档解析的任务特定模型。定量结果表明,Logics - Parsing 模型整体性能达到当前最优(SOTA),在英文(0.124)和中文(0.145)文档上均实现了最低的综合编辑距离。进一步的细分结果显示,在纯文本、化学结构和手写内容解析方面,Logics - Parsing 模型的性能优于所有其他方法。

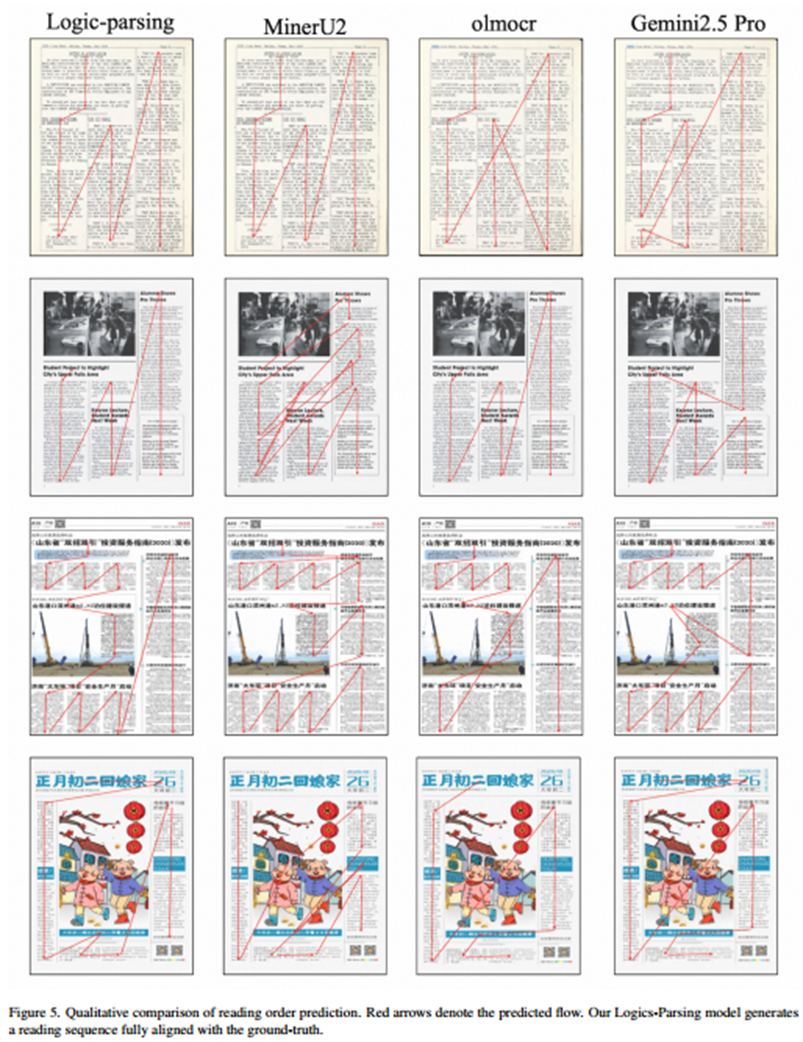

尽管在阅读顺序预测方面,Logics - Parsing 模型的性能略逊于商业工具 TextIn,但显著优于所有其他开源替代方案。图 5 展示了阅读顺序预测的部分定性对比结果。结果表明,Logics - Parsing 模型预测的阅读顺序在视觉上清晰、结构上连贯,严格遵循从左到右、从上到下的标准阅读习惯,同时准确保留了文本段落与语义区域之间的上下文关系。

此外,尽管 Logics - Parsing 模型在大多数维度上都表现出优越性能,但我们也注意到,在表格结构识别和数学公式识别方面,与顶级方法相比仍存在性能差距。这些不足指出了未来的改进方向,尤其是在复杂二维布局建模方面。

图 5 阅读顺序预测的定性对比(红色箭头表示预测流程)。Logics - Parsing 模型生成的阅读序列与真实序列完全对齐。

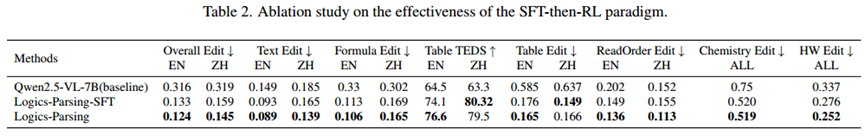

4.3.2 消融实验(Ablation Study)

为验证所提 “先 SFT 后 RL” 框架的有效性,我们开展了消融实验。明确对比了两个模型:一个是 2.3 节中定义的 Logics - Parsing - SFT 模型,另一个是融合了布局中心强化学习的最终 Logics - Parsing 模型。

实验结果如表 2 所示。我们观察到,在自建的 SFT 数据集上微调后,与原始 Qwen2.5 - VL - 7B 基线模型相比,Logics - Parsing - SFT 模型在各类内容类型的文档解析任务中均展现出卓越能力。这一性能充分验证了通过自动化与人工循环结合的方式生成的训练数据与标注的高质量。经过第二阶段(LC - RL 阶段)后,最终的 Logics - Parsing 模型在英文(EN)和中文(ZH)的几乎所有指标上,均持续优于 Logics - Parsing - SFT 模型。改进最为显著的是阅读顺序编辑距离 —— 这正是我们提出的多组件奖励机制主要优化的指标。具体而言,英文的阅读顺序得分从 0.149 降至 0.136,中文的阅读顺序得分则从 0.155 大幅降至 0.113。这一现象有力证明:在通过专门挖掘得到的小规模高难度样本上,采用所提的布局中心 GRPO 策略进行微调,能够有效增强模型处理复杂文档布局与推断准确阅读顺序的能力。

表 2 “先 SFT 后 RL” 范式有效性的消融实验

5. 结论(Conclusion)

本研究提出了 Logics - Parsing 模型 —— 一种基于端到端 LVLM 并融合布局中心强化学习的文档解析模型。通过专门设计的 “先 SFT 后 RL” 两阶段训练框架,以及针对各阶段特点精心构建的训练数据集,Logics - Parsing 模型具备了强大的文档布局显式建模能力与异构内容类型多模态识别能力。

为严格评估所提框架,我们提出了新的基准数据集 LogicsParsingBench,包含 1078 张涵盖多种类别的页面级高质量 PDF 图像。与 OminiDocBench 相比,LogicsParsingBench 包含更多样、更复杂的文档类型(如学术论文),并采用了改进的评估协议,为反映真实文档复杂性、推动文档智能研究发展提供了更公平、更具挑战性的基准。

未来,我们将重点探索适用于 SFT 训练的架构创新,并开发更具针对性、更细粒度的奖励机制,以改进基于布局中心的强化学习。这些方向有望推动文档解析模型向兼具高通用性与高专业性的方向发展,使其能够更精准、更灵活地处理各类文档理解任务。

6. 研究意义与未来方向

6.1 意义

- 提出的 “先 SFT 后 RL” 框架,为 LVLM 在文档解析领域的应用提供有效范式,平衡模型的记忆与泛化能力。

- 构建的高质量数据集和 LogicsParsingBench 基准,丰富了文档解析领域的训练与评估资源,推动该领域研究发展。

- 模型在多种复杂文档解析任务中的优异表现,为实际场景中文档结构化处理提供可靠解决方案。

6.2 未来方向

- 探索 SFT 阶段的架构创新,进一步提升模型基础文档解析能力。

- 设计更精细、针对性更强的奖励机制,优化 RL 阶段,改善表格和数学公式识别性能。

- 拓展模型适用范围,使其能处理更多稀有、复杂的文档类型,增强通用性与专业性。