RocketMQ 消息堆积:快速定位、处理与预防方案

消息堆积是 RocketMQ 运维中高频问题,若未及时处理会导致磁盘占用飙升、业务延迟,甚至引发服务雪崩。需按 “定位原因→紧急处理→长期优化” 三步解决,以下是具体方案:

一、先定位:明确堆积原因与规模

处理前需先判断堆积的 “量级” 和 “根因”,避免盲目扩容或优化。

1. 查看堆积规模(核心命令)

通过 mqadmin 命令查看消费组对目标 Topic 的消费进度,重点关注 “消费偏移量” 与 “最大偏移量” 的差值(差值即堆积数量):

# 格式:sh bin/mqadmin consumerProgress -n NameServer地址 -g 消费组名 -t Topic名

sh bin/mqadmin consumerProgress -n 127.0.0.1:9876 -g OrderConsumerGroup -t OrderTopic

输出关键信息解读:

Consume Offset:消费者当前已消费到的偏移量(已处理的最后一条消息位置)Commit Offset:消费者已确认提交的偏移量(通常与 Consume Offset 一致,不一致可能是消费后未提交)Max Offset:Broker 中该 Topic 队列的最大偏移量(已接收的最后一条消息位置)- 堆积量 = Max Offset - Consume Offset(单队列堆积量,所有队列总和为总堆积量)

2. 定位堆积根因(3 类常见原因)

根据业务场景和日志,快速排查以下核心原因:

| 堆积类型 | 典型表现 | 可能原因 |

|---|---|---|

| 消费能力不足 | 堆积量缓慢增长,Consumer 无报错,CPU / 内存使用率低 | 1. 消费线程数过少(默认线程数不足)2. 单条消息处理逻辑耗时(如同步调用第三方接口、复杂计算) |

| 消费端故障 | 堆积量快速增长,Consumer 日志有报错,或进程离线 | 1. Consumer 服务宕机、重启频繁2. 消费逻辑抛异常(如数据库连接失败、空指针),导致消息重试但无法成功3. 消费组配置错误(如订阅 Tag 不匹配,实际未消费) |

| 生产速度突增 | 短时间内堆积量暴涨,Producer 发送量远超平时 | 1. 业务峰值(如秒杀、大促)2. Producer 代码 bug(如循环发送重复消息) |

二、紧急处理:快速降低堆积量

根据根因选择对应方案,优先恢复 “消费能力”,再处理 “异常阻塞”。

1. 消费能力不足:临时提升消费并行度

适用于 “Consumer 正常运行,但处理速度跟不上生产速度” 的场景,3 个快速优化手段:

- 增加消费线程数:在 Consumer 代码中提高线程池核心数(默认

ConsumeThreadMin=20,可临时调整为 50~100,需根据服务器配置调整):java

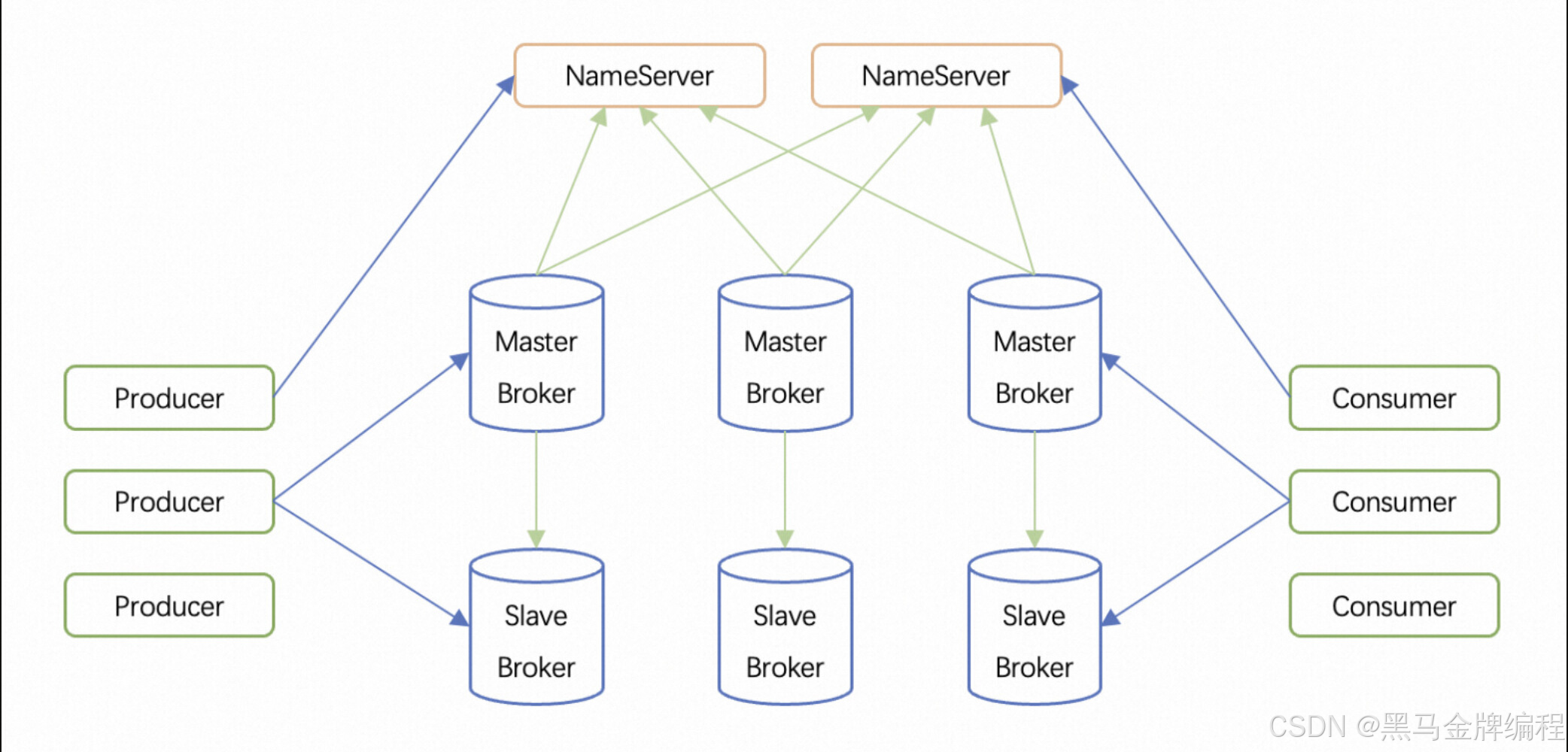

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("OrderConsumerGroup"); consumer.setConsumeThreadMin(50); // 最小消费线程数 consumer.setConsumeThreadMax(100); // 最大消费线程数 - 扩容 Consumer 实例:在集群模式下(默认),同消费组的多个 Consumer 会分摊队列消费,新增 Consumer 实例可直接分担压力(注意:Consumer 实例数 ≤ Topic 队列数,超出部分会空闲,需先确认 Topic 队列数是否足够)。

- 临时跳过非核心消息:若堆积的是非关键消息(如日志、统计数据),可临时修改消费逻辑,直接跳过消息(仅紧急场景使用,需记录跳过的偏移量,后续补处理):

java代码案例:

@Override public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs, ConsumeConcurrentlyContext context) {// 紧急场景:直接返回成功,跳过消费return ConsumeConcurrentlyStatus.CONSUME_SUCCESS; }

2. 消费端故障:修复阻塞点,恢复消费

适用于 “Consumer 报错、离线,导致消息无法处理” 的场景,按以下步骤处理:

- 恢复 Consumer 服务:若 Consumer 进程离线,先重启服务;若重启后仍报错,查看日志定位异常点(如数据库连接超时→检查数据库可用性,空指针→修复代码 bug)。

- 处理 “重试消息阻塞”:若因消息重试导致堆积(如某条消息反复消费失败,阻塞线程),先找到 “坏消息” 并跳过:

- 查看 Consumer 日志,找到反复报错的消息

msgId; - 在 Broker 端通过

mqadmin命令查询消息详情,确认是否为非法消息(如参数错误):sh bin/mqadmin queryMsgById -n 127.0.0.1:9876 -i 消息msgId - 临时修改消费逻辑,对该

msgId直接返回成功,避免阻塞其他消息:java代码案例:

@Override public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs, ConsumeConcurrentlyContext context) {for (MessageExt msg : msgs) {if ("BAD_MSG_ID".equals(msg.getMsgId())) {// 跳过坏消息return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;}}// 正常处理其他消息return processNormalMessage(msgs); }

- 查看 Consumer 日志,找到反复报错的消息

- 重置消费偏移量(谨慎使用):若因消费偏移量错误(如消费后未提交,导致重复消费堆积),可重置消费组的偏移量到 “最大偏移量”(即跳过所有堆积消息,仅业务允许时使用):

sh bin/mqadmin resetOffsetByTime -n 127.0.0.1:9876 -g OrderConsumerGroup -t OrderTopic -s latest

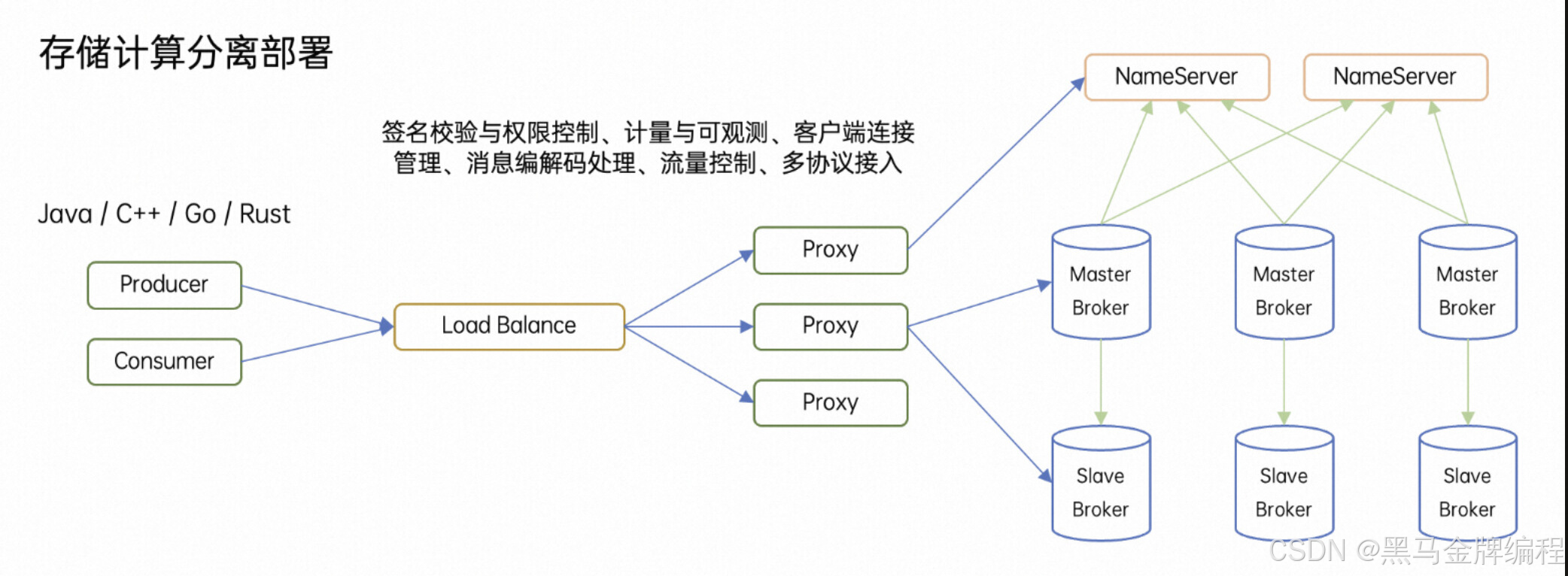

3. 生产速度突增:临时限流 + 扩容 Broker

适用于 “短时间生产过量,Broker 存储压力大” 的场景:

- Producer 端临时限流:若生产突增是业务峰值,可在 Producer 代码中添加限流(如用 Guava RateLimiter),降低发送速度:

java代码案例:

// 示例:每秒最多发送1000条消息 RateLimiter rateLimiter = RateLimiter.create(1000.0); if (rateLimiter.tryAcquire()) {producer.send(message); // 发送消息 } - 扩容 Broker 存储:若 Broker 磁盘使用率过高(如超过 80%),先清理旧日志(配置

logRetentionHours缩短日志保留时间),或新增 Broker 节点,将 Topic 队列分散到新节点,减轻存储压力。

三、长期优化:避免堆积再次发生

紧急处理后,需从 “生产、消费、Broker 配置” 三端优化,建立长效机制:

1. 消费端优化(核心)

- 线程数动态调整:根据业务峰值,预设消费线程池参数(如用配置中心动态修改

ConsumeThreadMin/Max,无需重启服务)。 - 消费逻辑异步化:将耗时操作(如调用第三方接口、写入数据库)改为异步处理(如用线程池异步执行),减少单条消息处理时间:

java代码案例:

@Override public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs, ConsumeConcurrentlyContext context) {// 异步处理消息,快速返回成功executorService.submit(() -> processNormalMessage(msgs));return ConsumeConcurrentlyStatus.CONSUME_SUCCESS; } - 死信队列监控:配置消费重试次数(如

setMaxReconsumeTimes(3)),超过次数的消息会进入 “死信队列”(Topic 格式:%DLQ%消费组名),定期监控死信队列,避免坏消息长期堆积。

2. 生产端优化

- 流量控制:在 Producer 端配置 “发送限流”(如结合业务峰值设置 QPS 上限),避免突发流量压垮 Broker。

- 消息过滤前置:Producer 发送消息时,通过

Tag或Key精准分类,Consumer 仅订阅所需消息,减少无效消费。

3. Broker 与监控优化

- Topic 队列数合理配置:队列数决定消费并行度上限(集群模式下,Consumer 实例数 ≤ 队列数),业务峰值前提前扩容队列(如将 Topic 队列数从 8 调整为 16):

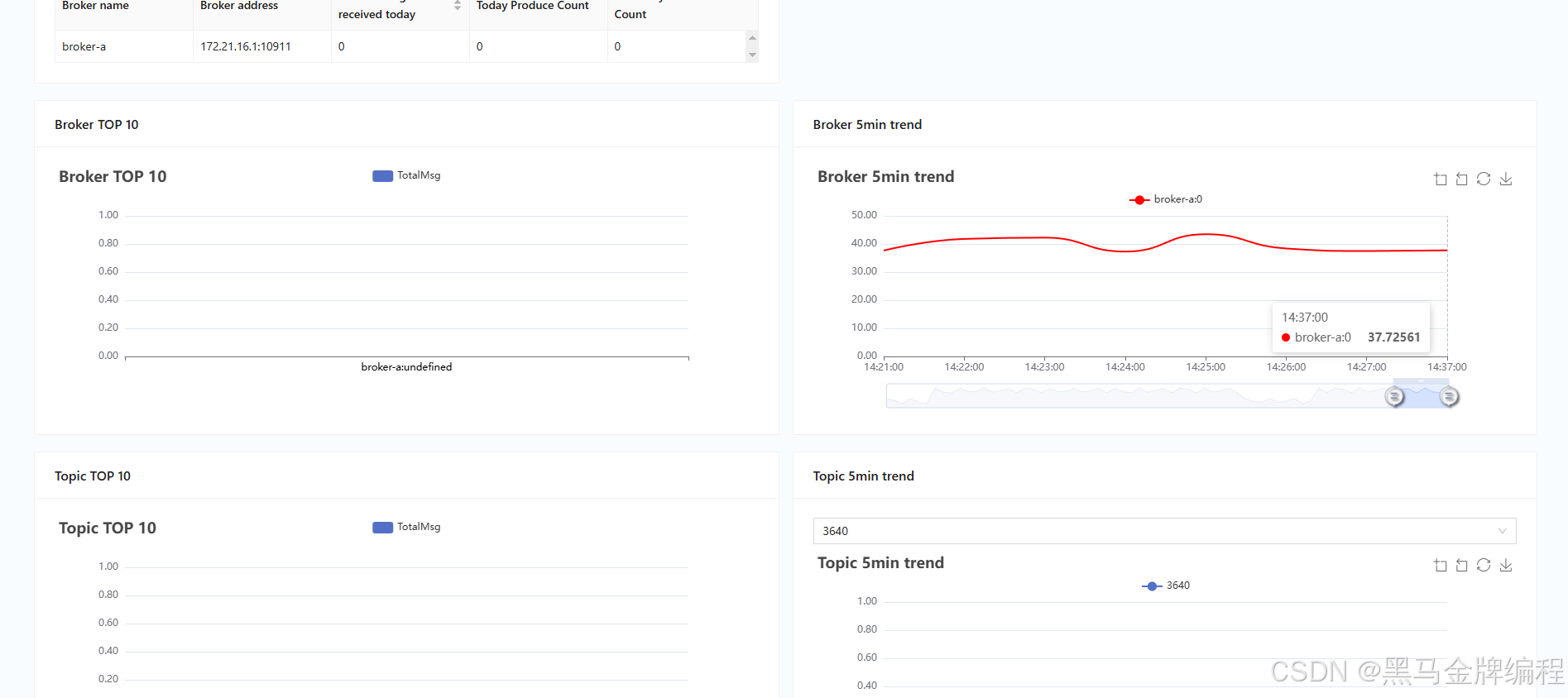

# 修改 Topic 队列数 sh bin/mqadmin updateTopic -n 127.0.0.1:9876 -t OrderTopic -c DefaultCluster -r 16 - 监控告警:通过 Prometheus + Grafana 监控以下指标,设置阈值告警(如堆积量>10000 时告警):

- 消费堆积量:

rocketmq_consumer_offset_diff(Max Offset - Consume Offset) - 消费成功率:

rocketmq_consumer_consume_success_ratio - Broker 磁盘使用率:

rocketmq_broker_disk_usage

- 消费堆积量:

总结:堆积处理核心原则

- 先止损:优先恢复消费能力(如扩容 Consumer、修复故障),避免堆积量持续增长;

- 后定位:明确根因(消费慢 / 故障 / 生产突增),针对性优化,不盲目扩容;

- 再预防:通过监控、动态配置、异步化,建立长期抗堆积能力,减少重复踩坑。

通过以上方案,可快速解决 90% 以上的 RocketMQ 消息堆积问题,同时保障业务稳定性。