【论文阅读 | ICCV 2025 | M-SpecGene:面向 RGBT 多光谱视觉的通用基础模型】

论文阅读 | ICCV 2025 | M-SpecGene:面向 RGBT 多光谱视觉的通用基础模型

- 1&&2. 摘要&&引言

- 3. RGBT550K数据集

- 4. 方法

- 4.1. 跨模态结构稀疏性(CMSS)

- 4.2. CMSS高斯混合建模

- 4.3. GMM-CMSS渐进掩码策略

- 4.4. 用于下游任务的M-SpecGene

- 5. 实验

- 5.1. 实施细节

- 5.2. RGBT多光谱目标检测

- 5.3. RGBT多光谱语义分割

- 5.4. RGBT跨模态特征匹配

- 5.5. RGBT多光谱显著目标检测

- 5.6. 消融研究

- 6. 结论

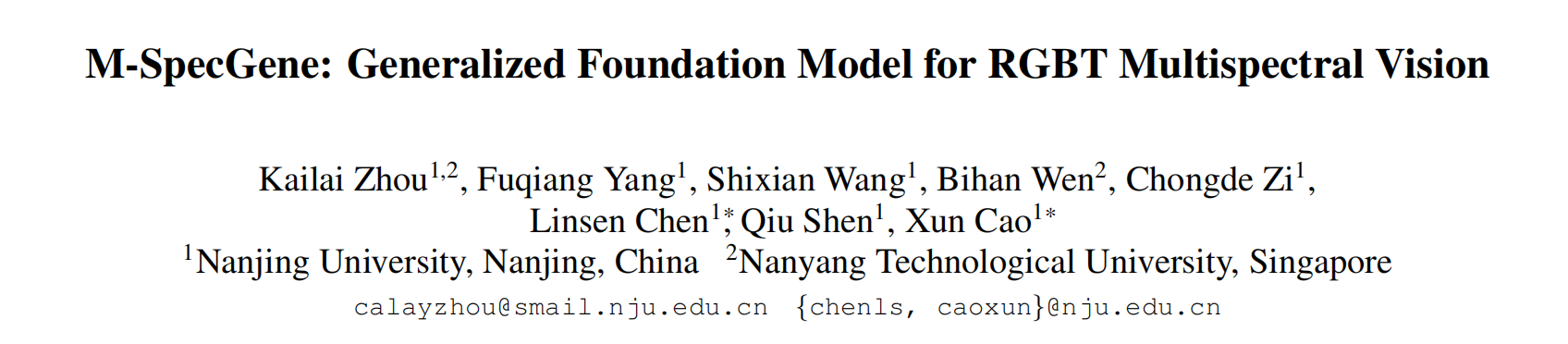

题目:M-SpecGene: Generalized Foundation Model for RGBT Multispectral Vision

期刊:ICCV(International Conference on Computer Vision)

论文:paper

代码:code

年份:2025

1&&2. 摘要&&引言

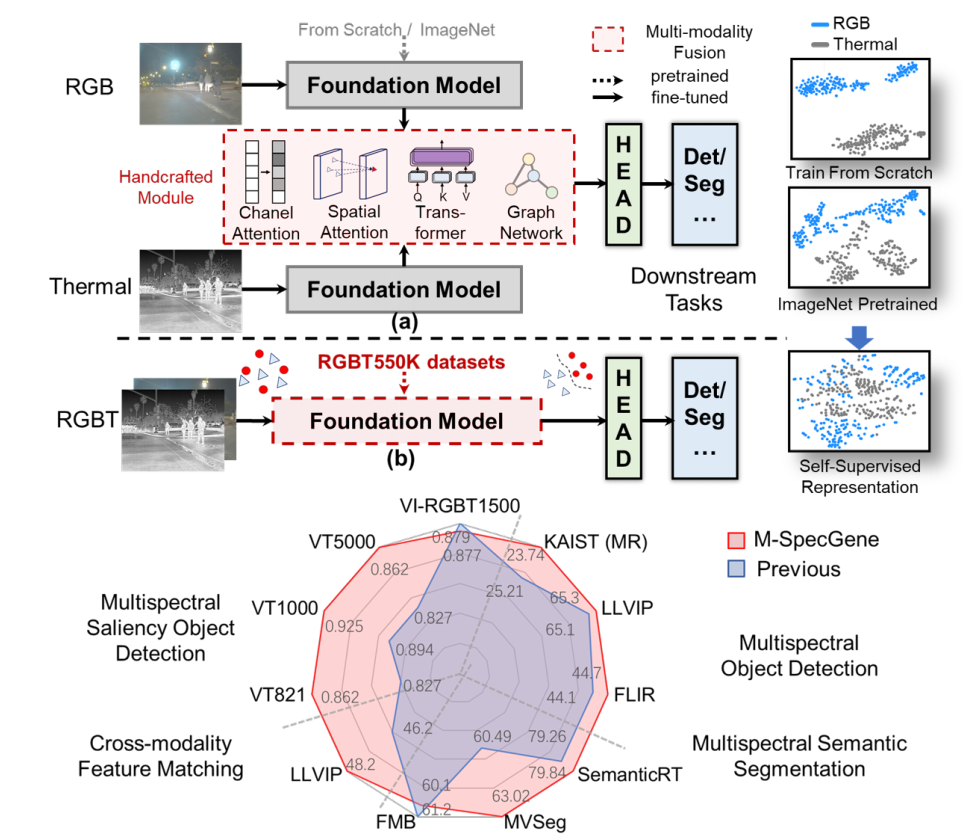

RGB - 热成像(RGBT)多光谱视觉对于复杂环境下的稳健感知至关重要。大多数 RGBT 任务遵循 “逐个案例” 的研究范式,依赖人工定制模型来学习面向任务的表征。

然而,这种范式本质上受到人工归纳偏差、模态偏差和数据瓶颈的限制。

为解决这些局限,首次尝试构建通用 RGBT 多光谱基础模型(M-SpecGene),该模型旨在通过自监督方式从大规模广泛数据中学习模态不变表征。M-SpecGene 为多光谱融合提供了新视角,并将以往 “逐个案例” 的研究整合到统一范式中。

考虑到 RGBT 数据中信息不平衡的独特特征,我们引入跨模态结构稀疏性(CMSS)度量来量化两种模态间的信息密度,进而提出 GMM-CMSS 渐进式掩码策略,以实现灵活、由易到难且以目标为中心的预训练过程。

M-SpecGene 为 RGBT 融合范式提供了新视角,其优势如下:

-

简化模型设计:单一基础模型可有效表征 RGB 和热成像两种模态,无需复杂的人工设计模块,且便于将单模态 RGB 方法适配到 RGBT 双模态任务中。

-

泛化表征能力:通过在大规模数据上进行自监督预训练,M-SpecGene 能够学习到通用表征,克服人工归纳偏差和模态偏差的局限,可适配多种下游任务。

-

提升数据利用率:M-SpecGene 可充分整合现有 RGBT 任务的自监督预训练数据,无需人工标注。

本文的贡献如下:

-

首次尝试构建多光谱基础模型 M-SpecGene,探索无需人工设计模块的新型 RGBT 融合范式。

-

精心构建高质量大规模数据集 RGBT550K,用于自监督预训练。

针对 RGBT 数据集的独特特征,提出 GMM-CMSS 渐进式掩码策略,以减轻信息不平衡的影响。 -

M-SpecGene 将以往 “逐个案例” 的研究整合到统一范式中,并在 11 个数据集、4 项 RGBT 下游任务中展现出强大的泛化能力。

图 1. (a) 手动定制模型:在逐个案例的研究范式下学习面向任务的表征。(b) 通用型 RGBT 多光谱基础模型旨在通过自监督学习来学习模态不变表征。RGB 与热成像特征的 t-SNE 可视化结果表明,M-SpecGene 模型实现了更优的跨模态对齐。

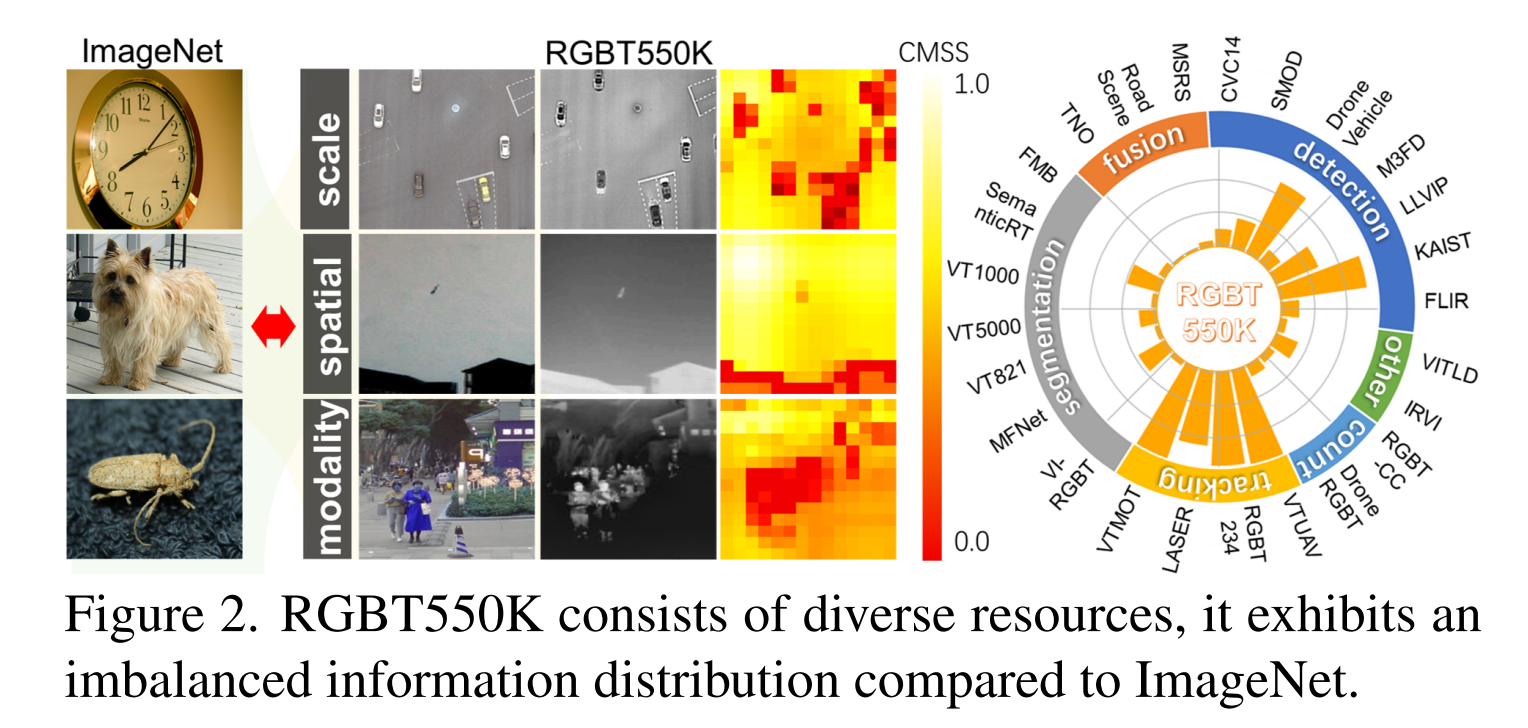

3. RGBT550K数据集

为了预训练一个具有强大泛化能力的多光谱基础模型,我们尽最大努力全面收集可用的RGBT数据集,最终从41个数据集和10个多光谱任务中收集了三百万个RGBT样本(称为RGBT3M)。尽管RGBT3M提供了大量的图像数量,但我们认为多样性和质量更为关键。RGBT3M数据集有几个局限性:1) 数据集间不平衡:RGBT检测和分割数据集[38,71]通常包含少于10,000个样本,而RGBT跟踪数据集[28]通常超过100,000个样本。2) 时间冗余:尽管跟踪数据集包含数十万个样本,但它们仅涵盖几百个独特场景,导致显著的时间冗余;3) 低图像质量:许多数据集在具有挑战性的条件下(如夜间或雨景)捕获,导致成像质量较低。

因此,我们通过以下步骤精炼RGBT3M:1) 确保数据集平衡:我们防止任何单个数据集占据过大的比例。2) 去除冗余:对RGBT视频数据集进行时间采样,以消除高度相似的帧。3) 评估图像质量:使用客观指标,我们发现SSIM[56]是衡量RGBT图像质量的有效指标。我们移除了SSIM值低于0.80的样本,因为这些图像通常缺乏足够的对象信息或质量较差。如图2所示,我们细致的预处理产生了RGBT550K,这是一个包含548,238个高质量样本的综合数据集。它涵盖了多样化的场景、任务、光照条件、分辨率和对象类别,为多光谱基础模型的自监督预训练提供了坚实的基础。更多细节可在附录中找到。

4. 方法

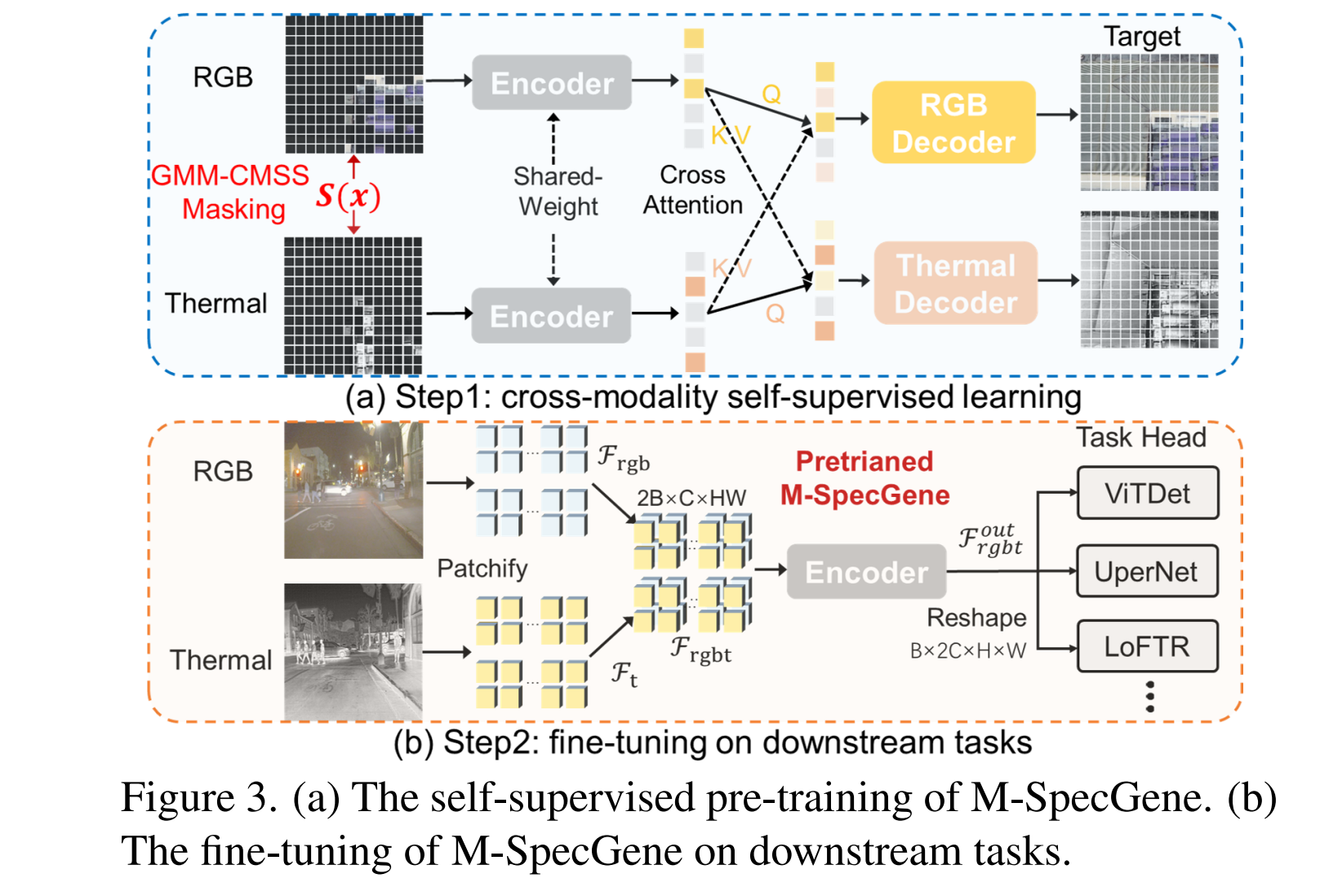

图 3.(a)M-SpecGene 的自监督预训练流程;(b)M-SpecGene 在下游任务中的微调流程。

如图3(a)所示,我们的M-SpecGene采用基于孪生(Siamese-based) 的架构,该架构基于掩码自编码器(masked autoencoders, MAE)[14] 进行跨模态自监督学习。它始于GMM-CMSS渐进掩码策略,该策略根据信息密度动态选择要掩码的图像块(patches)。互补的掩码RGB和热图像块由共享权重的ViT[10]编码器处理,然后使用交叉注意力层(cross-attention layer) 来促进潜在空间中互补信息的传播。最后,两个模态特定的、带有自注意力层的解码器独立地重建RGB和热模态的掩码像素。基于孪生的架构鼓励两种模态产生一致的表征。在自监督预训练之后,我们采用M-SpecGene ViT编码器对下游任务进行微调(fine-tuning),这将在第4.4节详细解释。

GMM-CMSS渐进掩码策略包括三个步骤:1) 鉴于RGBT数据集中信息分布不均,我们为每个RGBT图像对计算CMSS度量以量化信息密度。2) 我们采用高斯混合建模(Gaussian mixture modeling) 来估计整体CMSS分布,作为后续信息感知掩码的指导。3) 基于GMM设计一个采样函数(sampling function) 来实现渐进掩码策略。通过这些步骤,未掩码的图像块在预训练过程中逐渐从前景(高信息密度) 移动到背景(低信息密度) 区域。

4.1. 跨模态结构稀疏性(CMSS)

图2显示了RGBT数据集的一个突出特点是其显著的信息不平衡,体现在对象尺度、空间和模态信息密度的不均匀分布上。与ImageNet[7](对象通常居中并占据图像的较大部分)不同,RGBT数据集并非以对象为中心;它们往往包含更小、不那么突出的对象,且空间分布不均。此外,成像机制的差异导致模态不平衡[80],这意味着在不同条件下RGB和热模态之间的信息密度不对称。因此,MAE[14]中使用的随机掩码策略可能不成比例地关注信息稀疏区域,从而破坏有效的自监督学习。因此,我们的目标是基于跨模态信息密度的测量开发一种自适应掩码策略。具体来说,我们将RGB和热图像划分为 p×pp\times pp×p 个不重叠的图像块嵌入(patch embeddings),分别表示为 Argb={ai}i=1p×pA_{rgb}=\{a_{i}\}_{i=1}^{p\times p}Argb={ai}i=1p×p 和 Bt={bi}i=1p×pB_{t}=\{b_{i}\}_{i=1}^{p\times p}Bt={bi}i=1p×p 。这里, ai,bi∈R768a_{i}, b_{i}\in R^{768}ai,bi∈R768 是第i个图像块嵌入的特征向量。对于每个图像块嵌入对(a,b),我们定义跨模态结构稀疏性(CMSS) 如下:

m=sim(a,b)var(a)+var(b)+ϵm = \frac{\text{sim}(a, b)}{\text{var}(a) + \text{var}(b) + \epsilon}m=var(a)+var(b)+ϵsim(a,b)

其中分子表示RGB和热图像块嵌入之间的余弦相似度(cosine similarity)。分母由a和b的结构方差(structural variances) 组成。为了方便后处理,m的值被归一化到范围[0,1]。图2表明,在低信息密度区域(例如,天空),图像块嵌入对(a, b)表现出高相似性和低结构方差,导致相对较高的CMSS值。相反,在高信息密度区域(例如,行人),(a, b)表现出更大的差异,产生较低的相似性但较高的结构方差。因此,CMSS在具有丰富语义上下文的区域往往具有较低的值。因此,我们采用CMSS作为一个简单而有效的度量来评估RGBT图像块嵌入对的信息密度。

4.2. CMSS高斯混合建模

对于包含N个图像对的整个预训练数据集,其中每个图像对包含 p×pp\times pp×p 个图像块嵌入,整体CMSS分布可以表示为 m={mi}i=1N×p×pm=\left\{m_{i}\right\}_{i=1}^{N\times p\times p}m={mi}i=1N×p×p 。主要问题是基于这个整体CMSS分布m开发一种有效的掩码策略。为此,我们首先应用高斯混合模型(Gaussian Mixture Model, GMM) 通过最大似然估计(maximum likelihood) 来估计整个CMSS分布m。在用高斯混合模型估计m之后,我们根据与特定CMSS分布区间相关联的高斯模型动态调整掩码块。我们将从基础分布m中观察到的图像块嵌入 (a,b)(a, b)(a,b) 的CMSS m建模为:

p(m)=∑k=1KπkN(m∣μk,Σk)p(m) = \sum_{k=1}^{K} \pi_{k} \mathcal{N}\left(m\mid\mu_{k},\Sigma_{k}\right)p(m)=k=1∑KπkN(m∣μk,Σk)

这里, p(m)p(m)p(m) 表示要由高斯混合模型估计的CMSS概率密度函数(probability density function);K表示高斯分量的数量,默认设置为3; πk\pi_{k}πk 是第k个高斯分量 N(m∣μk,Σk)\mathcal{N}\left(m\mid\mu_{k},\Sigma_{k}\right)N(m∣μk,Σk) 的权重,该分量具有均值 μk\mu_{k}μk 和方差 Σk\Sigma_{k}Σk 。一次性计算整个预训练数据集的CMSS度量计算成本高昂。此外,可训练的线性投影参数在预训练期间不断更新。因此,我们的目标是动态更新高斯混合模型估计,与预训练过程逐 epoch(epoch-by-epoch) 同步。在每个预训练迭代中,我们计算 B×p×pB\times p\times pB×p×p 个CMSS样本,记为 miter={mi}i=1B×p×pm_{iter}=\left\{m_{i}\right\}_{i=1}^{B\times p\times p}miter={mi}i=1B×p×p ,对应于每个批次中的B个图像对。在估计步骤(E-step) 中,每个CMSS样本 mim_{i}mi 属于第k个高斯模型的后验概率(posterior probability) 估计如下:

αik=πkN(mi∣μk,Σk)∑j=1KπjN(mi∣μj,Σj)\alpha_{ik} = \frac{\pi_{k} \mathcal{N}(m_{i}\mid\mu_{k},\Sigma_{k})}{\sum_{j=1}^{K} \pi_{j} \mathcal{N}(m_{i}\mid\mu_{j},\Sigma_{j})}αik=∑j=1KπjN(mi∣μj,Σj)πkN(mi∣μk,Σk)

使用后验概率 αik\alpha_{i k}αik ,我们在最大化步骤(M-step) 中更新高斯混合模型的参数 {μk,Σk,πk}\left\{\mu_{k},\Sigma_{k},\pi_{k}\right\}{μk,Σk,πk} :

μknew=∑i=1Nαikmi∑i=1Nαik,Σknew=∑i=1Nαik(mi−μknew)(mi−μknew)T∑i=1Nαik,πknew=∑i=1NαikN\mu_k^{\text{new}} = \frac{\sum_{i=1}^{N} \alpha_{ik} m_i}{\sum_{i=1}^{N} \alpha_{ik}}, \quad \Sigma_k^{\text{new}} = \frac{\sum_{i=1}^{N} \alpha_{ik} (m_i - \mu_k^{\text{new}})(m_i - \mu_k^{\text{new}})^T}{\sum_{i=1}^{N} \alpha_{ik}}, \quad \pi_k^{\text{new}} = \frac{\sum_{i=1}^{N} \alpha_{ik}}{N}μknew=∑i=1Nαik∑i=1Nαikmi,Σknew=∑i=1Nαik∑i=1Nαik(mi−μknew)(mi−μknew)T,πknew=N∑i=1Nαik

遵循这些步骤,我们在每个预训练迭代中迭代更新高斯混合模型参数 {μk,Σk,πk}\left\{\mu_{k},\Sigma_{k},\pi_{k}\right\}{μk,Σk,πk} 以逼近CMSS概率密度函数 p(m)p(m)p(m) 。我们的观察表明,在经过有限数量的epoch后,分布 p(m)p(m)p(m) 达到稳定状态,使高斯混合模型能够为 p(m)p(m)p(m) 提供稳定且最优的拟合。

4.3. GMM-CMSS渐进掩码策略

在用高斯混合模型参数 {μk,Σk,πk}\left\{\mu_{k},\Sigma_{k},\pi_{k}\right\}{μk,Σk,πk} 近似 p(m)p(m)p(m) 之后,我们提出了GMM-CMSS渐进掩码策略,其中采样函数(sampling function) S(x)S(x)S(x) 定义如下:

S(x)=∑k=1Kπ^kN(x∣μ^k,Σ^k)S(x) = \sum_{k=1}^{K} \hat{\pi}_{k} \mathcal{N}\left(x\mid\hat{\mu}_{k},\hat{\Sigma}_{k}\right)S(x)=k=1∑Kπ^kN(x∣μ^k,Σ^k)

这里, μ^k,Σ^k\hat{\mu}_{k},\hat{\Sigma}_{k}μ^k,Σ^k 分别表示第k个高斯采样模型的均值和方差,而 μ^bias\hat{\mu}_{\text{bias}}μ^bias 表示用于模态平衡的均值采样偏差。具体来说,在每个预训练迭代中,一个包含B个图像对的批次包含 B×p×pB\times p\times pB×p×p 个图像块嵌入,采样函数 S(x)S(x)S(x) 生成 B×p×pB\times p\times pB×p×p 个采样点 s={xi}i=1B×p×ps=\{x_{i}\}_{i=1}^{B\times p\times p}s={xi}i=1B×p×p 。对于当前迭代的CMSS分布 miter={mi}i=1B×p×pm_{iter}=\{m_{i}\}_{i=1}^{B\times p\times p}miter={mi}i=1B×p×p ,我们从 miterm_{iter}miter 中采样 B×p×p×(r+rbias)B\times p\times p\times(r+r_{bias})B×p×p×(r+rbias) 个掩码块,这些块最接近生成的采样点s,其中r是掩码比率, rbiasr_{bias}rbias 是基于模态损失差异自适应调整的偏差。如图4所示,我们通过控制参数K, μ^k\hat{\mu}_{k}μ^k 和 Σ^k\hat{\Sigma}_{k}Σ^k 来实现渐进掩码策略。在预训练开始时,我们使用K=1, μ^1=0\hat{\mu}_{1}=0μ^1=0 和 Σ^1=0.01\hat{\Sigma}_{1}=0.01Σ^1=0.01 初始化采样函数S(x),确保未掩码块集中在高信息密度区域。随着预训练的进行,我们逐渐将 μ^1\hat{\mu}_{1}μ^1 从0增加到 μ1\mu_{1}μ1 ,中间方差 Σ^1\hat{\Sigma}_{1}Σ^1 通过双线性插值获得。一旦 μ^1=μ1\hat{\mu}_{1}=\mu_{1}μ^1=μ1 ,我们使用额外的高斯分量更新采样函数 S(x)S(x)S(x) ,设置 K=2,μ^2=0K=2,\hat{\mu}_{2}=0K=2,μ^2=0 和 Σ^2=0.01\hat{\Sigma}_{2}=0.01Σ^2=0.01 。我们对 μ^2,Σ^2\hat{\mu}_{2},\hat{\Sigma}_{2}μ^2,Σ^2 执行与 μ^1,Σ^1\hat{\mu}_{1},\hat{\Sigma}_{1}μ^1,Σ^1 相同的操作。在训练中期,参数配置为 K=3K=3K=3 和 {μ^k=μk,Σ^k=Σk}k=1,2,3\{\hat{\mu}_{k}\,=\,\mu_{k},\hat{\Sigma}_{k}\,=\,\Sigma_{k}\}_{k=1,2,3}{μ^k=μk,Σ^k=Σk}k=1,2,3 。在此设置下,采样函数 S(x)S(x)S(x) 紧密近似整体CMSS分布的概率密度函数 p(m)p(m)p(m) ,这可以视为随机掩码。在预训练结束时,我们逐渐将参数 {μ^k=μk}k=1,2,3\{\hat{\mu}_{k}\,=\,\mu_{k}\}_{k=1,2,3}{μ^k=μk}k=1,2,3 调整到 {μ^k=1.0}k=1,2,3\{\hat{\mu}_{k}\,=\,1.0\}_{k=1,2,3}{μ^k=1.0}k=1,2,3 ,一个接一个地进行。这种调整将未掩码块转向信息密度较低的区域。

我们的GMM-CMSS渐进掩码策略具有以下优点:1) 轻量级:预训练期间所需的额外计算成本可以忽略不计。2) 以对象为中心:高信息密度区域将在预训练的早期阶段受到更多关注。3) 渐进采样:我们提出的策略从高到低信息密度区域移动,促进了由易到难(easy-to-hard) 的自监督学习过程。

4.4. 用于下游任务的M-SpecGene

图3(b)说明了M-SpecGene在下游任务上的微调(fine-tuning)。首先,RGB和热图像被分割成特征嵌入 Frgb,Ft∈RB×C×HW\mathcal{F}_{rgb},\mathcal{F}_{t}\in R^{B\times C\times H W}Frgb,Ft∈RB×C×HW 。 FrgbF_{r g b}Frgb 和 FtF_{t}Ft 沿批次维度连接形成 Frgbt∈R2B×C×HW\mathcal{F}_{r g b t}\in R^{2 B\times C\times H W}Frgbt∈R2B×C×HW 。接下来, FrgbtF_{r g b t}Frgbt 由M-SpecGene ViT编码器并行处理,该编码器拥有表示RGB和热两种模态的能力。为了以简单的方式融合多光谱特征,M-SpecGene的输出特征 Frgbtout∈R2B×C×HW\mathcal{F}_{r g b t}^{\text{out}}\in R^{2 B\times C\times H W}Frgbtout∈R2B×C×HW 被重塑为 Frgbtout∈RB×2C×H×W\mathcal{F}_{r g b t}^{\text{out}}\in R^{B\times 2 C\times H\times W}Frgbtout∈RB×2C×H×W 。最后, FrgbtoutF_{r g b t}^{\text{out}}Frgbtout 被馈送到下游任务头中,用于检测(ViTDet[34])、分割(UperNet[59])或匹配(LoFTR[45])。这个工作流程为多光谱融合提供了新的见解,具有两个关键优势:1) 直接的融合策略利用了基础模型的能力,消除了复杂手工模块的设计;2) 基于RGB的单模态方法可以无缝适配到RGBT双模态任务,而无需额外修改。

5. 实验

5.1. 实施细节

为了最大化利用可用的单模态和对齐的RGBT数据,M-SpecGene首先在ImageNet[7]和单模态热数据集上预训练,以初始化编码器和两个解码器。随后,M-SpecGene在RGBT550K数据集上进一步预训练以促进一致的表征。RGB和热图像经过相同的预处理,包括在0.2倍到1.0倍范围内裁剪和50%概率的随机翻转。默认情况下,对RGB和热图像均应用90%的掩码比率,并使用AdamW优化器,基础学习率为 1.5×10−41.5\times 10^{-4}1.5×10−4 ,并在8个GTX 4090 GPU上使用半周期余弦衰减调度。遵循先前的研究[16, 32, 36],在自监督预训练之后,M-SpecGene在下游RGBT多光谱任务上进行全参数微调(full-parameter fine-tuning)。

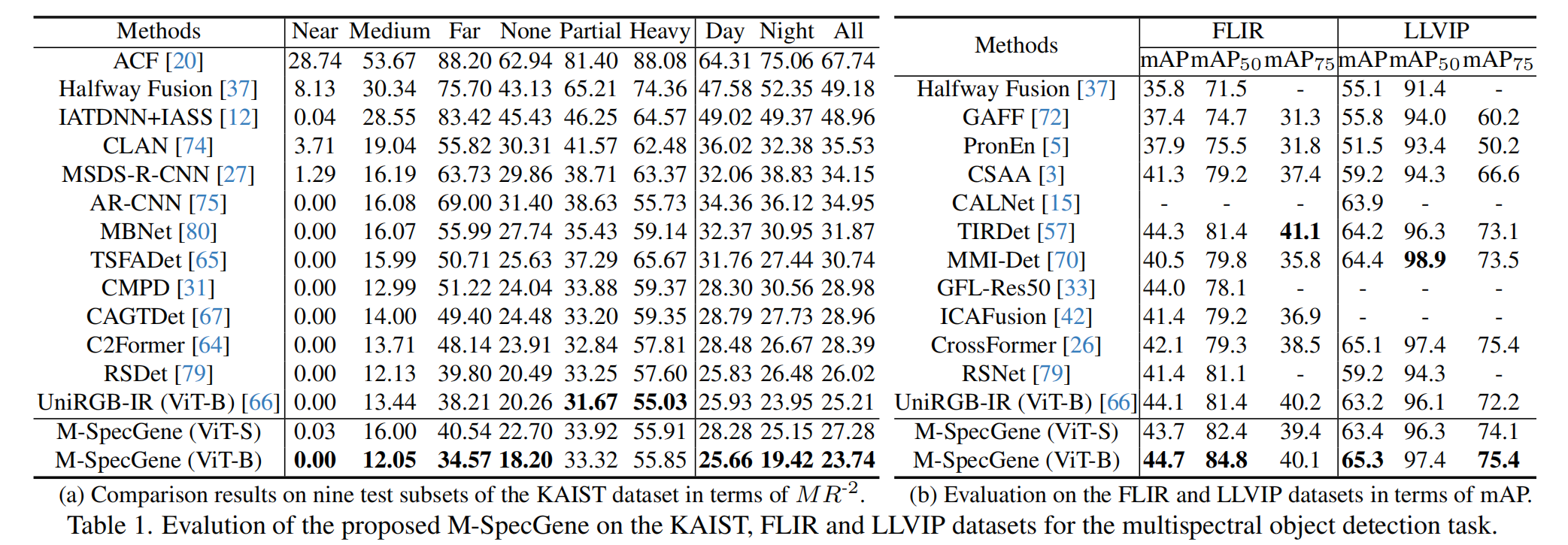

5.2. RGBT多光谱目标检测

实验设置: 我们在三个数据集上验证M-SpecGene的多光谱目标检测性能:KAIST[21]、LLVIP[24]和FLIR[71]。我们使用每图像误报数的对数平均漏检率 (MR−2)(MR^{-2})(MR−2) 评估KAIST数据集上的行人检测。对于LLVIP和FLIR数据集,我们使用平均精度均值(mean Average Precision, mAP) 进行评估。为了充分利用普通视觉Transformer(ViT)的能力,我们使用ViTDet[34]作为检测器。值得注意的是,RGB和热图像经过一致的数据增强,并且RGBT特征通过简单连接ViT编码器的输出进行融合。

结果与分析: 如表1(a)所示,我们的M-SpecGene在KAIST数据集的九项评估指标中的七项上取得了最佳性能,在“ALL”集上比先前的最佳方法UniRGB-IR[66]高出1.47%。在FLIR和LLVIP数据集上,ViT-S版本的M-SpecGene实现了与UniRGB-IR相当的性能,而ViT-B版本在表1(b)中展示了利用基础模型优势的增强能力,实现了比先前方法更高的检测精度。

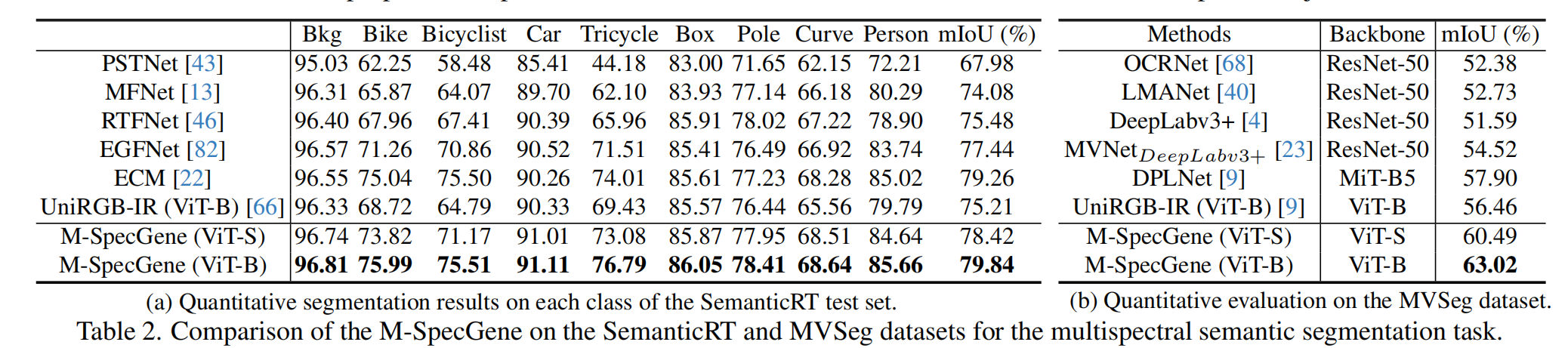

5.3. RGBT多光谱语义分割

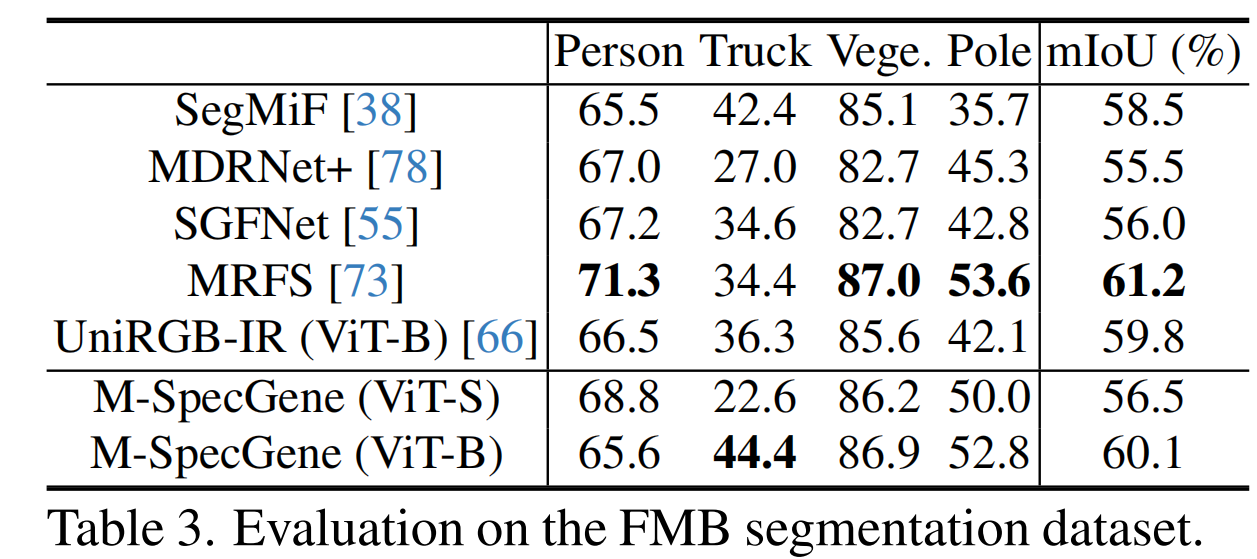

实验设置: 使用三个新近发布的、拥有高质量样本的数据集来验证多光谱语义分割任务。SemanticRT[22]、MVSeg[23] 和 FMB[38] 数据集分别包含13、26和15个类别。使用所有类别的平均交并比(mean Intersection over Union, mIoU) 来评估语义分割性能。遵循MAE[14],我们采用UperNet[59]作为基础分割框架。模型架构保持不变,仅添加了一个简单的连接操作。

结果与分析: 我们在表2(a)中的SemanticRT数据集和表2(b)中的MVSeg数据集上将M-SpecGene与竞争方法进行了比较。定量结果证实了M-SpecGene在两个数据集上的有效性。MVNet[23]作为一个利用多光谱视频片段获取额外时间信息的简单基线,而M-SpecGene仅利用帧级信息就实现了更高的mIoU精度。表3显示,在FMB数据集上,M-SpecGene优于其他竞争方法,但在某些指标上略逊于MSRS[73]。鉴于FMB是一个仅有280个验证样本的小规模数据集,基于Segformer[61]并融合了复杂模块的MSRS和UniRGB-IR,比仅采用简单连接操作进行特征融合的M-SpecGene更容易拟合FMB数据。M-SpecGene倾向于在涉及广泛类别多样性、大规模数据集和高任务复杂性的场景中实现更优的性能。

表2. (a) SemanticRT测试集上各类别的定量分割结果。(b) MVSeg数据集上的定量评估。

表3. 在FMB分割数据集上的评估。

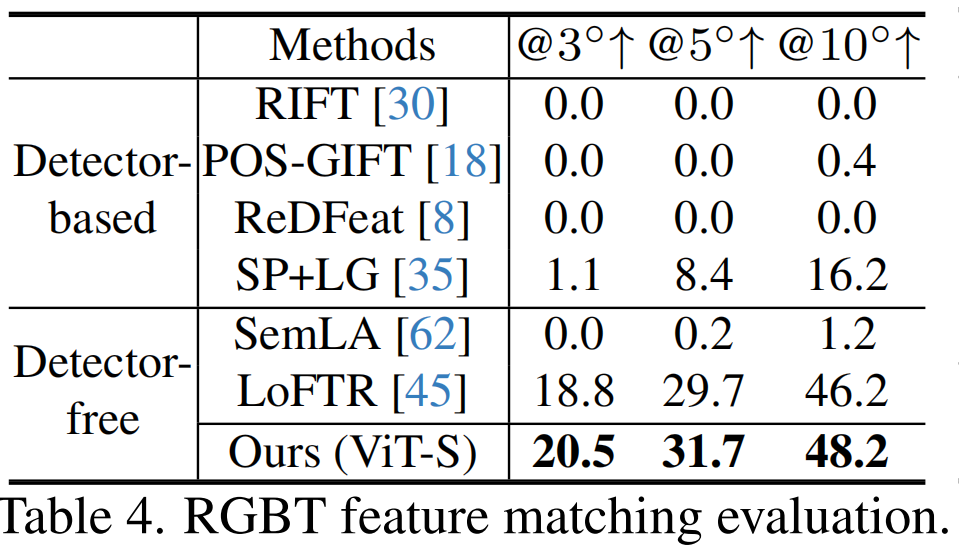

5.4. RGBT跨模态特征匹配

实验设置: 考虑到高对齐质量,使用LLVIP[24]数据集评估跨模态特征匹配。使用曲线下面积(Area Under the Curve, AUC) 指标进行评估。我们采用广泛认可的LoFTR[45]作为基本框架,其主干网络被替换为ViT-S。为了增强局部性,我们加入了一个卷积 stem[60]。

结果与分析: 表4显示,传统的手工特征描述子难以处理LLVIP数据集中的复杂场景。此外,基于检测器的方法由于难以跨两种模态提取可重复的关键点,导致结果不令人满意。我们的M-SpecGene在不同阈值下均显著优于其他方法,因为学习到的模态不变表征有助于在潜在空间中减少模态特征差异,从而促进了RGBT特征匹配。

表4. RGBT特征匹配评估。

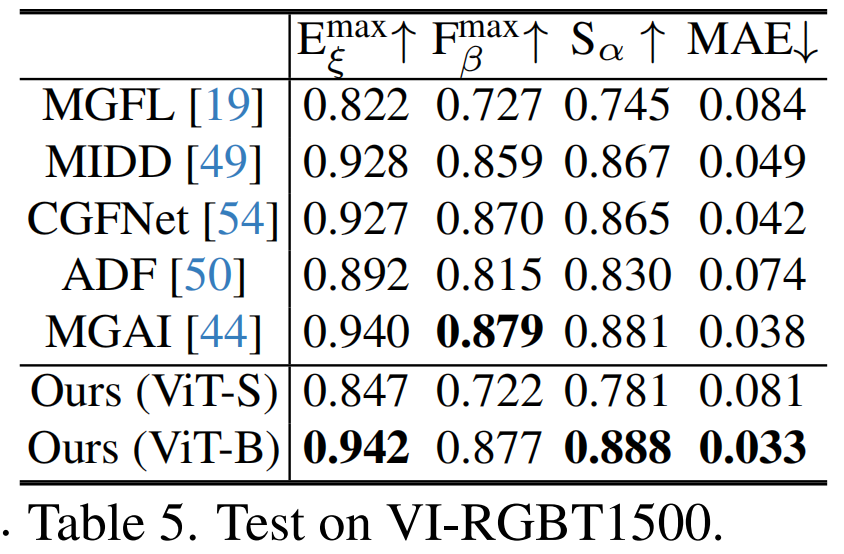

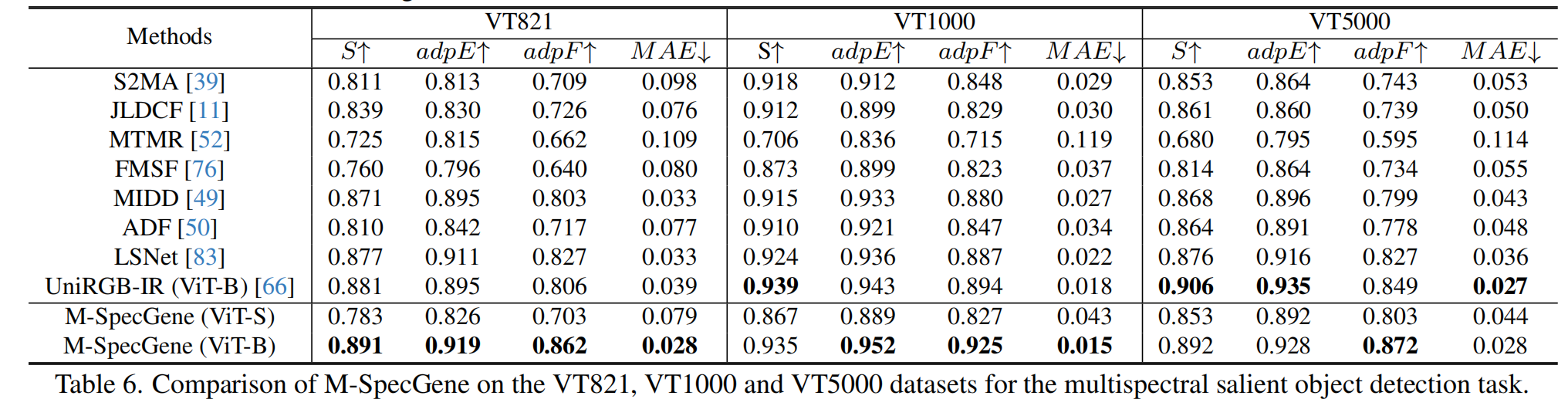

5.5. RGBT多光谱显著目标检测

实验设置: 使用VT821[52]、VT1000[47]、VT5000[50] 和 VI-RGBT1500[44] 数据集评估多光谱显著目标检测。采用F-measure (adpF, Fmax)、E-Measure (adpE, Emax)、S-Measure (S) 和平均绝对误差(Mean Absolute Error, MAE) 作为度量指标。我们采用UperNet[59]作为基本框架,并遵循常见设置,将VT5000数据集中的2,500个图像对视为训练集,其余数据集和其他数据集用作测试集。

结果与分析: 表5和表6中的实验表明,M-SpecGene在十一个子集指标上取得了比先前方法更好的结果,在VT821、VT1000和VI-RGBT1500数据集上(而非VT5000数据集)的改进尤其显著。这凸显了其卓越的泛化能力。

表5. 在VI-RGBT1500上的测试结果。

表6. M-SpecGene在VT821, VT1000 和 VT5000 数据集上用于多光谱显著目标检测的对比结果。

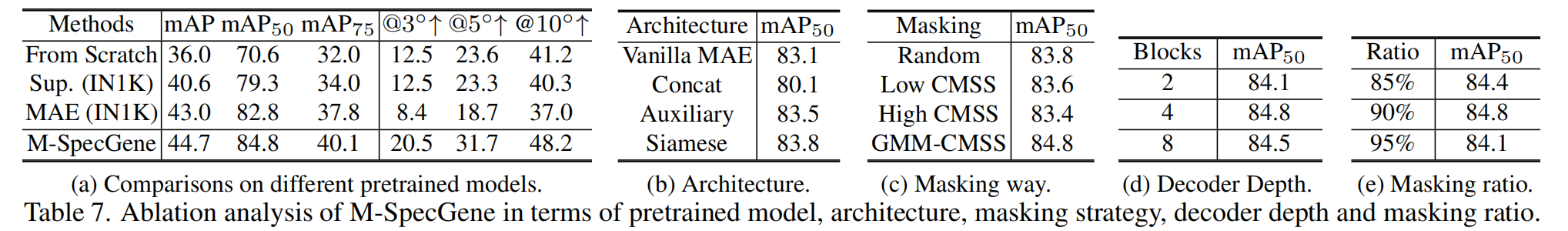

5.6. 消融研究

预训练模型比较: 在表7(a)中,我们比较了不同预训练模型在使用KAIST数据集进行多光谱目标检测和使用LLVIP数据集进行跨模态特征匹配方面的性能。我们观察到,从头开始训练的ViT在FLIR上的mAP表现很差。而普通MAE预训练的ViT与有监督(Sup.)预训练的ViT相比,将mAP50从40.6%提高到43.0%。M-SpecGene表现出更优的性能,进一步将mAP50提高到44.8%。在LLVIP数据集上,M-SpecGene将AUC@10px从41.2显著提升至48.2,而有监督和普通MAE预训练的ViT模型都导致匹配精度下降。我们将这种差异归因于检测和匹配任务之间的固有差异。检测任务旨在利用两种模态生成互补特征,而匹配任务侧重于识别两种模态共享的共同特征。因此,在单模态ImageNet数据集上预训练可能会破坏跨模态特征匹配所需的对称表征。总体而言,有效的模态不变表征预训练对于通用多光谱基础模型至关重要。

RGBT表征架构: 为了研究对RGB和热模态都有效的自监督表征架构,我们设计了四种方法:1) 普通MAE[14]:RGB和热图像在输入级别混合,采用普通MAE。2) 通道连接:RGB和热图像沿通道维度连接。3) 辅助分支:互补的掩码RGB和热块由共享权重的编码器处理,然后热特征在交叉注意力层中作为辅助信息,帮助RGB解码器重建掩码区域。4) 基于孪生(Siamese-based):鼓励RGB和热模态使用共享权重的编码器学习一致表征,并对每种模态应用独立解码器。表7(b)显示,基于孪生的架构取得了最佳结果,它保留了对称性并充分利用了跨模态互补性。

掩码策略: 我们在表7©中比较了四种不同的掩码策略:1) 随机掩码。2) 在低CMSS区域进行高斯掩码。3) 在高CMSS区域进行高斯掩码。4) GMM-CMSS渐进掩码。实验结果表明,仅关注单一信息密度区域会导致性能下降。相比之下,GMM-CMSS渐进掩码实现了灵活、由易到难且以对象为中心的学习过程,从而产生了更鲁棒的表征。

解码器深度: 表7(d)显示,解码器深度为4时取得了最佳结果,表明在具有两个独立解码器的孪生架构下,MAE[14]的默认解码器深度可以减小。

掩码比率: 表7(e)说明,较低的掩码比率(尤其降低了热模态的重建难度)会导致mAP略微下降。较高的掩码比率会对GMM-CMSS策略的有效性产生负面影响。因此,我们将默认掩码比率设置为90%。

表7. 关于预训练模型、架构、掩码策略、解码器深度和掩码比率的M-SpecGene消融分析。

(注:此处应嵌入文档中对应的表格图片)

特征可视化和统计分析: 我们首先连接由预训练模型提取的RGB和热特征,并对连接后的对象和背景特征进行可视化分析。如图5(b-c)所示,与有监督(IN1K)预训练模型相比,M-SpecGene提取的对象特征表现出更强的可区分性。随后,我们对三个检测数据集上对象和背景特征之间的差异进行了统计分析。具体来说,我们计算每个样本的对象和背景特征之间的Wasserstein距离,并展示了不同预训练模型的统计Wasserstein距离分布。图5(d-f)显示,从头训练的模型显示出较小的整体Wasserstein距离,而MAE(IN1K)和Sup.(IN1K)的分布显示出较大的Wasserstein距离。值得注意的是,我们的M-SpecGene实现了最大的Wasserstein距离分布,表明对象和背景之间的特征差异更显著。这表明GMM-CMSS渐进掩码策略有助于学习更以对象为中心的表征,从而促进生成更具区分性的特征。

6. 结论

我们首次尝试构建了一个多光谱基础模型,旨在将先前的按案例研究转变为统一范式。为了减轻RGBT数据集固有的信息不平衡的影响,我们引入了CMSS度量来衡量跨模态信息密度,并开发了GMM-CMSS渐进掩码策略,以实现灵活、由易到难且以对象为中心的预训练过程。所提出的M-SpecGene有效地在潜在空间中表示了RGB和热两种模态,无需手工模块,并为多光谱融合提供了新的见解。在四个任务的十一个数据集上进行的大量实验验证了M-SpecGene的泛化能力,它能够充分利用精心构建的高质量RGBT550K数据集进行自监督预训练,并可无缝适配RGB单模态方法到RGBT双模态任务,而无需额外修改。我们希望这项工作将从通用基础模型的角度推动多光谱视觉的应用。