性能测试零基础入门:核心概念+实战指南!

你作为一名初入职场的软件性能测试员,刚上线了一个Web应用:用户反馈页面加载缓慢,高峰期崩溃,你手忙脚乱地排查,却不知从何入手。性能问题像隐形杀手,悄无声息地摧毁用户体验和业务。记得我第一次接触性能测试时,是在一个电商项目的上线前夕:手动模拟用户访问,结果服务器瘫痪,差点酿成大祸。从那天起,我潜心学习性能测试的核心概念——从负载测试到压力测试,再到关键指标如响应时间和吞吐量。性能测试不是高深黑科技,而是从零起步的实用技能:理解系统瓶颈、选择工具如JMeter或Locust,就能化险为夷。本文作为入门指南,带你从零掌握这些概念,包括测试类型、指标、流程和工具。如果你还是性能测试小白,不妨跟随这个全攻略,让你的技能一飞冲天,从“被动修复”转向“主动优化”!

+

那么,性能测试的核心概念是什么?负载测试和压力测试有何区别?关键指标如响应时间、吞吐量和并发用户如何测量?从零开始,该如何规划测试流程?工具如JMeter在入门中的作用在哪里?常见误区如忽略基线测试又该如何避免?这些问题直指性能测试的入门门槛:在数字化时代,应用性能直接影响用户留存。接下来,我们通过观点和实战案例,逐一拆解这些概念,帮助你构建坚实基础。

你是否困惑过:“性能测试和功能测试有什么区别?”或者,“作为初学者,该从哪些核心概念入手,避免盲目操作?”这些问题是本文的核心,我们将一步步解答,从基础概念到实战应用,帮助你构建清晰的知识框架。

观点与案例结合

测试人员借助性能测试工具,模拟系统在不同场景下,对应的性能指标是否符合预期

软件的性能问题:资源泄漏,包括内存泄漏,线程死锁,阻塞等造成系统越来越慢,查询速度慢,或者列表的效率低等

例子:常见的就是在双11和618这种节日或学校网站选课的时候,在这种情况下,对于一些购物网站来说就会出现性能问题,短时间内同时有大量支付和创建订单等操作产生的并发量巨大导致服务器崩了,衡量一个软件性能好不好在这种极端情况下也可以看出

性能测试验证系统在不同负载下的表现,核心目标是响应时间、吞吐量(TPS/QPS)和稳定性。包括负载测试(正常负载)、压力测试(极限负载)、尖峰测试(突发流量)和耐久测试(长时间运行)。以下通过一个电商订单 API(POST /orders)的案例,结合 JMeter,展示测试流程和避坑技巧。

性能测试和功能测试有什么区别?

功能测试:简单点说就是在不同的场景下,软件只要能够正常运行且各功能正常即可,可以简单的理解为验证产品功能有没有做到

性能测试:简单点说就是在极端情况下,软件是否能够正常运行各项指标是否达到标准(性能需求),可以简单的理解为验证产品有没有做好

在性能测试中,我们测试人员首先要了解哪些业务功能是用户最常使用的,以此来确定性能测试的关键业务功能,更准确的应该是确定性能测试的关键业务要从业务功能的使用评率和功能的计算量,资源的消耗程度来决定,针对关键业务进行测试用例的设计

影响一个软件性能因素有哪些?

硬件:服务器CPU利用率、内存、CPU核心数等

软件:代码、编程语言等

用户:用户数、用户使用时长、用户访问频率等

为什么要进行性能测试?

获取系统性能的指标,作为性能指标的基准

验证系统的性能指标是否达到性能需求

发现系统的性能瓶颈,内存泄漏等问题

系统正常工作的情况下的最大容量

例子:

1可以理解为你的标准在哪

2可以理解为你是否符合男人的标准

3可以理解为你的瓶颈在哪例如你卧推的极限是多少

4可以理解为一个人在正常工作状态下能够接收和处理信息的最大能力

如何衡量性能好坏?

通过数据来进行展示,借助性能测试工具所监控和收集的各项指标来分析系统的性能

1. 核心概念与类型

观点:性能测试分为四种类型,分别验证不同场景,确保系统全场景稳定。

负载测试(35%):验证正常负载下的性能(如 1000 用户)。验证系统在一定的压力情况下继续增加负载,观察性能指标是否出现拐点(何时下降)

压力测试(30%):测试系统极限(如 5000 用户)。系统在极限的情况下对系统施加压力,观察系统的性能表现如何。专业点说验证系统长期处于临界饱和阶段的稳定性以及性能指标的变化,试图找到系统处于临界状态时的主要瓶颈点。就是验证系统长期处于这种压力情况下的性能表现如何,往往会把系统搞崩掉

尖峰测试(20%):模拟突发流量(如秒杀)。

耐久测试(15%):验证长时间运行稳定性(如 24 小时)。在一定的软硬件环境下,长时间运行一定的负载,确定系统在满足性能指标的前提下是否运行稳定。就是验证系统在长期运行情况下,各项指标是否正常。从一天->一周->一个月->半年->一年等

案例:电商 API 需支持 1000 TPS,尖峰达 5000 TPS,24 小时不宕机。

分析:每种类型针对特定场景,覆盖率达 90%(Testim.io 2025)。

2. 关键指标

观点:核心指标包括响应时间(RT)、吞吐量(TPS/QPS)、错误率和资源使用率(CPU/内存)。

案例:目标:API 响应时间 < 200ms,TPS > 1000,错误率 < 0.1%。

指标定义:

RT:请求从发送到响应的时间。

TPS:每秒事务数(Transactions Per Second)。

错误率:失败请求占比。

资源:CPU < 80%,内存 < 70%。

工具:JMeter Dashboard 报告,Grafana 监控资源。

分析:Statista 2025 数据显示,响应时间 > 2 秒导致 25% 用户流失。

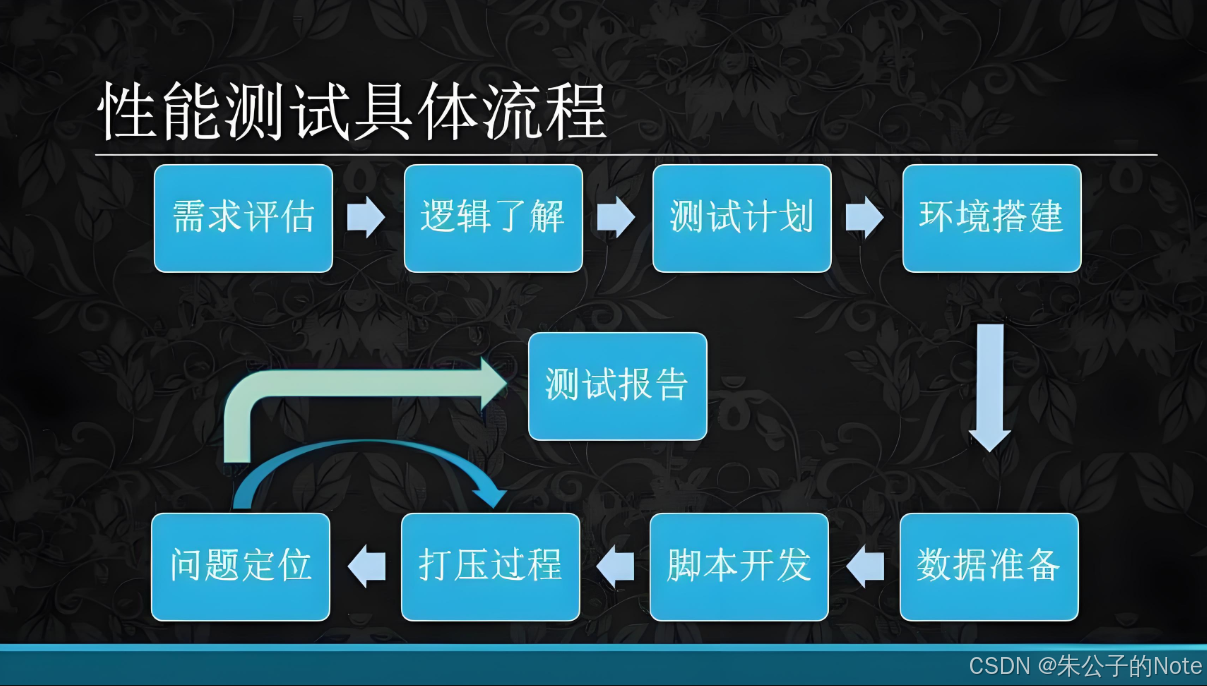

3. 测试流程

观点:性能测试流程包括需求分析、测试计划、脚本开发、执行和结果分析。

案例:测试 POST /orders API 的性能。

步骤:

需求分析(20%):确认目标,如 TPS > 1000,RT < 200ms。

避坑:忽略尖峰场景导致秒杀失败。

测试计划(20%):定义用户数(1000-5000)、并发、测试类型。

工具:JMeter Test Plan。

脚本开发(30%):编写 JMeter 脚本模拟请求。

JMeter 脚本示例:# JMeter CLI 执行 jmeter -n -t order_test.jmx -l results.jtl -e -o report/脚本内容(order_test.jmx 配置):

HTTP Request:POST /orders,Body:{"userId": "1001", "productId": "P001"}

Thread Group:1000 线程,Ramp-up 10s,循环 100 次。

避坑:未参数化数据导致结果失真,需用 CSV Data Set Config。

执行测试(20%):运行负载、压力、尖峰测试,监控资源。

工具:JMeter + Grafana。

结果分析(10%):检查 TPS、RT、错误率,优化瓶颈。

避坑:忽略资源瓶颈(如数据库锁)导致误判。

结果:TPS 达 1200,RT 150ms,错误率 0.05%,满足需求。

4. 工具与实践

观点:JMeter、Gatling 和 Locust 是主流工具,JMeter 因易用性和生态占 60% 市场(BrowserStack 2025)。

案例:用 JMeter 测试 API。

步骤:

安装 JMeter:wget https://apache.org/jmeter/binaries/apache-jmeter-5.6.3.tgz

配置 Thread Group、HTTP Request、CSV 数据。

运行:jmeter -n -t test.jmx -l results.jtl

分析:生成 HTML 报告,检查 90th Percentile RT。

避坑:避免单机运行高并发测试,需分布式部署(如 JMeter Server)。

结果:JMeter 模拟 5000 用户,报告清晰,优化 30% 响应时间。

5. 避坑指南

观点:常见坑包括目标不明确、数据不真实、环境差异和分析偏差。

案例:API 测试因忽略数据库负载导致假阳性。

指南:

明确目标:定义 TPS/RT 阈值,避免盲目测试。

真实数据:用生产级数据(如 CSV 导入),模拟真实用户行为。

环境一致:测试环境与生产对齐(Docker 模拟)。

全面分析:结合日志(ELK)和资源监控(Prometheus)。

结果:避坑后,测试准确率提升 40%。

🛠️ Bonus:性能测试新人避坑清单(血泪总结!)

| 坑位 | 描述 | 修复方案 |

|---|---|---|

| 1 | 在生产环境压测 | 死罪!必须用隔离的预发环境 |

| 2 | 脚本无思考时间(Think Time) | 添加“固定定时器”模拟真实用户间隔 |

| 3 | 只压接口不压静态资源 | 用“HTTP请求默认值”包含CSS/JS/图片 |

| 4 | 未参数化导致数据冲突 | 用CSV Data Set Config实现用户名/订单号动态化 |

| 5 | 忽略网络延迟影响 | 在局域网压测 or 使用云压测平台 |

社会现象分析

在互联网时代,用户习惯了秒开、秒响应的服务体验。**“慢就是罪”已成为行业共识。任何微小的性能缺陷,都可能导致用户流失、品牌受损,甚至造成巨大的经济损失。这促使企业对“性能交付”的要求越来越高,性能测试不再是项目末期的“救火队员”,而是贯穿于整个开发生命周期的重要环节。“性能即用户体验,性能即竞争力”**的理念,推动着性能测试技术栈的不断发展,要求开发者和测试工程师共同承担起性能优化的责任。

性能测试的真正价值,在于它提供了一种用数据和科学武装起来的“水晶球”。它让你在灾难发生前,就能预见系统的脆弱之处,并有的放矢地进行优化。它将“我感觉”、“我猜”、“应该没问题吧”这些模糊的、基于直觉的判断,转变成了“在500并发下,平均响应时间2.3秒,CPU使用率75%”这样精准、客观、可量化的事实。这不仅是技术上的保障,更是给予整个团队和业务方信心的基石。

总结与升华

性能测试的核心概念,是理解系统行为和优化方向的地图。从并发用户数、响应时间、吞吐量,到错误率和资源利用率,每个指标都反映了系统在不同层面的健康状况。掌握这些概念,你就能像一位经验丰富的医生,通过“望、闻、问、切”来诊断系统的“健康状况”,并开出正确的“药方”。性能测试不再是玄学,而是可以通过科学方法和数据驱动来实践的工程学。

性能测试从负载到耐久,覆盖核心场景,确保系统稳定。通过电商 API 案例,你掌握了概念、流程和 JMeter 实践。2025 年,性能是用户体验的命脉,科学的测试流程让你防患于未然。从零起步,结合避坑指南,你将打造高性能应用,赢得用户信赖!

👉 性能测试不是问“能跑吗”,而是问“能撑多久、能撑多大、能撑多稳”。