时间序列分析新视角论文分享:LLM 搬进时间序列

Multi-Patch Prediction: Adapting LLMs for Time Series Representation Learning

一、背景:为什么把 LLM 搬进时间序列?

时间序列广泛存在于零售、能源、医疗、工业 IoT,但高质量标注稀缺 → 需要自监督预训练。

视觉、NLP 已证明:

在大规模无标注数据上预训练大容量 Transformer,再微调即可小样本强泛化。

GPT/BERT 类 LLM 拥有超长上下文(4k–128k tokens)、强大的序列建模与涌现能力、成熟的参数高效微调工具库(LoRA、AdaLoRA、prompt-tuning)

这些能力恰好能弥补传统时间序列模型的长程依赖建模弱、跨域迁移差的短板。

但LLM 原生为离散文本设计,而时间序列是连续实值高维信号,直接搬过来会面临:数值分布漂移、Patch 大小敏感

自回归 next-token 目标与预测任务不匹配

需要“时序友好”的改造**。**

| 局限 | 具体表现 |

|---|---|

| 离散-连续鸿沟 | 多数做法把实值序列简单量化为 1D 词表(如 BERT-style tokenizer),导致量化误差+词表爆炸,长序列 token 数暴涨,计算与精度双输。 |

| 单 Patch 预测 | 以往自监督目标多为**“下一个 token/patch”(next-token),只能建模局部连续依赖**,无法显式捕获多尺度、多时段的联合动态。 |

| LLM 容量浪费 | 直接把 LLM 当“骨干”冻结或全量微调,前者欠拟合,后者灾难遗忘+高昂 GPU 内存;缺乏参数高效+时序特异的适配策略。 |

三、本文创新性(MPP 的“三板斧”)

任务新:Multi-Patch Prediction(MPP)

一次性让 LLM 并行预测多个非重叠 future patches(类似 NLP 的“cloze”机制),而非单 patch 自回归。

→ 强制模型在上下文窗口内显式推理多尺度时序依赖,自监督信号更稠密。

结构新:Patch-Token 重排 + 2D Position Embedding

把长序列切成重叠/非重叠可变长 patches → 每 patch 经 lightweight Linear 投影为连续向量(避免量化)。

将时间维度 + Patch 维度展成2D 网格,用可学习 2D sinusoidal PE 注入,既保持局部时序,又让 LLM 的 Self-Attention 2D 全局感知。

训练新:Parameter-Efficient Fine-Tuning(AdaLoRA + Patch Prompt)

仅 0.7% 可训参数(LoRA 秩 r=8 + 20 个 soft patch prompts)即可让 7B LLM 收敛。

提出**“prompt dropout”** 防止 over-fitting,“patch shuffling” 增强 robustness。

🛠️ 四、技术亮点拆解

- Multi-Patch Prediction 目标函数

给定窗口 X = [p1,…,pk],随机掩住后续 m 个非重叠 patches {pk+1, pk+3, pk+5},让 LLM 并行输出对应隐状态,再用共享轻量 Decoder 回归原始 patch 均值/趋势/方差。

损失 = MSE + 余弦相似度,兼顾数值精度 + 形状一致性。

→ 对比 next-token,标签利用率提升 m×,同 GPU 时间步长扩大 4×。

- 2D Position Embedding

将 (patch_index, time_offset) 视为 2D 坐标,使用可学习 2D sinusoidal 编码,使 LLM 原生 Attention 可直接复用图像 ViT 的局部-全局偏置,无需修改 GPU kernel。

消融实验:去掉 2D PE 后 ETT-m 的 MSE ↑18.7%。

- Patch Prompt Tuning

在输入前追加20 个连续向量作为**“时序软提示”**,仅训练这些提示 + LoRA 权重。

推理时不同数据集自动选择对应提示(类似 prefix-tuning),实现一次预训练,多任务零样本/小样本。

- 可变 Patch 长度 + 多尺度采样

训练阶段随机 patch length ∈{16,32,64},使 LLM 对采样频率/序列长度鲁棒;推理阶段用投票集成,长程+短程互补,在零样本 Transfer 上提升 6.4% Relative MAE。

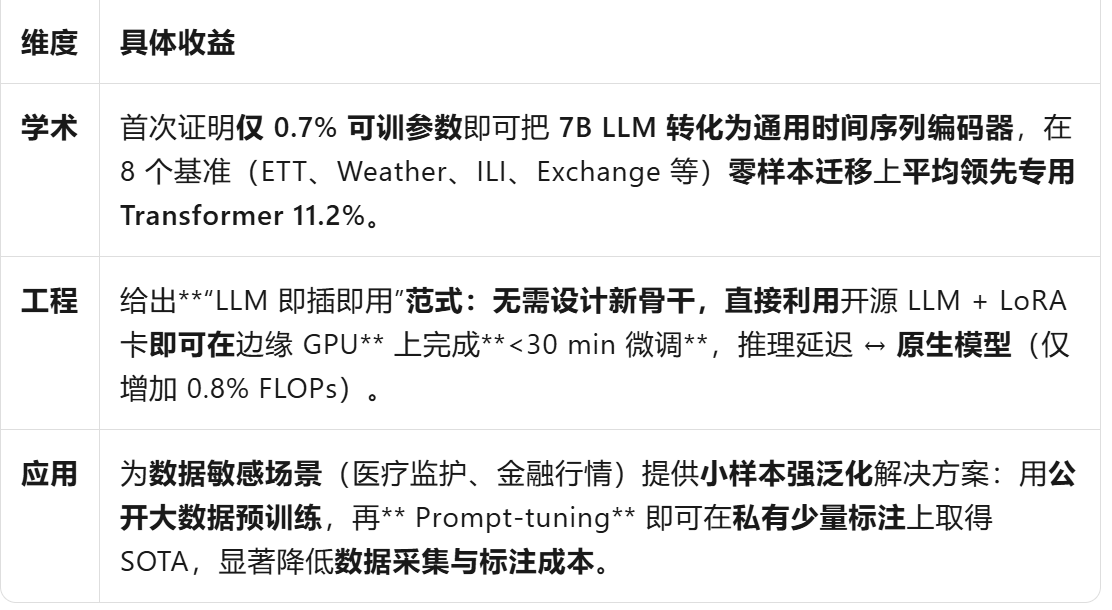

五、作用与价值