WorldSimBench: 迈向作为世界模拟器的视频生成模型——论文解读

WorldSimBench: 迈向作为世界模拟器的视频生成模型

Qin Y, Shi Z, Yu J, et al. Worldsimbench: Towards video generation models as world simulators[J]. arXiv preprint arXiv:2410.18072, 2024.

1. 引言与研究背景

在采取行动之前,人类会基于目标和对当前环境的观察进行预测。这些预测以各种形式呈现——文本规划、对未来场景变化的视觉想象,或者甚至是动作层面的潜意识规划。随着生成模型的发展,由这些模型驱动的智能体正在展现出使它们能够通过类人预测完成具身任务的预测能力。

近期预测模型的进展展示了其在预测物体和场景未来状态方面的卓越能力。然而,缺乏基于内在特征的分类继续阻碍着预测模型发展的进程。现有基准测试评估通常专注于通过评估文本输出的任务规划能力,或从美学角度评估视觉输出。然而,这些方法显著限制了对高度具身化预测模型的评估,因为具身场景更关注物理属性(例如透视一致性、物体可破坏性),而这些方法未能有效评估这些属性。

2. 预测模型的层次分类体系

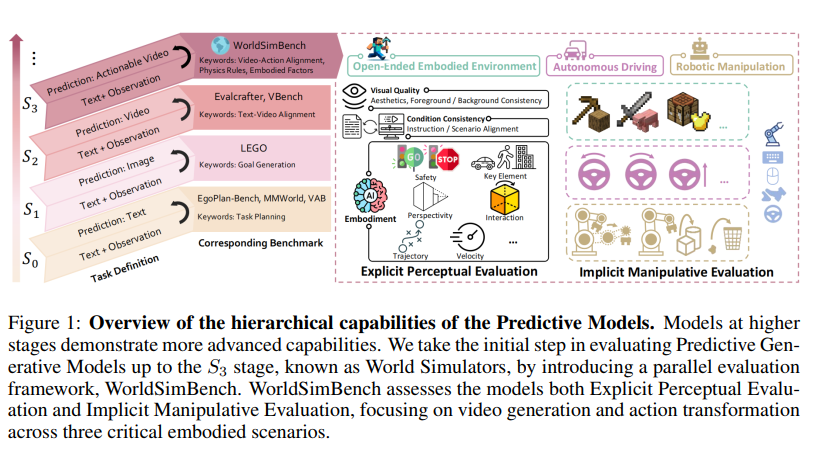

本研究建立了一个合理的预测模型层次体系,基于其具身化程度。从较低到较高阶段,模型能够生成:文本、图像、视频和可操作视频(即可以转换为动作的视频)。值得注意的是,S3阶段能够生成可操作视频的预测模型整合了强大的3D场景理解和物理规则先验,为生成可执行动作提供精确指导。

2.1 层次定义

图1描述:该图展示了预测模型的层次能力结构。左侧显示了从S0到S3的四个阶段,每个阶段对应不同的输出模态和评估基准。中间部分展示了WorldSimBench的双重评估框架,包括显式感知评估和隐式操作评估。右侧展示了三个关键的具身场景:开放式具身环境(显示Minecraft场景)、自动驾驶(显示道路场景)和机器人操作(显示机械臂操作场景)。

具体的层次定义如下:

- S0阶段(任务定义):预测模型生成文本形式的预测,输入为文本和观察,输出为文本规划

- S1阶段(预测图像):模型生成单帧图像预测,缺乏时间维度

- S2阶段(预测视频):模型生成视频序列,但主要关注美学质量

- S3阶段(世界模拟器):生成遵循物理规则且可转换为动作的视频

3. WorldSimBench评估框架设计

WorldSimBench通过两个互补的方法评估世界模拟器:显式感知评估专注于视觉质量、条件一致性和生成内容的具身性;隐式操作评估通过将视频转换为控制信号来衡量世界模拟器的性能。

3.1 显式感知评估

3.1.1 层次化评估维度

我们为三个具身场景开发了层次化评估维度清单,可分为三个主要方面:

设定评估函数 E:V×I→RdE: V \times I \rightarrow \mathbb{R}^dE:V×I→Rd,其中 VVV 是视频空间,III 是指令空间,ddd 是评估维度数量。对于每个维度 kkk,定义评分函数:

Sk(v,i)=∑j=1nwkj⋅fkj(v,i)S_k(v, i) = \sum_{j=1}^{n} w_{kj} \cdot f_{kj}(v, i)Sk(v,i)=j=1∑nwkj⋅fkj(v,i)

其中 wkjw_{kj}wkj 是权重,fkjf_{kj}fkj 是特征提取函数。

视觉质量评估包括:

- 美学(Aesthetics, AE):评估构图、颜色、光照

- 背景一致性(Background Consistency, BC):CBC=1−1T−1∑t=1T−1∣∣Bt−Bt+1∣∣2C_{BC} = 1 - \frac{1}{T-1}\sum_{t=1}^{T-1}||B_t - B_{t+1}||_2CBC=1−T−11∑t=1T−1∣∣Bt−Bt+1∣∣2

- 前景一致性(Foreground Consistency, FC):CFC=1−1T−1∑t=1T−1∣∣Ft−Ft+1∣∣2C_{FC} = 1 - \frac{1}{T-1}\sum_{t=1}^{T-1}||F_t - F_{t+1}||_2CFC=1−T−11∑t=1T−1∣∣Ft−Ft+1∣∣2

其中 BtB_tBt 和 FtF_tFt 分别表示时刻 ttt 的背景和前景特征。

条件一致性评估:

- 指令对齐(Instruction Alignment, IA):AIA=sim(Ev(v),Ei(i))A_{IA} = \text{sim}(E_v(v), E_i(i))AIA=sim(Ev(v),Ei(i))

- 场景对齐(Scenario Alignment, SA):仅用于OE场景

具身性评估:

- 轨迹合理性(Trajectory, TJ):Tscore=exp(−λ⋅Dtraj)T_{score} = \exp(-\lambda \cdot D_{traj})Tscore=exp(−λ⋅Dtraj)

- 透视性(Perspectivity, PV):评估3D深度感知

- 具身交互(Embodied Interaction, EI):评估物理交互的合理性

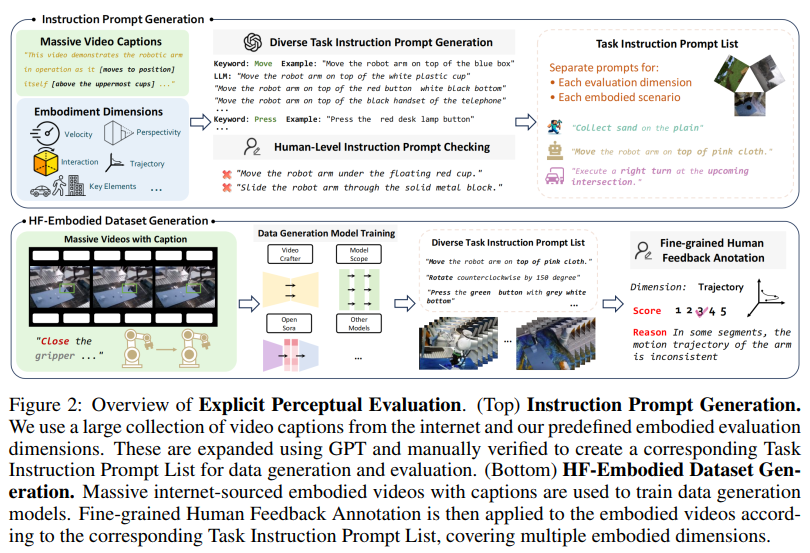

3.1.2 指令提示生成

图2描述:该图展示了显式感知评估的完整流程。顶部显示了指令提示生成过程,包括从互联网收集的大量视频字幕和预定义的具身评估维度,通过GPT扩展并手动验证后创建任务指令提示列表。底部显示了HF-Embodied数据集的生成过程,包括数据生成模型训练和细粒度人工反馈标注。

使用层次化评估维度和来自关键资源的大量视频字幕,创建了一个基础但全面的提示列表。利用大语言模型(如ChatGPT)的知识来扩展元提示的范围。经过相关性、多样性和数据分布的人工筛选后,编译了任务指令提示列表。

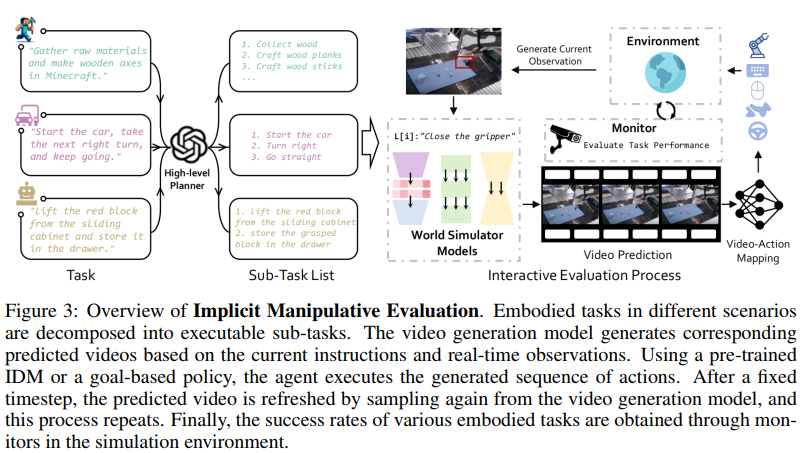

3.2 隐式操作评估

隐式操作评估将世界模拟器视为情境上下文的低级决策者。给定观察 oto_tot 和指令 iii,世界模拟器生成未来视频 v^t:t+H\hat{v}_{t:t+H}v^t:t+H:

v^t:t+H=Gθ(ot,i)\hat{v}_{t:t+H} = G_\theta(o_t, i)v^t:t+H=Gθ(ot,i)

其中 GθG_\thetaGθ 是参数化的视频生成模型,HHH 是预测时域。

然后使用预训练的逆动力学模型(IDM)或基于目标的策略将视频转换为动作:

at:t+H=πϕ(v^t:t+H)a_{t:t+H} = \pi_\phi(\hat{v}_{t:t+H})at:t+H=πϕ(v^t:t+H)

图3描述:该图展示了隐式操作评估的概览。具身任务被分解为可执行的子任务。视频生成模型基于当前指令和实时观察生成相应的预测视频。使用预训练的IDM或基于目标的策略,智能体执行生成的动作序列。在固定时间步后,通过从视频生成模型重新采样来刷新预测视频,此过程重复进行。最终,通过模拟环境中的监控器获得各种具身任务的成功率。

4. HF-Embodied数据集构建

4.1 数据收集与处理

数据集构建基于三个关键资源:

- 开放式具身环境(OE):使用OpenAI Contractor Gameplay数据集,包含人类玩家完成任务的记录

- 自动驾驶(AD):使用nuScenes训练集,以10Hz频率采样25帧视频片段

- 机器人操作(RM):使用RH20T-P数据集,包含原语级机器人操作指令

4.2 人工标注流程

标注质量通过以下公式评估:

Qanno=1N∑i=1N∑d=1Dαd⋅ICC(Si,d(1),Si,d(2))Q_{anno} = \frac{1}{N}\sum_{i=1}^{N}\sum_{d=1}^{D} \alpha_d \cdot \text{ICC}(S_{i,d}^{(1)}, S_{i,d}^{(2)})Qanno=N1i=1∑Nd=1∑Dαd⋅ICC(Si,d(1),Si,d(2))

其中 ICC\text{ICC}ICC 是组内相关系数,Si,d(j)S_{i,d}^{(j)}Si,d(j) 是标注者 jjj 对样本 iii 在维度 ddd 上的评分,αd\alpha_dαd 是维度权重。

最终数据集包含35,701个元组,结构如下:

D={(vi,ti,si,ri)}i=135701\mathcal{D} = \{(v_i, t_i, s_i, r_i)\}_{i=1}^{35701}D={(vi,ti,si,ri)}i=135701

其中 viv_ivi 是视频,tit_iti 是文本指令,si∈Rds_i \in \mathbb{R}^dsi∈Rd 是多维度分数,rir_iri 是标注理由。

5. 人类偏好评估器

5.1 模型架构

人类偏好评估器基于Flash-VStream架构,采用LoRA微调策略。模型输入包括采样视频帧序列 {f1,f2,...,fn}\{f_1, f_2, ..., f_n\}{f1,f2,...,fn} 和包含场景、指令、评估维度的提示 ppp。

损失函数定义为:

L=1∣D∣∑(v,t,s,r)∈D∑d=1D∣∣hθ(v,pd)−sd∣∣2\mathcal{L} = \frac{1}{|\mathcal{D}|}\sum_{(v,t,s,r) \in \mathcal{D}} \sum_{d=1}^{D} ||h_\theta(v, p_d) - s_d||^2L=∣D∣1(v,t,s,r)∈D∑d=1∑D∣∣hθ(v,pd)−sd∣∣2

其中 hθh_\thetahθ 是评估器网络,pdp_dpd 是维度 ddd 的提示。

5.2 训练策略

采用AdamW优化器,学习率调度使用余弦衰减:

ηt=ηmin+12(ηmax−ηmin)(1+cos(πtT))\eta_t = \eta_{min} + \frac{1}{2}(\eta_{max} - \eta_{min})(1 + \cos(\frac{\pi t}{T}))ηt=ηmin+21(ηmax−ηmin)(1+cos(Tπt))

其中 ηmax=2×10−5\eta_{max} = 2 \times 10^{-5}ηmax=2×10−5,ηmin=0\eta_{min} = 0ηmin=0,TTT 是总训练步数。

6. 实验结果与分析

6.1 显式感知评估结果

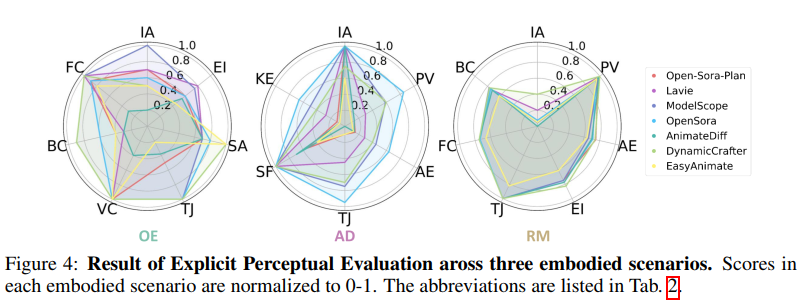

图4描述:该图展示了三个具身场景下的显式感知评估结果。使用雷达图形式展示各个模型在不同维度上的标准化得分(0-1范围)。在OE场景中,大多数模型在具身交互(EI)维度表现较差;在AD场景中,模型间差异较小但整体分数较低;在RM场景中,模型在静态维度(如PV、BC、FC)表现良好,但在动态维度(如IA、TJ)表现不佳。

评估结果表明,在开放式具身环境中,模型在生成物理合理的交互方面存在显著困难。特别是在具身交互维度,平均得分仅为:

SˉEIOE=1∣M∣∑m∈MSEIm=0.67\bar{S}_{EI}^{OE} = \frac{1}{|M|}\sum_{m \in M} S_{EI}^m = 0.67SˉEIOE=∣M∣1m∈M∑SEIm=0.67

6.2 隐式操作评估结果

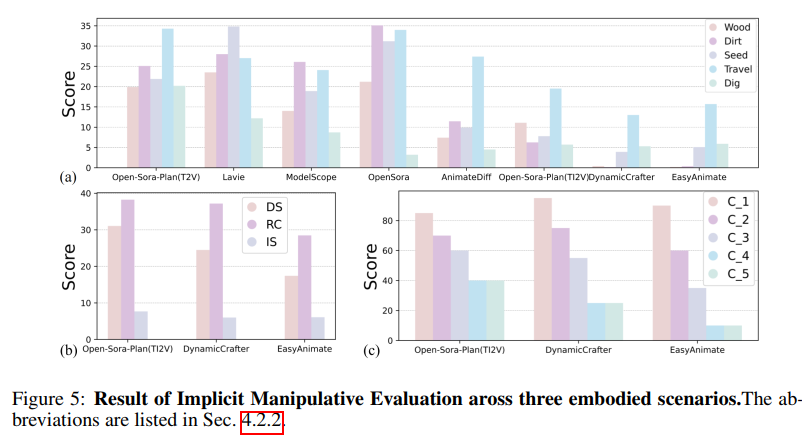

图5描述:该图展示了三个具身场景下的隐式操作评估结果。左侧显示了OE场景中不同任务的性能(包括收集木材、泥土、种子以及旅行距离和挖掘深度);中间显示了AD场景的各项指标(DS、RC、IS等);右侧显示了RM场景中完成1-5个连续任务的成功率。

在自动驾驶场景中,驾驶得分(DS)计算为:

DS=RC×IS=RC×∏i(1−pi)niDS = RC \times IS = RC \times \prod_{i} (1 - p_i)^{n_i}DS=RC×IS=RC×i∏(1−pi)ni

其中 RCRCRC 是路线完成率,pip_ipi 是违规类型 iii 的惩罚因子,nin_ini 是违规次数。

6.3 物理规则与动作对齐分析

通过皮尔逊相关系数评估显式和隐式评估的一致性:

ρ=∑i=1n(xi−xˉ)(yi−yˉ)∑i=1n(xi−xˉ)2∑i=1n(yi−yˉ)2\rho = \frac{\sum_{i=1}^{n}(x_i - \bar{x})(y_i - \bar{y})}{\sqrt{\sum_{i=1}^{n}(x_i - \bar{x})^2}\sqrt{\sum_{i=1}^{n}(y_i - \bar{y})^2}}ρ=∑i=1n(xi−xˉ)2∑i=1n(yi−yˉ)2∑i=1n(xi−xˉ)(yi−yˉ)

其中 xix_ixi 和 yiy_iyi 分别是显式和隐式评估得分。实验结果显示 ρ>0.7\rho > 0.7ρ>0.7,表明两种评估方法具有较强的一致性。

7. 消融研究与深入分析

7.1 图像条件对性能的影响

实验比较了纯文本条件(T2V)和文本+图像条件(TI2V)的模型性能。定义性能下降率:

ΔP=PT2V−PTI2VPT2V×100%\Delta P = \frac{P_{T2V} - P_{TI2V}}{P_{T2V}} \times 100\%ΔP=PT2VPT2V−PTI2V×100%

结果显示,在OE场景中,添加图像条件导致平均性能下降61%,这表明当前模型在处理多模态条件输入时存在显著挑战。

7.2 任务复杂度分析

定义任务复杂度函数:

C(task)=α⋅Lseq+β⋅Nobj+γ⋅DphysC(task) = \alpha \cdot L_{seq} + \beta \cdot N_{obj} + \gamma \cdot D_{phys}C(task)=α⋅Lseq+β⋅Nobj+γ⋅Dphys

其中 LseqL_{seq}Lseq 是序列长度,NobjN_{obj}Nobj 是涉及的物体数量,DphysD_{phys}Dphys 是物理交互的复杂度。实验发现,随着复杂度增加,成功率呈指数衰减:

S(C)=S0⋅e−λCS(C) = S_0 \cdot e^{-\lambda C}S(C)=S0⋅e−λC

附录A:数学推导

A.1 视频生成模型的概率框架

世界模拟器可以形式化为条件概率分布:

p(vt:t+H∣ot,i,θ)=∏k=0H−1p(vt+k+1∣vt:t+k,ot,i,θ)p(v_{t:t+H}|o_t, i, \theta) = \prod_{k=0}^{H-1} p(v_{t+k+1}|v_{t:t+k}, o_t, i, \theta)p(vt:t+H∣ot,i,θ)=k=0∏H−1p(vt+k+1∣vt:t+k,ot,i,θ)

采用扩散模型框架,前向过程定义为:

q(xt∣xt−1)=N(xt;1−βtxt−1,βtI)q(x_t|x_{t-1}) = \mathcal{N}(x_t; \sqrt{1-\beta_t}x_{t-1}, \beta_t I)q(xt∣xt−1)=N(xt;1−βtxt−1,βtI)

反向过程通过神经网络参数化:

pθ(xt−1∣xt)=N(xt−1;μθ(xt,t),Σθ(xt,t))p_\theta(x_{t-1}|x_t) = \mathcal{N}(x_{t-1}; \mu_\theta(x_t, t), \Sigma_\theta(x_t, t))pθ(xt−1∣xt)=N(xt−1;μθ(xt,t),Σθ(xt,t))

训练目标为最小化变分下界:

LVLB=Eq[∑t>1DKL(q(xt−1∣xt,x0)∣∣pθ(xt−1∣xt))−logpθ(x0∣x1)]\mathcal{L}_{VLB} = \mathbb{E}_q\left[\sum_{t>1}D_{KL}(q(x_{t-1}|x_t, x_0)||p_\theta(x_{t-1}|x_t)) - \log p_\theta(x_0|x_1)\right]LVLB=Eq[t>1∑DKL(q(xt−1∣xt,x0)∣∣pθ(xt−1∣xt))−logpθ(x0∣x1)]

A.2 视频到动作映射的逆动力学模型

给定视频序列 vt:t+Hv_{t:t+H}vt:t+H,逆动力学模型学习映射:

π:VH→AH\pi: \mathcal{V}^H \rightarrow \mathcal{A}^Hπ:VH→AH

采用变分自编码器框架,定义潜在变量 zzz:

qϕ(z∣v,a)=N(z;μϕ(v,a),σϕ(v,a))q_\phi(z|v, a) = \mathcal{N}(z; \mu_\phi(v, a), \sigma_\phi(v, a))qϕ(z∣v,a)=N(z;μϕ(v,a),σϕ(v,a))

pθ(a∣v,z)=∏t=1Hpθ(at∣vt:t+k,z)p_\theta(a|v, z) = \prod_{t=1}^{H} p_\theta(a_t|v_{t:t+k}, z)pθ(a∣v,z)=t=1∏Hpθ(at∣vt:t+k,z)

优化证据下界(ELBO):

LELBO=Eqϕ(z∣v,a)[logpθ(a∣v,z)]−DKL(qϕ(z∣v,a)∣∣p(z))\mathcal{L}_{ELBO} = \mathbb{E}_{q_\phi(z|v,a)}[\log p_\theta(a|v,z)] - D_{KL}(q_\phi(z|v,a)||p(z))LELBO=Eqϕ(z∣v,a)[logpθ(a∣v,z)]−DKL(qϕ(z∣v,a)∣∣p(z))

A.3 人类偏好评估器的对齐损失

为了使评估器与人类偏好对齐,定义Bradley-Terry模型:

P(vi≻vj)=exp(r(vi))exp(r(vi))+exp(r(vj))P(v_i \succ v_j) = \frac{\exp(r(v_i))}{\exp(r(v_i)) + \exp(r(v_j))}P(vi≻vj)=exp(r(vi))+exp(r(vj))exp(r(vi))

其中 r(v)r(v)r(v) 是奖励函数。训练损失为:

Lpref=−E(vw,vl)∼D[logσ(rθ(vw)−rθ(vl))]\mathcal{L}_{pref} = -\mathbb{E}_{(v_w, v_l) \sim \mathcal{D}}\left[\log \sigma(r_\theta(v_w) - r_\theta(v_l))\right]Lpref=−E(vw,vl)∼D[logσ(rθ(vw)−rθ(vl))]

加入正则化项防止奖励崩塌:

Ltotal=Lpref+λreg∣∣θ∣∣2+λvarVar(rθ)\mathcal{L}_{total} = \mathcal{L}_{pref} + \lambda_{reg}||\theta||^2 + \lambda_{var}\text{Var}(r_\theta)Ltotal=Lpref+λreg∣∣θ∣∣2+λvarVar(rθ)

A.4 闭环评估的马尔可夫决策过程

将隐式操作评估形式化为部分可观察马尔可夫决策过程(POMDP):

M=⟨S,A,O,T,R,Ω,γ⟩\mathcal{M} = \langle \mathcal{S}, \mathcal{A}, \mathcal{O}, T, R, \Omega, \gamma \rangleM=⟨S,A,O,T,R,Ω,γ⟩

其中:

- S\mathcal{S}S 是状态空间

- A\mathcal{A}A 是动作空间

- O\mathcal{O}O 是观察空间

- T:S×A→Δ(S)T: \mathcal{S} \times \mathcal{A} \rightarrow \Delta(\mathcal{S})T:S×A→Δ(S) 是转移函数

- R:S×A→RR: \mathcal{S} \times \mathcal{A} \rightarrow \mathbb{R}R:S×A→R 是奖励函数

- Ω:S→Δ(O)\Omega: \mathcal{S} \rightarrow \Delta(\mathcal{O})Ω:S→Δ(O) 是观察函数

- γ\gammaγ 是折扣因子

策略优化目标:

J(π)=Eτ∼pπ(τ)[∑t=0∞γtR(st,at)]J(\pi) = \mathbb{E}_{\tau \sim p_\pi(\tau)}\left[\sum_{t=0}^{\infty}\gamma^t R(s_t, a_t)\right]J(π)=Eτ∼pπ(τ)[t=0∑∞γtR(st,at)]

其中轨迹分布为:

pπ(τ)=p(s0)∏t=0∞π(at∣ot)T(st+1∣st,at)Ω(ot+1∣st+1)p_\pi(\tau) = p(s_0)\prod_{t=0}^{\infty}\pi(a_t|o_t)T(s_{t+1}|s_t, a_t)\Omega(o_{t+1}|s_{t+1})pπ(τ)=p(s0)t=0∏∞π(at∣ot)T(st+1∣st,at)Ω(ot+1∣st+1)

A.5 评估指标的信息论分析

定义生成视频与真实物理规则的互信息:

I(V;P)=∑v∈V∑p∈Pp(v,p)logp(v,p)p(v)p(p)I(V; P) = \sum_{v \in V}\sum_{p \in P} p(v, p)\log\frac{p(v, p)}{p(v)p(p)}I(V;P)=v∈V∑p∈P∑p(v,p)logp(v)p(p)p(v,p)

条件熵衡量给定指令下视频的不确定性:

H(V∣I)=−∑i∈Ip(i)∑v∈Vp(v∣i)logp(v∣i)H(V|I) = -\sum_{i \in I}p(i)\sum_{v \in V}p(v|i)\log p(v|i)H(V∣I)=−i∈I∑p(i)v∈V∑p(v∣i)logp(v∣i)

世界模拟器的有效性可通过最大化互信息同时最小化条件熵来衡量:

Leff=λ1I(V;P)−λ2H(V∣I)\mathcal{L}_{eff} = \lambda_1 I(V; P) - \lambda_2 H(V|I)Leff=λ1I(V;P)−λ2H(V∣I)

附录B:实验细节补充

B.1 训练超参数设置

所有模型训练采用统一的超参数配置:

- 批次大小:B=32B = 32B=32

- 学习率:η=2×10−5\eta = 2 \times 10^{-5}η=2×10−5

- 权重衰减:λ=0.01\lambda = 0.01λ=0.01

- 梯度裁剪:clip_norm=1.0\text{clip\_norm} = 1.0clip_norm=1.0

- 预热步数:warmup_steps=0.03×total_steps\text{warmup\_steps} = 0.03 \times \text{total\_steps}warmup_steps=0.03×total_steps

B.2 数据增强策略

为提高模型泛化能力,采用以下数据增强技术:

- 时间增强:随机时间裁剪和插值

- 空间增强:随机裁剪、旋转、翻转

- 颜色增强:颜色抖动、亮度调整

增强概率遵循:

paug=min(1.0,0.5+0.5×epochtotal_epochs)p_{aug} = \min(1.0, 0.5 + 0.5 \times \frac{\text{epoch}}{\text{total\_epochs}})paug=min(1.0,0.5+0.5×total_epochsepoch)

B.3 评估协议详情

每个场景的评估遵循严格的协议:

- 种子设置:所有实验使用固定随机种子确保可重现性

- 采样策略:视频生成采用top-p采样,p=0.95p = 0.95p=0.95

- 评估轮次:每个任务重复10次,报告均值和标准差

统计显著性检验采用配对t检验,显著性水平 α=0.05\alpha = 0.05α=0.05。