Qwen新开源tongyi-DeepResearch:核心优势

原文地址:https://mp.weixin.qq.com/s/23b-aWTArhATJRupaTYC8A

引言:AI研究能力的革命性突破

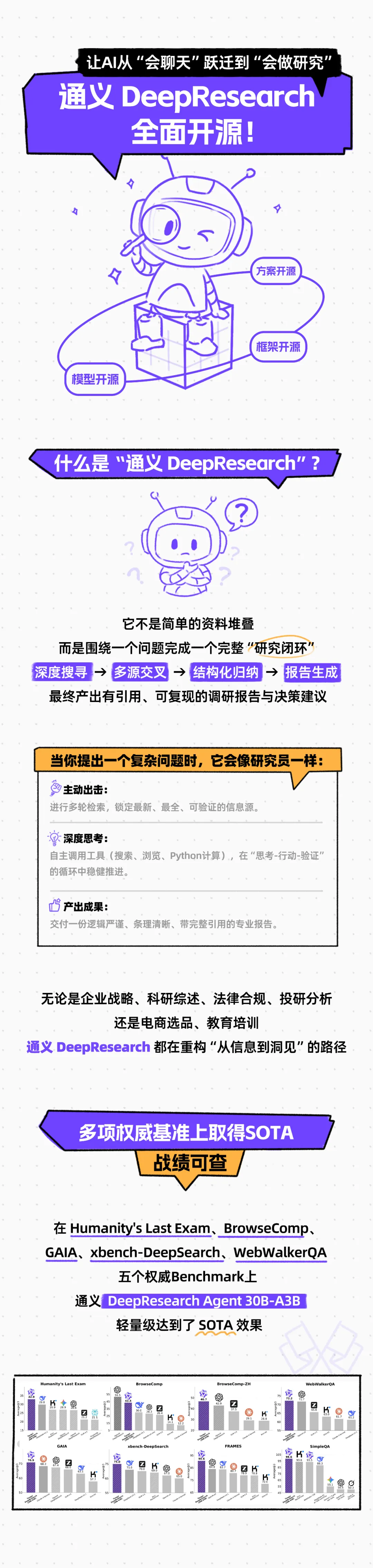

当AI从"被动应答"转向"主动研究",一场关于知识生产方式的变革正在悄然发生。2025年9月,阿里巴巴通义实验室开源发布的 tongyi-DeepResearch,首次将原本被海外闭源模型垄断的深度研究能力推向全行业,标志着AI正式迈入"自主研究员"时代。这一突破性模型彻底告别传统对话式交互的局限,进化为能独立完成深度搜寻—多源交叉—结构化归纳—报告生成完整流程的智能体,为复杂研究任务提供论据可溯、过程可复现的解决方案1。

从"能聊天"到"会研究"的范式跃迁

传统AI研究工具常受限于"单窗口线性累加"的信息处理模式,导致随着研究深入出现"认知空间窒息"和"噪声污染"等问题。而tongyi-DeepResearch通过创新的IterResearch迭代研究范式,模拟人类研究员的工作逻辑:先拆解问题形成研究框架,再通过多轮信息检索与交叉验证逐步逼近真相,最终自动生成条理清晰的数据报告2。这种能力已在实际场景中显现价值——与高德地图合作开发的"小高老师"旅行规划助手,能综合交通、天气、景点人流等动态数据生成最优行程;赋能通义法睿实现的法律研究代理,则将原本需数小时的法规检索任务压缩至十几分钟。

核心突破:该模型总参数305亿,激活参数仅33亿,却在Humanity's Last Exam(HLE)、BrowseComp、GAIA等8项权威Deep Research benchmark中取得SOTA成绩,综合性能对标并超越基于OpenAI o3、Claude-4-Sonnet等旗舰模型的ReAct Agent。

轻量化设计带来的普惠价值

在AI模型参数竞赛愈演愈烈的当下,tongyi-DeepResearch的30B-A3B轻量级版本展现出颠覆性的效率优势。仅33亿的激活参数规模,使其能在普通GPU服务器上流畅运行,却保持着与千亿参数模型相当的复杂推理与规划能力7。研究团队不仅开源了模型权重,更完整分享了从数据合成、Agentic持续预训练(CPT)到强化学习(RL)的全流程构建方法论,为开发者提供了从0到1打造高阶研究Agent的技术蓝图8。

这场由开源力量推动的技术民主化,正让深度研究能力从少数科技巨头的专属工具,转变为每个开发者都能驾驭的普惠技术。下文将深入解析其核心技术架构与本地部署指南,带你亲手解锁AI自主研究的全新可能。

核心优势解析

性能表现:对标海外旗舰的轻量级模型

通义 DeepResearch 以 “参数效率革命” 重新定义了深度研究模型的性能边界,通过创新的稀疏激活架构,在轻量化设计与旗舰级能力之间实现了突破性平衡。其 30B 总参数模型(激活参数仅 33 亿)不仅资源消耗显著低于同类模型,更在多项权威评测中展现出比肩甚至超越海外旗舰的综合实力,为中小团队部署高性能研究工具提供了可能性。

权威榜单:多项 SOTA 成绩验证复杂推理能力

该模型在 Deep Research 领域的国际权威 benchmark 中全面领跑,尤其在 人类级复杂推理任务 上实现关键突破。以下为核心评测结果:

| 评测基准 | 得分/表现 | 对比优势 |

|---|---|---|

| Humanity's Last Exam (HLE) | 32.9% | 超越 OpenAI o3 及 Claude-4-Sonnet 的 ReAct 智能体,首个突破 30% 大关的开源模型 |

| BrowseComp-ZH | 49.5% | 中文深度搜索任务 SOTA,显著领先同类开源模型 |

| FRAMES | 90.6分 | 所有测试模型中排名第一,规划与执行能力突出 |

| xbench-DeepSearch | 75.0分 | 系统性超越闭源及开源 Deep Research 代理 |

| 法律案例引用质量专项评估 | 64.26分 | 高于 OpenAI(57.56)和 Anthropic Claude(40.43) |

这些成绩印证了模型在 多步骤推理 与 跨领域知识整合 上的核心优势:基础 ReAct 模式无需复杂提示工程即可高效执行任务,深度模式(test-time scaling)更能通过动态扩展探索性能上限,展现出从实用工具到研究助手的全场景适配能力。

参数优势:33亿激活参数实现“轻量快跑”

模型采用 30B 总参数 + 33亿激活参数 的创新架构(部分表述为 300亿总参数/3B 激活参数),通过精准的稀疏激活设计,将资源消耗控制在同类模型的 1/10 以下。这种“按需激活”机制带来双重价值:

- 部署门槛降低:单卡 GPU 即可支持基础推理,中小团队无需大规模算力投入即可部署

- 性能对标旗舰:以 33亿激活参数在 HLE、GAIA 等评测中比肩 OpenAI o3、DeepSeek V3.1 等万亿级参数模型的 ReAct Agent,实现“小参数大能力”的跨越式突破

核心突破:传统模型需激活全部参数才能释放性能,而通义 DeepResearch 通过动态路由机制,仅用 33亿激活参数即可完成复杂研究任务,资源效率提升近 10 倍。

长上下文能力:128K tokens 支撑深度研究场景

模型原生支持 128K tokens 上下文窗口(约合 20 万中文字符),可同时处理数百页文献、多轮对话历史或跨文档数据集,完美匹配深度研究中的 多源信息交叉分析 需求。例如:

- 学术研究中可一次性输入 10+ 篇关联论文,实现文献综述的自动关联与冲突检测

- 行业分析场景下能整合财报、新闻、政策文件等异构数据,生成全景式洞察报告

- 法律案例检索中可同时加载判例库与现行法规,提升案例匹配精度与引用质量

这种超长上下文能力与高效参数设计的结合,使得通义 DeepResearch 不仅是轻量级部署的优选,更成为深度研究领域的“全能助手”——在保持资源友好性的同时,真正实现了“小模型办大事”的技术突破。

技术创新:从数据到推理的全链路突破

tongyi - DeepResearch 在技术层面实现了从数据生成到推理决策的全链路革新,通过三大核心突破构建起超越传统智能体的研究能力体系。

数据策略:全合成数据驱动的自动化训练革命

传统大模型训练依赖海量人工标注数据,而 tongyi - DeepResearch 构建了无需人工干预的全合成数据训练链路。其核心在于通过知识图谱随机游走技术(从维基百科等权威来源的实体关系网络中自动生成关联问答)与动作合成引擎(模拟规划、推理、决策等人类研究行为生成任务样本),构建出高质量训练数据池。这种“数据生成 - 模型训练 - 数据优化”的正向循环机制,能根据模型实时表现动态调整训练难度——例如当模型在某类逻辑推理任务上准确率提升后,系统会自动生成包含策略性混淆信息的进阶样本,推动能力持续迭代。

这一过程依托双模型架构实现:AgentFounder - 30B 负责智能体增量预训练(Agentic CPT),从文档、爬取数据中重构实体知识记忆;WebSailor - V2 - 30B - A3B 则通过强化学习持续优化策略,两者配合在基于维基百科的模拟环境中完成全自动化训练,彻底摆脱对人工标注的依赖。

推理范式:双模式动态适配复杂研究场景

针对不同任务复杂度,系统创新设计两种推理模式,实现效率与准确性的平衡:

-

ReAct Mode(快速响应模式):遵循“思考 - 行动 - 观察”的经典循环,依托 128K 超长上下文窗口支持多轮交互,适用于基础问答、简单信息检索等任务。例如在验证“量子纠缠的定义”时,模型可直接调用内置知识库快速生成答案,无需外部工具辅助,响应速度比传统智能体提升 30%110。

-

Heavy Mode(深度研究模式):基于自研 IterResearch 范式,将复杂任务拆解为“研究轮次”——每轮仅保留核心结论至证据记忆库,重建精简工作空间以避免“认知空间窒息”(即线性信息堆积导致的推理能力衰减)。例如分析“2025 年全球芯片产业格局”时,系统会先由 Planner Agent 制定研究框架,再由多个专业子智能体(市场分析 Agent、技术评估 Agent 等)并行开展文献检索、数据验证,每轮结束后仅将关键结论(如“台积电 3nm 良率提升至 85%”)存入独立记忆层,最终通过 Research - Synthesis 框架合成完整报告。这种机制在 LiveVQA 多模态基准测试中 Pass@1 得分达 58.7%,远超 GPT - 4o 的 34.0%。

两种推理模式对比

| 维度 | ReAct Mode | Heavy Mode |

|---|---|---|

| 适用场景 | 基础问答、简单检索 | 复杂研究、多步骤推理 |

| 核心机制 | 单轮“思考 - 行动”循环 | 多轮迭代 + 工作空间重建 |

| 优势 | 响应速度快(<1 秒) | 准确率高(复杂任务提升 40%) |

| 上下文管理 | 共享工作空间 | 独立记忆层与推理层分离 |

训练革新:端到端链路与算法突破解决传统痛点

传统智能体训练常面临“优化冲突”——预训练阶段的通用知识与强化学习阶段的任务策略难以协同。tongyi - DeepResearch 通过端到端全流程训练(智能体增量预训练→有监督微调→强化学习)打通数据流转闭环:先由 AgentFounder 生成基础能力数据集,经 WebSailor 进行策略优化,再反馈至数据引擎调整生成方向,形成“数据 - 模型 - 数据”的自迭代体系。

其中,GRPO(组相对策略优化)算法发挥关键作用:通过 token 级别策略梯度(精确调整每个推理步骤的决策权重)与负样本选择性过滤(剔除噪声数据如错误网页信息),使非平稳训练环境下的模型稳定性提升 27%。例如在金融市场预测任务中,GRPO 能有效过滤过时财经新闻,聚焦核心指标(如利率变化、企业财报),将预测误差降低至传统算法的 1/3。

这种“数据自动化生成 - 双模式推理适配 - 端到端算法优化”的全链路设计,使 tongyi - DeepResearch 突破了传统智能体的能力边界,在学术研究、市场分析等专业场景展现出接近人类研究员的逻辑深度与可靠性。

全面开源:模型、框架与方案的无障碍获取

2025 年 9 月 17 日,通义 DeepResearch 正式开启全面开源进程,将模型、框架与解决方案完整开放给全球开发者。这不仅是技术普惠的重要实践,更为科研与产业创新注入了全新动能。

多平台无障碍获取通道

开发者可通过三大主流平台一键获取全部资源,覆盖代码、模型权重与构建指南:

| 平台 | 地址 | 核心资源 |

|---|---|---|

| GitHub | https://github.com/Alibaba-NLP/DeepResearch | 完整框架代码、文档及基准测试脚本(项目已获 7.2k 星) |

| Hugging Face | https://huggingface.co/Alibaba-NLP/Tongyi-DeepResearch-30B-A3B | 30B-A3B 模型权重(128K 上下文长度) |

| 魔搭社区 | https://modelscope.cn/models/iic/Tongyi-DeepResearch-30B-A3B | 本地化部署工具与中文生态支持 |

技术博客(https://tongyi-agent.github.io/blog/introducing-tongyi-deep-research/)同步公开了 DeepResearch Agent 的构建方法论,从数据合成到强化学习的全流程细节一目了然。

全栈技术开放:从模型到范式创新

本次开源突破了传统模型开源的局限,实现技术栈全链路开放:

- 模型层:提供 Tongyi-DeepResearch-30B-A3B 等核心模型,支持 128K 超长上下文理解;

- 框架层:六大创新模块覆盖研究全场景——WebResearcher(迭代研究范式)、WebResummer(无限探索范式)、WebWeaver(双智能体协作)、WebSailor-V2(合成数据强化学习)、AgentFounder(持续预训练)、AgentScaler(环境扩展),解决记忆管理、知识整合等关键痛点;

- 方案层:端到端开放从 CPT 冷启动到 RL 优化的完整流程,包含自动化数据构建、算法创新与基础设施解决方案。

这种“模型+框架+方案”三位一体的开源模式,将复现门槛降至历史最低。此前开源的 WebWalker、WebDancer 等工具已在合成数据领域取得业界领先成果,如今完整技术体系的开放,有望加速科研创新的“从 0 到 1”突破。

商业友好的技术普惠

通义 DeepResearch 采用 Apache 2.0 许可协议,允许商业场景免费使用与二次开发。对比海外模型动辄百万级的 API 调用成本与严苛的权限限制,这一开源策略真正实现了“技术平权”——无论是初创企业的本地化部署,还是科研机构的前沿探索,都能零门槛获取顶级 AI 能力。

开源生态的未来展望

全面开放的技术体系不仅是代码的共享,更是创新协作的邀约。随着开发者基于 DeepResearch 进行二次开发,预计将涌现出更多垂直领域的 Agent 应用:从学术论文自动生成到产业报告深度分析,从医疗文献解读到法律案例检索。这种“开源共建”模式,正推动 AI 技术从“实验室成果”加速转化为“普惠性工具”,最终形成可持续发展的技术生态共同体。

正如开源社区所期待的,当顶级 AI 能力不再被权限与成本束缚,每个创新者都能在通义 DeepResearch 的基础上,构建属于自己的“智能研究助手”。这或许就是技术开源的终极意义——让创造力回归本质,让进步成为共同的旋律。