初学者如何选择适合的云平台进行AIGC训练?

AIGC(生成式人工智能)的 “常规应用” 涵盖文本生成、图像生成、语音合成、短视频生成及小模型微调等场景,其算力要求因任务类型、模型规模、生成精度 / 速度差异显著。以下从具体应用场景拆解算力需求,结合 “显存”(GPU 核心资源)和 “算力指标”(TFLOPS,每秒万亿次浮点运算)给出清晰参考,同时兼顾初学者和小团队的实际需求。

一、先明确:AIGC 常规应用的核心算力维度

算力需求主要由两个核心指标决定,二者缺一不可:

- GPU 显存:决定 “能否装下模型和数据”(AIGC 模型多为深度学习模型,需加载到 GPU 显存中运行),是 “入门门槛”;

- GPU 算力(FP16/FP8 为主):决定 “生成速度 / 训练效率”(AIGC 多依赖半精度 / 低精度计算,FP16 算力更具参考性)。

二、分场景拆解 AIGC 常规应用的算力要求

1. 文本生成(如文案、对话、摘要)

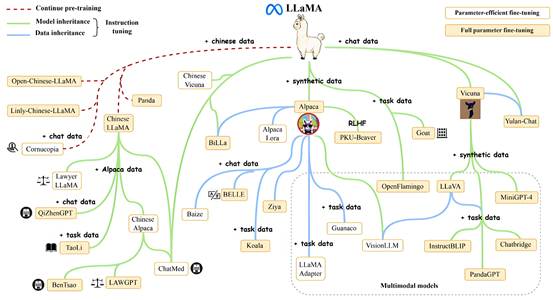

- 常见场景:本地部署小模型(如 Llama 2 7B、Qwen-7B、ChatGLM3-6B)、调用 API(如 OpenAI、通义千问,无本地算力需求);

- 显存要求:

- 基础精度(FP16):7B 模型需 13-15GB 显存,6B 模型需 11-13GB 显存;

- 量化优化(FP8/INT4):显存可降至 8-10GB(如 INT4 量化的 Llama 2 7B 仅需 8GB);

- 算力要求:

- 单条生成(如 500 字文案):消费级 GPU(如 RTX 3060/4060)的 FP16 算力(15-30 TFLOPS)足够,生成速度约 10-20 token / 秒(1 token≈0.7 个汉字);

- 批量生成(如一次性生成 100 条文案):需更高算力(如 RTX 4090,83 TFLOPS FP16),避免卡顿;

- 推荐硬件:

- 入门:RTX 3060(12GB)、RTX 4060 Ti(16GB);

- 流畅:RTX 3090(24GB)、RTX 4080(16GB)、RTX 4090(24GB)。

2. 图像生成(如创意图、产品图、风格迁移)

- 常见场景:Stable Diffusion(SD 1.5/SDXL)、MidJourney(调用 API 无本地算力需求)、DALL・E 3(API);

- 显存要求:

- 基础生成(512x512/768x768,SD 1.5):FP16 下需 8-10GB 显存,量化后 6-8GB;

- 高清生成(1024x1024,SDXL):FP16 下需 12-16GB 显存(开 xFormers 优化可降至 10-12GB);

- 超高清修复(2K/4K):需 24GB 以上显存(如 RTX 4090、A10);

- 算力要求:

- 单张 512x512 图(SD 1.5):RTX 3060(15 TFLOPS FP16)约 3-5 秒 / 张;

- 单张 1024x1024 图(SDXL):RTX 4070 Ti(56 TFLOPS FP16)约 5-8 秒 / 张,RTX 4090 约 2-3 秒 / 张;

- 推荐硬件:

- 入门:RTX 3060(12GB)、RTX 4060 Ti(16GB);

- 高清流畅:RTX 4070 Ti(12GB,需优化)、RTX 4080(16GB)、RTX 4090(24GB);

- 小团队批量:NVIDIA A10(24GB)、A100(40GB,适合高并发)。

3. 语音合成(TTS,如配音、短语音生成)

- 常见场景:开源模型(VITS、Tacotron 2)、商业 API(如阿里云 TTS、百度智能云 TTS);

- 显存要求:

- 基础模型(如 VITS 轻量版):5-8GB 显存(生成几十秒短语音);

- 高保真模型(如 VITS-L、情感 TTS):8-12GB 显存(支持多语言、情感调节);

- 算力要求:

- 实时生成(如直播配音):几百 GFLOPS 到几 TFLOPS 即可(如 RTX 3050,9 TFLOPS FP16),生成速度可达 “1:0.5”(生成 10 秒语音仅需 5 秒);

- 批量生成(如给 100 个视频配音):RTX 3060(15 TFLOPS)足够,无明显卡顿;

- 推荐硬件:

- 入门:RTX 3050(8GB)、RTX 3060(12GB);

- 高保真:RTX 4060 Ti(16GB)。

4. 短视频生成(10-30 秒,如创意短片、产品演示)

- 常见场景:开源模型(ModelScope 短视生成、Runway Gen-2 基础版)、商业工具(如 Pika Labs 基础版);

- 显存要求:

- 720P/10 秒视频:12-16GB 显存(如 RTX 4070 Ti 12GB,需开时序优化);

- 1080P/20 秒视频:24GB 以上显存(如 RTX 4090 24GB、A10 24GB);

- 算力要求:

- 视频生成需处理 “多帧图像时序关联”,算力需求高于单张图像:

- 720P/10 秒:需 40+ TFLOPS FP16(RTX 4070 Ti 56 TFLOPS,约 1 分钟生成);

- 1080P/20 秒:需 60+ TFLOPS FP16(RTX 4090 83 TFLOPS,约 2-3 分钟生成);

- 视频生成需处理 “多帧图像时序关联”,算力需求高于单张图像:

- 推荐硬件:

- 入门:RTX 4070 Ti(12GB,限 720P 短时长);

- 流畅:RTX 4090(24GB)、NVIDIA A10(24GB)。

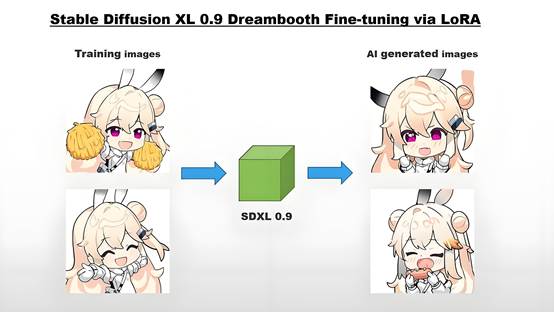

5. 小模型微调(如 SD LoRA、7B 文本模型微调)

- 常见场景:给 SD 加特定风格(如 “国风插画” LoRA)、微调 7B 模型做垂直领域问答(如 “法律问答”);

- 显存要求:

- SD LoRA 微调(特定风格):8-12GB 显存(RTX 3060 12GB 即可,训练时间 2-4 小时);

- 7B 文本模型 LoRA 微调(如 Llama 2 7B):12-16GB 显存(RTX 4070 Ti 12GB,开 gradient checkpointing 优化,训练时间 1-2 天);

- 7B 模型全参数微调(少用,常规场景无需):24GB 以上显存(RTX 4090 24GB);

- 算力要求:

- LoRA 微调(参数高效微调):算力需求较低,RTX 3060(15 TFLOPS)即可;

- 全参数微调:需更高算力(RTX 4090 83 TFLOPS),避免训练超时;

- 推荐硬件:

- LoRA 微调:RTX 3060(12GB)、RTX 4060 Ti(16GB);

- 7B 模型微调:RTX 4070 Ti(12GB,优化后)、RTX 4090(24GB)。

三、AIGC 常规应用算力需求参考表

应用类型 | 核心需求(显存 / FP16 算力) | 入门级硬件推荐 | 流畅级硬件推荐 | 小团队批量推荐 |

文本生成(7B) | 8-15GB / 15-30 TFLOPS | RTX 3060(12GB) | RTX 4070 Ti(12GB) | RTX 4090(24GB) |

图像生成(SDXL) | 10-16GB / 30-60 TFLOPS | RTX 4060 Ti(16GB) | RTX 4080(16GB) | NVIDIA A10(24GB) |

语音合成(TTS) | 5-12GB / 5-15 TFLOPS | RTX 3050(8GB) | RTX 3060(12GB) | RTX 4060 Ti(16GB) |

短视频生成(1080P) | 16-24GB / 40-80 TFLOPS | RTX 4070 Ti(12GB) | RTX 4090(24GB) | NVIDIA A100(40GB) |

小模型 LoRA 微调 | 8-16GB / 15-40 TFLOPS | RTX 3060(12GB) | RTX 4070 Ti(12GB) | RTX 4090(24GB) |

四、实用建议

- 优先 “低门槛尝试”:若仅需生成少量内容(如每周几张图、几十条文案),直接用API 调用(如 MidJourney、OpenAI),无需购买硬件,成本低(按次计费);初步实施可使用线上云服务器:如“智算云扉https://waas.aigate.cc/productService、算吧 https://www.suanba.cc/index”等租赁平台,支持按量计费。

- 消费级 GPU 足够入门:个人爱好者无需追求专业卡(如 A100),RTX 3060/4060 Ti 可覆盖 80% 常规场景(文本、图像、LoRA 微调);

- 优化手段降需求:通过 “模型量化”(如 INT4/FP8)、“梯度检查点”(训练时)、“xFormers”(图像生成)等工具,可降低 30%-50% 显存占用(如 RTX 3060 12GB 可跑 SDXL);

- 小团队按需扩容:若需批量生成(如每天生成 1000 张图),可组合 “消费级 GPU 集群”(如 2-4 张 RTX 4090)或租用云算力(如阿里云 GPU 实例、Lambda Labs),灵活控制成本。