非结构化数据处理:大数据时代的新挑战

在信息技术飞速发展的今天,我们已然迈入大数据时代。互联网的普及、物联网设备的广泛应用以及人工智能技术的迅猛发展,使得数据量呈爆炸式增长。据统计,全球数据量预计在未来几年内将达到泽字节(ZB)级别,其中绝大部分都是非结构化数据。这些非结构化数据包括文本、图片、音频、视频等多种形式,它们广泛存在于社交媒体、物联网设备、企业文档等各个角落。

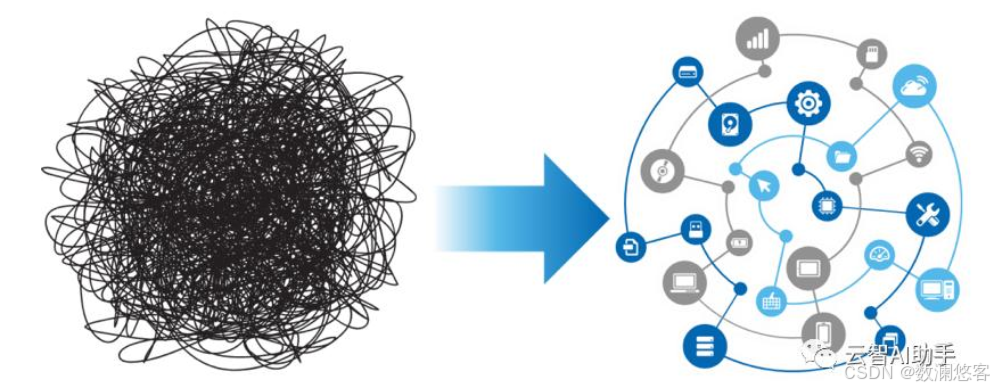

非结构化数据处理已然成为大数据时代的关键挑战。传统的数据处理方式在面对非结构化数据时显得力不从心,因为非结构化数据具有多样性、复杂性和海量性等特点。例如,社交媒体上的用户评论、图片分享以及视频内容,这些数据不仅格式各异,而且蕴含的信息丰富多样,如何从中提取有价值的信息成为一大难题。

在这个数据驱动的时代,数据从原始状态到最终应用的流动过程至关重要。从原始数据的采集,到经过处理、存储,再到提供服务并最终应用于各个领域,每一个环节都直接影响着数据的价值和应用效果。尤其是在非结构化数据处理中,这个流动过程更加复杂,需要借助先进的技术和架构来实现高效的数据处理和价值挖掘 。

架构蓝图:九层结构搭建数据处理大厦

为了应对非结构化数据处理的挑战,我们需要构建一个融合非结构化处理的大数据平台架构。这个架构就像是一栋九层大楼,每层都有其独特的功能和职责,数据从底层向上流动,每一层都为上层提供支撑,最终实现数据的价值挖掘和应用 。下面我们来详细分析每层的功能和关键技术,以及非结构化处理模块在其中的独特作用。

数据源层:数据的源头

数据源层是数据的起点,它包含了企业运营过程中产生的各种类型的数据,可分为结构化、半结构化和非结构化数据。结构化数据主要来源于传统的关系型数据库,如 MySQL、Oracle 等,它们具有固定的格式和模式,易于查询和分析,像企业的订单数据、用户信息等都属于结构化数据 。半结构化数据则有一定的结构,但不像结构化数据那样严格,常见的有 JSON、XML、CSV 文件,比如电商平台的商品详情页数据,可能包含一些结构化的商品属性,也有一些非结构化的用户评价 。

而非结构化数据的来源更为广泛,文档类如 Word、PDF、PPT,这些是企业知识的主要载体;媒体类包含图片、音频、视频,像会议录音、产品图片;文本类有网页、日志、代码,比如系统日志、技术文档等。数据源层是企业数据资产的基础,让企业 90% 被忽视的数据资产 “活” 起来,为后续的数据处理和分析提供了丰富的原料 。

数据采集层:智能化的数据搬运工

数据采集层的作用是将数据源层的数据收集起来,传输到数据处理层。传统的数据采集工具主要有 Sqoop 和 DataX,它们适用于定时批量导入结构化数据,就像货车定点运输一样,按照预定的时间和路线将数据从数据源搬运到目标存储中 。Kafka 和 Flink CDC 则用于实时数据流采集,能像传送带不停运转,持续不断地将数据传输到下游系统 。

对于非结构化数据采集,FSCrawler 是一个文件夹监控器,能够自动发现新文件并采集,比如当企业的文档文件夹中有新的 Word 文件产生时,FSCrawler 可以及时将其纳入采集范围 。Scrapy 爬虫则是网页采集器,能自动抓取网站内容,常用于采集网页上的新闻、评论等非结构化文本数据 。S3 Event 利用云存储事件触发采集,文件上传即采集,在云存储环境中应用广泛 。这些工具共同构成了一个智能化的数据收集系统,确保各种类型的数据能够及时、准确地被采集到大数据平台中 。

数据处理层:数据的智能加工厂

数据处理层是整个平台的核心引擎,它分为传统生产线和非结构化生产线。传统生产线主要进行 ETL 清洗、数据建模、聚合统计等操作,旨在将采集到的数据进行清洗和转换,使其符合分析和应用的要求 。非结构化生产线则更为复杂,基础处理车间利用分布式执行技术,Tika 文档解析能把 PDF/Word 变成文本,如同把纸质书数字化,方便后续的文本处理 。Tesseract OCR 用于识别图片文字,让扫描件秒变可编辑文本;OpenCV 图像处理可进行图片裁剪、格式转换、特征提取;FFmpeg 音视频处理能够提取音轨、视频转码、截取片段 。

在文本处理车间,jieba 分词把句子切成词语,例如将 “大数据平台” 切分为 “大数据 / 平台” 。NER 实体识别用于找出人名、地名、产品名、金额等关键信息;TF-IDF 关键词提取自动找出文档的核心主题词;文本分类聚类则自动给文档贴标签、归类 。计算引擎方面,Spark 和 Flink 作为分布式处理框架,能把任务分给多台机器同时干,大大提高处理效率 。Airflow 作为任务编排器,确保处理流程有序进行 。通过 UDF(用户自定义函数)将 AI 能力嵌入大数据引擎,实现规模化智能处理,比如利用 UDF 调用预训练的语言模型对文本进行情感分析 。

湖仓一体存储层:四大智能仓库

湖仓一体存储层包含四大智能仓库,分别是数据湖、数据仓库、向量数据库和搜索引擎。数据湖以 MinIO、S3 等对象存储为基础,是啥都能装的大仓库,能以原生格式存储任意规模的原始数据,具有 Schema on Read 的特点,写入时无强 Schema 约束 。Delta Lake 和 Iceberg 等数据湖表格式,支持版本管理和事务,进一步提升了数据湖的管理能力 。数据仓库如 Hive、ClickHouse,是 OLAP 分析引擎,专门做报表统计,擅长处理结构化数据,查询快、质量高 。

向量数据库是 AI 时代的关键新增组件,像 Milvus、Weaviate、Qdrant,用于存储文本 /