windows系统离线安装Ollama、创建模型(不使用docker)、coze调用

1. Ollama安装

参考:windows离线安装ollama

2. 模型创建

因为ollama运行在内网上,不能连接外网下载需要的模型,本文以chatgpt-20B版本作为示例。

可以从魔塔社区下载模型,但是安装的时候不知道为什么报错了,本文选择从镜像源全部下载:

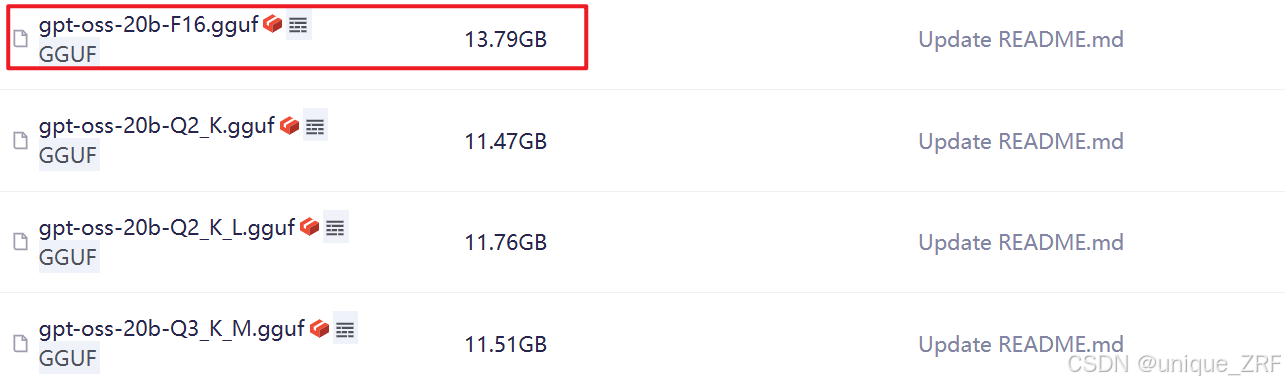

首先在外网下载文件:

模型链接

python环境中运行:

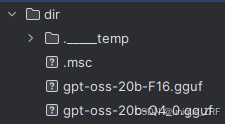

modelscope download --model unsloth/gpt-oss-20b-GGUF gpt-oss-20b-F16.gguf --local_dir ./dir

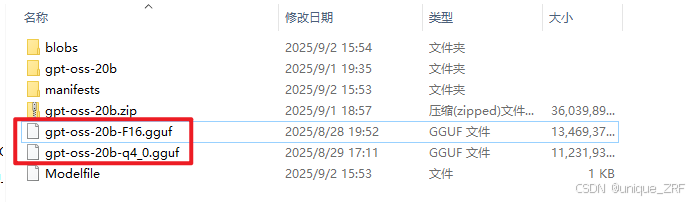

下载完成后将gpt-oss-20b文件夹压缩后导入内网

导入后创建Modelfile文件:

其内容如下:

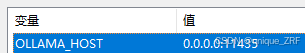

FROM ./gpt-oss-20b-F16.gguf如果端口被占用可新建用户变量:

set OLLAMA_HOST=0.0.0.0:11435

运行ollama:

ollama serve

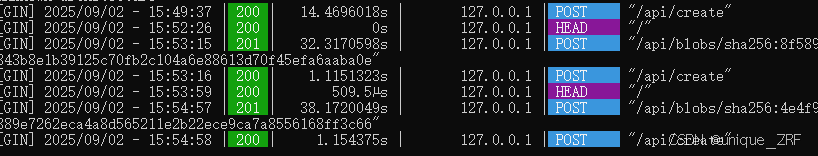

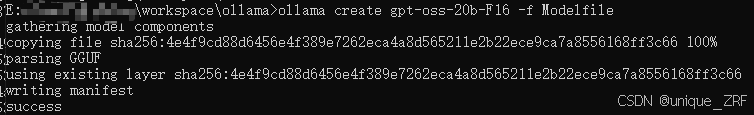

然后打开终端(CMD活PowerShell),进入该文件目录,运行以下代码导入模型:

ollama create gpt-oss-20b -f Modelfile

运行结果如下:

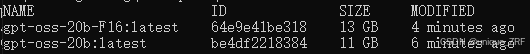

输入:ollama list 可查看当前安装的模型

3. Coze调用Ollama模型

注:也可以再Dify、langflow等低代码平台使用

参考上一篇文章部署的Coze:Coze离线部署

3.1 配置yaml文件

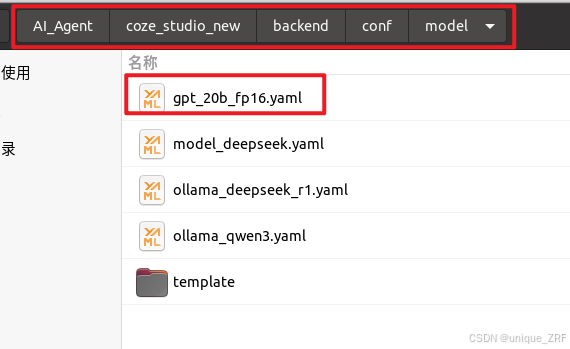

首先配置模型yaml文件,从template文件夹中拷贝出ollama的模板,然后重命名如下:

对yaml文件做如下修改:

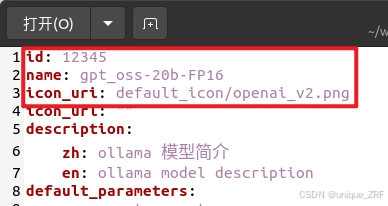

修改id、name、icon_url:

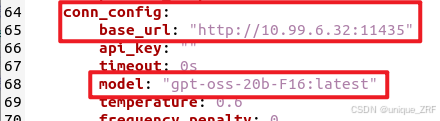

修改base_url,该地址为部署ollama的服务器的地址,端口按照上述操作进行过修改,默认为11434

api_key为空;

model为ollama部署的模型名称

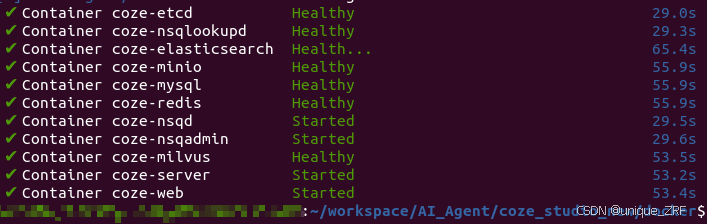

修改完成之后保存,在docker目录下运行以下命令重启coze:

docker-compose up -d --force-recreate

3.2 coze调用

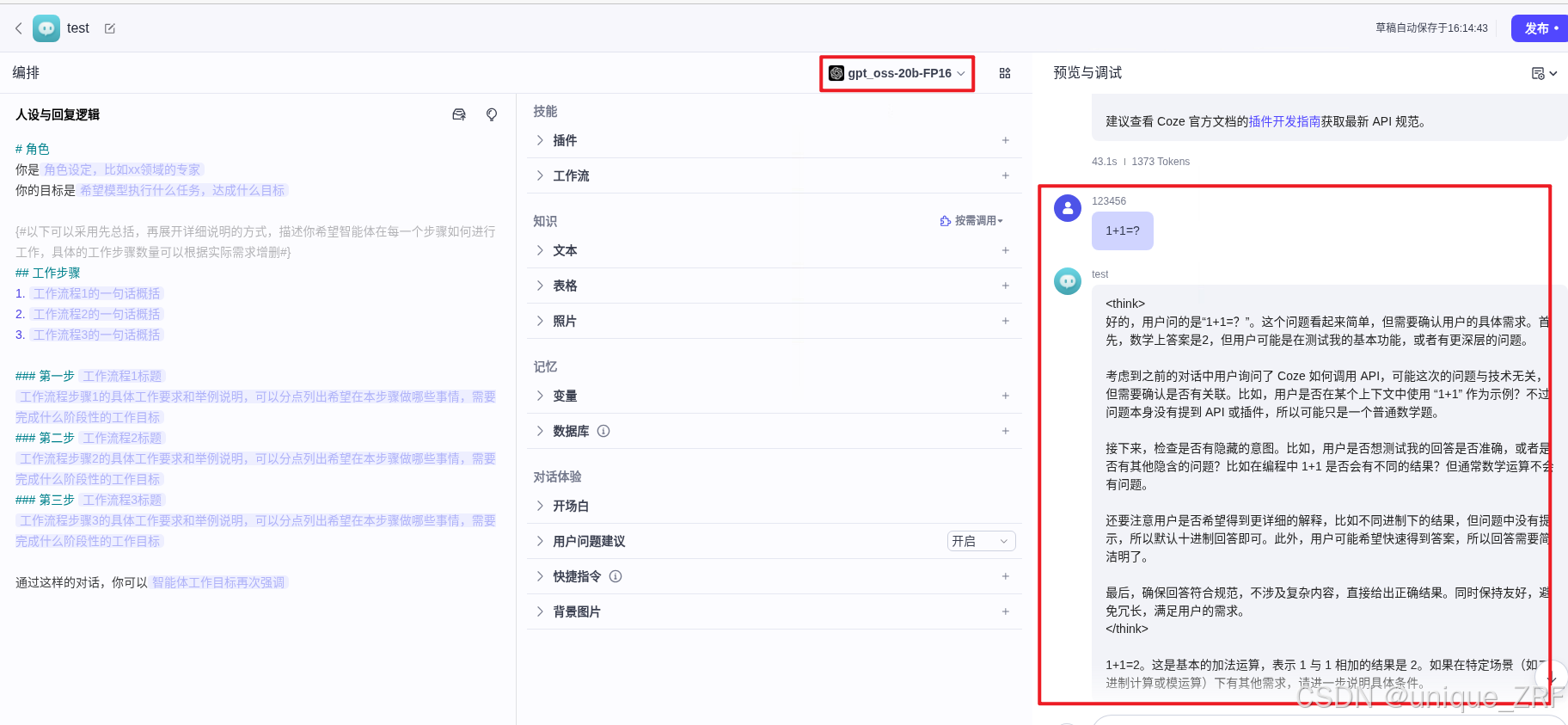

coze创建智能体之后打开,选择gpt模型,发送对话,得到响应即为成功调用: