大模型是如何“学会”思考的?——从预训练到推理的全过程揭秘

你有没有想过,当你说“帮我写一封辞职信,语气要礼貌但坚定”,大模型是如何理解你的意图,并生成一段逻辑清晰、语言得体的文字的?

它真的在“思考”吗?还是只是在“背答案”?

今天,我们就来揭开大模型背后的神秘面纱,带你从预训练到推理,完整走一遍大模型“学会思考”的全过程。全程不用公式,不堆术语,用一张图+通俗语言,让你真正看懂AI是如何“变聪明”的。

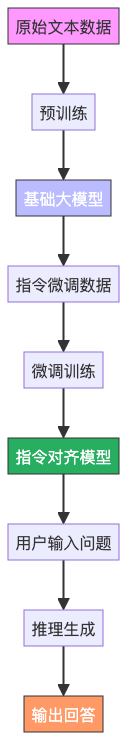

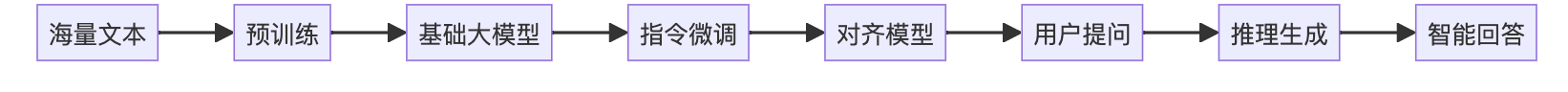

一、大模型的“成长”分三步:预训练 → 微调 → 推理

我们可以把大模型的成长过程,类比成一个人类学生的学习路径:

- 预训练:相当于“读万卷书”——在海量文本中学习语言规律。

- 微调:相当于“拜师学艺”——在特定任务中精进技能。

- 推理:相当于“实战答题”——面对新问题时给出答案。

下面这张流程图,清晰展示了整个过程:

接下来,我们一步步拆解。

二、第一步:预训练——让模型“读”遍互联网

目标:学会语言的基本规律,比如语法、常识、上下文关系。

怎么做?

模型被喂入海量的文本数据——维基百科、书籍、新闻、论坛帖子……可能高达上万亿个单词。它并不知道这些内容“对不对”,但它要完成一个任务:预测下一个词。

举个例子:

输入:“中国的首都是______”

模型的任务是猜出“北京”。

在这个过程中,模型不断调整内部参数,逐渐学会:

- “首都”通常跟国家名搭配;

- “中国”和“北京”经常一起出现;

- 句子结构如何组织才通顺。

经过数月甚至数年的训练,模型就形成了一个庞大的“语言知识库”,我们称之为基础大模型(如GPT-3、LLaMA等)。

📌 关键点:预训练不教模型“做什么”,而是教它“理解语言”。

三、第二步:微调——教会模型“听懂人话”

预训练后的模型虽然知识丰富,但它更像是一个“书呆子”——你问它问题,它可能继续“续写”而不是回答。

比如你输入:“2+2等于多少?”,它可能接一句:“一个简单的数学问题……”

所以,我们需要微调(Fine-tuning),特别是指令微调(Instruction Tuning)。

怎么做?

我们给模型看大量“问题-答案”对,比如:

- 问:“写一首关于春天的诗”

- 答:“春风拂面花自开,柳绿桃红映山川……”

通过这样的训练,模型学会:

- 用户输入是“指令”;

- 我的任务是“响应”而不是“续写”;

- 回答应符合意图、结构清晰、语气得当。

微调后的模型,就变成了我们日常使用的“对话AI”——比如ChatGPT、通义千问等。

📌 关键点:微调让模型从“语言专家”变成“服务专家”。

四、第三步:推理——模型的“临场发挥”

当你在对话框里输入一个问题,比如:“帮我规划一个三天的杭州旅行行程”,模型就开始了推理过程。

这个过程不是查数据库,而是基于它学到的知识和模式,一步步生成回答。

推理的内部机制:

- 理解输入:模型将你的问题转化为数学向量(语义编码);

- 激活知识:根据上下文,调用相关的地理、旅游、时间安排等知识;

- 逐步生成:一个词一个词地输出,每一步都预测“最合理”的下一个词;

- 控制逻辑:通过“注意力机制”确保前后连贯,比如第一天不去“第三天”的景点。

整个过程像下棋:每走一步,都考虑全局,确保最终结果合理、通顺、有用。

📌 关键点:推理不是检索,而是创造性的生成。

五、它真的在“思考”吗?

严格来说,大模型没有意识,也不会像人类一样“理解”世界。

它的“思考”,更像是一种极其复杂的模式匹配和概率推理。

但它表现出的逻辑性、创造力和语言能力,已经足以让我们感觉它“像在思考”。

这就像飞机不会拍翅膀,但依然能飞——我们不必拘泥于“是否真的思考”,而更应关注它能为我们做什么。

六、总结:大模型的“思考”之路

我们再回顾一下全过程:

- 预训练:学语言;

- 微调:学听话;

- 推理:学回答。

三步走完,一个“能说会道”的AI就诞生了。

写在最后

大模型的“思考”,不是一蹴而就的奇迹,而是一场精心设计的学习旅程。

它没有灵魂,却有智慧的影子;它不懂情感,却能写出动人的文字。

未来,随着技术进步,这种“类思考”能力会越来越强。而我们要做的,不仅是理解它如何工作,更要学会如何与它协作,让AI真正成为人类智慧的延伸。

如果你觉得这篇文章帮你理清了思路,欢迎点赞、转发,让更多人看懂AI的“大脑”是如何炼成的。