强化学习-CH6 随机近似

强化学习-CH6 随机近似

6.1 Robbins-Monro(RM)

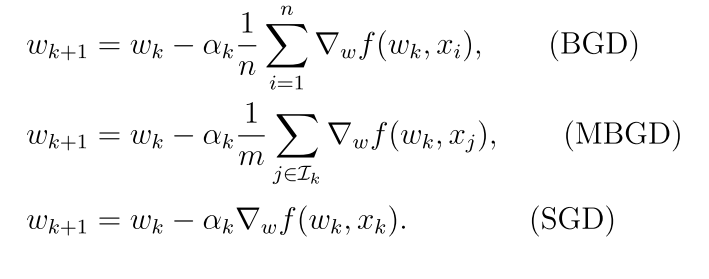

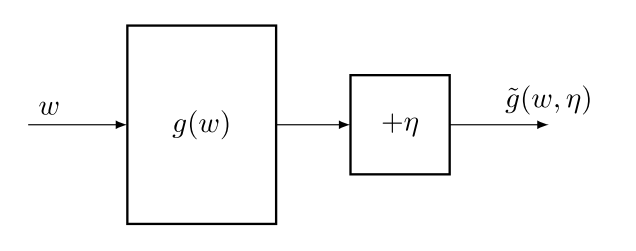

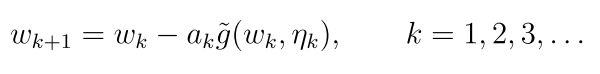

解根问题

g(w) = 0 不知道g函数的具体表达形式,只知道当给定一个输入时会给输出

算法求解:(迭代算法)

6.1.1 在期望值估计问题中的应用

求解E[X]

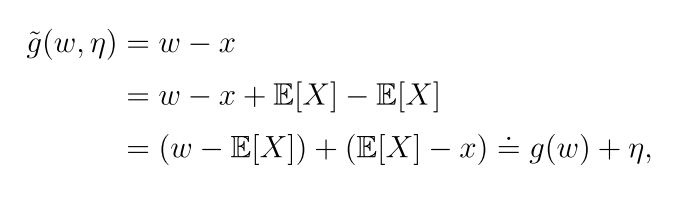

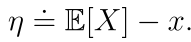

其中

算法求解

6.2 随机梯度下降(SGD)

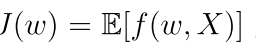

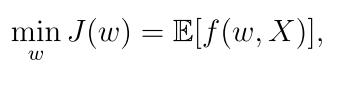

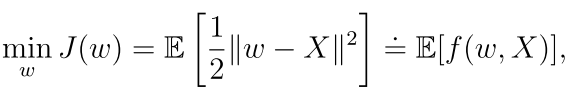

SGD是一种特殊的RM算法,考虑下面的最优化问题:

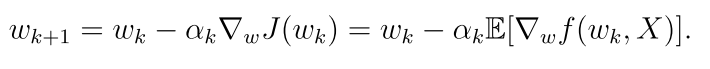

X是一个随机变量,w是参数,用梯度下降算法求解如下;

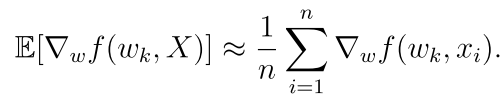

而E往往是不知道的,所以根据大数定律可知

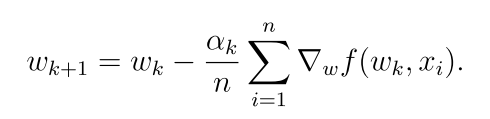

梯度下降算法为:

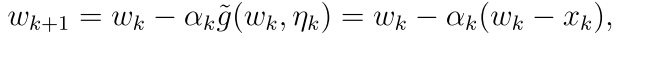

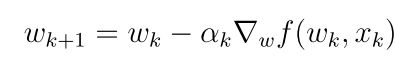

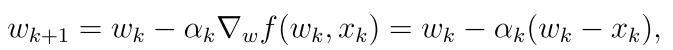

然后他需要一次迭代中的所有样本,可以每采集一个样本就更新一次(下面就是SGD算法)

6.2.1 在期望值估计问题中的应用

求解下面最优化问题:

随机梯度下降算法求解:

6.3 BGD ,SGD 和 mini-batch GD

最小化下式