3D生成模型-NeRF:用神经辐射场定义视图合成

论文题目:NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis(将场景表示为视图合成的神经辐射场)

会议:ECCV2020

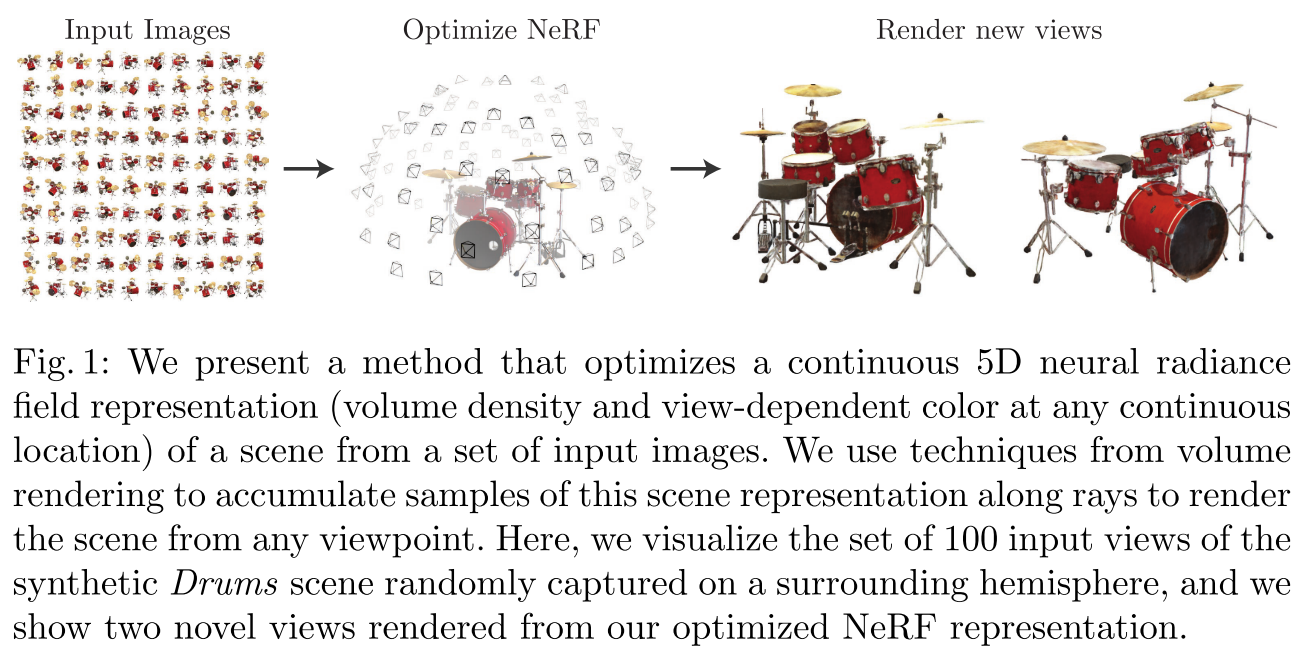

摘要:我们提出了一种方法,通过使用稀疏的输入视图集优化底层连续体场景函数,实现了合成复杂场景新视图的最先进结果。我们的算法使用全连接(非卷积)深度网络表示场景,其输入是单个连续的5D坐标(空间位置(x, y, z)和观看方向(θ, φ)),其输出是该空间位置的体积密度和视图相关的发射辐射。我们通过沿相机光线查询5D坐标来合成视图,并使用经典的体绘制技术将输出颜色和密度投影到图像中。因为体绘制是自然可微的,优化我们的表示所需要的唯一输入是一组已知相机姿势的图像。我们描述了如何有效地优化神经辐射场,以呈现具有复杂几何和外观的场景的逼真新颖视图,并展示了优于先前神经渲染和视图合成工作的结果。视图合成结果最好以视频的形式观看,因此我们敦促读者观看我们的补充视频以进行令人信服的比较。

代码链接:通过网盘分享的文件:instant-ngp

链接: https://pan.baidu.com/s/1-wWEdJE8Jo04yPtBgrFe7A?pwd=n1f2 提取码: n1f2