[Sync_ai_vid] UNet模型 | 音频特征提取器(Whisper)

第2章:LatentSync UNet模型

在第1章:唇形同步推理流程中,我们了解到唇形同步推理流程如同电影导演,协调各"专家模块"生成完美唇形同步视频。

本章将深入解析这个"工作室"中最核心的专家——LatentSync UNet。

模型定位

想象一位精通面部绘制(尤其是嘴部)的艺术家。

这位艺术家的任务不是绘制全新面部,而是基于原始嘴部动作和参考图像,巧妙调整现有绘画中的嘴部运动以匹配新音频。这正是LatentSync UNet的核心功能——作为LatentSync的核心生成模型。

核心输入输出:

- 含噪潜在视频帧:模糊不清的视频帧潜在表征

- 音频线索:描述发音特征的数值化提示(如

"P"音需闭唇,"O"音需圆唇) - 参考图像:保持面部一致性的基准

通过精修这些含噪帧,基于音频线索微调,最终输出唇音完美同步的新视频帧。

"潜在"空间的意义

如第1章所述,"潜在"空间是AI模型处理复杂数据(如图像/视频)的压缩编码空间。相比直接处理数百万像素,UNet在此高效空间操作,大幅提升处理速度。

架构原理:U-Net结构

LatentSync UNet基于U-Net神经网络架构(因结构形似字母"U"得名):

- 下采样路径(U型左侧):

压缩含噪潜在视频帧,提取时空关键特征(3D卷积处理视频时序关系) - 中间块(U型底部):最核心处理层,通过**

交叉注意力机制**融合音频特征 - 上采样路径(U型右侧):结合下采样阶段的跳跃连接,

重建高清视频帧

交叉注意力机制

该机制使UNet能动态"关注"音频特征的关键部分(如特定发音对应的口型)。

类比艺术家作画时:

- 视频帧作为

query(查询向量) - 音频特征作为

key(键向量)和value(值向量)

通过交叉参考确保唇形与发音精准匹配

工作流程集成

UNet通过唇形同步推理流程调用,核心交互见以下简化代码:

# 唇形同步流程中的扩散过程循环

for j, t in enumerate(timesteps):noise_pred = self.unet(unet_input, t, encoder_hidden_states=audio_embeds).sample# 使用噪声预测精修潜在表征

每次UNet调用都逐步去除噪声,使唇形更匹配音频。该过程迭代执行(次数由num_inference_steps参数控制),直至输出清晰同步的视频

配置参数

UNet行为由configs/unet/下的配置文件定义,关键参数示例:

model:add_audio_layer: true # 启用音频处理层cross_attention_dim: 384 # 匹配Whisper模型的音频特征维度 in_channels: 13 # 输入通道数(4+1+4+4)down_block_types: # 下采样块类型- "CrossAttnDownBlock3D" # 含交叉注意力的3D块

技术实现

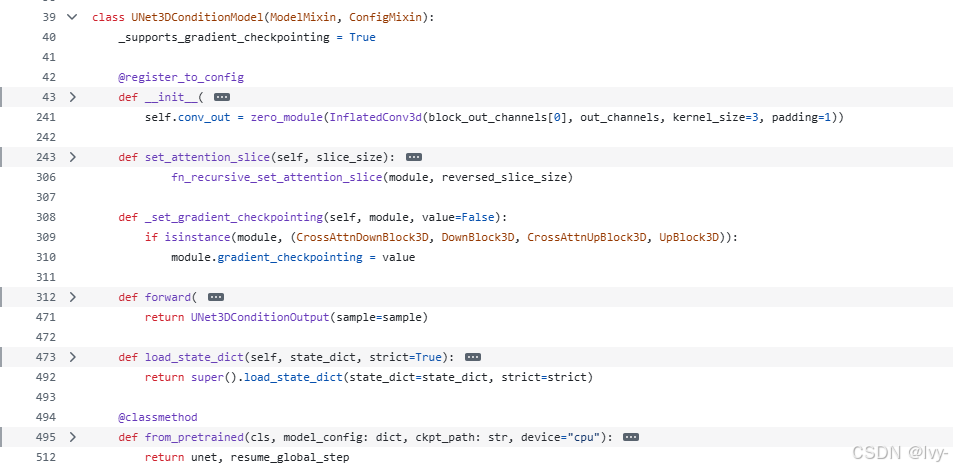

核心代码位于latentsync/models/unet.py的UNet3DConditionModel类:

1. 初始化构造

class UNet3DConditionModel(ModelMixin, ConfigMixin):def __init__(self, in_channels=13, cross_attention_dim=384):self.conv_in = InflatedConv3d(in_channels, block_out_channels[0])self.time_embedding = TimestepEmbedding(...)# 初始化下采样/中间/上采样块self.down_blocks = nn.ModuleList([CrossAttnDownBlock3D(...)])self.mid_block = UNetMidBlock3DCrossAttn(...)

2. 前向传播

def forward(self, sample, timestep, encoder_hidden_states):# 1. 时间步处理emb = self.time_embedding(timestep)# 2. 输入卷积sample = self.conv_in(sample)# 3. 下采样路径(含跳跃连接)for downsample_block in self.down_blocks:sample = downsample_block(sample, emb, encoder_hidden_states)# 4. 中间块处理sample = self.mid_block(sample, emb, encoder_hidden_states)# 5. 上采样路径for upsample_block in self.up_blocks:sample = upsample_block(sample, emb, encoder_hidden_states)return UNet3DConditionOutput(sample)

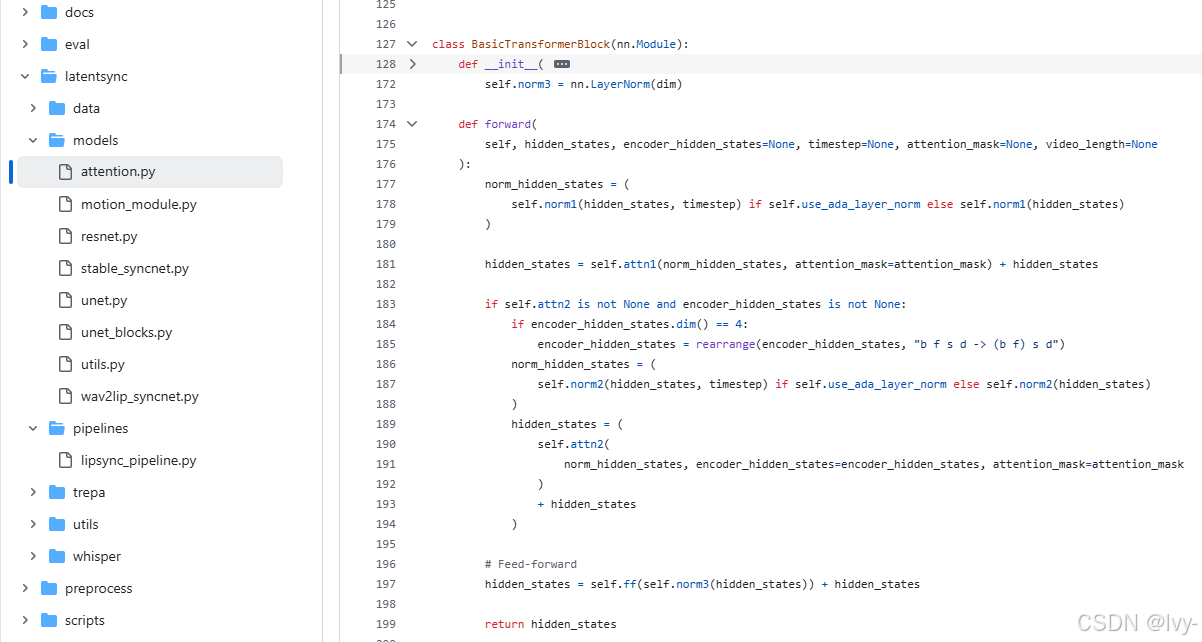

3. 核心注意力模块

位于latentsync/models/attention.py的交叉注意力实现:

class BasicTransformerBlock(nn.Module):def forward(self, hidden_states, encoder_hidden_states):# 视频特征作为query,音频特征作为key/valuehidden_states = self.attn2(norm_hidden_states, encoder_hidden_states=encoder_hidden_states) + hidden_statesreturn hidden_states

总结

LatentSync UNet作为项目的"艺术大脑",通过:

- 3D卷积处理视频时序特征

- 交叉注意力融合音频线索

多尺度跳跃连接保持画质- 迭代式潜在空间优化

实现了从异步视频到精准唇形同步的转变。

下一章将解析另一个关键模块——音频特征提取器(Whisper),其为UNet提供核心音频线索。

下一章:音频特征提取器(Whisper)

第3章:音频特征提取器(Whisper)

在探索LatentSync项目的过程中,我们已经了解了唇形同步推理流程如何像导演一样协调各模块工作,并深入研究了核心模块LatentSync UNet如何基于"音频线索"调整唇形运动。

但这些关键的"音频线索"从何而来?LatentSync如何解析音频内容以实现精准唇形同步?

这正是音频特征提取器的职责所在——它采用了名为Whisper的强大工具。

音频特征提取器(Whisper)是什么?

想象一位训练有素的听觉专家。

这位专家不仅能识别词语,更能分析发音的细微特征——音色、语调、语速甚至停顿。

随后生成一份详细的语音"蓝图",供其他系统(如我们的LatentSync UNet)用于驱动逼真的唇形运动。

LatentSync中的音频特征提取器就是这样的专业听觉系统。它采用特殊的AI模型Whisper。虽然Whisper以语音转文本(自动语音识别ASR)著称,但LatentSync仅使用其编码器模块,将原始音频转换为高维音频嵌入向量。

这些嵌入向量可视为语音的数字化"蓝图",不是具体文字,而是捕捉语音微妙特征的数值化表征。

这些特征正是UNet理解不同发音对应唇形运动的关键(例如发"o"音时的圆唇动作或发"p"音时的闭唇动作)。

为什么使用"嵌入向量"而非纯文本?

可能有人疑惑:为何不直接给UNet提供文本(如"你好")?原因很简单——纯文本包含的语音信息不足。

对比以下两个句子:

- “什么?”(快速疑问语气)

- “什么。”(缓慢陈述语气)

文字相同但发音特征迥异,对应的唇形运动也不同。

音频嵌入向量能捕捉这些细微差别——编码音素(最小语音单位)、韵律(节奏/重音/语调)等丰富信息,指导UNet生成自然精准的唇形动作。

长音频处理与效率优化(分块与缓存)

视频可能很长,逐帧处理音频特征效率低下。音频特征提取器进行了专门优化:

- 分块处理:不一次性处理完整音频,而是

将音频特征切分为对应短视频片段的"块",使处理更高效 - 特征缓存:

提取后的特征会被保存。当相同音频再次处理时可直接读取缓存,节省大量计算资源

流程集成方式

如第1章所述,唇形同步推理流程是总调度者,它指示音频特征提取器获取所需音频线索:

# 唇形同步流程核心代码片段

whisper_feature = self.audio_encoder.audio2feat(audio_path)

whisper_chunks = self.audio_encoder.feature2chunks(feature_array=whisper_feature, fps=video_fps)

audio2feat():提取完整音频特征"蓝图"feature2chunks():将特征切分为UNet可处理的片段

技术实现

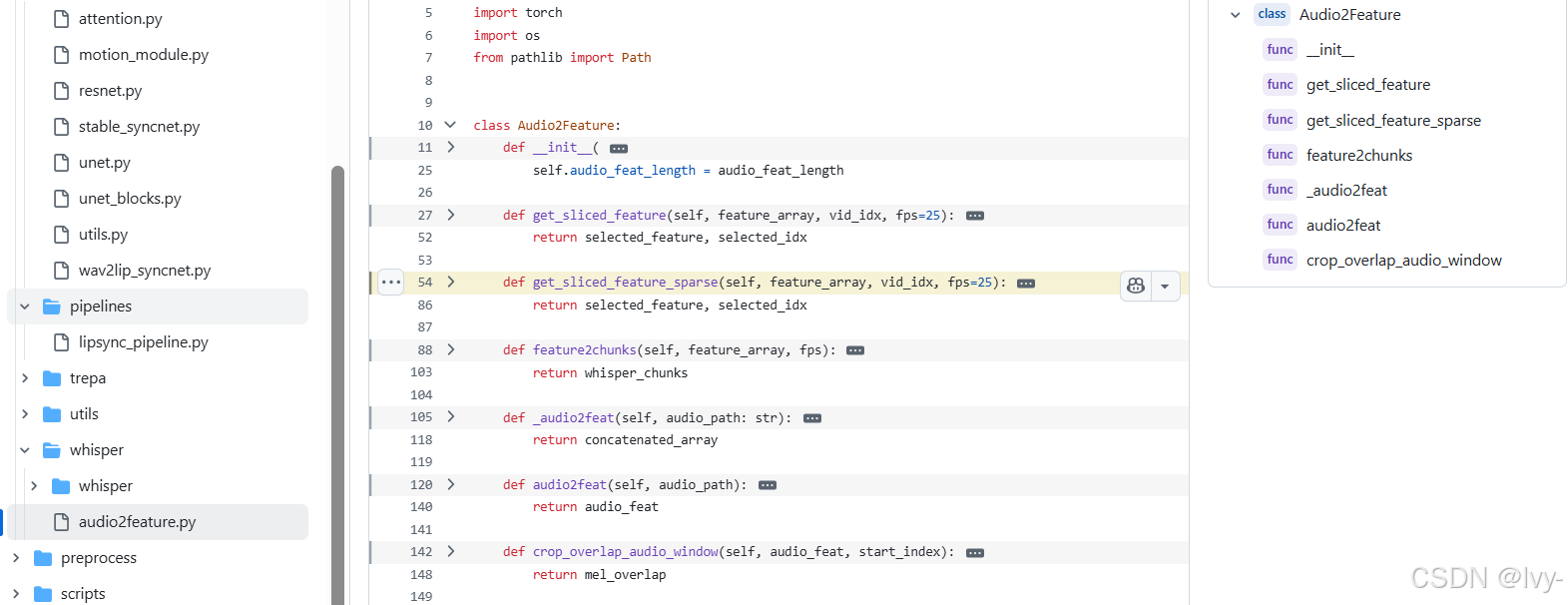

核心代码位于latentsync/whisper/audio2feature.py:

1. 初始化构造

class Audio2Feature:def __init__(self, model_path="checkpoints/whisper/tiny.pt"):self.model = load_model(model_path) # 加载轻量版Whisper模型self.audio_embeds_cache_dir = None # 特征缓存目录

2. 特征提取与缓存

def audio2feat(self, audio_path):if 特征已缓存:return 读取缓存else:features = self._audio2feat(audio_path) # 实际特征提取保存缓存(features)return features

3. Whisper核心处理

def _audio2feat(self, audio_path):result = self.model.transcribe(audio_path) # 调用Whisper模型return result["encoder_embeddings"] # 提取编码器嵌入向量

4. 特征分块处理

def feature2chunks(self, feature_array, fps):# 按视频帧率切分音频特征return [self.get_sliced_feature(feature_array, i, fps) for i in range(总帧数)]

总结

音频特征提取器(Whisper)是LatentSync的"听觉中枢",它:

- 利用Whisper编码器生成富含

语音特征的嵌入向量 - 通过智能缓存大幅提升处理效率

- 将长音频

切分为UNet可处理的时序块 - 为唇形同步提供精准的发音特征指导

下一章将介绍另一位重要"专家"——SyncNet唇形同步评判器,它负责确保生成的唇形动作达到最佳真实感。

下一章:SyncNet唇形同步评判器