浅聊RLVR

一、概述

RLVR,Reinforcement Learning from Verifiable Rewards,可验证奖励的强化学习,是向大语言模型注入学习策略的主要训练策略之一,也是时下最主流的RL方法,很多主流的大模型都在后训练中采用了这种方法。

那么,究竟什么是RLVR呢?他和之前的RL方式有什么区别?他的核心算法是什么?他有什么优势?他的局限性又在哪里?下文开始探讨。

二、什么是RLVR?ta与传统的RL区别在哪?

首先,RL的根本是提高采样效率,但是传统的RL需要依赖人类标注或者复杂的奖励模型,但是RLVR改变了这点,他不需要上述的条件,而是通过规则化验证器生成二元反馈(0/1)。根据任务的类型,可验证类型分为三类:

1、正确性验证:通过模型输出和标准答案做匹配来生成奖励。

2、执行验证:通过代码解释器执行生成的代码,根据单元测试结果提供奖励。

3、可验证约束:强制模型遵循输出格式或者拒绝不当的请求,违法规则奖励则为0.

相较于传统的RLHF来说,由于RLVR使用的是可验证奖励,他是基于客观规则的,所以很难被策略模型所欺骗,难以被过度优化;其次不需要人工标注的情况下,节省成本,适合自动化的部署。

不过由于非常依赖于真实答案或者标准答案,所以很难推广到一些开放性的问题上,比如创作写作等场景。

三、核心算法

GRPO是RLVR的核心算法,相对于传统的PPO算法,GRPO的优势估计和策略更新机制上具有独特之处。PPO是通过学习一个评估器来估计,而GRPO是利用蒙特卡洛滚动从旧策略中采样来估计优势,这种情况下,GRPO可以更高效的利用数据。特别是LLM训练中,GRPO的白化处理可以进一步的提高训练的稳定性。

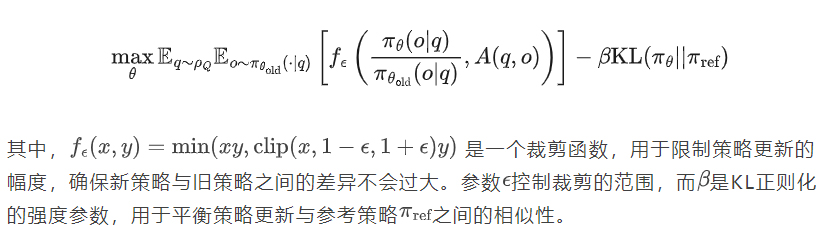

对于GRPO算法,优化目标可以表示为:

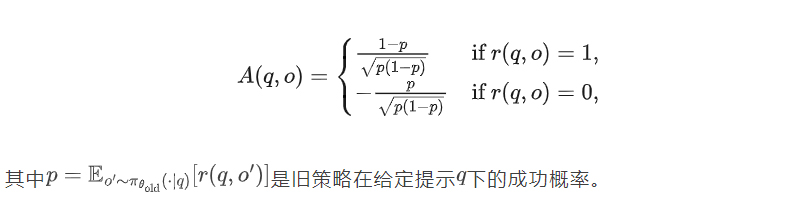

而可验证的二元特征可以表示为:

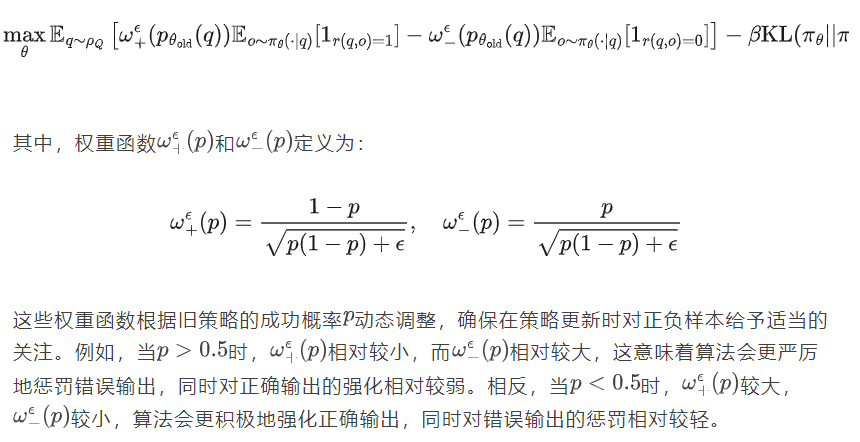

代入优化目标后,可以将优化目标改写为:

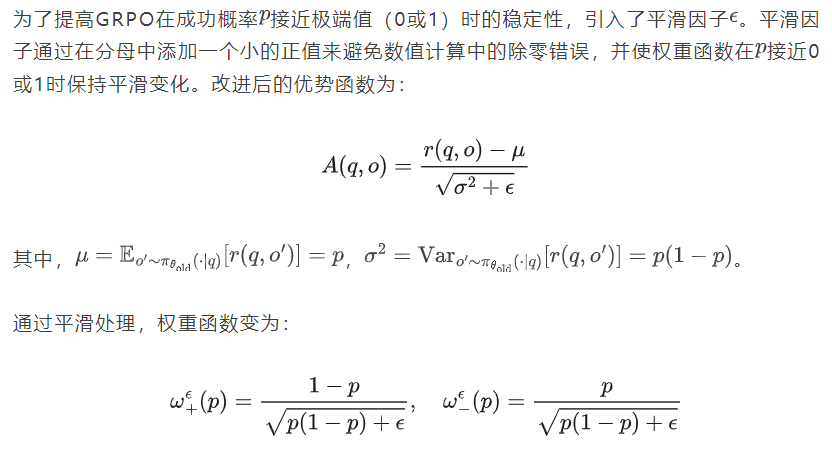

为了防止权重函数出现剧烈波动,需要加入平滑因子。

四、RLVR优势与局限

优势在于在提高了采样效率,也就是在少量次数的尝试下就可以得到目标答案,不过RLVR很难突破基座模型的能力上限,也就是基模无法解决的问题,RL训练后依旧难以解决(在大模型上,传统RL可以不断发现新策略)。

参考论文:https://arxiv.org/pdf/2504.13837

参考文献:https://www.51cto.com/article/816993.html