centerpoint训练过程

原文已经发表在知乎,辛苦移步~《centerpoint训练过程》

最近几天把centerpoint的训练流程又走了一遍,记录笔记如下。

算法版本:

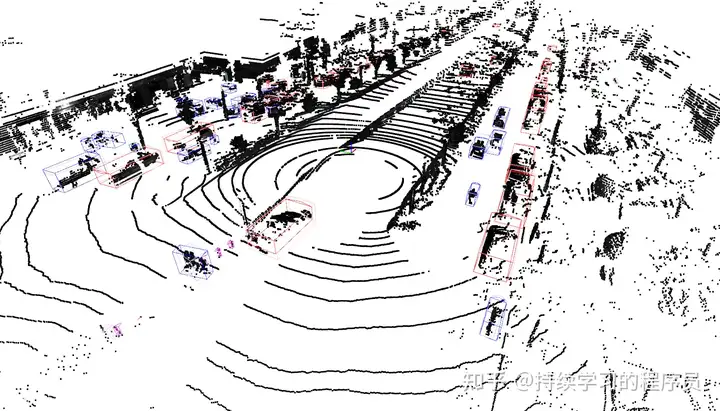

用的centerpoint版本配置是:cpdet_0.2_84.8m_dv_bev_second_secfpn_dw4_4cls_1tsk,也就是栅格大小0.2米,检测范围84.8米,动态体素化,bev pillar模式,second和secfpn分别是backbone和neck,4倍下采样,4个类别,1tsk就是所有类别在一起预测。按经验来看,不同类别分开预测效果会更好,例如车和行人,大小是不一样的,4倍下采样也就是意味着0.8米的栅格内只能存在一个目标,对小目标不太友好。不过做实验,就拿了以前用过的一版配置直接就跑起来了。

数据集:

数据集一:以前项目中使用的数据量有大几十万帧,但由于算力和时间有限,取了其中的2万帧做实验。类别有四类:机动车,非机动车,行人,交通锥桶。评测集有2k帧。

数据集二:在数据集一的基础之上,再叠加四万帧,共6万帧。类别同上。评测集也同上。主要是测试一下数据量增加后会对效果产生什么影响。

训练步骤:

1,版本一:就是base版本,用数据集一直接跑,看看2万帧能跑出什么指标来。共跑了10个epoch,单3090卡跑一个epoch得2.5小时。指标如下图,mAP计算用bev iou的阈值是:Car(0.5) Pedestrian(0.25) Bicycle(0.25) TrafficCone(0.25),括号后面是匹配的IOU。详细指标放在文末的附录中。