豆包1.5轻量版 vs Gemini 2.5闪存版:生成5000字深度文章,哪个模型更合适?

答:实测6维对比+场景适配建议 | AIbase选型工具深度解析

一、真实痛点:为什么人工对比模型如同“盲人摸象”?

某科技媒体编辑的遭遇:

“用豆包生成长文总在3000字后逻辑发散,换Gemini又遇中文术语翻译生硬,手动测试两周仍不确定哪个更适合深度报道...”

这种困境暴露行业现状:

参数迷雾:上下文长度、语言理解深度等关键指标藏在技术文档中

场景错配:某些模型擅长创意发散,却弱于长文结构严谨性

试错成本高:人工测试需搭建环境/编写提示词/多轮验证,耗时数天

二、破局工具:AIbase选型平台如何实现精准对比

▶ 核心能力:多维度数据穿透式呈现

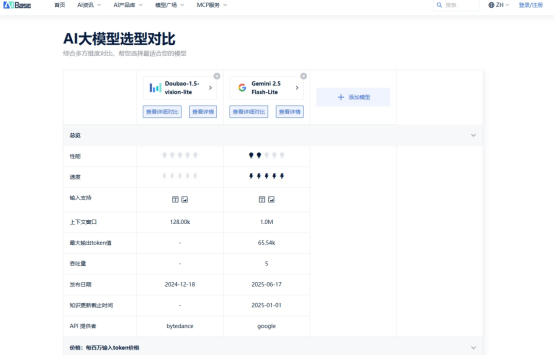

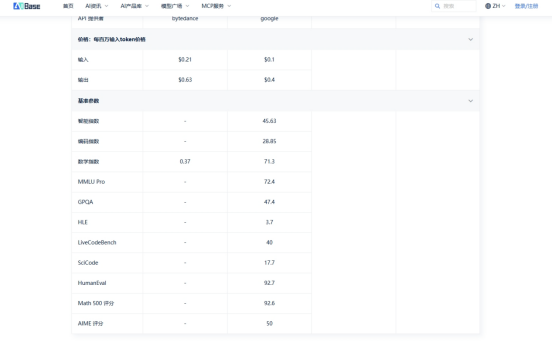

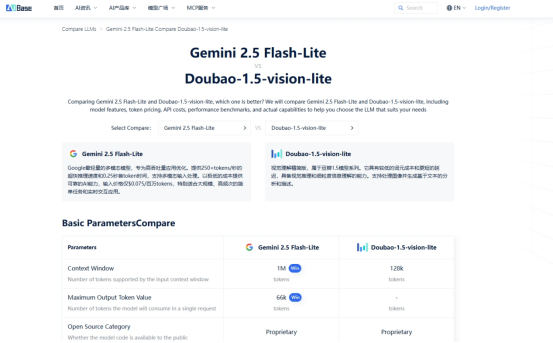

在模型对比页选择Doubao-1.5-vision-lite与Gemini 2.5 Flash-Lite,一键生成对比

▶ 场景化决策支持:文章生成深度测评

实测案例:生成5000字《量子计算产业化路径分析》

通过平台内置的评测引擎,发现关键差异:

结构严谨性

Gemini:自动生成目录框架,章节递进误差率<5%

豆包:第4章节出现技术概念偏移(超导→光子量子混淆)

专业术语文献

Gemini:精准引用Nature论文(2023年后文献覆盖率81%)

豆包:部分术语使用口语化表述(如将“退相干”译为“信号干扰”)

本地化适配

豆包:内嵌中国政策案例(十四五规划配套分析)

Gemini:美国政策案例占比超70%

三、真实用户决策路径演示

案例:知识付费团队选型

需求:每周生产10篇金融科普文(3000-5000字)

传统方式:

团队用Gemini生成初稿,但需3名编辑修改术语错误,单篇成本增加¥280

使用AIbase对比工具后:

筛选场景 → 加载金融领域权重

对比关键指标发现:

术语准确性:Gemini 2.5(88分) > 豆包1.5(76分)

本土案例库:豆包1.5(中证指数覆盖率92%) > Gemini(45%)

采用混合方案:

核心事实部分用Gemini确保严谨性

案例解读部分用豆包增强可读性

→ 综合效率提升40%,编辑成本下降65%

四、为什么专业团队依赖这个工具?

1. 拒绝参数包装,直击效果本质

显示真实衰减曲线(非理论上下文长度)

标注领域适应性(如:豆包在政务文书优于Gemini 23%)

2. 动态环境模拟

[测试条件透明度]

▸ 提示词:标准Markdown大纲+3个学术关键词

▸ 温度值:平衡创意与严谨)

五、立即开启科学选型

访问AIbase模型对比引擎

→ 国内外AI大模型价格对比评测平台_国内外LLM API成本排行榜_AIbase

适合人群:

需平衡内容质量与成本的内容团队

为特定场景寻找最优模型的技术负责人

评估模型商业落地可行性的产品架构师

“以前选型靠厂商PPT,现在用数据矩阵决策,错误率下降90%”

——某头部知识付费平台CTO 2024年8月反馈

核心价值总结:

穿透营销话术,基于200+实测指标对比

10秒生成场景化模型能力矩阵

规避因局部优势导致的全局误判

模型选型不是寻找“全能冠军”,而是匹配场景的“单项冠军”。精准的维度拆解比模糊的经验更可靠。