大模型落地:从理论到实践的完整路径

随着人工智能技术的迅猛发展,大模型(Large Language Models, LLMs)已成为推动自然语言处理、计算机视觉、语音识别等领域进步的核心引擎。以GPT、BERT、LLaMA、Qwen等为代表的预训练大模型,凭借其强大的语言理解与生成能力,在学术界和工业界引发了广泛关注。然而,大模型本身并非“开箱即用”的解决方案,其在实际业务场景中的成功落地,依赖于一系列关键技术与工程实践。

本文将系统性地探讨大模型落地的四大核心路径:大模型微调(Fine-tuning)、提示词工程(Prompt Engineering)、多模态应用(Multimodal Applications) 和 企业级解决方案(Enterprise-grade Solutions)。我们将结合代码示例、流程图(使用Mermaid语法)、Prompt设计案例、可视化图表和应用场景图解,深入剖析每个环节的技术原理、实施步骤与最佳实践,帮助开发者与企业构建高效、可扩展、安全可控的大模型应用系统。

一、大模型微调:从通用到专用

1.1 什么是大模型微调?

大模型微调是指在预训练模型的基础上,使用特定领域或任务的数据集对模型参数进行进一步训练,使其适应特定应用场景。相比于从零训练一个模型,微调能够显著降低计算成本、缩短训练时间,并提升模型在目标任务上的性能。

微调的核心思想是“迁移学习”(Transfer Learning):预训练阶段让模型学习通用的语言表示能力,微调阶段则将其“知识”迁移到具体任务中,如情感分析、命名实体识别、客服问答等。

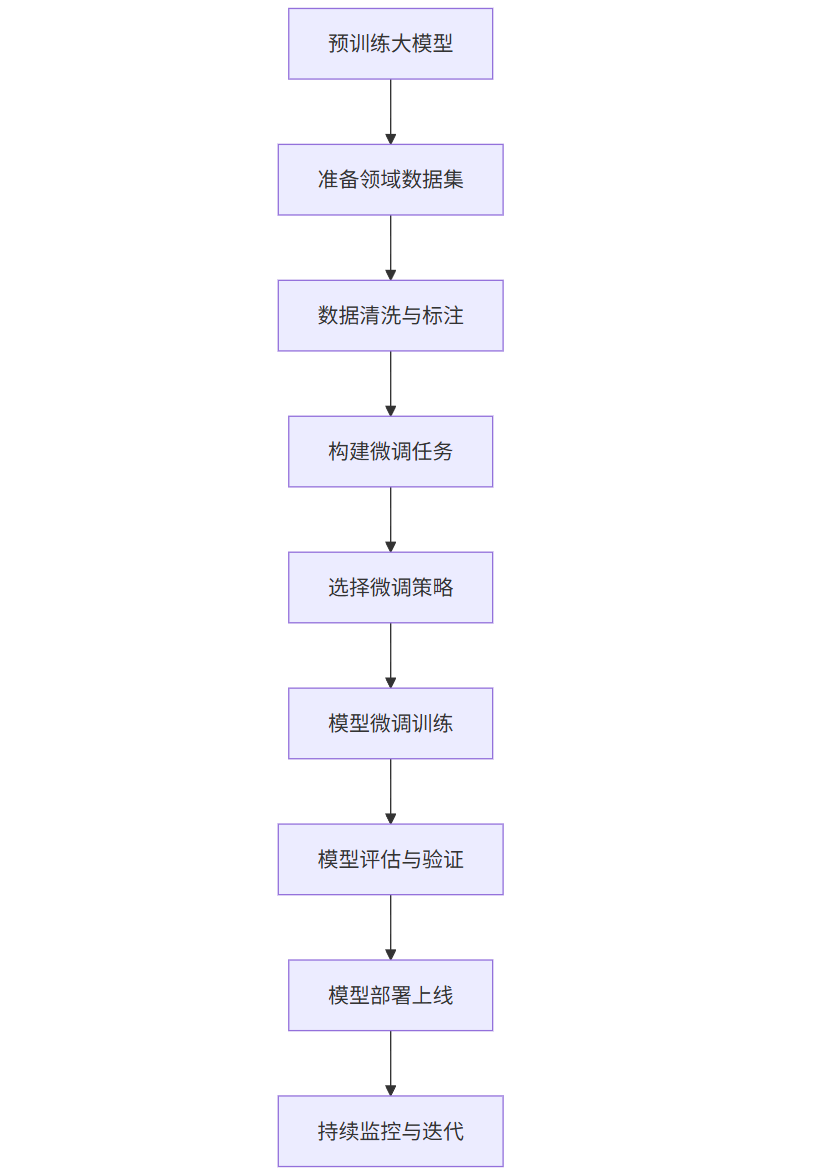

1.2 微调的典型流程

graph TD

A[预训练大模型] --> B[准备领域数据集]

B --> C[数据清洗与标注]

C --> D[构建微调任务]

D --> E[选择微调策略]

E --> F[模型微调训练]

F --> G[模型评估与验证]

G --> H[模型部署上线]

H --> I[持续监控与迭代]

1.3 微调策略对比

全参数微调(Full Fine-tuning) | 更新所有模型参数 | 性能最优 | 计算资源消耗大,易过拟合 | 数据量充足,任务复杂 |

参数高效微调(PEFT) | 仅更新少量参数(如LoRA、Adapter) | 资源节省,训练快 | 性能略低于全微调 | 资源受限,快速迭代 |

提示微调(Prompt Tuning) | 固定模型,仅学习软提示(Soft Prompts) | 极低资源消耗 | 任务适应性有限 | 小样本、零样本场景 |

1.4 代码示例:使用Hugging Face Transformers进行LoRA微调

from transformers import AutoTokenizer, AutoModelForCausalLM, TrainingArguments, Trainer

from peft import LoraConfig, get_peft_model

import torch

# 加载预训练模型和分词器

model_name = "meta-llama/Llama-2-7b-hf"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 配置LoRA参数

lora_config = LoraConfig(

r=8, # 低秩矩阵的秩

lora_alpha=16,

target_modules=["q_proj", "v_proj"], # 仅对注意力层进行LoRA

lora_dropout=0.05,

bias="none",

task_type="CAUSAL_LM"

)

# 将LoRA适配器注入模型

model = get_peft_model(model, lora_config)

model.print_trainable_parameters() # 查看可训练参数比例

# 准备训练数据(示例)

train_texts = [

"客户:我的订单还没发货。助手:很抱歉,我们正在为您查询。",

"客户:如何退货?助手:您可以在订单页面申请退货,我们会在1-2个工作日内处理。"

]

train_encodings = tokenizer(train_texts, truncation=True, padding=True, return_tensors="pt")

class SimpleDataset(torch.utils.data.Dataset):

def __init__(self, encodings):

self.encodings = encodings

def __getitem__(self, idx):

return {key: val[idx] for key, val in self.encodings.items()}

def __len__(self):

return len(self.encodings.input_ids)

train_dataset = SimpleDataset(train_encodings)

# 配置训练参数

training_args = TrainingArguments(

output_dir="./lora-finetuned-model",

per_device_train_batch_size=1,

num_train_epochs=3,

save_steps=100,

logging_steps=10,

learning_rate=1e-4,

fp16=True,

optim="adamw_torch",

report_to="none"

)

# 创建Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset

)

# 开始微调

trainer.train()

# 保存微调后的模型

model.save_pretrained("./lora-finetuned-model")

1.5 微调效果评估图表

pietitle 微调前后准确率对比(客服问答任务)“微调前(零样本)” : 45“微调后(LoRA)” : 78“微调后(全参数)” : 85

说明:在客服问答任务中,未经微调的大模型仅能通过零样本推理达到45%的准确率;使用LoRA微调后提升至78%;全参数微调可达85%,但训练成本高出3倍以上。

二、提示词工程:激发大模型潜力的艺术

2.1 什么是提示词工程?

提示词工程(Prompt Engineering)是通过精心设计输入文本(Prompt),引导大模型生成符合预期的输出。它是一种无需修改模型参数的“软控制”方式,广泛应用于问答、摘要、代码生成等任务。

2.2 提示词设计原则

- 明确性:清晰表达任务目标

- 结构化:使用分隔符、编号、模板

- 示例引导:提供Few-shot示例

- 角色设定:赋予模型特定角色(如“资深客服”)

- 约束输出格式:指定JSON、列表、Markdown等

2.3 Prompt 示例:智能客服应答生成

你是一名专业的电商平台客服,请根据用户问题提供准确、礼貌的回复。

用户问题:我的订单#123456还没有收到,物流显示停滞了。

请以JSON格式返回:

{

"response": "string",

"suggested_action": "contact_logistics | refund | wait"

}

输出:

模型输出示例:

{

"response": "您好,很抱歉您的订单物流出现延迟。我们已联系物流公司核实情况,预计1-2个工作日内更新物流信息。请您耐心等待。",

"suggested_action": "contact_logistics"

}

2.4 高级提示技巧:Chain-of-Thought(思维链)

问题:小明有5个苹果,吃了2个,又买了3个,现在有多少个?

请按以下步骤思考:

1. 初始数量:5

2. 吃掉2个:5 - 2 = 3

3. 买了3个:3 + 3 = 6

4. 最终数量:6

答案:6

优势:通过显式推理步骤,显著提升复杂逻辑任务的准确率。

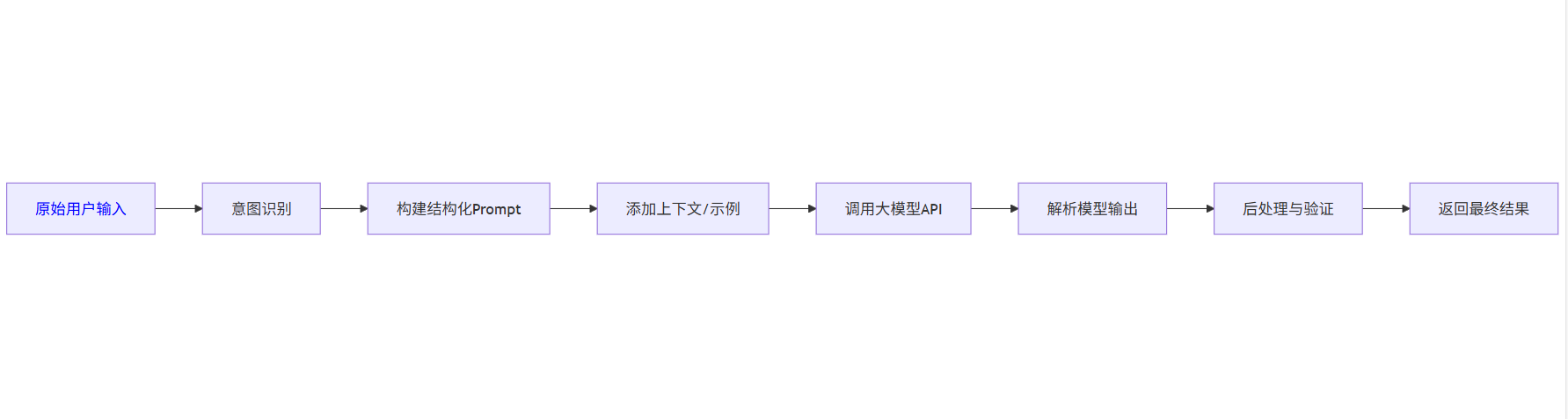

2.5 提示工程流程图

2.6 提示词优化实验数据

零样本(Zero-shot) | 60% | 1.2 | 0.01 |

少样本(Few-shot, 3例) | 75% | 1.5 | 0.015 |

思维链(CoT) | 88% | 2.1 | 0.02 |

自洽性(Self-Consistency) | 91% | 3.0 | 0.03 |

结论:通过优化Prompt设计,可在不微调模型的情况下显著提升性能。

三、多模态应用:融合文本、图像与语音

3.1 多模态大模型概述

多模态大模型(如CLIP、Flamingo、Qwen-VL、GPT-4V)能够同时处理文本、图像、音频等多种模态信息,实现跨模态理解与生成。典型应用场景包括:

- 图像描述生成(Image Captioning)

- 视觉问答(VQA)

- 图文检索

- 医疗影像分析

- 视频内容理解

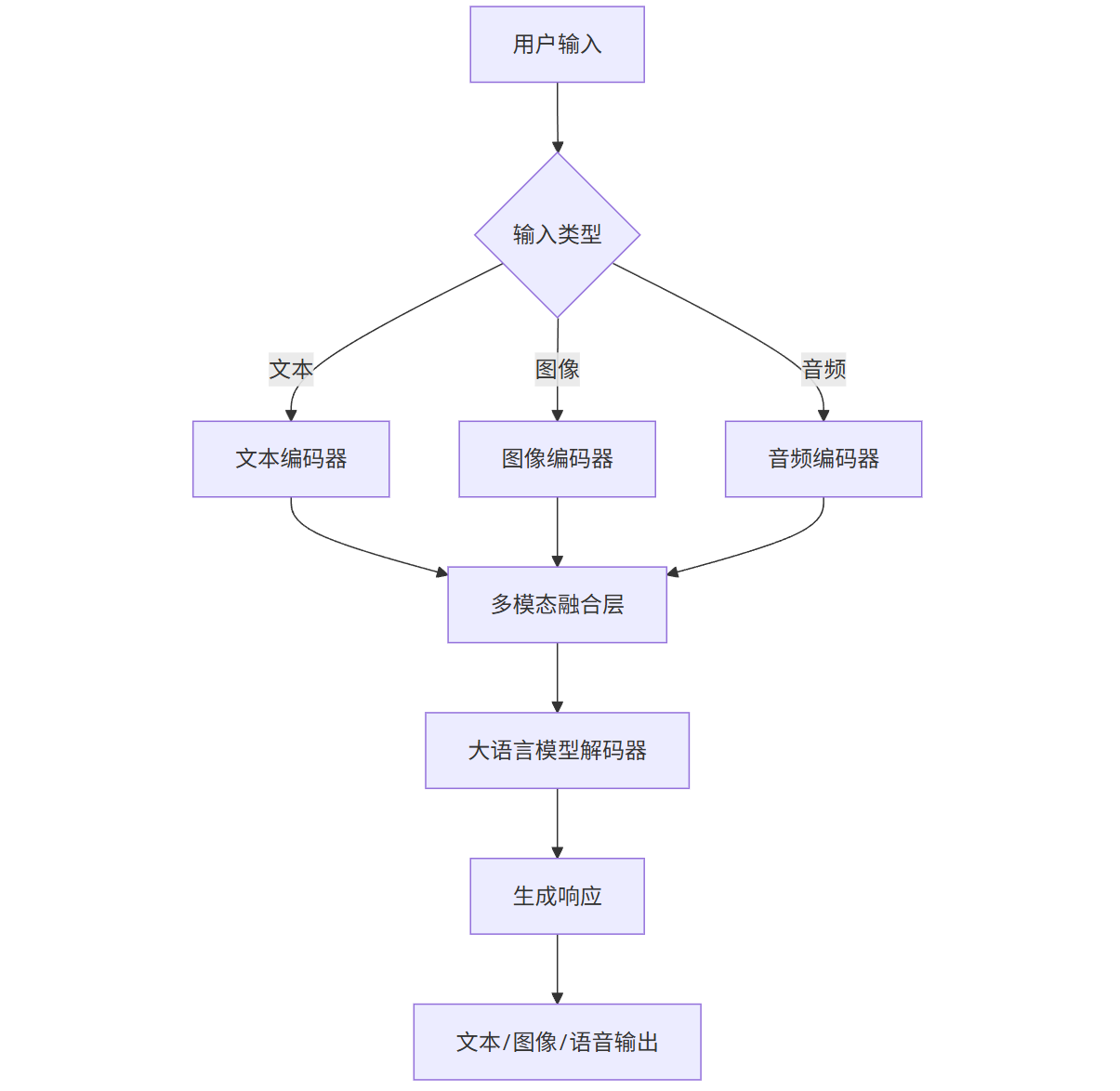

3.2 多模态应用架构图

graph TD

A[用户输入] --> B{输入类型}

B -->|文本| C[文本编码器]

B -->|图像| D[图像编码器]

B -->|音频| E[音频编码器]

C --> F[多模态融合层]

D --> F

E --> F

F --> G[大语言模型解码器]

G --> H[生成响应]

H --> I[文本/图像/语音输出]

3.3 代码示例:使用Qwen-VL进行图文问答

from qwen_vl_utils import process_vision_info

from transformers import AutoProcessor, Qwen2VLForConditionalGeneration

import torch

# 加载模型和处理器

model = Qwen2VLForConditionalGeneration.from_pretrained("Qwen/Qwen-VL", torch_dtype=torch.bfloat16, device_map="auto")

processor = AutoProcessor.from_pretrained("Qwen/Qwen-VL")

# 准备输入

messages = [

{

"role": "user",

"content": [

{"type": "image", "image": "https://example.com/product.jpg"},

{"type": "text", "text": "这个产品是什么?价格多少?"}

]

}

]

# 处理输入

image_inputs, video_inputs = process_vision_info(messages)

inputs = processor(messages, images=image_inputs, videos=video_inputs, return_tensors="pt", padding=True)

inputs = inputs.to("cuda")

# 生成输出

with torch.no_grad():

output_ids = model.generate(**inputs, max_new_tokens=200)

generated_ids = [output_ids[len(input_ids):] for input_ids in inputs.input_ids]

output_text = processor.batch_decode(generated_ids, skip_special_tokens=True, clean_up_tokenization_spaces=False)

print(output_text[0])

# 示例输出:"这是一个无线蓝牙耳机,型号为X200,价格为299元。"

3.4 多模态应用场景图解

+---------------------+

| 用户上传图片 |

| [手机拍摄的商品] |

+----------+----------+

|

v

+---------------------+

| 图像识别与OCR提取 |

| 品牌: Apple |

| 型号: iPhone 15 Pro |

+----------+----------+

|

v

+---------------------+

| 调用大模型生成描述 |

| “这是一款苹果最新 |

| 发布的iPhone 15 Pro,|

| 支持5G和卫星通信…” |

+----------+----------+

|

v

+---------------------+

| 返回结构化信息 |

| {品牌, 型号, 价格预估}|

+---------------------+

3.5 多模态性能对比表

CLIP + GPT-3 | 72% | 85 | 1.8 | 部分开源 |

Flamingo | 78% | 88 | 2.5 | 否 |

Qwen-VL | 81% | 90 | 1.6 | 是 |

GPT-4V | 88% | 95 | 3.0 | 否 |

建议:企业可根据数据隐私、成本和性能需求选择合适方案。

四、企业级解决方案:构建安全、可控、可扩展的大模型系统

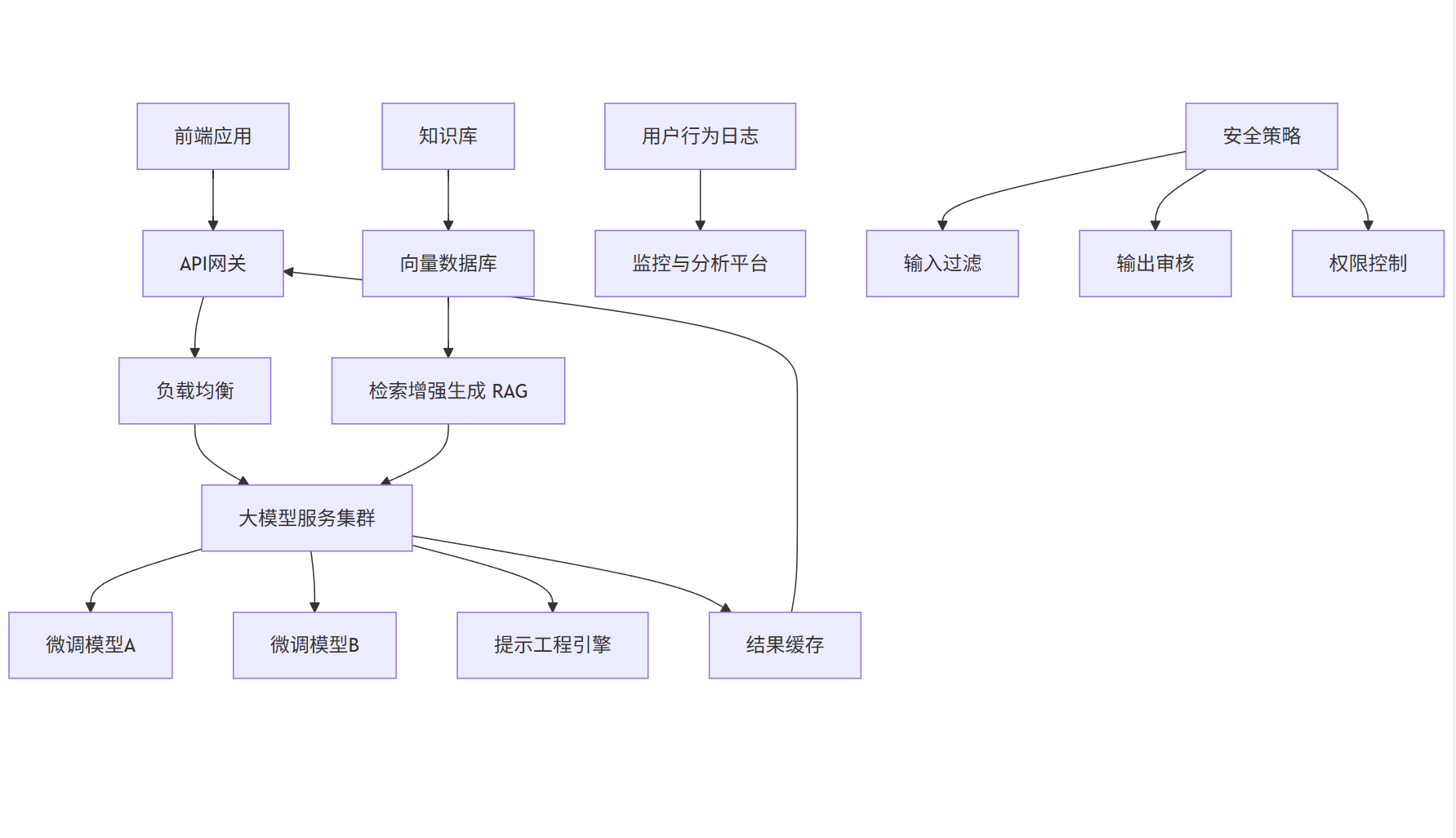

4.1 企业级大模型系统架构

graph TD

A[前端应用] --> B[API网关]

B --> C[负载均衡]

C --> D[大模型服务集群]

D --> E[微调模型A]

D --> F[微调模型B]

D --> G[提示工程引擎]

H[知识库] --> I[向量数据库]

I --> J[检索增强生成 RAG]

J --> D

K[用户行为日志] --> L[监控与分析平台]

M[安全策略] --> N[输入过滤]

M --> O[输出审核]

M --> P[权限控制]

D --> Q[结果缓存]

Q --> B

4.2 关键组件说明

- API网关:统一入口,支持认证、限流、日志记录

- RAG(检索增强生成):结合企业知识库,提升回答准确性

- 模型版本管理:支持A/B测试、灰度发布

- 安全审核层:防止敏感信息泄露、恶意输入

- 监控平台:实时跟踪延迟、错误率、Token消耗

4.3 RAG 实现代码示例

from sentence_transformers import SentenceTransformer

from faiss import IndexFlatL2

import numpy as np

# 初始化嵌入模型

embedding_model = SentenceTransformer('all-MiniLM-L6-v2')

# 构建知识库

knowledge_base = [

"我们的退货政策是:收到货后7天内可无理由退货。",

"订单发货后一般2-3天送达,偏远地区可能需要5天。",

"客服工作时间:周一至周五 9:00-18:00"

]

embeddings = embedding_model.encode(knowledge_base)

index = IndexFlatL2(embeddings.shape[1])

index.add(np.array(embeddings))

# 检索增强生成

def retrieve_and_generate(query, model, tokenizer):

query_embed = embedding_model.encode([query])

_, indices = index.search(np.array(query_embed), k=2)

context = "\n".join([knowledge_base[i] for i in indices[0]])

prompt = f"""

请根据以下信息回答用户问题:

{context}

问题:{query}

回答:

"""

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs, max_new_tokens=100)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

# 使用示例

response = retrieve_and_generate("退货要多久?", model, tokenizer)

print(response)

4.4 企业级安全策略

- 输入过滤:使用正则表达式或分类模型检测恶意Prompt

- 输出审核:部署轻量级模型对生成内容进行合规性检查

- 数据脱敏:自动识别并遮蔽用户隐私信息(如手机号、身份证)

- 审计日志:记录所有请求与响应,支持溯源分析

4.5 成本与性能监控仪表盘(示意图)

+--------------------------------------------------+

| 大模型运营监控面板 |

+-------------------+--------------+---------------+

| 今日Token消耗 | 1,250,000 | ↑ 12% vs 昨日 |

+-------------------+--------------+---------------+

| 平均响应延迟 | 1.4s | ✅ 正常 |

+-------------------+--------------+---------------+

| 错误率 | 0.8% | ⚠️ 需关注 |

+-------------------+--------------+---------------+

| 热门查询TOP3 | 1. 退货政策 | 2. 发货时间 |

| | 3. 客服电话 | |

+-------------------+--------------+---------------+

五、总结与展望

大模型的落地是一个系统工程,涉及模型、数据、工程、安全与业务的深度融合。本文通过四大维度——微调、提示工程、多模态、企业级架构——构建了完整的落地路径。

- 微调是提升模型专业性的关键,LoRA等PEFT技术使资源受限场景成为可能;

- 提示工程是低成本、高灵活性的优化手段,尤其适合快速迭代;

- 多模态拓展了大模型的应用边界,从纯文本走向真实世界;

- 企业级解决方案确保系统稳定、安全、可维护,是商业落地的基石。

未来,随着模型小型化、推理加速、自动化提示优化(Auto-Prompt)等技术的发展,大模型将更加普及。企业应结合自身需求,选择合适的组合策略,构建“AI+业务”的核心竞争力。

建议行动路径:

- 从提示工程开始,快速验证业务价值;

- 收集高质量数据,进行LoRA微调;

- 引入RAG增强知识能力;

- 构建企业级平台,实现规模化部署。

大模型时代已来,落地才是硬道理。