论文学习22:UNETR: Transformers for 3D Medical Image Segmentation

代码来源

unetr

模块作用

具有收缩和扩展路径的全卷积神经网络 (FCNN) 在大多数医学图像分割应用中表现出色,但卷积层的局部性限制了其学习长距离空间依赖性的能力。受 Transformer 在自然语言处理 (NLP) 领域近期在长距离序列学习方面取得的成功的启发,本文引入了一种名为 UNEt Transformers (UNETR) 的全新架构,它利用 Transformer 作为编码器来学习输入体的序列表征,并有效捕捉全局多尺度信息。Transformer 编码器通过不同分辨率的跳跃连接直接连接到解码器,以计算最终的语义分割输出。

模块结构

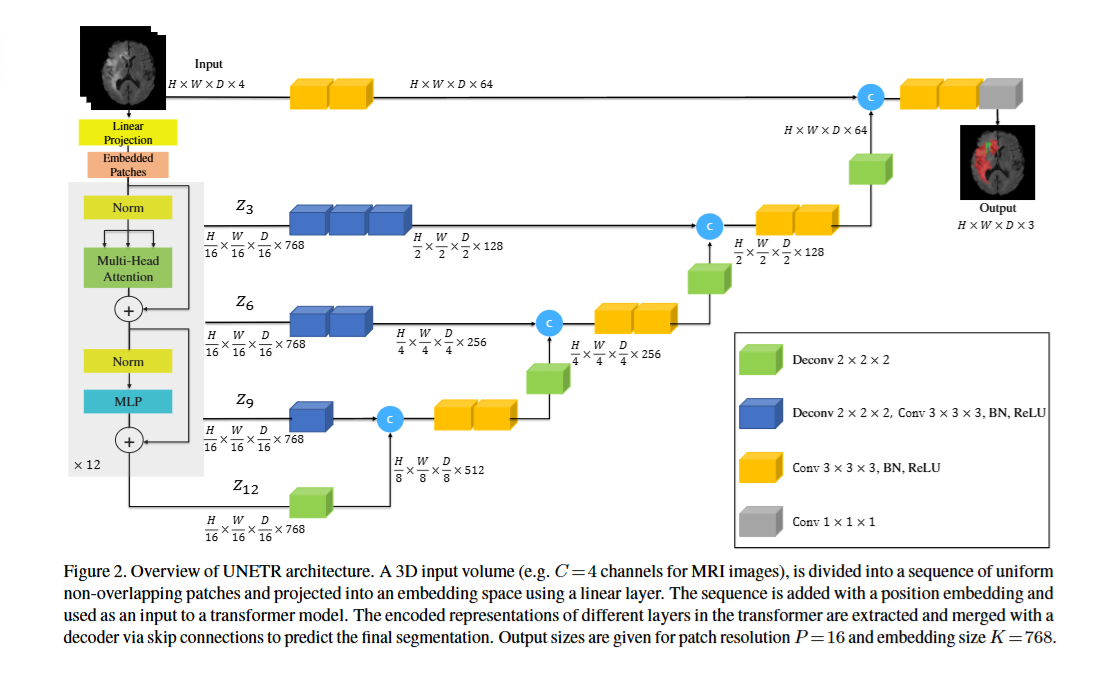

- Transformer编码器:

- 将3D图像转换为序列,学习长距离依赖和全局多尺度上下文,确保模型捕捉器官/肿瘤的变异形状和位置。

- CNN解码器:

- 通过上采样和跳跃连接恢复空间分辨率,融合全局(编码器)和局部(低级特征)信息,生成精确分割图。

总结

本文提出了一种基于Transformer的新型架构,称为UNETR,用于对体积医学图像进行语义分割,并将该任务重新表述为一维序列到序列的预测问题。研究人员提出使用Transformer编码器来增强模型学习长距离依赖关系的能力,并有效地捕捉多尺度的全局上下文表征。研究人员验证了UNETR在CT和MRI模式下不同体积分割任务中的有效性。UNETR在BTCV排行榜的标准赛和自由赛中均取得了多器官分割领域的新最高水平,并在MSD数据集上优于脑肿瘤和脾脏分割的竞争方法。总而言之,UNETR展现出了有效学习医学图像中关键解剖关系的潜力,这个方法可以作为医学图像分析中基于Transformer的新型分割模型的基础。