视觉障碍物后处理

1)视觉障碍物

传统:选择检测窗口-->提取图像特征-->设计分类器

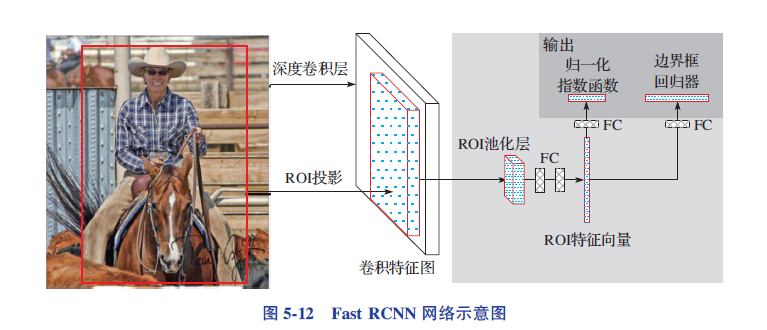

基于深度学习:CNN-based Fast RCNN 首先将图像输入CNN提取特征,在ROI中运用ROI池化层以确保每个区域的尺寸相同,最后将这些区域的特征送入全连接层进行分类,并用softmax和线性回归函数同时返回目标的bbox

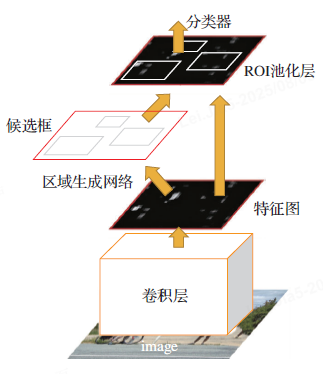

Faster RCNN 因其精度高、速度快等特点,在BEV (Bird' s Eye View) 算法流行前, 也是量

产中被改进较多的算法之一, 如在其基础上增加特征金字塔网络( Feature Pyramid Network,

FPN)、Cascade 级联技术等, 以达到量产工程化的要求。

YOLO也是经典2D图像检测

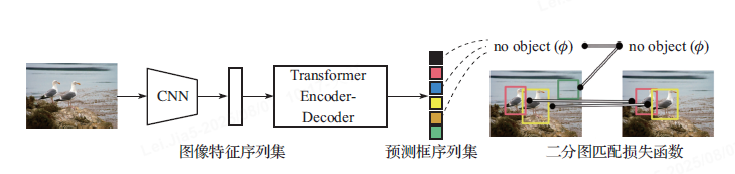

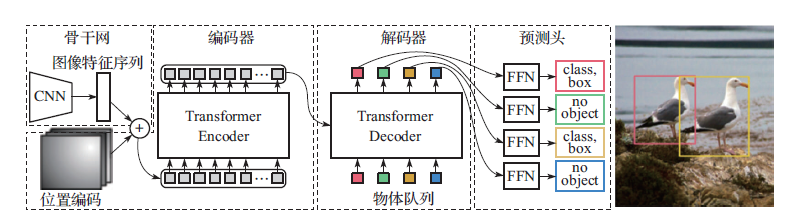

Transformer-based 目标检测方法

DETR 是Transformer-based 的开山之作, 存在很多瑕疵, 如较长的训练收敛时间、小目标识别能力不佳等

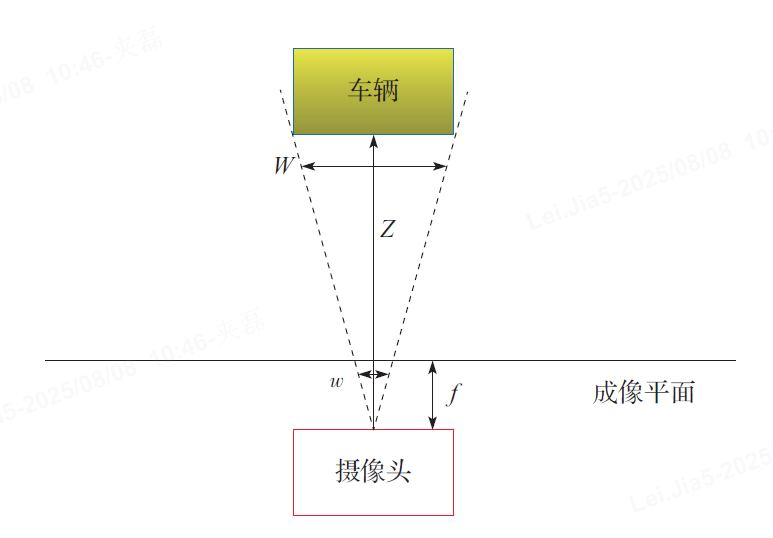

2)障碍物测距

目标检测-->2Dbox转换到3Dbox坐标系,并计算到目标在车体坐标系下的距离信息

传统:障碍物测距并不涉及深度学习模型直接推理出的3D Bbox 和深度估计信息, 而

是涉及通过像素尺寸或者物理方法进行传统意义上的距离测量。

障碍物测距方法有很多种, 包括相似三角形测距法、基于目标物理尺寸的测距法以及

车道线测距法等。这些方法的本质都离不开摄像头成像模型成像原理和对应的几何关系,

由几何关系可知, 只要世界坐标系中点P 在oc P1 → 射线上, 那么最终都会投影到图像的p 点。这意味着从3D 转换到2D 的投影过程中, 丢失了深度信息。所以, 基于传统的单目测距方法仅仅是对距离进行估算, 无法得到精准的距离信息。

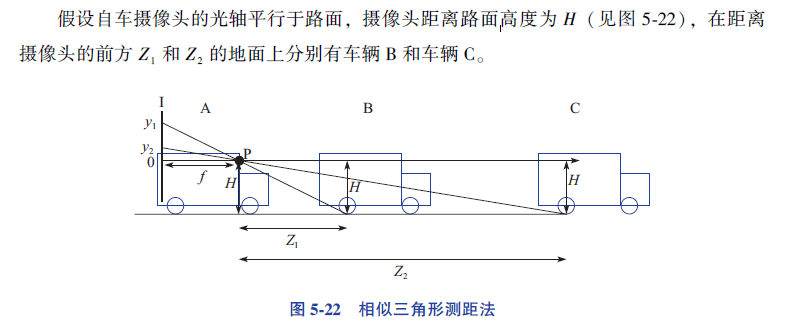

1)相似三角形测距法:

相似三角形测距法是最基本、最简便的方法。它是在已知摄像头参数内参(K)、旋转矩阵(R)、平移矩阵(T) 的前提下, 通过图像坐标p 推理得出对应的世界坐标P。

根据相似三角形的几何关系, 车辆B 的接地点在自车摄像头成像平面上的位置y1满足

所以, 车辆B 距离自车摄像头的距离Z1 可以表示为

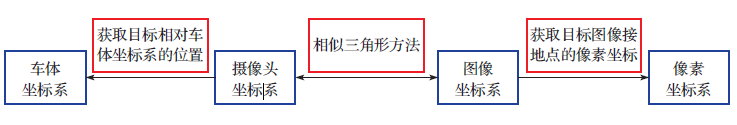

其中, f 为焦距。如图所示:这里的接地点通常指车尾/ 车头框的下底边的中心点,这里的Z1 实际为摄像头坐标系下的测量值, y1 为图像坐标系下的测量值, 所以需要将图像坐标系下的测量转换到摄像头坐标系下。另外, 由于测距通常基于车体坐标系下进行, 所以我们还需要将摄像头坐标系下的测量值转换到车体坐标系下,为了更好地统一表述, 后文不再区分像素坐标系和图像坐标

系, 如涉及像素坐标的会单独强调。

相似三角形测距法涉及坐标系转换流程:

a)自动驾驶/计算机视觉中将图像像素坐标转换为实际地面距离的核心算法,主要用于计算障碍物相对于车辆的位置(单位:米)

u0_, v0_:图像的主点坐标(即相机光学中心在图像上的投影,通常是图像中心)。image_width_, image_height_:图像的宽度和高度(像素单位)。HFOV_left_, HFOV_right_:水平视场角的左半部分和右半部分(弧度单位,总水平视场角 = 左 + 右)。VFOV_upper_, VFOV_down_:垂直视场角的上半部分和下半部分(弧度单位,总垂直视场角 = 上 + 下)。camera_height_:相机离地面的高度(通常单位为毫米)。dynamic_pitch_angle_:相机的俯仰角(弧度单位,0 表示水平向前,正数表示向下倾斜)。

计算图像点横纵距离的示例代码:

void RunDistanceWithFov(const cv::Point2f &input_pt, cv::Point2f &output_dis) {double deg_value = 0;if (input_pt.y > v0_) {deg_value = atan((input_pt.y - v0_) *2 * VFOV_down_ / image_height_);} else {deg_value = -atan((v0_ - input_pt.y) *2 * VFOV_upper_ / image_height_);}output_dis.y = (camera_height_ / tan(dynamic_pitch_angle_ + deg_value));if (output_dis.y < 0) output_dis.y = 0;double sqrt_val = sqrt(camera_height_ *camera_height_ + output_dis.y *output_dis.y);if (input_pt.x > u0_)output_dis.x = (sqrt_val * (input_pt.x - u0_) * HFOV_right_ *2 / image_width_);elseoutput_dis.x = (sqrt_val *(input_pt.x - u0_) *HFOV_left_ *2 / image_width_);output_dis.x /= 1000.0;output_dis.y /= 1000.0;

}

// 给单个点测距

void RunDistanceEstimation(const CameraParameter &config_calib,

const cv::Point2f &input_pt, cv::Point2f &output){

// 动态pitch 角

dynamic_pitch_angle_ = config_calib.pitch;

// 动态yaw 角

dynamic_yaw_angle_ = config_calib.yaw;

// 俯仰角和偏航角转换成弧度

dynamic_pitch_angle_ = (90.0 - dynamic_pitch_angle_) *3.1415926 / 180;

dynamic_yaw_angle_ = dynamic_yaw_angle_ *3.1415926 / 180;

// 输入点和去畸变输出点

std::vector<cv::Point2f> input_pts, point_undistorts;

input_pts.push_back(input_pt);

static_calib_.distortion_coeffs, cv::noArray(), static_calib_.

camera_matrix);

// 开始测距,output 是该点测距结果

RunDistanceWithFov(point_undistorts[0], output);

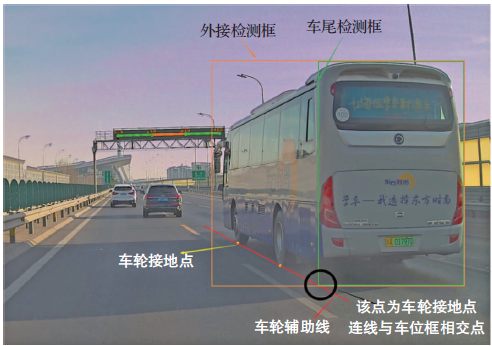

}相似三角形测距法的关键在于获取目标图像接地点的像素坐标, 而目标图像接地点一般是通过目标检测模型计算目标车辆车尾/ 车头框下底边的中心点得到的。如果接地点存在n 个像素误差, 那么测距误差公式为

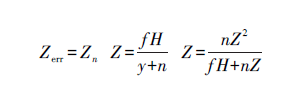

其中f 为焦距, H 为摄像头高度, n 为像素误差, Z 为目标像素相对摄像头的距离。当f H 远大于nZ 时, 测距误差随着距离的增长呈二次方增长, 误差比例则随着距离呈线性增长。

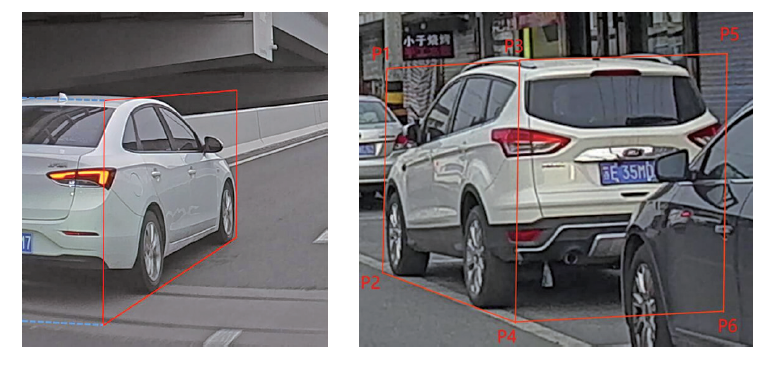

除了采用车尾/ 车头框得到的接地点进行测距外, 对于近距离的车辆, 我们还可以利

用车轮接地点进行测距。图5-25 为车轮框示意图。一般情况下, 车辆的车轮框的接地点

并不在车辆的最小外接矩形框的下底边上。相对于采用车尾/ 车头框得到的接地点, 车轮

框的接地点更准确, 所以测距的准确性也较高。

2)车道线消失点测距法

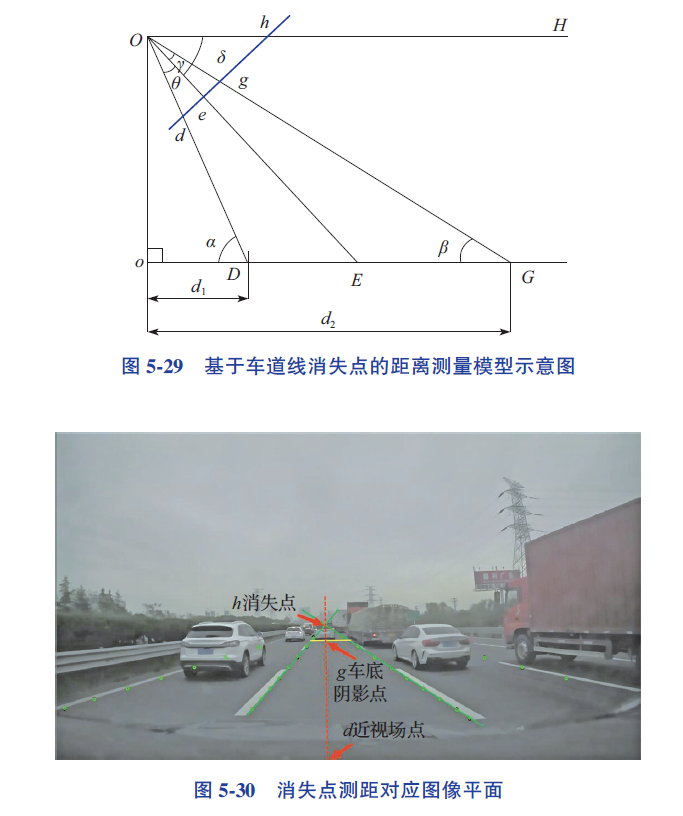

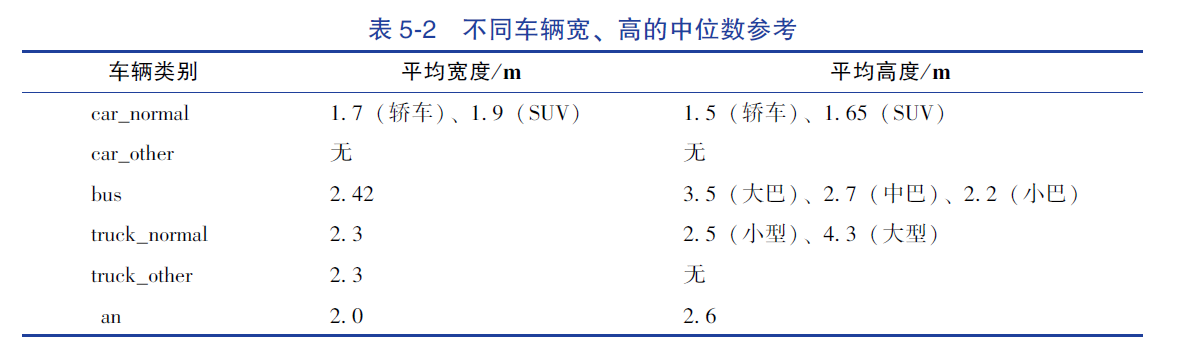

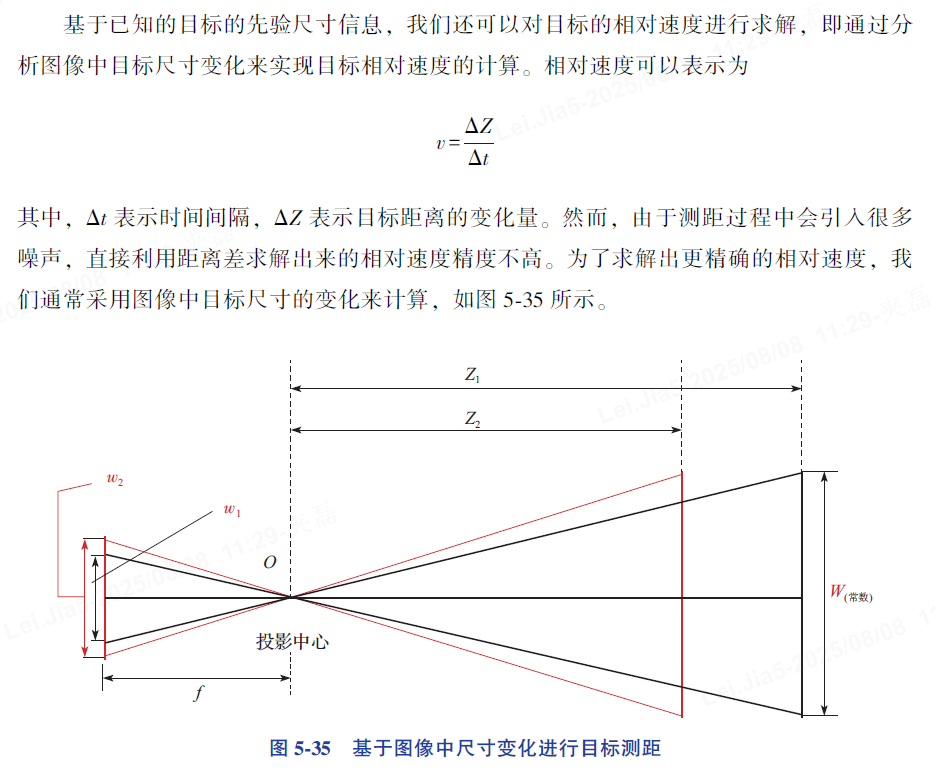

3)车辆物理尺寸测距法

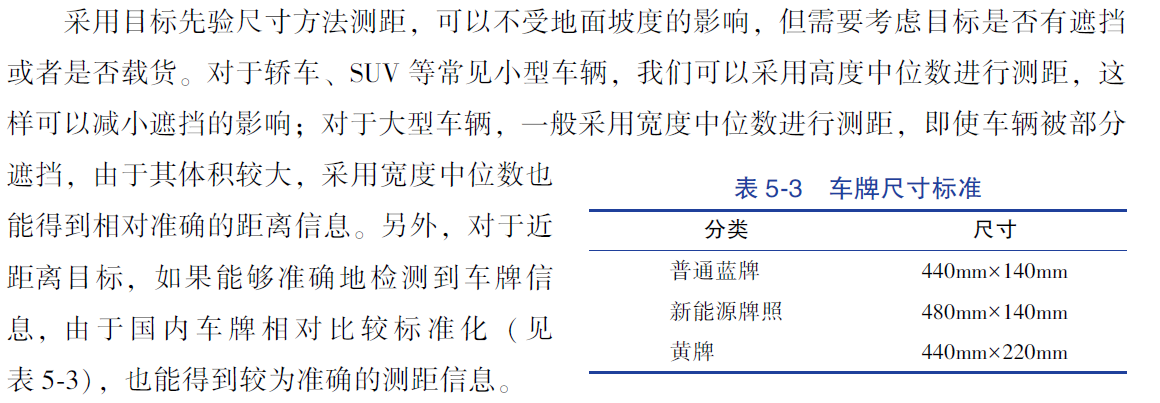

除了利用目标图像中的接地点进行测距, 我们还可以利用目标的尺寸(如目标的宽

度、高度等) 进行测距。 假设W 为车辆实际宽度, w 为图像中车辆的宽度, 已知摄像头的焦距f, 根据针孔摄像头成像模型的相似三角形原理得出距离Z 为Z =f W/w

假设W 为车辆实际宽度, w 为图像中车辆的宽度, 已知摄像头的焦距f, 根据针孔摄像头成像模型的相似三角形原理得出距离Z 为Z =f W/w

在实际应用中, 目标被遮挡或者处于视野边界处经常出现, 所以利用目标宽度进行车辆距离测量仅适用于某些特定的车辆, 如LMC (Left Most Critical, 左侧第一辆车)、RMC(Right Most Critical, 右侧第一辆车)、CIPV (Closest In Path Vehicle, 自车路径上最近的车辆, 也指自车道最近的车) 等.

4)基于图像中目标尺寸变化的测距法

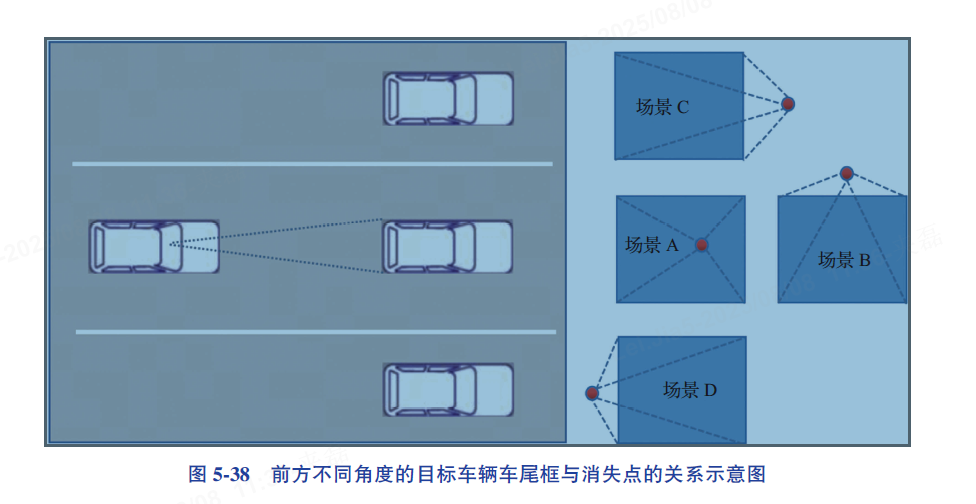

5)基于消失线的测距法

6)

传统的障碍物单目测距方法主要是车辆测距中提到的几种技术, 其中最常用的是相似三角形测距方法, 该方法适用于所有的无遮挡障碍物测距

行人,骑行人,俩轮车测距

相较于车辆测距, 行人测距方法要简单很多, 除了行人接地点测距方法外, 还包括利用行人高度测距方法、利用人头/ 身高比例的测距方法等。而针对骑行人/ 两轮车的测距方法则相对有限, 通常只采用接地点测距方法。

在实际行人测距时, 通常会采用接地点方法对行人的纵向距离进行预估, 并利用其他测距方法进行校准。

a)利用行人高度测距方法,男的170~180cm,女的150~170cm,取中位数165cm,相似三角形,Z=fH/h,H 为人的高度中位数,h为行人在图像中Bbox的高度,f为摄像头焦距。

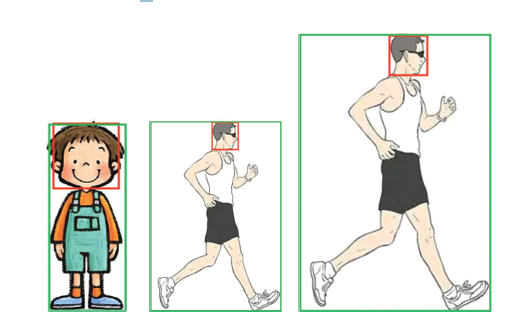

利用行人高度测距方法不用考虑地面结构和平面假设, 但由于人的实际高度与所用的高度中位数有一定的偏差(约15cm), 所以计算出的实际纵向距离也会有一定的偏差。另外,检测模型无法有效地区分儿童和成年人, 对儿童的测距偏差会更大。由于检测模型不能区分儿童和成年人, 利用行人高度测距方法得到的儿童纵向距离的偏差远大于成年人纵向距离的偏差。因此利用行人高度测距方法时, 我们还需要用其他方法进行距离矫正。

b)利用行人人头测距方法

利用行人人头测距方法,大多数人头部长度介于18~25cm之间(婴儿除外),如果直接利用人头的长度进行测距,其误差与利用行人高度进行测距的误差相差不大。

对于正常成年人,人体头部与身体进行测距,其误差利用行人高度进行测距误差相差不大。

对于正常成年人而言, 人体头部与身体的比例相对稳定, 大约为1 ∶ 7, 这一比例不受性别差异的影响; 对于儿童(6 岁以上), 通常头身比例在1 ∶ 4 左右。所以, 在进行行人检测的时, 我们也可以对人头进行检测(不含头上的饰品, 如帽子等), 利用人头框与行人框的比例关系, 区分出成年人和儿童, 然后再利用行人高度测距、行人人头测距或者接地点测距方法进行更精确的测量。

利用人头测距方法可以避免因为成年人Bbox 高度和儿童Bbox 高度引起的测距混淆,

同时避免了接地点偏差造成的混淆。

骑行人/俩轮车测距

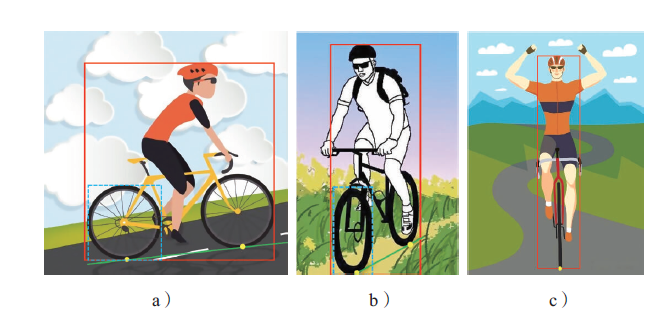

唯一有效的两轮车测距是基于车轮接地点的测距, 并利用两轮之间的轴距信息进行距离约束。车轮接地点一般被设定为检测模型检出的车轮最小外接矩形框下底边缘的中心点。

图中黄色点代表车辆前后轮的接地点(即车辆的接地点), 通过相似三角形方法对接地点像素进行坐标转换, 从而求解出前后两轮真实的物理距离。图中绿线展示了前后两轮的接地点连线, 该连线有助于计算出自行车的航向角。

俩接地点以及轴距,俩点做航向,

单点横向距离稳定,纵向与车轮直径中位数(58cm)来验证接地点测距

3)基于视觉的目标追踪

视觉目标追踪1)行人运动的不确定性,行人姿态和特征变化可能会导致跟踪失败,2)车辆从FOV边缘处进入自车视野范围内或者车辆行人被其他交通参与者遮挡时,如果选用不合适的跟踪关联策略,可能会引入较大的噪声,导致模型更新错误,3)在自车运动过程中可能收到光照强度,目标快速运动,低分辨率等影响,导致图像出现模糊等。

A)目标跟踪方法

1) 生成式模型: 生成式模型跟踪方法是首先建立一个目标模型或者提取目标特征,并在后续帧中进行相似特征搜索, 通过逐步迭代实现目标定位。然而, 由于目标外观变化的随机性和多样性(如分辨率低、目标图像形变等) 特点的影响, 使用单一数学模型来描述待跟踪目标有很大的局限性, 这可能影响跟踪的准确性。常见的生成式模型跟踪方法有光流法、粒子滤波法、均值漂移算法等。

2) 鉴别式模型: 是指将目标模型和背景信息同时考虑在内, 通过分析目标模型和背景信息的差异来实现目标提取, 从而确定当前帧中的目标位置。此类方法通常使用经典的机器学习方法来训练分类器(如随机森林等)。虽然基于深度学习的跟踪方法目前比较流行, 但在量产工程中, 传统的跟踪方法依然有很大的应用空间。

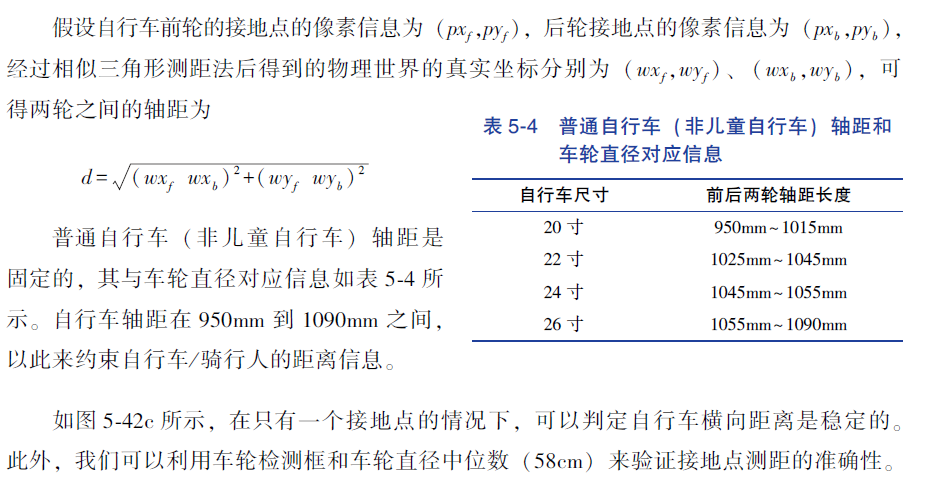

a)目标数据关联

目标数据关联基于时间序列将来自同一个目标在不同时刻(即帧与帧之间)的属性信息进行串联。包括新目标出现,旧目标消失

传统的目标数据关联方法(运筹学),基于视觉的目标跟踪中,常用的目标数据关联:

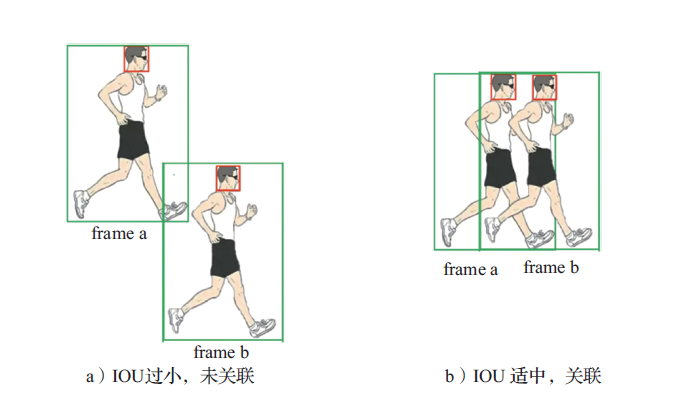

1) 基于IOU 的匹配关联方法: 采用IOU 度量方式来对连续帧之间的目标检测框依次

进行匹配的技术, 即计算前一帧每个目标检测框与当前帧所有检测框的IOU, 只要某个检

测框的IOU 值满足设定的指标值或者在该帧中是最大的, 则将这个检测框与之关联

2)最近邻算法(Nearest Neighbor,NN)

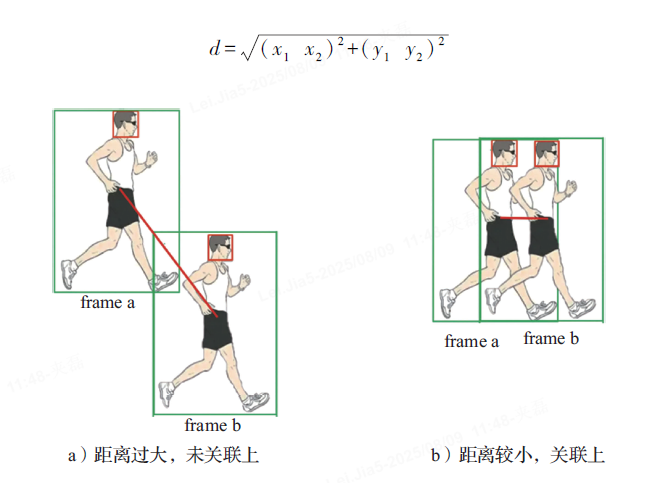

主要依赖距离(马氏距离,欧氏距离等)度量来将前一帧中的目标与当前帧中的目标进行匹配,从而将彼此距离接近的进行关联。

最近邻算法是最简单的目标数据关联技术, 通过设定一个阈值来聚类最相近的一组数据。但是在密集环境中, 最近邻算法性能会显著下降。在人群密集的情况下, 检测框与检测框的距离相近, 这可能会导致错误的目标数据关联。当多个目标可能关联到同一个测量结果时, 即对于这些目标而言, 某一测量结果都是它们最近的关联, 我们可以采用全局最近邻方法计算所有可能的关联, 然后采用总距离或者总概率最大化的关联方式, 避免出现误关联情况。

3)匈牙利算法:一种基于Hall 定理(该定理用于判定二分图是否完全匹配) 的部分图匹配算法, 其核心是寻求增广路径

B)目标跟踪管理方法

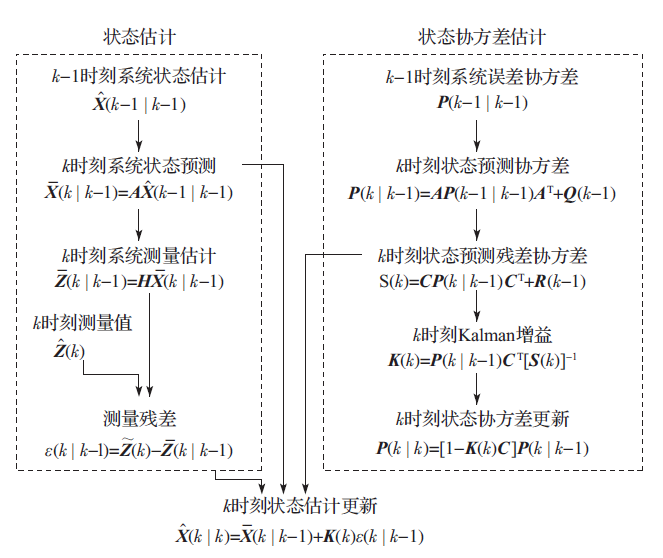

1)卡尔曼滤波

不对目标特征进行建模,认为物体的运动模型服从高斯分布,并基于此对目标的运动状态进行预测,然后通过将预测结果与观察模型进行对比,根据产生的误差来更新运动目标的状态,常用于估计目标下一帧的位置

1.1) 基于目标运动和量测噪声模型的卡尔曼滤波与预测增益序列可以自动选择。这意

味着通过改变一些关键参数, 相同的滤波器可以适用于不同的运动目标和量测环境。

1.2) 卡尔曼滤波与预测增益序列能自动地适应检测过程的变化, 包括采样周期的变化

和漏检情况。

1.3) 卡尔曼滤波通过协方差矩阵可以很方便地对估计精度进行度量, 同时在多目标跟

踪中, 这种度量工具还可用于跟踪门的形成及门限大小的确定。

1.4) 通过监测卡尔曼滤波中残差向量(预测值与实际观测值之间的差异), 可以判断

原假定的目标模型与实际目标的运动特性是否符合。

1.5) 在密集多回波环境下进行多机动目标跟踪时, 通过卡尔曼滤波与目标预测方法可

以部分地补偿误相关的误差; 还可以通过增大协方差矩阵的元素值来反映不确定性相关误

差的影响。

一般量产是非线性的,有EKF,也有UKF等

2)粒子滤波

基于蒙特卡罗理论实现的非线性递推贝叶斯滤波算法, 它使用一组带有相关权值的离散随机样本集(即粒子集) 来近似表征目标的后验概率密度。粒子滤波不受线性、高斯分布以及维数的限制, 因此适用于任何状态空间模型, 且精度可逼近最优估计。

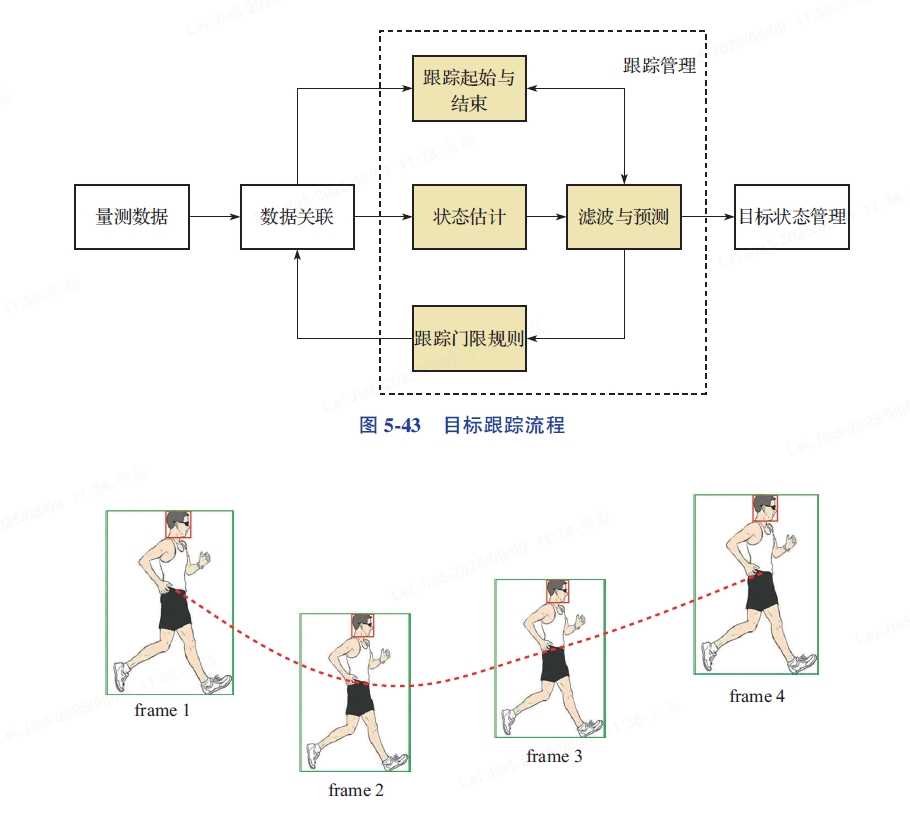

C)多目标跟踪方法

基于视觉的单目标跟踪需要从图像的角度来考虑目标的特征信息。基于视觉的多目标跟踪则更进一步, 需要考虑在当前帧中的目标与历史航迹中的目标进行关联, 之后再进行跟踪。这可以看成目标关联方法和跟踪方法的组合。其中, 比较有名的基于视觉的多目标跟踪方法如SORT 系列。

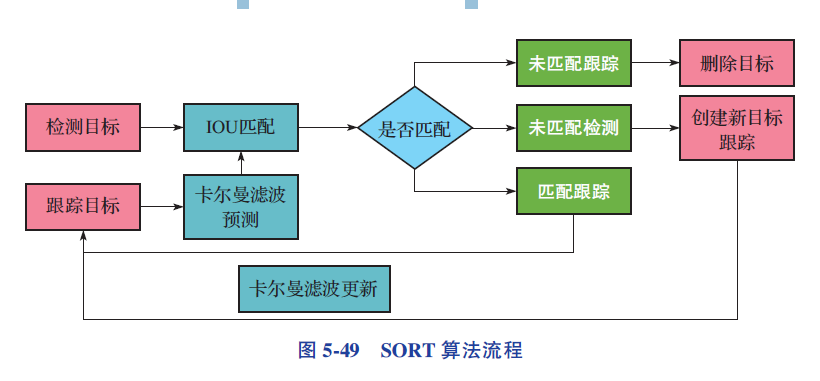

1)SORT多目标关联,轨迹预测等功能

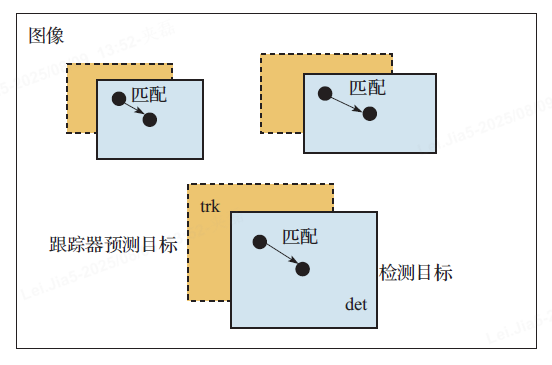

卡尔曼滤波(Kalman Filter, KF) 和匈牙利算法(HungarianAlgorithm, HA)。首先, 它采用匈牙利算法将检测结果与跟踪器中的预测结果进行IOU 匹配, 然后采用卡尔曼滤波对匹配到的目标轨迹进行预测, 并对未匹配到的目标信息进行更新。由于SORT 算法采用在线跟踪方式, 可以在不使用未来帧信息和保持帧速率的前提下, 提供最好的模型性能。

SORT 算法使用匈牙利算法在检测器的检测结果和跟踪器的跟踪轨迹之间找到一个代价最小的最优分配。SORT 算法采用带权重的匈牙利算法逐帧跟踪目标之间的关联, 用IOU 距离作为匈牙利算法的权重,同时通过给IOU 设置一个阈值来界定错误的匹配, 屏蔽无效的关联结果。通过IOU 阈值的设置实现对短时遮挡一定程度的容忍, 但只适用于障碍物比目标略大的情况。当目标短时间被遮挡时, 检测器可能会错误地将目标附近的障碍物识别为目标。IOU 在大小相似且距离相近的物体中的计算结果较大, 通常不会得到一个低于阈值的结果, 这导致被遮挡目标的跟踪轨迹匹配中断, 并与短时间内遮挡物体的障碍物进行匹配。因此, 当遮挡结束时,真实目标可以根据障碍物的轨迹快速恢复正确的关联。

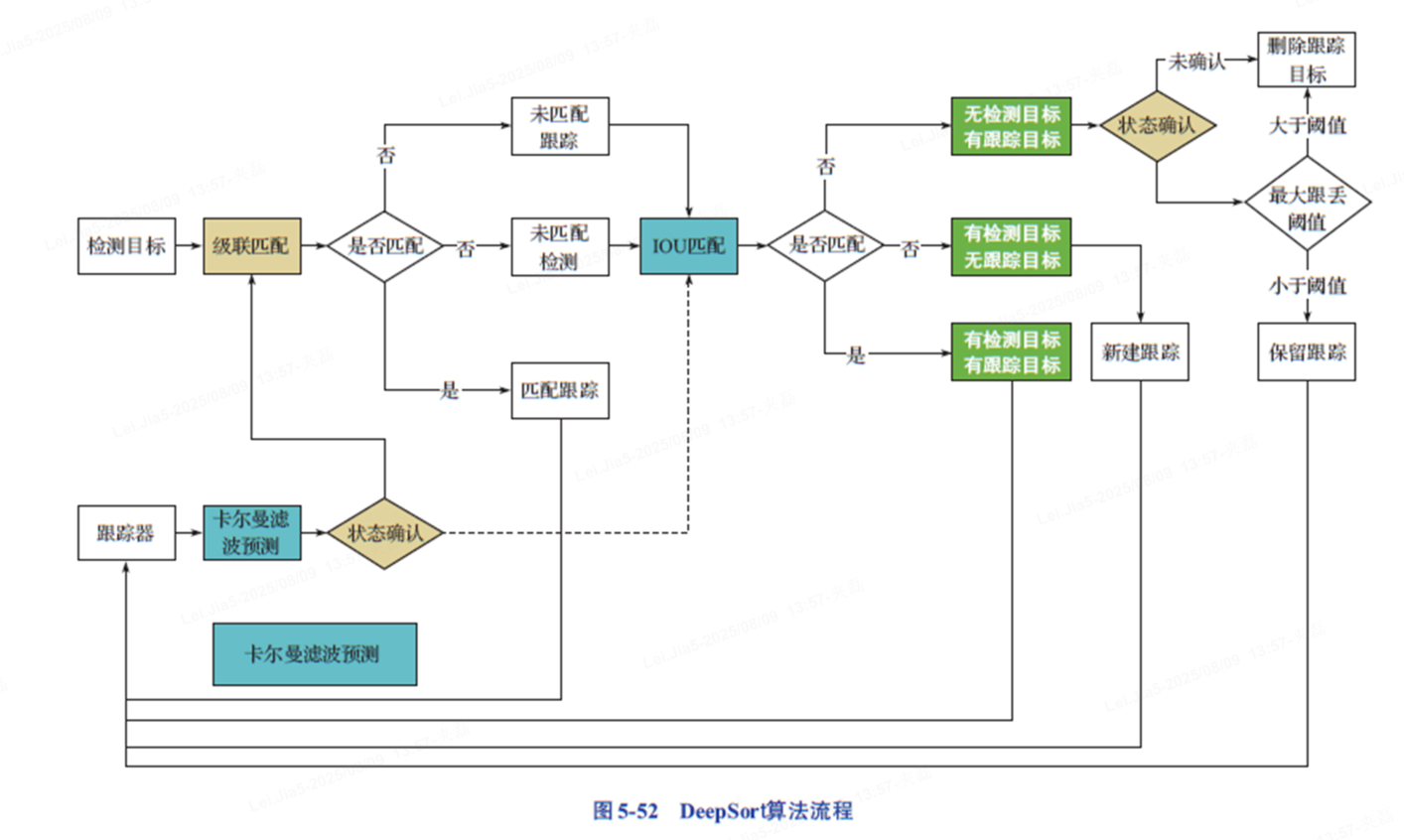

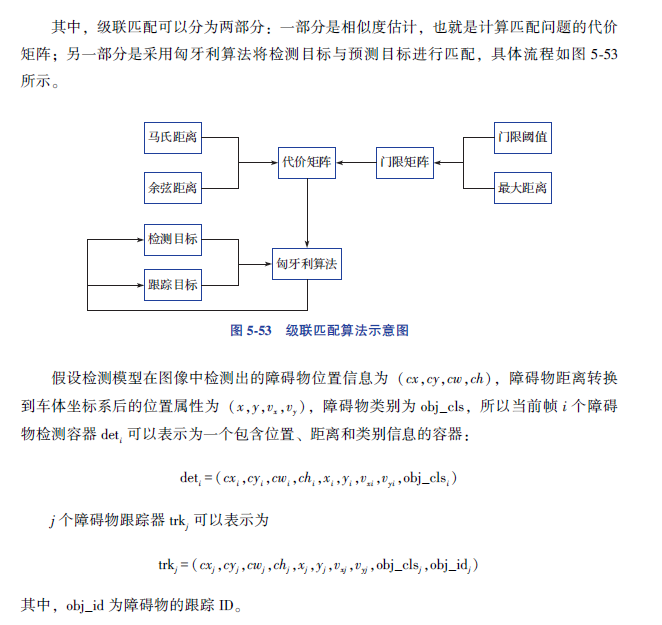

2)DeepSort算法

DeepSort 算法在SORT 算法的基础上增加了级联匹配和新轨迹的确认机制。轨迹可以分为确认状态和未确认状态, 新产生的轨迹是未确认状态。未确认轨迹必须和检测出的目标连续匹配超过一定次数才能转换为确认状态。如果确认的轨迹和检测出的目标连续失配一定次数, 则被删除。

检测目标

- 名词:系统 “看” 到的物体(比如监控里识别出的行人)。

- 例子:你在路口看到一个穿红衣服的人,这就是 “检测目标”。

级联匹配

- 名词:先拿简单特征快速匹配(比如衣服颜色、大致位置),筛掉明显不相关的。

- 例子:大脑先看 “红衣服”“在路口”,快速判断是不是之前跟踪的人(比如昨天跟踪过穿红衣服的)。

匹配跟踪 / 未匹配跟踪 / 未匹配检测

- 匹配跟踪:经过匹配逻辑(级联匹配、IOU 匹配 等),判定当前检测到的目标,和跟踪列表里已有的某条跟踪(已持续跟踪的目标)是同一个对象 。此时要基于新检测信息,更新这条跟踪的状态(比如位置、速度、外观特征等 )。

- 未匹配跟踪:跟踪列表里已经存在的跟踪(之前持续跟踪的目标),在当前帧,没找到能匹配上的检测目标 。意味着这个目标可能被遮挡、暂时离开检测视野,但跟踪还没被系统判定 “失效” 。

- 未匹配检测:当前帧新检测到的目标,在跟踪列表里找不到能匹配上的已有跟踪 。说明这是一个 “新出现” 的目标,系统可能要为它新建跟踪

- 匹配跟踪 → 检测到的目标,和已有跟踪 “对上了”,更新跟踪;

- 未匹配跟踪 → 已有跟踪还在,但当前帧没检测到对应目标;

- 未匹配检测 → 检测到新目标,跟踪列表里 “没见过”,要新建跟踪

DeepSort算法流程如下:

1) 首先, 将当前帧目标检测的Bbox 和上一帧跟踪的Bbox 逐一进行IOU 匹配, 然后将IOU 匹配的结果送入代价矩阵。

2) 将代价矩阵作为匈牙利算法的输入, 并进行线性匹配, 可以得到3 种匹配结果:未匹配的轨迹被删除(该轨迹是不确定状态, 如果是确定状态, 需要达到一定次数才可以删除); 未匹配的检测可以初始化为一个新的轨迹; 检测目标框与历史跟踪中的目标框匹配成功, 将其对应的检测属性通过卡尔曼滤波更新对应的轨迹属性。

3) 循环步骤1)、2), 直到出现确认的轨迹。

4) 通过卡尔曼滤波预测确认的跟踪目标属性和未确认的目标属性, 将确认轨迹的目标属性与检测目标属性进行级联匹配(如空间下的距离匹配、运动跟踪等)。

5) 级联匹配后也会出现3 种结果: 跟踪航迹匹配成功, 这样的匹配是通过卡尔曼滤波更新对应的跟踪属性; 其他两种结果是匹配失败, 包含跟踪在但检测不在, 以及跟踪不在但检测在, 将未确认状态的轨迹和没有匹配的轨迹与未匹配的检测信息逐一进行IOU 匹配, 再通过IOU 匹配结果计算代价矩阵。

6) 将代价矩阵作为匈牙利算法的输入, 得到线性的匹配结果, 同样得到3 种结果:未匹配的轨迹; 未匹配的检测; 匹配成功更新跟踪属性。

7) 循环步骤4) 到6), 直到跟踪结束。

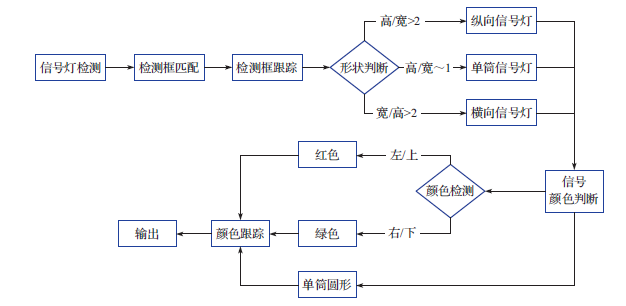

D)红绿灯与交通标识牌视觉后处理1)红绿灯

小目标检测范畴,尺寸相对较小,分辨率相对较低,可能会导致小目标检出率以及准确率降低

1.1)位置跟踪

红绿灯的位置跟踪是在深度学习提供的图像框基础上, 通过滤波方法对红绿灯信号的潜在区域进行精细定位。可以采用IOU 关联策略将当前帧检出的红绿灯框与历史帧中的红绿灯框进行关联匹配, 然后利用卡尔曼滤波技术对这些框的角点进行跟踪

对已经跟踪的红绿灯信号, 我们可以通过分析跟踪框的高度、宽度、宽高比等信息来

判断信号灯的形状, 并初步确定真正的信号区域。尽管气候、道路等环境因素会对采集的,交通信号灯图像产生不同程度的噪声、褪色及形变等影响, 但交通信号灯的基本形状和几何尺寸不会发生太大的变化。根据信号灯的设计规范, 我们可以通过以下标准来判别信号灯的方向:

如果宽度/ 高度>2, 则认为该信号灯为横向信号灯;

如果高度/ 宽度>2, 则认为该信号灯为纵向信号灯;

如果宽度≈高度, 则该信号灯为单筒信号灯,

- 未匹配检测 → 检测到新目标,跟踪列表里 “没见过”,要新建跟踪

1. 2)信号追踪

在完成红绿灯框的位置跟踪和形状判断后, 我们需要对红绿灯的颜色信号进行识别。根据交通信号灯的设计规范, 信号灯的灯板是一个黑色的矩形框, 红绿灯颜色出现的位置有一定的规律。

对于横向安装的红绿灯, 其排列顺序通常为红灯在左侧、黄灯在中间、绿灯在右侧; 对于纵向安装的红绿灯, 其排列顺序通常为红灯在上方、黄灯在中间、绿灯在下方。我们可以利用深度学习或者亮度统计方法给出信号灯的颜色信号, 并对信号灯进行跟踪处理。

以上是红绿灯视觉后处理的全部内容。但在自动驾驶中, 仅凭感知层面的红绿灯检测和后处理是远远不够的, 很容易造成误检、漏检等问题, 这对下游进行车辆控制有极大的影响(如图5-57 所示, 远距离的红绿灯信息模糊, 无法有效检出颜色信息, 对车辆自动驾驶有一定的干扰)。为了实现精准的红绿灯识别, 我们需要结合高精地图和V2X 技术。高精地图可以提供自车所在的车道信息和相对红绿灯的距离信息, 同时V2X 技术可以感知到红绿灯的状态, 将两者结合, 再加上视觉感知提供的冗余信息, 能够准确地获取红绿灯的真实信号。

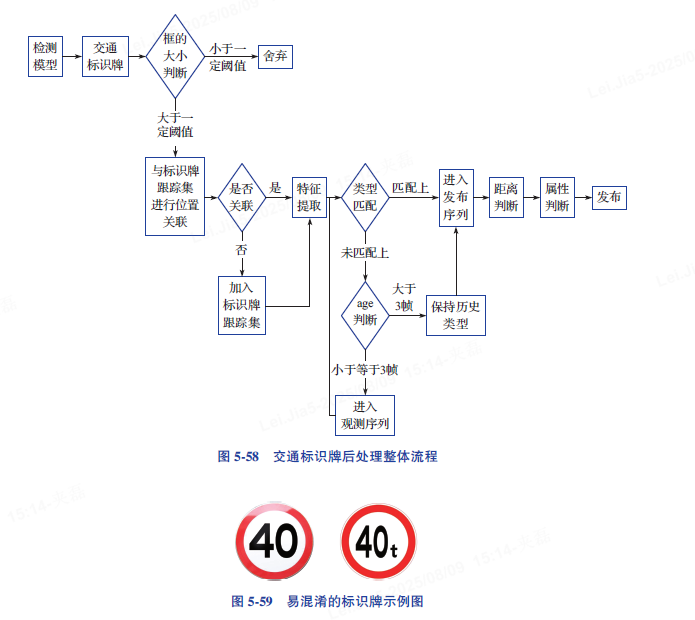

2)交通标识牌视觉后处理

相比于交通信号灯的后处理, 交通标识牌的后处理相对简单, 它不需要关注颜色信号的变化, 只需要将标识牌的具体含义传递给车辆, 以便进行速度和周围环境的判断。然而, 交通标识牌本身较小, 可利用的特征信息有限, 再加上样本分布不均衡, 这可能会导致模型输出的标识牌类别中存在很多错误信息。此外, 为了避免给驾驶员产生错误的干扰, 有些OEM 对HMI 供应商输出的标识牌设置了优先级限制。交通标识牌的后处理可以按照属性分为位置跟踪和类型跟踪两部分。位置跟踪方法与交通信号灯的位置跟踪方法一致。这里主要介绍类型跟踪。

在检测过程中, 当系统首次检测到交通标识牌时, 由于标识牌可能距离车辆较远, 标识牌尺寸很小, 纹理特征不清楚, 很难正确识别出标识牌的内容, 所以需要对标识牌清晰度进行判断, 只有当清晰度达到一定的标准后, 才能进行跟踪

2.1)首先利用标志牌特征提取网络模型构建一个标识牌特征样本库

2.2)将每一帧图像中位置关联上的标识牌输入标志牌特征提取模型,得到每个标识牌的特征向量

2.3)将得到特征向量与标识牌特征样本库进行对比,将对比得分最高的类别赋值给关联的标识牌,记为

2.4)将获取的类别与历史关联类别

比较,如果

=

,则将该目标放入待输出标识牌序列集;如果

!=

,且跟踪周期

<3帧,则将其加入待观测标识牌序列,

>=3帧后,再加入待输出标识牌序列

2.5)利用标识牌的尺寸一致性对待输出标识牌序列中的标识牌进行距离换算, 结合自车速度信息, 筛选出符合距离条件的标识牌。

2.6)最后, 对处于相同纵向距离的标识牌进行属性判断(一般, OEM 会给出相关的属性判断条件), 并送入HMI 进行显示。

以上内容是标识牌后处理的全部流程。和交通信号灯一样, 仅仅依靠感知层面的检测和后处理是远远不够的, 对NOA 中的融合限速功能来说是不满足条件的, 所以需要结合高精地图信息来保证精度要求。高精地图可以提供自车所在的车道信息和对应的限速信息, 再结合视觉感知得到的标识牌类型, 能满足融合限速功能要求。

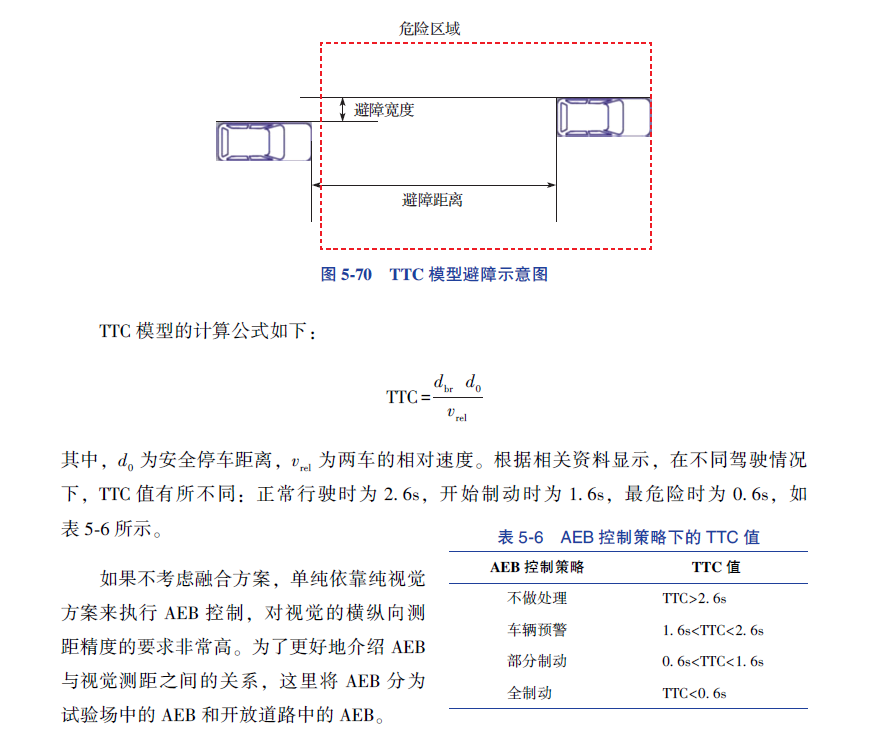

4)功能需求

功能常见问题及解决方法

问题1:视觉测距误差较大

问题2:不同测距方法之间偏差较大

问题3:CIPV等重点目标不稳定性

问题4:大小车叠套在一起误判

问题5:目标航向角偏差问题

问题6:误识别场景和鬼影场景

问题7:VRU目标横穿场景下输出的横纵向举例或速度偏差较大

依旧存在如长尾问题、罕见事件、背景欺骗等挑战,需要视觉后处理技术来确保视觉感知的准确性和稳定性