Qwen3-Coder:介绍及使用 -- 超强AI编程助手

更多内容:XiaoJ的知识星球

目录

- 一、Qwen3-Coder模型介绍

- 1.预训练阶段(Pre-Training)

- 2.后训练阶段(Post-Training)

- 1)Scaling Code RL: Hard to Solve, Easy to Verify

- 2)Scaling Long-Horizon RL

- 二、Qwen3-Coder模型使用

- 1. Web中使用Qwen3-Coder:ChatQwenAI

- 2. Windows中使用Qwen3-Coder:VSCode+cline

- 1)获取API Key

- 2)安装cline插件

- 3)配置Qwen3-coder

- 3. Linux中使用Qwen3-Coder:Qwen Code CLI工具

- 1)环境安装

- (1)安装Node.js

- (2)安装Qwen Code CLI

- 2)API 配置

- (1)获取API Key

- (2)设置环境变量:API和模型

- 3)使用Qwen Code CLI

- (1)运行Qwen Code CLI

- (2)使用Qwen Code CLI

.

本文将介绍内容:

-

Qwen3-Coder模型介绍

-

Qwen3-Coder不同平台上使用

.

一、Qwen3-Coder模型介绍

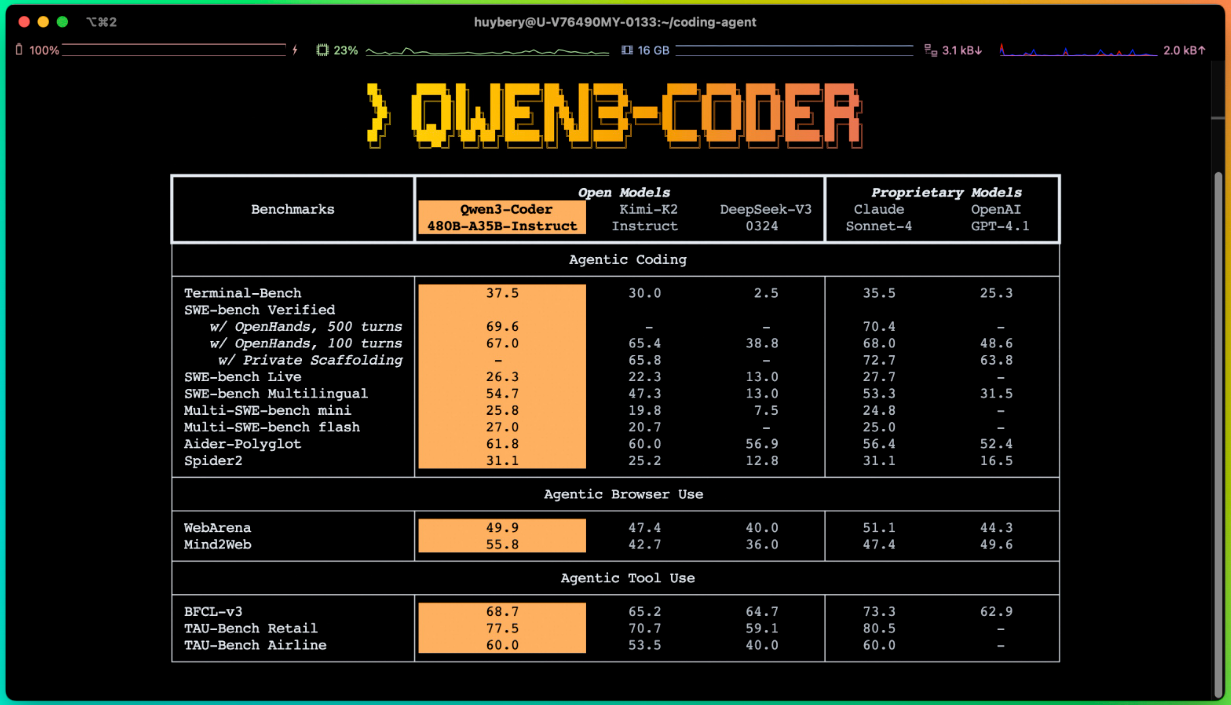

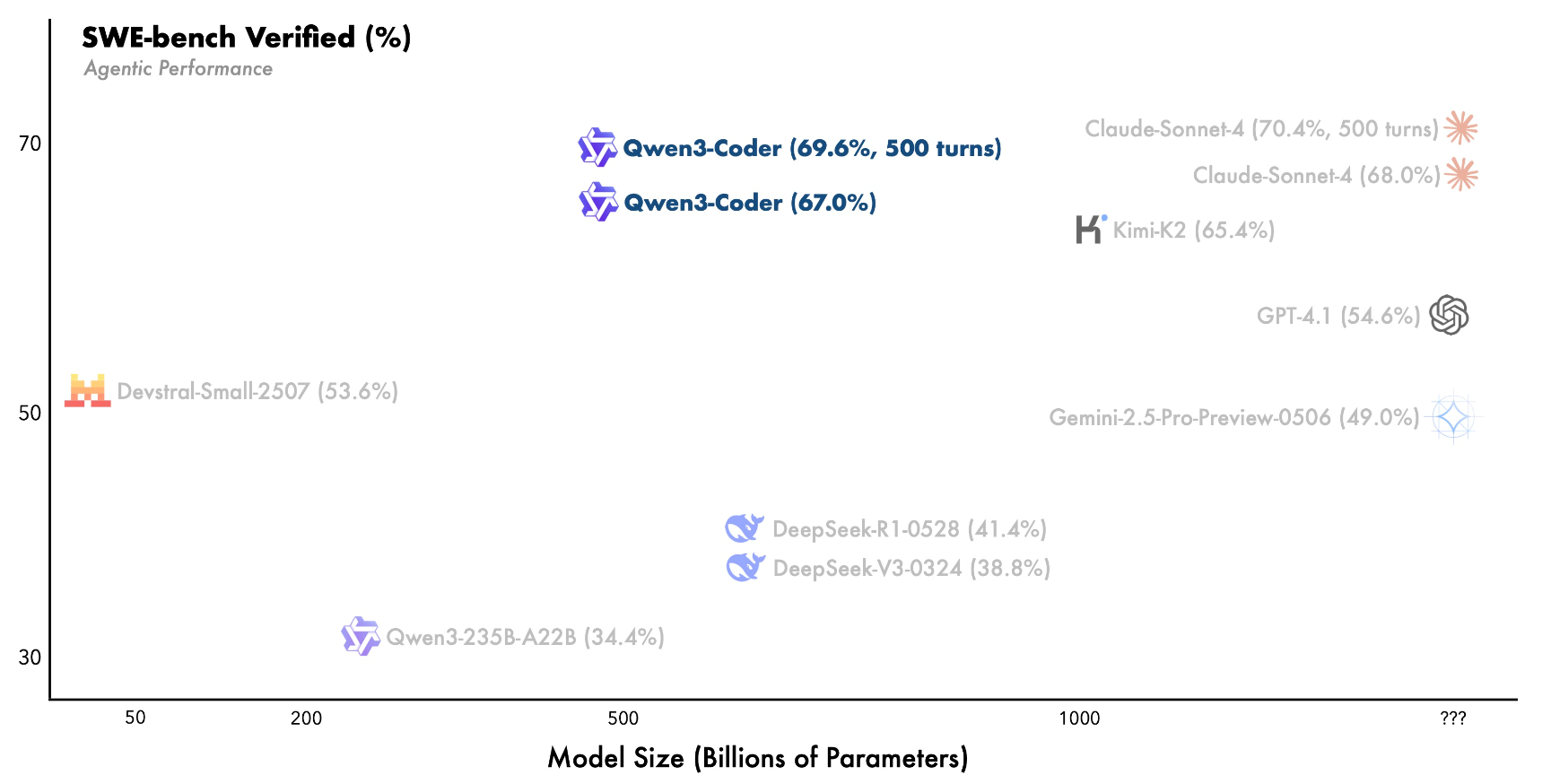

阿里发布的 Qwen3-Coder 系列最强版本:Qwen3-Coder-480B-A35B-Instruct。该模型为 480B 总参数、35B 激活的 MoE 架构,原生支持 256K 上下文,可通过 YaRN 扩展至 1M token。在 Agentic Coding、Browser-Use 和 Tool-Use 上达到开源模型 SOTA,媲美 Claude Sonnet4。

.

.

1.预训练阶段(Pre-Training)

Qwen3-Coder 在不同角度进行扩展,以提升模型的代码能力:

-

数据扩展:总计 7.5T(代码占比 70%),在保持通用与数学能力的同时,具备卓越的编程能力;

-

上下文扩展:原生支持 256K 上下文,借助 YaRN 可拓展至 1M,专为仓库级和动态数据(如 Pull Request,拉取请求)优化,助力 Agentic Coding(代理式编程);

-

合成数据扩展:利用 Qwen2.5-Coder 对低质数据进行清洗与重写,显著提升整体数据质量;

YaRN(Yet another RoPE extension method,通常指对 RoPE 的改进)是一种上下文长度扩展技术,用于让原本训练在较短上下文上的模型,能够高效支持更长的输入。

- 原生 RoPE(Rotary Position Embedding)限制了模型处理的最长上下文(如 32K、64K);

- YaRN 通过对位置编码进行重加权和插值,在不重新预训练的前提下,将上下文扩展到 1M token,同时保持生成质量。

.

2.后训练阶段(Post-Training)

1)Scaling Code RL: Hard to Solve, Easy to Verify

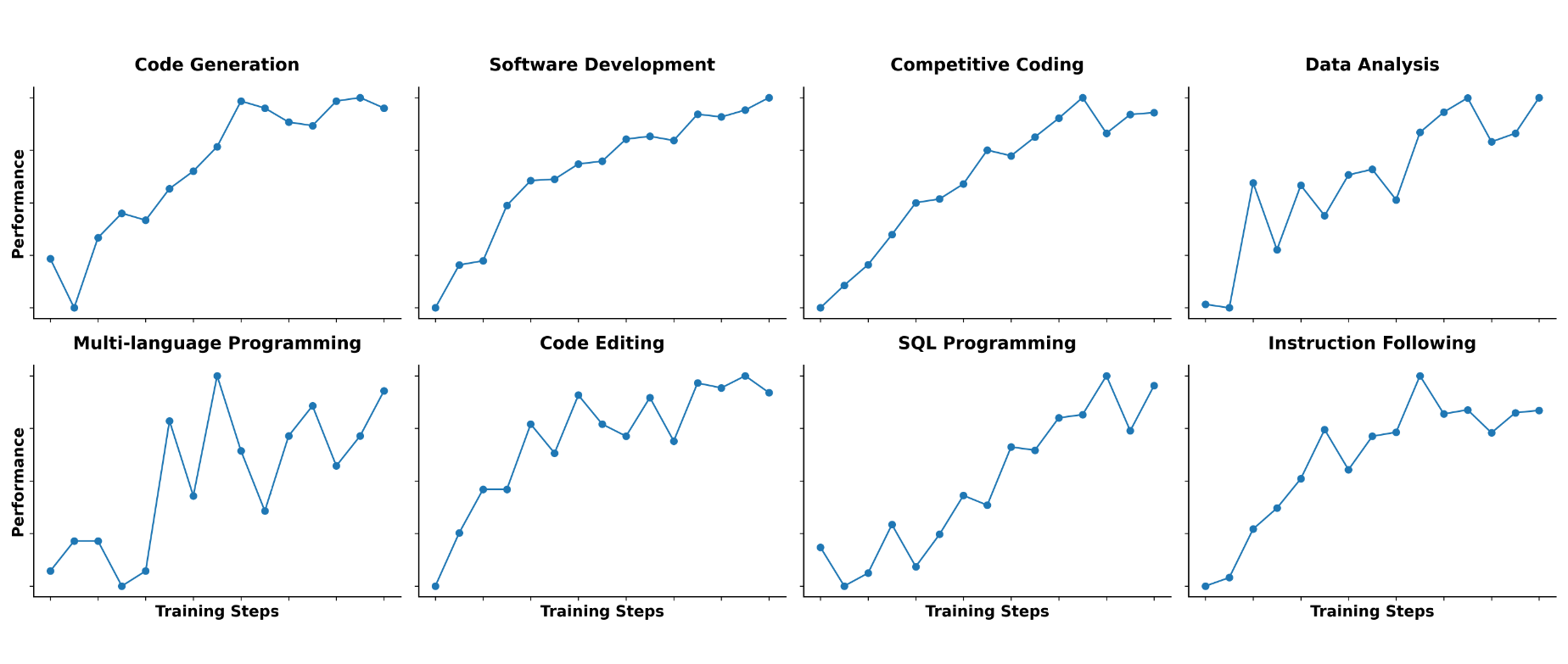

与当前社区普遍聚焦于竞赛类代码生成不同,Qwen3-Coder关注的代码任务在于执行驱动的大规模强化学习上。因此选择在更丰富的真实代码任务上扩展 Code RL(Reinforcement Learning,强化学习) 训练。

通过自动扩展测试样例,构建了大量高质量训练数据,成功释放了强化学习的潜力:不仅显著提升了代码执行成功率,还对其他任务带来了增益。这将激励继续寻找“难解但易验证(Hard to Solve, Easy to Verify)”的任务,作为强化学习的理想场景。

2)Scaling Long-Horizon RL

在真实软件工程任务(如 SWE-Bench)中,模型需自主规划、调用工具、多轮交互并持续决策,属于典型的长周期强化学习(Long-Horizon RL) 任务。为此,在 Qwen3-Coder 的后训练中引入 Agent RL,鼓励模型通过多轮交互使用工具解决问题。

主要挑战是环境扩展(Environment Scaling),我们构建了可验证的扩展系统,依托阿里云基础设施,支持同时运行 20,000 个独立环境,实现大规模强化学习训练与自动评测。

最终,Qwen3-Coder 在 SWE-bench Verified 上达到开源模型 SOTA 水平。

.

二、Qwen3-Coder模型使用

下面展示在不同平台使用Qwen模型,以使用Qwen3-Coder模型为例。

.

1. Web中使用Qwen3-Coder:ChatQwenAI

进入ChatQwenAI网页:https://chat.qwen.ai/

左上角选择模型Qwen3-Coder即可使用。

.

2. Windows中使用Qwen3-Coder:VSCode+cline

使用Qwen3-Coder模型,可以通过VSCode安装cline插件来实现,以下是具体步骤:

1)获取API Key

-

中国大陆用户,请前往 https://bailian.console.aliyun.com/ 或 https://modelscope.cn/docs/model-service/API-Inference/intro 申请 API 密钥

-

非中国大陆用户,请前往 https://modelstudio.console.alibabacloud.com/ 申请 API 密钥

我参考了阿里云百炼–API认证获取:https://bailian.console.aliyun.com/?tab=api#/api 进行认证获取API Key。

2)安装cline插件

-

安装VSCode:打开https://code.visualstudio.com下载安装。

-

安装cline:打开VSCode,进入扩展商店(Ctrl/Cmd+Shift+X),搜索“cline”安装。

-

登录cline:点击"Get Started for Free",跳转到谷歌邮箱登录网页进行登录。

3)配置Qwen3-coder

-

打开cline设置:点击VSCode左侧cline图标,点击设置按钮(齿轮图标)。

-

选择模型类型:API Provider 选择“OpenAI Compatible”。

-

配置模型api:设置内容 Base URL(阿里API地址)、OpenAl Compatible API Key(阿里API Key)、Model ID(模型名称)。

-

保存设置:点击 “Done” ,即可在VSCode中使用Qwen3-coder。

配置示例:

# 打开cline设置# API Provider

OpenAI Compatible# Base URL

https://dashscope.aliyuncs.com/compatible-mode/v1

# OpenAl Compatible API Key

<you api key>

# Model ID

qwen3-coder-plus# 点击 "Done" 保存即可使用

以上配置完成后,就可以在VSCode的cline插件中使用qwen3-coder-plus模型了,其他qwen模型,只需要更换Model ID为模型名即可使用。

.

3. Linux中使用Qwen3-Coder:Qwen Code CLI工具

下面将介绍,在Linux中安装Qwen Code CLI调用Qwen3-Coder模型。构建你的AI编程助手。

Qwen Code 是一款改编自 Gemini CLI 的命令行 AI 工作流工具(更多详细信息,请参阅本文档),针对 Qwen3-Coder 模型进行了优化,并增强了解析器支持和工具支持。

1)环境安装

(1)安装Node.js

Qwen Code 要求 Node.js 版本 >= 20

安装或升级 Node.js:使用 nvm 管理,环境变量可以添加到~/.bashrc中永久生效。

# 安装nvm

curl -o install_nvm.sh https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh

bash install_nvm.sh# 生效nvm环境

export NVM_DIR="$HOME/.nvm"

source "$NVM_DIR/nvm.sh"# 安装Node.js 20

nvm install 20

nvm use 20

验证是否安装成功:

node -v

npm -v

(2)安装Qwen Code CLI

安装:(运行时执行qwen即可)

# 方式 1:全局安装(推荐)

npm install -g @qwen-code/qwen-code# 方式 2:源码安装(可选)

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code

npm install

npm install -g .

验证是否安装成功:

qwen --version

2)API 配置

设置您的 Qwen API 密钥(在 Qwen Code 项目中,您也可以在 .env 文件中设置您的 API 密钥)。.env 文件应放置在当前项目的根目录中。

(1)获取API Key

-

中国大陆用户,请前往 https://bailian.console.aliyun.com/ 或 https://modelscope.cn/docs/model-service/API-Inference/intro 申请 API 密钥

-

非中国大陆用户,请前往 https://modelstudio.console.alibabacloud.com/ 申请 API 密钥

我参考了阿里云百炼–API认证获取:https://bailian.console.aliyun.com/?tab=api#/api 进行认证获取API Key。

(2)设置环境变量:API和模型

中国大陆,可以通过阿里云百炼平台使用Qwen3-Coder。

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

中国大陆,ModelScope 每天提供 2,000 次免费模型推理 API 调用

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://api-inference.modelscope.cn/v1"

export OPENAI_MODEL="Qwen/Qwen3-Coder-480B-A35B-Instruct"

非中国大陆,可以通过阿里云modelstuido平台使用Qwen3-Coder。

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

3)使用Qwen Code CLI

(1)运行Qwen Code CLI

# 进入安装目录运行qwen

cd your-path/qwen-code

qwen

如果前面没设置API Key和模型变量,这里同样可以设置:

API Key: <your_api_key> Base URL: <your_base_url> Model: "qwen3-coder-plus" # 或其他模型名

(2)使用Qwen Code CLI

出现以下内容,即可通过在命令行输入问题,使用Qwen Code CLI进行交互了。

██╗ ██████╗ ██╗ ██╗███████╗███╗ ██╗

╚██╗ ██╔═══██╗██║ ██║██╔════╝████╗ ██║╚██╗ ██║ ██║██║ █╗ ██║█████╗ ██╔██╗ ██║██╔╝ ██║▄▄ ██║██║███╗██║██╔══╝ ██║╚██╗██║

██╔╝ ╚██████╔╝╚███╔███╔╝███████╗██║ ╚████║

╚═╝ ╚══▀▀═╝ ╚══╝╚══╝ ╚══════╝╚═╝ ╚═══╝Tips for getting started:

1. Ask questions, edit files, or run commands.

2. Be specific for the best results.

3. /help for more information.Using 1 QWEN.md file

╭─────────────────────────────────────────────────────────────────────────────────────────────╮

│ > Type your message or @path/to/file |

╰─────────────────────────────────────────────────────────────────────────────────────────────╯~/qwen-code no sandbox (see qwen3-coder-plus (100% context left| ✖ 1 error (ctrl+o for

(main*) /docs) details)

简单示例:输入问题“qwen3-coder-plus是一个什么类型的模型?”

╭────────────────────────────────────────────╮

│ > qwen3-coder-plus是一个什么类型的模型? │

╰────────────────────────────────────────────╯✦ qwen3-coder-plus 是阿里巴巴通义千问系列中的一个代码生成模型。它是 qwen3 系列模型的增强版本,专门针对代码生成任务进行了优化和加强。相比基础版本,它可能在代码理解、多语言支持、复杂逻辑推理以及生成代码的质量和准确性方面有显著提升。如果你正在使用或开发基于该模型的应用,可以告诉我具体的需求或问题,我会尽力提供帮助。Using 1 QWEN.md file

╭──────────────────────────────────────────────────────────╮

│ > Type your message or @path/to/file │

╰──────────────────────────────────────────────────────────╯

声明:资源可能存在第三方来源,若有侵权请联系删除!