使用CosyVoice-300M实现零样本语音克隆:Xinference部署与实战

文章目录

- 引言:语音克隆技术的革命

- 什么是CosyVoice-300M?

- 使用Xinference部署CosyVoice-300M

- 1. 安装Xinference

- 2. 启动Xinference服务

- 3. 部署CosyVoice-300M模型

- 语音克隆实战代码解析

- 代码关键点解析

- 最佳实践建议

- 应用场景

- 常见问题解决

- 结语

引言:语音克隆技术的革命

语音克隆技术近年来取得了突破性进展,使得我们能够仅凭几秒钟的参考音频就能生成与目标声音高度相似的合成语音。在众多开源语音模型中,CosyVoice-300M凭借其出色的表现和轻量级设计脱颖而出。本文将深入探讨如何使用Xinference部署CosyVoice-300M模型,并通过完整代码示例展示如何实现零样本语音克隆。

什么是CosyVoice-300M?

CosyVoice-300M是由CosyVoice团队开发的开源语音合成模型,具有以下核心特点:

- 零样本语音克隆能力:仅需10秒左右的参考音频即可克隆声音

- 轻量级设计:300M参数规模,相比同类模型更易于部署

- 高质量输出:生成语音自然流畅,接近真人发音

- 多语言支持:支持中文、英文等多种语言

- 开源免费:基于MIT许可证开放源代码和预训练模型

该模型采用先进的深度学习架构,结合了文本到语音(TTS)和语音转换(VC)技术,使其在语音克隆任务中表现出色。

使用Xinference部署CosyVoice-300M

Xinference是一个强大的开源模型推理平台,支持多种AI模型的部署与管理。以下是部署步骤:

1. 安装Xinference

pip install xinference

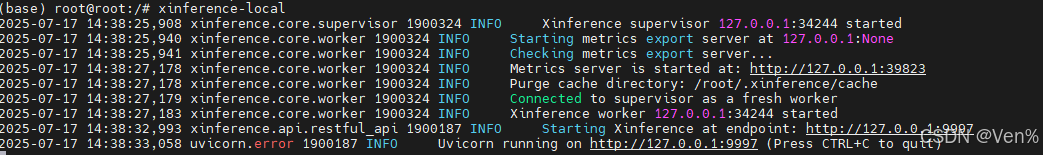

2. 启动Xinference服务

xinference-local

默认服务地址为:http://localhost:9997

3. 部署CosyVoice-300M模型

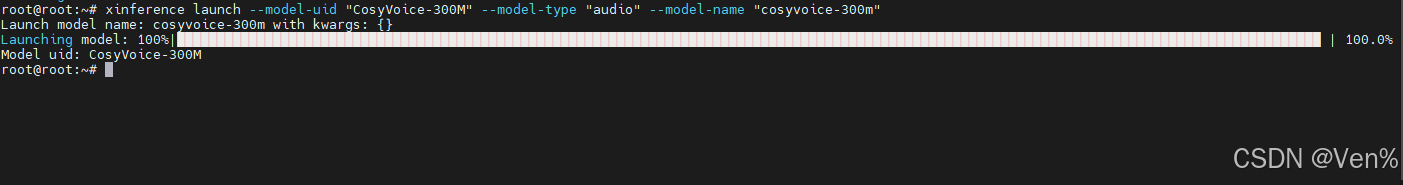

通过Web界面或命令行部署模型:

xinference launch --model-uid CosyVoice-300M --model-type audio --model-name CosyVoice-300M

部署成功后,可以通过http://localhost:9997查看模型状态。

语音克隆实战代码解析

下面是一个完整的语音克隆实现,包含音频生成和播放功能:

from xinference.client import Client

from pydub import AudioSegment

from pydub.playback import play

import os

import sysdef generate_and_play_speech(text: str,ref_audio_path: str,ref_text: str,server_url: str = "http://localhost:9998",model_uid: str = "CosyVoice-300M",output_path: str = "generated_speech.wav"

):"""生成语音克隆并播放音频参数:text -- 要生成的文本内容ref_audio_path -- 参考音频文件路径ref_text -- 参考音频对应的文本内容server_url -- Xinference服务器地址 (默认: http://localhost:9998)model_uid -- 语音克隆模型UID (默认: CosyVoice-300M)output_path -- 生成音频的保存路径 (默认: generated_speech.wav)"""try:# 1. 连接Xinference服务器client = Client(server_url)# 2. 加载语音克隆模型model = client.get_model(model_uid)# 3. 读取参考音频if not os.path.exists(ref_audio_path):raise FileNotFoundError(f"参考音频文件不存在: {ref_audio_path}")with open(ref_audio_path, "rb") as f:zero_shot_prompt = f.read()# 4. 生成克隆语音generated_speech = model.speech(text,prompt_text=ref_text,prompt_speech=zero_shot_prompt,)# 5. 保存生成的音频with open(output_path, "wb") as f:f.write(generated_speech)print(f"✅ 语音生成成功,保存至: {output_path}")# 6. 播放生成的音频play_audio(output_path)return output_pathexcept Exception as e:print(f"❌ 语音生成失败: {str(e)}")raisedef play_audio(file_path: str):"""播放生成的语音文件"""try:print(f"播放语音: {file_path}")audio = AudioSegment.from_mp3(file_path)play(audio)except Exception as e:print(f"播放失败: {str(e)}")# 使用示例

if __name__ == "__main__":# 配置参数config = {"text": "大家好我是克隆声音两年半的练习生,请大家多多指教","ref_audio_path": "test.wav","ref_text": "反正近期呢会有两首中文的歌陆续的带给大家","server_url": "http://localhost:9998","model_uid": "CosyVoice-300M"}# 生成并播放语音generate_and_play_speech(**config)

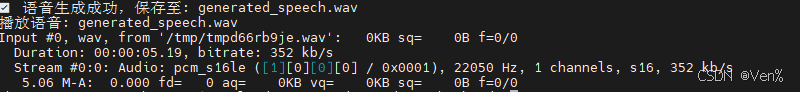

运行截图:

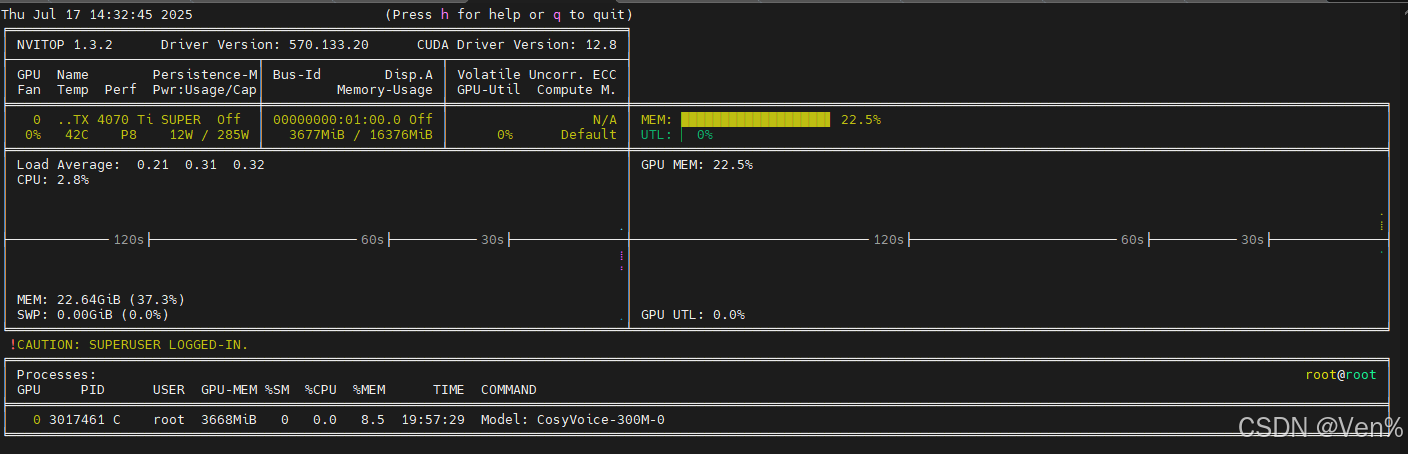

GPU使用情况:

代码关键点解析

-

模型连接与加载

client = Client(server_url) model = client.get_model(model_uid)通过Xinference客户端连接到本地服务器并加载预部署的模型

-

零样本提示准备

with open(ref_audio_path, "rb") as f:zero_shot_prompt = f.read()读取参考音频作为语音克隆的基础

-

语音生成核心

generated_speech = model.speech(text,prompt_text=ref_text,prompt_speech=zero_shot_prompt, )调用模型的speech方法,结合目标文本、参考文本和参考音频生成克隆语音

-

音频播放功能

audio = AudioSegment.from_mp3(file_path) play(audio)使用pydub库实现生成音频的即时播放

最佳实践建议

-

参考音频选择

- 时长10-30秒效果最佳

- 清晰无背景噪音

- 包含多种音素变化

-

参数调优

# 可添加的调优参数示例 generated_speech = model.speech(text,prompt_text=ref_text,prompt_speech=zero_shot_prompt,language="zh", # 明确指定语言speed=1.0, # 语速控制 (0.5-2.0)seed=42 # 固定随机种子保证可复现性 ) -

性能优化

- 使用GPU加速:启动Xinference时添加

--gpu参数 - 批处理生成:同时生成多个语音片段提高效率

- 使用GPU加速:启动Xinference时添加

应用场景

- 个性化语音助手:为不同用户创建专属声音

- 无障碍技术:为失语者恢复声音

- 内容创作:视频配音、有声读物制作

- 游戏开发:NPC角色语音生成

- 语言学习:母语者发音模仿

常见问题解决

-

音频质量不佳

- 尝试不同的参考音频

- 调整语速参数(0.8-1.2范围)

- 确保参考文本与音频完美匹配

-

部署问题

# 检查模型是否正常加载 xinference list -

长文本处理

- 将长文本拆分为短句(<30字)

- 分段生成后拼接

结语

CosyVoice-300M结合Xinference提供了一个强大且易用的语音克隆解决方案。通过本文的代码示例和技术解析,您可以快速构建自己的语音克隆应用。随着语音合成技术的不断发展,我们期待看到更多创新的应用场景出现。

提示:语音克隆技术应负责任地使用,尊重他人声音权利,避免滥用和侵权。