ollama快速部署使用(windows版)

1、下载&安装

官网:Ollama,选择对于的操作系统,我这里使用windows进行操作。这里下载可能需要安全上网,下载好后直接安装即可使用。

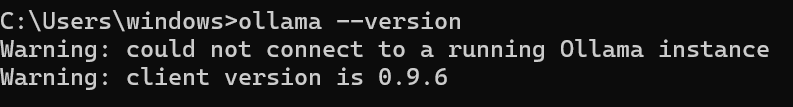

2、验证安装

打开命令提示符或 PowerShell,输入以下命令验证安装是否成功:

ollama --version

3、修改ollama模型的存储位置

我的ollama安装位置:D:\ollama

模型默认下载位置:C:\Users\xxx\.ollama

首先在ollama安装的文件夹中创建一个ollamamodels文件夹,这个ollamamodels文件夹你也可以放在别的地方。

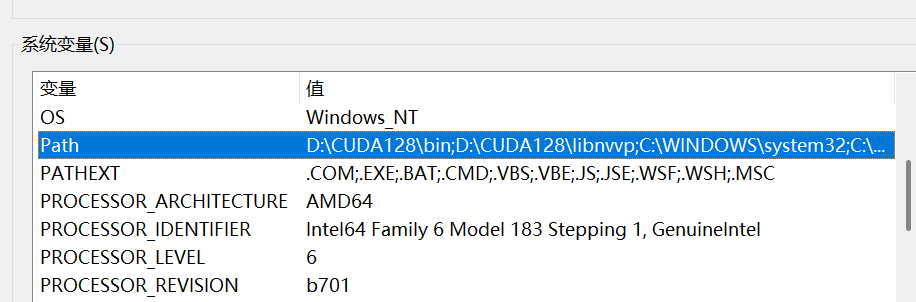

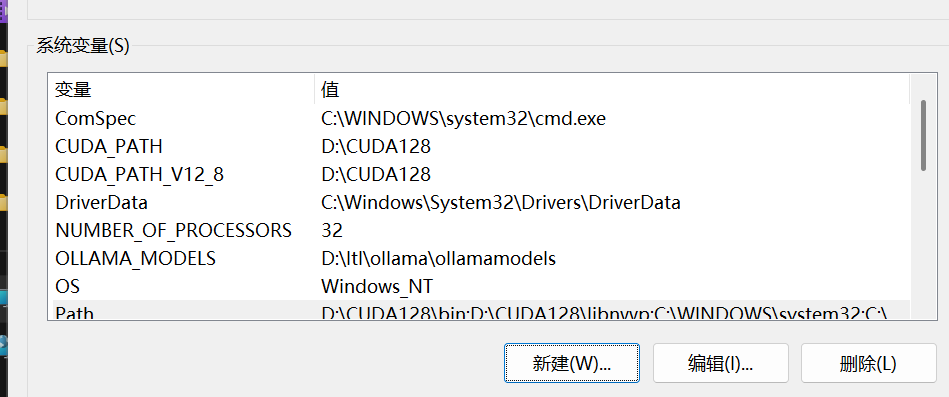

打开环境变量

在系统变量找到Path,点进去

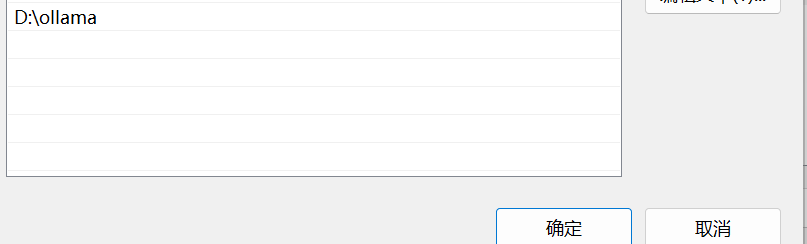

将D:\ollama添加进去,点击确定。

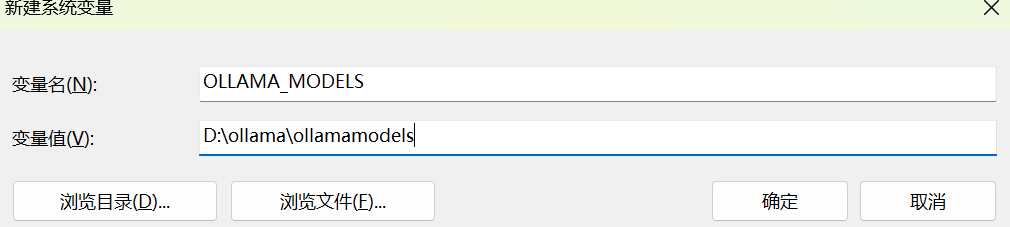

然后在系统环境变量中点击新建

变量名为:OLLAMA_MODELS,地址为你上面创建存放模型的文件夹。这样下载的模型就会放在指定的文件夹中,不会占用c盘的空间。

4、ollama运行模型

ollama支持的模型:library

ollama服务启动:

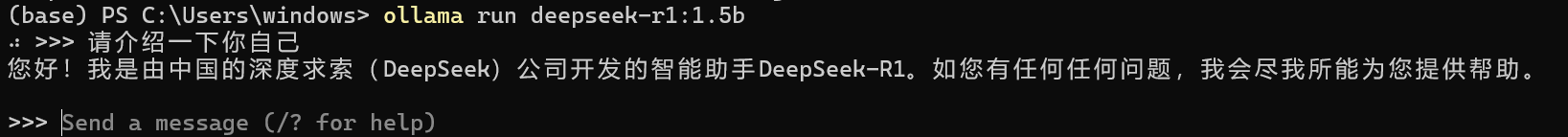

ollama serveollama下载模型,这里以deepseek-r1:1.5b 为例:

ollama run deepseek-r1:1.5b 我这里已经下载好了,可以看到直接进入对话界面了

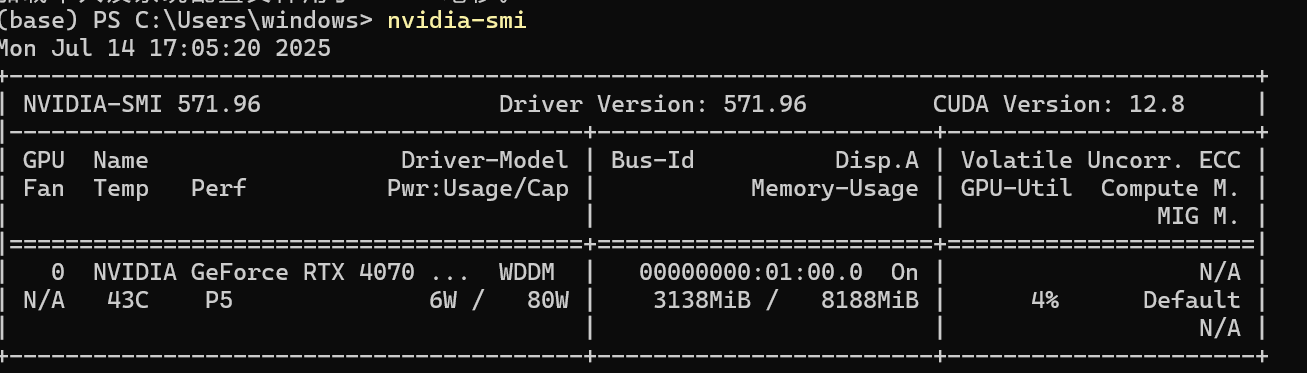

查看显存占了大概三个G

ollama操作比较简单,其他操作如下:

(base) PS C:\Users\windows> ollama -h

Large language model runnerUsage:ollama [flags]ollama [command]Available Commands:serve Start ollamacreate Create a model from a Modelfileshow Show information for a modelrun Run a modelstop Stop a running modelpull Pull a model from a registrypush Push a model to a registrylist List modelsps List running modelscp Copy a modelrm Remove a modelhelp Help about any commandFlags:-h, --help help for ollama-v, --version Show version informationUse "ollama [command] --help" for more information about a command.5、通过api调用ollama正在运行的模型

(1)通过requests来访问generate方法。

# pip install requests

import requests

import jsonOLLAMA_URL = "http://localhost:11434/api/generate" # Ollama 默认地址

MODEL = "deepseek-r1:1.5b"prompt = "用一句话介绍你自己"payload = {"model": MODEL,"prompt": prompt,"stream": False # 关闭流式,直接一次性返回

}resp = requests.post(OLLAMA_URL, json=payload, timeout=120)

print(resp.json()["response"])

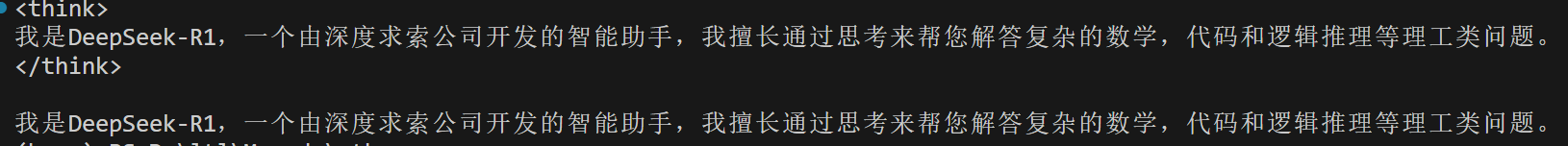

(2)通过requests来访问chat方法:

import requests, jsonOLLAMA_CHAT = "http://localhost:11434/api/chat"

MODEL = "deepseek-r1:1.5b"messages = [{"role": "user", "content": "1+1=?"},{"role": "assistant", "content": "2"},{"role": "user", "content": "再加 3 呢?"}

]payload = {"model": MODEL,"messages": messages,"stream": False

}resp = requests.post(OLLAMA_CHAT, json=payload)

print(resp.json()["message"]["content"])

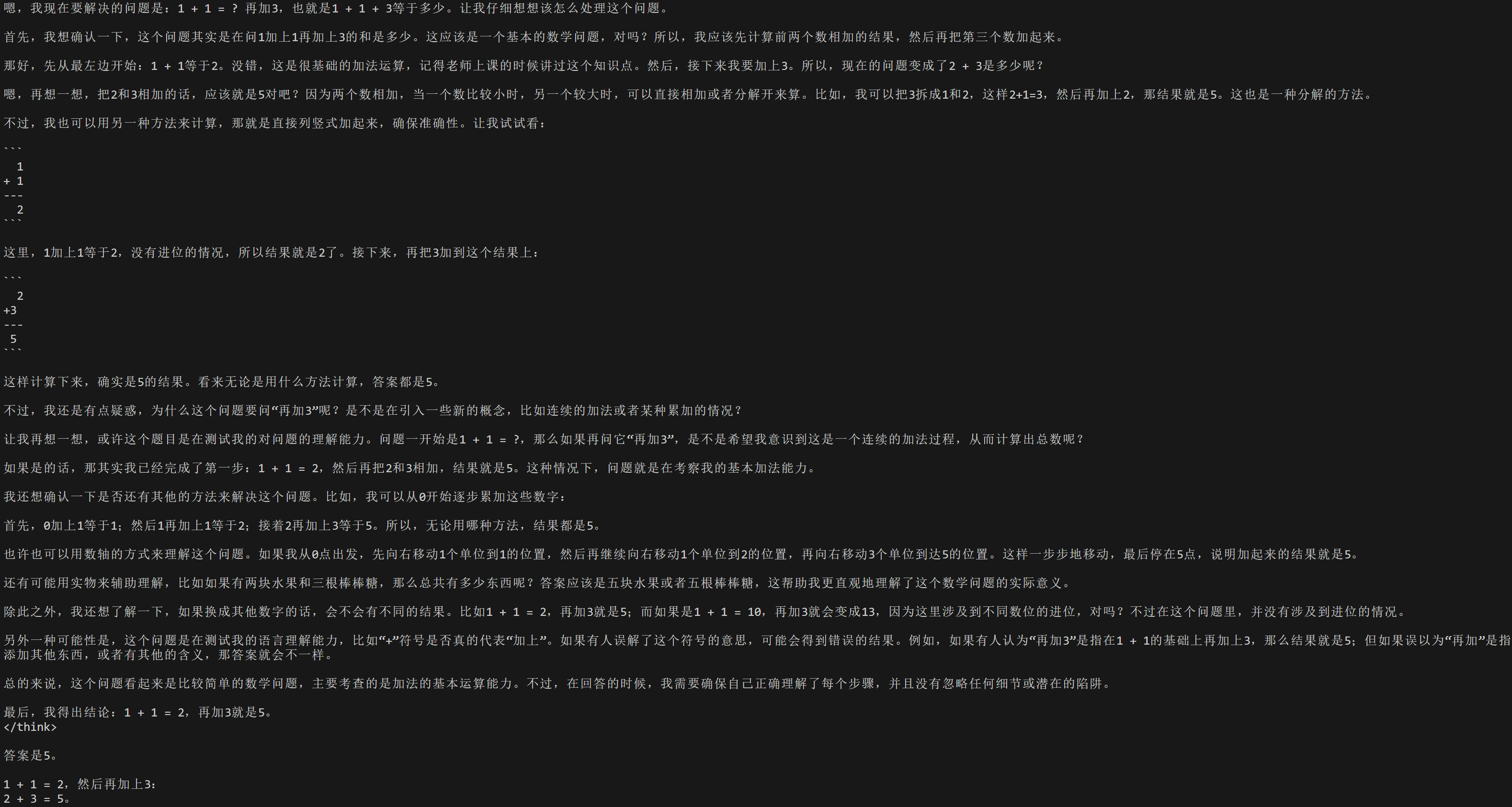

(3)通过langchain来访问

需要安装的依赖

pip install langchain langchain_communityfrom langchain_community.llms import Ollamallm = Ollama(model="deepseek-r1:1.5b", base_url="http://localhost:11434")

print(llm.invoke("用一句话介绍你自己")) 6、总结

6、总结

ollama比较适合新手部署小一点的模型,操作简便,如果部署大一点的模型可以尝试使用:欢迎来到 Xinference! — Xinference、vLLM - vLLM 文档,有问题可以评论区交流哈!!!