【论文阅读 | IF 2025 | COMO:用于多模态目标检测的跨 Mamba 交互与偏移引导融合】

论文阅读 | IF 2025 | COMO:用于多模态目标检测的跨 Mamba 交互与偏移引导融合

- 1&&2. 摘要&&引言

- 3. 方法

- 3.1 整体结构

- 3.2 Mamba 交互块

- 3.2.1 单 Mamba 块

- 3.2.2 跨 Mamba 块

- 3.3 全局和局部扫描方法

- 3.4 偏移引导融合

- 3.4.1 模块结构

- 3.4.2 融合流程

- 4. 实验

- 4.1 实验设置

- 数据集

- 对比方法与基线

- 训练与测试参数

- 4.2 评估指标

- 4.3 实验 1:DroneVehicle 数据集

- 结果概述

- 关键结论

- 4.4 实验 2:LLVIP 数据集

- 结果概述

- 关键结论

- 4.5 实验 3:VEDAI 数据集

- 结果概述

- 关键结论

- 4.6 消融研究

- 可视化分析

- 4.7 Mamba 交互块与 Transformer 对比

- 4.8 全局与局部扫描参数分析

- 4.9 应用场景讨论

- 5. 结论

题目:COMO: Cross-mamba interaction and offset-guided fusion for multimodal object detection

会议:Information Fusion(IF)

论文:paper

代码:code

年份:2025

1&&2. 摘要&&引言

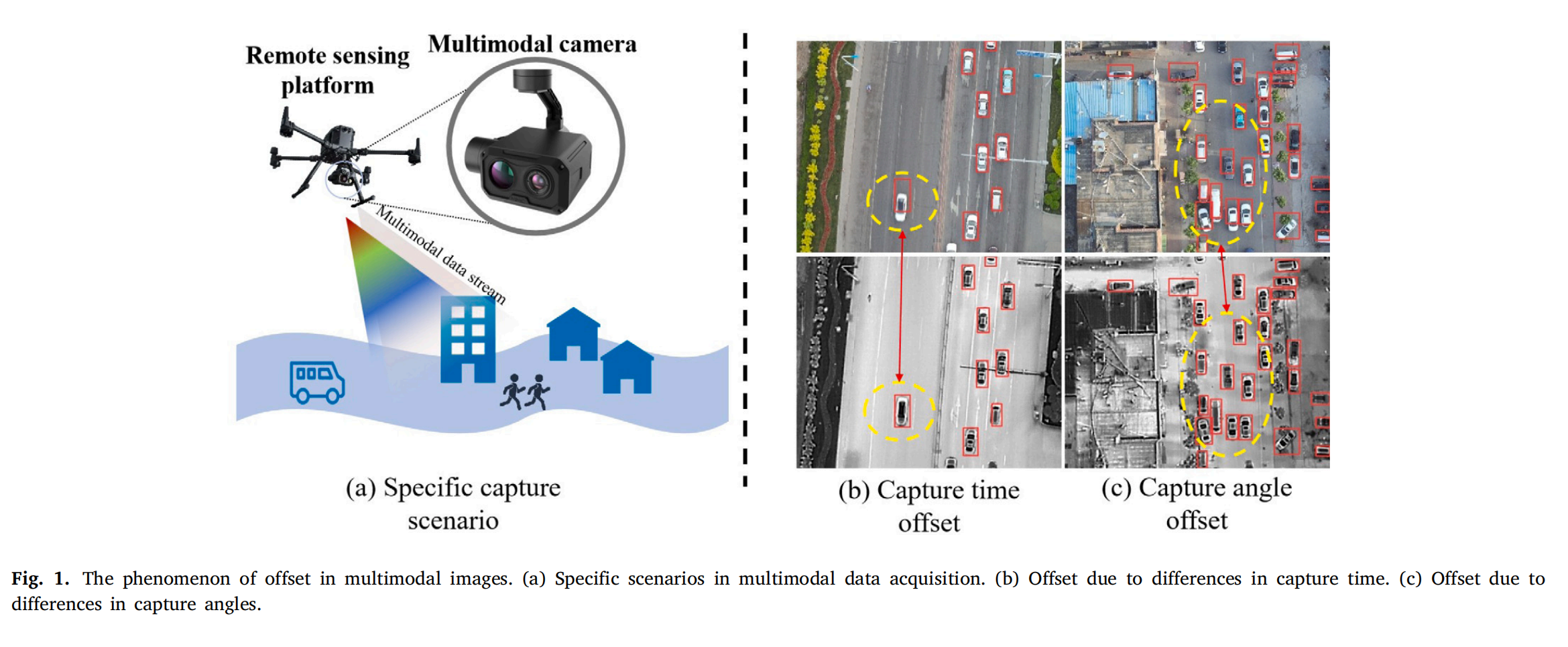

单模态目标检测任务在面对多样场景时往往会出现性能下降。相比之下,多模态目标检测任务通过融合不同模态的数据,能够提供更全面的目标特征信息。

在本文中,我们提出了一种名为跨 Mamba 交互与偏移引导融合(COMO)的新框架,用于多模态目标检测任务。COMO 框架采用跨 Mamba 技术构建特征交互方程,实现多模态序列化状态计算。这在产生交互融合输出的同时,减少了计算开销并提高了效率。

此外,COMO 利用受错位影响较小的高层特征,促进模态间的交互和互补信息传递,解决了由相机角度和捕获时间变化引起的位置偏移问题。

再者,COMO 在跨 Mamba 模块中融入全局和局部扫描机制,以捕获具有局部相关性的特征,尤其在遥感图像中。为了保留低层特征,偏移引导融合机制确保了多尺度特征的有效利用,能够构建多尺度融合数据立方体,从而提升检测性能。

所提出的 COMO 方法在三个由 RGB 和红外图像对组成的基准多模态数据集上进行了评估,在多模态目标检测任务中展现出了最先进的性能。它为遥感数据提供了量身定制的解决方案,使其更适用于实际场景。

图1. 多模态图像中的偏移现象。(a) 多模态数据采集的特定场景。(b) 由捕获时间差异导致的偏移。© 由捕获角度差异导致的偏移。

总之,本文的贡献有三点:

- 提出了一种多模态目标检测框架来解决多模态图像中的偏移问题。该框架采用 Mamba 交互方法促进模态间信息交换和互补融合。此外,它整合了全局和局部扫描机制,以捕获全局和局部相关特征。

- 设计了偏移引导融合方法,以解决仅依靠高层特征进行交互时出现的低层特征丢失问题。这种方法允许高层特征引导低层特征的融合,从而最大化信息保留并最小化偏移的影响。

- 在三个具有不同视角的基准数据集上进行了实验,并将我们的方法与几种相关方法进行了比较。结果表明,我们提出的方法在不同场景下都取得了最佳性能。此外,我们仔细检查了模型组件的影响,证实我们的方法有效满足实际应用需求。

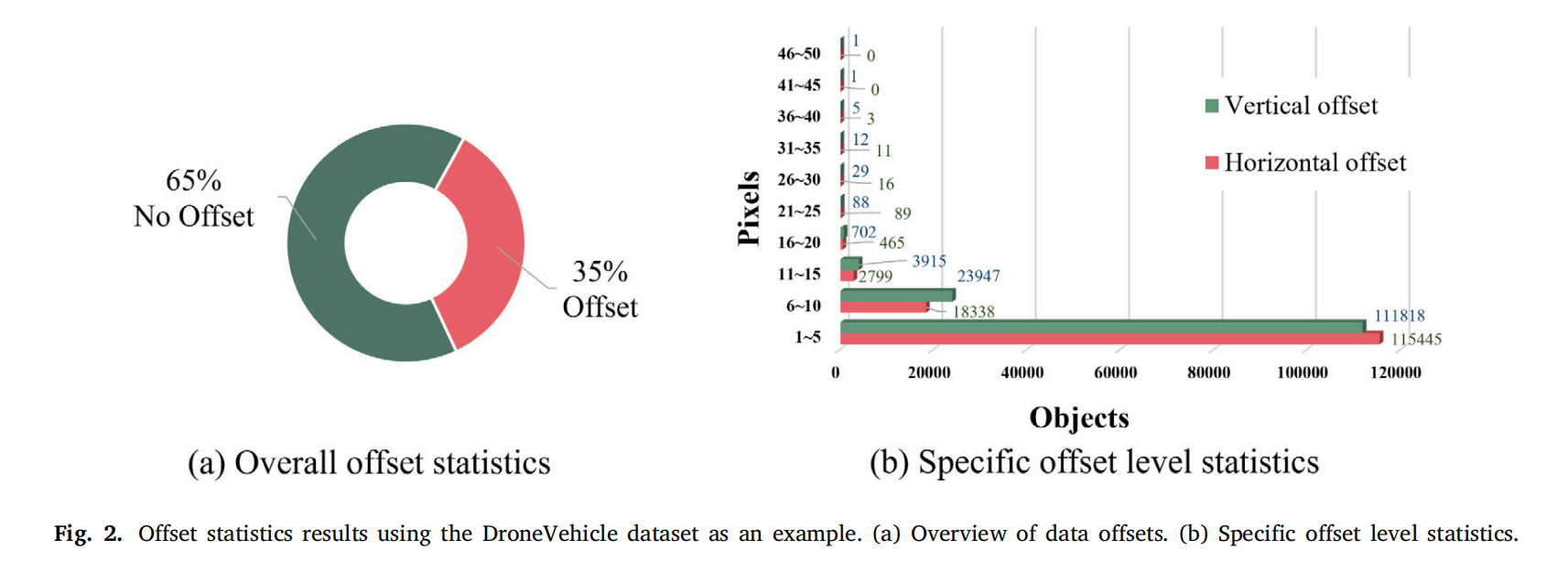

图2. 以DroneVehicle数据集为例的偏移统计结果。(a) 数据偏移概况。(b) 特定偏移程度统计。

3. 方法

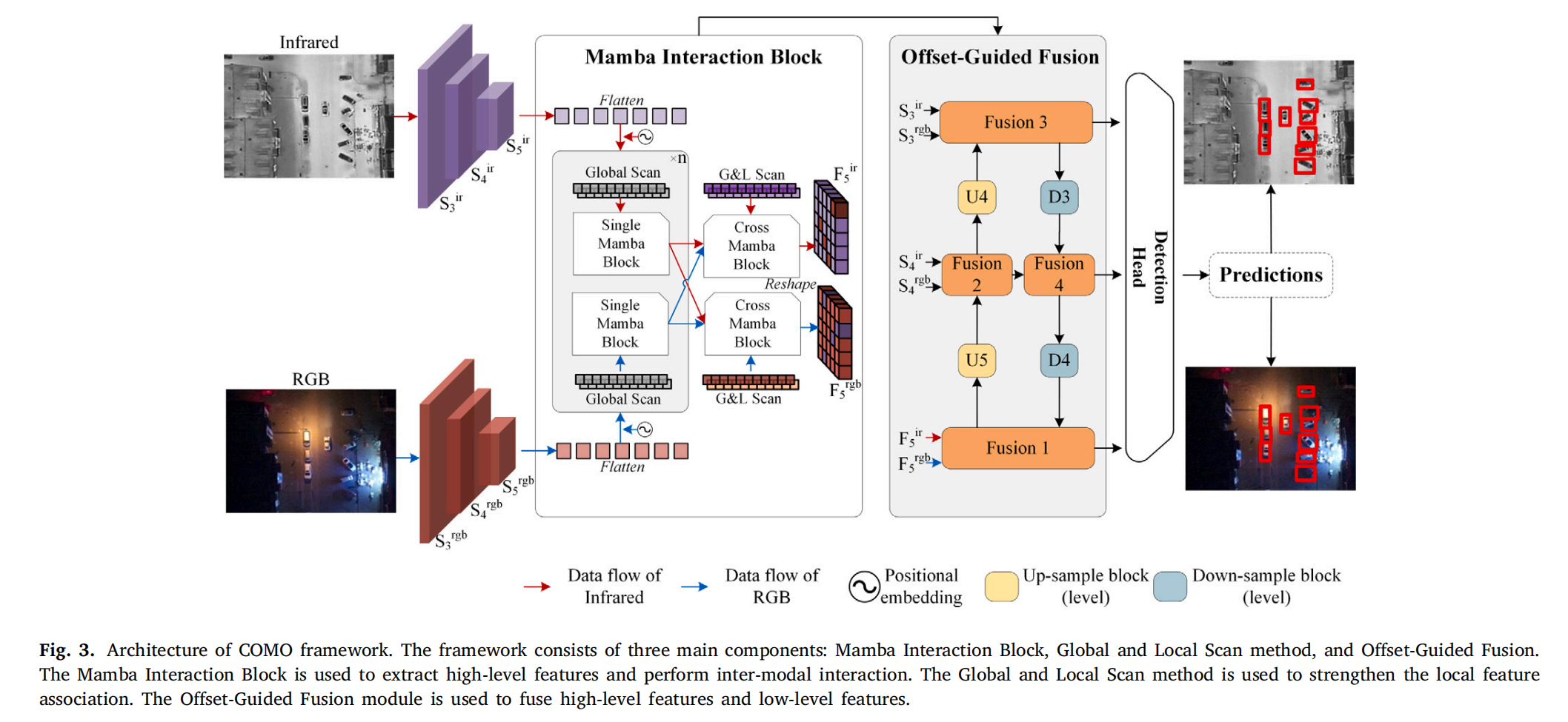

本节详细介绍 COMO(多模态目标检测)方法,其核心设计围绕模态间交互与偏移抑制展开,通过 Mamba 交互块、全局/局部扫描方法及偏移引导融合模块,实现多模态特征的高效融合与无偏检测。

图3. COMO框架的架构。该框架由三个主要组件构成:Mamba交互块、全局与局部扫描方法以及偏移引导融合模块。Mamba交互块用于提取高级特征并执行模态间交互。全局与局部扫描方法用于加强局部特征关联。偏移引导融合模块用于融合高级特征和低级特征。

3.1 整体结构

给定可见光图像 xrgbx_{\text{rgb}}xrgb 和红外图像 xirx_{\text{ir}}xir,COMO 方法通过以下步骤实现多模态目标检测:

-

多尺度特征提取:

使用两个结构相同的 CNN 骨干网络(如 ResNet)分别提取 xrgbx_{\text{rgb}}xrgb 和 xirx_{\text{ir}}xir 的多尺度特征,得到 {S3ir,S4ir,S5ir,S3rgb,S4rgb,S5rgb}\{S_3^{\text{ir}}, S_4^{\text{ir}}, S_5^{\text{ir}}, S_3^{\text{rgb}}, S_4^{\text{rgb}}, S_5^{\text{rgb}}\}{S3ir,S4ir,S5ir,S3rgb,S4rgb,S5rgb}(SkS_kSk 表示第 kkk 阶段特征图)。 -

高层特征交互:

仅选择最高级特征 {S5ir,S5rgb}\{S_5^{\text{ir}}, S_5^{\text{rgb}}\}{S5ir,S5rgb} 输入 Mamba 交互块,通过模态间交互生成融合特征 {F5ir,F5rgb}\{F_5^{\text{ir}}, F_5^{\text{rgb}}\}{F5ir,F5rgb}。 -

偏移引导融合:

将多尺度特征 {S3ir,S4ir,S3rgb,S4rgb}\{S_3^{\text{ir}}, S_4^{\text{ir}}, S_3^{\text{rgb}}, S_4^{\text{rgb}}\}{S3ir,S4ir,S3rgb,S4rgb} 与高层交互特征 {F5ir,F5rgb}\{F_5^{\text{ir}}, F_5^{\text{rgb}}\}{F5ir,F5rgb} 输入偏移引导融合网络,融合低层细节与高层语义,抑制偏移影响。 -

检测头输出:

最终融合特征经检测头输出目标检测结果(如边界框、类别置信度)。

设计动机:高层特征(S5S_5S5)包含丰富的语义信息,其空间感受野内的偏移量(Δx,Δy\Delta x, \Delta yΔx,Δy)对交集区域 Aintersection=∣wblk−Δx∣×∣hblk−Δy∣A_{\text{intersection}} = |w_{\text{blk}} - \Delta x| \times |h_{\text{blk}} - \Delta y|Aintersection=∣wblk−Δx∣×∣hblk−Δy∣ 的影响更小(wblk,hblkw_{\text{blk}}, h_{\text{blk}}wblk,hblk 为特征块尺寸),因此选择高层特征作为交互主体,既能减少计算量,又能降低偏移敏感度。

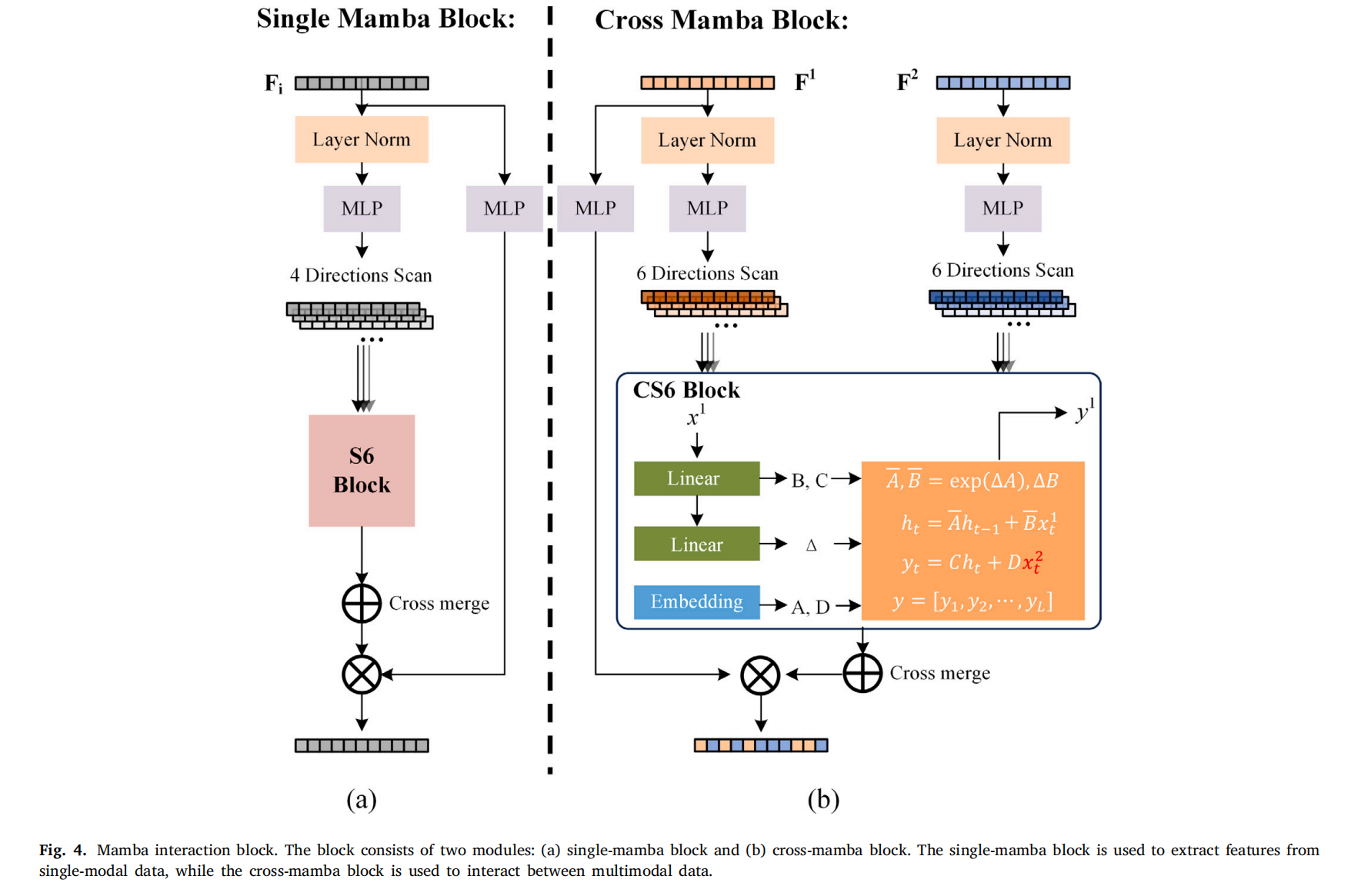

3.2 Mamba 交互块

Mamba 交互块是 COMO 的核心模块,负责模态间特征交互,包含单 Mamba 块(处理单模态特征)和跨 Mamba 块(处理多模态交互),具体结构如图 4 所示。

图4. Mamba交互块。该块由两个模块组成:(a) 单Mamba块和(b) 跨Mamba块。单Mamba块用于从单模态数据中提取特征,而跨Mamba块用于多模态数据之间的交互。

3.2.1 单 Mamba 块

单 Mamba 块用于提取单模态(如红外或可见光)的高层特征 S5S_5S5 的交互表示,流程如下:

-

特征矩阵构建:

对输入特征 SinS_{\text{in}}Sin(如 S5irS_5^{\text{ir}}S5ir 或 S5rgbS_5^{\text{rgb}}S5rgb)进行自适应最大池化和平均池化,生成维度一致的矩阵 Fin∈RH×W×CF_{\text{in}} \in \mathbb{R}^{H \times W \times C}Fin∈RH×W×C:

Fin=Pavg(Sin)+Pmax(Sin).(2)F_{\text{in}} = \mathcal{P}_{\text{avg}}(S_{\text{in}}) + \mathcal{P}_{\text{max}}(S_{\text{in}}). \tag{2} Fin=Pavg(Sin)+Pmax(Sin).(2) -

深度特征映射与 dropout:

对 FinF_{\text{in}}Fin 进行深度特征映射(线性变换),并添加 dropout 增强泛化能力:

Fm=Drop(Fh→C(Silu(FC→h(Fin)))),(3)F_m = \text{Drop}(\mathcal{F}^{h \to C}(\text{Silu}(\mathcal{F}^{C \to h}(F_{\text{in}})))), \tag{3} Fm=Drop(Fh→C(Silu(FC→h(Fin)))),(3)

其中 hhh 为隐藏层通道数,F(⋅)\mathcal{F}(\cdot)F(⋅) 为线性映射,Silu(⋅)\text{Silu}(\cdot)Silu(⋅) 为激活函数,Drop(⋅)\text{Drop}(\cdot)Drop(⋅) 为随机丢弃神经元。 -

序列化与位置编码:

将 FmF_mFm 展平为令牌序列,并添加可学习的位置嵌入(显式编码空间位置),模拟状态空间模型(SSM)的序列输入。 -

四方向扫描与 SSM 特征提取:

通过四方向扫描(crossscan)扩展序列分布,每个方向的扫描结果经 S6 块(SSM 增强结构)提取特征,最终反向扫描(reversescan)恢复原始序列结构,输出融合特征 FoutF_{\text{out}}Fout:

{xi=crossscani(Iin),yi=S6i(xi),i=1,2,3,4Iout=∑i=14reversescani(yi).(4)\begin{cases} x_i = \text{crossscan}_i(I_{\text{in}}), \\ y_i = S6_i(x_i), & i = 1,2,3,4 \\ I_{\text{out}} = \sum_{i=1}^4 \text{reversescan}_i(y_i). \end{cases} \tag{4} ⎩⎨⎧xi=crossscani(Iin),yi=S6i(xi),Iout=∑i=14reversescani(yi).i=1,2,3,4(4)

S6 块(SSM 结构):

S6 块通过离散状态空间方程建模序列依赖,参数通过时间尺度 Δ\DeltaΔ 离散化(ZOH 转换):

{A‾=exp(ΔA),B‾=(ΔA)−1(exp(ΔA)−I)⋅ΔB≈ΔB,(5)\begin{cases} \overline{A} = \exp(\Delta A), \\ \overline{B} = (\Delta A)^{-1}(\exp(\Delta A) - I) \cdot \Delta B \approx \Delta B, \end{cases} \tag{5} {A=exp(ΔA),B=(ΔA)−1(exp(ΔA)−I)⋅ΔB≈ΔB,(5)

离散化后,状态转移方程为:

{ht=A‾ht−1+B‾xt,yt=Cht+Dxt,(6)\begin{cases} h_t = \overline{A} h_{t-1} + \overline{B} x_t, \\ y_t = C h_t + D x_t, \end{cases} \tag{6} {ht=Aht−1+Bxt,yt=Cht+Dxt,(6)

最终输出为所有时间步结果的集合 Ys=[y1,y2,...,yL]Y_s = [y_1, y_2, ..., y_L]Ys=[y1,y2,...,yL](L=H×WL = H \times WL=H×W)。

3.2.2 跨 Mamba 块

跨 Mamba 块用于多模态特征交互(如红外与可见光),输入为多模态高层特征 Fs1F_s^1Fs1(红外)和 Fs2F_s^2Fs2(可见光),流程如下:

-

交叉扫描与 CS6 核心计算:

对 Fs1F_s^1Fs1 和 Fs2F_s^2Fs2 进行四方向交叉扫描,生成交互序列 xi1,xi2x_i^1, x_i^2xi1,xi2,经 CS6 块提取跨模态特征:

{xi1,xi2=crossscani(Fs1,Fs2),yi=CS6i(xi1,xi2),i=1,2,...,6Iout=∑i=14reversali(yi).(7)\begin{cases} x_i^1, x_i^2 = \text{crossscan}_i(F_s^1, F_s^2), \\ y_i = \text{CS6}_i(x_i^1, x_i^2), & i = 1,2,...,6 \\ I_{\text{out}} = \sum_{i=1}^4 \text{reversal}_i(y_i). \end{cases} \tag{7} ⎩⎨⎧xi1,xi2=crossscani(Fs1,Fs2),yi=CS6i(xi1,xi2),Iout=∑i=14reversali(yi).i=1,2,...,6(7) -

CS6 核心方程:

CS6 块将第一种模态输入视为历史状态 ht−1h_{t-1}ht−1,与第二种模态输入 xt2x_t^2xt2 交互,生成跨模态输出:

{ht=A‾ht−1+B‾xt1,yt=Cht+Dxt2,(8)\begin{cases} h_t = \overline{A} h_{t-1} + \overline{B} x_t^1, \\ y_t = C h_t + D x_t^2, \end{cases} \tag{8} {ht=Aht−1+Bxt1,yt=Cht+Dxt2,(8)

最终输出 F5rgbF_5^{\text{rgb}}F5rgb 和 F5irF_5^{\text{ir}}F5ir 为跨 Mamba 块的多模态融合结果。

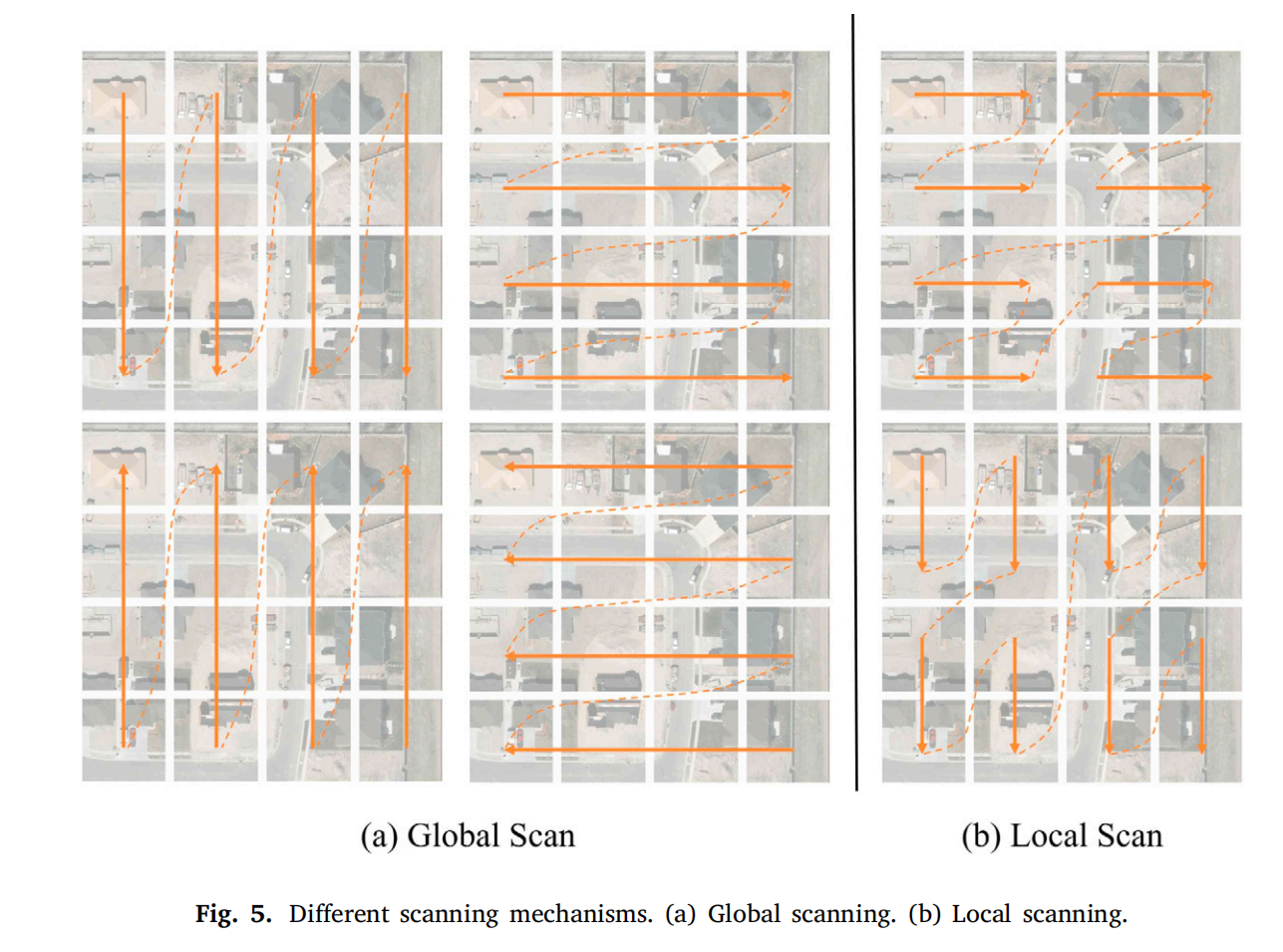

图5. 不同的扫描机制。(a) 全局扫描。(b) 局部扫描。

3.3 全局和局部扫描方法

Mamba 模型的 S6 块擅长处理一维因果序列,但视觉图像的空间关系是非因果的(如局部依赖强于全局顺序)。为解决此问题,COMO 提出全局-局部扫描方法(GLS),结合全局扫描与局部窗口扫描:

- 全局扫描:沿图像高度方向逐行扫描(类似 Vim [37]),捕获长距离依赖;

- 局部扫描:将图像划分为多个窗口(尺寸为图像大小的 1/3),逐窗口扫描,保留局部细节关联。

在跨 Mamba 块中,通过添加 2 个方向的局部扫描(如水平、垂直),增强模型对局部空间关系的建模能力,平衡全局上下文与局部细节(如图 5 所示)。

3.4 偏移引导融合

为解决高层特征语义丰富但缺乏低层纹理细节、低层特征受偏移影响大的问题,COMO 设计偏移引导融合模块,通过自上而下(FPN)与自下而上(PAN)的路径融合多尺度特征:

3.4.1 模块结构

融合模块接收三类输入:

- 高层特征 F5ir,F5rgbF_5^{\text{ir}}, F_5^{\text{rgb}}F5ir,F5rgb(无偏移引导);

- 红外低层特征 S3ir,S4irS_3^{\text{ir}}, S_4^{\text{ir}}S3ir,S4ir;

- 可见光低层特征 S3rgb,S4rgbS_3^{\text{rgb}}, S_4^{\text{rgb}}S3rgb,S4rgb。

3.4.2 融合流程

-

通道重建与残差保留:

对拼接后的输入特征 xxx,通过卷积通道残差保留块(ConvBlock)和通道重建块(RepBlock)增强信息流:

F(x)=∑i=1N(ConvBlocki(x)+RepBlock(ConvBlocki(x))).(9)F(x) = \sum_{i=1}^N \left( \text{ConvBlock}_i(x) + \text{RepBlock}(\text{ConvBlock}_i(x)) \right). \tag{9} F(x)=i=1∑N(ConvBlocki(x)+RepBlock(ConvBlocki(x))).(9) -

多尺度融合:

高层特征通过 FPN 自上而下引导低层特征的融合,低层特征通过 PAN 自下而上补充细节,最终输出融合后的多尺度特征,输入检测头完成目标检测。

设计优势:高层特征引导低层特征细化,缓解偏移对低层纹理的影响;融合模块与检测颈部集成,减少冗余计算,提升实时性。

4. 实验

本节通过多模态目标检测任务验证 COMO 方法的有效性,涵盖实验设置、评估指标、多数据集验证、消融研究及模块分析,最终展示其在实际场景中的适用性。

4.1 实验设置

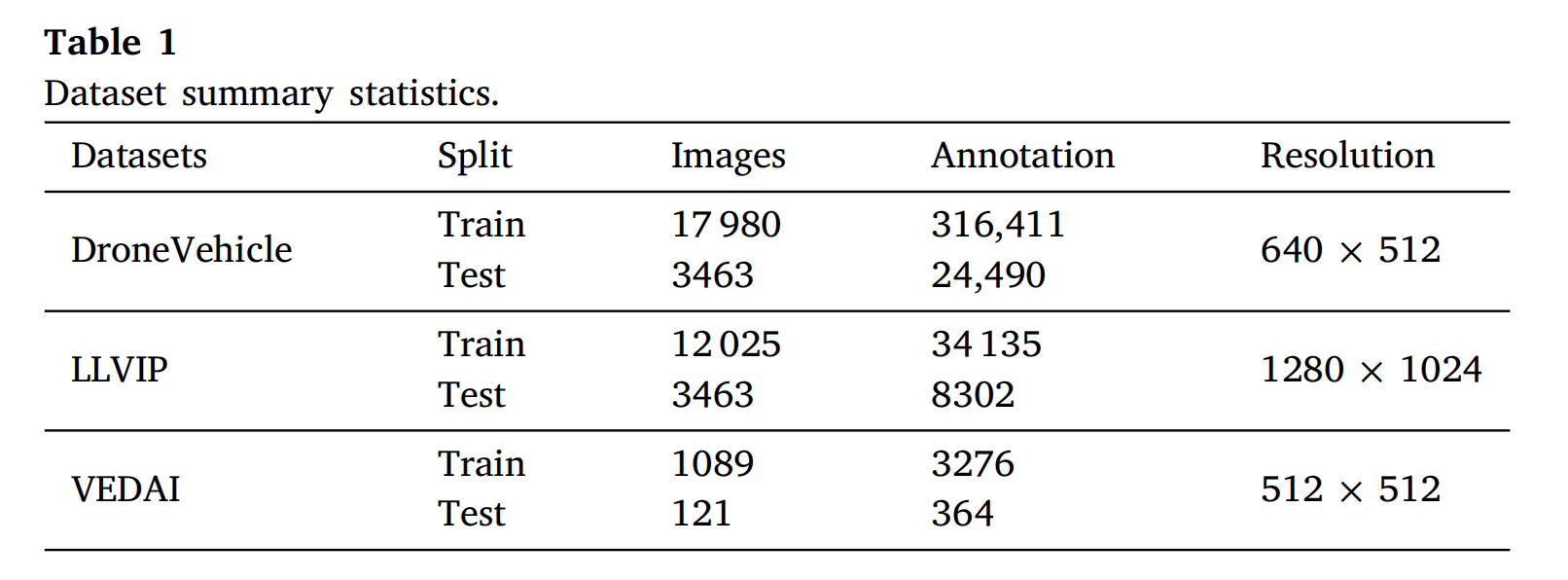

数据集

选择三个不同视角的数据集验证模型泛化能力:

- DroneVehicle:大规模无人机捕获的 RGB-红外图像对(28,439 对训练,1,469 对测试),含汽车、卡车等五类目标,存在位置偏移挑战;

- LLVIP:低光照道路监控的行人检测数据集(16,836 对训练),仅含夜间场景,可见光信息不足且遮挡频繁;

- VEDAI:小规模遥感图像数据集(1200+图像,3700+目标),含8类车辆,目标小且分辨率低。

对比方法与基线

- 对比方法:YOLOrs、CFT、SuperYOLO、GHOST、MFPT、ICAFusion、GM-DETR、DaFF、CMADet 等 9 种 SOTA 方法;

- 基线模型:基于 YOLOv5(s/l 版本)和 YOLOv8(s 版本)实现 COMO,利用 COCO 预训练权重初始化,采用马赛克数据增强。

训练与测试参数

- 训练配置:DroneVehicle/LLVIP 使用 YOLOv5s/YOLOv8s(150 轮),VEDAI 使用 YOLOv5l(300 轮);

- 测试配置:批量大小 32,FPS 衡量推理速度(不使用 FP16/TensorRT 加速)。

4.2 评估指标

- 核心指标:MS-COCO 标准平均精度(mAP),计算所有类别 AP 的平均值;

- 补充指标:IoU=50% 时的 mAP(mAP50mAP_{50}mAP50),评估目标定位与分类的平衡性能;

- 其他指标:模型大小(Parameter)、计算量(Flops)、推理速度(FPS),衡量实时性与资源消耗。

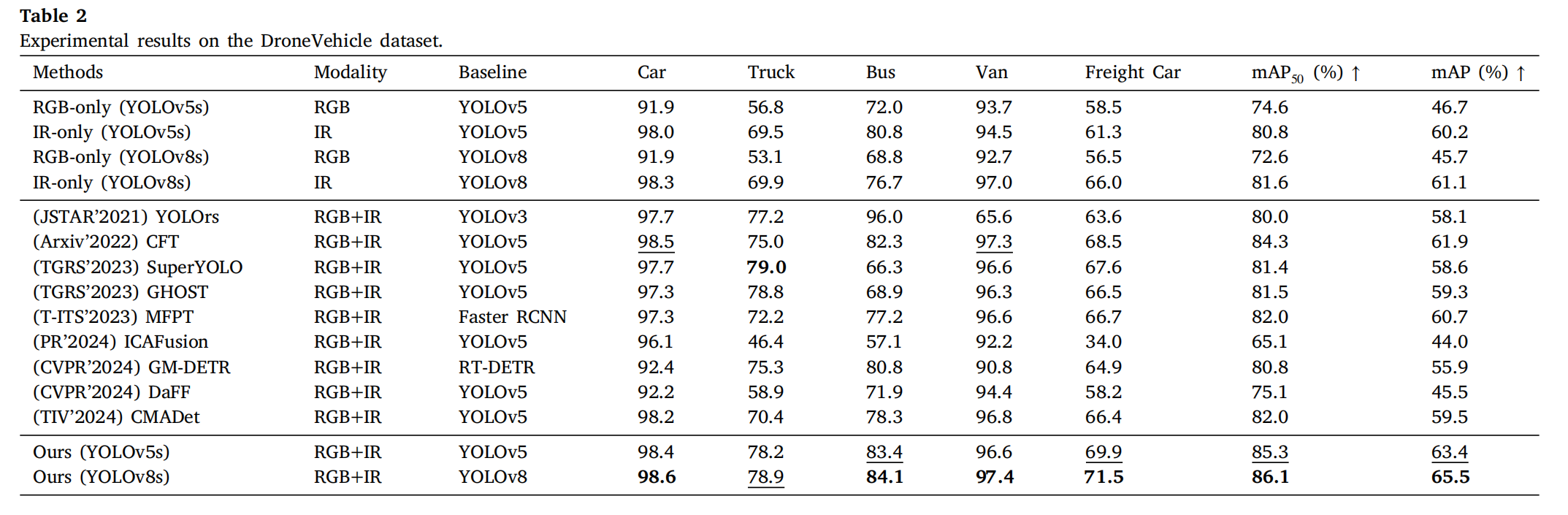

4.3 实验 1:DroneVehicle 数据集

结果概述

COMO 在 DroneVehicle 上取得最先进性能(表 2):

- YOLOv8s 基线:mAP50=86.1%mAP_{50}=86.1\%mAP50=86.1%,mAP=65.5%(均优于其他方法);

- YOLOv5s 基线:mAP50=85.3%mAP_{50}=85.3\%mAP50=85.3%,mAP=63.4%(显著领先)。

关键结论

- 偏移抑制:仅使用受偏移影响小的高层特征(S5S_5S5)交互,结合低层特征融合,有效减轻偏移对检测的影响;

- 实时性优势:模型参数量(56.31 MB)与计算量(14.03 GFLOPs)低于 Transformer 方法(如 146.09 MB、15.31 GFLOPs),推理速度更快;

- 大目标检测:在货车、公共汽车等大目标检测中表现突出,验证其对复杂场景的适应性。

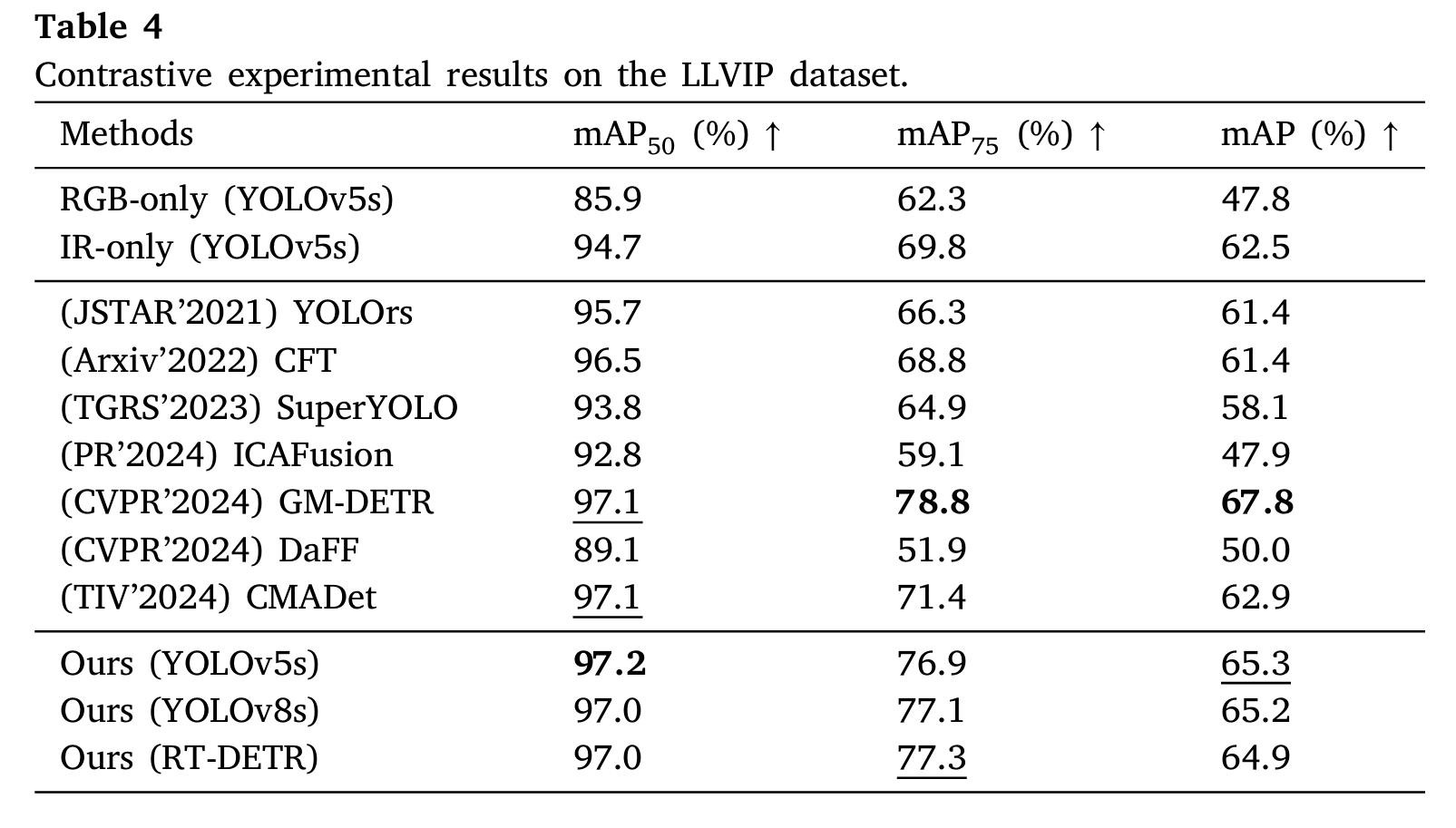

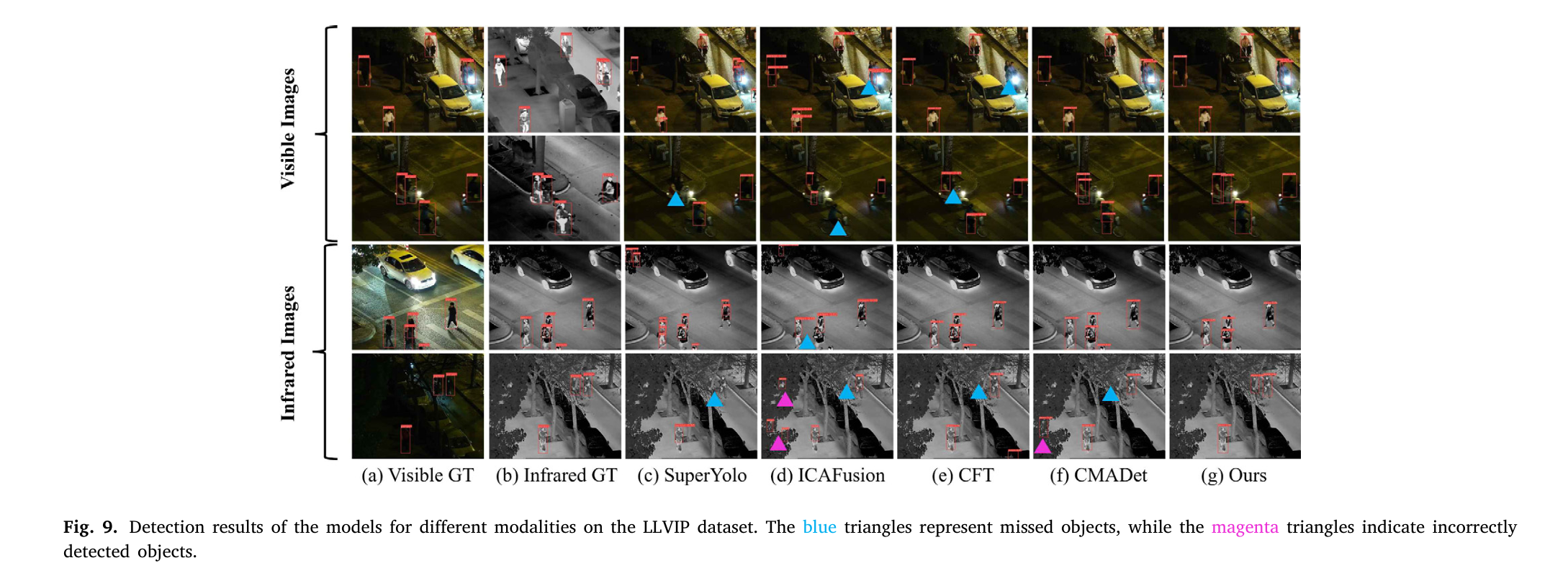

4.4 实验 2:LLVIP 数据集

结果概述

LLVIP 为低光照夜间行人检测场景,COMO 表现如下(表 4):

- YOLOv5 基线:mAP50=97.2%mAP_{50}=97.2\%mAP50=97.2%(最佳性能),mAP=96.8%mAP=96.8\%mAP=96.8%;

- 对比分析:尽管 mAP75mAP_{75}mAP75 略低于 GM-DETR(因数据集同质性高),但与次优方法差距小,验证其在单类别多模态检测中的泛化能力。

关键结论

- 多模态互补:有效融合红外(热辐射)与可见光(纹理)信息,解决夜间可见光信息不足问题;

- 遮挡鲁棒性:通过局部扫描与高层特征引导,缓解遮挡对目标检测的影响。

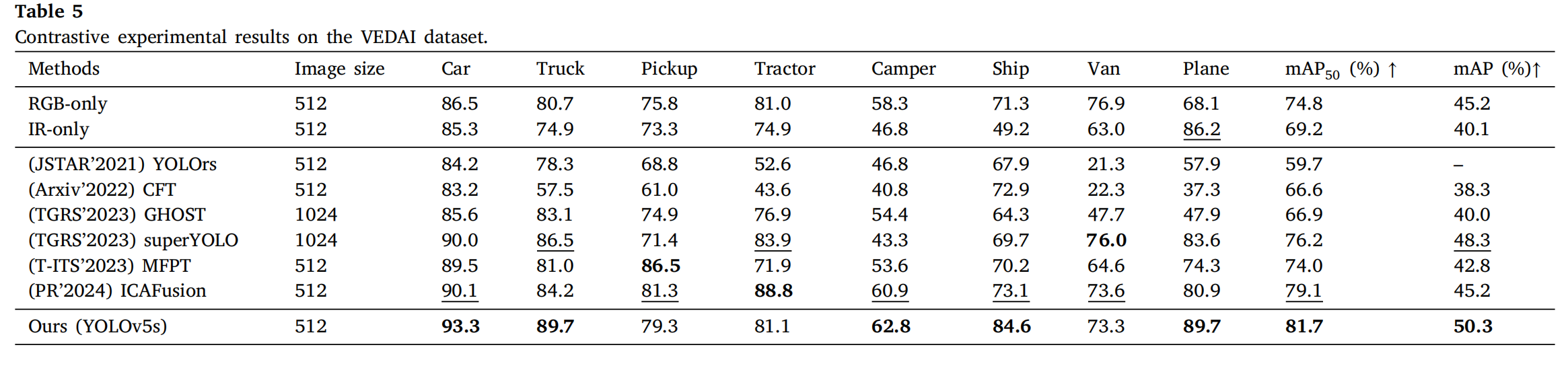

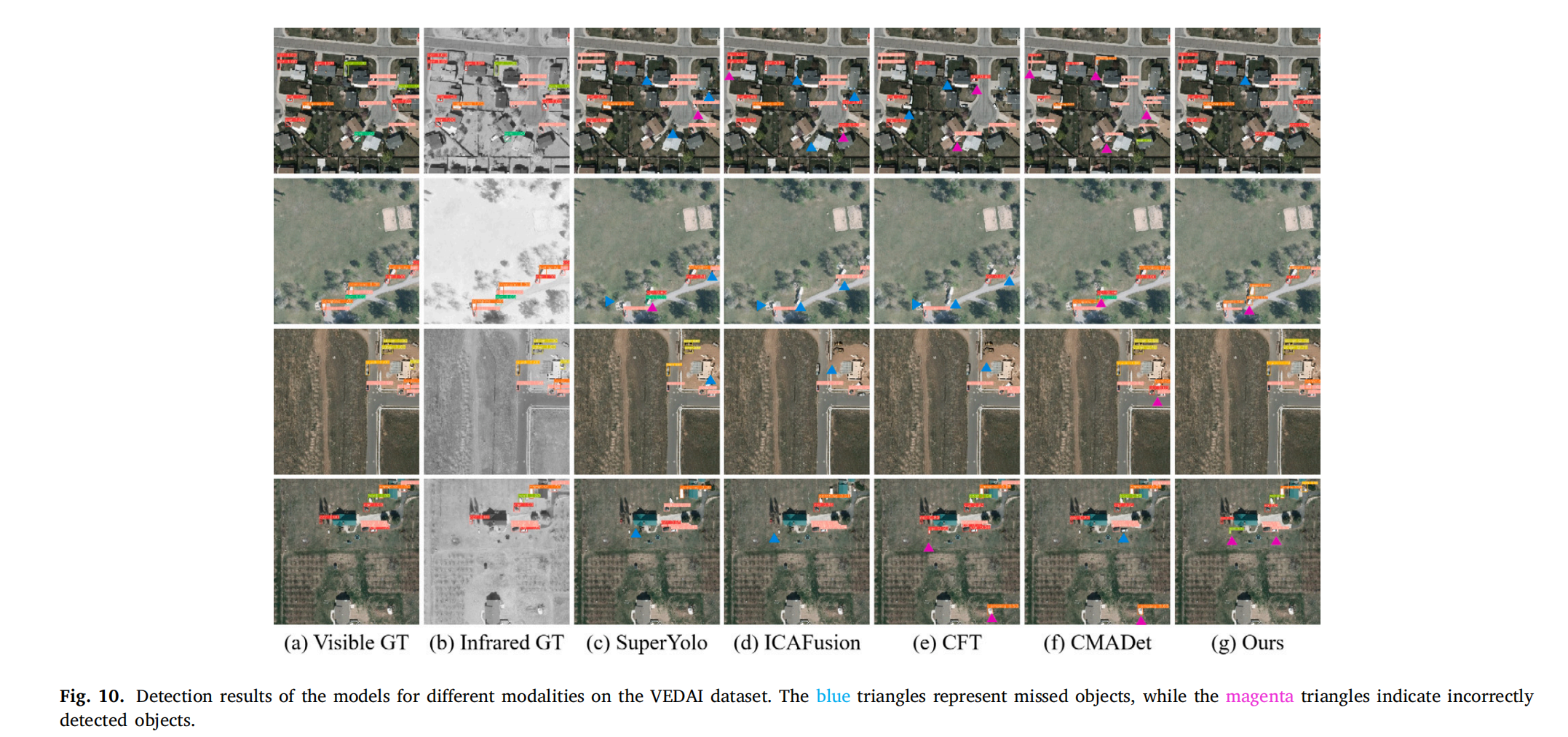

4.5 实验 3:VEDAI 数据集

结果概述

VEDAI 为小目标遥感检测场景,COMO 表现如下(表 5):

- YOLOv5 基线:mAP50=85.3%mAP_{50}=85.3\%mAP50=85.3%(最佳性能),显著优于其他方法;

- 小目标检测:通过多尺度特征融合(S3−S5S_3-S_5S3−S5)与局部扫描,有效捕捉小目标细节(如 512×512 分辨率下的车辆)。

关键结论

- 遥感适配性:验证 COMO 在对齐良好的机载遥感数据上的有效性,扩展了其应用场景;

- 多尺度优势:融合低层(细节)与高层(语义)特征,提升小目标检测精度。

4.6 消融研究

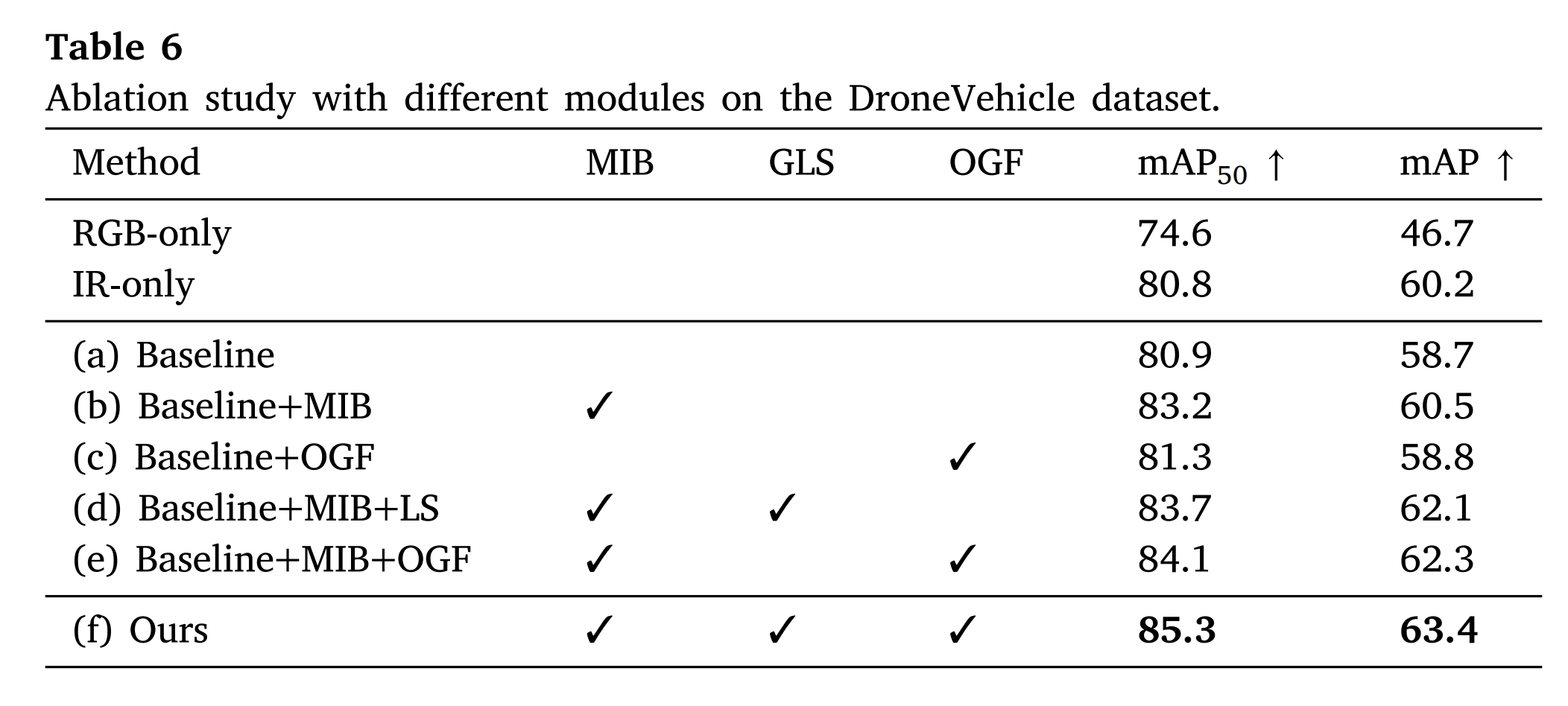

通过消融实验验证各模块必要性(表 6):

- Mamba 交互块(MIB):移除后 mAP50mAP_{50}mAP50 下降 2.4%,证明其对跨模态交互的关键作用;

- 全局-局部扫描(GLS):仅使用全局扫描时 mAP50mAP_{50}mAP50 仅提升 0.5%,添加局部扫描后提升至 85.3%,验证局部特征对细节的增强;

- 偏移引导融合(OGF):引入后 mAP50mAP_{50}mAP50 提升 0.9%,表明高层特征引导可有效减轻偏移影响。

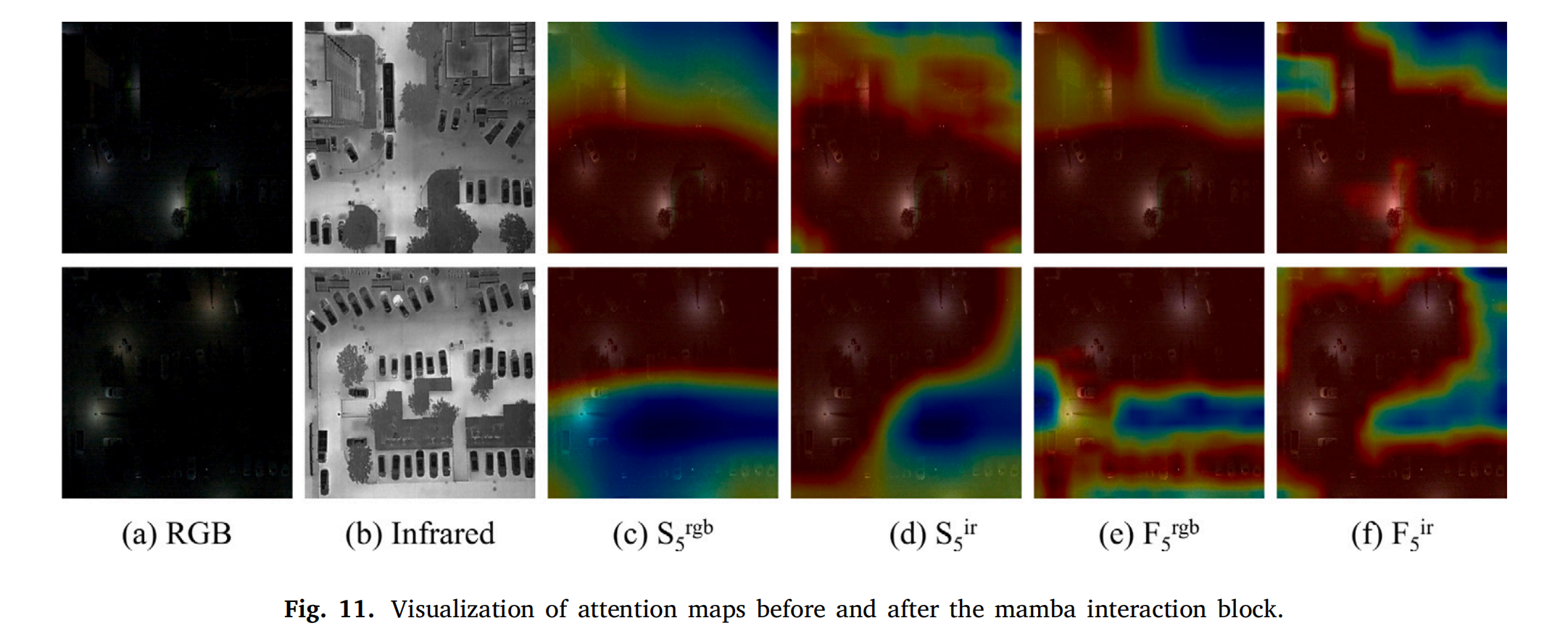

可视化分析

Mamba 交互块的注意力图显示(图 11):

- 红外增强 RGB 弱边缘结构,RGB 丰富红外空间连续性;

- 动态特征选择抑制跨模态噪声,模态一致边界对齐验证状态空间建模的有效性。

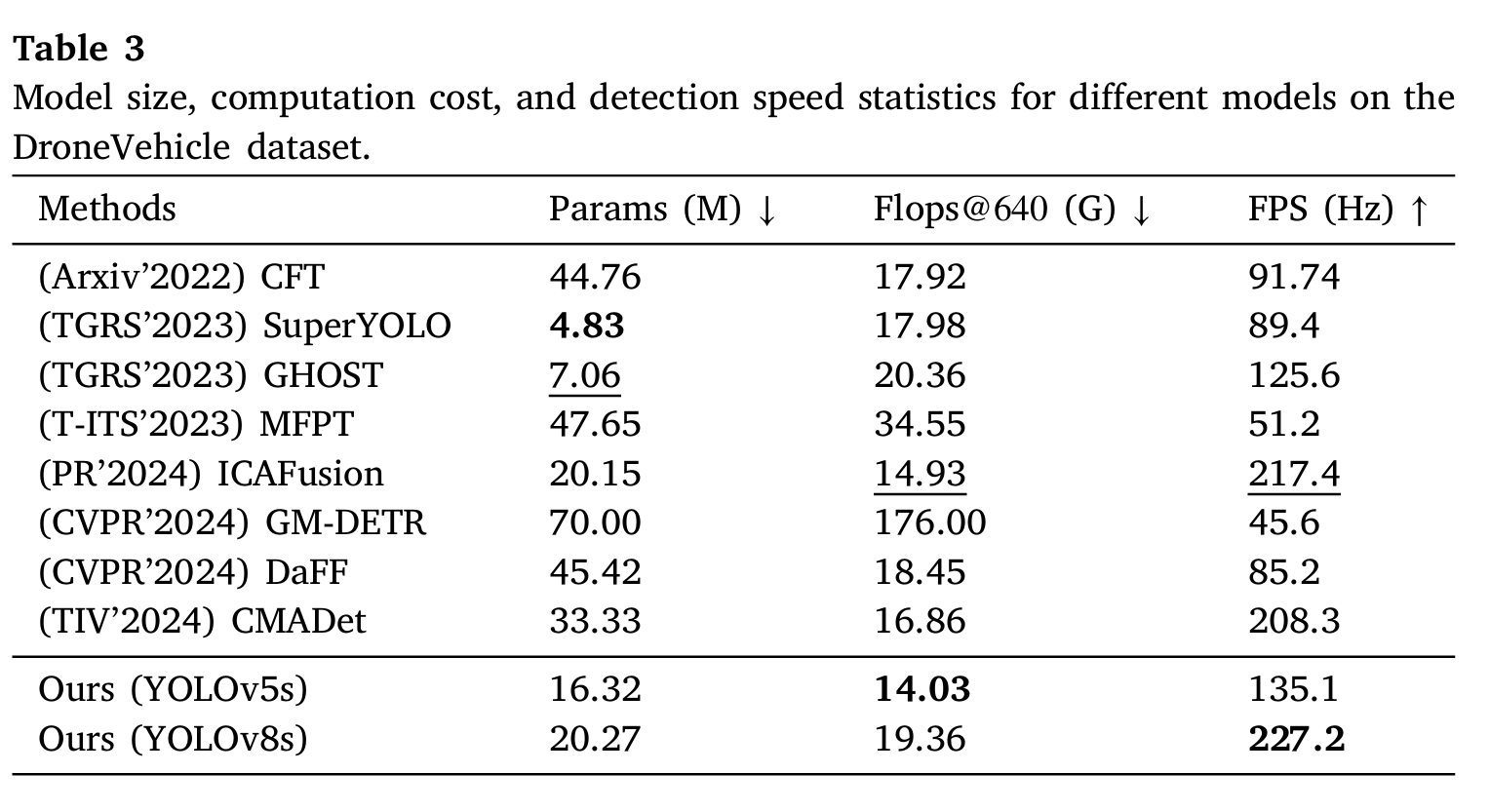

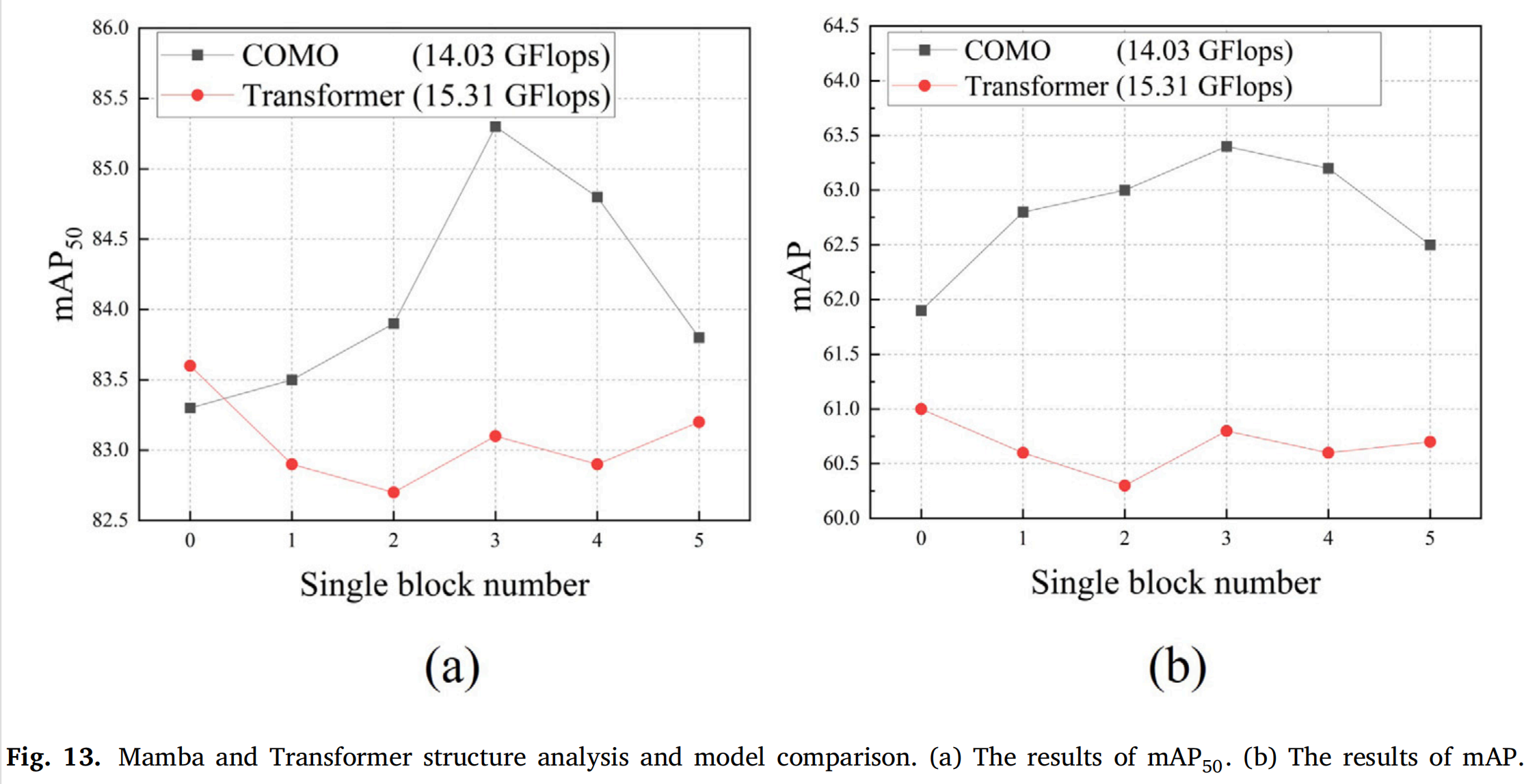

4.7 Mamba 交互块与 Transformer 对比

设计对比实验(图 13):

- MIB 模块:单块数量 3 时 mAP50=85.3%mAP_{50}=85.3\%mAP50=85.3%,计算量 14.03 GFLOPs,模型大小 56.31 MB;

- Transformer 模块:单块数量 0 时 mAP50=83.6%mAP_{50}=83.6\%mAP50=83.6%,计算量与模型大小显著更高(15.31 GFLOPs、146.09 MB)。

结论:MIB 在多模态任务中更高效,能更好捕获跨模态交互并提升性能。

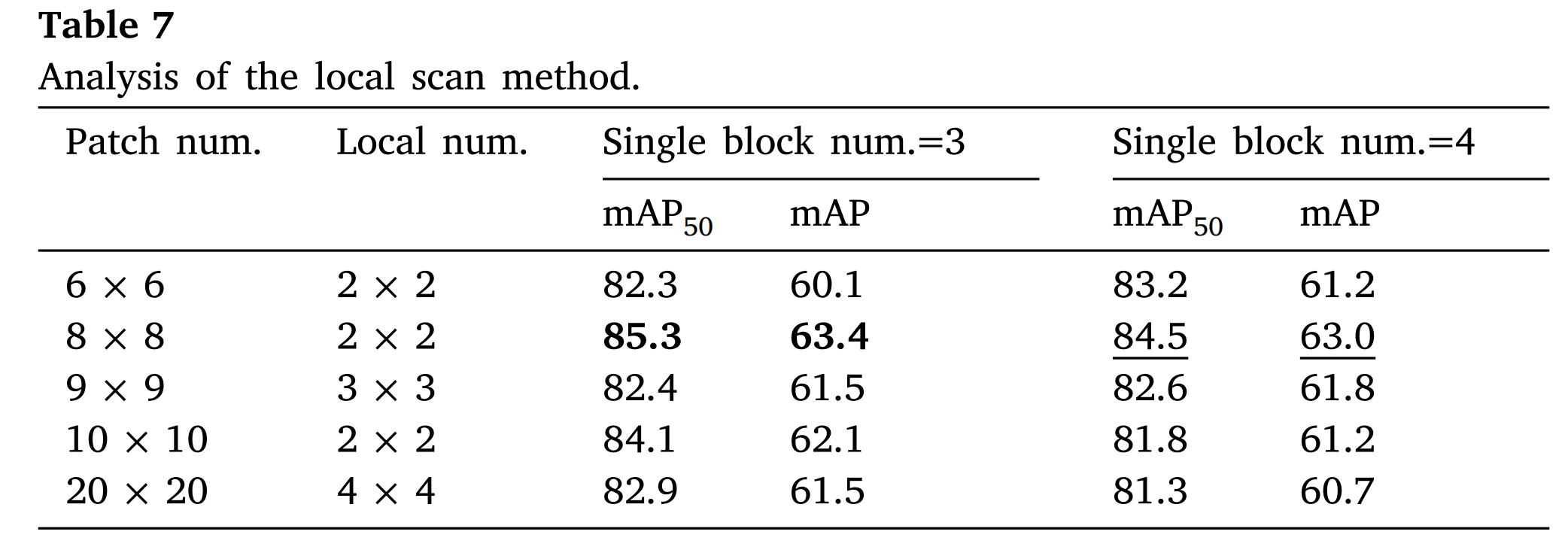

4.8 全局与局部扫描参数分析

通过调整补丁大小与局部窗口大小(表 7),确定最佳参数:

- 补丁数量 8×8(640×640 图像分 8×8 补丁),局部窗口 2×2 时 mAP50=85.3%mAP_{50}=85.3\%mAP50=85.3%;

- 原因:小窗口增强局部细节关联,大补丁保留全局上下文,平衡细节与全局信息。

4.9 应用场景讨论

COMO 适用于多模态目标检测的广泛场景:

- 航空/无人机:处理大范围、多尺度目标(如车辆、建筑);

- 道路监控:夜间、低光照行人检测;

- 遥感:小目标(如车辆)的高精度识别。

优势总结:多模态互补、偏移抑制、实时性强,满足实际应用需求。

5. 结论

本文提出 COMO 方法,通过 Mamba 交互块、全局-局部扫描及偏移引导融合,在多模态目标检测任务中实现最先进性能。实验验证其在 DroneVehicle(大目标)、LLVIP(低光照行人)、VEDAI(小目标遥感)等场景的有效性,且计算效率与实时性突出。未来将探索 COMO 在更多模态(如激光雷达)及其他任务(如分割)中的应用。