2 Studying《BPF.Performance.Tools》1-9

目录

1 Introduction

1.1 What Are BPF and eBPF?

1.2 What Are Tracing, Snooping, Sampling, Profiling, and Observability?

1.3 What Are BCC, bpftrace, and IO Visor?

1.4 A First Look at BCC: Quick Wins

1.5 BPF Tracing Visibility

1.6 Dynamic Instrumentation: kprobes and uprobes

1.7 Static Instrumentation: Tracepoints and USDT

1.8 A First Look at bpftrace: Tracing open()

1.9 Back to BCC: Tracing open()

1.10 Summary

2 Technology Background

2.1 BPF Illustrated

2.2 BPF

2.3 Extended BPF (eBPF)

2.4 Stack Trace Walking

2.5 Flame Graphs

2.6 Event Sources

2.7 kprobes

2.8 uprobes

2.9 Tracepoints

2.10 USDT

2.11 Dynamic USDT

2.12 PMCs

2.13 perf_events

2.14 Summary

3 Performance Analysis

3.1 Overview

3.2 Performance Methodologies

3.3 Linux 60-Second Analysis

3.4 BCC Tool Checklist

3.5 Summary

4 BCC

4.1 BCC Components

4.2 BCC Features

4.3 BCC Installation

4.4 BCC Tools

4.5 funccount

4.6 stackcount

4.7 trace

4.8 argdist

4.9 Tool Documentation

4.10 Developing BCC Tools

4.11 BCC Internals

4.12 BCC Debugging

4.13 Summary

5 bpftrace

5.1 bpftrace Components

5.2 bpftrace Features

5.3 bpftrace Installation

5.4 bpftrace Tools

5.5 bpftrace One-Liners

5.6 bpftrace Documentation

5.7 bpftrace Programming

5.8 bpftrace Usage

5.9 bpftrace Probe Types

5.10 bpftrace Flow Control

5.11 bpftrace Operators

5.12 bpftrace Variables

5.13 bpftrace Functions

5.14 bpftrace Map Functions

5.15 bpftrace Future Work

5.16 bpftrace Internals

5.17 bpftrace Debugging

5.18 Summary

6 CPUs

6.1 Background

6.2 Traditional Tools

6.3 BPF Tools

6.4 BPF One-Liners

6.5 Optional Exercises

6.6 Summary

7 Memory

7.1 Background

7.2 Traditional Tools

7.3 BPF Tools

7.4 BPF One-Liners

7.5 Optional Exercises

7.6 Summary

8 File Systems

8.1 Background

8.2 Traditional Tools

8.3 BPF Tools

8.4 BPF One-Liners

8.5 Optional Exercises

8.6 Summary

9 Disk I/O

9.1 Background

9.2 Traditional Tools

9.3 BPF Tools

9.4 BPF One-Liners

9.5 Optional Exercises

9.6 Summary

1 Introduction

本章介绍了一些关键术语,总结了一些技术,并演示了一些BPF性能工具。这些技术将在接下来的章节中进行更详细的解释。

1.1 What Are BPF and eBPF?

BPF代表伯克利包过滤器,这是一种首次开发于1992年的冷门技术,用于提高数据包捕获工具的性能 [McCanne 92]。2013年,Alexei Starovoitov提出了对BPF的重大重写[2],随后由Alexei和Daniel Borkmann进一步开发,并在2014年被纳入Linux内核[3]。这将BPF转变为一个通用的执行引擎,可用于多种用途,包括创建高级性能分析工具。

由于BPF功能强大,所以很难精确解释。它提供了一种在各种内核和应用事件上运行小型程序的方法。如果你熟悉JavaScript,你可能会发现一些相似之处:JavaScript允许网站在浏览器事件(如鼠标点击)上运行小型程序,从而实现各种基于网页的应用。BPF允许内核在系统和应用事件(如磁盘I/O)上运行小型程序,从而实现新的系统技术。它使内核完全可编程,使用户(包括非内核开发者)能够定制和控制他们的系统,以解决实际问题。

BPF是一种灵活且高效的技术,由指令集、存储对象和帮助函数组成。由于其虚拟指令集规范,它可以被视为一种虚拟机。这些指令由Linux内核BPF运行时执行,包括一个解释器和一个将BPF指令转换为原生指令以执行的JIT编译器。BPF指令首先必须通过一个验证器,验证器检查安全性,以确保BPF程序不会崩溃或破坏内核(但它不会防止用户编写可能执行但不合理的逻辑程序)。BPF的组件在第二章中详细解释。

到目前为止,BPF的三个主要用途是网络、可观察性和安全性。本书重点关注可观察性(跟踪)。

扩展的BPF通常缩写为eBPF,但官方缩写仍然是BPF,没有“e”。因此,在本书中,我使用BPF来指代扩展的BPF。内核中只有一个执行引擎,即BPF(扩展的BPF),它既运行扩展的BPF程序,也运行“经典的”BPF程序。

1.2 What Are Tracing, Snooping, Sampling, Profiling, and Observability?

这些术语都是用于分类分析技术和工具的。

**追踪**是一种基于事件的记录方法,也是这些BPF工具所使用的仪器类型。你可能已经使用过一些特定用途的追踪工具。例如,Linux的strace(1)记录并打印系统调用事件。有许多工具不进行事件追踪,而是使用固定的统计计数器来测量事件,然后打印摘要;Linux的top(1)就是一个例子。追踪器的一个显著特征是它能够记录原始事件及其元数据。这类数据可能非常庞大,可能需要后期处理成摘要。BPF使得编程追踪器成为可能,这些追踪器可以在事件上运行小程序,以实现自定义的实时统计摘要或其他操作,从而避免了昂贵的后处理。

虽然strace(1)的名称中带有“trace”(追踪),但并不是所有的追踪器都这样命名。例如,tcpdump(8)是另一种用于网络数据包的专用追踪器。(或许它应该被命名为tcptrace?)Solaris操作系统有自己的版本叫snoop(1M)2,是用来嗅探网络数据包的。我是第一个开发和发布许多追踪工具的人,并且是在Solaris上进行的,当时我(也许是遗憾地)为我早期的工具使用了“嗅探”这个术语。这就是为什么现在我们有execsnoop(8)、opensnoop(8)、biosnoop(8)等。嗅探、事件转储和追踪通常指的是同一件事。这些工具将在后续章节中介绍。

除了工具名称,内核开发者尤其使用“追踪”一词来描述用于可观察性的BPF。

**采样工具**通过获取部分测量数据来描绘目标的粗略图像,这也称为创建概要或概要分析。BPF有一个名为profile(8)的工具,通过定时器对运行中的代码进行采样。例如,它可以每10毫秒进行一次采样,或者换句话说,每秒钟(在每个CPU上)进行100次采样。采样器的一个优点是其性能开销可能比追踪器低,因为它们只测量更大事件集合中的一部分。缺点是采样只能提供粗略的图像,可能会遗漏事件。

**可观察性**指通过观察来理解系统,并对实现此目的的工具进行分类。这些工具包括追踪工具、采样工具和基于固定计数器的工具。不包括基准测试工具,因为基准测试工具通过执行工作负载实验来改变系统状态。本书中的BPF工具是可观察性工具,它们使用BPF进行编程追踪。

1.3 What Are BCC, bpftrace, and IO Visor?

这样直接编写BPF指令非常繁琐,因此开发了前端工具,提供了更高级别的语言;追踪领域的主要工具有BCC和bpftrace。

BCC(BPF编译器集合)是为BPF开发的第一个高级追踪框架。它提供了一个C编程环境,用于编写内核BPF代码,以及用户级接口的其他语言:Python、Lua和C++。它还是libbcc和当前libbpf库的起源,这些库提供了使用BPF程序进行事件仪表化的功能。BCC仓库还包含超过70个用于性能分析和故障排除的BPF工具。您可以在系统上安装BCC,然后运行提供的工具,而无需自己编写任何BCC代码。本书将向您展示这些工具的使用。

bpftrace是一个较新的前端,提供了一个专门的高级语言,用于开发BPF工具。bpftrace代码非常简洁,通常在本书中包含工具源代码,以展示工具的仪表化和处理方式。bpftrace建立在libbcc和libbpf库之上。

BCC和bpftrace如图1-1所示。它们是互补的:bpftrace非常适合强大的单行命令和定制短脚本,而BCC则更适合复杂的脚本和守护进程,并且可以利用其他库。例如,许多Python BCC工具使用Python argparse库提供复杂和精细的工具命令行参数控制。

另一个BPF前端叫做ply,目前正在开发中。它设计为轻量级,并且需要最少的依赖项,非常适合嵌入式Linux环境。如果ply更适合您的环境,您仍然会发现本书的示例可以通过切换到ply的语法进行执行。(ply的未来版本可能会直接支持bpftrace的语法。)本书侧重于bpftrace,因为它经历了更多的开发,并且具备分析所有目标所需的所有功能。

BCC和bpftrace并不存储在内核代码库中,而是存储在GitHub上的Linux基金会项目IO Visor中。它们的仓库链接如下:

- https://github.com/iovisor/bcc

- https://github.com/iovisor/bpftrace

本书中使用术语BPF追踪来指代BCC和bpftrace工具。

1.4 A First Look at BCC: Quick Wins

让我们直接看一些工具输出,以获取一些快速成果。以下工具跟踪新进程,并在每个进程启动时打印一行摘要。这个特定的工具是来自BCC的execsnoop(8),它通过跟踪execve(2)系统调用来工作,这是exec(2)的一个变体(因此得名)。关于安装BCC工具的信息在第四章中介绍,后续章节将更详细地介绍这些工具。

输出显示了在跟踪过程中执行的进程:这些进程可能如此短暂,以至于其他工具无法捕捉到它们。输出有许多行,展示了标准的Unix实用程序:ps(1)、grep(1)、sed(1)、cut(1)等。仅从页面上查看输出,你看不到的是它打印的速度。可以使用execsnoop(8)的-t选项来打印时间戳列:

我已经截取了输出(如[…]所示),但时间戳列显示了一个新线索:

新进程之间的时间间隔每隔一秒钟就会跳跃一次,这种模式循环重复。通过浏览输出,我发现每秒钟会启动30个新进程,这些进程之间会有一个一秒钟的暂停,然后又是30个进程的一批。

这里展示的输出来自我使用execsnoop(8)调试的Netflix的真实问题。这个问题发生在用于微基准测试的服务器上,但基准测试结果显示了过大的方差,不足以信任。在系统应该空闲时,我运行了execsnoop(8),发现系统并没有空闲!每秒钟都会启动这些进程,它们干扰了我们的基准测试。原因是一个配置错误的服务,每秒尝试启动一次,失败后再次尝试。一旦停止了这个服务,这些进程就停止了(通过execsnoop(8)确认),然后基准测试结果变得一致了。

execsnoop(8)的输出有助于性能分析方法论,称为工作负载特征化,本书中许多其他BPF工具也支持这一方法论。这种方法论很简单:定义正在施加的工作负载。理解工作负载通常足以解决问题,避免需要深入挖掘延迟或进行详细分析。在这种情况下,问题是应用到系统上的进程工作负载。第三章介绍了这种方法和其他方法。

尝试在你的系统上运行execsnoop(8),让它运行一个小时。你会发现什么?

execsnoop(8)打印每个事件的数据,但其他工具使用BPF计算高效的摘要。另一个可以用于快速成功的工具是biolatency(8),它将块设备I/O(磁盘I/O)汇总为延迟直方图。

以下是在一个对高延迟敏感的生产数据库上运行biolatency(8)的输出,因为它有服务级别协议要求在一定毫秒数内交付请求。

在运行biolatency(8)工具时,会对块I/O事件进行仪表化,并利用BPF计算和汇总它们的延迟。当用户停止运行该工具(按下Ctrl-C时),会打印汇总结果。我在这里使用了-m选项,以毫秒为单位打印汇总信息。

在这些输出中有一些有趣的细节,显示出双峰分布以及延迟的异常值。最大的峰值(通过ASCII分布可视化)位于0到1毫秒范围内,跟踪过程中有16,355个I/O操作落在此范围内。这说明速度很快,很可能是由于磁盘缓存命中以及闪存设备的作用。第二个峰值延伸到32到63毫秒范围内,比这些存储设备预期的速度慢得多,这表明可能存在排队现象。可以使用更多的BPF工具深入分析以确认这一点。最后,512到1023毫秒范围内有11个I/O操作。这些极慢的I/O被称为延迟异常值。现在我们知道它们的存在,可以使用其他BPF工具对其进行更详细的检查。

对于数据库团队而言,这些是需要重点研究和解决的问题:如果数据库在这些I/O操作上被阻塞,数据库的延迟目标将会超出。

1.5 BPF Tracing Visibility

BPF跟踪为您提供了对整个软件堆栈的可见性,并允许根据需要创建新的工具和仪表化。您可以立即在生产环境中使用BPF跟踪,无需重新启动系统或以任何特殊模式重新启动应用程序。这种感觉就像拥有X光视觉:当您需要检查某个深层次的内核组件、设备或应用程序库时,您可以以前所未有的方式直接观察到它——实时且在生产环境中。

举例来说,图1-2展示了一个通用的系统软件堆栈,我在其中用基于BPF的性能工具进行了标注,用于观察不同的组件。这些工具来自于BCC、bpftrace以及本书的内容。后续章节将详细解释其中许多工具的使用方法。

考虑一下您会使用哪些不同的工具来检查诸如内核CPU调度器、虚拟内存、文件系统等组件。通过简单浏览这张图表,您可能会发现以前的盲点,现在可以通过BPF工具进行观察。

传统上用于检查这些组件的工具总结在表1-1中,同时标明了BPF跟踪是否可以观察这些组件。

传统工具可以为分析提供有用的起点,您可以使用BPF跟踪工具进行更深入的探索。第3章总结了使用系统工具进行基本性能分析的内容,这可以作为您的起点。

1.6 Dynamic Instrumentation: kprobes and uprobes

BPF 跟踪支持多种事件源,以提供对整个软件堆栈的可见性。其中值得特别提及的是动态检测(也称为动态跟踪)——即在生产环境中将检测点插入到正在运行的软件中的能力。当不使用时,动态检测不会带来任何开销,因为软件运行未被修改。BPF 工具通常使用它来检测内核和应用程序函数的开始和结束,这些函数在一个典型的软件堆栈中可能有成千上万个。这种深度和全面的可见性让人感觉像是一种超能力。

动态检测最早在1990年代创造 [Hollingsworth 94],基于调试器用于在任意指令地址插入断点的技术。通过动态检测,目标软件记录信息,然后自动继续执行,而不是将控制权交给交互式调试器。动态跟踪工具(例如 kerninst [Tamches 99])被开发出来,并包含跟踪语言,但这些工具仍然不为人所知且很少使用。部分原因是它们涉及相当大的风险:动态跟踪需要在地址空间中实时修改指令,任何错误都可能导致立即的损坏和进程或内核崩溃。

动态检测第一次在2000年由IBM团队开发为Linux的DProbes,但补丁集被拒绝了。5 动态检测内核函数(kprobes)最终在2004年加入Linux,起源于DProbes,尽管它仍然不为人所知且难以使用。

一切在2005年发生了变化,当时Sun Microsystems推出了其自身版本的动态跟踪DTrace,具有易于使用的D语言,并将其包含在Solaris 10操作系统中。Solaris以生产稳定性而闻名和信赖,将DTrace作为默认包安装帮助证明动态跟踪可以安全地用于生产环境。这是该技术的一个转折点。我发表了许多文章展示了DTrace的实际用例,并开发和发布了许多DTrace工具。Sun的市场营销和销售部门也推广了这项技术;它被认为是一个引人注目的竞争特性。Sun教育服务部门将DTrace纳入标准Solaris课程并教授专门的DTrace课程。这些努力使动态检测从一种不为人所知的技术变成了一项广为人知且需求量大的功能。

Linux 在2012年增加了针对用户级函数的动态检测,以 uprobes 的形式。BPF 跟踪工具使用 kprobes 和 uprobes 来实现整个软件堆栈的动态检测。

为了展示如何使用动态跟踪,表1-2提供了使用 kprobes 和 uprobes 的 bpftrace 探针说明符示例。(bpftrace 在第5章中介绍。)

1.7 Static Instrumentation: Tracepoints and USDT

动态插装存在一个缺点:它会插装那些在软件的不同版本中可能被重命名或移除的函数。这被称为接口稳定性问题。在升级内核或应用程序软件后,您可能突然发现您的BPF工具不能正常工作。可能会打印关于找不到要插装的函数的错误,或者根本不打印任何输出。另一个问题是,编译器可能会将函数内联作为编译优化,使它们无法通过kprobes或uprobes进行插装。

解决稳定性和内联问题的一个方法是切换到静态插装,其中稳定的事件名称被编码到软件中,并由开发人员维护。BPF跟踪支持内核静态插装的跟踪点(tracepoints),以及用户级静态定义跟踪(USDT)用于用户级静态插装。静态插装的缺点在于,这些插装点对开发人员来说可能是维护负担,因此如果存在,通常数量有限。

这些细节只在您打算开发自己的BPF工具时才重要。如果是这样,建议的策略是首先尝试使用静态跟踪(使用tracepoints和USDT),然后在静态跟踪不可用时切换到动态跟踪(使用kprobes和uprobes)。

表1-3提供了使用tracepoints和USDT进行静态插装的bpftrace探针说明符示例。本表中提到的open(2) tracepoint 在第1.8节中有使用。

1.8 A First Look at bpftrace: Tracing open()

让我们从使用bpftrace跟踪open(2)系统调用开始。对于这个系统调用,有一个跟踪点(syscalls:sys_enter_open8),我将在命令行中编写一个简短的bpftrace程序,只有一行。

你暂时不需要理解下面这个一行程序中的代码;bpftrace语言和安装说明在第5章中有详细介绍。但你可能能够猜到这个程序的功能,即使不懂这种语言,因为它相当直观(一种直观的语言是设计良好的标志)。现在,只需关注工具的输出即可。

输出显示了进程名称和传递给open(2)系统调用的文件名:bpftrace正在进行系统范围的跟踪,因此任何使用open(2)的应用程序都会被观察到。每行输出总结了一个系统调用,这是一个产生每个事件输出的工具示例。BPF跟踪不仅可以用于生产服务器分析。例如,我在写这本书的同时在我的笔记本电脑上运行它,它展示了Slack聊天应用正在打开的文件。

BPF程序是在单引号中定义的,并且当我按下Enter键运行bpftrace命令时,它被编译并运行。bpftrace还激活了open(2)的跟踪点。当我按下Ctrl-C停止命令时,open(2)的跟踪点被停用,并且我的小型BPF程序被移除。这就是BPF跟踪工具按需仪器化的工作原理:它们只在命令的生命周期内激活和运行,这可能只有几秒钟。

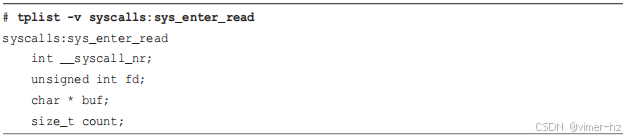

生成的输出比我预期的要慢:我觉得我错过了一些open(2)系统调用事件。内核支持几种open的变体,而我只追踪了其中一种。我可以使用bpftrace通过使用-l和通配符列出所有的open跟踪点:

啊,我觉得现在openat(2)变种更常用。我会用另一个bpftrace的一行命令来确认一下:

再次强调,这个一行命令的代码将在第五章进行解释。目前,重要的是理解输出内容。现在显示的是这些跟踪点的计数,而不是每个事件一行显示。这证实了在跟踪过程中openat(2)系统调用更频繁——在跟踪期间调用了308次,而open(2)系统调用只被调用了五次。这个总结是由BPF程序在内核中高效计算的。

我可以在我的一行命令中添加第二个跟踪点,同时跟踪open(2)和openat(2)。然而,一行命令会开始变得有点长并且在命令行上不太方便操作,这时最好将其保存为一个脚本(一个可执行文件),这样可以更容易地在文本编辑器中进行编辑。这已经为您做好了:bpftrace附带了opensnoop.bt,它跟踪每个系统调用的开始和结束,并将输出打印为列。

这些列包括进程ID(PID)、进程命令名称(COMM)、文件描述符(FD)、错误代码(ERR)以及系统调用尝试打开的文件路径(PATH)。opensnoop.bt工具可用于排除失败的软件问题,例如尝试从错误路径打开文件,也可根据访问情况确定配置文件和日志文件的存储位置。它还可以识别一些性能问题,如文件打开过快或频繁检查错误的位置。它是一个具有多种用途的工具。

bpftrace附带超过20个此类现成可运行工具,而BCC则提供超过70个。除了直接帮助解决问题外,这些工具还提供源代码,展示如何跟踪各种目标。有时可能会遇到一些陷阱,正如我们在跟踪open(2)系统调用时看到的那样,它们的源代码可能展示了解决这些问题的方法。

1.9 Back to BCC: Tracing open()

现在让我们来看看BCC版本的opensnoop(8):

这里的输出看起来与之前的单行命令输出非常相似,至少具有相同的列。但是这个opensnoop(8)输出有一个bpftrace版本没有的东西:它可以使用不同的命令行选项调用:

虽然bpftrace工具通常简单且只做一件事,但BCC工具通常复杂且支持多种操作模式。虽然你可以修改bpftrace工具来仅显示失败的打开操作,但BCC版本已经支持这样的选项(-x):

这些输出显示了重复的失败。这样的模式可能指向效率低下或配置错误,可以进行修复。

BCC工具通常具有多个类似的选项,可以改变它们的行为,使它们比bpftrace工具更加灵活。这使它们成为一个很好的起点:希望它们可以满足你的需求,而无需编写任何BPF代码。然而,如果它们缺少你需要的可见性,你可以切换到bpftrace并创建自定义工具,因为这是一种更容易开发的语言。

后续可以将bpftrace工具转换为更复杂的BCC工具,支持各种选项,如之前展示的opensnoop(8)。BCC工具还可以支持使用不同的事件:在可用时使用tracepoints,不可用时切换到kprobes。但请注意,BCC编程要复杂得多,超出了本书的范围,本书专注于bpftrace编程。附录C提供了BCC工具开发的速成课程。

1.10 Summary

BPF跟踪工具可用于性能分析和故障排除,主要有两个项目提供支持:BCC和bpftrace。本章介绍了扩展BPF、BCC、bpftrace以及它们使用的动态和静态仪器技术。

下一章将更详细地探讨这些技术。如果你急于解决问题,可以暂时跳过第二章,直接阅读第三章或后续章节,这些章节涵盖了你感兴趣的主题。这些后续章节大量使用了术语,其中许多在第二章有解释,同时也在术语表中有总结。

2 Technology Background

第1章介绍了BPF性能工具使用的各种技术。本章将更详细地解释这些技术:它们的历史、接口、内部结构以及与BPF的使用。

本章是本书技术深度最大的章节,为了简洁起见,假设读者具有一定的内核内部和指令级编程知识。

学习目标不是记住本章的每一页内容,而是让你能够:

- 熟悉BPF的起源及扩展BPF在当今的角色

- 理解帧指针堆栈遍历和其他技术

- 掌握如何阅读火焰图

- 理解kprobes和uprobes的使用,并熟悉它们的稳定性注意事项

- 理解tracepoints、USDT探针和动态USDT的作用

- 了解性能计数器(PMC)及其与BPF跟踪工具的使用

- 关注未来的发展:BTF、其他BPF堆栈遍历器

理解本章将提高你对本书后续内容的理解,但你可能选择现在快速浏览本章,并根据需要随时返回以获取更多详细信息。第3章将帮助你开始使用BPF工具来提升性能。

2.1 BPF Illustrated

图2-1展示了本章介绍的许多技术及它们之间的关系。

2.2 BPF

BPF最初是为BSD操作系统开发的,其描述可见于1992年的论文《The BSD Packet Filter: A New Architecture for User-level Packet Capture》[McCanne 92]。这篇论文是在1993年USENIX冬季会议上在圣迭戈发表的,与《Measurement, Analysis, and Improvement of UDP/IP Throughput for the DECstation 5000》[7]一同展示。尽管DECstation已经退出市场,但BPF作为行业标准的数据包过滤解决方案仍然存在。

BPF的工作方式非常有趣:用户通过一个BPF虚拟机的指令集(有时称为BPF字节码)定义过滤表达式,然后将其传递给内核以由解释器执行。这使得过滤可以在内核级别完成,避免了每个数据包都要昂贵地复制到用户级进程的情况,从而提高了数据包过滤的性能,例如在tcpdump(8)中使用。它还提供了安全性,因为可以在执行之前验证来自用户空间的过滤器是否安全。由于早期的数据包过滤必须在内核空间进行,安全性是一个硬性需求。图2-2展示了这一工作原理。

你可以使用tcpdump(8)的-d选项来打印出它用于过滤表达式的BPF指令。例如:

最初的BPF,现在称为“经典BPF”,是一种有限的虚拟机。它包括两个寄存器、一个由16个内存槽组成的临时存储器,以及一个程序计数器。所有这些都是使用32位寄存器大小运行的。经典BPF首次出现在Linux内核中是在1997年,对应2.1.75内核版本 [8]。

自BPF添加到Linux内核以来,已经有一些重要的改进。Eric Dumazet在2011年7月发布的Linux 3.0版本中添加了BPF即时编译器(JIT),提升了性能以取代解释器 [9]。2012年,Will Drewry为seccomp(安全计算)系统调用策略添加了BPF过滤器 [10];这是BPF在网络之外的首次应用,展示了BPF作为通用执行引擎的潜力。

2.3 Extended BPF (eBPF)

Extended BPF由Alexei Starovoitov在其在PLUMgrid工作期间创建,当时该公司正在研究创建软件定义网络解决方案的新方法。这是BPF在20年间的首次重大更新,使BPF扩展为通用虚拟机 [3]。在该提议阶段,来自Red Hat的内核工程师Daniel Borkmann帮助重新设计,以便将其纳入内核并替代现有的BPF [4]。扩展BPF成功地被纳入,并自此以来得到许多其他开发者的贡献(详见致谢部分)。

扩展BPF增加了更多的寄存器,从32位切换到64位字,创建了灵活的BPF“映射”存储,并允许调用一些受限制的内核函数 [5]。它还被设计为通过一对一的映射到本机指令和寄存器进行即时编译,从而使先前的本机指令优化技术能够重新用于BPF。BPF验证器也进行了更新,以处理这些扩展并拒绝任何不安全的代码。

表2-1显示了经典BPF与扩展BPF之间的区别。

Alexei最初的提议是2013年9月的一个名为“扩展BPF”的补丁集 [2]。到了2013年12月,Alexei已经开始提议将其用于跟踪过滤器 [11]。经过与Daniel的讨论和开发,这些补丁从2014年3月开始逐步合并到Linux内核中 [3][12]。JIT组件在2014年6月的Linux 3.15版本中合并,用于控制BPF的bpf(2)系统调用在2014年12月的Linux 3.18版本中合并 [13]。Linux 4.x系列的后续增加则为kprobes、uprobes、tracepoints和perf_events增加了BPF支持。

在最早的补丁集中,这项技术被缩写为eBPF,但后来Alexei改为简称为BPF [7]。所有关于BPF的开发现在都在net-dev邮件列表上进行,统一称为BPF。

Linux BPF运行时的架构如图2-3所示,展示了BPF指令如何通过BPF验证器并由BPF虚拟机执行。BPF虚拟机的实现包括解释器和JIT编译器:JIT编译器生成本机指令进行直接执行。验证器拒绝不安全的操作,包括无界循环:BPF程序必须在有限时间内完成。

BPF可以利用帮助程序来获取内核状态,并使用BPF映射进行存储。BPF程序在事件发生时执行,这些事件包括kprobes、uprobes和tracepoints。

接下来的章节讨论为什么性能工具需要BPF、扩展BPF编程、查看BPF指令、BPF API、BPF的限制以及BTF。这些章节为理解在使用bpftrace和BCC时BPF的工作原理提供了基础。此外,附录D直接讲述了使用C进行BPF编程,附录E介绍了BPF指令。

2.3.1 Why Performance Tools Need BPF

性能工具部分使用扩展BPF是因为它的可编程性。BPF程序可以执行自定义的延迟计算和统计摘要。单凭这些特性就足以构建一个有趣的工具,而且许多其他跟踪工具也具备这些功能。BPF之所以与众不同,是因为它不仅高效且安全,而且已经集成在Linux内核中。有了BPF,你可以在生产环境中运行这些工具,而无需添加任何新的内核组件。

让我们看一些输出和图表,了解性能工具如何使用BPF。这个例子来自我早期发布的一个名为bitehist的BPF工具,它展示了磁盘I/O的直方图 [15]:

关键变化在于直方图可以在内核上下文中生成,这极大地减少了复制到用户空间的数据量。这种效率提升非常显著,使得原本成本过高的工具可以在生产环境中运行。具体来说:

在使用BPF之前,生成这种直方图摘要的完整步骤如下:

1. 在内核中:启用磁盘I/O事件的仪表化。

2. 在内核中,对于每个事件:将记录写入性能缓冲区。如果使用追踪点(推荐),记录包含有关磁盘I/O的多个元数据字段。

3. 在用户空间:定期将所有事件的缓冲区复制到用户空间。

4. 在用户空间:遍历每个事件,解析事件的元数据以获取字节字段。其他字段被忽略。

5. 在用户空间:生成字节字段的直方图摘要。

步骤2到4对于高I/O系统有很高的性能开销。想象一下,每秒传输10,000个磁盘I/O跟踪记录到一个用户空间程序中进行解析和汇总。

使用BPF后,bitesize程序的步骤如下:

1. 在内核中:启用磁盘I/O事件的仪表化,并附加一个由bitesize定义的自定义BPF程序。

2. 在内核中,对于每个事件:运行BPF程序。它仅获取字节字段并将其保存到自定义的BPF映射直方图中。

3. 在用户空间:读取一次BPF映射直方图并将其打印出来。

这种方法避免了将事件复制到用户空间和重新处理的成本。它还避免了复制未使用的元数据字段。唯一复制到用户空间的数据如前面的输出所示:即“count”列,这是一个数字数组。

2.3.2 BPF Versus Kernel Modules

理解BPF在可观测性方面的好处的另一种方法是将其与内核模块进行比较。kprobes和tracepoints已经存在多年,并且可以直接从可加载的内核模块中使用。使用BPF相比内核模块进行跟踪的好处包括:

- BPF程序通过验证器进行检查;而内核模块可能引入错误(如内核崩溃)或安全漏洞。

- BPF通过映射提供丰富的数据结构。

- BPF程序可以编译一次,随后在任何地方运行,因为BPF指令集、映射、辅助函数和基础设施构成了稳定的ABI。但是,某些BPF跟踪程序可能引入不稳定组件,如在内核结构中进行仪表化的kprobes,因此不能完全做到这一点(请参见第2.3.10节,关于解决方案的工作)。

- BPF程序不需要编译内核构建产物。

- 学习BPF编程比开发内核模块所需的内核工程更容易,使更多人能够使用它。

需要注意的是,当BPF用于网络时,还有其他好处,包括能够原子性地替换BPF程序。而内核模块需要先完全卸载出内核,然后再加载新版本到内核中,可能会导致服务中断。

内核模块的好处在于可以使用其他内核功能和设施,而不仅限于BPF辅助函数调用。然而,这也带来了风险,如果滥用任意内核功能,则可能引入错误。

2.3.3 Writing BPF Programs

BPF可以通过现有的多个前端进行编程。用于跟踪的主要前端,按照语言层级从低到高排列如下:

- LLVM

- BCC

- bpftrace

LLVM编译器支持BPF作为编译目标。可以使用LLVM支持的更高级语言编写BPF程序,例如通过Clang的C语言或LLVM中间表示(IR),然后将其编译成BPF。LLVM包括优化器,可提高生成的BPF指令的效率和大小。

在LLVM IR中开发BPF是一种改进,但切换到BCC或bpftrace更为便捷。BCC允许用C语言编写BPF程序,而bpftrace提供其自己的高级语言。它们内部都使用LLVM IR和LLVM库来编译成BPF。

本书中的性能工具是使用BCC和bpftrace编程的。直接使用BPF指令或LLVM IR编程属于BCC和bpftrace内部开发人员的领域,超出了本书的范围。对于我们使用和开发BPF性能工具的人来说并不必要。如果您希望成为BPF指令开发人员或感兴趣,以下是一些额外阅读资源:

- 附录E提供了BPF指令和宏的简要概述。

- BPF指令在Linux源树的文档中有记录,位于Documentation/networking/filter.txt [17]。

- LLVM IR在在线LLVM参考文档中有记录;可以从llvm::IRBuilderBase类的参考开始 [18]。

- 参阅Cilium BPF和XDP参考指南 [19]。

大多数人永远不会直接编写BPF指令,但有时会查看它们,例如在工具遇到问题时。接下来的两个部分将使用bpftool(8)和bpftrace展示示例。

2.3.4 Viewing BPF Instructions: bpftool

bpftool(8)是在Linux 4.15中添加的,用于查看和操作BPF对象,包括程序和映射。它位于Linux源代码中的tools/bpf/bpftool目录下。本节总结了如何使用bpftool(8)查找加载的BPF程序并打印它们的指令。

bpftool

从Linux 5.2版本开始,默认输出的bpftool(8)显示其操作对象的对象类型。

perf和prog子命令可用于查找和打印跟踪程序。这里未涵盖的bpftool(8)功能包括附加程序、读写映射、操作cgroups以及列出BPF功能。

bpftool perf

perf子命令显示通过perf_event_open()附加的BPF程序,这在Linux 4.17及更高版本上是BCC和bpftrace程序的标准操作方式。例如:

这些输出显示了三个不同的PID,每个PID都有不同的BPF程序:

- PID 1765 是用于实例分析的Vector BPF PMDA代理。 (详见第17章了解更多详情。)

- PID 21993 是 biolatency(8) 的bpftrace版本。它展示了两个uprobes,分别是来自bpftrace程序的BEGIN和END探针,以及两个kprobes,用于检测块I/O的开始和结束。(源代码可参见第9章。)

- PID 25440 是 biolatency(8) 的BCC版本,目前用于对块I/O的不同开始函数进行检测。

偏移字段显示了从被检测对象进行检测的偏移量。对于bpftrace,偏移量1781920匹配了bpftrace二进制文件中的BEGIN_trigger函数,偏移量1781927匹配了END_trigger函数(可以使用readelf -s bpftrace进行验证)。

prog_id 是BPF程序的ID,可以通过以下子命令打印出来。

bpftool prog show

prog show子命令列出所有程序(不仅限于基于perf_event_open()的程序):

这个输出显示了bpftrace程序的程序ID(从232到235)和BCC程序的程序ID(262和263),以及其他已加载的BPF程序。请注意,BCC kprobe程序具有BPF类型格式(BTF)信息,这在输出中通过btf_id的存在显示出来。关于BTF的详细信息可以参考第2.3.9节。暂时理解BTF是BPF版本的调试信息即可。

bpftool prog dump xlated

可以通过其ID打印(“dump”)每个BPF程序。xlated模式将BPF指令翻译成汇编语言。以下是程序234,即bpftrace块I/O完成程序的示例:

输出显示了BPF可以使用的受限内核辅助函数之一:bpf_probe_read()。(更多的辅助函数列在表2-2中。)

现在将前面的输出与已使用BTF编译的BCC块I/O完成程序的输出进行比较,其ID为263:

这个输出现在包含了来自BTF的源代码信息(用粗体突出显示)。请注意,这是一个不同的程序(具有不同的指令和调用)。

如果可用,linum修饰符还包括来自BTF的源文件和行号信息(用粗体突出显示)。

在这种情况下,行号信息指的是运行程序时BCC创建的虚拟文件。

opcodes修饰符包括BPF指令的操作码(用粗体突出显示):

BPF指令的操作码在附录E中有详细说明。

还有一个visual修饰符,以DOT格式输出控制流图信息,可以供外部软件进行可视化。例如,可以使用GraphViz及其dot(1)有向图工具 [20]:

然后可以查看生成的PNG文件,以查看指令流。GraphViz提供了不同的布局工具:我通常使用dot(1),neato(1),fdp(1)和sfdp(1)来绘制DOT数据图。这些工具允许进行各种自定义(例如边长:-Elen)。图2-5展示了使用GraphViz中的osage(1)来可视化这个BPF程序的结果。

这是一个复杂的程序!其他GraphViz工具会将代码块展开,以避免箭头的混乱,但会生成更大的文件。如果你需要阅读像这样的BPF指令,你应该尝试不同的工具,找到最适合你的那一个。

bpftool prog dump jited

prog dump jited子命令显示正在执行的处理器的机器码。本节显示了x86_64;然而,BPF支持Linux内核支持的所有主要架构的JIT。对于完成的BCC块I/O程序:

如前所示,此程序的BTF存在使得bpftool(8)能够包含源代码行;否则,这些行将不会存在。

bpftool btf

bpftool(8)还可以转储BTF ID。例如,BTF ID 5 是用于完成的BCC块I/O程序:

2.3.5 Viewing BPF Instructions: bpftrace

tcpdump(8)可以使用-d选项输出BPF指令,而bpftrace可以使用-v12选项进行相同的操作:

如果出现bpftrace内部错误,这些输出也会被打印出来。如果你在开发bpftrace内部功能时,可能会不小心违反BPF验证器的规则,导致程序被内核拒绝。此时,这些指令将被打印出来,你需要研究它们以确定问题的原因并开发修复方案。

大多数人永远不会遇到bpftrace或BCC的内部错误,也不会看到BPF指令。如果你确实遇到了这样的问题,请向bpftrace或BCC项目提交一个问题报告,或考虑自己贡献修复方案。

2.3.6 BPF API

为了更好地理解BPF的能力,以下部分总结了Linux 4.20版本中包含的扩展BPF API 的选定部分,来自include/uapi/linux/bpf.h。

BPF助手函数

BPF程序无法调用任意的内核函数。为了在这种限制下完成特定任务,提供了BPF可以调用的“助手”函数。选定的函数列在表2-2中。

一些这些助手函数在先前的bpftool(8)的xlated输出和bpftrace的-v输出中已经展示过了。

这些描述中的术语“current”指的是当前正在运行的线程——即当前在CPU上运行的线程。

请注意,include/uapi/linux/bpf.h 文件通常为这些助手函数提供了详细的文档。以下是从bpf_get_stackid()的摘录:

这些文件可以在任何托管Linux源代码的网站上在线浏览,例如:https://github.com/torvalds/linux/blob/master/include/uapi/linux/bpf.h。

还有许多其他的助手函数可用,主要用于软件定义网络。当前版本的Linux(5.2)有98个助手函数。

bpf_probe_read()

bpf_probe_read() 是一个特别重要的助手函数。在BPF中,内存访问受限于BPF寄存器和栈(以及通过助手的BPF映射)。对于任意内核内存(如BPF之外的其他内核内存),必须通过bpf_probe_read()来读取,它执行安全检查并禁用页面故障,以确保从探针上下文中的读取不会导致故障(这可能会引起内核问题)。

除了读取内核内存,这个助手函数还用于将用户空间内存读取到内核空间。这种操作的实现方式取决于架构:在x86_64架构上,用户和内核地址范围不重叠,因此可以通过地址确定模式。但在其他架构(如SPARC [21])中,情况并非如此,因此BPF要支持这些其他架构,可能需要额外的助手函数,比如bpf_probe_read_kernel()和bpf_probe_read_user()。

BPF系统调用命令

表2-3展示了用户空间可以调用的选定BPF操作。

这些操作作为bpf(2)系统调用的第一个参数传递。您可以使用strace(1)来查看它们的执行过程。例如,可以检查运行BCC execsnoop(8)工具时发出的bpf(2)系统调用:

**这些操作在输出中用粗体显示**。请注意,我通常避免使用strace(1),因为它当前的ptrace()实现可能会显著减慢目标进程的速度——减慢超过100倍 [22]。我在这里使用它是因为它已经为bpf(2)系统调用提供了翻译映射,将数字转换为可读字符串(例如,“BPF_PROG_LOAD”)。

BPF程序类型

不同的BPF程序类型指定了BPF程序附加到的事件类型和事件的参数。用于BPF跟踪程序的主要程序类型如表2-4所示。

之前的strace(1)输出包括两个类型为BPF_PROG_TYPE_KPROBE的BPF_PROG_LOAD调用,因为那个版本的execsnoop(8)使用了kprobe和kretprobe来检测execve()的开始和结束。

在bpf.h中还有更多用于网络和其他用途的程序类型,包括表2-5中显示的那些。

BPF Map Types

BPF映射类型,其中一些列在表2-6中,定义了不同类型的映射。

之前的strace(1)输出包括一个类型为BPF_MAP_TYPE_PERF_EVENT_ARRAY的BPF_MAP_CREATE调用,该调用由execsnoop(8)使用,用于将事件传递给用户空间以供打印。

在bpf.h中还有许多用于特殊目的的映射类型。

2.3.7 BPF Concurrency Controls

直到Linux 5.1版本之前,BPF缺乏并发控制,直到添加了自旋锁辅助函数。(然而,它们目前还不能在跟踪程序中使用。)在跟踪过程中,多个并行线程可以并行查找和更新BPF映射字段,导致其中一个线程覆盖另一个线程的更新,从而造成数据损坏。这也被称为“丢失更新”问题,即并发读写重叠,导致更新丢失。跟踪前端工具BCC和bpftrace尽可能使用每CPU哈希和数组映射类型来避免这种损坏。它们为每个逻辑CPU创建实例以供使用,防止并行线程更新共享位置。例如,用于计算事件数量的映射可以作为每CPU映射进行更新,然后在需要时将每CPU的值合并为总计数。

比较计数结果显示,普通哈希映射事件数量低估了0.01%。

除了每CPU映射外,还有其他用于并发控制的机制,包括独占的加法指令(BPF_XADD)、可以原子地更新整个映射的映射内映射,以及BPF自旋锁。通过bpf_map_update_elem()进行的常规哈希和LRU映射更新也是原子的,并且由于并发写入而没有数据竞争。自Linux 5.1版本中添加的自旋锁由bpf_spin_lock()和bpf_spin_unlock()辅助函数控制 [23]。

2.3.8 BPF sysfs Interface

在Linux 4.4中,BPF引入了通过虚拟文件系统暴露BPF程序和映射的命令,通常挂载在/sys/fs/bpf目录下。这种能力被称为“pinning”,具有多种用途。它允许创建持久的BPF程序(类似守护进程),即使加载它们的进程退出后仍然继续运行。它还提供了另一种用户级程序与运行中的BPF程序交互的方式:它们可以读取和写入BPF映射。

在这本书中,BPF可观测性工具并未使用pinning,这些工具模仿了标准的Unix实用程序,可以启动和停止。然而,如果需要,这些工具中的任何一个都可以转换为使用pinning的形式。这种技术更常用于网络程序(例如,Cilium软件 [24])。

作为pinning的一个示例,Android操作系统利用pinning自动加载和固定存放在/system/etc/bpf目录下的BPF程序 [25]。Android提供了库函数与这些固定的程序进行交互。

2.3.9 BPF Type Format (BTF)

本书中反复描述的一个问题是缺乏关于被插装代码的信息,这使得编写BPF工具变得困难。正如将在多个场合提到的那样,解决这些问题的理想方案是在此引入的BTF(BPF Type Format)。

BTF(BPF类型格式)是一种元数据格式,用于编码调试信息,用于描述BPF程序、BPF映射等等。BTF这个名称最初是用于描述数据类型,但后来扩展到包括定义子例程的函数信息、源代码/行信息的行信息,以及全局变量信息。

BTF调试信息可以嵌入到vmlinux二进制文件中,或者与BPF程序一起通过本地Clang编译或LLVM JIT生成,以便可以更轻松地使用加载器(例如libbpf)和工具(例如bpftool(8))检查BPF程序。检查和跟踪工具,包括bpftool(8)和perf(1),可以检索此类信息,以提供带有源代码注释的BPF程序,或者根据它们的C结构漂亮打印映射键/值,而不是原始的十六进制转储。先前的bpftool(8)示例演示了对LLVM-9编译的BCC程序进行转储。

除了描述BPF程序外,BTF正成为描述所有内核数据结构的通用格式。在某些方面,它正在成为BPF使用的内核调试信息的轻量级替代品,以及内核头文件的更完整和可靠的替代品。

BPF跟踪工具通常需要安装内核头文件(通常通过linux-headers软件包),以便可以导航到各种C结构。这些头文件不包含内核中所有结构的定义,这使得开发某些BPF可观察性工具变得困难:缺失的结构需要作为一种解决方法在BPF工具源代码中定义。还存在处理复杂头文件时出现问题的情况;在这些情况下,bpftrace可能会转向中止,而不是继续进行可能不正确的结构偏移量。BTF可以通过提供所有结构的可靠定义来解决此问题。(一个早期的bpftool btf输出展示了如何包含task_struct。)在未来,包含BTF的Linux内核vmlinux二进制文件将具备自我描述能力。

在编写本书时,BTF仍在开发中。为了支持一次编译,随处运行的倡议,将会为BTF添加更多信息。有关BTF的最新信息,请参阅内核源码中的Documentation/bpf/btf.rst [26]。

2.3.10 BPF CO-RE

BPF编译一次,随处运行(CO-RE)项目旨在允许将BPF程序编译为BPF字节码后,保存并分发到其他系统上执行。这将避免在每个系统上都安装BPF编译器(如LLVM和Clang),尤其对于空间受限的嵌入式Linux而言,这是一项挑战。此外,它还将避免在执行BPF可观察性工具时运行编译器所带来的运行时CPU和内存成本。

CO-RE项目的开发人员安德里·纳克里科(Andrii Nakryiko)正在解决诸如不同系统上的内核结构偏移处理等挑战,这需要根据需要重写BPF字节码中的字段偏移。另一个挑战是缺失的结构成员,这要求根据内核版本、内核配置和/或用户提供的运行时标志,条件性地访问字段。CO-RE项目将利用BTF信息,并在撰写本书时仍在开发中。

2.3.11 BPF Limitations

BPF程序不能调用任意内核函数;它们仅限于API中列出的BPF辅助函数。随着需求的增加,未来的内核版本可能会添加更多辅助函数。BPF程序还对循环施加限制:允许BPF程序在任意kprobes上插入无限循环是不安全的,因为这些线程可能持有关键锁,阻塞系统的其余部分。解决方法包括展开循环,并为需要循环的常见用途添加辅助函数。Linux 5.3增加了对BPF有界循环的支持,这些循环具有可验证的上限运行时间。

BPF堆栈大小限制为MAX_BPF_STACK,设置为512。在编写BPF可观测性工具时,特别是在堆栈上存储多个字符串缓冲区时,有时会遇到此限制:单个char[256]缓冲区消耗了堆栈的一半。目前没有增加此限制的计划。解决方案是改用BPF映射存储,它在效果上是无限的。已经开始将bpftrace字符串切换到映射存储,而不是堆栈存储。

BPF程序中指令的数量最初限制为4096条。长的BPF程序有时会遇到此限制(如果没有LLVM编译器优化,它们将更快地遇到此限制)。Linux 5.2显著增加了此限制,因此不应再成为问题。BPF验证器的目标是接受任何安全的程序,这些限制不应成为障碍。

2.3.12 BPF Additional Reading

更多了解扩展BPF的信息来源包括:

- 内核源码中的Documentation/networking/filter.txt [17]

- 内核源码中的Documentation/bpf/bpf_design_QA.txt [29]

- bpf(2) 手册页 [30]

- bpf-helpers(7) 手册页 [31]

- Jonathan Corbet 的文章 "BPF: the universal in-kernel virtual machine" [32]

- Suchakra Sharma 的文章 "BPF Internals—II" [33]

- Cilium 的 "BPF and XDP Reference Guide" [19]

在第4章和附录C、D和E中还提供了BPF程序的额外示例。

2.4 Stack Trace Walking

堆栈跟踪是理解导致事件发生的代码路径以及对内核和用户代码进行性能分析的无价工具。BPF提供了专门的映射类型来记录堆栈跟踪,并可以使用基于帧指针或ORC(ORC unwinder)的堆栈遍历来获取它们。未来,BPF可能会支持其他的堆栈遍历技术。

2.4.1 Frame Pointer–Based Stacks

帧指针技术遵循一种约定,即在寄存器中始终可以找到一个链表的堆栈帧头部(在x86_64架构上是RBP),并且返回地址存储在存储的RBP的已知偏移量(+8)处[Huibicka 13]。这意味着任何中断程序的调试器或跟踪器可以读取RBP,然后通过遍历RBP链表并获取已知偏移处的地址轻松获取堆栈跟踪信息。这在图2-6中有展示。

AMD64 ABI指出,将RBP用作帧指针寄存器是一种传统做法,但可以避免使用它以节省函数前奏和后奏指令,并将RBP作为通用寄存器可用。

目前,gcc编译器默认省略帧指针并将RBP用作通用寄存器,这导致基于帧指针的堆栈遍历出现问题。可以通过使用 `-fno-omit-frame-pointer` 选项来恢复默认设置。关于引入省略帧指针作为默认的补丁有三个细节解释为何这样做 [34]:

- 该补丁最初是为i386引入的,该架构有四个通用寄存器。释放RBP将可用寄存器数从四个增加到五个,从而显著提高性能。但是对于x86_64而言,已经有16个可用寄存器,因此这种改变带来的收益要少得多 [35]。

- 假设堆栈遍历问题已经解决,这是因为gdb(1)支持其他技术。然而,这并未考虑到在中断禁用的有限上下文中运行的跟踪器堆栈遍历。

- 需要在基准测试中与Intel的icc编译器竞争。

如今,在x86_64上,大多数软件都使用gcc的默认设置,导致帧指针堆栈跟踪出现问题。我上次在生产环境中研究帧指针省略带来的性能增益时,通常不到百分之一,并且经常接近零,难以测量。Netflix的许多微服务都已经重新启用了帧指针,因为通过CPU分析获得的性能优势超过了微小的性能损失。

使用帧指针并非遍历堆栈的唯一方法;其他方法包括debuginfo、LBR和ORC。

2.4.2 debuginfo

附加调试信息通常以调试信息包的形式提供给软件,这些包包含以DWARF格式的ELF调试信息文件。这些文件包括.gdb(1)等调试器可以用来遍历堆栈的部分,即使没有使用帧指针寄存器。ELF文件的关键部分是.eh_frame和.debug_frame。

调试信息文件还包括包含源代码和行号信息的部分,使得调试的文件比原始的二进制文件要大得多。第12章中的一个例子展示了libjvm.so的大小为17兆字节,而其调试信息文件则达到了222兆字节。在某些环境中,由于其巨大的大小,调试信息文件未被安装。

BPF当前不支持使用这种堆栈遍历技术:这是处理器密集型的操作,需要读取可能未被置换的ELF部分。这使得在受限的禁止中断的BPF环境中实现此技术变得具有挑战性。

请注意,BPF前端工具BCC和bpftrace确实支持调试信息文件以进行符号解析。

2.4.3 Last Branch Record (LBR)

最后分支记录是Intel处理器的一种功能,用于在硬件缓冲区中记录分支,包括函数调用分支。这种技术没有额外开销,可以用来重构堆栈跟踪。然而,它的深度受处理器的限制,可能仅支持记录4到32个分支。生产软件,特别是Java,的堆栈跟踪可能超过32个帧。

目前,BPF不支持最后分支记录,但将来可能会支持。有限的堆栈跟踪总比没有堆栈跟踪要好!

2.4.4 ORC

一个新的调试信息格式被设计用于堆栈跟踪,称为Oops Rewind Capability(ORC),其处理器负荷比DWARF低 [36]。ORC使用. orc_unwind 和 .orc_unwind_ip ELF节,目前已在Linux内核中实现。在寄存器有限的架构上,可能希望在编译内核时不使用帧指针,而是使用ORC进行堆栈跟踪。

ORC堆栈展开通过perf_callchain_kernel()函数在内核中实现,BPF可以调用该函数。这意味着BPF也支持ORC堆栈跟踪。目前尚未为用户空间开发ORC堆栈。

2.4.5 Symbols

目前,堆栈跟踪在内核中被记录为一组地址,稍后由用户级程序转换为符号(例如函数名)。在采集和转换之间可能出现符号映射已更改的情况,导致转换无效或缺失。这在第12章第3.4节中有详细讨论。未来可能的工作包括在内核中添加符号转换的支持,以便内核可以立即收集和转换堆栈跟踪信息。

2.4.6 More Reading

堆栈跟踪和帧指针在第12章进一步讨论了C语言和Java,第18章则提供了总结概述。

2.5 Flame Graphs

火焰图经常在本书的后续章节中使用,因此本节总结了如何使用和阅读它们。

火焰图是堆栈跟踪的可视化形式,我在解决MySQL性能问题和比较两个数千页文本的CPU配置文件时发明了它们[Gregg 16]。除了CPU配置文件外,它们还可以用于可视化来自任何分析器或跟踪器记录的堆栈跟踪。本书后续部分将展示它们如何应用于BPF跟踪的CPU空闲事件、页面错误等。本节解释了这种可视化方法。

2.5.1 Stack Trace

堆栈跟踪,也称为堆栈回溯或调用链,是一系列函数的列表,显示代码的执行流程。例如,如果 func_a() 调用了 func_b(),而 func_b() 又调用了 func_c(),那么在这一点上的堆栈跟踪可能会写成:

func_c

func_b

func_a

堆栈的底部(func_a)是起始点,而它上面的行显示了代码的执行路径。换句话说,堆栈的顶部(func_c)是当前函数,向下移动显示其层级关系:父函数、祖父函数,依此类推。

2.5.2 Profiling Stack Traces

定时抽样堆栈跟踪可以收集成千上万个堆栈,每个堆栈可能有几十甚至几百行长。为了更方便地研究这么大量的数据,Linux 的 perf(1) 分析器将堆栈样本总结为调用树,并显示每条路径的百分比。而 BCC 的 profile(8) 工具则以另一种方式总结堆栈跟踪,显示每个唯一堆栈跟踪的计数。在第六章提供了 perf(1) 和 profile(8) 的真实世界示例。使用这两种工具,可以快速识别存在单一堆栈占用 CPU 时间大部分情况下的病态问题。然而,对于许多其他问题,包括小的性能退化,找出罪魁祸首可能需要研究数百页的分析器输出。火焰图的创建就是为了解决这个问题。

要理解火焰图,可以考虑这个CPU分析器输出的合成示例,显示堆栈跟踪的频率计数:

func_e

func_d

func_b

func_a

1

func_b

func_a

2

func_c

func_b

func_a

7

这个输出展示了一个堆栈跟踪,后跟一个计数,总共有10个样本。例如,代码路径 func_a() -> func_b() -> func_c() 被抽样了七次。这个代码路径显示 func_c() 在CPU上运行。而 func_a() -> func_b() 代码路径,其中 func_b() 在CPU上运行,被抽样了两次。还有一个以 func_e() 在CPU上运行结束的代码路径被抽样了一次。

2.5.3 Flame Graph

图2-7展示了先前分析的火焰图表示。

这个火焰图具有以下特性:

■ 每个框代表堆栈中的一个函数(称为“堆栈帧”)。

■ 纵轴显示堆栈深度(堆栈中帧的数量),从底部的根部到顶部的叶子部分排列。从底部向上看,可以理解代码的执行流程;从顶部向下看,可以确定函数的祖先关系。

■ 横轴跨越样本集合。需要注意的是,它不像大多数图表那样显示时间的流逝从左到右。左到右的排序实际上是对帧的字母排序,以最大化帧合并。结合纵轴对帧的排序,这意味着图表的原点是左下角(与大多数图表相同),代表0,a. x轴上的长度确实具有意义:框的宽度反映了其在分析中的出现频率。宽框的函数在分析中的存在比窄框的函数更为显著。

火焰图实际上是一种邻接图,采用倒置冰柱布局[Bostock 10],用于可视化一组堆栈跟踪的层次结构。

在图2-7中,出现频率最高的堆栈显示为中间最宽的“塔”,从 func_a() 到 func_c()。由于这是一个显示CPU样本的火焰图,我们可以描述顶部边缘为运行在CPU上的函数,正如图2-8所突出显示的那样。

图2-8显示,func_c() 直接在CPU上运行了70% 的时间,func_b() 在CPU上运行了20% 的时间,func_e() 在CPU上运行了10% 的时间。另外的函数,func_a() 和 func_d(),在CPU上没有直接采样过。

阅读火焰图时,首先寻找最宽的塔,并先理解它们。

对于包含数千个样本的大型分析,可能会有一些代码路径只被少数采样,它们显示出的塔非常窄,无法容纳函数名称。这实际上是一种好处:你的注意力自然会被吸引到那些带有可读函数名称的宽塔上,先看这些塔有助于你首先理解整体分析的大部分内容。

2.5.4 Flame Graph Features

我的原始火焰图实现支持以下章节描述的功能[37]。

颜色调色板

帧可以根据不同的方案进行着色。默认情况下,每个帧使用随机的暖色调,这有助于在视觉上区分相邻的塔。多年来,我添加了更多的颜色方案。我发现以下对火焰图最有用:

- 色调:色调表示代码类型。例如,红色可以表示本地用户级代码,橙色表示本地内核级代码,黄色表示C++代码,绿色表示解释函数,青色表示内联函数等,具体颜色取决于您使用的语言。洋红色用于突出搜索匹配项。一些开发人员已经定制了火焰图,以始终使用特定色调突出显示他们自己的代码。

- 饱和度:饱和度从函数名称中获取。它提供了一些颜色变化,有助于区分相邻的塔,同时保持函数名称的相同颜色,更容易比较多个火焰图。

- 背景颜色:背景颜色提供了火焰图类型的视觉提醒。例如,您可以使用黄色表示CPU火焰图,蓝色表示非CPU或I/O火焰图,绿色表示内存火焰图。

另一个有用的颜色方案是用于IPC(每周期指令)火焰图,其中使用从蓝到白到红的渐变为每个帧着色,以可视化IPC的额外维度。

鼠标悬停

原始火焰图软件创建带有嵌入式JavaScript的SVG文件,可以在浏览器中加载以进行交互功能。其中一个功能是,在鼠标悬停帧时,会显示信息行,显示该帧在配置文件中出现的百分比。

缩放

可以点击帧进行水平缩放[18]。这允许检查窄帧,放大以显示它们的函数名称。

搜索

搜索按钮或Ctrl-F允许输入搜索项,然后突出显示匹配该搜索项的帧。还显示累积百分比,指示包含该搜索项的堆栈跟踪有多少频繁出现。这使得计算特定代码区域在配置文件中的占比变得简单。例如,您可以搜索"tcp_"以显示有多少配置文件在内核TCP代码中。

2.5.5 Variations

Netflix正在开发一个更加互动的火焰图版本,使用d3技术 [38]。这个开源项目被应用在Netflix的FlameScope软件中 [39]。

一些火焰图实现默认翻转y轴顺序,创建了一个“icicle图”,根在顶部。这种反转确保了即使是比屏幕高度更高的火焰图,以及从顶部开始显示的火焰图,根和其直接函数仍然可见。我的原始火焰图软件支持这种反转,使用--inverted参数。我个人偏好将这种icicle布局保留给从叶到根的合并,这是另一种火焰图变体,先合并叶子,最后合并根。例如,在分析自旋锁时,这种方法非常有用。

火焰图与火焰图类似的火焰图表(flame charts)受到火焰图的启发 [Tikhonovsky 13],但x轴按时间顺序而不是字母顺序排序。火焰图表在Web浏览器分析工具中很受欢迎,用于检查JavaScript,因为它们适合理解单线程应用程序中基于时间的模式。一些性能分析工具同时支持火焰图和火焰图表。

差分火焰图显示两个配置文件之间的差异 [20]。

2.6 Event Sources

图2-9展示了可以进行仪器化的不同事件来源及其示例。该图还显示了BPF支持附加到这些事件的Linux内核版本。

以下各节将详细解释这些事件来源。

2.7 kprobes

kprobes提供了内核的动态仪器化功能,它是基于IBM团队在2000年开发的DProbes跟踪器而来。然而,DProbes并未合并到Linux内核中,而kprobes却成功合并了。kprobes首次出现在Linux 2.6.9中,该版本发布于2004年。

kprobes能为任何内核函数创建仪器化事件,还可以在函数内部仪器化指令。它可以在生产环境中实时运行,而无需重新启动系统或将内核运行在特殊模式下。这是一项令人惊叹的能力:它意味着我们可以为Linux中数以万计的内核函数之一创建新的自定义指标。

kprobes技术还有一个称为kretprobes的接口,用于在函数返回时以及记录返回值时进行仪器化。当kprobes和kretprobes同时为同一函数进行仪器化时,可以记录时间戳以计算函数的持续时间,这对性能分析来说是一个重要的指标。

2.7.1 How kprobes Work

使用kprobes仪器化内核指令的步骤如下 [40]:

A. 如果是kprobe:

1. kprobes会复制并保存目标地址的字节(足够多的字节以覆盖它们,替换为断点指令)。

2. 目标地址会被替换为断点指令:在x86_64架构下是int3。(如果可以进行kprobe优化,则指令为jmp。)

3. 当执行流程触发这个断点时,断点处理程序会检查断点是否是由kprobes安装的,如果是,则执行kprobe处理程序。

4. 然后执行原始指令,并且执行流程继续。

5. 当不再需要kprobe时,原始字节会被复制回目标地址,指令恢复到原始状态。

B. 如果是用于Ftrace已经仪器化的地址的kprobe(通常是函数入口),

可能会进行基于Ftrace的kprobe优化,步骤如下 [Hiramatsu 14]:

1. 将Ftrace kprobe处理程序注册为被跟踪函数的Ftrace操作。

2. 函数在其函数序言中执行内置调用(对于gcc 4.6+和x86,是__fentry__),该调用会调用到Ftrace。Ftrace调用kprobe处理程序,然后返回执行函数。

3. 当不再需要kprobe时,从Ftrace中移除Ftrace-kprobe处理程序。

C. 如果是kretprobe:

1. 为函数入口创建一个kprobe。

2. 当函数入口kprobe被触发时,保存返回地址,然后用替代(“跳板”)函数替换它:kretprobe_trampoline()。

3. 当函数最终调用返回(例如ret指令),CPU将控制传递给跳板函数,该函数执行kretprobe处理程序。

4. kretprobe处理程序通过返回保存的返回地址来结束。

5. 当不再需要kretprobe时,移除kprobe。

kprobe处理程序可能在禁止抢占或中断的情况下运行,具体取决于架构和其他因素。

修改内核指令文本实时可能听起来极具风险,但它已被设计为安全。这个设计包括一个黑名单,其中列出了kprobe不会仪器化的函数,包括kprobes本身,以避免递归陷阱条件。kprobes还使用安全技术来插入断点:在x86架构下使用本地的int3指令,或者在使用jmp指令时使用stop_machine()来确保其他核心不在修改过程中执行指令。实际应用中最大的风险是仪器化一个非常频繁的内核函数:如果发生这种情况,每次调用都会增加一点小的开销,累积起来可能会拖慢系统的速度。

由于安全原因,kprobes在某些ARM 64位系统上无法工作,因为不允许对内核文本部分进行修改。

2.7.2 kprobes Interfaces

原始的kprobes技术是通过编写定义了预处理程序和后处理程序的内核模块来实现的,这些程序用C语言编写,并通过调用kprobe API函数register_kprobe()进行注册。然后,可以加载内核模块,并通过调用printk()输出系统消息以发出自定义信息。完成后需要调用unregister_kprobe()来注销kprobe。

我没有看到有人直接使用这个接口,除了2010年Phrack的一篇文章《使用kprobes进行内核仪器化》,由一个名为ElfMaster22的研究人员撰写。这可能不是kprobes的失败,因为它最初是为Dprobes而设计的。现在,使用kprobes有三种接口:

- kprobe API:register_kprobe()等。

- 基于Ftrace的接口,通过/sys/kernel/debug/tracing/kprobe_events实现,可以通过向该文件写入配置字符串来启用和禁用kprobes。

- perf_event_open():perf(1)工具使用的接口,最近还被BPF跟踪所支持,Linux 4.17内核中添加了对perf_kprobe pmu的支持。

kprobes主要通过前端跟踪器使用,包括perf(1)、SystemTap以及BPF跟踪工具BCC和bpftrace。

原始的kprobes实现还有一个变体称为jprobes,专门设计用于跟踪内核函数入口。随着时间推移,我们意识到kprobes可以满足所有需求,jprobes接口变得不再必要。2018年,kprobe维护者Masami Hiramatsu从Linux中移除了jprobes接口。

2.7.3 BPF and kprobes

kprobes为BCC和bpftrace提供了内核动态仪器化功能,并被多种工具使用。其接口包括:

- BCC:attach_kprobe() 和 attach_kretprobe()

- bpftrace:kprobe 和 kretprobe 探针类型

BCC中的kprobe接口支持在函数开始时和函数加指令偏移量时进行仪器化,而bpftrace目前仅支持在函数开始时进行仪器化。这两种跟踪工具的kretprobe接口都用于仪器化函数的返回。

例如,来自BCC的一个示例是vfsstat(8)工具,用于仪器化关键的虚拟文件系统(VFS)接口调用,并打印每秒的汇总信息:

这些是attach_kprobe()函数。在"event="赋值之后可以看到内核函数。

例如,来自bpftrace的这个一行命令计算所有VFS函数调用的次数,通过匹配"vfs_*"实现:

这个输出显示,在跟踪过程中,vfs_unlink()函数被调用了两次,而vfs_read()函数被调用了5581次。

从任何内核函数中获取调用次数的能力是一种有用的功能,可以用于对内核子系统的工作负载特性进行表征。

2.7.4 kprobes Additional Reading

了解kprobes的更多资源:

- Linux内核源码中的 Documentation/kprobes.txt [42]

- Sudhanshu Goswami 的文章 "An Introduction to kprobes" [40]

- Prasanna Panchamukhi 的书籍 "Kernel Debugging with kprobes" [43]

2.8 uprobes

uprobes提供了用户级动态仪器化功能。该工作在多年前就开始了,最初使用了类似于kprobes接口的utrace接口。最终,这一技术发展成为uprobes,并在2012年7月发布的Linux 3.5内核中合并 [44]。

uprobes类似于kprobes,但针对用户空间进程。uprobes可以仪器化用户级函数的入口以及指令偏移量,而uretprobes则可以仪器化函数的返回。

uprobes也是基于文件的:当跟踪可执行文件中的函数时,所有使用该文件的进程都会被仪器化,包括将来启动的进程。这使得可以跟踪系统范围内的库调用。

2.8.1 How uprobes Work

uprobes与kprobes在其方法上类似:它在目标指令处插入一个快速断点,并将执行传递给一个uprobes处理程序。当不再需要uprobes时,目标指令会被返回到其原始状态。对于uretprobes,函数入口处使用uprobes进行仪器化,并且返回地址会被一个跳转函数(trampoline function)劫持,与kprobes类似。

您可以通过使用调试器来看到它的实际效果。例如,可以对bash(1) shell中的readline()函数进行反汇编操作:

请注意,第一条指令已经变成了int3断点(针对x86_64架构)。

为了对readline()函数进行仪器化,我使用了一个bpftrace的一行命令:

这个命令会统计在所有正在运行和未来启动的bash shell中调用readline()的次数,并在按下Ctrl-C后打印计数并退出。当bpftrace停止运行时,uprobes会被移除,原始指令也会被恢复。

2.8.2 Uprobes Interfaces

uprobes有两种接口:

- 基于Ftrace的接口,通过/sys/kernel/debug/tracing/uprobe_events:可以通过向该文件写入配置字符串来启用和禁用uprobes。

- 使用perf_event_open():这是perf(1)工具以及最近BPF跟踪所使用的方式,支持从Linux 4.17内核开始(使用perf_uprobe pmu)。

此外,还有一个register_uprobe_event()内核函数,类似于register_kprobe(),但它没有作为公共API公开。

2.8.3 BPF and uprobes

uprobes为BCC和bpftrace提供了用户级动态仪器化,并被许多工具使用。其接口包括:

- BCC:attach_uprobe() 和 attach_uretprobe()

- bpftrace:uprobe 和 uretprobe 探针类型

BCC中的uprobes接口支持对函数开头或任意地址进行仪器化,而bpftrace目前仅支持对函数开头进行仪器化。对于这两种跟踪器来说,uretprobes接口用于仪器化函数的返回过程。

例如,在BCC中,gethostlatency(8)工具通过解析器库调用getaddrinfo(3)、gethostbyname(3)等来仪器化主机解析调用(DNS)的过程。

这些是attach_uprobe()和attach_uretprobe()调用。用户级函数可以在“sym=”赋值后看到。

作为bpftrace的一个示例,以下这些一行命令列出并计算了从libc系统库中所有gethost函数的调用次数:

这个输出显示,在跟踪期间,gethostname()函数被调用了两次。

2.8.4 uprobes Overhead and Future Work

uprobes可以附加到每秒触发数百万次的事件,例如用户级分配例程:malloc()和free()。尽管BPF经过性能优化,但将微小的开销乘以每秒数百万次会累积起来。在某些情况下,malloc()和free()的跟踪,本应是BPF的首选用例,但可能会使目标应用程序的速度减慢十倍(10倍)甚至更多。这阻止了在这些情况下使用BPF;只有在测试环境中进行故障排除或在已经损坏的生产环境中才能接受这种速度变慢。第18章包括有关操作频率的部分,以帮助您解决这一限制。您需要了解哪些事件频繁发生,尽可能避免跟踪它们,并寻找较慢的事件来替代,以解决同样的问题。

未来用户空间跟踪可能会有很大改进——也许在您阅读此文时已经实现。正在讨论的不再使用当前的uprobes方法,该方法会陷入内核,而是采用共享库解决方案,可以提供不需要内核模式切换的用户空间BPF跟踪。多年来,LTTng-UST一直在使用这种方法,其性能测量结果显示速度提升了10倍到100倍。

2.8.5 uprobes Additional Reading

更多信息请参阅Linux内核源代码中的Documentation/trace/uprobetracer.txt文件【46】。

2.9 Tracepoints

跟踪点用于内核静态插装。它们涉及跟踪开发者在内核代码的逻辑位置插入的调用,并将这些调用编译到内核二进制文件中。由Mathieu Desnoyers于2007年开发,跟踪点最初被称为内核标记,并在2009年的Linux 2.6.32版本中提供。表2-7比较了kprobes和跟踪点。

跟踪点对内核开发者来说是一项维护负担,其作用范围远不及kprobes广泛。其优势在于,跟踪点提供了一个稳定的API:使用跟踪点编写的工具应该能够跨更高版本的内核继续工作,而使用kprobes编写的工具可能会因为被跟踪的函数被重命名或修改而失效。

如果有跟踪点可用且足够,您应该始终首选使用跟踪点,只有在需要时才考虑使用kprobes作为备选方案。

跟踪点的格式是 subsystem:eventname(例如,kmem:kmalloc)【47】。跟踪器使用不同术语来指代第一个组件:作为系统、子系统、类别或提供者。

2.9.1 Adding Tracepoint Instrumentation

作为一个跟踪点的示例,本节解释了如何将 sched:sched_process_exec 添加到内核中。

在 include/trace/events 目录中有用于跟踪点的头文件。以下是来自 sched.h 文件的内容:

这段代码将跟踪系统定义为 sched,并将跟踪点名称定义为 sched_process_exec。接下来的几行定义了元数据,包括在 TP_printk() 中的“格式字符串” —— 这是在使用 perf(1) 工具记录跟踪点时包含的一个有用的摘要。

前述信息在运行时也可以通过 Ftrace 框架在 /sys 下的格式文件获取,针对每个跟踪点都有相应的文件。例如:

这些格式文件由跟踪器处理,以理解与跟踪点相关联的元数据。

下面的跟踪点是通过内核源码中的 fs/exec.c 调用的,通过 trace_sched_process_exec():

trace_sched_process_exec() 函数标记了跟踪点的位置。

2.9.2 How Tracepoints Work

重要的是,未启用的跟踪点的开销应尽可能小,以避免因未使用的功能而付出性能代价。Mathieu Desnoyers 通过使用一种称为“静态跳转修补”的技术来实现这一点。这项技术如下运作,前提是编译器支持必要的特性(asm goto):

1. 在内核编译时,会在跟踪点位置添加一个不执行任何操作的指令。实际使用的指令取决于架构:对于 x86_64,这是一个5字节的无操作(nop)指令。此大小用于稍后替换为5字节的跳转(jmp)指令。

2. 也会在函数末尾添加一个跟踪点处理程序(trampoline),该处理程序会遍历注册的跟踪点探针回调函数数组。这会稍微增加指令文本大小(作为一个跳板,它是一个小型例程,所以执行会进入然后立即退出),这可能对指令缓存产生小的影响。

3. 在运行时,当跟踪器启用跟踪点时(它可能已经被其他运行中的跟踪器使用):

a. 跟踪点回调函数数组会被修改,为跟踪器添加一个新的回调函数,通过RCU进行同步。

b. 如果之前未启用跟踪点,则将 nop 的位置重写为跳转到跟踪点跳板的指令。

4. 当跟踪器禁用跟踪点时:

a. 跟踪点回调函数数组会被修改,移除回调函数,通过RCU进行同步。

b. 如果最后一个回调函数被移除,则将静态跳转指令重新写回 nop。

这样可以将未启用的跟踪点的开销最小化,使其几乎可以忽略不计。如果不支持 asm goto,则会使用回退技术:而不是将 nop 替换为 jmp,会基于从内存读取的变量使用条件分支。

2.9.3 Tracepoint Interfaces

有两种用于跟踪点的接口:

■ 基于 Ftrace,通过 /sys/kernel/debug/tracing/events:其中每个跟踪点系统都有子目录,并且每个跟踪点本身都有文件(通过向这些文件写入来启用和禁用跟踪点)。

■ perf_event_open():由 perf 工具使用,并且最近也被 BPF 跟踪所采用(通过 perf_tracepoint pmu)。

2.9.4 Tracepoints and BPF

跟踪点为 BCC 和 bpftrace 提供了内核静态工具。接口如下:

■ BCC:TRACEPOINT_PROBE()

■ bpftrace:tracepoint probe 类型

BPF 在 Linux 4.7 中支持了 tracepoints,但在此之前,我开发了许多依赖 kprobes 的 BCC 工具。这意味着在 BCC 中的 tracepoint 示例比我希望的要少,仅仅是支持开发的顺序导致了这种情况。

BCC 和 tracepoints 的一个有趣例子是 tcplife(8) 工具。它以一行摘要形式打印 TCP 会话的各种详细信息(在第10章中详细介绍)。

在 Linux 内核中适当的跟踪点出现之前,我编写了这个工具,因此我使用了 tcp_set_state() 内核函数上的 kprobe。在 Linux 4.16 中增加了一个合适的跟踪点:sock:inet_sock_set_state。我修改了工具以支持两者,这样它可以在较旧和较新的内核上运行。该工具定义了两个程序——一个用于跟踪点,一个用于 kprobes——然后通过以下测试选择要运行的程序:

作为 bpftrace 和 tracepoints 的示例,以下这行命令对之前显示的 sched:sched_process_exec 跟踪点进行了仪器化:

这个 bpftrace 命令一行打印出调用 exec() 的进程名称。

2.9.5 BPF Raw Tracepoints

Alexei Starovoitov在2018年为跟踪点开发了一个名为BPF_RAW_TRACEPOINT的新接口,该接口在Linux 4.17中加入。它避免了创建稳定跟踪点参数的成本(这些参数可能并非总是需要的),并且将原始参数暴露给跟踪点。在某种程度上,这类似于像使用kprobes那样访问跟踪点:虽然API不稳定,但可以访问更多字段,并且不需要支付常规跟踪点的性能开销。相比使用kprobes,它也更为稳定,因为跟踪点探针名称是稳定的,只有参数可能不稳定。

Alexei展示了在压力测试中,BPF_RAW_TRACEPOINT的性能优于kprobes和标准跟踪点的结果 [48]:

对于那些全天候仪器化跟踪点的技术来说,这可能尤其有趣,以最小化启用跟踪点的开销。

2.9.6 Additional Reading

更多信息,请查看内核源代码中的 Documentation/trace/tracepoints.rst,由Mathieu Desnoyers编写 [47]。

2.10 USDT

用户级静态定义跟踪(USDT)提供了用户空间版本的跟踪点。Sasha Goldshtein为BCC实现了USDT,我和Matheus Marchini为bpftrace实现了USDT。

对于用户级软件来说,有许多跟踪或日志记录技术,许多应用程序都带有自己的定制事件记录器,可以在需要时启用。USDT的不同之处在于它依赖于外部系统跟踪器来激活。如果没有外部跟踪器,应用程序中的USDT点无法使用,也不会执行任何操作。

USDT由Sun Microsystems的DTrace实用程序广为人知,现在已经在许多应用程序中可用。Linux开发了一种利用USDT的方式,这源自SystemTap跟踪器。BCC和bpftrace跟踪工具利用了这项工作,两者都可以对USDT事件进行仪器化。

仍然存在来自DTrace的一个遗留问题:许多应用程序默认不编译USDT探针,而是需要像 --enable-dtrace-probes 或 --with-dtrace 这样的配置选项。

2.10.1 Adding USDT Instrumentation

USDT探针可以通过使用systemtap-sdt-dev包中的头文件和工具,或者使用自定义头文件添加到应用程序中。这些探针定义了可以放置在代码中逻辑位置的宏,以创建USDT仪器化点。BCC项目包含一个名为examples/usdt_sample的USDT代码示例,可以使用systemtap-sdt-dev头文件或来自Facebook的Folly C++库[11]的头文件进行编译。在接下来的部分,我将介绍使用Folly的示例。

Folly

使用Folly添加USDT仪器化的步骤如下:

1. 将头文件添加到目标源代码中:

#include "folly/tracing/StaticTracepoint.h"

2. 在目标位置添加USDT探针,格式为:

FOLLY_SDT(provider, name, arg1, arg2, ...)

其中,"provider"用于分组探针,"name"是探针的名称,后跟可选的参数。BCC的USDT示例包含以下内容:

FOLLY_SDT(usdt_sample_lib1, operation_start, operationId, request.input().c_str());

这定义了一个名为usdt_sample_lib1:operation_start的探针,并提供了两个参数。USDT示例还包含一个operation_end探针。

3. 构建软件。您可以使用readelf(1)来检查USDT探针是否存在:

使用readelf(1)的-n选项打印注释部分,这部分应显示有关已编译USDT探针的信息。

4. 可选步骤:有时您想要添加到探针的参数在探针位置不容易获取,并且必须使用耗费CPU资源的函数调用进行构造。为了避免在探针不使用时频繁进行这些调用,您可以在函数之外的源文件中添加一个探针信号量:

FOLLY_SDT_DEFINE_SEMAPHORE(provider, name)

然后,探针点可以变为:

现在,昂贵的参数处理仅在探针被使用(启用)时发生。信号量的地址将在readelf(1)中可见,跟踪工具在使用探针时可以设置它。这确实使得跟踪工具复杂化了一些:当受信号量保护的探针被使用时,这些跟踪工具通常需要指定一个PID,以便为该PID设置信号量。

2.10.2 How USDT Works

在应用程序编译时,会在USDT探针的地址处放置一个空操作(nop)指令。然后,内核在仪器化时会动态地将该地址更改为一个断点,使用uprobes技术。

与uprobes类似,我可以展示USDT的运行情况,尽管这需要做更多工作。从前面的readelf(1)输出中可以看到探针的位置是0x6a2。这是相对于二进制段的偏移量,因此您首先需要了解二进制段的起始位置。由于位置无关可执行文件(PIE)的存在,这个起始位置可能会有所不同,PIE使得地址空间布局随机化(ASLR)更加有效。

nop指令已经改变成int3(x86_64的断点指令)。当这个断点被触发时,内核会执行附加的BPF程序,并传递给USDT探针的参数。当USDT探针被停用时,nop指令会被恢复。

2.10.3 BPF and USDT

USDT为BCC和bpftrace提供了用户级静态插装。其接口包括:

- BCC: USDT().enable_probe()

- bpftrace: usdt探针类型

例如,对前面例子中的循环探针进行仪器化:

这个bpftrace的一行命令还打印出了传递给探针的整数参数。

2.10.4 USDT Additional Reading

理解USDT的更多资源包括:

- Brendan Gregg 的《Hacking Linux USDT with Ftrace》 [49]

- Sasha Goldshtein 的《USDT Probe Support in BPF/BCC》 [50]

- Dale Hamel 的《USDT Tracing Report》 [51]

2.11 Dynamic USDT

之前描述的USDT探针是添加到源代码中并编译到生成的二进制文件中的,在插装点留下nop指令,并在ELF注释部分中留下元数据。然而,一些语言如Java在JVM上是解释执行或即时编译的。动态USDT可用于在Java代码中添加插装点。

需要注意的是,JVM已经在其C++代码中包含了许多USDT探针,用于GC事件、类加载和其他高级活动。这些USDT探针正在对JVM的函数进行插装。但是,对于即时编译的Java代码,无法添加USDT探针。USDT需要一个包含探针描述的预编译ELF文件的notes部分,而对于JIT编译的Java代码这种文件是不存在的。

动态USDT通过以下方式解决了这个问题:

- 预先编译一个带有所需USDT探针嵌入函数中的共享库。这个共享库可以是C或C++编写的,并且具有用于USDT探针的ELF notes部分。它可以像任何其他USDT探针一样进行插装。

- 在需要时使用 `dlopen(3)` 加载共享库。

- 从目标语言添加共享库调用。可以使用适合该语言的API来实现这些调用,隐藏底层的共享库调用。

Matheus Marchini 在一个名为 libstapsdt 的库中实现了Node.js和Python的动态USDT支持,该库提供了在这些语言中定义和调用USDT探针的方法。通常可以通过包装这个库来为其他语言添加支持,比如 Dale Hamel 为Ruby所做的那样,利用了Ruby的C扩展支持 [54]。

例如,在Node.js中的JavaScript中:

probe1.fire()调用仅在探针被外部插装时执行其匿名函数。在这个函数内部,可以处理参数(如果有必要),然后将它们传递给探针,而不必担心这种参数处理会带来非启用状态下的CPU成本,因为如果探针未使用,这部分过程会被跳过。

libstapsdt会在运行时自动创建一个包含USDT探针和ELF notes部分的共享库,并将该部分映射到运行程序的地址空间中。

2.12 PMCs

性能监控计数器(PMC)也被称为性能仪器计数器(PIC)、CPU性能计数器(CPC)和性能监控单元事件(PMU事件)。这些术语都指的是处理器上可编程的硬件计数器。

尽管有许多种类的PMC,Intel选取了七个PMC作为“架构集”,提供了一些核心功能的高级概述[Intel 16]。这些架构集PMC的存在可以通过CPUID指令来检查。表2-8展示了这个集合,作为有用PMC的示例。

PMC(性能监控计数器)是性能分析中至关重要的资源。只有通过PMC,你才能测量CPU指令的效率、CPU缓存的命中率、内存、互连和设备总线的利用率、停顿周期等。利用这些测量数据来分析性能可以带来各种小型性能优化。

PMCs也是一种特殊的资源。虽然有数百种不同的PMC可用,但在CPU中同时只有固定数量的寄存器(可能只有六个)可用于同时测量它们。你需要选择在这六个寄存器上想要测量的PMC,或者通过循环使用不同的PMC集合来对它们进行采样(Linux的perf(1)支持这种自动循环)。其他软件计数器不受这些限制的影响。

2.12.1 PMC Modes

PMCs可以在两种模式下使用:

- 计数模式:在这种模式下,PMCs跟踪事件发生的速率。内核可以在需要时读取计数,例如获取每秒的度量指标。这种模式的开销几乎为零。

- 溢出采样模式:在这种模式下,PMCs可以向内核发送中断,用于监控的事件,以便内核可以收集额外的状态信息。被监视的事件可以每秒发生数百万次甚至数十亿次;如果每次事件都发送一个中断,系统几乎会停滞。解决方案是通过使用可编程计数器来对事件进行采样,当计数器溢出时(例如每10,000次LLC缓存未命中或每1百万个停顿周期),计数器向内核发出信号。

采样模式对于BPF跟踪特别有趣,因为它生成可以通过自定义BPF程序进行仪器化的事件。BCC和bpftrace都支持PMC事件。

2.12.2 PEBS

溢出采样可能由于中断延迟(通常称为“滑差”)或乱序指令执行而未记录触发事件的正确指令指针。对于CPU周期分析来说,这种滑差可能并不是问题,一些性能分析工具故意引入抖动以避免锁步采样(或使用偏移采样率,如99赫兹)。但对于测量其他事件,如LLC未命中,采样的指令指针需要是准确的。

英特尔开发了一种称为精确事件基础采样(PEBS)的解决方案。PEBS利用硬件缓冲区在PMC事件发生时记录正确的指令指针。Linux的perf_events框架支持使用PEBS。

2.12.3 Cloud Computing

许多云计算环境尚未向其虚拟机客户提供PMC(性能监控计数器)的访问权限。从技术上讲,可以启用这一功能;例如,Xen虚拟化管理程序具有vpmu命令行选项,允许向客户机公开不同的PMC集合[55]。亚马逊已经为其Nitro虚拟化管理程序的客户启用了许多PMC。

2.13 perf_events

perf_events设施用于perf(1)命令进行采样和跟踪,它于2009年添加到Linux 2.6.21中。值得注意的是,多年来perf(1)和其perf_events设施受到了广泛关注和开发,BPF跟踪器可以调用perf_events来利用其功能。BCC和bpftrace最初使用perf_events进行环形缓冲区,然后进行PMC仪器化,现在通过perf_event_open()进行所有事件仪器化。

虽然BPF跟踪工具利用了perf(1)的内部机制,但也开发并添加了一个面向BPF的接口到perf(1)中,使perf(1)成为另一个BPF跟踪器。与BCC和bpftrace不同,perf(1)的源代码位于Linux树中,因此perf(1)是唯一内置于Linux中的BPF前端跟踪器。

perf(1)的BPF仍在开发中且使用起来较为复杂。详细介绍超出了本章节的范围,本章节主要关注BCC和bpftrace工具。perf BPF的示例包含在附录D中。

2.14 Summary

BPF性能工具利用了多种技术,包括扩展BPF、内核和用户动态仪器化(kprobes和uprobes)、内核和用户静态跟踪(tracepoints和用户标记),以及perf_events。BPF还可以通过基于帧指针的遍历或ORC获取堆栈跟踪,这些可以以火焰图的形式进行可视化。本章节涵盖了这些技术,并提供了进一步阅读的参考资料。

3 Performance Analysis

本书中的工具可以用于性能分析、故障排除、安全分析等多种用途。为了帮助您理解如何应用它们,本章提供了性能分析的快速入门课程。

学习目标:

- 理解性能分析的目标和活动

- 进行工作负载特性分析

- 使用USE方法进行分析

- 进行深入分析

- 理解检查清单方法论

- 使用传统工具和Linux 60秒检查清单找到快速性能优化

- 使用BCC/BPF工具检查清单找到快速性能优化

本章首先描述了性能分析的目标和活动,然后总结了传统(非BPF)工具的方法论,可以首先尝试使用这些传统工具来直接找到快速的性能优化点,或者提供后续基于BPF的分析的线索和背景信息。章末包括了一个BPF工具的检查清单,后续章节将介绍更多的BPF工具。

3.1 Overview

在深入进行性能分析之前,思考一下你的目标以及可以帮助你实现这些目标的不同活动,这可能会有所帮助。

3.1.1 Goals

总体而言,性能分析的目标是提升终端用户性能并降低运营成本。将性能目标明确化为可测量的指标是有帮助的;这样的测量可以显示何时达到了性能目标,或者量化了不足之处。这些测量包括:

- 延迟:完成请求或操作所需的时间,通常以毫秒计量

- 比率:每秒的操作或请求率

- 吞吐量:通常以每秒传输的数据量(比特或字节)计量

- 利用率:资源在一段时间内的繁忙程度,以百分比表示

- 成本:性能与价格之比

终端用户性能可以量化为应用程序响应用户请求所需的时间,目标是缩短这个时间。这段等待时间通常称为延迟。通过分析请求时间并将其分解为组成部分,如运行在CPU上的时间及其代码、等待磁盘、网络和锁资源的时间、等待CPU调度器的时间等,可以改善延迟。可以编写一个BPF工具,直接跟踪应用程序请求时间及来自多个不同组件的延迟。这样的工具将是特定于应用程序的,并可能在同时跟踪多个不同事件时产生显著的开销。实际上,通常会使用较小的具体工具来研究特定组件的时间和延迟。本书包括许多这样的较小和具体的工具。

降低运营成本可以涉及观察软件和硬件资源的使用方式,并寻找优化方法,目标是减少公司在云或数据中心的支出。这可能涉及不同类型的分析,例如总结或记录组件的使用方式,而不是其响应的时间或延迟。本书中的许多工具也支持这一目标。

在进行性能分析时,请牢记这些目标。使用BPF工具很容易生成大量数据,并花费数小时来理解一个后来证明并不重要的度量指标。作为性能工程师,我经常收到开发人员发送的工具输出截图,他们担心一个表现看起来很糟糕的度量。我的第一个问题通常是:“您是否遇到了已知的性能问题?” 他们的答案往往是:“没有,我们只是觉得这个输出看起来...有趣。” 这可能确实很有趣,但我首先需要确定目标:我们是在试图减少请求延迟,还是运营成本?目标为进一步的分析设定了上下文。

3.1.2 Activities

BPF性能工具不仅可以用于分析特定问题,还可以用于以下性能活动[Gregg 13b],请考虑以下列表,并思考BPF性能工具如何在每个活动中发挥作用:

显而易见的是,本书中的许多工具适合研究特定的性能问题,但也要考虑它们如何改善监控、非回归测试以及其他活动。

3.1.3 Mulitple Performance Issues

在使用本书描述的工具时,请准备好发现多个性能问题。问题在于确定哪个问题最为重要:通常是对请求延迟或成本影响最大的那个问题。如果你并没有预期发现多个性能问题,请尝试查找你的应用程序、数据库、文件系统或软件组件的bug跟踪器,并搜索关键词“performance”。通常会存在多个未解决的性能问题,以及一些尚未列在跟踪器中的问题。关键在于找出哪些问题最为重要。

任何一个问题可能有多个根本原因。很多时候,当你修复了一个原因时,其他原因会变得显而易见。或者,当你解决了一个原因时,另一个组件就成了瓶颈。

3.2 Performance Methodologies

有了如此多的性能工具和功能可用(例如,kprobes、uprobes、tracepoints、USDT、PMCs;请参阅第2章),如何处理它们提供的所有数据可能会很困难。多年来,我一直在研究、创建和记录性能方法论。方法论是一种你可以遵循的过程,提供了起点、步骤和终点。我的先前著作《系统性能》记录了几十种性能方法论[Gregg 13b]。我在这里将总结其中一些,您可以使用BPF工具进行跟随。

3.2.1 Workload Characterization

工作负载特征化的目的是了解应用负载。您无需分析导致的性能问题,比如延迟。我发现最大的性能改进往往是“消除不必要的工作”。通过研究工作负载的组成部分可以找到这样的改进。

执行工作负载特征化的建议步骤如下:

1. 谁引起了负载(例如,PID、进程名称、UID、IP地址)?

2. 为什么负载被调用(代码路径、堆栈跟踪、火焰图)?

3. 负载是什么(IOPS、吞吐量、类型)?

4. 负载随时间如何变化(每个间隔的摘要信息)?

本书中的许多工具可以帮助您回答这些问题。例如,vfsstat(8):

这显示了应用在虚拟文件系统(VFS)层级上的工作负载的详细信息,并通过提供类型和操作速率回答了步骤3,并通过随时间提供每个间隔的摘要来回答步骤4。

作为步骤1的简单示例,我将转向bpftrace并使用一个单行命令(输出已截断):

这显示,在我跟踪时,名为“Web Content”的进程执行了1725次vfs_read()操作。

本书中有更多通过这些步骤的工具示例,包括稍后章节中的火焰图,可以用于第2步。

如果您分析的目标没有现成的工具可用,您可以创建自己的工作负载特征化工具来回答这些问题。

3.2.2 Drill-Down Analysis

钻取分析涉及检查一个指标,然后找到将其分解成组成部分的方法,接着将最大的组成部分进一步分解成其自身的组成部分,依此类推,直到找到一个或多个根本原因。

打个比方来解释一下。想象一下,你发现信用卡账单异常高。为了分析,你登录银行查看交易记录。在那里,你发现有一笔大额支付给一个在线书店。然后你登录到那家书店,查看是哪些书导致了这笔支出,结果发现你意外地购买了1000本这本书(谢谢您!)。这就是钻取分析:找到一个线索,然后深入挖掘,根据更多的线索进行进一步分析,直到解决问题。

钻取分析的建议步骤如下:

1. 从最高层级开始检查。

2. 检查下一级的详细信息。

3. 选择最有趣的分解或线索。

4. 如果问题未解决,回到步骤2。

钻取分析可能涉及定制工具,这些工具在使用bpftrace比使用BCC更为合适。

钻取分析的一种类型涉及将延迟分解为其构成部分。想象一下以下的分析序列:

1. 请求的延迟是100毫秒(ms)。

2. 其中10毫秒在CPU上运行,90毫秒在CPU之外阻塞。

3. 在CPU之外的时间中,有89毫秒是在文件系统上阻塞。

4. 文件系统在锁定上阻塞了3毫秒,并在存储设备上阻塞了86毫秒。

在这里,你的结论可能是存储设备存在问题,这是一个答案。但钻取分析也可以用来更精确地理解背景情况。考虑以下的替代序列:

1. 应用程序在文件系统上阻塞了89毫秒。

2. 文件系统在文件系统写入上阻塞了78毫秒,并在读取上阻塞了11毫秒。

3. 文件系统写入在访问时间戳更新上阻塞了77毫秒。

现在你的结论是文件系统访问时间戳是延迟的根源,可以通过禁用它们(这是一种挂载选项)来解决问题。这比得出需要更快的磁盘的结论要好得多。

3.2.3 USE Method

我开发了资源分析的USE方法论[Gregg 13c]。

针对每一种资源,检查以下内容:

1. 利用率(Utilization)

2. 饱和度(Saturation)

3. 错误(Errors)

你的第一个任务是找到或绘制软件和硬件资源的图表。然后,你可以迭代地对它们进行检查,寻找这三个指标。图3-1展示了一个通用系统的硬件目标示例,包括可以检查的组件和总线。

考虑你当前的监控工具及其显示图3-1中每一项的利用率、饱和度和错误的能力。你目前有多少盲点?

这种方法的优势在于它从重要的问题开始,而不是从以指标形式回答问题,然后试图逆向推导为何这些指标重要。它还能够揭示盲点:它从你想要回答的问题开始,无论是否存在便捷的工具来衡量这些问题。

3.2.4 Checklists

性能分析的检查清单可以列出工具和指标供运行和检查。它们可以集中在低 hanging fruit 上:识别一些十分常见的问题,提供每个人都能遵循的分析指导。这些适合广泛的公司员工执行,可以帮助你扩展技能。

接下来的部分将介绍两个检查清单:一个使用传统(非BPF)工具进行快速分析(第一分钟内),另一个是早期尝试的BCC工具清单。

3.3 Linux 60-Second Analysis

这份清单可以用于任何性能问题,并反映了我在登录到性能不佳的Linux系统后的头60秒内通常执行的操作。这是由我和Netflix性能工程团队共同发布的[56]:

需要运行的工具包括:

1. uptime

2. dmesg | tail

3. vmstat 1

4. mpstat -P ALL 1

5. pidstat 1

6. iostat -xz 1

7. free -m

8. sar -n DEV 1

9. sar -n TCP,ETCP 1

10. top

接下来的部分将解释每个工具的用途。在BPF书籍中讨论非BPF工具可能显得有些不合时宜,但如果不这样做,就会错过一个已经存在的重要资源。这些命令可能会直接帮助你解决一些性能问题。如果不能,它们可能会揭示性能问题的线索,指导你如何使用后续的BPF工具来找到真正的问题所在。

3.3.1 uptime

这是查看负载平均值的快速方式,它指示了想要运行的任务(进程)数量。在Linux系统中,这些数字包括希望在CPU上运行的进程,以及在不可中断I/O(通常是磁盘I/O)中被阻塞的进程。这提供了资源负载(或需求)的高级概念,可以进一步使用其他工具进行深入探索。

这三个数字是指数阻尼移动平均值,分别以1分钟、5分钟和15分钟为常数。这三个数字让你了解负载随时间的变化情况。在上面的示例中,负载平均值显示最近有轻微增加。在首次响应问题时,检查负载平均值是否仍然存在是值得的。

3.3.2 dmesg | tail

这显示了最近的10条系统消息(如果有)。查找可能导致性能问题的错误。上面的示例包括内存不足杀手(out-of-memory killer)和TCP丢弃请求的消息。TCP消息甚至指向下一个分析领域:SNMP计数器。

3.3.3 vmstat 1

这是源自BSD的虚拟内存统计工具,同时显示其他系统指标。当使用参数1调用时,它会打印每秒的摘要;注意,第一行数字是自系统启动以来的总结(除了内存计数器)。

需要检查的列包括:

- **r**: 在CPU上运行并等待轮换的进程数。这比负载平均值更好地指示CPU饱和情况,因为它不包括I/O。解释方式是,如果“r”值大于CPU核心数,则表示饱和。

- **free**: 空闲内存,以KB为单位。如果有太多数字难以计算,可能有足够的空闲内存。命令`free -m`可以更好地解释空闲内存的状态。

- **si** 和 **so**: 交换进和交换出。如果这些值不为零,表示内存不足。只有在配置了交换设备时才会使用这些。

- **us, sy, id, wa, st**: 这些是CPU时间的细分,平均分布在所有CPU上。它们分别是用户时间、系统时间(内核)、空闲时间、等待I/O时间和被偷取的时间(被其他虚拟机(guests)占用,或者在Xen中是被客户机自己的隔离驱动域占用)。

示例显示CPU时间大部分处于用户模式。这应该引导您下一步分析正在运行的用户级代码,可以使用性能分析工具。

3.3.4 mpstat -P ALL 1

这个命令打印每个CPU的时间分解状态。输出显示了一个问题:CPU 0 的用户时间达到了100%,表明存在单线程瓶颈。

另外要注意高% iowait时间,可以用磁盘I/O工具来探索,以及高% sys时间,可以用系统调用和内核跟踪,以及CPU性能分析工具来探索。

3.3.5 pidstat 1

pidstat(1)显示每个进程的CPU使用情况。top(1)是一个常用的用于此目的的工具;然而,pidstat(1)默认提供滚动输出,因此可以看到随时间变化的情况。这个输出显示一个Java进程每秒消耗不同数量的CPU;这些百分比是在所有CPU上求和的,因此500%相当于五个CPU每个都在100%利用。

3.3.6 iostat -xz 1

这个工具显示存储设备的I/O指标。输出中每个磁盘设备的列在此处被换行,使阅读变得困难。

需要检查的列包括:

- **r/s, w/s, rkB/s, wkB/s**: 这些是每秒向设备传递的读取次数、写入次数、读取的KB数和写入的KB数。用于工作负载的表征。性能问题可能仅仅是由于施加了过多的负载。

- **await**: I/O的平均时间,以毫秒计。这是应用程序遭受的时间,因为它包括排队时间和正在服务的时间。比预期的平均时间长可能表明设备饱和或设备问题的指示。

- **avgqu-sz**: 发送到设备的平均请求数。大于1的值可能表明饱和(尽管设备,特别是前端多个后端磁盘的虚拟设备通常并行处理请求)。

- **%util**: 设备利用率。这实际上是忙碌百分比,显示设备每秒执行工作的时间。它不显示容量规划意义上的利用率,因为设备可以并行处理请求。大于60%的值通常会导致性能不佳(应该在await列中看到),尽管这取决于设备。接近100%的值通常表明设备饱和。

输出显示对md0虚拟设备的写入工作负载约为每秒约300兆字节,看起来支持了nvme0设备的两者。

3.3.7 free -m

这显示了以兆字节为单位的可用内存。请检查可用值不接近零;它显示系统中实际可用的内存量,包括缓冲区和页面缓存中的内存。

在缓存中保留一些内存可以提升文件系统的性能。

3.3.8 sar -n DEV 1

sar(1)工具有多种模式用于不同组的指标。在这里,我使用它来查看网络设备的指标。检查接口吞吐量 rxkB/s 和 txkB/s,看是否已达到任何限制。

3.3.9 sar -n TCP,ETCP 1

现在我们正在使用sar(1)来查看TCP指标和TCP错误。需要检查的列包括:

- active/s:每秒本地发起的TCP连接数(例如,通过connect())

- passive/s:每秒远程发起的TCP连接数(例如,通过accept())

- retrans/s:每秒的TCP重传次数

活动和被动连接计数对于工作负载的特征化非常有用。重传表示可能存在网络或远程主机的问题。

3.3.10 top

到这一步,你已经通过之前的工具看到了许多这些指标,但通过使用top(1)实用程序并浏览系统和进程摘要进行最后的双重检查可能会很有帮助。

幸运的话,这60秒的分析将帮助你发现关于系统性能的一两个线索。你可以利用这些线索跳转到一些相关的BPF工具进行进一步分析。

3.4 BCC Tool Checklist

这个清单是BCC存储库中的一部分,位于docs/tutorial.md文件中,由我编写[30]。它提供了一个通用的BCC工具清单,可以逐个使用:

1. execsnoop

2. opensnoop

3. ext4slower(或者btrfs*、xfs*、zfs*)

4. biolatency

5. biosnoop

6. cachestat

7. tcpconnect

8. tcpaccept

9. tcpretrans

10. runqlat

11. profile

这些工具提供了关于新进程、打开的文件、文件系统延迟、磁盘I/O延迟、文件系统缓存性能、TCP连接和重传、调度器延迟以及CPU使用情况的更多信息。它们在后续章节中会有更详细的介绍。

3.4.1 execsnoop

execsnoop(8)通过每次execve(2)系统调用打印一行输出来显示新进程的执行情况。检查短暂存在的进程,因为这些进程可能消耗CPU资源,但可能不会出现在大多数定期拍摄运行进程快照的监控工具中。execsnoop(8)在第6章详细介绍了其功能。

3.4.2 opensnoop

opensnoop(8)为每个open(2)系统调用(及其变体)打印一行输出,包括被打开的路径及其是否成功("ERR"错误列)。打开的文件可以告诉您很多关于应用程序运行方式的信息:识别它们的数据文件、配置文件和日志文件。有时应用程序可能会因为不断尝试读取不存在的文件而表现不佳。opensnoop(8)在第8章中有更详细的介绍。

3.4.3 ext4slower

ext4slower(8)跟踪ext4文件系统的常见操作(读取、写入、打开和同步),并打印超过时间阈值的操作。这可以识别或证明一种性能问题:应用程序在通过文件系统等待缓慢的磁盘I/O。还有其他文件系统的类似工具,如btrfsslower(8)、xfsslower(8)和zfsslower(8)。详细内容请参阅第8章。

3.4.4 biolatency

biolatency(8)跟踪磁盘I/O延迟(即从设备发出到完成的时间),并将其显示为直方图。这比iostat(1)显示的平均值更能说明磁盘I/O的性能。可以检查多种模式。模式是分布中比其他值更频繁出现的值,例如,这个例子显示了一个多模态分布,一个模式在0到1毫秒之间,另一个模式集中在8到15毫秒范围内。也可以看到异常值:此截图显示了一个在512到1023毫秒范围内的异常值。biolatency(8)在第9章有更详细的介绍。

3.4.5 biosnoop

biosnoop(8)为每个磁盘I/O打印一行输出,包括延迟等详细信息。这使您能够更详细地检查磁盘I/O,并寻找时间顺序模式(例如,读取排队在写入后面)。biosnoop(8)在第9章有更详细的介绍。

3.4.6 cachestat

cachestat(8)每秒(或自定义间隔)打印一行摘要,显示来自文件系统缓存的统计信息。可以用它来识别低缓存命中率和高缺失率。这可能为性能调优提供线索。cachestat(8)在第8章有更详细的介绍。

3.4.7 tcpconnect

tcpconnect(8)为每个活动的TCP连接(例如,通过connect()建立的连接)打印一行输出,包括源地址和目标地址在内的详细信息。查找可能指向应用程序配置不足或入侵者的意外连接。tcpconnect(8)在第10章有更详细的介绍。

3.4.8 tcpaccept

tcpaccept(8)是tcpconnect(8)的配套工具。它为每个被动TCP连接(例如,通过accept()接受的连接)打印一行输出,包括源地址和目标地址在内的详细信息。tcpaccept(8)在第10章有更详细的介绍。

3.4.9 tcpretrans

tcpretrans(8)为每个TCP重传数据包打印一行输出,详细信息包括源地址、目标地址以及TCP连接的内核状态。TCP重传会导致延迟和吞吐量问题。对于状态为ESTABLISHED的重传,可以查找外部网络的问题。对于状态为SYN_SENT的重传,可能指向目标内核CPU饱和和内核数据包丢失的问题。tcpretrans(8)在第10章有更详细的介绍。

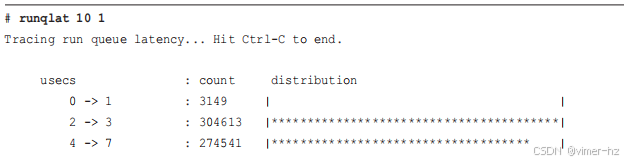

3.4.10 runqlat

runqlat(8)计算线程在等待CPU执行的时间,并将这些时间以直方图的形式打印出来。使用这个工具可以识别CPU访问等待时间超过预期的情况,线程可能因为CPU饱和、配置错误或调度程序问题而遭受影响。runqlat(8)在第6章有更详细的介绍。

3.4.11 profile

profile(8)是一个CPU分析器,你可以使用它来了解哪些代码路径正在消耗CPU资源。它在定时间隔内对堆栈跟踪进行采样,并打印出唯一堆栈跟踪的摘要及其出现次数计数。这里显示了截断的输出,只展示了一个堆栈跟踪,出现了58次。profile(8)在第6章有更详细的介绍。

3.5 Summary

性能分析旨在提高最终用户的性能并降低运营成本。有许多工具和指标可帮助您分析性能;事实上,这些工具如此之多,以至于在特定情况下选择合适的工具可能会让人感到不知所措。性能方法论可以指导您进行选择,指导您从何处开始、分析步骤以及结束位置。

本章总结了性能分析的方法论:工作负载特征化、延迟分析、USE方法和检查清单。接着介绍了Linux性能分析60秒检查清单,并解释了其用途,这可以作为解决任何性能问题的起点。它可能直接帮助您解决问题,或者至少提供线索,指示性能问题出现的位置,并使用BPF工具进行进一步分析。

此外,本章还包括了一个BPF工具检查清单,详细内容将在后续章节中进行解释。

4 BCC

BPF编译器集合(BCC,有时在项目和包名称后写成小写bcc)是一个开源项目,包含编译器框架和用于构建BPF软件的库。它是BPF的主要前端项目,由BPF开发人员支持,通常是首个使用最新内核追踪BPF增强功能的地方。BCC还包含超过70个现成的BPF性能分析和故障排除工具,本书中涵盖了其中许多工具。

BCC由Brenden Blanco于2015年4月创建。在Alexei Starovoitov的鼓励下,我于2015年加入了该项目,并成为性能工具、文档和测试的重要贡献者。现在有许多贡献者,BCC已经成为包括Netflix和Facebook在内的公司的默认服务器安装。

学习目标:

- 了解BCC的特性和组件,包括工具和文档

- 理解单一用途和多用途工具的好处

- 学习如何使用funccount(8)多工具进行事件计数

- 学习如何使用stackcount(8)多工具发现代码路径

- 学习如何使用trace(8)多工具进行每个事件的自定义打印

- 学习如何使用argdist(8)多工具进行分布摘要

- (可选)了解BCC内部结构

- 了解BCC调试技术

本章介绍了BCC及其特性;展示了如何安装BCC;提供了其工具、工具类型和文档的概述;最后,介绍了BCC的内部结构和调试。如果您希望开发自己的新工具,请务必学习本章和第5章(bpftrace),这样您就能选择最适合您需求的前端。附录C总结了使用示例开发BCC工具的过程。

4.1 BCC Components

BCC包含工具的文档、man页面和示例文件,以及使用BCC工具的教程,以及用于BCC工具开发的教程和参考指南。它提供了在Python、C++和lua(未显示)中开发BCC工具的接口;将来可能会添加更多接口。

该仓库地址为:

https://github.com/iovisor/bcc

在BCC仓库中,Python工具的文件扩展名为.py,但通过软件包安装BCC时通常会去掉这个扩展名。BCC工具和man页面的最终安装位置取决于您使用的软件包,因为不同的Linux发行版对其进行了不同的打包。工具可能安装在/usr/share/bcc/tools、/sbin或/snap/bin中,工具本身可能有前缀或后缀,以显示它们来自BCC集合。这些差异在第4.3节中有描述。

4.2 BCC Features

BCC是一个由来自各个公司的工程师创建和维护的开源项目。它不是商业产品。如果它是商业产品,就会有一个营销部门制作广告,吹嘘它的众多特性。

特性列表(如果准确)可以帮助您了解新技术的能力。在BPF和BCC的开发过程中,我创建了期望功能的列表[57]。随着这些功能的实现,它们已经成为已交付的功能列表,并分为内核级和用户级特性。这些特性在接下来的章节中描述。

4.2.1 Kernel-Level Features

BCC可以利用多种内核级特性,例如BPF、kprobes、uprobes等。以下列表包含一些实现细节(括号内):

- 动态插装,内核级(支持kprobes的BPF)

- 动态插装,用户级(支持uprobes的BPF)

- 静态跟踪,内核级(支持tracepoints的BPF)

- 定时采样事件(使用perf_event_open()的BPF)

- PMC(性能监控计数器)事件(使用perf_event_open()的BPF)

- 过滤(通过BPF程序)

- 调试输出(bpf_trace_printk())

- 每事件输出(bpf_perf_event_output())

- 基本变量(全局和线程级变量,通过BPF映射)

- 关联数组(通过BPF映射)

- 频率计数(通过BPF映射)

- 直方图(二的幂次方、线性和自定义,通过BPF映射)

- 时间戳和时间差(bpf_ktime_get_ns()和BPF程序)

- 堆栈跟踪,内核级(BPF stackmap)

- 堆栈跟踪,用户级(BPF stackmap)

- 覆写环形缓冲区(perf_event_attr.write_backward)

- 低开销插装(BPF JIT、BPF映射总结)

- 适用于生产环境(BPF验证器)

关于这些内核级特性的背景,请参阅第2章。

4.2.2 BCC User-Level Features

BCC用户级前端和BCC代码库提供以下用户级功能:

- 静态跟踪,用户级(通过uprobes实现SystemTap风格的USDT探针)

- 调试输出(使用Python的BPF.trace_pipe()和BPF.trace_fields())

- 每事件输出(使用BPF_PERF_OUTPUT宏和BPF.open_perf_buffer())

- 间隔输出(使用BPF.get_table()和table.clear())

- 直方图打印(table.print_log2_hist())

- C结构导航,内核级(BCC重写器映射到bpf_probe_read())

- 符号解析,内核级(ksym()和ksymaddr())

- 符号解析,用户级(usymaddr())

- 调试信息符号解析支持

- BPF tracepoint支持(通过TRACEPOINT_PROBE)

- BPF堆栈跟踪支持(BPF_STACK_TRACE)

- 各种其他辅助宏和函数

- 示例(位于/examples目录下)

- 多种工具(位于/tools目录下)

- 教程(/docs/tutorial*.md)

- 参考指南(/docs/reference_guide.md)

4.3 BCC Installation

BCC软件包适用于许多Linux发行版,包括Ubuntu、RHEL、Fedora和Amazon Linux,因此安装非常简便。如果需要,您也可以从源代码构建BCC。有关最新的安装和构建说明,请查看BCC代码库中的INSTALL.md文件[58]。

4.3.1 Kernel Requirements

BCC工具所使用的主要内核BPF组件在Linux 4.1和4.9之间的版本中添加,但是随着后续版本的推出,也不断有改进。因此,建议您使用Linux 4.9内核(于2016年12月发布)或更新版本。此外,还需要启用一些内核配置选项:CONFIG_BPF=y, CONFIG_BPF_SYSCALL=y, CONFIG_BPF_EVENTS=y, CONFIG_BPF_JIT=y, 以及CONFIG_HAVE_EBPF_JIT=y。这些选项现在在许多发行版中默认已经启用,因此通常您无需手动更改。

4.3.2 Ubuntu

BCC已经被打包到Ubuntu的multiverse仓库中,包名为bpfcc-tools。您可以使用以下命令进行安装:

sudo apt-get install bpfcc-tools linux-headers-$(uname -r)

这将把工具安装到/sbin目录下,并添加"-bpfcc"后缀。

您还可以从iovvisor仓库获取最新的稳定且经过签名的软件包:

sudo apt-key adv --keyserver keyserver.ubuntu.com --recv-keys 4052245BD4284CDD

echo "deb https://repo.iovisor.org/apt/$(lsb_release -cs) $(lsb_release -cs) main" | sudo tee /etc/apt/sources.list.d/iovisor.list

sudo apt-get update

sudo apt-get install bcc-tools libbcc-examples linux-headers-$(uname -r)

这些工具将安装在/usr/share/bcc/tools目录下。

此外,BCC也作为Ubuntu的snap包可用:

sudo snap install bcc

这些工具将安装在/snap/bin目录下(可能已经包含在您的$PATH中),并以“bcc.”前缀提供(例如,bcc.opensnoop)。

4.3.3 RHEL

BCC已经包含在Red Hat Enterprise Linux 7.6的官方yum仓库中,可以使用以下命令进行安装:

sudo yum install bcc-tools

这些工具将安装在/usr/share/bcc/tools目录下。

4.3.4 Other Distributions

INSTALL.md中还包括了Fedora、Arch、Gentoo和openSUSE的安装说明,以及源代码构建的说明。

4.4 BCC Tools

图4-2展示了主要的系统组件以及许多可用于观察它们的BCC工具。

4.4.1 Highlighted Tools

请注意,这些章节还包含许多未列在表4-1中的额外bpftrace工具。在完成本章和第5章之后,您可以根据需要跳转到后面的章节,将本书作为参考指南使用。

4.4.2 Tool Characteristics

BCC工具都具有以下共同特点:

- 它们解决实际的可观测性问题,是出于必要性而构建的。

- 它们设计用于在生产环境中由root用户运行。

- 每个工具都有一个man页(位于man/man8目录下)。

- 每个工具都有一个示例文件,包含示例输出和输出解释(位于tools/*_example.txt目录下)。

- 许多工具接受选项和参数,如果使用-h选项,大多数会打印USAGE消息。

- 工具源代码以块注释介绍开头。

- 工具源代码遵循一致的风格(使用pep8工具进行检查)。

为了保持一致性,新工具的添加会经过BCC维护者的审核,并要求作者遵循BCC的CONTRIBUTING_SCRIPTS.md指南。

BCC工具的设计也旨在与系统上的其他工具(如vmstat(1)和iostat(1))看起来和感觉一致。与vmstat(1)和top(1)类似,了解BCC工具的工作原理是有帮助的,特别是对于估算工具开销。本书解释了这些工具的工作原理,并经常描述了预期的开销;本章和第2章介绍了BCC和正在使用的内核技术的内部工作原理。

尽管BCC支持不同的语言前端,但BCC工具主要使用Python进行用户级组件开发,使用C进行内核级BPF开发。这些Python/C工具得到了BCC开发人员最多的关注和维护,因此在本书中有所涵盖。

贡献者指南中的建议之一是“编写解决问题的工具,而不要过多”。这鼓励开发单一用途的工具,而不是多功能工具,只要可能。

4.4.3 Single-Purpose Tools

Unix的哲学是做好一件事并且做到精致。这一理念的体现之一是创建小而高质量的工具,可以通过管道连接在一起完成更复杂的任务。这导致了大量小型的、单一用途的工具,例如今天仍在使用的grep(1)、cut(1)和sed(1)等。

BCC包含许多类似的单一用途工具,包括opensnoop(8)、execsnoop(8)和biolatency(8)。其中,opensnoop(8)就是一个很好的例子。考虑一下它是如何针对追踪open(2)系统调用家族定制选项和输出的:

对于BPF工具而言,采用这种风格的好处包括:

- **易于初学者学习:** 默认的输出通常已经足够使用。这意味着初学者可以立即使用这些工具,而无需对命令行用法做出决策,也不需要了解要监控哪些事件。例如,opensnoop(8)只需运行opensnoop就能产生有用且简洁的输出。不需要了解kprobes或tracepoints来监控open系统调用。

- **易于维护:** 对于工具开发者而言,需要维护的代码量更小,测试负担也更轻。多用途工具可能会以多种不同的方式监控各种工作负载,因此对工具进行小改动可能需要数小时的测试,以确保没有引入回归问题。对于最终用户而言,这意味着单一用途的工具更有可能在需要时正常工作。

- **提供代码示例:** 每个小工具都提供了一个简洁而实用的代码示例。许多学习BCC工具开发的人会从这些单一用途的工具开始,并根据需要进行定制和扩展。

- **定制参数和输出:** 工具的参数、位置参数和输出不需要适应其他任务,可以专门为单一用途进行定制。这可以提高可用性和可读性。

对于刚接触BCC的人来说,单一用途的工具是一个很好的起点,然后再转向更复杂的多用途工具。

4.4.4 Multi-Purpose Tools

BCC包含可以用于各种不同任务的多用途工具。它们比单一用途工具更难学习,但也更加强大。如果你只偶尔使用多用途工具,可能不需要深入学习它们;你可以在需要时收集一些单行命令来执行。

多用途工具的优点包括:

- **更大的可见性:** 不仅仅分析单个任务或目标,而是可以同时查看各个组件。

- **减少代码重复:** 可以避免有多个类似代码的工具。

BCC中最强大的多工具包括funccount(8)、stackcount(8)、trace(8)和argdist(8),这些在接下来的章节中进行了介绍。这些多用途工具通常允许你决定追踪哪些事件。然而,要充分利用这种灵活性,你需要了解要使用哪些kprobes、uprobes和其他事件,以及如何使用它们。后续章节将回到单一用途工具的具体主题上。

表格4-2总结了本章中概述的多用途工具。

请查看BCC仓库以获取完整和更新的工具选项和功能列表。这里仅概述了一些最重要的功能。

4.5 funccount

funccount(8)用于计数事件,特别是函数调用,并可以回答以下问题:

- 这个函数调用是内核级还是用户级的?

- 这个函数调用的频率是多少,每秒多少次?

为了提高效率,funccount(8)通过使用BPF映射在内核上下文中维护事件计数,并仅将总计报告给用户空间。与传统的“转储后处理”工具相比,这极大地减少了funccount(8)的开销。然而,高频率事件仍然可能导致显著的开销,因为它们的频率很高。例如,内存分配(malloc()、free())可能每秒发生数百万次,使用funccount(8)来跟踪这些事件可能会导致超过30%的CPU开销。有关典型频率和开销的更多信息,请参阅第18章。

接下来的章节将演示funccount(8),并解释其语法和功能。

4.5.1 funccount Examples

答案:是的。这个调用简单地跟踪 tcp_drop() 内核函数,直到键入 Ctrl-C 为止。在跟踪过程中,它被调用了三次。

这个命令使用类似shell的通配符来匹配所有以"vfs_"开头的内核函数。在跟踪过程中,调用次数最多的内核函数是vfs_write(),共调用了6938次。

速率是可变的,但大约是每秒约2000次调用。这是对libc库中的一个函数进行仪器化,而且是系统范围内的:输出显示了所有进程的调用速率。

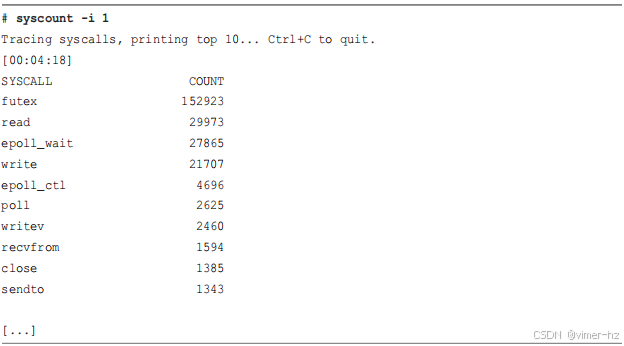

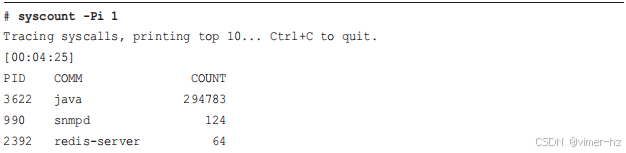

这个问题可以通过不同的事件源来回答。在这种情况下,我使用了来自syscalls系统的tracepoints,并简单地匹配了所有系统调用入口的tracepoints("sys_enter_*")。在跟踪过程中,调用次数最多的系统调用是futex(),共调用了42,929次。

4.5.2 funccount Syntax

funccount(8)的参数包括用于更改行为的选项以及描述要仪器化事件的字符串:

funccount [options] eventname

eventname的语法如下:

- **name** 或 **p:name**:仪器化名为name()的内核函数。

- **lib:name** 或 **p:lib:name**:仪器化位于库lib中名为name()的用户级函数。

- **path:name**:仪器化位于路径path中的文件中名为name()的用户级函数。

- **t:system:name**:仪器化名为system:name的跟踪点。

- **u:lib:name**:仪器化位于库lib中名为name的USDT探测点。

- **\***:通配符,匹配任何字符串(通配符匹配)。选项-r允许使用正则表达式代替。

这种语法在某种程度上受到了Ftrace的启发。在仪器化内核和用户级函数时,funccount(8)使用kprobes和uprobes。

4.5.3 funccount One-Liners

统计VFS内核调用次数:

funccount 'vfs_*'

统计TCP内核调用次数:

funccount 'tcp_*'

每秒统计TCP发送调用次数:

funccount -i 1 'tcp_send*'

显示每秒块I/O事件的速率:

funccount -i 1 't:block:*'

显示每秒新进程的产生率:

funccount -i 1 t:sched:sched_process_fork

显示每秒libc中getaddrinfo()(名称解析)的调用次数:

funccount -i 1 c:getaddrinfo

统计libgo中所有"os.*"调用的次数:

funccount 'go:os.*'

4.5.4 funccount Usage

间隔选项(-i)使funccount的一行命令在某种程度上变成了迷你性能工具,显示每秒自定义事件的速率。可以从成千上万的可用事件中创建自定义指标,并且如果需要,可以使用-p选项将其过滤到目标进程ID。

4.6 stackcount

stackcount(8)用于统计导致事件发生的堆栈跟踪。与funccount(8)类似,事件可以是内核级或用户级函数、跟踪点或USDT探测点。stackcount(8)可以回答以下问题:

- 为什么会调用这个事件?代码路径是什么?

- 所有不同的代码路径都是如何调用这个事件的,它们的频率是多少?

为了效率,stackcount(8)完全在内核上下文中执行这些总结,使用特殊的BPF映射来存储堆栈跟踪信息。用户空间读取堆栈ID和计数,然后从BPF映射中获取堆栈跟踪,进行符号转换并打印输出。与funccount(8)类似,stackcount(8)的开销取决于被仪器化事件的频率,由于stackcount(8)需要执行更多的工作来获取和记录堆栈跟踪,因此开销可能稍高。

4.6.1 stackcount Example

我注意到在一个空闲系统上使用funccount(8),我似乎有很高的ktime_get()内核函数调用率 — 每秒超过8000次。这些调用获取时间,但为什么我的空闲系统需要频繁获取时间呢?

这个例子使用stackcount(8)来识别导致ktime_get()调用的代码路径。

输出内容长达数百页,包含了1000多个堆栈跟踪。这里只包含了其中两个。每个堆栈跟踪以每个函数一行的方式打印,并且包括其出现次数。例如,第一个堆栈跟踪显示了通过dmcrypt_write()、blk_mq_make_request()和nvme_queue_rq()的代码路径。我猜测(没有查看代码的情况下),这可能是为了将I/O开始时间存储起来,以便后续优先处理。在追踪过程中,这个从ktime_get()到dmcrypt_write()的路径发生了52次。调用ktime_get()最频繁的堆栈来自于CPU空闲路径。

选项-P将进程名称和PID与堆栈跟踪一起显示。

这显示了PID为0,进程名称为"swapper/2"通过do_idle()调用了ktime_get(),进一步确认了这是空闲线程。使用-P选项会产生更多输出,因为先前分组的堆栈跟踪现在会根据每个单独的PID进行分割。

4.6.2 stackcount Flame Graphs

有时您会发现某个事件只打印了一个或几个堆栈跟踪,这在stackcount(8)的输出中很容易浏览。对于像ktime_get()这样的输出长达数百页的情况,可以使用火焰图来可视化输出。(火焰图在第2章介绍。)原始的火焰图软件[37]接受折叠格式的堆栈作为输入,每个堆栈跟踪一行,帧(函数名)用分号分隔,末尾带有空格和计数。stackcount(8)可以使用-f选项生成这种格式。

以下示例追踪ktime_get()持续10秒钟(-D 10),包含每个进程的堆栈(-P),并生成火焰图:

这里使用了wc(1)工具,显示输出共有1586行——代表着这么多个唯一的堆栈和进程名称组合。图4-3展示了生成的SVG文件的截图。

火焰图显示,大多数ktime_get()调用来自于八个空闲线程——系统上每个CPU一个,如相似的塔所示。其他来源显示为左侧较窄的塔。

4.6.3 stackcount Broken Stack Traces

堆栈跟踪及其在实际中遇到的诸多问题,已在第2、12和18章讨论过。常见的问题包括堆栈遍历中断以及符号丢失。

例如,之前的堆栈跟踪显示tick_nohz_idle_enter()调用了ktime_get()。然而,在源代码中并没有这个函数。实际上有一个调用tick_nohz_start_idle()的地方,其源代码位于(kernel/time/tick-sched.c)。

这种小型函数通常会被编译器内联,这就导致了一个堆栈,其中父函数直接调用ktime_get()。tick_nohz_start_idle符号在/proc/kallsyms(对于这个系统而言)中找不到,进一步表明它已经被内联。

4.6.4 stackcount Syntax

stackcount(8)命令的参数定义了要进行性能分析的事件:

stackcount [options] eventname

事件名称的语法与funccount(8)相同:

- name 或 p:name:分析内核函数 name()

- lib:name 或 p:lib:name:分析库 lib 中名为 name() 的用户级函数

- path:name:分析路径为 path 的文件中名为 name() 的用户级函数

- t:system:name:分析名为 system:name 的跟踪点

- u:lib:name:分析库 lib 中名为 name 的USDT探针

- *:通配符,匹配任何字符串(使用-g选项支持正则表达式)。

4.6.5 stackcount One-Liners

统计引起块I/O的堆栈跟踪:

stackcount t:block:block_rq_insert

统计导致发送IP数据包的堆栈跟踪:

stackcount ip_output

统计导致发送IP数据包并显示相关PID的堆栈跟踪:

stackcount -P ip_output

统计导致线程阻塞并移出CPU的堆栈跟踪:

stackcount t:sched:sched_switch

统计导致执行read()系统调用的堆栈跟踪:

stackcount t:syscalls:sys_enter_read

4.6.6 stackcount Usage

4.7 trace

trace(8)是一个BCC多功能工具,用于从多种不同的来源进行事件跟踪:kprobes、uprobes、tracepoints和USDT探针。

它可以回答诸如以下问题:

- 当内核或用户级函数被调用时,它们的参数是什么?

- 这个函数的返回值是什么?是否失败?

- 这个函数是如何被调用的?用户级或内核级堆栈跟踪是什么?

由于每个事件输出一行,trace(8)适用于调用不频繁的事件。非常频繁的事件,例如网络数据包、上下文切换和内存分配,可能每秒发生数百万次,trace(8)会产生大量输出,导致显著的性能开销。减少开销的一种方法是使用过滤表达式仅打印感兴趣的事件。频繁发生的事件通常更适合使用其他工具进行分析,如funccount(8)、stackcount(8)和argdist(8)这样在内核中进行总结的工具。argdist(8)将在下一节中介绍。

4.7.1 trace Example

以下示例显示通过跟踪do_sys_open()内核函数来进行文件打开操作,这是opensnoop(8)的trace(8)版本:

arg2是传递给do_sys_open()的第二个参数,是打开的文件名,类型为char *。最后一列标记为“-”,是提供给trace(8)的自定义格式字符串。

4.7.2 trace Syntax

trace(8)的参数是用于更改行为的选项和一个或多个探针:

trace [options] probe [probe ...]

探针的语法如下:

eventname(signature) (boolean filter) "format string", arguments

eventname签名是可选的,在某些情况下是必需的(参见第4.7.4节)。

过滤器也是可选的,并允许布尔运算符:==、<、>和!=。带有参数的格式字符串也是可选的。如果没有格式字符串,trace(8)仍会打印每个事件的元数据行;但是,没有自定义字段。

eventname的语法类似于funccount(8)的事件名称语法,还添加了返回探针:

- name或p:name:监控调用name()的内核函数

- r::name:监控调用name()的内核函数返回

- lib:name或p:lib:name:监控库lib中调用name()的用户级函数

- r:lib:name:监控库lib中调用name()的用户级函数返回

- path:name:监控路径处的文件中调用name()的用户级函数

- r:path:name:监控路径处的文件中调用name()的用户级函数返回

- t:system:name:监控名为system:name的跟踪点

- u:lib:name:监控库lib中名为name的USDT探针

- *:通配符,匹配任何字符串(globbing)。-r选项允许使用正则表达式。

格式字符串基于printf(),支持以下格式:

- %u:无符号整数

- %d:整数

- %lu:无符号长整数

- %ld:长整数

- %llu:无符号长长整数

- %lld:长长整数

- %hu:无符号短整数

- %hd:短整数

- %x:无符号整数,十六进制

- %lx:无符号长整数,十六进制

- %llx:无符号长长整数,十六进制

- %c:字符

- %K:内核符号字符串

- %U:用户级符号字符串

- %s:字符串

总体语法类似于其他语言中的编程。考虑下面的trace(8)单行命令:

trace 'c:open (arg2 == 42) "%s %d", arg1, arg2'

以下是更类似于C语言的等效程序(仅供示例;trace(8)不会执行此程序):

trace 'c:open { if (arg2 == 42) { printf("%s %d\n", arg1, arg2); } }'

在临时跟踪分析中经常需要自定义打印事件的参数,因此trace(8)是一个常用的工具。

4.7.3 trace One-Liners

以下是翻译:

在使用消息中列出了许多单行命令。这里是一些附加的单行命令选择。

跟踪内核的do_sys_open()函数,并输出文件名:

trace 'do_sys_open "%s", arg2'

跟踪内核的do_sys_open()函数返回,并打印返回值:

trace 'r::do_sys_open "ret: %d", retval'

使用模式和用户级堆栈跟踪do_nanosleep()函数:

trace -U 'do_nanosleep "mode: %d", arg2'

通过pam库跟踪认证请求:

trace 'pam:pam_start "%s: %s", arg1, arg2'

4.7.4 trace Structs

BCC使用系统头文件和内核头文件包来理解一些结构体。例如,考虑以下单行命令,它跟踪带有任务地址的do_nanosleep()函数:

trace 'do_nanosleep(struct hrtimer_sleeper *t) "task: %x", t->task'

幸运的是,hrtimer_sleeper结构体位于内核头文件包中(include/linux/hrtimer.h),因此BCC可以自动读取它。

对于不在内核头文件包中的结构体,可以手动包含它们的头文件。例如,以下单行命令仅在目标端口为53(DNS;以大端序写成13568)时跟踪udpv6_sendmsg()函数:

trace -I 'net/sock.h' 'udpv6_sendmsg(struct sock *sk) (sk->sk_dport == 13568)'

net/sock.h文件是必需的,以便理解struct sock,因此它使用了-I选项手动包含。这仅在系统上有完整的内核源代码时才能工作。

一种正在开发中的新技术可能会消除安装内核源代码的需要——BPF类型格式(BTF),它将在编译后的二进制文件中嵌入结构信息(见第2章)。

4.7.5 trace Debugging File Descriptor Leaks

这里有一个更为复杂的例子。我在调试Netflix生产实例上的一个真实问题——文件泄漏时开发了这个例子。目标是获取有关未被释放的套接字文件描述符的更多信息。通过sock_alloc()的堆栈跟踪可以提供这样的信息;然而,我需要一种区分已被释放(通过sock_release())和未被释放的分配的方法。问题在图4-4中有所说明。

追踪sock_alloc()并打印堆栈跟踪是直接的操作,但这会产生缓冲区A、B和C的堆栈跟踪。在这种情况下,只有缓冲区B是感兴趣的,因为它在追踪时没有被释放。

我能够使用一个单行命令来解决这个问题,尽管它需要后处理。以下是这个单行命令和一些输出:

这段话描述了如何在内核函数sock_alloc()的返回点上插入跟踪,并打印返回值、套接字地址以及堆栈跟踪(使用了-K和-U选项)。同时,它还追踪了__sock_release()内核函数的入口及其第二个参数:这显示了已关闭的套接字地址。使用-t选项可以打印这些事件的时间戳。

我已经截断了输出(输出和Java堆栈非常长),只展示了一个套接字地址为0xffff9c76526dac00的分配和释放配对(以粗体突出显示)。我能够通过后处理这些输出,找出已打开但未关闭的文件描述符(即没有匹配的关闭事件),然后使用分配的堆栈跟踪来识别导致文件描述符泄漏的代码路径(这里没有展示)。

这个问题也可以通过类似于第7章中介绍的专用BCC工具(如memleak(8))来解决,该工具将堆栈跟踪保存在BPF映射中,并在释放事件期间删除它们,以便稍后打印映射以显示长期存留的问题。

4.7.6 trace Usage

由于这是一种你可能偶尔使用的小型编程语言,用法消息结尾的示例是非常宝贵的提醒。

尽管trace(8)非常有用,但它并不是一个完整的语言。要了解完整的语言,请参阅第5章中的bpftrace。

4.8 argdist

argdist(8)是一个总结参数的多功能工具。以下是Netflix的另一个真实例子:一个Hadoop服务器遇到了TCP性能问题,我们追踪到问题是由于零大小的窗口广告导致的。我使用了argdist(8)的一行命令来总结生产环境中的窗口大小。以下是问题输出的部分内容:

这个工具对__tcp_select_window()内核函数的返回进行了仪器化,并将返回值以2的幂直方图(-H选项)的形式进行了总结。默认情况下,argdist(8)每秒打印一次这个总结。直方图显示了"0 -> 1"行中的零大小窗口问题:在上述时间间隔内,计数为6100。我们能够使用这个工具确认问题是否仍然存在,同时我们对系统进行了更改以纠正这个问题。

4.8.1 argdist Syntax

argdist(8)的参数设置了总结的类型、仪器化的事件以及要总结的数据:

argdist {-C|-H} [选项] 探针

argdist(8)要求使用-C或-H选项:

■ -C:频率计数

■ -H:2的幂直方图

探针的语法为:

eventname(signature)[:type[,type...]:expr[,expr...][:filter]][#label]

eventname和signature的语法几乎与trace(8)命令相同,唯一的例外是内核函数名的快捷方式不可用。例如,跟踪内核的vfs_read()函数使用"p::vfs_read",而不是"vfs_read"。通常需要提供signature。如果signature为空,则需要使用空括号"()"。

type显示了要总结的值类型:u32表示无符号32位整数,u64表示无符号64位整数,以此类推。支持多种类型,包括用于字符串的"char *"。

expr是要总结的表达式。它可以是函数的参数或跟踪点的参数。还有一些特殊变量只能在返回探针中使用:

■ $retval:函数的返回值

■ $latency:从进入到返回的时间,以纳秒为单位

■ $entry(param):进入探针时param的值

filter是一个可选的布尔表达式,用于过滤要添加到总结中的事件。支持的布尔运算符包括==、!=、<和>。

label是一个可选设置,将标签文本添加到输出中,以便自我记录。

4.8.2 argdist One-Liners

以下是使用消息中列出的许多单行命令。这里是一些额外的单行命令选择。

打印由内核函数vfs_read()返回的结果(大小)的直方图:

argdist.py -H 'r::vfs_read()'

打印由用户级libc read()在PID 1005上返回的结果(大小)的直方图:

argdist -p 1005 -H 'r:c:read()'

通过syscall ID计算syscalls的数量,使用raw_syscalls:sys_enter跟踪点:

argdist.py -C 't:raw_syscalls:sys_enter():int:args->id'

计算tcp_sendmsg()的大小:

argdist -C 'p::tcp_sendmsg(struct sock *sk, struct msghdr *msg, size_t size):u32:size'

将tcp_sendmsg()的大小汇总为2的幂直方图:

argdist -H 'p::tcp_sendmsg(struct sock *sk, struct msghdr *msg, size_t size):u32:size'

按文件描述符计算PID 181的libc write()调用次数:

argdist -p 181 -C 'p:c:write(int fd):int:fd'

按照读取的频率打印进程,其中延迟大于0.1毫秒:

argdist -C 'r::__vfs_read():u32:$PID:$latency > 100000'

4.8.3 argdist Usage

argdist(8)允许您创建许多功能强大的单行命令。对于超出其功能范围的分布总结,请参阅第5章。

4.9 Tool Documentation

每个BCC工具都有一个手册页和一个示例文件。BCC的/examples目录中包含一些类似工具的代码样本,但这些代码在其自身的代码之外并未有文档记录。您在/tools目录中找到的工具,或者在使用分发包时安装在系统其他位置的工具,应当有相应的文档记录。

接下来的部分以opensnoop(8)为例讨论工具文档。

4.9.1 Man Page: opensnoop

如果您的工具是通过软件包安装的,您可能会发现man opensnoop命令可用。如果您查看存储库,可以使用nroff(1)命令来格式化man页面(这些页面使用ROFF格式)。

man页面的结构基于其他Linux实用程序的结构。多年来,我不断完善了man页面内容的方法,并关注了某些细节。以下man页面包括了我的解释和建议:

这个man页面处于第8节,因为它是一个需要root权限的系统管理命令,正如我在DESCRIPTION部分的结尾所述。未来,扩展的BPF可能会对非root用户开放,就像perf(1)命令一样。如果发生这种情况,这些man页面将移动到第1节。

NAME部分包括对工具的一句描述。它说明这是一个为Linux设计的工具,使用eBPF/BCC(因为我为不同操作系统和跟踪器开发了多个版本的这些工具)。

SYNOPSIS部分总结了命令行的使用方法。

DESCRIPTION部分概述了工具的功能及其有用之处。描述工具为何有用是至关重要的,用简单的语言解释它解决了什么现实世界的问题(这对每个人可能并不显而易见)。提供这些信息有助于确保工具足够有用以发布。有时候,我在编写这一部分时会遇到困难,这让我意识到特定工具的使用案例可能过于狭窄,不值得发布。

DESCRIPTION部分还应指出主要的注意事项。提前告知用户可能存在的问题比让他们自己摸索要好。这个示例包括了有关动态跟踪稳定性和所需内核版本的标准警告。

接下来继续:

REQUIREMENTS部分列出任何特殊要求,而OPTIONS部分列出每个命令行选项:

EXAMPLES通过展示工具在不同方式下的执行来解释工具及其各种功能。这可能是man页面中最有用的部分。

FIELDS解释了工具可以输出的每个字段。如果一个字段有单位,应该在man页面中包含它们。例如,这个示例明确说明"TIME(s)"的单位是秒。

OVERHEAD部分是设定期望的地方。如果用户意识到存在较高的开销,他们可以进行计划,并仍然成功地使用这个工具。在这个例子中,预期开销应该很低。

最后的部分展示了这个工具来自BCC,以及其他元数据,并包括指向其他阅读材料的指针:示例文件,以及在SEE ALSO中列出的相关工具。

如果一个工具已经从其他跟踪器移植过来,或者基于其他工作,最好在man页面中进行文档化。有许多BCC工具已经移植到bpftrace存储库,bpftrace的man页面在它们的SOURCE部分声明了这一点。

4.9.2 Examples File: opensnoop

通过查看输出示例,可以是解释工具的最佳方式,因为它们的输出可能直观易懂,这是一个好工具设计的标志。BCC中的每个工具都有一个专门的文本文件,其中包含示例。

示例文件的第一句提供工具的名称和版本。输出示例从基础到更高级别都包括在内:

工具的输出在示例文件中得到了解释,尤其是在第一个示例中。示例文件的末尾包含了一份使用消息的副本。这可能看起来有些多余,但对在线浏览很有用。示例文件通常不会展示每个选项的使用方式,因此以使用消息结束可以展示工具的其他功能。

4.10 Developing BCC Tools

由于大多数读者可能更喜欢使用高级别的bpftrace语言进行编程,本书专注于使用bpftrace进行工具开发,并将BCC作为预先编写工具的来源。BCC工具开发作为附录C的可选内容进行了涵盖。

那么,在bpftrace已经存在的情况下,为什么还要开发BCC工具呢?BCC适合构建具有各种命令行参数和选项、以及完全定制输出和动作的复杂工具。例如,一个BCC工具可以使用网络库将事件数据发送到消息服务器或数据库。相比之下,bpftrace适合编写单行命令或接受零个或单个参数,并且仅打印文本输出的短小工具。

BCC还允许更低级别的控制,用于用C编写的BPF程序以及用Python或其他支持的语言编写的用户级组件。但这也带来了一些复杂性:开发BCC工具可能需要比bpftrace工具长10倍的时间,并且可能包含多达10倍的代码行数。

无论您是在BCC还是bpftrace中编码,通常都可以将核心功能从一种语言转移到另一种语言——一旦确定了这些功能应该是什么。在完全使用BCC开发工具之前,您可能还会使用bpftrace作为原型和概念验证语言。

关于BCC工具开发资源、技巧和带有源代码解释的示例,请参见附录C。接下来的章节涵盖了BCC内部和调试内容。即使您只是运行而不是开发BCC工具,但在需要调试出现问题的工具时,了解一些BCC内部知识可能也是必要的。

4.11 BCC Internals

BCC包括以下组成部分:

- 用于编写内核级BPF程序的C++前端API,包括:

- 一个预处理器,用于将内存解引用转换为bpf_probe_read()调用(以及在未来的内核中,bpf_probe_read()的变体)

- C++后端驱动程序:

- 通过Clang/LLVM编译BPF程序

- 在内核中加载BPF程序

- 将BPF程序附加到事件上

- 使用BPF映射进行读取/写入

- 用于编写BPF工具的语言前端API:Python、C++和lua

这些内容如图4-5所示。

图4-5中显示的BPF、Table和USDT Python对象是它们在libbcc和libbcc_bpf中实现的包装器。

Table对象与BPF映射进行交互。这些表已经成为BPF对象的BPF项目(使用Python的“魔法方法”,如__getitem__),因此以下行是等效的:

counts = b.get_table("counts")

counts = b["counts"]

USDT在Python中是一个单独的对象,因为其行为与kprobes、uprobes和tracepoints不同。在初始化期间,必须将其附加到进程ID或路径上,因为与其他事件类型不同,某些USDT探针需要在进程镜像中设置信号量以激活它们。这些信号量可供应用程序使用,以确定当前是否正在使用USDT探针,并决定是否准备其参数,或者是否可以跳过以进行性能优化。

C++组件编译为libbcc_bpf和libbcc,其他软件(如bpftrace)使用这些组件。libbcc_bpf源自Linux内核源代码中的tools/lib/bpf目录(它起源于BCC)。

BCC加载BPF程序并进行事件工具化的步骤包括:

1. 创建Python BPF对象,并将BPF C程序传递给它。

2. BCC重写器预处理BPF C程序,将解引用替换为bpf_probe_read()调用。

3. Clang将BPF C程序编译为LLVM IR。

4. 根据需要,BCC代码生成器添加额外的LLVM IR。

5. LLVM将IR编译成BPF字节码。

6. 如果使用映射,创建映射。

7. 将字节码发送到内核,并由BPF验证程序检查。

8. 启用事件,并将BPF程序附加到事件上。

9. BCC程序通过映射或perf_event缓冲区读取工具化数据。

接下来的章节将更详细地探讨这些内部机制。

4.12 BCC Debugging

除了插入printf()语句之外,还有多种调试和故障排除BCC工具的方法。本节总结了print语句、BCC调试模式、bpflist和重置事件等内容。如果您正在阅读本节是因为要解决问题,请同时查看第18章,该章涵盖了常见问题,如丢失事件、丢失堆栈和丢失符号。

图4-6显示了程序编译流程以及可以用于沿途检查的各种调试工具。

4.12.1 printf() Debugging

使用printf()进行调试可能会感觉像是一种简单粗暴的方法,与使用更复杂的调试工具相比,但它可以是有效和快速的。printf()语句不仅可以添加到Python代码中进行调试,还可以添加到BPF代码中。为此,有一个特殊的辅助函数:bpf_trace_printk()。它将输出发送到特殊的Ftrace缓冲区,可以通过读取/sys/kernel/debug/tracing/trace_pipe文件来查看。

例如,假设您在使用biolatency(8)工具时遇到问题,尽管它正在编译和运行,但输出看起来有些不对劲。您可以插入一个printf()语句来确认探测点是否触发,以及所使用的变量是否具有预期的值。以下是在biolatency.py中添加的示例,用粗体突出显示:

现在可以运行该工具:

# ./biolatency.py

跟踪块设备I/O... 按下Ctrl-C结束。

在另一个终端会话中,可以使用cat命令读取Ftrace的trace_pipe文件:

输出包含各种Ftrace默认字段,接着是我们自定义的bpf_trace_printk()消息(由于换行,消息可能被分割成多行)。

如果您使用cat命令读取trace文件而不是trace_pipe,将打印头信息:

这两个文件的区别如下:

- **trace**: 打印头信息;不会阻塞。

- **trace_pipe**: 阻塞以等待更多消息,并在读取时清除消息。

这个Ftrace缓冲区(通过trace和trace_pipe查看)被其他Ftrace工具使用,因此您的调试消息可能会与其他消息混合在一起。这对调试来说足够有效,如果需要的话,您可以过滤消息,只查看感兴趣的部分(例如,对于本例,您可以使用:grep BDG /sys/.../trace)。

使用第二章中介绍的bpftool(8),您可以通过bpftool prog tracelog命令打印Ftrace缓冲区。

4.12.2 BCC Debug Output

有些工具,比如funccount(8)的-D选项,已经提供了打印调试输出的选项。查看工具的使用消息(使用-h或--help选项)以查看是否有此选项。许多工具都有一个未记录的--ebpf选项,该选项会打印工具生成的最终BPF程序。

例如:

这在BPF程序被内核拒绝的情况下可能会很有用:您可以打印出来并检查是否存在问题。

4.12.3 BCC Debug Flag

BCC为所有工具提供了调试能力:可以在程序的BPF对象初始化器中添加调试标志。例如,在opensnoop.py中,有如下一行代码:

b = BPF(text=bpf_text)

可以修改为包含调试设置:

b = BPF(text=bpf_text, debug=0x2)

这样在运行程序时会打印BPF指令:

BPF调试选项是可以组合的单比特标志。它们列在src/cc/bpf_module.h中,如下所示:

debug=0x1f会打印所有内容,可能会输出数十页的内容。

4.12.4 bpflist

BCC中的bpflist(8)工具列出了正在运行BPF程序的工具以及一些详细信息。例如:

这显示opensnoop(8)工具正在使用PID 30231运行,并且使用了两个BPF程序和两个映射。这是有道理的:opensnoop(8)为每个事件使用一个BPF程序进行工具化,并且有一个映射用于在探测器之间传递信息,还有一个映射用于向用户空间发射数据。

-v(详细)模式计数kprobes和uprobes,-vv(非常详细)模式会计数并列出kprobes和uprobes。例如:

这显示有两个BPF程序在运行:systemd(PID 1)和opensnoop(PID 31364)。在-vv模式下还会列出开放的kprobes和uprobes。请注意,PID消费者31364编码在kprobe名称中。

4.12.5 bpftool

bpftool源自Linux源代码树,可以显示运行中的程序,列出BPF指令,与映射进行交互等功能。这些内容在第二章中有详细介绍。

4.12.6 dmesg

有时,来自BPF或其事件源的内核错误会出现在系统日志中,并可以使用dmesg(1)命令查看。例如:

# dmesg

[...]

[8470906.869945] trace_kprobe: Could not insert probe at vfs_rread+0: -2

这是一个关于尝试为vfs_rread()内核函数创建kprobe的错误信息;这是一个拼写错误,因为vfs_rread()函数并不存在。

4.12.7 Resetting Events

开发软件通常涉及编写新代码并修复错误的循环过程。在引入BCC工具或库中的错误时,可能会导致启用跟踪后BCC崩溃。这可能会使内核事件源处于启用状态,而没有进程来消费它们的事件,从而造成一些不必要的开销。

这个问题最初出现在旧的基于Ftrace的/sys接口中,BCC最初用于为除perf_events(PMCs)之外的所有事件源进行仪表化。perf_events使用了基于文件描述符的perf_event_open()。perf_event_open()的一个好处是,崩溃的进程会触发内核清理其文件描述符,进而触发已启用事件源的清理。从Linux 4.17版本开始,BCC已经全部转换为使用perf_event_open()接口来处理所有事件源,因此残留的内核启用问题应该已成为历史。

如果您使用的是较旧的内核,可以使用BCC中的一个名为reset-trace.sh的工具来清理Ftrace内核状态,从而移除所有已启用的跟踪事件。请仅在确定系统上没有任何跟踪消费者(不仅限于BCC,还包括任何跟踪器)运行时使用此工具,因为它可能会过早终止它们的事件源。

这是我在我的BCC开发服务器上的一些输出:

在这个详细模式操作下(-v),reset-trace.sh 所执行的所有步骤都会被打印出来。输出中在重置 kprobe_events 和 uprobe_events 后的空白行表示重置操作成功完成。

4.13 Summary

BCC项目提供了70多个BPF性能工具,其中许多支持通过命令行选项进行定制,并且所有工具都配备了文档:man手册和示例文件。大多数工具都是单一用途的,专注于良好地观察一项活动。也有一些是多用途工具;本章介绍了其中四个:funccount(8)用于计算事件数量,stackcount(8)用于计算导致事件的堆栈跟踪,trace(8)用于打印自定义事件输出,以及argdist(8)用于汇总事件参数作为计数或直方图。本章还涵盖了BCC调试工具。附录C提供了开发新BCC工具的示例。

5 bpftrace

bpftrace是基于BPF和BCC构建的开源跟踪器。与BCC类似,bpftrace提供了许多性能工具和支持文档。然而,它还提供了一种高级编程语言,允许您创建强大的一行命令和简短的工具。例如,使用bpftrace的一行命令将vfs_read()的返回值(字节或错误值)汇总为直方图:

bpftrace是由Alastair Robertson于2016年12月作为业余项目创建的。由于它设计良好,并且与现有的BCC/LLVM/BPF工具链非常匹配,我加入了该项目,并成为主要的代码、性能工具和文档贡献者。现在,我们已经有许多其他人加入进来,2018年我们完成了添加第一批重要功能的工作。

本章介绍了bpftrace及其特性,概述了其工具和文档,解释了bpftrace编程语言,并以bpftrace调试和内部结构的介绍结束。

学习目标:

- 理解bpftrace的特性及其与其他工具的比较

- 学习在哪里找到工具和文档,以及如何执行这些工具

- 学习如何阅读稍后章节中包含的bpftrace源代码

- 开发bpftrace编程语言中的新的一行命令和工具

- (可选)了解bpftrace的内部结构

如果您希望立即开始学习bpftrace编程,可以直接跳转到第5.7节,然后再回到这里继续了解bpftrace。

bpftrace非常适合使用自定义的一行命令和简短脚本进行即时仪表化,而BCC则更适合复杂的工具和守护程序。

5.1 bpftrace Components

bpftrace包含工具、man页、示例文件的文档,以及一个bpftrace编程教程(一行命令教程)和编程语言的参考指南。包含的bpftrace工具的扩展名为.bt。

前端使用lex和yacc解析bpftrace编程语言,使用Clang解析结构。后端将bpftrace程序编译成LLVM中间表示,然后通过LLVM库编译为BPF。详细信息请参见第5.16节。

5.2 bpftrace Features

特性列表可以帮助您了解新技术的能力。我为bpftrace创建了期望的特性列表,以指导开发,并且现在这些特性已经实现并列在本节中。在第4章中,我将BCC的特性列表按内核级别和用户级别的特性分组,因为它们使用不同的API。而对于bpftrace来说,只有一个API:bpftrace编程。这些bpftrace特性相反是根据事件源、动作和一般特性进行分组。

5.2.1 bpftrace Event Sources

这些事件源使用了第2章介绍的内核级技术。bpftrace接口(探针类型)显示在括号中:

- 动态仪表化,内核级(kprobe)

- 动态仪表化,用户级(uprobe)

- 静态跟踪,内核级(tracepoint、software)

- 静态跟踪,用户级(usdt,通过libbcc)

- 定时抽样事件(profile)

- 间隔事件(interval)

- PMC事件(hardware)

- 合成事件(BEGIN,END)

这些探针类型在第5.9节中有更详细的解释。未来计划添加更多事件源,可能在您阅读时已经存在;它们包括套接字和skb事件、原始跟踪点、内存断点和自定义PMC。

5.2.2 bpftrace Actions

这些是事件触发时可以执行的操作。以下是一些关键操作的选择;完整列表详见bpftrace参考指南:

- 过滤(predicates)

- 每个事件的输出(printf())

- 基本变量(global, $local 和 per[tid])

- 内建变量(pid, tid, comm, nsecs 等)

- 关联数组(key[value])

- 频率计数(count() 或 ++)

- 统计信息(min(), max(), sum(), avg(), stats())

- 直方图(hist(), lhist())

- 时间戳和时间差(nsecs,及哈希存储)

- 栈回溯,内核(kstack)

- 栈回溯,用户(ustack)

- 符号解析,内核级(ksym(), kaddr())

- 符号解析,用户级(usym(), uaddr())

- C结构导航(->)

- 数组访问([])

- Shell命令(system())

- 打印文件(cat())

- 位置参数($1, $2, …)

操作在第5.7节中有更详细的解释。如果有强烈的使用案例,可能会添加更多操作,但希望保持语言尽可能小以便更容易学习。

5.2.3 bpftrace General Features

以下是bpftrace的一般特性和存储库组件:

- 低开销的仪表化(BPF JIT 和 maps)

- 生产环境安全(BPF 验证器)

- 多种工具(位于 /tools 目录下)

- 教程(/docs/tutorial_one_liners.md)

- 参考指南(/docs/reference_guide.md)

5.2.4 bpftrace Compared to Other Observability Tools

比较bpftrace与其他也能仪表化所有事件类型的跟踪工具:

- **perf(1)**: bpftrace提供了一种更高级的语言,语法简洁,而perf(1)的脚本语言则比较冗长。perf(1)通过perf record支持高效的事件转储到二进制格式,并且支持像perf top这样的内存中摘要模式。bpftrace支持在内核中高效的自定义直方图等汇总功能,而perf(1)的内置内核汇总功能仅限于计数(perf stat)。perf(1)可以通过运行BPF程序来扩展其功能,尽管不像bpftrace那样使用高级语言;详见附录D中的perf(1) BPF示例。

- **Ftrace**: bpftrace提供了类似C和awk的更高级语言,而Ftrace的自定义仪表化(包括hist-triggers)有其特有的语法。Ftrace的依赖较少,适合于小型Linux环境。Ftrace还具有诸如函数计数之类的仪表化模式,迄今比bpftrace使用的事件源进行了更多性能优化(例如,我的Ftrace funccount(8)目前比相应的bpftrace具有更快的启动和停止时间以及更低的运行时开销)。

- **SystemTap**: bpftrace和SystemTap都提供了更高级的语言。bpftrace基于内置的Linux技术,而SystemTap添加了自己的内核模块,在非RHEL系统上的可靠性有所不足。SystemTap已经开始支持类似bpftrace的BPF后端,这应该使其在其他系统上更加可靠。目前,SystemTap在其库(tapsets)中具有更多的辅助功能,用于仪表化不同的目标。

- **LTTng**: LTTng优化了事件转储,并提供了分析事件转储的工具。这与bpftrace设计的即时分析方法有所不同。

- **应用程序工具**: 应用程序和运行时特定的工具仅限于用户级别的可见性。bpftrace可以仪表化内核和硬件事件,使其能够识别超出这些工具范围的问题来源。这些工具的优势在于它们通常针对目标应用程序或运行时进行了定制。例如,MySQL数据库分析器已经了解如何仪表化查询,而JVM分析器已经可以仪表化垃圾收集。在bpftrace中,你需要自己编写这样的功能。

不必孤立地使用bpftrace。目标是解决问题,而不是仅仅使用bpftrace,有时结合使用这些工具可能更快速有效。

5.3 bpftrace Installation

bpftrace应该可以通过你的Linux发行版的软件包安装,但在撰写本文时,这些软件包才刚刚开始出现;第一个bpftrace软件包是由Canonical提供的一个snap包[1],还有一个Debian软件包[2],也将会在Ubuntu 19.04上可用。你也可以从源代码构建bpftrace。查看bpftrace仓库中的INSTALL.md获取最新的软件包和构建说明[63]。

5.3.1 Kernel Requirements