【漫话机器学习系列】241.典型丢弃概率(Typical Dropout Probabilities)

深度学习中的典型Dropout概率解析

本文结合实际资料,详细解读深度学习中常见的Dropout设置,帮助大家更好地理解和应用这一关键正则化技术。

一、引言

在深度学习模型中,为了防止模型过拟合(Overfitting),我们通常会采用多种正则化手段。其中,Dropout是一种简单高效的方法。它通过在训练过程中随机“丢弃”一部分神经元,从而降低神经元之间的复杂共适应关系,提高模型的泛化能力。

那么,在实际应用中,我们应当以多大的概率去Drop神经元呢?本文将以Chris Albon的总结为依据,详细讲解典型的Dropout概率设定。

二、典型的Dropout概率

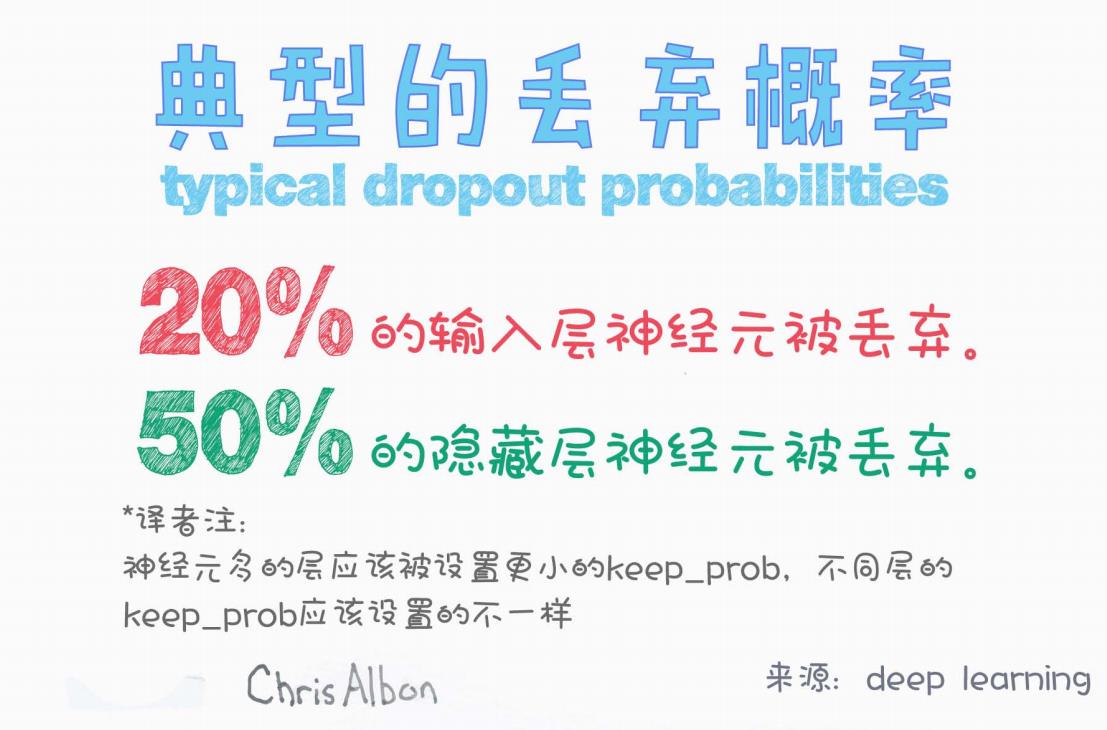

根据图示资料,总结如下:

-

输入层(Input Layer):

-

通常会以 20% 的概率将输入层神经元随机置零(丢弃)。

-

-

隐藏层(Hidden Layer):

-

通常会以 50% 的概率将隐藏层神经元随机置零(丢弃)。

-

如下图所示:

20% 的输入层神经元被毛弃(Dropout)。

50% 的隐藏层神经元被毛弃(Dropout)。

这种设定源自大量经验总结,能够在防止过拟合的同时,保证训练过程的有效性。

三、为什么输入层和隐藏层的Dropout概率不同?

Dropout的**保留概率(keep_prob)**指的是神经元被“保留下来”的概率(即没有被Dropout的概率)。

Chris Albon在图中特别注明:

神经元多的层应设置更小的keep_prob,不同层的keep_prob应该设置得不一样。

简单来说:

-

输入层

输入特征通常经过工程处理或是人类设计,已经是比较精炼的,因此如果丢弃过多,容易导致信息丢失,因此Dropout概率设置较低(20%)。 -

隐藏层

隐藏层的神经元通常数量很多且存在冗余,适当提高Dropout概率(50%),可以有效破除神经元间复杂的相互依赖,提高网络的泛化能力。

换句话说,不同层次的神经元数量和特性不同,因此合理地分配Dropout比例是必要的。

四、Dropout在训练和推理阶段的差异

需要注意的是:

-

训练阶段

Dropout随机屏蔽神经元,抑制复杂的共适应现象。 -

推理阶段(测试/预测阶段)

Dropout不再屏蔽任何神经元,而是将训练阶段的输出统一缩放(scale),以保证期望值的一致性。

例如,在TensorFlow早期版本中,需要手动设置keep_prob;而在PyTorch、TensorFlow 2中,框架内部会自动处理训练和推理时的差异,无需手动干预。

五、实践中的建议

根据行业实践,Dropout使用时可以遵循以下建议:

-

合理选择Dropout位置:

Dropout并不是越多越好,一般只在隐藏层或者输入层使用,不建议在输出层使用。 -

根据模型复杂度调整Dropout率:

对于大型复杂模型,可以适当增加Dropout概率;对于小型模型,Dropout率应适度降低,以免导致欠拟合。 -

与其他正则化方法结合:

Dropout可以与L2正则化(权重衰减)、Batch Normalization等技术搭配使用,提高效果。

六、总结

Dropout是深度学习中防止过拟合的经典手段之一。

不同层次的神经元应采用不同的Dropout概率设置:

-

输入层建议Dropout率为 20%。

-

隐藏层建议Dropout率为 50%。

实际应用时,应结合模型规模、数据量和具体任务灵活调整。

希望本文能帮助你在构建神经网络时,合理使用Dropout,提高模型的鲁棒性和泛化能力!

七、参考资料

-

Chris Albon — [Machine Learning Flashcards]

-

Ian Goodfellow — [Deep Learning Book]

-

TensorFlow / PyTorch 官方文档

如果你喜欢这样的技术分享,欢迎点赞、评论或收藏!

有任何问题也可以留言讨论,一起进步!